Sorte de réponse du berger à la bergère, puisqu'AMD lançait en début d'année son Radeon HD 3870 X2, une carte elle aussi dotée de deux puces graphiques, le GeForce 9800 GX2 s'affirme sur le papier comme la nouvelle référence en matière de carte graphique très haut de gamme. Parallèlement à ce lancement, NVIDIA en profite pour lever le voile sur son nouveau chipset pour processeurs Intel, le nForce 790i SLI. Alors que le nForce 780i SLI ne nous avait pas laissé un souvenir impérissable, le nForce 790i SLI promet de corriger tous ses défauts ou presque. De quoi faire du couple GeForce 9800 GX2 et nForce 790i SLI, la plateforme de jeu idéale ?

GeForce 9800 GX2 : simples GeForce 8 déguisés ?

Face au G80 qui animait les GeForce 8800 GTX ou Ultra, les anciennes références haut de gamme de NVIDIA, le G92 que l'on retrouve au sein du GeForce 9800 GX2 apporte quelques raffinements supplémentaires. On pense bien sûr à la présence d'une interface PCI-Express 2.0 native, aux améliorations de l'algorithme de compression des couleurs, ou encore à la prise en charge du HDCP sur les sorties DVI en dual-link. En contrepartie, le G92 a perdu le bus mémoire un rien exotique des G80 puisqu'il faut se contenter d'un bus mémoire 256 bits quand les premières GeForce 8800 disposaient d'une interface mémoire sur 384 bits pour les modèles GTX et Ultra, et 320 bits pour le modèle GTS. Techniquement, ce changement s'avère pénalisant au niveau de la bande passante mémoire théorique même si NVIDIA s'efforce de compenser cette limitation par une hausse de la fréquence des puces mémoire. Autre sacrifice de taille, le G92 ne dispose que de 16 ROP, du nom des unités en charge des derniers traitements sur les pixels, contre 24 pour le G80 alias GeForce 8800. Ceci, combiné au bus mémoire, devrait avoir un effet négatif sur les performances en anticrénelage.

Avec deux puces graphiques et un seul connecteur PCI-Express 16x, la GeForce 9800 GX2 dispose naturellement d'un switch PCI-Express sous la forme d'un composant similaire au nForce 200 que l'on retrouve sur les cartes mères en nForce 780i notamment. Cette puce, véritable contrôleur PCI-Express 2.0 sur 48 voies, permet à chaque puce graphique de disposer de 16 voies PCI-Express. Parallèlement, les deux puces graphiques de la GeForce 9800 GX2 sont reliées entre elles par une connexion SLI, puisque c'est bel et bien la technologie de rendu multi-processeurs SLI qui permet à NVIDIA de proposer une seule et même carte graphique munie de deux GPU. Du reste, et contrairement à l'acceptation habituelle de l'implémentation de la technologie SLI, il n'est pas nécessaire de disposer d'une carte mère NVIDIA nForce pour profiter du GeForce 9800 GX2. La carte est donc compatible avec tout PC, qu'il soit équipé d'un chipset AMD, Intel ou NVIDIA. Terminons en précisant que le GeForce 9800 GX2 est compatible avec la technologie Quad-SLI.

Le switch BR04 employé par la GeForce 9800 GX2

GeForce 9800 GX2 : les spécifications

Embarquant deux puces graphiques G92 comportant chacune 754 millions de transistors, la carte GeForce 9800 GX2 dispose d'un total de 256 processeurs de flux, à raison de 128 processeurs par puce. Côté fréquences de fonctionnement, chaque processeur est cadencé à 600 MHz alors que les unités de shaders, ou processeurs de flux, opèrent à 1,5 GHz. Quant à la mémoire, interfacée sur 256 bits, elle fonctionne à la fréquence de 1 GHz : chaque processeur graphique a par ailleurs à sa disposition un total de 512 Mo de mémoire vidéo en GDDR3.

GeForce 9800 GX2 : vue de l'intérieur

Il est intéressant de noter que ces spécifications sont identiques à celles du GeForce 8800 GT. Chacune des puces du GeForce 9800 GX2 reprend en effet les spécifications du GeForce 8800 GT, la seule différence notable se situant au niveau du nombre de processeurs de flux, on passe de 112 à 128 et de la fréquence de fonctionnement de la mémoire, celle-ci opérant à 1 GHz sur le GeForce 9800 GX2 et non à 900 MHz comme sur les GeForce 8800 GT. En se basant sur ces caractéristiques, les performances d'une GeForce 9800 GX2 s'annoncent donc équivalentes, voire très légèrement supérieures à celles d'un SLI de GeForce 8800 GT 512 Mo.

| GeForce 8800 GT | GeForce 8800 GTX | Radeon HD 3870 X2 | GeForce 9800 GX2 | |

| Interface | PCI-Ex. 16x - Gen2 | PCI-Ex. 16x | PCI-Ex. 16x | PCI-Ex. 16x - Gen2 |

| Gravure | 0,065 µ | 0,09 µ | 0,055 µ | 0,065 µ |

| Transistors | 754 Millions | 681 Millions | 666 Millions | 754 Millions |

| RAMDAC | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz |

| T&L | DirectX 10 | DirectX 10 | DirectX 10.1 | DirectX 10 |

| Stream Processors | 112 | 128 | 320 | 128 |

| Unités ROP | 16 | 24 | 16 | 16 |

| Mémoire embarquée | 512 Mo | 768 Mo | 2x 512 Mo | 2x 512 Mo |

| Interface mémoire | 256 bits | 384 Bits | 256 bits | 256 bits |

| Bande passante | 57,6 Go/s | 101.3 Go/s | 58,9 Go/s | 64 Go/s |

| Fréquence GPU | 600 MHz | 575 MHz | 825 MHz | 600 MHz |

| Fréquence Stream Processors | 1500 MHz | 1350 MHz | 825 MHz | 1500 MHz |

| Fréquence mémoire | 900 MHz | 900 MHz | 900 MHz | 1 GHz |

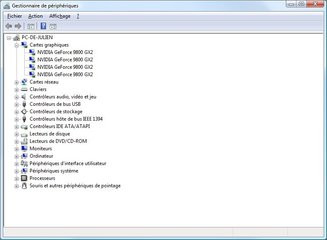

GeForce 9800 GX2 : nouveau fonctionnement Quad-SLI

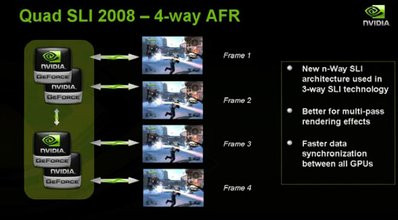

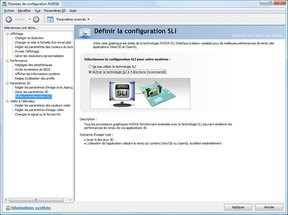

Nous l'évoquions précédemment, il est possible de faire fonctionner deux GeForce 9800 GX2 de concert afin de profiter de la puissance de quatre puces graphiques. Naturellement, il faudra cette fois-ci disposer d'une plateforme compatible avec la technologie SLI, c'est-à-dire d'une carte mère avec chipset NVIDIA nForce. Si NVIDIA profite du GeForce 9800 GX2 pour ressusciter sa technologie Quad SLI, la firme au caméléon inaugure un tout nouveau mode de rendu, le « 4-way AFR ». Celui-ci remplace le mode hybride de l'ancien Quad-SLI qui consistait en un « SFR d'AFR ». Pour être plus clair : avec l'ancienne solution Quad-SLI de NVIDIA deux des quatre processeurs graphiques travaillaient sur une partie de l'image (SFR), et ce, une image sur deux (AFR).

Dans sa version 2008 la technologie Quad-SLI gère l'AFR ou rendu d'image alterné sur chacune des puces graphiques avec tout type de jeux OpenGL et DirectX. Autrement dit, au même instant, chaque puce graphique travaille sur le rendu d'une scène distincte. NVIDIA indique avoir pour cela réécrit le pilote Quad-SLI et explique que les jeux actuels font un usage tellement intensif des shaders que l'AFR ou Alternate Frame Rendering est le mode qui permet le gain de performance le plus important. Attention toutefois, le « 4-Way AFR » n'est disponible que sous Windows Vista. Précisons au passage qu'avec le Quad-SLI de GeForce 7950 GX2, le mode « 4-Way AFR » existait mais était réservé uniquement aux jeux OpenGL, le système d'exploitation Windows XP limitant alors le nombre de backbuffer à trois.

GeForce 9800 GX2 en Quad-SLI

GeForce 9800 GX2 : alimentation et technologie HybridPower

En réunissant deux puces sur une seule et même carte graphique, il est bien évident que les exigences en matière électrique de la carte en question sont supérieures à la norme. Ainsi NVIDIA recommande au minimum une alimentation de 580 Watts tout en précisant pour les configurations plutôt musclées qu'une alimentation de 850 Watts est préférable. D'après nos relevés, effectués ici sur la consommation totale de la machine, le GeForce 9800 GX2 consomme un peu plus que son concurrent direct chez AMD le Radeon HD 3870 X2 :| Consommation totale au repos | Consommation totale en charge | |

| Radeon HD 3870 X2 | 195 Watts | 394 Watts |

| GeForce 9800 GX2 | 214 Watts | 404 Watts |

Reste un souci, d'ordre purement pratique, les connecteurs PCI-Express 8 broches de certaines alimentations ne rentrent tout simplement pas dans le connecteur de la GeForce 9800 GX2. NVIDIA explique s'être conformé aux spécifications définies par le groupe PCI-Express pour concevoir son connecteur, ce qui ne serait pas le cas de certains fabricants d'alimentations. Dans certains cas, il faudra donc forcer pour faire rentrer le connecteur alors que dans d'autres il ne rentrera tout simplement pas. Pour corriger le tir, NVIDIA devrait proposer un adaptateur avec certaines de ses cartes.

Un connecteur parfois impossible à enficher

Afin d'économiser de l'énergie, NVIDIA propose pour la première fois, avec sa GeForce 9800 GX2, une implémentation de sa technologie HybridPower. Il s'agit sur le papier de couper l'alimentation de la carte graphique principale lorsque le système ne requiert pas de puissance 3D et qu'il est utilisé pour des tâches bureautiques. Dans ce cas de figure, l'affichage du bureau Windows bascule sur le chipset de la carte mère, un chipset qui se devra d'être NVIDIA et d'intégrer lui aussi la technologie HybridPower. Problème pour NVIDIA, aucun chipset compatible HybridPower n'est actuellement disponible sur le marché et le premier chipset qui prendra en charge cette technologie sera destiné à la plateforme AMD.

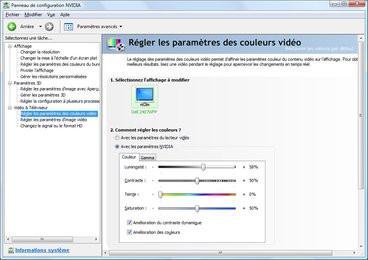

GeForce 9800 GX2 : PureVideo HD est là

Parallèlement, le GeForce 9800 GX2 profite des nouvelles fonctions introduites par les pilotes de la génération 174 sortis en même temps que le GeForce 9600. Il s'agit pour mémoire de la possibilité de décoder deux flux vidéos HD ou encore d'améliorations dynamiques du contraste et de la couleur pour des vidéos toujours plus réalistes. Qui plus est, avec les dernières versions des logiciels de lecture vidéo, la lecture de flux vidéos haute définition ne désactive plus l'interface graphique Aero sous Windows Vista.

Activation des fonctions d'amélioration dynamique de l'image

NVIDIA GeForce 9800 GX2 : la carte de XFX

Le fabricant XFX est l'un des tous premiers à avoir pu nous faire parvenir une carte graphique basée sur le GeForce 9800 GX2. Baptisée simplement GeForce 9800 GX2, la carte reprend le design de référence de NVIDIA, un design pour le moins inédit et franchement massif qui occupera deux slots dans votre PC. Contrairement à AMD qui, sur sa Radeon HD 3870 X2, place deux puces graphiques sur le même PCB, NVIDIA opte pour un design double PCB. Chaque puce graphique avec sa mémoire est sur un PCB différent et les deux PCB sont séparés par un bloc de refroidissement avec cœur cuivre, ailettes et ventilateur type cage d'écureuil situé sur l'extrémité droite de la carte. Celui-ci expulsera l'air chaud à l'extérieur de votre PC et il est important de préciser qu'au-delà d'une certaine température, en l'occurrence 105° C, la fréquence des puces est automatiquement diminuée. Le tout est caréné dans un carter métallique qui recouvre et protège l'ensemble des composants de la carte, alors que la carte mesure 27 centimètres.

Une carte... impressionnante !

Munie de deux connecteurs d'alimentation PCI-Express : le premier sur six broches, le second sur huit broches, la carte dispose de témoins lumineux indiquant la bonne alimentation de chacun de ses étages. Attention, la carte ne fonctionnera pas en lui raccordant deux connecteurs d'alimentation PCI-Express sur six broches. Extérieurement, la carte offre deux connecteurs DVI, numérotés, et pour la première fois chez NVIDIA un connecteur HDMI. À proximité des connecteurs d'alimentation, nous retrouvons un petit cache en caoutchouc dissimulant l'entrée audio pour le passthrough vers HDMI. Pouvant fonctionner avec une seconde carte GeForce 9800 GX2, la carte de XFX dispose d'un connecteur SLI, que l'on retrouve dissimulé sous un petit cache amovible en plastique.

Détails de la GeForce 9800 GX2 : connecteurs externe, et connecteurs d'alimentation

En fonctionnement normal, c'est-à-dire avec des applications bureautiques classiques, la carte reste relativement discrète. En revanche, au bout de quelques minutes de jeu, le ventilateur se fera largement entendre, d'autant plus dans un environnement confiné, ce qui est le cas de tous les boîtiers PC en principe. Au niveau des caractéristiques techniques, la carte est en tout point conforme avec les spécifications édictées par NVIDIA avec 512 Mo de mémoire GDDR3 par puce graphique et des fréquences conformes à celles évoquées plus haut.

NVIDIA GeForce 9800 GX2 : la carte signée Gainward

Le fabricant Gainward a lui aussi pu nous faire parvenir une carte GeForce 9800 GX2. Reprenant le design de référence de NVIDIA, la carte se différencie du modèle XFX par son autocollant ici aux couleurs du fabricant Gainward. Pour le reste, et sans surprise, tout est strictement identique à commencer par la taille, le poids ou encore la forme de la carte. Naturellement les caractéristiques techniques sont ici encore similaires à celles du design de référence NVIDIA avec 512 Mo de mémoire vidéo par puce graphique et une fréquence de fonctionnement de 1500 MHz pour les processeurs de flux. On notera toutefois que Gainward livre sa GeForce 9800 GX2 avec le jeu Tomb Raider Anniversay Edition alors que XFX accompagne sa carte du jeu Company Of Heroes.

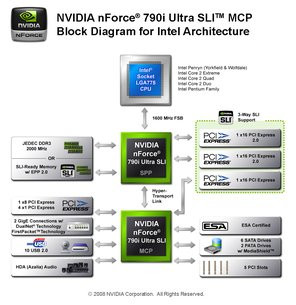

NVIDIA nForce 790i Ultra SLI : premier chipset NVIDIA avec DDR3

Pour le nForce 790i NVIDIA nous propose cette fois-ci un vrai nouveau chipset composé d'un tout nouveau northbridge. Celui-ci a été entièrement revu pour gérer nativement les derniers processeurs Intel de la famille Penryn gravés en 45 nm, qu'ils soient munis de deux ou quatre cœurs et ce jusqu'au FSB1600. En matière de prise en charge processeur, NVIDIA s'assure de la gestion des demi coefficients multiplicateurs alors que l'utilisateur peut ajuster, via le BIOS, le voltage GTLVRef, un paramètre qui peut être revu à la baisse pour compenser les chutes de tension qui peuvent se produire avec des processeurs quadri-cœurs.

Carte mère XFX nForce 790i Ultra SLI

Le contrôleur mémoire du northbridge, alias SPP, est également tout nouveau puisqu'il s'agit cette fois d'un contrôleur double-canal en DDR3 avec prise en charge de la spécification EPP2 alias SLI Memory. Rappelons que l'EPP consiste en une série de profils, embarqués sur la barrette mémoire, et comportant divers réglages prédéfinis pour des performances élevées et ou des réglages d'overclocking. Adoptant un fonctionnement désynchronisé, le bus mémoire peut opérer à la fréquence de votre choix sans lien avec la fréquence du bus système. Décliné selon deux modèles, le nForce 790i dans sa version SLI gère au mieux la DDR3 1333 MHz quand le modèle nForce 790i Ultra SLI prend en charge la DDR3 1600 MHz. NVIDIA indique que le contrôleur mémoire dispose de diverses optimisations avec des algorithmes conçus pour des temps de latence très faibles alors que de nouveaux algorithmes de mise en cache prédictive des données font leur apparition.

Diagramme d'interconnexions du nForce 790i Ultra SLI

Côté PCI-Express, le nForce 790i SLI gère la norme 2.0 tout comme son prédécesseur le nForce 780i SLI. À une différence de taille toutefois, le nForce 790i SLI gère le bus PCI-Express de seconde génération de manière native quand le nForce 780i SLI avait recours à une puce externe, un composant nForce 200. En tout, ce sont près de soixante lignes PCI-Express qui sont gérées par les nForce 790i Ultra SLI et nForce 790i SLI soit la possibilité de créer une configuration 3-Way SLI avec trois cartes graphiques câblées chacune sur 16x. A l'instar du composant nForce 200, le contrôleur PCI-Express 2.0 du nForce 790i intègre deux nouvelles technologies censées optimiser la communication de puce graphique à puce graphique, ce qui est particulièrement utile en SLI. Il s'agit du PW Short ou Posted-write shortcut qui permet à un processeur graphique de transmettre un message directement à un autre processeur graphique sans quitter le chipset : en ne repassant pas par le bus processeur, le message arrive logiquement plus vite à destination. La technologie de Broadcast permet quant à elle de diffuser une seule commande sur le bus système qui sera ensuite répliquée aux diverses puces graphiques par le biais du chipset : cela évite les transmissions en série.

Northbridge nForce 790i Ultra SLI

NVIDIA nForce 790i Ultra SLI : un southbridge vieillissant mais... avec ESA !

En ce qui concerne le southbridge, NVIDIA nous ressert son nForce 570, un composant pour le moins daté. On a donc droit à six ports Serial-ATA de seconde génération ou à la prise en charge des modes RAID 0, RAID 1, RAID 0+1, RAID 5 mais toujours pas d'AHCI. Intégrant deux contrôleurs réseau Gigabit, le southbridge dispose des technologies FirstPacket et DualNet, la première étant censée améliorer le ping, la seconde permettant le teaming, et il gère toujours ce bon vieux bus PCI. Quant à l'IDE il est toujours de la partie avec un seul canal.Introduite avec le nForce 780i SLI, la technologie ESA, récemment approuvée par le forum d'implémentation de l'USB, a pour but de faciliter l'accès aux informations du système. Il s'agit de transmettre, via le protocole USB, les informations sur la température du processeur, la vitesse de rotation des ventilateurs ou encore la température globale du boîtier, celle de l'alimentation ou les tensions délivrées par l'alimentation. Particulièrement utile pour les amateurs d'overclocking, la technologie ESA nécessite bien sûr une alimentation et un boîtier compatible ESA, un minimum d'électronique supplémentaire étant nécessaire. Sans grande surprise donc, le tout nouveau nForce 790i SLI est lui aussi compatible ESA.

- Carte mère XFX NVIDIA nForce 790i Ultra SLI,

- Processeur Intel Core 2 Extreme QX9650 (3 GHz),

- 2x1 Go DDR3 Crucial Balistix @ 1000 MHz,

- Disque dur Western Digital Raptor 150 Go Serial-ATA 150

Ce test est également pour nous l'occasion d'inclure Call Of Duty 4 dans notre panel de jeux, avec une démo perso, alors que nous avons créé une nouvelle démo sous Crysis, dans le niveau « Ice ». Nous en profitons également pour changer les résolutions de test afin d'inclure des résolutions élevées représentatives de l'usage de ces configurations très haut de gamme.

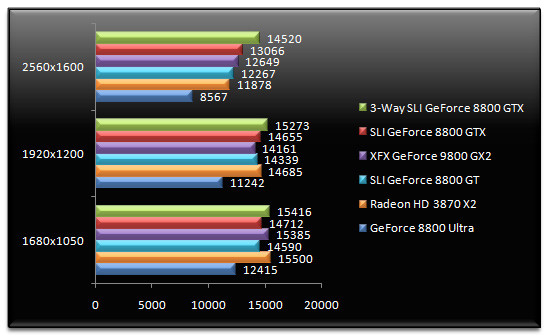

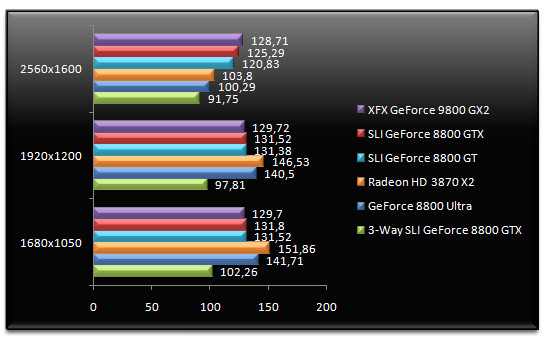

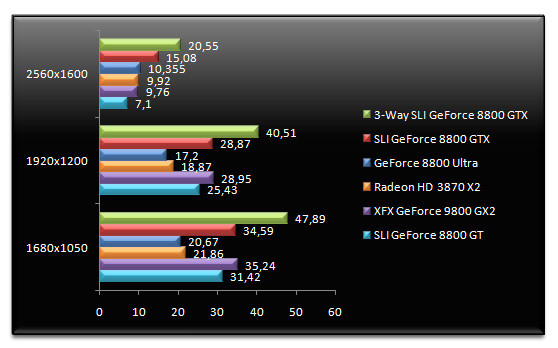

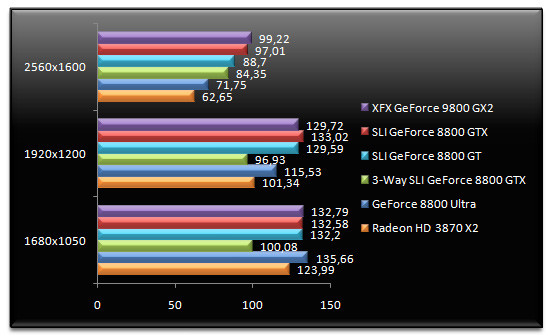

3DMark 06

Pour ne pas déroger à nos habitudes, nous démarrons les tests avec ce bon vieux 3DMark 06... en attendant 3DMark Vantage ! On constate que dans les basses résolutions, nos cartes ou couples de cartes sont plus ou moins au même niveau de performance, seule la GeForce 8800 Ultra marquant le pas. Il faut atteindre les 2560x1600 pour commencer à voir une certaine hiérarchie entre nos cartes. Le GeForce 9800 GX2 est ici 6 % plus rapide que le Radeon HD 3870 X2 alors qu'il est très légèrement plus rapide que le SLI de GeForce 8800 GT. Comparé à une GeForce 8800 Ultra, le GeForce 9800 GX2 est 47 % plus rapide que notre configuration à base de trois GeForce 8800 GTX reste la plus rapide.

Enemy Territory : Quake Wars - v1.4

Quake Wars a tout récemment rejoint notre protocole de tests. Le jeu, basé sur le moteur OpenGL de Doom 3, est ici testé avec une démo enregistrée par nos soins. En 1680x1050 tout comme en 1920x1200, nos cartes affichent les mêmes performances, à l'exception de la GeForce 8800 Ultra. Comme sous 3DMark 06, les différences de performances se font ressentir en 2560x1600. Dans cette résolution, le GeForce 9800 GX2 est 3 % plus performant que le SLI de GeForce 8800 GT alors qu'il est 19 % plus rapide que le récent Radeon HD 3870 X2 d'AMD. Face au GeForce 8800 Ultra, le GeForce 9800 GX2 offre un surcroît de performances de 49 %.

F.E.A.R. - v1.08

Petit détour sous F.E.A.R., un vénérable FPS, où la configuration avec trois GeForce 8800 GTX affiche de très bons résultats. Le Radeon HD 3870 X2 n'est pas en reste puisqu'en 2560x1600, la carte affiche des performances supérieures au GeForce 9800 GX2. Dans ce cas précis, la carte d'AMD est 28 % plus performante que la petite dernière de NVIDIA. Petite dernière qui fait mieux que le SLI de GeForce 8800 GT, mais moins bien qu'un SLI de GeForce 8800 GTX.

Half-Life 2 - Episode Two

Sous Half-Life 2, ici testé avec une démo de notre cru réalisée sous l'épisode deux du jeu, le GeForce 9800 GX2 l'emporte, si l'on considère la résolution de 2560x1600. En revanche, le Radeon HD 3870 X2 d'AMD est significativement plus rapide en 1680x1050 et en 1920x1200, un point qui devrait intéresser les possesseurs d'écrans 20, 22 et 24 pouces. On notera qu'en 2560x1600, les performances de la GeForce 9800 GX2 sont 6 % plus élevées que celles d'un SLI de GeForce 8800 GT. Un mot enfin sur la solution « 3-Way SLI » qui fait ici peine à voir puisque ses performances sont systématiquement les plus mauvaises.

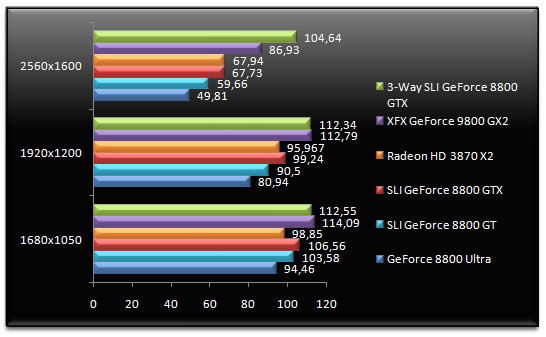

Unreal Tournament 3 - v1.2 - War Serenity Bot

Pour Unreal Tournament 3, la solution graphique la plus rapide est à n'en pas douter le trio de GeForce 8800 GTX. Le GeForce 9800 GX2 termine second avec un frame rate 8 % supérieur à celui du SLI de GeForce 8800 GT. Comparativement au Radeon HD 3870 X2 d'AMD, le GeForce 9800 GX2 se montre ici 22 % plus rapide. Et le GeForce 8800 Ultra en prend pour son grade puisqu'en 2560x1600 le nouveau-venu est 75 % plus véloce.

Call Of Juarez - DirectX 10

Petit détour sous Call Of Juarez où la résolution maximale de notre panel de tests, le 2560x1600 n'est pas disponible. On se contente donc de résolutions standards à savoir les 1680x1050 et 1920x1200 où la solution la plus performante est le trio de GeForce 8800 GTX. La carte qui nous occupe, à savoir la GeForce 9800 GX2, termine en seconde position avec des performances 19,6 % supérieures au Radeon HD 3870 X2 d'AMD. Ici, le GeForce 9800 GX2 fait mieux que les SLI de GeForce 8800 GT et GeForce 8800 GTX.

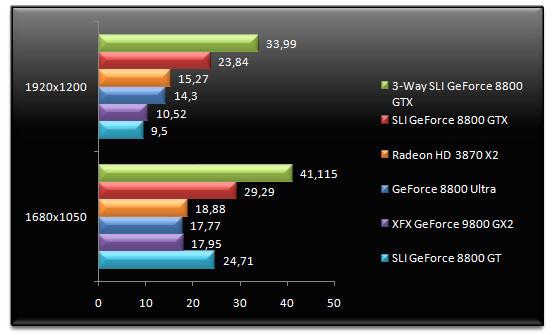

Company Of Heroes - v2.202 - DirectX 10

Le RTS Company Of Heroes, ici testé en mode DirectX 10, plaide en faveur de la solution « 3-Way SLI » de NVIDIA. On notera également les très bonnes prestations du SLI de GeForce 8800 GTX. Il est intéressant de constater qu'en 2560x1600, les performances du GeForce 9800 GX2 s'écroulent, rejoignant du reste celles du SLI de GeForce 8800 GT pour n'être plus que 20 % supérieures à celles d'une GeForce 8800 Ultra. La raison principale de cette chute des performances semble être liée à la quantité de mémoire vidéo, plus faible sur les G92 que sur les G80. Quant au Radeon HD 3870 X2, s'il est plus performant que le GeForce 8800 Ultra en 1680x1050 et en 1920x1200, il chute derrière le GeForce 8800 Ultra en 2560x1600. Dans cette résolution, la GeForce 9800 GX2 est 30 % plus rapide que la dernière carte d'AMD.

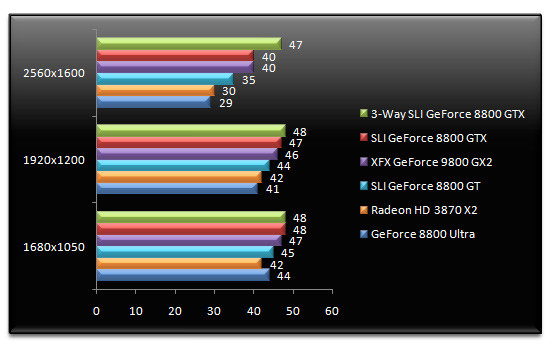

World In Conflict - DirectX 10 - v1.0007

World In Conflict fait sans surprise la part belle aux solutions SLI. La configuration à base de trois GeForce 8800 GTX est largement en tête alors que le SLI de GeForce GTX rivalise ici avec le GeForce 9800 GX2. On notera toutefois le léger avantage du GeForce 9800 GX2 sur le SLI de GeForce 8800 GT, un avantage de l'ordre de 4 % en 1920x1200. Dans cette résolution la dernière carte de NVIDIA est 9 % plus rapide que le Radeon HD 3870 X2 d'AMD.

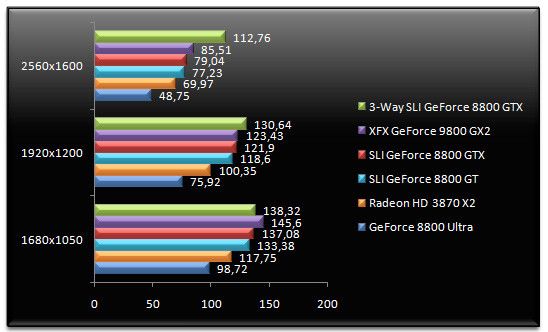

Crysis - DirectX 10 - v1.2, réglages très élevés

FPS star de la fin d'année dernière, Crysis est bien plus qu'un jeu puisqu'il s'agit d'un véritable benchmark pour cartes graphiques. Histoire de changer un peu, nous utilisons ici une démo de notre cru, réalisée sur le niveau « Ice ». Le trio de GeForce 8800 GTX donne ici les meilleures performances alors que le SLI de GeForce 8800 GTX termine second. Si en 1680x1050 et en 1920x1200 le GeForce 9800 GX2 fait aussi bien que le SLI de GeForce 8800 GTX, il s'effondre en 2560x1600, la faute à la quantité de mémoire vidéo trop réduite et à la bande passante mémoire elle aussi étriquée. De fait, en 2560x1600, la GeForce 9800 GX2 est au niveau d'une GeForce 8800 Ultra ou d'une Radeon HD 3870 X2 alors que le SLI de GeForce 8800 GT obtient dans cette résolution le plus mauvais score.

BioShock - DirectX 10 - v1.1

BioShock, surprise de la fin 2007, utilise le fameux moteur graphique Unreal Engine. En tête nous retrouvons le « 3-Way SLI » suivi du GeForce 9800 GX2. Le Radeon HD 3870 X2 ne démérite pas puisqu'il affiche de très bons scores, y compris en 2560x1600 où il se paye le luxe de rivaliser avec un SLI de GeForce 8800 GTX. Dans cette résolution, le GeForce 9800 GX2 se montre 28 % plus rapide que le Radeon HD 3870 X2. En revanche, les performances du SLI de GeForce 8800 GT sont ici nettement en retrait face au GeForce 9800 GX2, sans raison apparente.

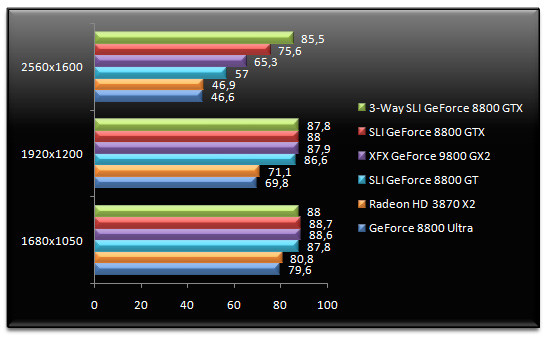

Call Of Duty 4 - v1.5 - FSAA 4x

Le test du GeForce 9800 GX2 nous sert de prétexte à l'intégration d'un nouveau bench réalisé sous Call Of Duty 4, avec une partie enregistrée par nos petites mimines. Si en 1680x1050 et en 1920x1200 nos diverses configurations sont à égalité, vraisemblablement limitées par le processeur, on observe une certaine hiérarchie en 2560x1600. Dans cette résolution, le GeForce 9800 GX2 est 14 % plus rapide que le SLI de GeForce 8800 GT alors que le SLI de GeForce 8800 GTX et plus encore le triple SLI sont en tête. Face au Radeon HD 3870 X2, le GeForce 9800 GX2 est 23 % plus performant en 1920x1200, un écart qui est identique lorsque l'on compare le GeForce 9800 GX2 au GeForce 8800 Ultra.

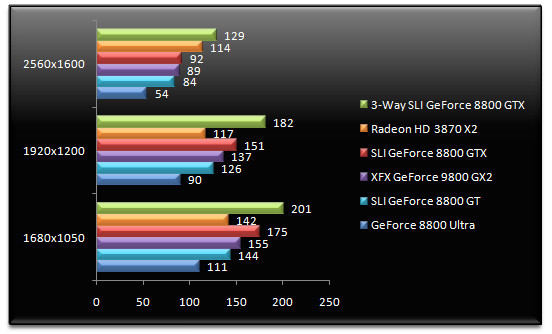

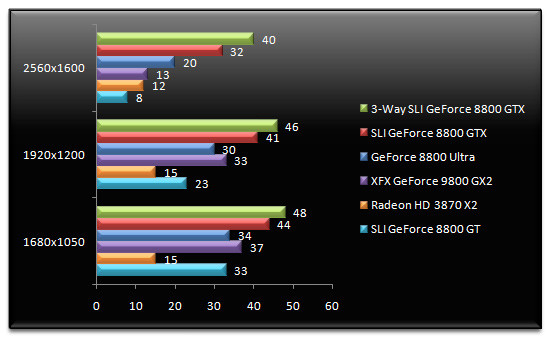

F.E.A.R. v1.08 - AA 4x AF 16x

Retour sous F.E.A.R. où nous activons cette fois-ci les fonctions d'anticrénelage. Notre solution « 3-Way SLI » conserve la tête avec des performances 44 % plus élevées que le SLI de GeForce 8800 GTX en 2560x1600. Étrangement, le SLI de GeForce 8800 GT affiche ici des performances très légèrement supérieures au GeForce 9800 GX2, peut-être du fait des versions de pilotes différentes employées entre les cartes GeForce 8 et GeForce 9. En 1680x1050 et en 1920x1200, le GeForce 9800 GX2 est plus rapide que le Radeon HD 3870 X2, mais cet avantage disparait en 2560x1600 où les cartes sont à égalité. Dans cette résolution, le GeForce 9800 GX2 est 32 % plus rapide que le GeForce 8800 Ultra.

Half-Life 2 : Episode Two - AA 4x AF 16x

Retour sous Half-Life 2, où Gordon Freeman semble bouder la solution « 3-Way SLI » lorsque les options d'anticrénelage sont actives. Du coup, le GeForce 9800 GX2 l'emporte en 2560x1600 d'une courte tête face au SLI de GeForce 8800 GTX. Dans cette résolution, le dernier bébé de NVIDIA est 12 % plus rapide que le SLI de GeForce 8800 GT. En 1920x1200, le GeForce 9800 GX2 inflige une correction au Radeon HD 3870 X2 avec des performances 28 % supérieures. Même constat en 1680x1050 où la carte signée XFX est 7 % plus performante que le Radeon HD 3870 X2.

World In Conflict - DirectX 10 - v1.0007 - AA 4x AF 16x

Pour World In Conflict, les options de filtrage ne changent guère la donne sur le duo de tête, les SLI et 3-Way SLI de GeForce 8800 GTX occupant les premières marches du podium. Si en 1680x1050 et en 1920x1200 le GeForce 9800 GX2 fait heureusement mieux que le GeForce 8800 Ultra, ce n'est pas le cas en 2560x1600 où la carte simple processeur est 54 % plus rapide que la solution GeForce 9800 GX2. C'est une fois encore la trop faible quantité de mémoire vidéo embarquée qui est visiblement responsable de cet effondrement des performances. Songez qu'en 1680x1050, la GeForce 9800 GX2 de NVIDIA est 59 % plus rapide que le Radeon HD 3870 X2 d'AMD alors qu'en 2560x1600 cet avantage chute à 8 % ! On notera toutefois que face au SLI de GeForce 8800 GT, la GeForce 9800 GX2 est plus véloce.

Enemy Territory : Quake Wars - v1.4 - AA 4x - AF 16x

L'activation des fonctions d'anticrénelage ne bouleverse pas le classement sous Quake Wars puisque Triple SLI et SLI de GeForce 8800 GTX restent en tête. Ici, le GeForce 9800 GX2 fait jeu égal avec le SLI de GeForce 8800 GT, quelle que soit la résolution, alors que l'avantage du GeForce 9800 GX2 sur le Radeon HD 3870 X2 est faible voir même nul, du moins en 1680x1050. En 1920x1200, l'avantage pour NVIDIA est de 5 % et il grimpe à 11 % en 2560x1600.

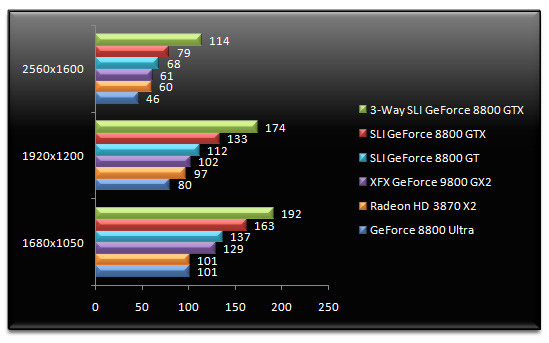

Call Of Juarez - DirectX 10 - FSAA 4x

L'activation du filtrage sous Call Of Juarez reste très largement favorable à nos trois GeForce 8800 GTX. Toutefois, le Radeon HD 3870 X2 termine ici second à égalité avec le SLI de GeForce 8800 GTX alors que le GeForce 9800 GX2 n'est pas capable de concurrencer la dernière carte graphique d'AMD. Face au GeForce 8800 Ultra, la GeForce 9800 GX2 de XFX est tout de même 44 % plus rapide en 1680x1050.

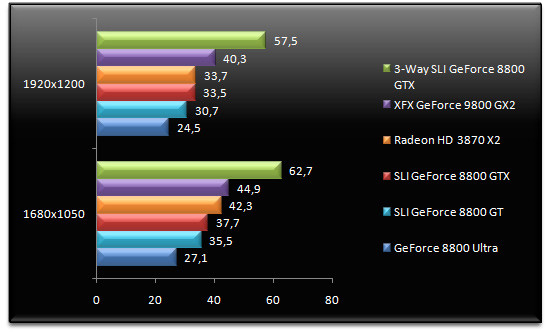

Crysis - DirectX 10 - v1.2, réglages très élevés - AA 4x

On termine avec Crysis où nous activons l'anticrénelage 4x. Les performances de nos diverses cartes sont insuffisantes pour faire tourner le jeu en 2560x1600 d'où la disparition de cette résolution de notre graphique. La bande passante mémoire étriquée et la quantité de mémoire vidéo trop faible font que le GeForce 9800 GX2 s'écroule et si curieusement le SLI de GeForce 8800 GT affiche de meilleures performances en 1680x1050, ce n'est plus le cas en 1920x1200 où le GeForce 8800 Ultra fait mieux que ce type de solutions, un comble ! Dans cette résolution, le Radeon HD 3870 X2 est 45 % plus rapide ! On aurait aimé voir la solution haut de gamme de NVIDIA plus convaincante sous Crysis une fois l'anticrénelage activé.

Conclusion

Arrivé au terme de ce test, force est de constater que le GeForce 9800 GX2 de NVIDIA s'affiche effectivement comme une nouvelle référence en matière de performances 3D. Il faut dire qu'après les épisodes GeForce 7900 GX2 et GeForce 7950 GX2, NVIDIA connait parfaitement la recette qui consiste à regrouper sur une seule et même carte deux processeurs graphiques. AMD en fait d'ailleurs les frais puisque son récent Radeon HD 3870 X2, lui aussi doté de deux puces graphiques, est ici battu.Reste que l'enthousiasme n'est pas à son zénith puisqu'au final cette GeForce 9800 GX2 se contente de performances peu ou prou similaires à celles d'un SLI de GeForce 8800 GT, ses caractéristiques étant, malgré le nom, strictement identiques à celles du GeForce 8800 GT. Certes la nouvelle-venue pourra fonctionner dans n'importe quelle machine qu'il s'agisse d'un système nForce ou non. Cette souplesse est assurément bienvenue seulement voilà à 549 euros TTC, le GeForce 9800 GX2 est particulièrement onéreux surtout lorsque ce coût est comparé à celui de deux GeForce 8800 GT ; en moyenne 420 euros TTC. En dehors du prix, déjà bien supérieur à celui d'une Radeon HD 3870 X2, la carte génère tout de même certaines nuisances puisqu'au-delà de son poids, tout de même 1,11 kg, elle requiert deux connecteurs d'alimentation PCI-Express, dont un huit broches, alors qu'elle s'avérera assez bruyante.

En contrepartie, NVIDIA nous propose pour la première fois sur son haut de gamme un connecteur HDMI et aussi un moteur de décompression vidéo matériel prenant en charge les flux H.264, deux nouveautés qui sont bienvenues. Reste qu'en faisant du neuf avec du vieux, comme AMD d'ailleurs, NVIDIA a de plus en plus de mal à cacher sur le créneau haut de gamme la stagnation des performances à laquelle on assiste depuis la sortie du GeForce 8800. Et ne rêvez pas, cette GeForce 9800 GX2 ne permettra toujours pas de jouer convenablement à Crysis en 2560x1600 : dommage !