Pour AMD, l'arrivée des Radeon HD 4850 est l'illustration concrète d'un véritable changement de stratégie déjà esquissé avec les Radeon HD de la série 3000. Plutôt que de concevoir de larges puces monolithiques, comme le fait NVIDIA avec les inconvénients que l'on sait (consommation électrique élevée, chauffe importante, etc.), la firme de Sunnyvale préfère produire des puces plus petites avec un seul objectif : le maximum de performances possible par watt consommé. Certes, ce choix laisse la place à NVIDIA sur le très haut de gamme, AMD étant obligé de réunir deux puces pour inquiéter une GeForce GTX 280. Mais sur le milieu de gamme, le choix d'AMD pourrait faire mal, très mal. Preuve en est, la sortie inattendue ce jour, du GeForce 9800 GTX+, une référence mystérieuse que nous vous présenterons un peu plus loin tout comme d'ailleurs le GeForce GTX 260 que nous n'avions pu tester jusqu'alors.

Bien qu'initialement fixé au 25 juin, le lancement des Radeon HD 4000 a été pour le moins chaotique puisqu'AMD a alimenté en masse les revendeurs depuis plusieurs semaines avec à la clé une disponibilité déjà effective des cartes Radeon HD 4850 alors même que les journalistes ne pouvaient parler des cartes avant cette date fatidique. Si nous ne félicitons pas AMD pour cette fantastique pagaille, nous avons choisi de respecter les termes originels de l'accord de confidentialité pour vous fournir un dossier complet avec un test des Radeon HD 4870, et non quelques graphiques jetés sur le papier ça et là.

AMD RV770 : L'architecture RV670 revisitée

Au cœur des Radeon HD 4000 nous retrouvons une toute nouvelle puce graphique baptisée RV770. Celle-ci reprend l'architecture unifiée DirectX 10.1 des précédentes puces RV670, tout en l'améliorant. Les équipes d'ATI/AMD se sont en effet employées à corriger ou à revisiter certaines zones du RV670 qui posaient problème à commencer par la structure même de l'architecture SIMD de la puce. Avant de rentrer dans les détails, un petit rappel s'impose. Avec les G80, G92 et plus récemment avec le G200, NVIDIA propose une architecture qu'il qualifie de SIMT c'est-à-dire « Single Instruction, Multiple Threads » et qui correspond dans la pratique à l'application d'une opération sur plusieurs threads par opposition à l'architecture SIMD, Single Instruction, Multiple Data, où une instruction de plusieurs opérations est appliquée à un élément. Techniquement, qu'il s'agisse d'architecture SIMT ou SIMD, les puces, en l'occurrence AMD ou NVIDIA, sont dans tous les cas dotées d'unités scalaires. Sur le papier le SIMT est censé être plus efficace, le programmeur n'ayant pas à se soucier du remplissage de l'unité vectorielle, ce qui n'est pas le cas du SIMD.

Découpage de la puce RV770

Bien que les puces d'AMD et de NVIDIA proposent toutes deux des architectures graphiques unifiées, elles comportent un nombre différent d'unités de traitement, autrement appelés processeurs de flux. Et la simple comparaison du nombre d'unités ne suffit pas à estimer la puissance d'une puce face à l'autre, puisque NVIDIA et AMD comptent leurs unités de calcul d'une manière différente. Ainsi si nous prenons le dernier GeForce GTX 280, il dispose de 240 processeurs de flux alors qu'AMD annonce fièrement 800 processeurs de flux pour son RV770 ! Mais à la différence du GeForce 8800 GTX qui va travailler sur 128 éléments simultanément ou du GeForce GTX 280 qui travaille sur 240 éléments en même temps, le RV770 va travailler sur 160 éléments, chaque élément pouvant contenir jusqu'à cinq instructions : ses unités de calcul sont en effet de type vec5.

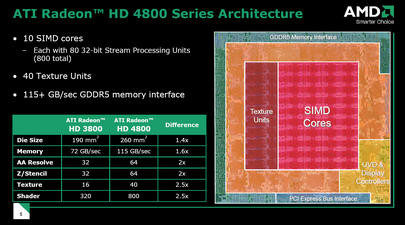

Vue d'ensemble de l'architecture du RV770

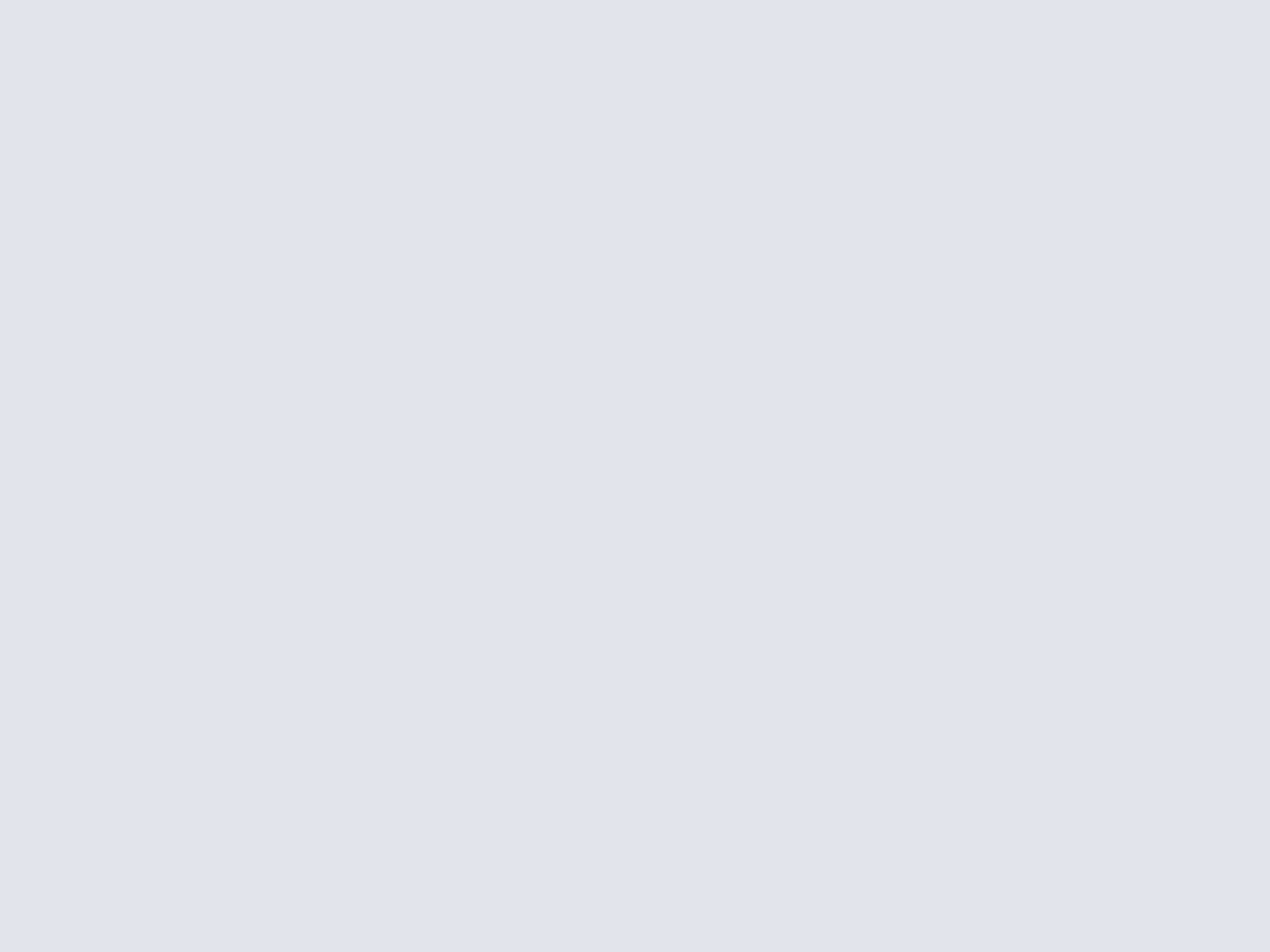

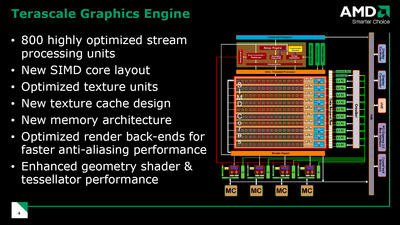

Niveau organisation, et comme évoqué plus haut, AMD a revu l'agencement des unités SIMD puisque la puce comporte un total de dix cœurs SIMD, chacun étant composé de 16 processeurs de flux de type vec5. Précédemment, les Radeon HD 3850/3870 disposaient de quatre cœurs SIMD, chacun avec 16 processeurs de flux vec5, pour un total de 320 processeurs de flux. Chaque cœur SIMD dispose de ses propres contrôles et peut travailler de manière indépendante alors que les cœurs peuvent communiquer entre eux via une mémoire cache globale partagée de 16 Ko. Par ailleurs, AMD annonce des améliorations au niveau des temps de traitement de certaines opérations par ses unités vec5, notamment en matière de double précision. Quand aux shaders de géométrie, instaurés avec DirectX 10, leur traitement est plus véloce qu'auparavant, AMD ayant augmenté le nombre maximum de threads supporté. L'unité de tesselation, introduite avec le Radeon HD 2900 et servant à multiplier les formes géométriques en partant d'une figure simple, a également fait l'objet d'améliorations pour gérer l'instancing alors qu'elle est dorénavant compatible DirectX 10 et DirectX 10.1. Reste qu'il y a hélas peu de chances pour que les développeurs l'utilisent, l'unité de tesselation d'ATI ayant jusqu'alors été boudée par la plus grande partie des créateurs de jeux vidéo.

Gros plan sur un coeur SIMD

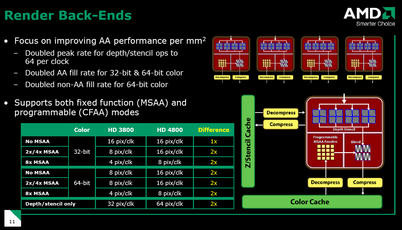

Chaque cœur SIMD dispose de sa propre unité de texture, elle-même dotée de quatre unités, soit un total de quarante processeurs de texture. AMD explique avoir revu la conception de ces unités pour une meilleure performance. C'est ainsi que par diverses petites astuces la bande passante de leur mémoire cache a été multipliée par deux ce qui influe notamment sur les performances en terme de filtrage. Autre très bonne nouvelle, AMD a enfin revu ses unités ROP en charge des derniers traitements sur les pixels et notamment responsables de l'anticrénelage. Celles-ci sont en effet bugguées depuis la sortie du R600 et AMD ne les avait pas revues avec le RV670, ce qui se traduisait par de mauvaises performances en anticrénelage. Exit les ROP buggués du R600 et place à de nouvelles unités ROP affichant de meilleures performances, les ROP du RV770 pouvant traiter deux fois plus de pixels par cycle d'horloge que celles du RV670 alias Radeon HD 3800. Précisons que face aux Radeon HD 3800, les Radeon HD 4850 et 4870 disposent du même nombre d'unités ROP, à savoir 16.

Unités ROP

Enfin, AMD revoit le contrôleur mémoire de sa puce graphique. Bien que nous soyons toujours en présence d'un contrôleur mémoire 256 bits distribué, celui-ci est maintenant doté d'un hub. Le hub est dédié au trafic à faible bande passante alors que l'on distingue à la périphérie de la puce quatre contrôleurs mémoire, placés le plus près des unités les plus consommatrices de bande passante et ce pour des temps de latence les plus faibles possibles. La conception du contrôleur mémoire a également été revue pour supporter les fréquences de fonctionnement élevées de la mémoire GDDR5 proposée avec le Radeon HD 4870. Ainsi, avec de la mémoire GDDR5, AMD peut offrir avec un bus mémoire conventionnel de 256 bits une bande passante dépassant les 100 Go/s.

AMD Radeon HD 4850/4870 : la puce RV770

Gravée en 55nm par TSMC, la puce RV770 qui anime aussi bien le Radeon HD 4850 que le Radeon HD 4870 compte 965 millions de transistors contre 666 millions pour le précédent RV670 que l'on retrouve dans les Radeon HD 3800. Qu'elle anime le Radeon HD 4850 ou le Radeon HD 4870, la puce RV770 est quoi qu'il arrive dotée du même nombre d'unités à savoir 800 processeurs de flux, 40 unités de texture et 16 unités ROP alors qu'elle utilise le bus PCI-Express de seconde génération.

AMD RV770 : la puce au coeur des Radeon HD 4000

Seules les fréquences de fonctionnement changent d'un modèle à l'autre avec 625 MHz pour le Radeon HD 4850 contre 750 MHz pour le Radeon HD 4870. Tandis que le Radeon HD 4850 utilise de la mémoire GDDR3 cadencé à 993 MHz, le Radeon HD 4870 utilise pour sa part de la mémoire GDDR5 cadencée à 1800 MHz. Ainsi quand le Radeon HD 4850 offre une bande passante théorique moyenne de 59 Go/s, le Radeon HD 4870 propose une bande passante de 107 Go/s.

De l'intérêt de la GDDR5 ?

Avec le Radeon HD 4870, AMD se montre une fois de plus à la pointe de la technologie en utilisant une toute nouvelle variété de mémoire sous la forme de la GDDR5. Rappelons qu'AMD avait par le passé déjà utilisé de la mémoire GDDR4, notamment avec le Radeon HD 3870. Alors que le standard actuel de mémoire pour les cartes graphiques est incontestablement la GDDR3, AMD cherche à se démarquer en dotant ses puces graphiques d'une mémoire ultra-rapide. Ainsi quand NVIDIA propose sur son GeForce GTX 280 un double contrôleur mémoire 256 bits, soit au final un contrôleur mémoire 512 bits, AMD préfère opter pour une mémoire véloce afin d'augmenter la bande passante mémoire, un sujet toujours aussi critique pour les performances d'une puce graphique.

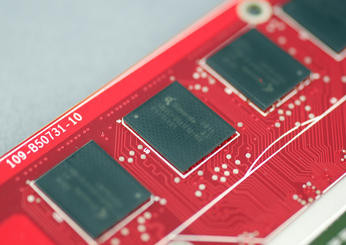

Les puces mémoire GDDR5 Qimonda du Radeon HD 4870

Face à la mémoire GDDR4 et par extension à la GDDR3, la mémoire GDDR5 offre plusieurs avantages, à commencer par une consommation électrique moindre grâce, notamment, à une tension d'alimentation plus faible (1.5 volt). On retrouve également de nouvelles fonctionnalités avec un protocole de détection des erreurs et diverses améliorations au niveau de la gestion de l'écriture et de la lecture. En termes de bande passante, une puce GDDR5 offre un débit de 4 Gbps, à 1 GHz, contre 2 Gbps pour une puce GDDR3 à la même fréquence.

AMD RV770 : Et l'UVD passe en version 2 !

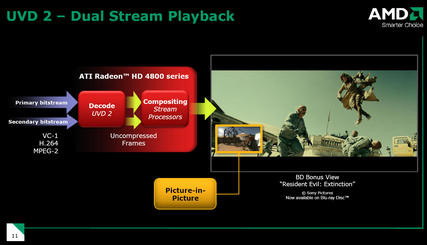

AMD profite de sa nouvelle puce pour revoir son moteur de décodage vidéo, l'UVD ou Unified Video Decoder. Ce dernier offre des capacités de décodage matériel des flux haute définition aux formats VC-1 et H.264. Les nouveautés introduites par la version 2 de l'UVD sont à chercher du côté de la prise en charge du format MPEG2 HD, une fonctionnalité qui faisait jusqu'à présent défaut aux puces AMD. En prime, AMD introduit deux nouvelles fonctionnalités dans son UVD2 avec la gestion du dual-stream à savoir la possibilité de décoder simultanément deux flux haute-définition lors de l'utilisation des fonctions PIP ou image dans l'image des derniers disques Blu-ray. Il faudra naturellement, pour en profiter, utiliser un lecteur logiciel compatible.

Moteur UVD2 : quelques améliorations pour la lecture Blu-ray

Parallèlement, ATI propose toujours une intégration des clés HDCP à sa puce alors que le HDMI est également géré. Comme c'était le cas avec les Radeon HD des séries 2000/3000, la série Radeon HD 4000 dispose d'un contrôleur audio intégré. Celui-ci a pour but d'envoyer directement le signal audio sur l'interface HDMI de la carte, sans branchement annexe comme sur les cartes NVIDIA où il faut ponter à la carte son de la carte mère un câble SPDIF. Problème : toutes les cartes mères n'ont pas de connectique SPDIF... Autre problème, le circuit audio intégré des Radeon HD 2000/3000 était limité à une prise en charge audio sur six canaux et des normes comme le DTS HD ou le Dolby TrueHD n'étaient pas gérées, HDMI 1.2 oblige. AMD revient sur cette limitation et propose dorénavant une implémentation HDMI 1.3 compatible donc avec les flux audio 7.1 et les encodages précédemment cités, à condition bien sûr d'avoir un décodeur capable de lire ces formats.

Enfin, du côté des fonctionnalités AVIVO, du nom du moteur de post-traitement des vidéos, AMD propose un nouvel algorithme de mise à l'échelle de l'image en provenance des DVD pour les afficher sur des écrans à la résolution HD alors qu'il est question de nouvelles fonctions d'augmentation automatique et dynamique du contraste des vidéos, comme avec les derniers pilotes NVIDIA.

Consommation électrique et PowerPlay

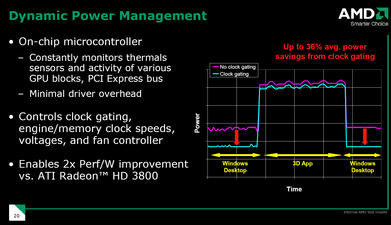

La consommation électrique des puces graphiques est un sujet brûlant et alors que NVIDIA mettait en avant ses nouvelles technologies d'économie d'énergie sur ses GeForce GTX de la série 200, AMD vante les mérites de sa technologie PowerPlay. Il s'agit de la seconde génération de la dite technologique lorsque l'on considère les puces graphiques pour ordinateurs de bureau, le PowerPlay existant depuis bien plus longtemps sur les puces à destination des ordinateurs portables.

Technologie PowerPlay

Le but de la technologie PowerPlay est d'ajuster les fréquences de la puce et de la mémoire en fonction de la charge graphique alors que des technologies dites de « clock gating » permettent de désactiver des zones entières de la puce lorsque celles-ci ne sont pas requises. Pour cela, AMD intègre un micro-contrôleur directement au sein de la puce graphique afin de surveiller en temps réel les divers paramètres comme l'activité des blocs de la puce, l'activité du bus PCI-Express ou encore la température de la puce afin d'ajuster en fonction ses paramètres d'alimentation.

| GeForce 8800 Ultra | GeForce 9800 GTX | GeForce 9800 GTX+ | GeForce GTX 280 | GeForce GTX 260 | Radeon HD 4850 | Radeon HD 4870 | |

| Consommation « idle » | 109,8 Watts | 102,6 Watts | 100,2 Watts | 111 Watts | 106,2 Watts | 102,6 Watts | 109,8 Watts |

| Consommation en charge | 168 Watts | 154 Watts | 159 Watts | 233 Watts | 161,4 Watts | 148,2 Watts | 157,8 Watts |

Au moyen de pinces ampèremétriques, nous avons mesuré l'intensité du courant qui traverse les câbles d'alimentation électrique PCI-Express de nos diverses cartes graphiques. Comme on peut le constater, en charge les nouvelles Radeon HD 4000 consomment sensiblement moins que les dernières GeForce, puisqu'un Radeon HD 4870 nécessitera environ 4 Watts de moins qu'un GeForce GTX 260. Le Radeon HD 4850 consomme de son côté 6 Watts de moins que le GeForce 9800 GTX. Enfin, en idle, les cartes AMD sont celles qui consomment le moins au global. On notera toutefois une consommation électrique identique entre le Radeon HD 4850 et le GeForce 9800 GTX. Quant au nouveau GeForce 9800 GTX+ dont nous vous parlerons plus loin, celui-ci consomme légèrement plus en charge que le modèle GTX malgré sa finesse de gravure supérieure.

AMD Radeon HD 4850 : la carte signée Sapphire

Pour ce test, le fabricant Sapphire nous a fait parvenir une Radeon HD 4850, une carte purement basée sur le design de référence élaboré par AMD. Dotée d'un PCB rouge, la carte est identique au Radeon HD 3850, qu'il s'agisse de sa longueur, un peu plus de 23 centimètres, ou du système de refroidissement utilisé.

Radeon HD 4850 par Sapphire

Interfacée en PCI-Express 16x, la carte dispose d'un connecteur d'alimentation électrique PCI-Express à six broches et se dote de deux connecteurs CrossFire. Quelques mots sur le système de refroidissement, ici constitué d'un radiateur en cuivre reposant sur la puce graphique et les puces mémoire, au moyen de pads thermiques pour ces dernières, et muni en son extrémité d'un ventilateur. Contrairement aux cartes concurrentes, on pense bien sûr aux GeForce 9800 GTX, la Radeon HD 4850 a le bon goût de rester au format simple slot, un choix que nous saluons. Côté mémoire, la carte est pourvue de 512 Mo de mémoire vidéo en GDDR3 et il s'agit ici de puces signées Qimonda. En sortie, cette Radeon HD 4850 propose deux connecteurs DVI ainsi qu'une prise mini-DIN utile pour les sorties vidéos analogiques. La connectique HDMI s'obtient au moyen d'un adaptateur DVI/HDMI du reste fourni par Sapphire.

AMD Radeon HD 4870 : la carte... elle aussi signée Sapphire

Plus difficile d'approvisionnement, le Radeon HD 4870 nous est parvenu dans une version portant lui aussi les couleurs de Sapphire. Double-slot, la carte se présente au format PCI-Express 16x et mesure 24 centimètres de long. Elle dispose de deux connecteurs d'alimentation électrique PCI-Express et se dote naturellement de deux connecteurs Crossfire sur le rebord du PCB. Le système de ventilation est naturellement massif avec un cœur cuivre reposant sur la puce graphique et doté de deux heat-pipes connectés à un radiateur à ailettes en aluminium. Le tout est enchâssé dans une coque de plastique translucide dotée en son extrémité d'un ventilateur cage d'écureuil, un ventilateur qui sait rester discret et expulse l'air chaud à l'extérieur de l'ordinateur.

Radeon HD 4870 : la carte par Sapphire

Les puces mémoire sont quant à elles pourvues de pads thermiques qui font contact avec la base métallique du système de refroidissement. Avec 512 Mo de mémoire vidéo, la carte utilise de la mémoire GDDR5 signée Qimonda. Avec deux connecteurs DVI en sortie, la carte dispose d'un connecteur mini-DIN pour les sorties vidéos analogiques. Naturellement, et à l'instar des Radeon HD 2000/3000, un connecteur DVI/HDMI, livré par le fabricant de la carte, permet de transformer un connecteur DVI en HDMI. On notera, pour la petite histoire, la présence sur la tranche de la carte d'un logo ATI Radeon qui n'est pas sans rappeler le logo GeForce récemment apparu sur les dernières cartes graphiques de la firme au caméléon.

Et NVIDIA refait parler de lui avec le GeForce 9800 GTX+

Techniquement, la puce qui anime le GeForce 9800 GTX+ reste un G92 avec 128 processeurs de flux et une prise en charge DirectX 10. La grande nouveauté vient de la finesse de gravure de cette puce puisque NVIDIA passe du 65nm au 55nm, toujours chez TSMC. Ce changement permet à NVIDIA de revoir les fréquences à la hausse et c'est ainsi que les processeurs de flux opèrent à 1836 MHz quand le reste de la puce est cadencé à 738 MHz. Face au GeForce 9800 GTX premier du nom, le gain en terme de fréquence est de 148 MHz pour les processeurs de flux et de 63 MHz pour la puce, soit respectivement une hausse de 8 et 9%.

| GeForce 9800 GTX | GeForce 9800 GTX+ | Radeon HD 3870 | Radeon HD 4850 | Radeon HD 4870 | GeForce GTX 280 | |

| Interface | PCI-Ex. 16x - Gen2 | PCI-Ex. 16x | PCI-Ex. 16x | PCI-Ex. 16x - Gen2 | PCI-Ex. 16x - Gen2 | PCI-Ex. 16x - Gen2 |

| Gravure | 0,065 µ | 0,055nm µ | 0,055 µ | 0,055 µ | 0,055 µ | 0,065 µ |

| Transistors | 754 Millions | 754 Millions | 666 Millions | 956 Millions | 956 Millions | 1,4 Milliards |

| RAMDAC | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz |

| T&L | DirectX 10 | DirectX 10 | DirectX 10.1 | DirectX 10.1 | DirectX 10.1 | DirectX 10 |

| Stream Processors | 128 | 128 | 320 | 800 | 800 | 240 |

| Unités ROP | 16 | 16 | 16 | 16 | 16 | 32 |

| Mémoire embarquée | 512 Mo | 512 Mo | 512 Mo | 512 Mo | 512 Mo | 1024 Mo |

| Interface mémoire | 256 bits | 256 Bits | 256 bits | 256 bits | 256 bits | 512 bits |

| Bande passante | 70,4 Go/s | 64 Go/s | 73,4 Go/s | 59 Go/s | 107 Go/s | 142 Go/s |

| Fréquence GPU | 675 MHz | 738 MHz | 775 MHz | 625 MHz | 750 MHz | 602 MHz |

| Fréquence Stream Processors | 1688 MHz | 1836 MHz | 775 MHz | 625 MHz | 750 MHz | 1296 MHz |

| Fréquence mémoire | 1100 MHz | 1000 MHz | 1,12 GHz | 993 MHz (GDDR3) | 900 MHz (GDDR5) | 1107 MHz |

Caractéristiques comparées du GeForce 9800 GTX+ aux autres puces

Le reste des caractéristiques de la carte coïncide avec le précédent mais tout récent GeForce 9800 GTX puisque nous sommes toujours en présence d'une puce interfacée en PCI-Express 2.0 avec support du SLI et du 3-Way SLI alors que côté mémoire, NVIDIA reste fidèle à la GDDR3 et à un bus de 256 bits. Faute de nouveauté réelle, hormis cette évidente montée en fréquence, NVIDIA tente de mettre en avant ses technologies visant à utiliser la puce graphique comme un coprocesseur.

NVIDIA GeForce 9800 GTX+ : on avait dit pas le physique !

Avec le rachat d'Ageia, NVIDIA s'est mis dans l'idée de proposer une accélération matérielle des effets physiques par la puce graphique en utilisant tout simplement sa technologie CUDA. Rappelons brièvement que CUDA permet d'utiliser la puce graphique comme un processeur généraliste. Sur le papier, cette ambition est plutôt louable. Oui mais voilà, dans son désir ardent de faire à tout prix parler de lui avec une technologie que ne propose pas AMD, NVIDIA nous prendrait presque pour des candides. Dans sa communication autour des pilotes PhysX, la firme évoque la prise en charge de 140 jeux optimisés PhysX. Certes, sauf que dans cette liste 138 des 140 titres se contentent d'un traitement purement logiciel de la physique... Certains jeux pourront effectivement exploiter la puce graphique comme un processeur physique via une mise à jour de l'API PhysX mais d'autres nécessiteront obligatoirement un patch, patch dont la sortie est au bon vouloir de l'éditeur du jeu.

Bref... pour le lancement de PhysX, NVIDIA propose à la presse un pilote supportant la bagatelle de ... deux titres : 3DMark Vantage et Unreal Tournament via une map spécifique... On a tout de même connu plus convaincant comme lancement. Et encore, nous n'avons pas abordé le vaste débat concernant l'à propos d'utiliser le GPU pour traiter la physique plutôt que l'un des cœurs du processeur de votre machine. Car quand Intel s'apprête à lancer des processeurs huit cœurs en 2009, il faudra bien les utiliser pour faire autre chose que du traitement de texte, et le calcul d'effet physique paraît un bon choix... Affaire à suivre !

NVIDIA GeForce 9800 GTX+ : la carte

Pour tester le GeForce 9800 GTX+, NVIDIA nous a fait parvenir une carte de référence. Celle-ci est en tout point identique au GeForce 9800 GTX avec un design double-slot. Si l'on aurait pu espérer que le passage en 55nm permette de faire une carte un peu moins encombrante, ce n'est hélas pas le cas. On se retrouve donc avec une carte interfacée en PCI-Express avec une longueur d'environ 27 centimètres et un système de refroidissement plutôt large. Comme sur toutes les dernières cartes NVIDIA, l'ensemble est caréné dans une coque de plastique ce qui protège les divers composants alors qu'un large ventilateur de type cage d'écureuil assure le refroidissement en expulsant l'air chaud à l'extérieur du système.

Avec un double connecteur SLI, le GeForce 9800 GTX+ dispose de deux connecteurs d'alimentation PCI-Express six broches et embarque... 512 Mo de mémoire vidéo GDDR3. On retrouve en sortie deux connecteurs DVI et un connecteur mini-DIN pour les sorties vidéos analogiques. Précisons que la carte supporte la récente technologie Hybrid Power introduite par NVIDIA et permettant, sur les plate-formes nForce, de couper totalement son alimentation électrique pour basculer sur le chipset graphique de la carte mère lorsque les tâches en cours d'exécution ne requièrent pas une puissance 3D élevée.

NVIDIA GeForce GTX 260 : Tour d'horizon

Parallèlement au lancement du GeForce GTX 280, NVIDIA sortait il y a tout juste une semaine le GeForce GTX 260, une version un tantinet plus modeste que le modèle précité. Faute de disponibilité, nous n'avions pu tester la carte en question la semaine dernière. Ce test nous permet de revenir sur cette lacune et avant de vous présenter le modèle Point Of View, il nous faut énumérer les caractéristiques du GeForce GTX 260.Gravé en 65nm, et basé sur la seconde génération d'architecture unifiée de NVIDIA, le GeForce GTX 260 est une puce DirectX 10 bénéficiant de plusieurs améliorations architecturales face au G92 qui anime notamment le GeForce 9800 GTX+ présenté en page précédente. Ces améliorations étant identiques à celles du GeForce GTX 280 nous ne les détaillerons pas plus, préférant vous renvoyer à notre précédent dossier. Face au GeForce GTX 280, le GeForce GTX 260 subit quelques coupes sombres avec un nombre plus restreint de processeurs de flux, NVIDIA désactivant tout simplement certaines partitions de la puce. Alors que son grand frère embarque 240 processeurs de flux, le GeForce GTX 260 devra se contenter de 192 processeurs de flux, soit 8 partitions actives contre 10 sur le modèle 280. Cela implique bien sûr un nombre d'unités ROP plus faible avec 28 ROP pour le GeForce GTX 260 contre 32 pour le grand frère. Ce n'est du reste pas le seul ajustement puisque outre les fréquences que nous évoquerons un peu plus loin, le GeForce GTX 260 est pourvu d'un bus mémoire.... 448 bits ! NVIDIA nous refait ici le coup des GeForce 8 avec un contrôleur mémoire 256 bits et un second contrôleur 128 bits. De fait, la capacité mémoire maximale adressable par la puce est limitée à 896 Mo alors que la firme de Santa Clara reste ici fidèle à la GDDR3.

Côté fréquences de fonctionnement, et du fait du nombre élevé de transistors, sans parler du procédé de fabrication un rien daté, le GeForce GTX 260 affiche des fréquences pour le moins modestes face au GeForce 9800 GTX+. Les processeurs de flux sont ici cadencés à 1242 MHz contre 1296 MHz pour le GeForce GTX 280 et 1836 MHz pour le GeForce 9800 GTX+... Côté mémoire on passe de 1107 MHz pour le GeForce GTX 280 à 1000 MHz ce qui, cumulé avec l'interface mémoire plus faible, rabaisse la bande passante mémoire théorique à 104,3 Go/s pour le GeForce GTX 260. Voilà pour les grandes lignes de ce GeForce GTX 260.

Point Of View GeForce GTX 260 : la carte

Difficile de distinguer au premier coup d'œil une GeForce GTX 280 d'une GeForce GTX 260. Les deux cartes sont physiquement identiques, avec un design fermé, et seul le nombre de broches des connecteurs d'alimentation PCI-Express permet de faire rapidement le distinguo. Alors que le GeForce GTX 280 dispose d'un connecteur électrique PCI- Express 6 broches et d'un second connecteur PCI-Express 8 broches, le GeForce GTX 260 embarque deux connecteurs PCI-Express 6 broches. Pour le reste, la carte de Point Of View dispose donc du même système de refroidissement que les GeForce GTX 280, composé d'un radiateur dont le socle est en cuivre alors qu'un ventilateur type cage d'écureuil souffle sur ses ailettes pour expulser l'air chaud à l'extérieur de la carte.

Avec 896 Mo de mémoire vidéo, le GeForce GTX 260 fait appel à des puces mémoire Hynix certifiées à 0.8ns alors que Point Of View propose en sortie deux connecteurs DVI en plus du connecteur mini-DIN utilisée pour les sorties vidéos analogiques. Notez la présence, sur la tranche de la carte graphique d'un connecteur SPDIF qui permet de récupérer le signal audio en provenance de la carte son afin de l'injecter sur le bus HDMI.

- Carte mère Asus P5E3 Premium - (BIOS 0402),

- Processeur Intel Core 2 Extreme QX9650 (3 GHz),

- 2x 1 Go mémoire DDR3 Corsair CM3X1024-1800C7 @ 1333,

- Disque dur Western Digital Raptor 150 Go - Serial-ATA 150

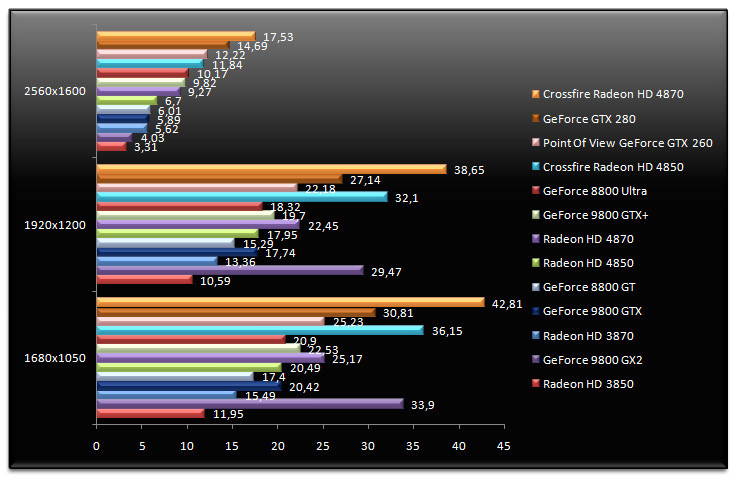

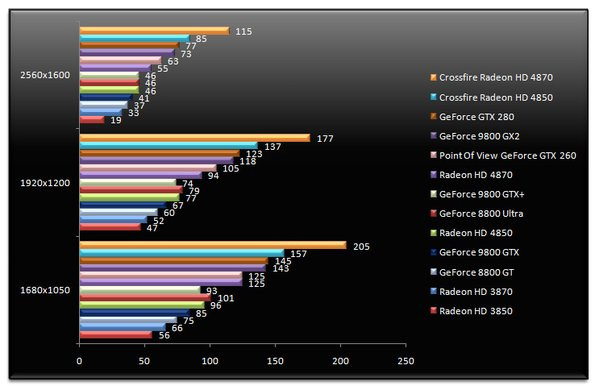

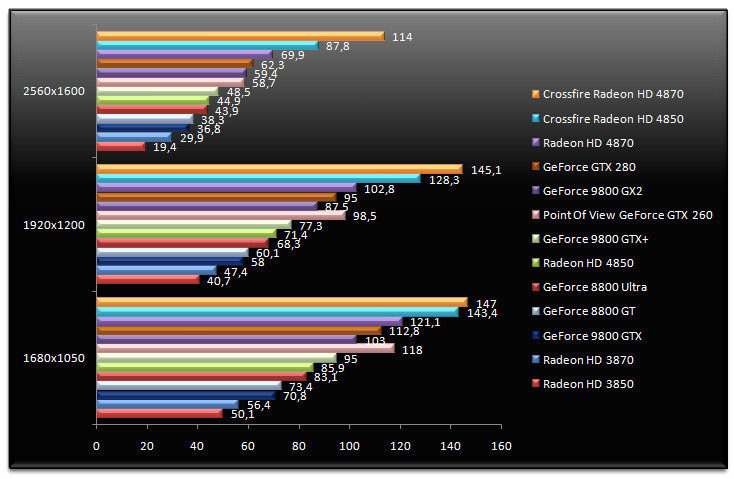

3DMark Vantage

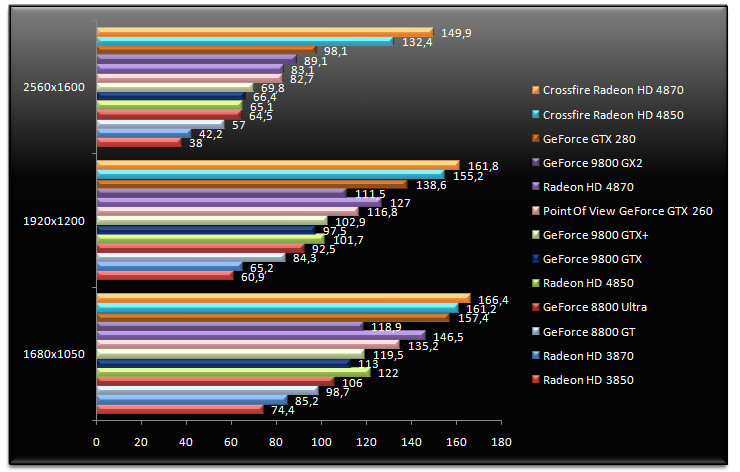

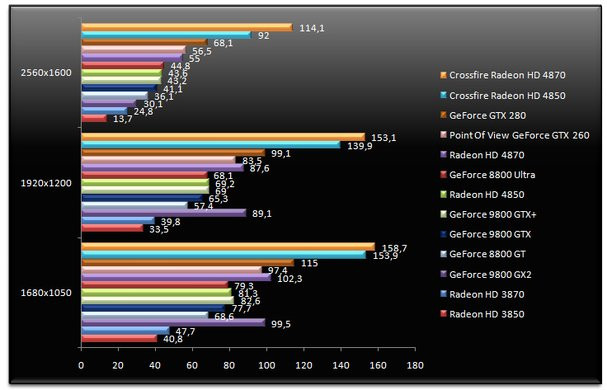

On démarre notre série de tests avec 3DMark Vantage. La dernière mouture de l'outil de test 3D de FutureMark donne nos deux configurations Crossfire largement gagnantes. Utilisé seul, le Radeon HD 4850 est supérieur en terme de performances aux GeForce 8800 Ultra, GeForce 9800 GTX et GeForce 9800 GTX+. Face à son prédécesseur, le Radeon HD 3850, le nouveau Radeon HD 4850 offre des performances deux fois supérieures, un tel écart étant avant tout justifié par la différence de quantité mémoire sur la carte : 256 Mo pour le Radeon HD 3850 et 512 Mo pour le nouveau Radeon HD 4850. Ici, le GeForce GTX 260 se montre 26% plus rapide que le Radeon HD 4850, alors que le Radeon HD 4870 le devance de justesse.

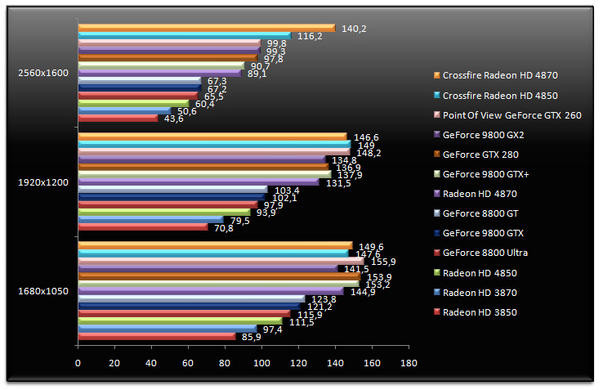

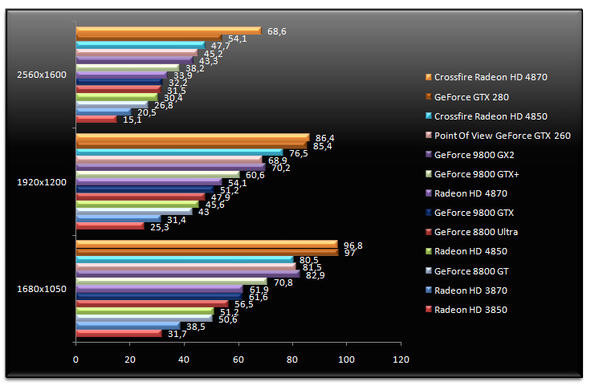

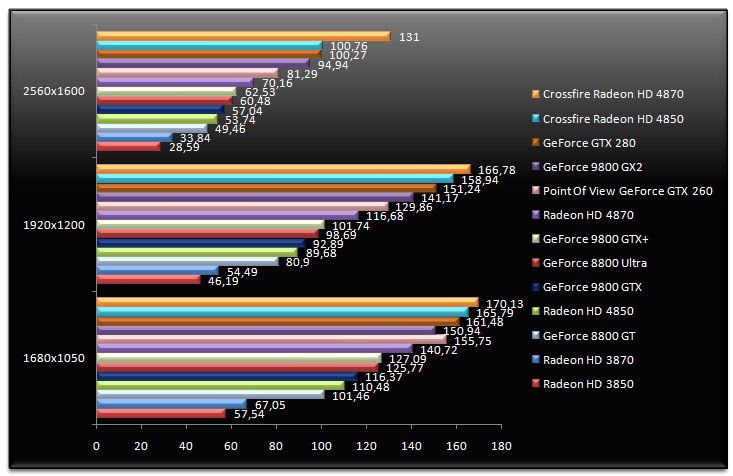

Enemy Territory : Quake Wars - v1.4

Sous Quake Wars, les nouvelles Radeon affichent des performances assez intéressantes bien que le Radeon HD 4850 laisse ici passer les GeForce 9800 GTX et GeForce 9800 GTX+. Le Radeon HD 4870 fait d'ailleurs mieux que les GeForce 8800 Ultra et GeForce 9800 GTX sans toutefois égaler le GeForce 9800 GTX+. Ce dernier affiche des performances 35% supérieures au GeForce 9800 GTX alors que le GeForce GTX 260 caracole en tête avec le GeForce GTX 280. Comparé au Radeon HD 3850, le Radeon HD 4850 est 33% plus performante.

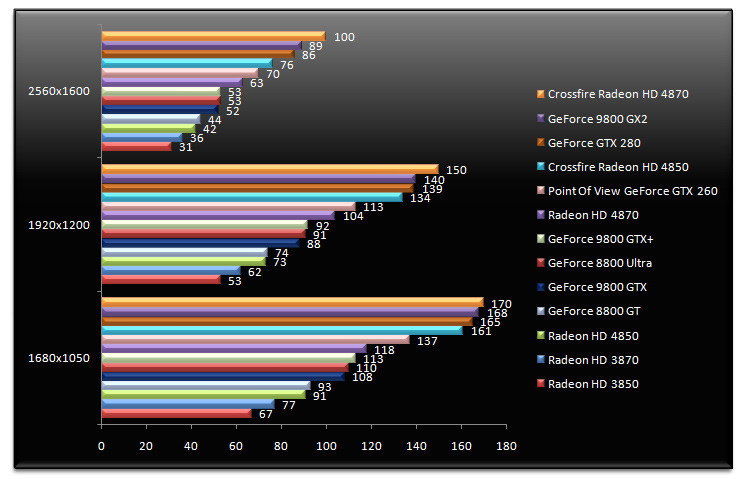

F.E.A.R. - v1.08

Petit détour sous F.E.A.R. où le Crossfire de Radeon HD 4870 est plus qu'en tête. En troisième position nous retrouvons le GeForce GTX 280, ce dernier affichant des performances 23% supérieures au GeForce GTX 260 en 1920x1200. De son côté, le Radeon HD 4850 devance le Radeon HD 3870 alors que le passage en Crossfire augmente ses performances de la bagatelle de 83% ! Quant au GeForce 9800 GTX+, il est 4% plus rapide que le GeForce 9800 GTX. C'est peu même si les performances affichées sont supérieures au Radeon HD 4850.

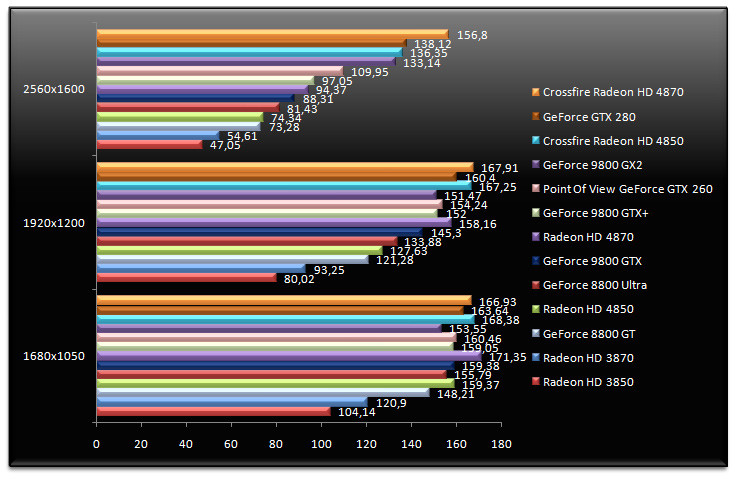

Half-Life 2 - Episode Two

Alors que les performances d'Half-Life 2 Episode Two sont limitées par le processeur en 1680x1050 et en 1920x1200, il faut passer en 2560x1600 pour observer une certaine hiérarchie entre nos cartes. Le Crossfire de Radeon HD 4870 ravit au GeForce GTX 280 la première place alors que le Crossfire de Radeon HD 4850 termine troisième. Le Radeon HD 4850 affiche ici des performances presque équivalentes au GeForce 8800 Ultra alors que le Radeon HD 4870 devance le nouveau GeForce 9800 GTX+. Ce dernier est 4% plus rapide que le GeForce 9800 GTX. Quant au GeForce GTX 260, il est 13% plus rapide que le GeForce 9800 GTX+ en 2560x1600.

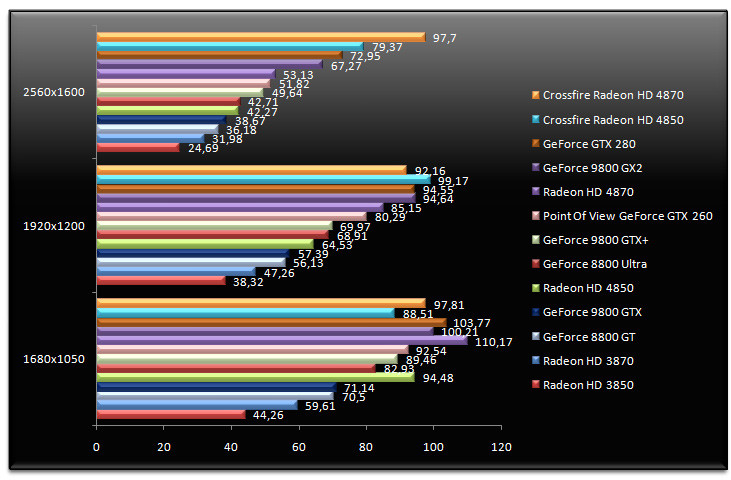

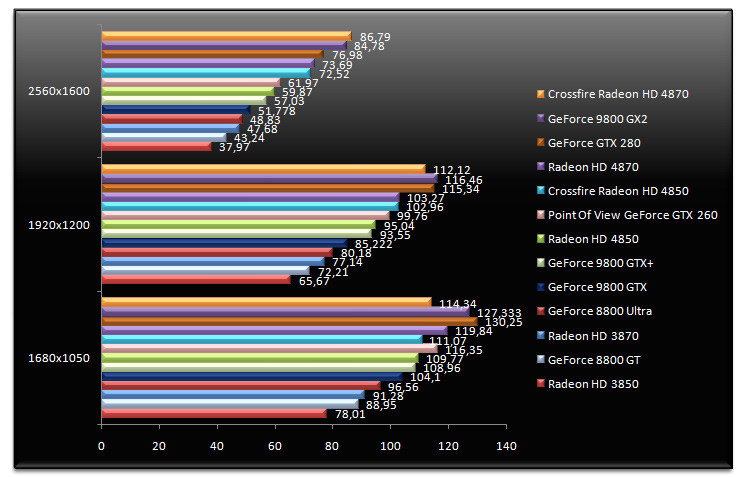

Unreal Tournament 3 - v1.2 - War Serenity Bot

Sous Unreal Tournament 3, les Crossfire restent largement en tête. C'est ainsi que le Crossfire de Radeon HD 4850 se paye le luxe de devancer le GeFOrce GTX 280. Le Radeon HD 4850 est ici devant le GeForce 9800 GTX en terme de performances alors qu'il égale à quelques centièmes d'images à la seconde le GeForce 8800 Ultra. Comparé au Radeon HD 4850, le Radeon HD 4870 est 32% plus performant en 1920x1200. Quant au GeForce 9800 GTX+, il affiche en 1920x1200 des performances 22% supérieures au GeForce 9800 GTX.

Company Of Heroes - v2.301 - DirectX 10

Le RTS Company Of Heroes affiche des scores particulièrement intéressants. En 1680x1050 et en 1920x1200, le Crossfire de Radeon HD4870 est à égalité avec le GeForce GTX280 alors que ce dernier capitule en 2560x1600 laissant le champ libre à notre configuration Crossfire. Dans tous les cas, le Crossfire de Radeon HD 4850 reste en retrait face au GeForce GTX 280. Comparé au GeForce GTX 260, le GeForce GTX 280 reste 24% plus rapide alors que le GeForce 9800 GTX+ affiche de son côté un surcroit de performances de l'ordre de 18% face au GeForce 9800 GTX. Quant au Radeon HD 4850, il est 6% plus rapide que le GeForce 8800 GT quand le modèle HD 4870 supplante les GeForce 8800 Ultra et 9800 GTX. Signalons enfin que le passage en Crossfire du Radeon HD 4850 augmente ici les performances de 67%.

World In Conflict - DirectX 10 - v1.0007

Deuxième jeu de stratégie de notre sélection, World In Conflict fait l'apologie des configurations Crossfire, le Crossfire de Radeon HD 4850 étant plus rapide que le GeForce GTX 280 en 2560x1600. Du reste, ce bon résultat s'exprime uniquement en 2560x1600, les plate-formes Crossfire étant visiblement limitées dans les résolutions inférieures. Le Radeon HD 4850 confirme ici ses bonnes performances, pratiquement du niveau du GeForce 8800 Ultra, alors que le GeForce 9800 GTX+ est 5% plus performant que le GeForce 9800 GTX. Face au Radeon HD 4850, le Radeon HD 4870 est 13% plus rapide en 1920x1200.

Crysis - DirectX 10 - v1.2, réglages très élevés

Le récent Crysis nous permet d'évaluer, avec notre propre démo, les performances des diverses cartes graphiques DirectX 10 de nore sélection. Le Crossfire de Radeon HD 4870 affiche des performances assez impresionnantes alors que le GeForce GTX 280 parvient à maintenir sa seconde place en 2560x1600. Ce n'est toutefois pas le cas des résolutions inférieures où le Crossfire de Radeon HD 4850 le devance systématiquement. Plus rapide que le GeForce 8800 GT, le Radeon HD 4850 fait ici jeu égal avec le GeForce 9800 GTX. Quant au GeForce 9800 GTX+, ses performances sont 11% supérieures au GeForce 9800 GTX original en 1920x1200. On retiendra du Radeon HD 4870, des performances 25% plus élevées que le Radeon HD 4850 toujours en 1920x1200.

BioShock - DirectX 10 - v1.1

Basé sur le moteur graphique Unreal Engine, Bioshock était le FPS révélation de la fin d'année 2007. Côté performances le Radeon HD 4850 devance ici toutes les GeForce 9, puisque la petite dernière d'AMD fait mieux que le GeForce 9800 GTX+ ! Ce dernier est du reste 9% plus rapide que le GeForce 9800 GTX original. Quant au Radeon HD 4870 il talonne régulièrement le GeForce GTX 280. Et puisque nous évoquons la dernière série de processeurs graphiques GeForce, sachez que le GeForce GTX 260 est très légèrement plus rapide que le Radeon HD 4850 avec un avantage de 3,5% en 2560x1600. Pour finir le passage d'une Radeon HD 4850 à deux cartes en Crossfire se traduit par une hausse des performances d'environ 8% en 1920x1200 et 22% en 2560x1600 : ici le rendu multi-GPU n'est pas forcément au meilleur de sa forme.

Call Of Duty 4 - v1.6

Le récent FPS Call Of Duty 4 est ici utilisé avec une démo de notre cru. On en retire les enseignements suivants avec des configurations Crossfire qui poutrent et un Radeon HD 4850 plus rapide que le GeForce 8800 Ultra et ce même en 1680x1050. Côté NVIDIA, le GeForce 9800 GTX+ est 5% plus rapide que le GeForce 9800 GTX en 1920x1200 alors que le GeForce GTX 260 se fait devancer par un Radeon HD 4870 8% plus rapide. L'écart de performances entre le Radeon HD 4870 et le Radeon HD 4850 s'établit à 27% en 2560x1600. Dans cette résolution, le Crossfire de Radeon HD 4850 est tout simplement deux fois plus rapide qu'une Radeon HD 4850.

Call Of Juarez - DirectX 10

On termine cette seconde page de tests avec Call Of Juarez. Un titre qui plébiscite les configurations Crossfire. On notera que le Radeon HD 4870 se montre plus rapide que les GeForce 9800 GX2 et GeForce GTX 280 alors que son petit frère, le Radeon HD 4850, est ici plus rapide que le GeForce GTX 260. Quant à l'écart entre le GeForce 9800 GTX+ et le GeForce 9800 GTX, il tourne autour des 12%.

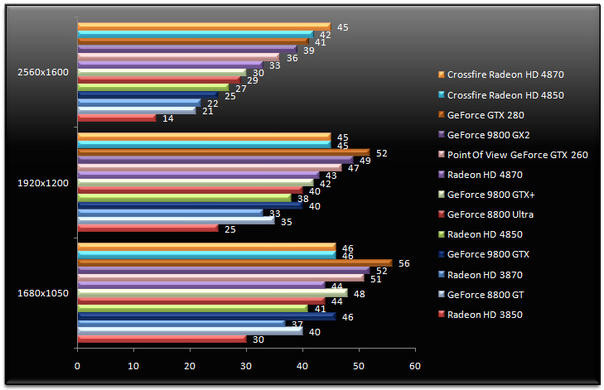

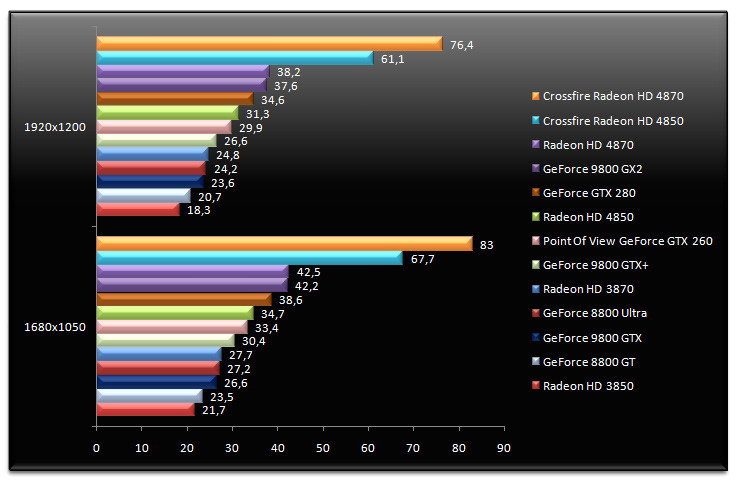

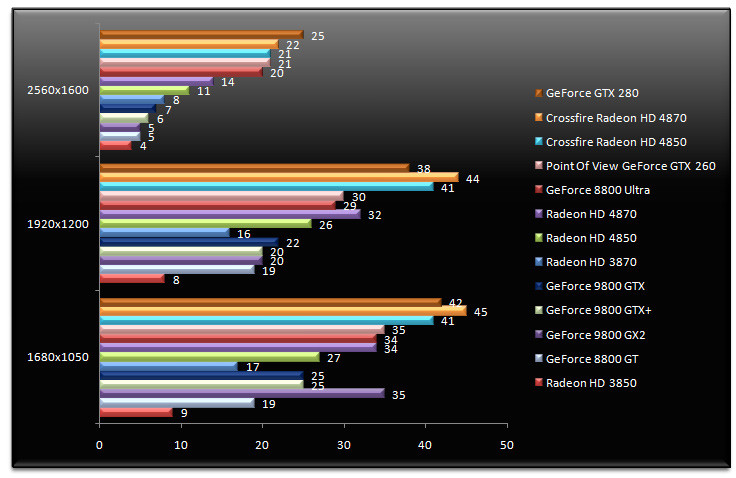

Call Of Duty 4 - v1.6 - FSAA 4x & AF 16x

Cette troisième page est traditionnelement dédiée aux tests de performance en AA. Cet article n'échappe pas à la règle et on démarre avec Call Of Duty 4. Visiblement les changements apportés aux unités ROP font leur effet puisqu'en 1920x1200 le Radeon HD 4850 est plus rapide que les GeForce 9800 GTX et GTX+ alors qu'il devance même (de peu il est vrai) le GeForce 8800 Ultra. Cela ne suffit toutefois pas pour inquiéter les GeForce GTX 260 et 280, le Radeon HD 4870 terminant à quelques fps du GeForce GTX 260. Face au Radeon HD 4850, le Radeon HD 4870 est 26% plus rapide. Quant aux configurations Crossfire, elles font merveille tout simplement avec des performances largement supérieures au GeForce GTX 280.

F.E.A.R. v1.08 - AA 4x AF 16x

Les observations formulées précédemment restent valables sous F.E.A.R bien que le GeForce GTX 280 soit ici beaucoup plus proche du Crossfire de Radeon HD 4850. Utilisé seul le Radeon HD 4850 demeure plus rapide qu'une GeForce 9800 GTX et fait jeu égal avec le GeForce 8800 ULtra et le GeForce 9800 GTX+ en 2560x1600. Le petit dernier de NVIDIA est d'ailleurs 10% plus rapide que le GeForce 9800 GTX. Le GeForce GTX 260 affiche pour sa part des performances égales en faible résolution au Radeon HD 4870 alors qu'il affiche une certaine supériorité plus la résolution augmente. Le Radeon HD 4870 se montre ici 22% plus rapide que le Radeon HD 4850.

Half-Life 2 : Episode Two - AA 4x AF 16x

L'activation des options de filtrage semble moins réussir aux nouvelles Radeon HD 4000 sous Half-Life 2 : Episode Two que sous les autres tests. En effet notre Radeon HD 4850 termine ici légèrement en retrait face au GeForce 9800 GTX alors qu'il fait heureusement mieux que le GeForce 8800 GT. Le Radoen HD 4870 est en revanche en mesure de s'approcher du GeForce GTX 260 même si ce dernier conserve un avantage d'environ 11% en 1680x1050. Quant au GeForce GTX 280 il fait jeu égal avec le Crossfire de Radeon HD 4850, laissant le Crossfire de Radeon HD 4870 parader en tête.

World In Conflict - DirectX 10 - v1.0007 - AA 4x AF 16x

Surprise ! Sous World In Conflict, l'activation du filtrage donne le GeForce GTX 280 gagnant en 2560x1600 devant les configurations Crossfire alors que les performances du GeForce 9800 GTX+ sont en retrait face au GeForce 9800 GTX et ce dans toutes les résolutions ! Radeon HD 4850 et Radeon HD 4870 affichent des performances supérieures aux GeForce 9800 GTX et autres GeForce 8800 GTalors que le Radeon HDD 4870 bat le GeForce 8800 Ultra en 1920x1200. L'écart entre Radeon HD 4850 et Radeon HD 4870 s'élève par ailleurs à 27%. Quant au passage en Crossfire, il augmente les performances de 57% en 1920x1200 pour le Radeon HD 4850. Terminons par un mot sur le GeForce GTX 260 qui s'affiche à peine plus rapide qu'un GeForce 8800 Ultra et dont les performances sont inférieures au Radeon HD 4870 en 1920x1200 alors que la tendance s'inverse du tout au tout en 2560x1600. La carte est en effet sauvée par sa plus grande quantité de mémoire.

Enemy Territory : Quake Wars - v1.4 - AA 4x - AF 16x

On referme cette troisième page avec Enemy Territory : Quake Wars. Là encore, les surprises s'enchaînent puisque le Radeon HD 4870 fait mieux que les GeForce GTX 260 et 280, et ce en 1920x1200 comme en 2560x1600. Le modèle haut de gamme d'AMD revendique des performances 55% supérieures au Radeon HD 4850 en résolution XHD alors que le Radeon HD 4850 est en retrait face au nouveau GeForce 9800 GTX+. Un retrait qui s'accompagne d'une bonne nouvelle puisque le Radeon HD 4850 demeure plus rapide que le GeForce 8800 Ultra et ce en 1920x1200 comme en 2560x1600. Quant aux configurations Crossfire, elles poutrent tout simplement ! En 1920x1200, résolution native des écrans 24 et 27 pouces rappelons-le, le Crossfire de Radeon HD 4850 est 80% plus véloce qu'une seule carte Radeon HD 4850. De fait, le Crossfire de Radeon HD 4850 dépasse largement le niveau de performances offert par le GeForce GTX 280.

Conclusion

De son côté, le Radeon HD 4870 est, disons-le, un peu moins séduisant. Certes, la carte offre des performances supérieures au Radeon HD 4850 mais pour 100 euros de plus qu'une Radeon HD 4850, le gain de performance n'est que de 25% en moyenne quand pour 150 euros de plus le gain peut atteindre 75% avec deux Radeon HD 4850 en Crossfire. Quant à la mémoire GDDR5, son intérêt semble limitée pour le moment : onéreuse et disponible en faible quantité, cette mémoire aurait probablement donnée de meilleurs résultats avec un bus mémoire 512 bits, fonctionnalité qui fait hélas défaut au RV770. Du reste, les 512 Mo de mémoire vidéo embarqués par le Radeon HD 4870 semblent quelque peu étriqués pour une carte graphique haut de gamme en cette mi-2008. Dans les faits donc le Radeon HD 4870 utilisé seul ne peut pas inquiéter une GeForce GTX 260, carte dont les performances s'avèrent relativement élevées. La carte de Point Of View ne rougit en effet pas souvent dans nos divers tests alors que sa grande soeur, à base de GeForce GTX 280, est en général 23% plus rapide. Mais à quel prix ? Car à 350 euros TTC, le GeForce GTX 260 semble fort onéreux face à l'offre d'AMD.

Impossible de conclure cet article sans dire quelques mots sur NVIDIA et la sortie inattendue du GeForce 9800 GTX+. Alors que nous sanctionnions il y a quelques semaines la firme au caméléon pour son GeForce 9800 GTX, une carte que nous jugions inutile à l'époque, NVIDIA confirme que nous étions dans le vrai ! La firme propose en effet avec la GeForce 9800 GTX+, un modèle amélioré, plus rapide et gravé en 55nm quand le GeForce 9800 GTX n'avait pas grand-chose pour lui si ce n'est peut être la prise en charge Hybrid Power. Ce GeForce 9800 GTX+ entraine bien sûr une baisse de prix sur le GeForce 9800 GTX alors qu'il ne sera pas disponible avant la mi-juillet. Car ne nous y trompons pas, ce produit a vu le jour uniquement grâce à AMD : NVIDIA appliquant son habituelle tactique du contre-lancement. Quand le produit d'en face est meilleur que prévu, on en sort un nouveau distribué en petite quantité à la presse histoire d'assurer ses arrières même si le produit en question ne sera pas disponible avant plusieurs semaines dans le commerce (on se souvient du GeForce 6800 Ultra Extreme)... Bref, on ne félicite pas NVIDIA pour cette sortie précipitée alors qu'à 200 euros TTC la carte ne parvient pas à nous convaincre face au Radeon HD 4850, d'autant que la firme de Santa-Clara aurait pu revoir son design de référence pour proposer une carte plus compacte... Chose qui n'a pas été faite, hélas.

Probablement conscient que proposer un énième G92 overclocké ne suffirait pas (cette fois-ci) pour l'emporter sur AMD, NVIDIA profite du GeForce 9800 GTX+ pour introduire la prise en charge de l'API PhysX par ses pilotes. L'idée étant de faire tourner sur la puce graphique les calculs liés aux simulations physiques. Problème, à l'heure où nous écrivons ces lignes seuls deux titres sont supportés : Unreal Tournament 3, avec lequel nous n'avons pas réussi à installer le pack de maps optimisé pour la PhysX et 3DMark Vantage, dont le test CPU physique est à l'origine d'une nouvelle polémique. Bref, nous serons ravis de vanter les mérites du PhysX par NVIDIA mais lorsque celui-ci disposera véritablement d'un écosystème compatible et non d'une pseudo liste de 140 jeux dont seule au final une poignée profite d'une véritable accélération.

- Venez discuter de cet article dans le forum