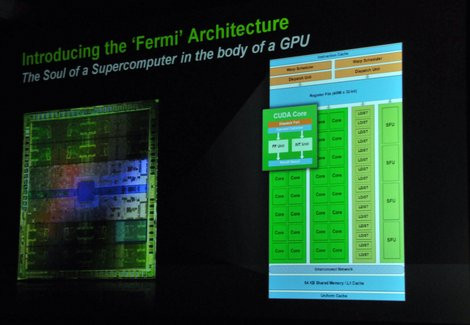

Basé sur l'architecture connue sous le nom de code Fermi et dévoilé pour la première fois au mois d'octobre 2009 lors du NVIDIA GPU Tech, le GeForce GTX 480 est une véritable petite révolution pour NVIDIA. Comprenez par là que l'architecture Fermi est totalement nouvelle : les ingénieurs de NVIDIA étaient en effet arrivés en bout de cycle avec les GeForce de la série 200, il leur a donc fallu remettre leur ouvrage sur le métier pour concevoir une nouvelle architecture qui réponde à la fois aux attentes des développeurs de jeux, mais aussi aux exigences de DirectX 11, entre autres !

Lorsque NVIDIA a commencé à communiquer autour de l'architecture Fermi, la firme a choisi de mettre en avant l'aspect compute des choses, c'est-à-dire la capacité de l'architecture à effectuer des calculs génériques. Il n'en fallait pas plus pour que certains voient dans cette annonce le désintérêt de NVIDIA pour les joueurs et pour le jeu en général. Naturellement, il n'en est rien et si NVIDIA a effectivement tout fait pour séduire un nouveau public et une nouvelle clientèle, en axant à un moment donné sa communication sur le calcul, la firme n'oublie pas son marché de base. La sortie du GeForce GTX 480 est censée démontrer cette volonté, une volonté clairement affichée par NVIDIA qui dédie sa nouvelle carte graphique aux joueurs PC du monde entier, rien que cela.

Au-delà des choix architecturaux, le GeForce GTX 480 inaugure plusieurs nouveautés techniques pour l'offre haut de gamme de NVIDIA à commencer par un procédé de fabrication en 40nm, l'emploi de mémoire vidéo de type GDDR5 ou encore l'inclusion d'un circuit audio dans la puce graphique... autant d'évolutions qui devraient contribuer à remettre l'offre de NVIDIA au goût du jour.

Le GeForce GTX 480 est-il deux fois plus rapide que le GeForce GTX 285 qu'il est censé remplacer ? Comment se positionne-t-il face aux Radeon HD de la série 5000 qui trustent les podiums depuis des mois. C'est précisément à ces questions que notre test va tenter de répondre.

NVIDIA GF100 : des ambitions...

Nous l'écrivions dès l'introduction, le GF100, nom de code de la puce animant le GeForce GTX 480, est pour NVIDIA l'occasion de faire table rase du passé, puisqu'il s'agit d'une toute nouvelle architecture. Avant de passer en revue les choix opérés par NVIDIA en la matière, il est bon de connaître les ambitions affichées par la firme au caméléon.

Des ambitions qui se résument selon trois axes : les performances, la qualité d'image et la géométrie. Basé sur la troisième génération d'architecture à processeurs de flux, le GF100 comporte deux fois plus d'unités que ses prédécesseurs, une caractéristique qui devrait effectivement lui permettre d'offrir des performances élevées dans les jeux. En ce qui concerne la qualité d'image, NVIDIA inaugure un nouveau mode d'anticrénelage 32x alors que les changements apportés à sa puce devraient offrir des performances supérieures lorsque les fonctions de filtrage sont actives.

...centrées autour de la géométrie...

Au début de notre article, nous évoquions la nécessité pour NVIDIA de répondre aux besoins des développeurs. Parfois, NVIDIA va au-delà et anticipe leurs besoins... en tentant de leur montrer une direction que la firme considère porteuse à un moment donné. C'est ce qui se passe avec le GF100 et la soudaine résurgence de la géométrie ! NVIDIA part en effet du constat que si les jeux PC offrent des effets par pixel très proche de ce que l'on peut voir dans les meilleures productions hollywoodiennes, ce n'est pas le cas de la géométrie qui resterait à la traîne. C'est en partie la faute du matériel qui a longtemps été fort limité avec une seule unité dédiée au traitement de la géométrie et des polygones, quand plusieurs dizaines d'unités travaillent sur les pixels par exemple. Pour bien illustrer ce déséquilibre, NVIDIA communique une donnée qui n'est pas forcément à son avantage : lorsque le GeForce GTX 285 offre 150 fois la puissance de calcul d'un GeForce FX en matière de pixels, la puissance géométrique du premier est à peine 3 fois supérieure à celle du second !

Illustration du manque de puissance géométrique selon NVIDIA : le bandana pour masquer l'absence de cheveux, les détails du porte-pistolet anguleux

Pour bien saisir l'importance de la géométrie, il faut comprendre que plus la puce graphique aura de puissance géométrique, plus elle pourra calculer ou gérer un nombre élevé de triangles, ce qui se traduira à l'écran par des détails bien plus fins et donc, in fine, un réalisme accru. Afin de parvenir à cet objectif, NVIDIA replace la géométrie au début du pipeline graphique avec l'arrivée des Polymorph Engine que nous décrirons plus avant.

...mais pas seulement !

L'autre volonté affichée avec Fermi concerne bien entendu l'aspect compute, autrement dit l'utilisation de la puce pour des opérations génériques n'ayant rien à voir avec la 3D. Alors que le développement du GF100 a commencé avant même que CUDA ne voie le jour, l'architecture profite tout de même d'avancées en la matière. On pourra citer dès à présent des performances plus importantes lors des opérations atomiques afin de permettre aux processus de coopérer entre eux sur, par exemple, de nouveaux algorithmes de rendu. Car la puissance de la puce en terme de compute peut non seulement servir à des applications de tous les jours comme un PowerDVD ou un Badaboom, mais elle peut aussi s'exprimer dans les jeux par le biais de la fameuse technologie PhysX notamment.

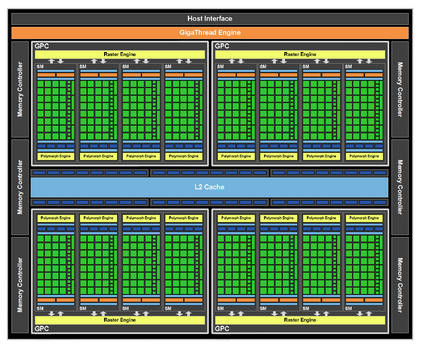

Architecture NVIDIA Fermi : tour du propriétaire

NVIDIA profite de Fermi pour revoir l'agencement de son architecture. Exit les structures de type TPC (Texture Processing Clusters) que l'on retrouvait au cœur des G8x, G9x et autres puces GT200 et qui englobaient unités de texture et processeurs de flux. À la place, NVIDIA propose avec son GF100 de découper sa puce en quatre grandes zones baptisées GPC ou Graphics Processing Clusters, au sein desquels on retrouve l'ensemble des unités spécialisées.

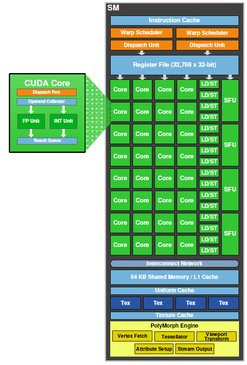

L'architecture de la puce GF100

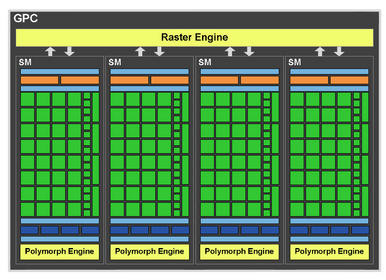

Dans chaque GPC on retrouve 4 SM, c'est-à-dire 4 ensembles de Streaming Multiprocessors, autrement appelés multiprocesseurs. Il s'agit de ces blocs qui comportent in fine ce que NVIDIA appelle les cœurs CUDA. Chaque SM renferme 32 noyaux d'exécution CUDA pouvant travailler chacun sur des entiers ou des nombres en virgule flottante. Ceux-ci évoluent doucement pour se baser non plus sur des instructions MAD (multiply add), mais FMA (fused multiply add) alors que NVIDIA prend en charge la norme IEEE754-2008. Comme les GPU Cypress d'AMD, Fermi est complètement compatible avec cette norme et les modes d'arrondis qu'elle propose.

Gros plan sur un GPC

Chaque SM se dote d'un double scheduler. Le scheduler est une sorte de super chef de gare qui va agencer et dispatcher le travail en fonction de la charge et des unités disponibles. Chaque scheduler peut envoyer une instruction à 16 des processeurs CUDA, à chaque cycle d'horloge. Avec deux schedulers, nos 32 noyaux CUDA peuvent donc être potentiellement tous alimentés au même moment. Parallèlement, on retrouve dans notre SM un total de 16 unités de type Load/Store permettant le calcul des adresses mémoire source et destination pour un maximum de 16 processus par cycle. Et NVIDIA de disposer des SFU, au nombre de quatre dans chaque SM. Il s'agit ici d'unités de fonctions spécialisées pouvant exécuter une instruction par cycle. C'est dans les SFU que s'effectue le calcul de fonctions mathématiques comme sinus, cosinus, racine carrée, etc.

Le détail d'un SM

Nous l'écrivions plus haut, chaque GPC comporte 4 Streaming Multiprocessors ou multiprocesseurs, chaque SM comptant 32 noyaux CUDA. Fort de ces chiffres, et alors que la puce compte 4 GPC, on pouvait logiquement tabler sur un total de 512 cœurs d'exécution CUDA. C'est du reste ce que NVIDIA avait annoncé de longue date. Oui mais voilà, sur les 16 SM que devait compter la puce, l'un d'eux a été désactivé. Avec 15 SM, la puce GeForce 100 dispose donc de 480 cœurs CUDA. Des problèmes de rendement ont visiblement contraint NVIDIA à se montrer moins ambitieux.

Reste une question de sémantique pure et dure : l'appellation de cœur CUDA doit-elle s'appliquer au plus petit dénominateur de la puce, à savoir une unité SIMD, ou bien à une unité plus large comme le Streaming Multiprocessor ou SM ? De notre côté, on aurait tendance a préféré la dénomination de cœur CUDA pour un SM...

Autre changement important pour NVIDIA, les unités de texture prennent dorénavant place au cœur même des fameuses unités SM. Et dans chaque SM on retrouve un total de quatre unités de texture. Avec 15 SM, la puce GeForce GTX 480 profite donc de 60 unités de texture. C'est moins que les GeForce de la série 200 qui pouvaient tabler sur 80 unités de texture ! En contrepartie, les unités de texture étant dorénavant intégrées au SM, elles sont réputées plus efficaces avec quelques petites optimisations de-ci, de-là. Ainsi, le chargement de certaines textures se fait dorénavant à pleine vitesse. Côté débit, les unités de texture peuvent traiter quatre échantillons par cycle d'horloge. Naturellement, les exigences de DirectX 11 en matière de formats de texture sont respectées et NVIDIA propose la fonction Gather4.

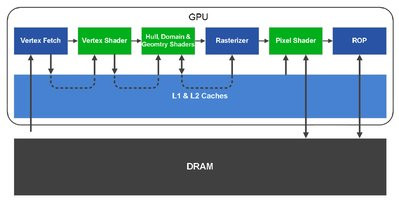

Côté mémoire, l'architecture Fermi inaugure un autre changement avec les précédentes GeForce. En effet, on retrouve six contrôleurs mémoire de 64 bits chacun. Techniquement, la puce GeForce 100 dispose donc d'une interface mémoire de 384 bits, en retrait face aux 512 bits des GeForce 200. À l'inverse, le GeForce 100 prend enfin en charge la mémoire GDDR5... De fait, le bus mémoire réduit sera compensé par les fréquences de fonctionnement supérieures de la GDDR5. Du côté de la mémoire cache, intimement liée au sous-système mémoire évoqué à l'instant, le GeForce 100 se rapproche un peu plus d'un processeur x86 avec pour la première fois chez NVIDIA deux niveaux de cache. On retrouve un cache de premier niveau, ou cache L1, jusqu'alors absent des GeForce GT200. Il servira aux opérations de type Load/Store et sa taille est de 64 Ko configurable en 16+48 Ko ou inversement. Le cache de second niveau augmente avec 768 Ko, contre 256 Ko précédemment. Il n'est toutefois pas dit que cette quantité soit suffisante pour l'ensemble des données à traiter notamment du fait du nouvel agencement du cache et du fait qu'il remplace une série de caches dédiés. De plus, NVIDIA ne communique pas les temps de latence des caches.

Fonctionnement des caches du GF100

Enfin, et c'est directement lié aux choix architecturaux au niveau de la mémoire, le GeForce 100 dispose de six partitions ROP, contre 8 pour son prédécesseur. Rappelons que les ROP sont les unités en charge des dernières opérations sur les pixels comme l'anticrénelage ou le mélange, etc. Avec un nombre de partitions réduit face au GeForce GT200, NVIDIA propose plus d'unités ROP par partition : 8 au lieu de 4. On retrouvera donc 48 unités ROP dans la version la plus aboutie de l'architecture Fermi incarnée par le GeForce GTX 480. Naturellement, on observe quelques avancées avec de nouveaux algorithmes censés être plus efficaces ou encore l'arrivée d'un mode CSAA 32x qui utilise un mix entre MSAA 8x et coverage 24x.

La géométrie pour maître mot !

Nous le disions dans les premières pages de ce dossier, la géométrie se veut un des fers de lance de l'architecture Fermi. La prise en charge de DirectX 11 équivaut à l'arrivée d'une unité de tessellation dans ce nouveau GeForce. Le but étant d'offrir un niveau de détail accru sans pour autant submerger le système graphique de calculs interminables et lourds. C'est l'utilité numéro un de la tessellation qui permet de générer des détails géométriques « gratuitement ». Le développeur définit une représentation géométrique simple d'un objet ou d'un personnage alors que l'unité de tessellation subdivise cette représentation en un ensemble de petits triangles afin d'augmenter les détails géométriques sans pour autant repasser par des étapes de calcul, description, etc. Rappelons tout de même que si Fermi propose enfin la prise en charge de la tesselation, ATI propose cette caractéristique depuis la série des Radeon HD 2000.

La tessellation ? Parce que je le vaux bien !

Et pour faire plus que de la simple tessellation, NVIDIA remet sur le devant de la scène une technique de rendu comme le displacement mapping, autrefois mis en avant par un certain canadien du nom de Matrox. En associant tessellation et displacement mapping, on obtiendrait ainsi un duo d'enfer particulièrement économe en terme d'empreinte mémoire et de calcul tout en proposant un haut niveau de détail. Rappelons que le displacement mapping est une texture avec des informations de hauteur : lorsqu'elle est appliquée à un modèle, les informations de position des vertices (le sommet des triangles) du modèle sont modifiées. Et NVIDIA de souligner que les éléments d'une scène ayant profité du displacement mapping se comportent naturellement lorsqu'ils sont animés.

À gauche : la vue fil de fer et l'impressionnant nombre de triangles, à droite le rendu final

Voilà pour la théorie et ses applications principales entrevues par NVIDIA. Dans la pratique, l'architecture Fermi inaugure dans chaque SM, une unité baptisée polymorph engine. Celle-ci se charge de toutes les opérations sur les vertices : de leur récupération jusqu'à l'envoi dans le SM. Étant donné que chaque SM dispose de son polymorph engine, les opérations sur la géométrie peuvent dorénavant être parallélisées. Il est du reste à noter que chaque polymorph engine renferme une unité de tessellation alors que tous les polymorph engines sont interconnectés. Il est donc possible de faire passer les primitives de l'un à l'autre des moteurs polymorphes, en français dans le texte, via la mémoire cache L2.

Gros plan sur les moteurs polymorphe

Une fois nos primitives traitées par les polymorph engines, elles arrivent dans le raster engine où nos triangles se transforment ici en pixels. Les raster engines prennent place non pas dans chaque SM, mais dans le GPC. Avec un raster engine par GPC, la puce dispose d'un total de quatre raster engines ! Sur le papier, cela devrait donner un avantage non négligeable à la puce en terme de performances sur les résolutions courantes. Les raster engines sont interconnectés, tout comme les polymorph engines, et peuvent donc partager des informations comme celles concernant le culling, ce procédé qui permet d'évincer les triangles qui ne seront pas affichés à l'écran car masqués par d'autres objets. En revanche, il est à noter que les pixels relatifs à un raster engine doivent rester dans le GPC qui les concerne. Autre avantage de l'interconnexion des raster engines : la possibilité de les faire travailler de concert sur certaines tâches lourdes comme le découpage de grands triangles par exemple.

Suivi des moteurs de rastérisation

Avec quatre moteurs de rastérisation travaillant en parallèle, et une unité de tessellation dans chaque grappe de processeurs de flux, les fameux SM, l'architecture GeForce 100 propose huit fois la puissance géométrique de l'architecture GT200. Et NVIDIA peut se targuer d'être le premier fabricant de GPU à proposer une puce allant au-delà de la limite du un triangle par cycle d'horloge !

Quelques mots sur le compute !

La partie compute de l'architecture du GeForce 100 a naturellement fait l'objet de multiples attentions de la part de NVIDIA, et ce, bien que la conception de la puce ait démarré avant même la mise au point de CUDA. Sans nous replonger dans des détails techniques poussés, on retiendra quelques nouveautés assez importantes pour NVIDIA comme l'arrivée des deux niveaux de mémoire cache. Le fait de disposer d'une mémoire partagée devrait permettre d'améliorer significativement les performances des applications CUDA en permettant aux processus situés dans le même bloc de coopérer facilement entre eux en réutilisant notamment leurs données.Alors que l'architecture Fermi a été conçue en partie pour proposer de meilleures performances en compute, certaines fonctionnalités sont désactivées sur la puce GeForce 100. C'est notamment le cas des unités en charge de la double précision en virgule flottante : celles-ci sont inopérantes sur les cartes graphiques à destination des joueurs, NVIDIA les réservant exclusivement à ses cartes graphiques de la série Tesla.

Parmi les avancées en matière de compute, il y a tout de même une optimisation assez intéressante au niveau du changement de contexte. La puce est en effet dix fois plus rapide qu'une GeForce GTX 285 pour passer d'une configuration de travail à une autre, un élément important lorsque l'on mélange rendu 3D et calculs PhysX sur la même carte par exemple. Parallèlement, NVIDIA a assoupli la gestion des branchements tout en dotant le GeForce 100 d'un système de prévision des branchements. Pour une plus grande efficacité, l'exécution concurrente de kernels est rendue possible : la puce peut exécuter jusqu'à 16 kernels au même moment, sous réserve que ceux-ci n'aient pas de dépendance.

Lancé de rayons : une démonstration fort convaincante...

GeForce 100 et fréquences de fonctionnement

Avec le GeForce 100, NVIDIA inaugure un autre changement plus subtil qui ne concerne pas tant, cette fois, l'architecture même de sa puce que ses fréquences de fonctionnement. La firme revoit en effet ses domaines de fréquence pour que les unités qui fonctionnaient à une fréquence deux fois supérieure au reste de la puce, typiquement les processeurs de flux sur les précédentes GeForce, soient plus nombreuses.

Les fréquences du GeForce GTX 480

Avec Fermi, tout ce qui est dans les blocs intitulés GPC fonctionne à une fréquence double du reste de la puce, un peu à la manière de l'architecture Netburst des Pentium 4 et du fameux bus Quad-Pumped. En clair, les unités de texture, les processeurs de flux, les unités de tesselation et autres fonctionnent dorénavant à une fréquence double. Il ne reste guère plus que les unités ROP à fonctionner à la même fréquence que celle définie pour la puce graphique.

GeForce 100 : la puce

Vous l'aurez compris à la lecture de notre tour d'horizon de l'architecture Fermi, NVIDIA reste fidèle à sa stratégie : celle qui consiste à faire la puce la plus monumentale possible avec le plus de ressources. Seulement voilà, cette recette semble ne plus vraiment fonctionner depuis les GeForce GT200 ou plus exactement depuis qu'ATI privilégie le rendement de l'architecture à la multiplication des unités de calcul. Reste qu'avec 512, pardon 480 unités de calcul, et une quantité de mémoire cache non négligeable, la puce GeForce 100 totalise 3,2 milliards de transistors. C'est à ce jour la plus grosse puce graphique jamais produite.

Le die « Fermi »

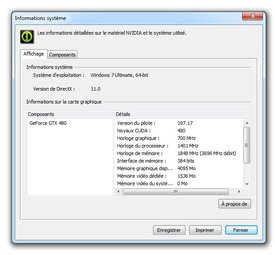

Gravée en 40 nm par TSMC, la puce GeForce 100 est cadencée à 700 MHz alors que ses unités de calcul opèrent à 1401 MHz. Couplée à de la mémoire GDDR5 interfacée sur 384 bits, la puce est censée bénéficier d'une bande passante mémoire de 177,4 Go/s.

Comme évoqué plus haut, la puce GeForce 100 se contente de 480 processeurs de flux CUDA, contre 512 attendus initialement. C'est maintenant un fait avéré, TSMC a rencontré de sérieux soucis de mise au point de son procédé de fabrication en 40 nm, les Radeon de la série 5000 en ayant d'ailleurs largement fait les frais. Avec une complexité encore accrue par rapport aux dernières Radeon, le GeForce GTX 480 de NVIDIA a donc été privé en cours de route d'un nombre d'unités non négligeable vraisemblablement pour des raisons de rendement.

Puce NVIDIA GeForce GTX 480

GeForce 100 : la vidéo

Pas de gros changement à signaler de ce côté-là. Contrairement aux Radeon HD de la série 5000 qui disposent d'un nombre de sorties vidéo impressionnant (la technologie EyeFinity), NVIDIA n'a pas retenu cette approche. De fait, on se contente d'un double pipeline d'affichage chez NVIDIA avec la prise en charge des technologies DVI Dual-Link sur tous les connecteurs, le support du HDCP et pour la première fois l'inclusion du HDMI de manière... propre ! À noter que l'ensemble de l'électronique en charge de l'affichage est intégré à la puce.Tout comme les récentes GeForce GT 240, la puce GeForce 100 profite d'une prise en charge de la norme HDMI 1.3 avec l'inclusion d'un circuit audio : NVIDIA se met enfin à la page de ce côté-là. Plus besoin donc de relier sa carte graphique à sa carte son pour envoyer le signal audio à son amplificateur ou à son téléviseur. Un pas qui va assurément dans la bonne direction. Et l'on retrouve naturellement le moteur vidéo PureVideo sur le GeForce 100, moteur qui nous revient ici dans sa version VP4. Il prend en charge la décompression des flux vidéo haute définition de type H.264 mais également le décodage AVC et MKV.

GeForce GTX 480 : la carte de référence

Physiquement, la carte de référence GeForce GTX 480 conserve des proportions somme toute raisonnables pour une carte graphique haut de gamme. Interfacée en PCI-Express 2.0, la carte mesure 27 centimètres et occupera deux emplacements dans votre tour. Niveau alimentation électrique, on trouve sur le rebord un connecteur PCI-Express 8 broches et un connecteur PCI-Express 6 broches. Le double connecteur SLI est toujours présent sur ce modèle.Côté système de refroidissement, la carte est pourvue d'un carénage dorénavant habituel sur les modèles haut de gamme. Toutefois, vraisemblablement pour des raisons de coût, l'arrière du PCB n'est pas protégé comme sur feus les GeForce GTX 280. La puce graphique est ici surplombée d'un radiateur assez massif pourvu de cinq caloducs. Ce même radiateur recouvre les puces mémoire et est encastré dans un carter de plastique et de métal. Un large ventilateur de type cage d'écureuil souffle sur l'ensemble et expulse l'air chaud à l'arrière du boîtier. Il est à noter, comme aperçu sur les photos, qu'une partie des caloducs du radiateur sont apparents sur la tranche de la carte.

NVIDIA GeForce GTX 480

Auto-régulé, le ventilateur peut s'avérer assez bruyant, sa vitesse de rotation maximale étant de 3000 tours minute. Précisons au passage que le GeForce GTX 480 chauffe de manière importante : 70° C sur les bords de la carte en charge et plus de 84° C au dos selon nos relevés ! NVIDIA certifie sa carte pour un TDP annoncé de 250 Watts (au repos peut être ?). Niveau fréquences de fonctionnement, la carte répond fort logiquement aux exigences de NVIDIA avec une puce opérant à 700 MHz et des processeurs de flux tournant à 1401 MHz. Les 1536 Mo de mémoire vidéo des puces Samsung de GDDR5 opèrent pour leur part à 1848 MHz.

À noter enfin, la présence en sortie de deux connecteurs DVI et d'un port mini-HDMI. Nul ne sait si les constructeurs de carte livreront un câble mini-HDMI vers HDMI avec leurs GeForce GTX 480.Nous arrivons maintenant au coeur de ce dossier, à savoir les tests de performance. Voici la configuration utilisée pour mesurer les performances du tout nouveau GeForce GTX 480 :

- Carte mère Asus P6T Deluxe v1 (BIOS 2101),

- Processeur Intel Core i7 980X,

- 6 Go Mémoire DDR3-1333 Corsair @ 1333,

- Disque SSD Intel 160 Go,

- Disque dur Seagate Barracuda 1 To 7200.12

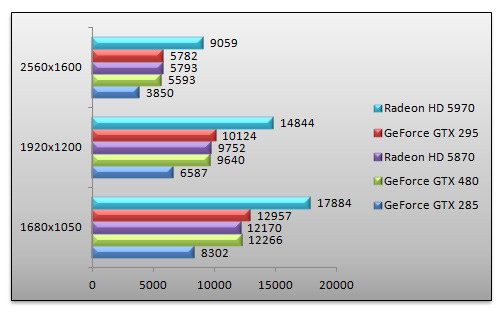

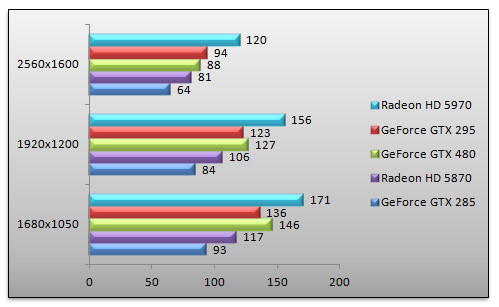

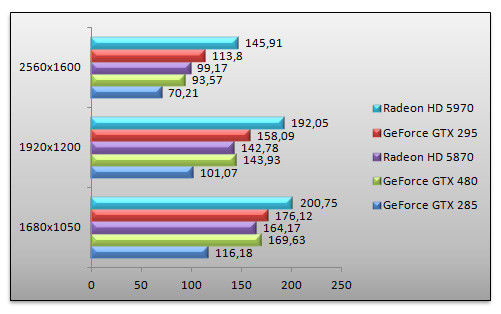

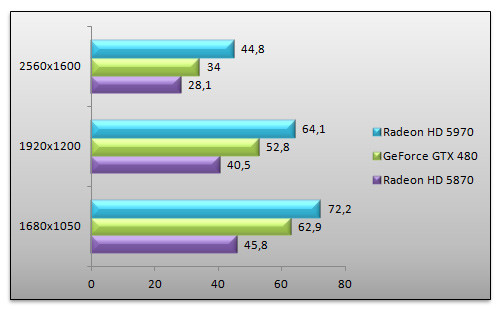

3DMark Vantage - Mode High

On démarre avec 3DMark Vantage. Pour ce routier du bench, la Radeon HD 5970 reste la carte graphique la plus rapide. Avec ses deux puces graphiques, elle supplante une autre carte bi-GPU, la GeForce GTX 295. Ici le Radeon HD 5870 semble faire légèrement mieux que le GeForce GTX 480. Ce dernier se révèle tout de même 45% que le GeForce GTX 285 qu'il remplace, en 2560x1600.

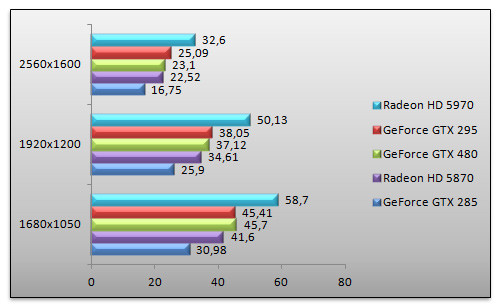

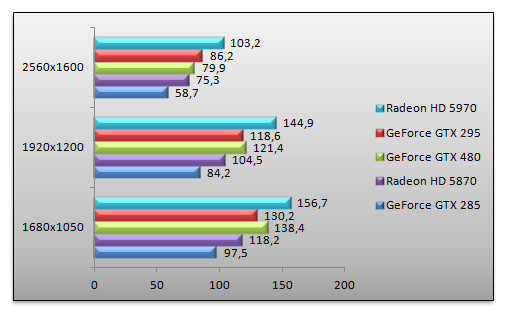

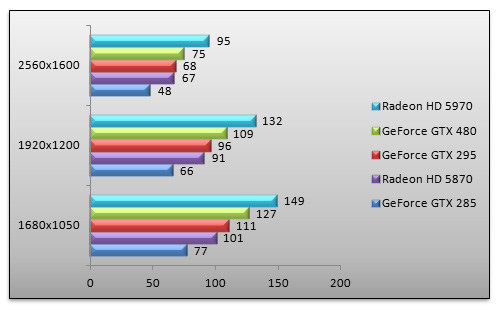

Call Of Duty 4 - v1.7

On enchaîne avec un FPS, ce bon vieux Call Of Duty 4. Les cartes bi-GPU sont ici en tête ce qui ne surprend guère. Notre GeForce GTX 480 fait ici jeu égal avec le Radeon HD 5870. Face au GeForce GTX 285, le GeForce GTX 480 est 21% plus performant en 1920x1200.

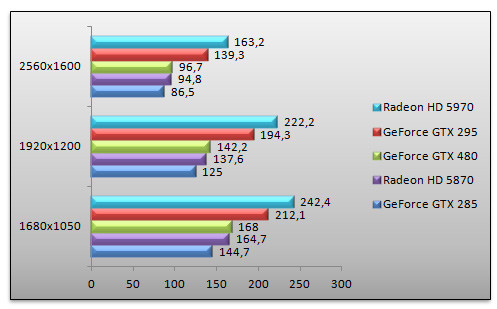

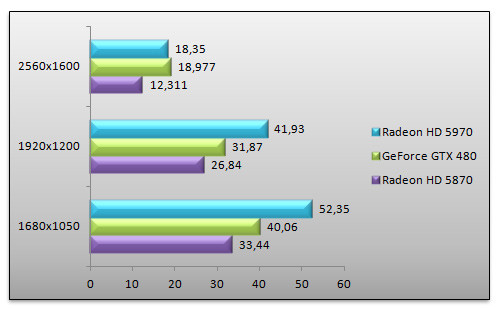

Crysis Warhead - v1.1 - Frost - Enthusiast - 64 bit

Avec Crysis, ici testé dans sa mouture Warhead, le GeForce GTX 480 prend des couleurs. Il devance le Radeon HD 5870 de manière sensible dans les résolutions courantes : 7% en 1920x1200 par exemple, alors qu'il fait presque jeu égal avec ce dernier en 2560x1600. Face au GeForce GTX 285, les performances du GeForce GTX 480 sont 43% supérieures en 1920x1200, la résolution d'un écran 24 pouces. Naturellement, les cartes bi-GPU restent en tête de peloton.

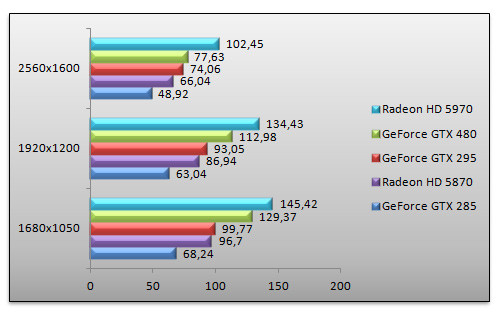

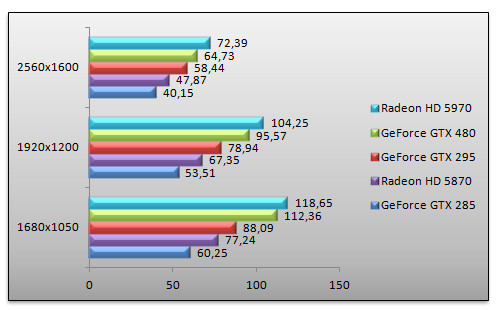

Far Cry 2 - v1.03

On reste dans les jeux de tir avec Far Cry 2. Alors que le Radeon HD 5970 termine en tête, le GeForce GTX 480 s'adjuge la seconde place, devant le GeForce GTX 295, une carte pourtant dotée de deux processeurs graphiques. Ici le GeForce GTX 480 profite de sa généreuse quantité de mémoire vidéo embarquée. En 1920x1200, il est 80% plus rapide que le GeForce GTX 285.

Left 4 Dead 2

Le dernier épisode de Left 4 Dead reste basé sur le moteur graphique Source d'Half-Life 2. Bien que nous utilisions un processeur hexa-coeurs, les résultats obtenus en 1680x1050 et 1920x1200 semblent quelque peu limités. En 2560x1600, une certaine hiérarchie se forme. En tête, le Radeon HD 5970 devance toutes les autres cartes, alors que le GeForce GTX 295 est second. Face au Radeon HD 5870, le GeForce GTX 480 fait moins bien. En 2560x1600, la carte d'ATI reste 12% plus performante. Comparé au GeForce GTX 285 qu'il remplace, le GeForce GTX 480 se montre 44% plus rapide.

Batman Arkham Asylum - v1.1

Succès de la fin d'année dernière, Batman est un jeu basé sur le moteur graphique Unreal et profitant de la technologie PhysX de NVIDIA. Nous désactivons toutefois le rendu PhysX car sur les cartes ATI, les effets PhysX sont traités par le processeur entrainant une chute invraisemblable des performances. Nous mettons donc toutes nos cartes sur un pied d'égalité. En tête, nous retrouvons les bi-GPU avec le tandem Radeon HD 5970 et GeForce GTX 295. Le GeForce GTX 480 termine troisième avec des performances 3% supérieures au Radeon HD 5870 en 2560x1600. Comparé au GeForce GTX 285, le GeForce GTX 480 est 32% plus rapide.

Tom Clancy's H.A.W.X. - v1.02

H.A.W.X. est un jeu profitant d'un rendu DirectX 10.1, rendu que nous activons sur les cartes compatibles. Toutefois, les GeForce GTX 285 et 295 se contentent du rendu DirectX 10. En tête nous retrouvons nos cartes bi-GPU et l'on notera que le GeForce GTX 480 affiche des performances supérieures au GeForce GTX 295 en 1680x1050 et en 1920x1200 avant finalement de se laisser distancer. Face au Radeon HD 5870, le GeForce GTX 480 est 20% plus performant en 1920x1200.

Resident Evil 5

Pour Resident Evil 5, les cartes bi-GPU sont les plus performantes. Le GeForce GTX 480 termine devant le Radeon HD 5870 avec des performances 16% plus élevées en 1680x1050 et 1920x1200 avant de voir son avantage fondre à 6% en 2560x1600.

Call Of Duty 4 - v1.7 - FSAA 4x - AF 16x

Retour sous Call Of Duty 4 où nous activons les fonctions de filtrage. Nous ne reviendrons pas sur les cartes bi-GPU. Le GeForce GTX 480 affiche ici des performances légèrement supérieures au Radeon HD 5870 : 3% de plus en 1920x1200 alors qu'il devance le GeForce GTX 285 avec un score 13% supérieur.

Far Cry 2 - v1.03 - AA 4x

Retour sous Far Cry 2 où nous activons l'anticrénelage. Le GeForce GTX 480 continue de briller sous Far Cry 2 avec des performances supérieures au GeForce GTX 295 et presque équivalentes au Radeon HD 5970. Face au Radeon HD 5870, les performances de la petite dernière de NVIDIA sont ici 42% supérieures au Radeon HD 5870 en 1920x1200. Un écart qui se justifie notamment par la quantité de mémoire vidéo embarquée par la GeForce GTX 480.

Left 4 Dead 2 - AA 4x AF 16x

Sous Left 4 Dead 2, le GeForce GTX 480 brille beaucoup moins que sous Far Cry 2. Il égale ici le Radeon HD 5870 avant de se rétracter en 2560x1600 pour laisser l'avantage à ATI. Les cartes bi-GPU demeurent les plus rapides. Comparé au GeForce GTX 285, le GeForce GTX 480 se montre 33% plus rapide en 2560x1600.

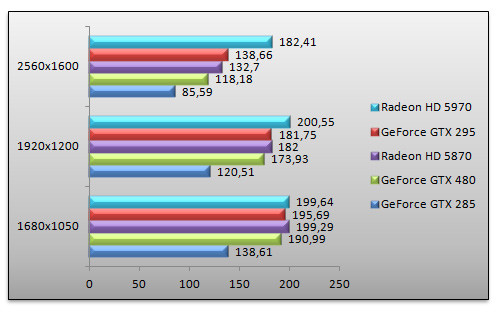

Tom Clancy's H.A.W.X. - v1.02 - AA 4x

Retour sous H.A.W.X. avec l'anticrénelage. Rappelons que sur les GeForce GTX 285 et 295 nous utilisons le rendu DirectX 10 quand nous activons le rendu DirectX 10.1 sur toutes les autres cartes. Le GeForce GTX 480 signe ici une belle prestation avec des performances 65% supérieures au GeForce GTX 285 en 1920x1200, un score que nous attribuerons en partie à sa mémoire vidéo plus généreuse. Face au Radeon HD 5870, le GeForce GTX 480 est ici 20% plus performant.

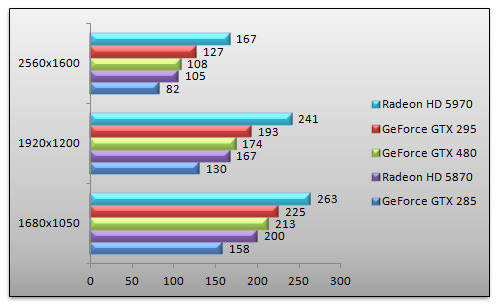

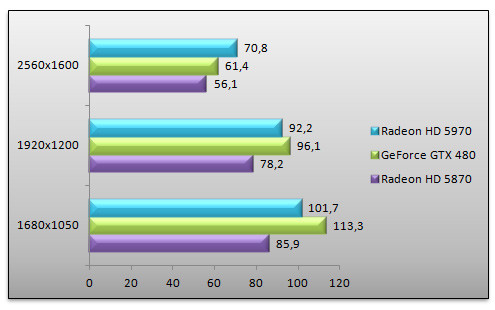

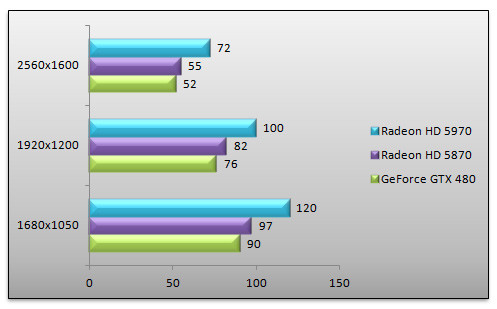

Dirt 2

Dirt 2 bénéficie d'un rendu DirectX 11. Nous comparons donc uniquement les cartes DirectX 11 avec ce jeu. En tête, nous retrouvons le Radeon HD 5970. Il est amusant de noter que le GeForce GTX 480 fait mieux en 1680x1050 et 1920x1200. Face au Radeon HD 5870, le GeForce GTX 480 est 23% plus rapide que le Radeon HD 5870 en 1920x1200.

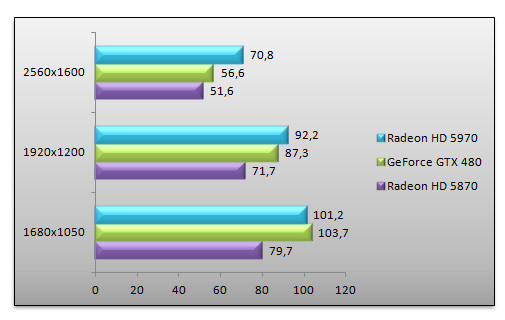

Dirt 2 - AA 4x

L'activation de l'anticrénelage ne change pas singulièrement la donne. Le Radeon HD 5970 domine outrageusement. Si le GeFore GTX 480 est 21% plus rapide que le Radeon HD 5870 en 1920x1200, cet avantage retombe à 9% en 2560x1600.

Metro 2033

Tout nouveau, le jeu Metro 2033 bénéficie d'un rendu DirectX 11. Alors que le Radeon HD 5970 domine largement en 1680x1050 et 1920x1200, il s'écrase en 2560x1600 au profit du GeForce GTX 480 ! Face au Radeon HD 5870, le GeForce GTX 480 est jusqu'à 54% plus rapide. Las, cela ne permet pour autant pas de jouer dans de bonnes conditions en 2560x1600, le nombre d'images par seconde étant encore trop faible.

STALKER - Call Of Pripyat

Surprise ! Alors que le GeForce GTX 480 surprenait jusqu'alors par ses bonnes performances en DirectX 11, il termine ici en retrait face au Radeon HD 5870. Les performances de la carte d'ATI sont 7% supérieures au dernier-né de NVIDIA quand le Radoen HD 5970 domine largement les débats.

Unigine 2.0 - Heaven

On termine notre série de tests avec Unigine 2.0, un benchmark DirectX 11 faisant appel aux fonctionnalités comme la tessellation. Nous réglons ici la tessellation sur un niveau modéré, seul représentatif de la charge actuelle des jeux en la matière. En tête, le Radeon HD 5970 semble intouchable. En revanche, le GeForce GTX 480 signe de beaux scores jusqu'à 30% supérieurs au Radeon HD 5870. On note toutefois un certain repli en très haute résolution où le GeForce GTX 480 n'est plus que 20% plus véloce que son concurrent direct.

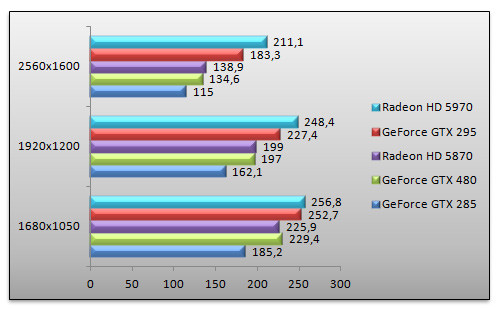

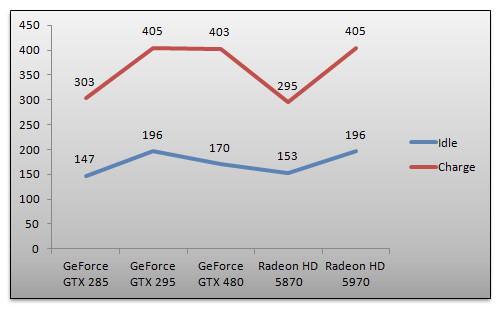

Consommation

Impossible pour nous de conclure cet article sans parler de la consommation électrique de nos diverses cartes graphiques. Nous effectuons un relevé à la prise, au moyen de notre wattmètre. Il s'agit donc de la consommation électrique totale de notre configuration de test. La première mesure en charge est opérée alors que 3DMark Vantage tourne en 2560x1600, la seconde alors que le système est au repos.

Comme prévu, la consommation de la GeForce GTX 480 est élevée, très élevée. En charge elle consomme autant que les cartes bi-GPU. Face à une Radeon HD 5870, notre système consomme jusqu'à 110 Watts de plus avec la GeForce GTX 480. Au repos, la carte consomme heureusement moins que les cartes bi-GPU. En revanche, notre système semble toujours plus consommer avec le GeForce GTX 480 qu'avec le Radeon HD 5870 ou le GeForce GTX 285.

Conclusion

À l'heure du bilan, force est de reconnaître que le très attendu GeForce GTX 480 fait le job, et qu'il le fait relativement bien. La nouvelle architecture proposée par NVIDIA semble sur le papier assez intéressante alors que les premiers tests confirment de bonnes prestations d'ensemble. L'arrivée de DirectX 11 est bien entendu salutaire, on l'attendait tout de même chez NVIDIA depuis plus d'un semestre ! De plus, l'architecture semble pouvoir se décliner beaucoup plus facilement que le précédent GeForce GT200, ce qui devrait aider NVIDIA à proposer une gamme DirectX 11 complète dans les mois à venir. D'autres technologies font enfin leur apparition sur cette nouvelle référence haut de gamme comme la mémoire GDDR5, utilisée par ATI depuis belle lurette, ou encore l'inclusion d'un circuit audio dans la puce graphique pour faciliter les connexions HDMI , un paramètre il est vrai moins crucial sur le très haut de gamme.Fort de solides performances, le GeForce GTX 480 dispose d'un bon potentiel d'autant que ses performances devraient ne faire que s'améliorer au fur et à mesure que NVIDIA optimisera ses pilotes. Reste une question : NVIDIA réussira-t-il son pari d'imposer plus de géométrie aux développeurs de jeux ou bien les transistors consacrés à la dite puissance géométrique le sont-ils en pure perte ? Seul l'avenir répondra à cette question... Mais en attendant, la GeForce GTX 480 est bel et bien la carte graphique mono GPU la plus rapide du moment. En prime, son avantage semble encore plus important avec les titres DirectX 11, alors même que ceux-ci font un usage encore assez timoré de fonctions comme la tessellation.

Alors... génial ce GeForce GTX 480 ? Non, car après six mois d'attente, on était sûrement en droit d'attendre quelque chose d'un peu plus ébouriffant de la part de la firme au caméléon. Au final, lorsqu'il est remis en perspective face à son concurrent direct, le Radeon HD 5870, le GeForce GTX 480 est certes généralement un peu plus rapide, mais il est loin de révolutionner le genre alors que son prix public conseillé, annoncé à 479 euros par NVIDIA, le place déjà bien au-dessus de la tarification de son rival qui se négocie en moyenne 400 euros. D'autre part, la dernière-née de NVIDIA risque de se faire rare dans les étales, la complexité de la puce et le procédé de fabrication en 40 nm pas franchement maîtrisé par TSMC n'aidant pas.

Au chapitre des regrets, on déplore l'absence d'un pipeline vidéo pouvant gérer plus de deux écrans à la fois ou encore la chauffe et la consommation électrique assez importantes de cette GeForce GTX 480. Avec une seule puce, la carte arrive à s'échauffer autant qu'une GeForce GTX 295 ou qu'une Radeon HD 5970 alors que sa consommation électrique est vertigineuse. Sur le segment du très haut de gamme, il convient de modérer l'importance du facteur consommation électrique. En revanche, l'échauffement de la carte nécessite un boîtier bien ventilé alors qu'elle entraîne justement un effet de bord désagréable : une ventilation qui peut parfois être pénible, car relativement bruyante sur la GeForce GTX 480.

Finalement, à l'heure du choix, et sans avoir pu tester le GeForce GTX 470 qui reste à ce jour mystérieux, le GeForce GTX 480 a le mérite d'incarner une alternative valable à l'offre d'AMD. Face au Radeon HD 5870 qu'il égale ou surpasse en terme de performances, le GeForce GTX 480 a d'autres atouts que les seules performances comme la prise en charge de CUDA, le support PhysX ou encore la technologie 3D Vision. Reste que tout ceci ne saurait justifier un prix largement plus élevé que celui du Radeon HD 5870. Or la faible disponibilité de la carte risque précisément de la rendre fort onéreuse... NVIDIA se veut toutefois rassurant et nous indique que les premières cartes seront livrées en quantité dès le 12 avril.