Introduction

Longtemps baptisé R600, le nouveau et premier processeur graphique d'AMD a officiellement reçu le nom de baptême de Radeon HD 2900 XT. D'emblée, on note la disparition du préfixe X qui caractérisait depuis plusieurs années déjà les puces graphiques Radeon au profit du préfixe HD, censé insister sur les fonctions haute-définition de la nouvelle famille DirectX 10 d'AMD. Car si nous vous présentons aujourd'hui le Radeon HD 2900 XT, modèle haut de gamme par excellence, AMD prévoit de sortir dès cet été les déclinaisons milieu et entrée de gamme du R600 avec les Radeon HD 2400 et 2600. On ne pourra d'ailleurs s'empêcher de tiquer sur ce détail, puisqu'aux dernières nouvelles, l'ultime report du R600 avait été justifié par la volonté d'AMD de lancer une famille complète et non une seule puce... c'est visiblement raté ! Le retard d'AMD est-il salutaire ? Le R600 va-t'il mettre à mal le GeForce 8 ? Autant de questions auxquelles nous allons tenter de répondre dans les pages qui suivent.

En avant DirectX 10 !

DirectX 10 c'est aussi une précision de calcul qui reste fixée au format FP32 avec toutefois quelques changements au niveau du calcul des arrondis, la firme de Microsoft essayant de rapprocher les GPU de la norme IEEE 754. Avec DirectX 10, Microsoft nous propose un modèle de programmation totalement unifié. Concrètement, les développeurs peuvent maintenant programmer pixel et vertex shaders en utilisant le même langage et les mêmes instructions. Mais DirectX 10, c'est également le passage au Shader Model 4.0. Un passage synonyme, comme à chaque nouvelle mouture de l'API de Microsoft, de limites repoussées notamment au niveau du nombre maximum d'instructions, du nombre de constantes autorisées ou de la taille des textures gérées par DirectX (jusqu'à 8192x8192 contre 4096x4096 précédemment). D'autres nouveautés appréciables font leur apparition comme la possibilité de sauvegarder le résultat d'un calcul sans pour autant attendre que celui-ci ait traversé toutes les unités de la puce.

La nouvelle Ruby... en DirectX 10

Et comment ne pas mentionner, pour refermer ce rapide tour d'horizon de DirectX 10, l'arrivée des Geometry Shaders, qui se situent précisément entre les vertex et les pixels shaders dans le pipeline de l'API. Leur but ? Permettre aux développeurs de créer de la géométrie, une tâche autrefois dévolue au processeur du PC. Grâce aux shaders de géométrie, les développeurs pourront notamment améliorer la gestion du niveau de détail, la gestion de la fourrure pour les personnages, ou encore améliorer les ombres extrudées pour ne citer que quelques exemples.

Radeon HD 2900 XT : architecture unifiée, v2.0 !

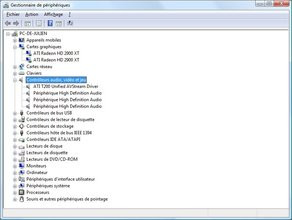

Alors que Microsoft avait fait appel à NVIDIA pour le développement de la puce graphique de sa première console de Jeux Vidéo, la Xbox, la firme de Bill GATES s'est tournée vers ATI pour le développement de la puce graphique de sa console « next gen ». Ainsi est né Xenos, le processeur graphique de la Xbox 360, processeur qui implémentait pour la toute première fois une architecture unifiée. Nous n'évoquons pas Xenos au hasard puisqu'avec le R600 ATI propose sa deuxième génération d'architecture graphique unifiée ou USA pour « Unified Shader Architecture ». Entre temps, ATI avait bien proposé les R520 et R580, qui amorçaient un début d'unification en découplant unités de textures et pipelines de traitement de pixels. Si l'idée d'une architecture unifiée semble aujourd'hui s'imposer d'elle-même, AMD s'est finalement fait griller la politesse par NVIDIA qui contre toute attente à adopté cette solution pour ses GeForce 8.

Architecture unifiée : le pourquoi du comment

Mais assez parlé de NVIDIA ! En proposant une architecture unifiée, AMD répond à la diversité des besoins des développeurs de jeux. Jusqu'à présent, dans le cadre d'une architecture traditionnelle, les ressources de la puce 3D étaient fixes avec un certain nombre d'unités dédiées aux pixels shaders et tant d'autres consacrées au traitement des vertex shaders. Avec l'unification, la notion de pixel pipeline disparaît purement et simplement, et la puce est constituée d'un ensemble de Processeurs de flux capables de travailler sur tout type de données (ou presque) et pouvant être reconfigurés à la volée pour s'adapter à une charge massive de pixels shaders ou de vertex shaders. Conséquence de cette souplesse accrue, outre une plus grande puissance de calcul disponible pour les divers programmes 3D - quel que soit leur type : la capacité du R600 à travailler sur des données plus générales en transformant le GPU en unité de calcul générale (GPGPU).

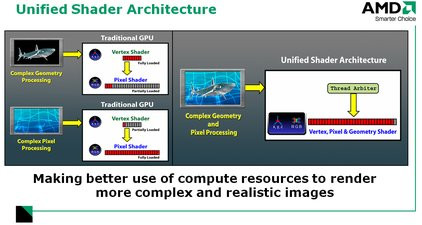

Radeon HD 2900 XT : l'architecture dans le détail

Maintenant que vous savez que le R600 dispose d'une architecture unifiée, il est temps de faire le tour du propriétaire de cette dernière, en suivant le cheminement logique de nos pixels. En tête de la puce, on retrouve le processeur de commandes, ou « Command Processor », qui va gérer les flux de commandes en provenance du pilote graphique. Présent dans les puces Radeon depuis le Radeon 9700 (alias R300), ce dernier voit sa consommation CPU réduite avec une amélioration de l'ordre de 30% selon AMD, que ce soit en DirectX 9.0 ou en DirectX 10. Une fois cette première étape franchie, le « Setup Engine » prend le relais pour préparer les données en fonction de leur nature (vertex, pixel ou geometry shaders) avant de les soumettre aux Processeurs de flux par le biais du « Dispatch Processor ». Déjà utilisé dans les Radeon X1900, celui-ci a été passablement amélioré. Rappelons qu'il agit comme un super chef de gare pour maximiser l'usage de tous les processeurs de flux en aiguillant les données en fonction de la disponibilité de chacun des processeurs, et ce toujours dans le but de réduire les temps de latence et d'accroître l'efficacité de la puce. L'Ultra-Threaded Dispatch Processor dispose de sa propre mémoire cache avec un cache dédié pour les constantes et un autre pour les instructions de shaders permettant ainsi de traiter des shaders dont le nombre d'instructions est virtuellement illimité.

Vue d'ensemble de l'architecture du Radeon HD 2900 XT

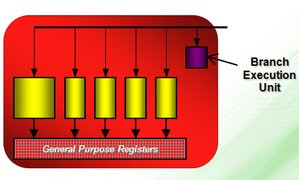

Architecture unifiée oblige, le cœur du R600 est composé d'une nuée de processeurs plus ou moins indépendants les uns des autres. Sorte de DSP (Digital Signal Processor) des temps modernes, ils sont ici appelés processeurs de flux et regroupés selon quatre grands blocs SIMD (Single Instruction, Multiple Data) de 80 processeurs chacun. Chaque bloc SIMD renferme en réalité 16 unités de calcul, chacune des unités étant elle-même constituée de cinq processeurs de flux. En plongeant au sein d'une unité de calcul, qui est pour ainsi dire l'unité individuelle la plus petite travaillant directement sur nos chers pixels, on s'aperçoit que des cinq processeurs qui la composent, le premier est doté de fonctions supplémentaires lui permettant de travailler sur des instructions supplémentaires de type SIN, COS, LOG, utilisées plus rarement dans les shaders. Sachez qui plus est que chaque unité de calcul dispose de ses propres registres et conserve une unité d'exécution de branchement.

Gros plan sur une unité de calcul

Cette architecture super-scalaire répond à la certification IEEE754, et représente un changement certain par rapport au Radeon X1950 dont les unités opéraient en mode vecteur+scalaire et ne pouvaient traiter que deux instructions par cycle d'horloge ou 3+1 composante, ou encore 4+1 composante. Chaque shader core du R600 peut de son côté traiter jusqu'à cinq instructions scalaires MAD (Multiply-Add) par cycle d'horloge ou travailler sur les cinq composantes d'un vecteur. Au total, le dernier bébé d'AMD comporte donc 320 processeurs de flux, un chiffre à mettre en parallèle avec les 128 processeurs de flux que compte le GeForce 8800 GTX.

Reste que si les chiffres avancés par AMD laissent à penser que le GeForce 8800 de NVIDIA est sérieusement dépassé, ils sont un rien trompeurs. En effet, la répartition des processeurs de flux n'est pas du tout la même entre AMD et NVIDIA. Alors que les processeurs de flux du GeForce 8800 sont totalement indépendants les uns des autres, ce n'est pas nécessairement le cas chez AMD, les processeurs étant regroupés par grappe de cinq.

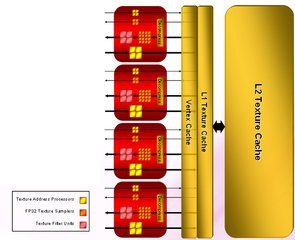

Radeon HD 2900 XT : unités de texture et ROP

Poursuivons notre tour d'horizon de l'architecture du R600 pour nous arrêter sur les unités de texture. Et là les choses se compliquent sérieusement car AMD entretient un flou certain sur l'agencement exact de ses unités de textures. Découplées des Processeurs de flux, celles-ci sont au nombre de quatre, un nombre qui d'emblée surprend puisqu'il est inférieur aux huit unités des GeForce 8800 GTX. Chaque unité de texture du R600 comprend divers sous processeurs dont certains sont dédiés à l'adressage des textures et d'autres à leurs filtrages. Nous ne reprendrons pas ici le détail des sous-unités, les informations communiquées par AMD ne correspondant pas nécessairement à la réalité puisque le fondeur inclue dans ses calculs des unités apparemment dédiées à d'autres tâches. En définitive, ce qui importe est que le nombre d'unités en charge du filtrage s'établit à 16 sur le R600 quand le G80, dans sa version GTX, en compte 64...

Autopsie d'une unité de texture

Pour le reste, les unités de texture du R600 sont reliées à une mémoire cache de premier niveau, elle-même reliée à un second niveau de cache, de l'ordre de 256 Ko, utilisé pour remédier aux erreurs lors des accès au cache de premier niveau et pouvant être mis à contribution pour obtenir un meilleur débit lors des lectures de textures non filtrées. Quant à l'efficacité des unités de texture, AMD précise que le R600 peut travailler sur des textures HDR 64 bits sept fois plus rapidement que les Radeon X1000 alors que le filtrage des textures en FP16 s'effectue à pleine vitesse. On notera également le support des textures haute résolution, en accord avec les spécifications de DirectX 10 ainsi que la prise en charge d'un nouveau format de texture pour les effets de rendu HDR 32 bits avec le format R:9, G:9, B:9, E:5. AMD indique par ailleurs avoir amélioré la qualité du filtrage anisotropique, le mode haute qualité introduit par les Radeon X1000 étant maintenant le mode de rendu par défaut. Cela se traduit concrètement par la disparition de la case à cocher « Haute Qualité » dans les pilotes Catalyst. Toutefois les améliorations du filtrage ne permettent hélas pas à ATI de repasser devant le GeForce 8 de NVIDIA qui reste donc la référence en la matière.

De gauche à droite : filtrage AF 16x sur Radeon X1950 XTX, Radeon HD 2900 XT et GeForce 8800

L'étude du diagramme de l'architecture R600 fait également apparaître un cache pour les opérations de lecture/écriture en mémoire. Rendu nécessaire par DirectX 10 et sa fonction Stream Out, qui permet de récupérer le résultat d'un calcul sans attendre la fin du cheminement des données dans la puce, celui-ci est accessible par chacun des processeurs de flux et permet par ailleurs de virtualiser l'espace de stockage des registres. Il peut être mis à profit pour la communication entre les threads ou encore pour stocker des données issues des shaders de géométrie.

Enfin nos pixels doivent encore passer par les ROP, du nom de ces unités en charge des ultimes opérations comme le mélange des couleurs ou l'application d'un anticrénelage. Depuis la série des R300, c'est-à-dire depuis les Radeon 9700, la structure de ces unités n'avait pas évolué. Le R600 est l'occasion pour AMD de remettre à plat l'architecture des ROP, également connus sous le nom de « Render back end », et cela n'est pas forcément une bonne chose au vu des résultats, comme nous le verrons un peu plus loin dans la partie performances de ce test. Alors que le GeForce 8800, dans sa version GTX, compte 24 unités ROP, le R600 ou Radeon HD2900 XT n'en comporte que 16. C'est moins que chez NVIDIA mais chaque unité est en principe capable de travailler sur deux pixels par cycle d'horloge quand les ROP du GeForce 8800 ne peuvent travailler que sur deux couleurs ou deux valeurs Z durant le même cycle d'horloge.

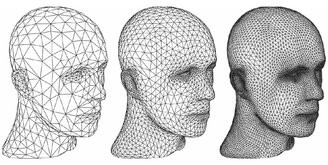

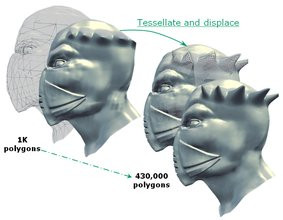

Le retour du TruForm : unité de tesselation

Surprise, AMD donne avec le Radeon HD2900 une seconde vie à sa fonction Truform un temps présente sur ses anciennes puces Radeon 8500. Et à l'instar du Xenos, la puce graphique qui anime la Xbox 360, le R600 dispose de sa propre unité de tesselation programmable. Rappelons le principe de la tesselation, qui est de multiplier les formes géométriques en partant d'une figure assez simple et en appliquant à chaque polygone une sub-division récursive de ce dernier. En 3D comme en géométrie, chaque triangle comporte trois sommets, et notre tesselateur va utiliser la position et la normale, le vecteur perpendiculaire à la surface de notre triangle, pour effectuer une interpolation et générer de nouveaux sommets entre les vertices (ou sommets) déjà existants.

Principe de la tesselation

Habituellement, la tesselation peut être gérée par le processeur mais la présence d'une unité dédiée rend le processus plus efficace. Intéressante sur le papier, l'unité de tesselation devra être adoptée par les développeurs pour être réellement utile. C'est bien là tout le problème, l'unité de tesselation ne faisant pas partie des spécifications de DirectX 10. De fait, elle devrait surtout faciliter la vie des développeurs lors des portages sur PC de jeux Xbox 360.

Exemple plus concret de la tesselation

Radeon HD 2900 XT : Nouveau mode d'anti-crénelage

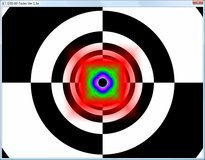

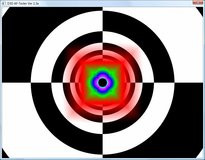

Comme à chaque nouvelle génération de puce graphique, AMD apporte des améliorations à ses fonctions d'anticrénelage. Outre les modes déjà disponibles dans les précédentes générations comme le Temporal AA introduit avec les X800 ou encore l'Adaptative AA qui vise à éliminer le crénelage des textures transparentes, AMD nous propose avec le R600 le CFAA ou Custom Filter Anti-Aliasing. Le but poursuivi est toujours le même, à savoir améliorer la qualité d'affichage en réduisant les effets d'escalier. Pour y parvenir, AMD se propose de combiner un super-échantillonnage traditionnel avec deux nouveaux filtres de son cru, sans pour autant augmenter l'empreinte mémoire.

De gauche à droite : Radeon HD 2900 XT AA 4x, CFAA 12x, CFAA 16x, GeForce 8800 AA 4x, CSAA 16x

Concrètement, le CFAA utilise un plus grand nombre de pixels en guise d'échantillons, mais seulement là où c'est nécessaire. AMD utilise en effet de nouveaux algorithmes avec un fonctionnement adaptatif : après avoir détecté les bords, et ce en une seule passe, le filtrage des pixels présents en bordure va utiliser plus d'échantillons que le filtrage des autres pixels. Cela doit permettre, selon AMD, de parfaitement lisser les bords des objets tout en réduisant le fourmillement des textures et en évitant de rendre flou certains détails de l'image (comme le texte). Fonctionnant avec les effets de rendu HDR et pouvant être mis à jour de manière logicielle, le CFAA est décliné selon plusieurs modes dont le CFAA 12x et le CFAA 16x. Son activation dans les pilotes est un modèle du genre puisque l'utilisateur choisit d'abord le niveau d'anticrénelage désiré avant de définir le type de filtre.

Activation du CFAA depuis les pilotes CATALYST

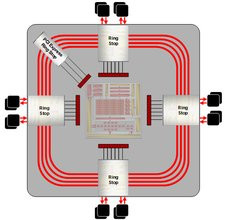

Un nouveau contrôleur mémoire... vraiment 512 bits !

Le Radeon HD2900 reprend, dans sa version XT, le contrôleur mémoire du R520, un contrôleur de mémoire de type Ring Bus. Le principe du Ring Bus est de faire circuler, selon deux voies, les données en anneau autour du processeur afin de garantir des accès et des lectures ultra-rapides via divers points d'entrée et sortie, réduisant par ailleurs les temps de latence. Capitalisant sur ses développements antérieurs, AMD profite du R600 pour améliorer son Ring Bus de manière significative. A l'époque du R520, ATI annonçait que son processeur était muni d'un Ring Bus 512 bits, ce qui avait créé une certaine confusion laissant croire que l'interface mémoire était également sur 512 bits, ce qui n'était pas le cas puisque les puces mémoire étaient interfacées sur 256 bits.

Diagramme du contrôleur mémoire Ring Bus

D'un Ring bus hybride, AMD passe avec le R600 à un Ring bug totalement distribué où il est possible d'avoir simultanément une requête sur 512 bits et une réponse sur 512 bits alors que les puces mémoires sont physiquement interfacées sur 512 bits. Grâce à cette évolution, la bande passante mémoire augmente assez significativement puisqu'avec de la simple GDDR3, cadencée à une fréquence presque raisonnable, AMD annonce une bande passante de 106 Go/s. Conséquence toutefois du passage à 512 bits : l'augmentation du nombre de puces mémoire présentes sur la carte avec huit canaux, soit un total de 16 puces 32 bits. Notez que si le Radeon HD 2900 XT utilise de la mémoire GDDR3, le contrôleur est lui déjà compatible avec la GDDR4.

Radeon HD 2900 XT : AVIVO passe en version 2

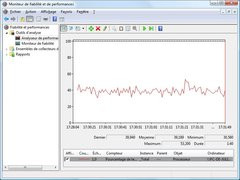

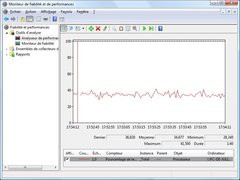

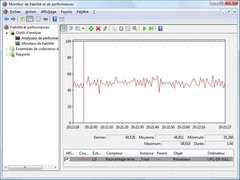

Si l'UVD est absent du R600, ce dernier profite tout de même de la technologie AVIVO HD qui consiste en de nouveaux effets de post-processing avec la gestion du désentrelacement ou encore de la mise à échelle. Nous avons bien sûr cherché à mettre en avant les performances d'AVIVO HD en termes de consommation processeur. Pour cela nous avons employé PowerDVD 7.3 Ultra dans sa version finale avec trois puces différentes : le GeForce 8800 GTS, le Radeon X1950 XTX et le Radeon HD 2900 XT. Pour ce dernier nous avons employé la version du logiciel fournit par AMD, une version légèrement adaptée à AVIVO HD. En source de lecture, nous avons retenu le HD-DVD Babel, un HD-DVD qui se distingue par son encodage : du H.264 à 20 Mbps de moyenne. Les trois captures ci-dessous indiquent la consommation processeur moyenne relevée sur nos trois puces :

Radeon X1950 XTX, GeForce 8800 GTS 640 Mo, Radeon HD 2900 XT

Comme on peut le constater, la consommation processeur relevée avec le Radeon HD 2900 XT est loin d'être la meilleure puisque c'est précisément la plus élevée ! 48% de moyenne contre 34% pour le GeForce 8800 GTS et 39% pour le Radeon X1950 XTX... Visiblement donc, AVIVO HD n'est pas opérationnel, dommage !

Mise à jour : Contrairement à ce qui est indiqué par les documentations d'AMD, l'UVD n'est pas présent dans le Radeon HD 2900 XT. Il est réservé uniquement aux Radeon HD 2400 et HD 2600.

Radeon HD 2900 XT : HDCP et HDMI

Autre nouveauté du R600 liée à la vidéo : l'inclusion des clés HDCP directement dans la puce graphique. Inutile donc pour le fabricant de carte graphique d'ajouter une puce CryptoROM ce qui garantit au passage que toutes les Radeon HD sont compatibles HDCP. Autre raffinement : les Radeon HD supportent le HDCP sur les sorties Dual-Link DVI. Cela permet aux possesseurs d'écran 30 pouces de bénéficier du décodage HDCP, fonctionnalité qui manque cruellement aux GeForce 8800. Enfin, et c'est ici une exclusivité du Radeon HD 2900 : la prise en charge native de l'interface HDMI avec intégration d'un contrôleur audio. Oui le R600 dispose d'une puce audio 5.1 utilisée pour transmettre en HDMI le flux audio accompagnant votre vidéo sans pour autant nécessiter de câblage particulier comme c'est le cas actuellement sur la plupart des Cartes Graphiques où il faut relier la carte à la sortie S/PDIF de la carte mère ou de la carte son. Cela aurait pu être une bonne idée, sauf que la compatibilité HDMI est limitée aux spécifications 1.2 de la norme. Exit donc la prise en charge des formats audio avancés comme le Dolby TrueHD ou le Lossless pourtant utilisés par les HD-DVD et Blu-ray. Et alors que les Radeon HD 2900 XT gèrent l'interface HDMI, aucune carte n'est dotée d'un connecteur HDMI physique puisqu'AMD a fait le choix de proposer un adaptateur DVI vers HDMI également compatible avec le transfert des signaux audio. Ce n'est pas un mal en soit, sauf que certains fabricants pourraient être tentés de ne pas fournir l'adaptateur, particulièrement sur les modèles entrée et milieu de gamme des déclinaisons du Radeon HD 2900...Radeon HD 2900 XT : la puce

Techniquement, le R600 comporte, selon les chiffres communiqués par AMD, près de 700 millions de transistors soit un peu plus que les 680 millions de transistors du GeForce 8800. Alors que la puce haut de gamme de NVIDIA est gravée en 90nm, AMD a retenu une finesse de gravure de 80nm pour son R600. Issue des usines de TSMC, la puce se distingue donc des futures Radeon HD 2400 et 2600 qui seront gravées en 65nm. Physiquement, la puce adopte une présentation différente des GeForce 8, le die étant visible, AMD n'ayant pas doté sa puce d'un couvercle métallique. On notera d'ailleurs la disposition en étoile du die.| GeForce 8800 GTS 640 Mo | GeForce 8800 GTX | GeForce 8800 Ultra | Radeon HD 2900 XT | |

| Interface | PCI-Express 16x | PCI-Express 16x | PCI-Express 16x | PCI-Express 16x |

| Gravure | 0,09µ | 0,09µ | 0,09µ | 0,08µ |

| Transistors | 681 Millions | 681 Millions | 681 Millions | 700 Millions |

| RAMDAC | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz |

| T&L | DirectX 10 | DirectX 10 | DirectX 10 | DirectX 10 |

| Stream Processors | 96 | 128 | 128 | 64x5 (320) |

| Unités ROP | 20 | 24 | 24 | 16 |

| Mémoire embarquée | 640 Mo | 768 Mo | 768 Mo | 512 Mo |

| Interface mémoire | 320 Bits | 384 Bits | 384 Bits | 512 bits |

| Bande passante | 64 Go/s | 86 Go/s | 101,3 Go/s | 106 Go/s |

| Fréquence GPU | 500 MHz | 575 MHz | 612 MHz | 740 MHz |

| Fréquence Stream Processors | 1200 MHz | 1350 MHz | 1500 MHz | 740 MHz |

| Fréquence mémoire | 800 MHz | 900 MHz | 1080 MHz | 825 MHz |

En matière de fréquences de fonctionnement, AMD recommande 740 MHz pour la puce graphique et 825 MHz pour les 512 Mo de mémoire GDDR 3 qui l'accompagnent. A noter, qu'au contraire du GeForce 8, les Processeurs de flux du Radeon HD 2900 XT opèrent à la fréquence nominale de la puce graphique. Une précision qui pourrait bien faire toute la différence au niveau des performances... Signalons également que pour la première fois sur une puce haut de gamme AMD, la prise en charge du CrossFire est ici native. A l'instar du RV570 qui anime les Radeon X1950 Pro, l'électronique CrossFire est intégrée directement à la puce. Plus besoin donc de câble externe ni de carte maître comme sur les Radeon X1800 et Radeon X1950.

Du côté de la consommation électrique, et comme on pouvait le redouter, le Radeon HD 2900 XT n'est pas franchement en progrès face à son prédécesseur, le Radeon X1950 XTX. Selon nos relevés, sa consommation électrique est plus importante et dépasse d'ailleurs celle du récent GeForce 8800 Ultra comme on peut le voir dans le tableau ci-dessous. Rappelons que le tableau comporte la consommation globale du système mesurée lors d'un test 3DMark 06 en 2560x1600. Dans un autre registre, l'enveloppe thermique, ou TDP, s'établit à 225 Watts pour la carte, soit 96 Watts de plus qu'un GeForce 8800 GTS 640 Mo... Et oui, le R600 chauffe et il chauffe beaucoup !

| Consommation électrique globale du système | |

| GeForce 8800 GTS 640 Mo | 273 Watts |

| GeForce 8800 GTX | 282 Watts |

| GeForce 8800 Ultra | 311 Watts |

| Radeon X1950 XTX | 280 Watts |

| Radeon HD 2900 XT | 333 Watts |

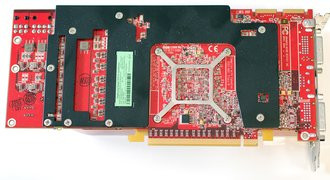

Radeon HD 2900 XT : la carte de référence

Pour ce test, nous avons pu récupérer une carte de référence AMD ainsi qu'une carte signée du fabricant taïwanais Jetway. Les deux cartes partageaient logiquement le même design avec un PCB rouge de 24 cm de long, à peine plus court donc que celui d'une GeForce 8800. Double slot, les cartes utilisaient le même système de refroidissement avec un cœur cuivre reposant sur la puce graphique et relié par deux heat-pipes à un radiateur également en cuivre. Gainé dans une coque de plastique rouge transparent, le système de refroidissement adopte en son extrémité un ventilateur façon cage d'écureuil dont le rôle sera d'expulser la chaleur à l'extérieur de la carte. Si le ventilateur est plutôt discret en 2D, il s'avère particulièrement bruyant en 3D, sa vitesse de rotation passant d'un mode réduit à un mode accéléré sans étape intermédiaire. Plutôt massif, le dispositif s'avère qui plus est assez lourd, ce qui a contraint AMD à disposer une plaque métallique sur le dos de la carte afin de minimiser les torsions.Au format PCI-Express 16x, la carte dispose de deux connecteurs d'alimentation électrique PCI-Express avec une petite particularité. Le premier connecteur est en effet un connecteur 8 broches alors que le second est un connecteur 6 broches. La plupart des alimentations ne disposant pas encore de connecteur PCI-Express 8 broches, celui-ci est compatible avec le raccordement d'un câble à six broches. Toutefois l'utilisation d'un tel câble désactivera la fonction OverDrive, qui overclocke automatiquement ou manuellement la carte graphique.

La carte de référence AMD Radeon HD 2900 XT

Avec 512 Mo de mémoire GDDR3, nos deux cartes étaient munies de puces Hynix certifiées à 1ns. Offrant des fréquences identiques aux spécifications établies par AMD, avec 740 MHz pour le cœur graphique et 825 MHz pour la mémoire, les cartes étaient munies d'une puce additionnelle Theater 200 pour la gestion de la capture vidéo analogique en entrée. En matière de connectique, les cartes Radeon HD 2900 XT comportent deux prises CrossFire, et deux connecteurs DVI en sortie en plus du connecteur mini-DIN.

Côté bundle enfin, la carte de Jetway est accompagnée de tout le nécessaire en matière de câblage avec deux adaptateurs Molex vers PCI-Express, deux adaptateurs DVI/VGA, un connecteur CrossFire, un adaptateur DVI vers HDMI et deux câbles regroupant les entrées/sorties vidéo analogiques. On retrouve également dans la boîte un manuel, un CD de pilotes et surtout un papier intitulé Black Box. Tous les Radeon HD 2900 XT, quelque soit leur marque, seront en effet livrés avec un coupon permettant d'obtenir gratuitement les jeux Half-Life 2 - Episode Two et Team Fortress 2 lorsqu'ils seront disponibles via Steam en téléchargement.

- Carte mère Asus P5W-DH Deluxe (BIOS 2004),

- Processeur Intel Core 2 Extreme X6800 (2,93 GHz),

- 2x 1 Go mémoire DDR2 Corsair Twin2X 6400C3,

- Disque dur Western Digital Raptor 150 Go Serial-ATA 150

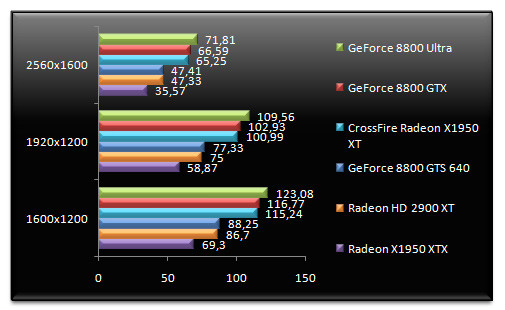

Nous avons un temps penser tester le CrossFire de Radeon HD 2900 XT, seulement voilà la configuration était particulièrement instable rendant tout test impossible. Notez que nous retenons ici des résolutions élevées de 1600x1200 à 2560x1600 en passant par le 1920x1200.

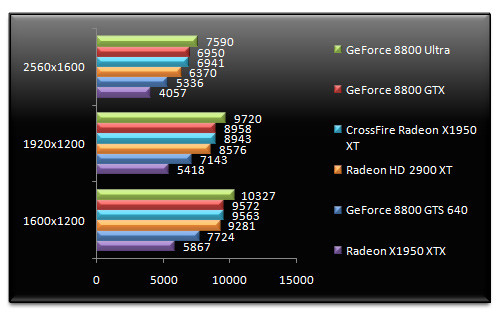

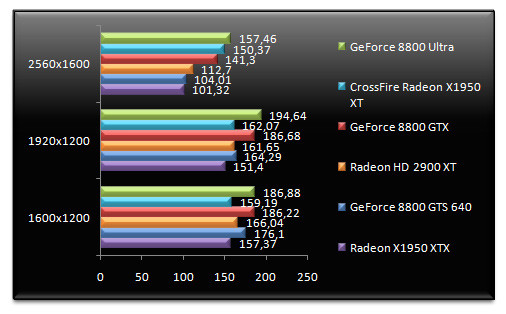

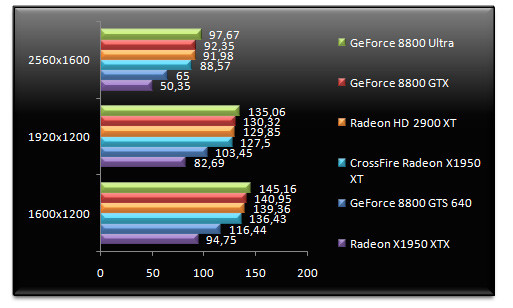

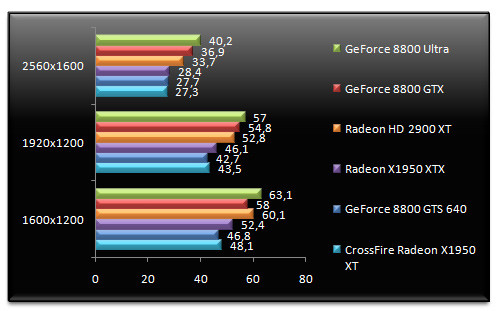

3DMark 06 - v1.1.0

On démarre avec un habitué des benchmarks, 3DMark 06. En tête nous retrouvons les GeForce 8800 Ultra et GeForce 8800 GTX alors que le CrossFire de Radeon X1950 XT parvient à afficher des performances supérieures au Radeon HD 2900 XT, ce dernier terminant quatrième. Comparativement au Radeon X1950 XTX, le petit dernier d'AMD est 57% plus performant en 2560x1600, un avantage qui se réduit à 19% face au GeForce 8800 GTS 640 Mo, son concurrent direct.

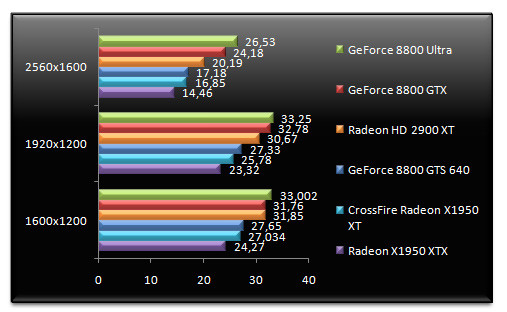

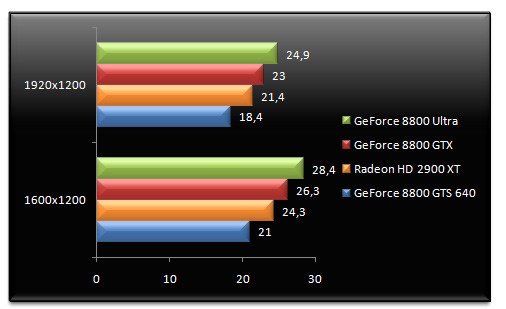

Doom 3 - v1.3

Ce bon vieux Doom 3 ne change pas le palmarès observé sous 3DMark 06, le trio de tête étant toujours constitué des GeForce 8800 Ultra et GTX et du CrossFire de Radeon X1950 XT. Le Radeon HD 2900 XT qui nous intéresse aujourd'hui termine donc quatrième en affichant des performances 19% supérieures au GeForce 8800 GTS 640 Mo en 2560x1600. Face au Radeon X1950 XTX, le nouveau-né d'AMD est 69% plus rapide en 2560x1600. Reste que dans cette résolution, le GeForce 8800 GTX se montre 18% plus performant.

Far Cry v1.4

Le patch final 1.4 de Far Cry n'étant pas compatible avec les effets de rendu HDR sous Windows Vista, nous désactivons tout simplement le rendu HDR. Alors que nos différentes puces semblent limitées par le processeur en 1600x1200 et en 1920x1200, le passage en 2560x1600 permet d'établir une certaine hiérarchie. En tête figure toujours le GeForce 8800 Ultra alors que la seconde place revient au CrossFire de Radeon X1950 XT qui devance ici le GeForce 8800 GTX. Notre Radeon HD 2900 XT est toujours quatrième mais l'écart avec le GeForce 8800 GTS 640 Mo se resserre sérieusement, la puce d'AMD étant seulement 8% plus rapide alors que le gain face au Radeon X1950 XT ne dépasse pas les 11%. Du coup notre GeForce 8800 GTX est loin d'être inquiété et peut tranquillement afficher des performances 25% supérieures au Radeon HD 2900 XT.

F.E.A.R. - v1.08

F.E.A.R., ici utilisé avec la diffusion des ombres, est le premier test qui permet au Radeon HD 2900 XT de terminer troisième (en 2560x1600), devant le système CrossFire, sans pouvoir toutefois inquiéter le GeForce 8800 GTX ni même le GeForce 8800 Ultra. Malgré cette remontée dans le classement, l'avantage du Radeon HD 2900 XT sur le GeForce 8800 GTS 640 Mo reste modéré : seulement 10% en 1920x1200. Comparé au Radeon X1950 XTX, le Radeon HD 2900 XT se révèle 51% plus performant en 1920x1200.

Splinter Cell Chaos Theory v1.05

Splinter Cell confirme la tendance observée avec F.E.A.R., le Radeon HD 2900 XT reprenant quelques couleurs. Si la dernière puce d'AMD fait respectivement mieux que notre système CrossFire et que le Radeon X1950 XTX seul, elle ne parvient pas à faire chanceler les GeForce 8800 GTX et Ultra. Face au GeForce 8800 GTS 640 Mo, le Radeon HD 2900 XT est tout de même 21% plus performant en 1920x1200, un chiffre qui demeure identique en 2560x1600. Face au Radeon X1950 XTX, le Radeon HD 2900 XT offre des performances 51% supérieures.

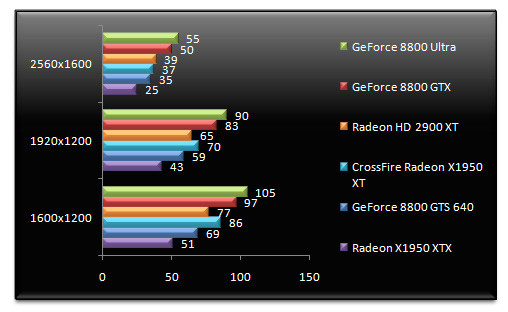

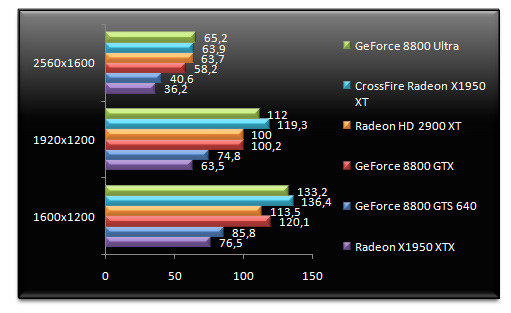

Half-Life 2 Lost Coast

On démarre cette seconde page avec Half-Life 2 Lost Coast. Ici, le Radeon HD 2900 XT tire bien son épingle du jeu même si les résultats semblent limités par le processeur de notre système. Le dernier représentant en date des Radeon est à égalité avec le GeForce 8800 GTX, le modèle Ultra conservant toutefois la pôle-position. Face au GeForce 8800 GTS 640 Mo, l'écart de performances en faveur du Radeon HD 2900 XT est assez conséquent puisqu'il atteint 41% ! Face au Radeon X1950 XTX, le Radeon HD 2900 XT est 83% plus rapide en 2560x1600.

Call Of Duty 2 - v1.3

Call Of Duty 2, la dernière version en date du FPS sur PC, confirme les bonnes prestations du Radeon HD 2900 XT qui se montre 14% plus rapide que le Radeon X1950 XTX en 1920x1200 et 23% plus performant que le GeForce 8800 GTS 640 Mo dans cette même résolution. Sans surprise toutefois, les GeForce 8800 GTX et Ultra sont largement en tête. La comparaison avec le GeForce 8800 Ultra attribue au dernier modèle de NVIDIA des performances 20% supérieures en 2560x1600 à celles du Radeon HD 2900 XT.

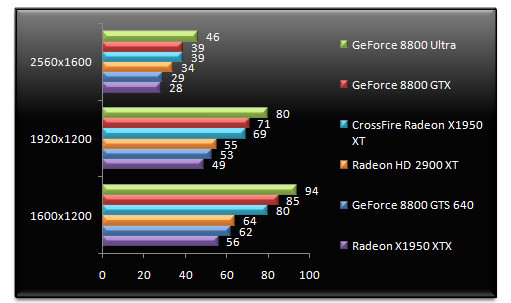

Supreme Commander

Alors que Call Of Duty 2 donnait une bonne image du Radeon HD 2900 XT, Supreme Commander dresse un état des lieux différent. Certes, le Radeon HD 2900 XT demeure classé troisième et plus la résolution augmente plus l'écart avec le GeForce 8800 GTS 640 Mo se creuse passant de 12% en faveur d'AMD en 1600x1200 à 17% en 1920x1200. Mais l'écart se creuse également face aux GeForce 8800 haut de gamme. Si en 1600x1200 le Radeon HD 2900 XT est équivalent au GeForce 8800 GTX, ce dernier se montre 19% plus performant en 2560x1600. Face au Radeon X1950 XTX enfin, le Radeon HD 2900 XT est globalement 30% plus rapide.

Company Of Heroes - v1.05

Petite rechute pour le Radeon HD 2900 XT sous Company Of Heroes, le CrossFire de X1950 XT lui volant la vedette, du moins en 2560x1600. D'après ce RTS plutôt récent, le GeForce 8800 GTX serait simplement 10% plus performant que le Radeon HD 2900 XT en 2560x1600 alors que la dernière puce d'AMD n'arrive hélas pas à égaler le GeForce 8800 Ultra ou même le CrossFire de Radeon X1950 XT. Face au Radeon X1950 XTX, le gain de performances obtenu en passant au Radeon HD 2900 XT atteint les 49% en 1920x1200, un chiffre qui demeure constant même en 2560x1600.

STALKER v1.0001

Autre jeu particulièrement récent, STALKER n'en inflige pas moins une véritable claque au Radeon HD 2900 XT. Ici, la dernière puce d'AMD est systématiquement derrière le GeForce 8800 GTS 640 Mo. En 1920x1200, le Radeon HD 2900 XT a beau être 76% plus performant que le Radeon X1950 XTX, le GeForce 8800 GTS 640 Mo reste 7% plus rapide que le dernier-né d'AMD. Quant aux performances du CrossFire... elles se passent de tout commentaire...

Call Of Juarez - DirectX 10

Pour la première fois depuis plusieurs mois, nous avons enfin un test DirectX 10 basé sur la prochaine mise à jour du moteur du jeu Call Of Juarez. Bien que soumis à caution, ce test donne une idée des performances DirectX 10 de nos cartes et si AMD pointe du doigt le fait que les GeForce 8 ne peuvent faire tourner le jeu lorsque l'anticrénelage est activé, suite à un bug du moteur, les performances du R600 ne semblent pas franchement sensationnelles du moins lorsque nous utilisons les pilotes 158.47 Beta fournis par NVIDIA, des pilotes qui améliorent grandement les performances des GeForce 8 sous Call Of Juarez. Ici, le Radeon HD 2900 XT est 16% plus rapide que le GeForce 8800 GTS 640 Mo en 1600x1200 mais les GeForce 8800 GTX et GeForce 8800 Ultra conservent l'avantage.

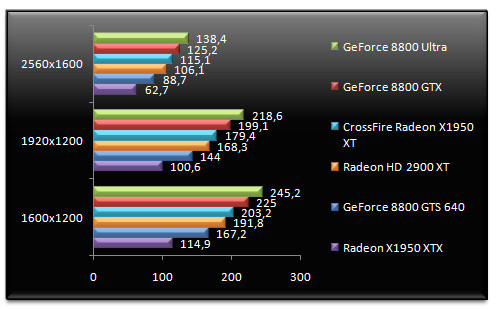

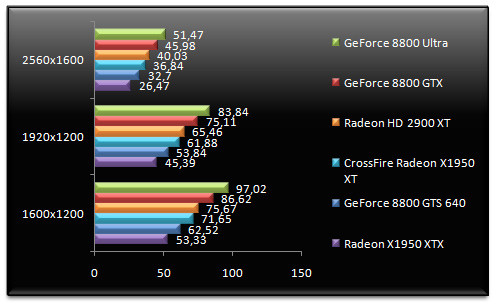

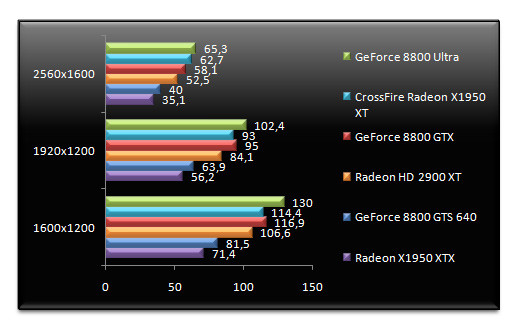

Doom 3 - v1.3 - AA 4x

On démarre cette troisième et dernière page de test en activant l'anticrénelage sous Doom 3. Première bonne surprise, le Radeon HD 2900 XT s'affiche ici à égalité avec le CrossFire de X1950 XT alors qu'il fait mieux que le GeForce 8800 GTX sans toutefois chatouiller le GeForce 8800 Ultra. Face au GeForce 8800 GTS 640 Mo, le Radeon HD 2900 XT est 57% plus rapide en 2560x1600, l'écart grimpant à 76% vis à vis du Radeon X1950 XTX. Mieux, si le CrossFire de X1950 XTX est plus rapide que le HD 2900 XT en 1600x1200 et en 1920x1200, ce dernier affiche des performances égales en 2560x1600.

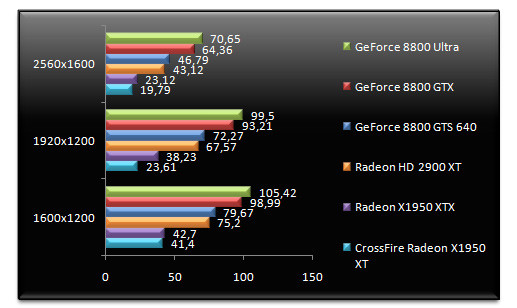

Call Of Duty 2 - v1.3 - AA 4x & AF

Forts de ces bons résultats, nous continuons avec Call Of Duty 2. Et... malheureusement c'est la déconvenue ! Le Radeon HD 2900 XT est ici moins rapide que le GeForce 8800 GTS 640 Mo, la puce de NVIDIA se montrant 11 à 13% plus performante en fonction de la résolution. Et face au Radeon X1950 XTX, le Radeon HD 2900 XT affiche des performances inférieures sauf en 2560x1600 où il peut se féliciter d'un avantage de 10%.

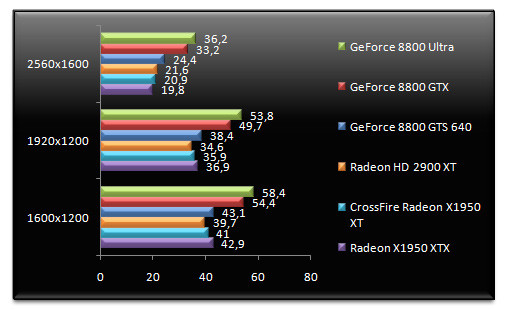

F.E.A.R. v1.08 - AA 4x - AF16x

F.E.A.R ne parvient pas vraiment à laver l'honneur du Radeon HD 2900 XT, une fois l'anticrénelage activé, car si la dernière puce d'AMD fait tout de même un peu mieux que le GeForce 8800 GTS 640 Mo, elle est à des années lumières du CrossFire de Radeon X1950 XT ou des GeForce 8800 GTX. 3% plus rapide que le GeForce 8800 GTS 640 Mo en 1920x1200, le Radeon HD 2900 XT est 12% plus rapide que son prédécesseur dans cette résolution. Mais le CrossFire demeure 25% plus rapide quand le GeForce 8800 GTX est 29% plus performant.

Half Life 2 Lost Coast - AA4x - AF16x

Terminons avec Half-Life 2 où nous activons l'anticrénelage et le filtrage anisotropique. C'est une claque supplémentaire pour le Radeon HD 2900 XT qui est en retrait du GeForce 8800 GTS 640 Mo même si son avantage sur le Radeon X1950 XTX atteint 33% en 2560x1600. Derrière le GeForce 8800 GTS 640 Mo, le Radeon HD 2900 XT se fait pulvériser par le CrossFire de X1950 XT et donc logiquement par les GeForce 8800 GTX et Ultra qui semblent ici intouchables.

Conclusion

Le plus grave est à chercher du côté de l'anticrénelage où les performances ne sont clairement pas au rendez-vous alors que les espoirs de voir de futurs pilotes les améliorer sont très minces, une partie des unités ROP étant défaillante. Que dire d'une puce haut de gamme dont les performances en anticrénelage 4x sont parfois inférieures au Radeon X1950 XTX de génération précédente ? Et ce n'est pas en regardant la température générée par la carte ou sa consommation électrique que le bilan va s'améliorer ! Pauvre petit Knut, l'ours polaire abandonné par sa maman avec qui même Leonardo di Caprio a posé, ce n'est pas avec de telles cartes que le réchauffement climatique va être enrayé...

Mais n'allez pas croire pour autant que le R600 soit une mauvaise puce, non, bien au contraire ! Car si les performances ne sont pas révolutionnaires, elles sont toutefois supérieures en général au GeForce 8800 GTS 640 Mo et ce à la fois en DirectX 9.0 et en OpenGL (ce dernier point étant presque ironique). Du côté des performances DirectX 10, il est beaucoup trop tôt pour tirer une quelconque conclusion du premier test issu du jeu Call Of Juarez. Il faudra attendre l'arrivée des jeux DirectX 10 pour véritablement se faire une opinion, même si AMD dit offrir des performances supérieures au GeForce 8 lorsqu'il s'agit de traitement des geometry shaders, un point qu'il faudra vérifier.

Plus rapide que le GeForce 8800 GTS, le Radeon HD 2900 XT le surpasse également en termes de fonctionnalités. On pense naturellement au nouvel AVIVO HD, bien que l'UVD soit finalement aux abonnés absents, ou encore à la gestion du HDCP sur les sorties Dual-DVI, autant de fonctionnalités qui font hélas défaut au GeForce 8 de NVIDIA. On aurait pu mentionner le HDMI natif avec contrôleur audio intégré, sauf qu'AMD se borne à supporter la norme 1.2 fermant ainsi la porte au Dolby TrueHD, rendant ce support pratiquement inutile pour les HD-DVD et Blu-ray. Au final, et même si NVIDIA conserve sa couronne sur le terrain des performances, le Radeon HD 2900 XT s'affiche comme une carte intéressante surtout au tarif annoncé : entre 379 et 399 euros TTC, soit plus ou moins le même prix que le GeForce 8800 GTS 640 Mo avec en prime un bundle jeu conséquent, Half-Life 2: Episode 2 étant livré avec toutes les cartes AMD. Incarnant pour la première fois depuis six mois une alternative aux GeForce 8, le Radeon HD 2900 XT n'est hélas pas en mesure de disputer le leadership à NVIDIA...

Le Radeon HD 2900 XT vous intéresse ? Retrouvez-le dans le