NVIDIA a lancé à l'approche de l'été 2016 sa carte graphique haut de gamme, la GeForce GTX 1080. Une carte graphique que l'on nous a promis plus rapide grâce à une nouvelle micro-architecture notamment.

Au cœur de cette GeForce GTX 1080 on retrouve une toute nouvelle micro-architecture connue sous le nom de code Pascal. Après Fermi, Kepler et Maxwell, c'est donc un énième grand savant qui prête son nom au GPU haut de gamme de NVIDIA et ses futures déclinaisons.

Si la version professionnelle de Pascal est taillée pour le marché des datacenters avec des nouveautés significatives sur des aspects cruciaux, notamment pour le deep learning, la déclinaison grand public se veut plus proche des préoccupations quotidiennes des gamers. Et c'est finalement bien normal.

Avec Maxwell, la précédente génération d'architecture, NVIDIA avait placé la barre assez haut en termes d'efficacité énergétique et de rapport performances par watts. Visiblement, le caméléon est bien décidé à récidiver avec Pascal. Il faut dire que la petite dernière de NVIDIA va profiter d'un avantage de taille : une finesse de gravure bien supérieure.

Jen Hsun Huang, cofondateur de NVIDIA, lors de la présentation de la GeForce GTX 1080, à Austin

Tandis que les deux générations de Fermi étaient gravées en 40 nm, Kepler, incarné par la GeForce GTX 680 et ses descendantes, profitait d'une finesse de fabrication en 28 nm, tout comme Maxwell, coincé sur un process en 28 nm. Pascal, lui, inaugure une finesse de gravure en 16 nm FinFet : une vraie première dans l'industrie du GPU que l'on n'attendait (presque) plus... depuis fin 2011 (c'était le Radeon HD 7970 : AMD revient sur le très haut de gamme, en DirectX 11.1) !

Et si NVIDIA innove ou plutôt étrenne un nouveau procédé de fabrication, le caméléon reste plus prudent du côté de la mémoire. On se souvient en effet que le top du top d'AMD inaugurait une mémoire HBM. Une mémoire technologiquement à la pointe avec une bande passante extraordinaire mais des contraintes certaines qui ont conduit AMD à proposer une Fury X avec seulement 4 Go de mémoire vidéo.

Gardons enfin à l'esprit que cette GeForce GTX 1080 n'est pas un modèle Ti, NVIDIA démarre donc sa nouvelle génération graphique avec une carte haut de gamme mais un « petit GPU » toutes proportions relatives, le GP104.

Mise à jour : Cet article a été mis à jour une première fois le 20 mai 2016, suite à nos soucis de plate-forme, avec cette fois-ci des benchs intégrant les cartes AMD du moment à savoir les Radeon R9 390X, Radeon R9 Fury (également appelée Fury Pro) et Radeon R9 Fury X. La conclusion a été mise à jour en fonction avec également une notation adéquate alors que nous avons rajouté quelques tests en overclocking.

27 juin 2016 : nouvelle mise à jour pour revenir sur le SLI et les performances en SLI de deux GeForce GTX 1080.

Une architecture proche de l'existant

Alors que l'on attendait une architecture refondue pour Pascal, celle-ci évolue en douceur par rapport aux générations précédentes et notamment à Maxwell.Ainsi, on retrouve toujours une puce DirectX 12 composée de GPC, ces grands blocs contenant nos SM, les Streaming Multiprocessors, lesquels abritent finalement nos cœurs d'exécution CUDA qui sont en quelque sorte les petites mains de la puce. Ce sont ces unités qui vont travailler sur les pixels de nos jeux et autres programmes 3D (ou non d'ailleurs).

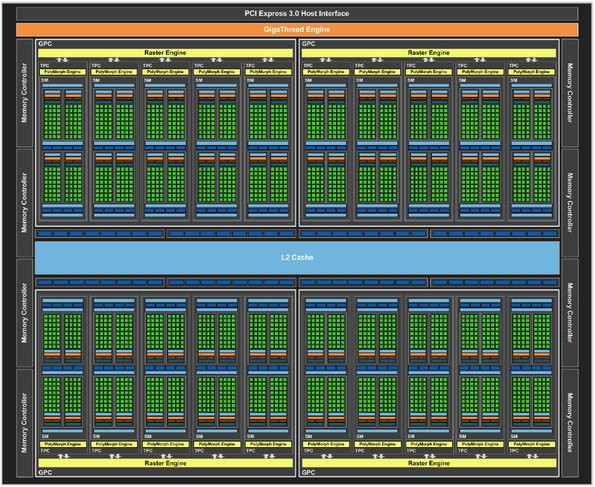

La puce est découpée en quatre grands GPC et de ce côté-là, il n'y a pas de changements. NVIDIA fait évoluer sa terminologie et parle maintenant de TPC pour désigner un bloc combinant à la fois le PolyMorph Engine, qui regroupe certaines fonctions géométriques, ainsi qu'un SM.

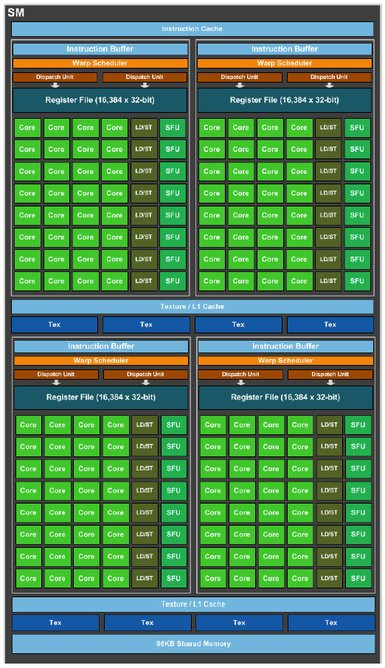

Avec Pascal, tout comme avec Maxwell, chaque GPC dispose de son propre moteur de rasterisation ; on compte 5 SM par GPC où chaque SM comporte 128 unités CUDA. Les unités CUDA sont organisées en petits groupes : 32 threads par bloc, ce qui revient à dire qu'un SM est composé de quatre blocs de 32 unités CUDA. Dans chacun des blocs d'un même SM, on retrouve un registre de 64 ko, soit 256 ko de registre au total, tandis que notre SM a à sa disposition 96 ko de mémoire partagée, 48 ko de cache L1 et 8 unités de texture. Il n'y a ici aucun changement par rapport au GK104 de Maxwell.

Gros plan sur le diagramme de la puce GP104

Au total donc, dans sa configuration complète, la puce GP104 du GeForce GTX 1080 propose 2560 unités CUDA et 160 unités de texture. A cela s'ajoute une mémoire cache de second niveau partagée entre toutes les unités de la puce avec 2 Mo alors que le bus mémoire est interfacé sur 256 bits via 8 contrôleurs mémoire de 32 bits. Le nombre d'unités ROP demeure donc identique à 64.

Zoom sur un SM complet

Des technologies de compression mémoire supérieures

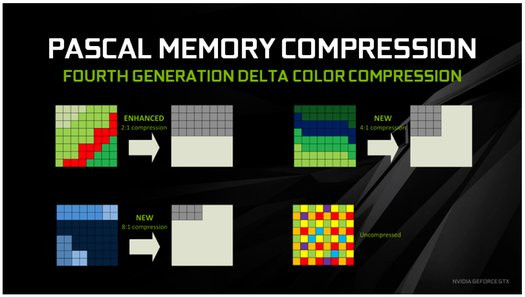

Si l'architecture n'est pas bouleversée sur le plan schématique, NVIDIA a pris soin d'améliorer certains aspects, notamment la compression mémoire. L'idée étant de réduire la bande passante mémoire consommée via des techniques intelligentes de compression qui se veulent non destructrices.Ainsi à bande passante équivalente, la consommation mémoire peut être inférieure non seulement du côté du frame buffer, mais aussi du côté de l'utilisation de la mémoire cache de second niveau et des transferts entre mémoire et cache, mais aussi entre mémoire vidéo et unités de texture.

Les différentes techniques de compression de Pascal

Ces techniques de compression mémoire ne sont pas nouvelles. De tout temps, les fabricants de GPU ont cherché à optimiser l'usage de la mémoire avec divers artifices et algorithmes plus ou moins efficients. Du reste, NVIDIA avait déjà entamé des travaux dans ce sens avec Maxwell. L'un des moyens d'y parvenir est de calculer la différence de couleur dans une zone, par rapport à une couleur repère : plus l'écart avec une couleur proche est faible, plus la réduction de la consommation mémoire sera importante. C'est ce qu'on appelle la compression delta. Dans le meilleur des cas, la compression 2:1 peut donner en résultat une empreinte des données deux fois inférieure à l'empreinte initiale.

NVIDIA revendique ici un algorithme plus efficace, par ailleurs, un mode 4:1 a été ajouté, toujours pour le codage différentiel, afin de gérer les cas de figure où la différence entre les pixels est plus que minime et ainsi d'atteindre un ratio de ¼ l'espace de stockage original. Enfin un mode 8:1 est également ajouté et combine 4:1 et 2:1.

Efficacité supposée des nouveaux algorithmes de compression mémoire : au milieu Maxwell, à droite Pascal

Selon le constructeur, l'ensemble de ces nouvelles techniques de compression devrait prodiguer jusqu'à 20% de bande passante mémoire supplémentaire, ce qui, combiné à la mémoire plus rapide utilisée sur la GeForce GTX 1080 permettrait à la puce de disposer d'une bande passante mémoire 1,7 fois supérieure à une GeForce GTX 980.

Asynchronous Compute

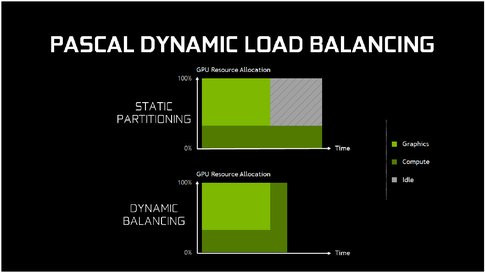

L'évolution des jeux et de leur moteur a pour conséquence une plus grande variété de scenarii d'utilisation de la puce. Il n'est pas rare que la puce graphique doive gérer à la fois physique et graphique, ou qu'elle doive effectuer le rendu 3D et son post-traitement.Ces scenarii asynchrones ont divers effets de bord avec la nécessité pour la puce de gérer au mieux une variété de situations. On déplorerait qu'un workload n'utilise pas pleinement les ressources de la puce, alors que celle-ci aurait pu être configurée différemment pour exécuter deux workloads simultanément, pour une meilleure efficacité.

Pour gérer cela au mieux, Pascal introduit une gestion du load balacing dynamique : le partitionnement statique du GPU et des unités consacrées à telle ou telle charge de travail, qui était de mise sous Maxwell, est maintenant dynamique. Cela permet à l'une des tâches concomitantes de recourir à toutes les ressources disponibles de la puce, mais non utilisées, pendant que l'autre tâche continue de tourner.

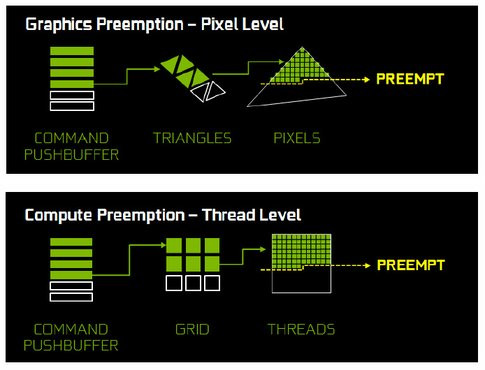

L'autre cas de figure fréquent pour les calculs asynchrones est celui des workloads qui doivent s'exécuter impérativement dans une fenêtre de temps critique au risque de retarder tout le reste du pipeline et d'engendrer la perte de frame. Dans les générations précédentes, les GPU se contentaient de supporter un changement de contexte très rapide. Avec Pascal, NVIDIA inaugure le Pixel Level Preemption : il s'agit de faire en sorte que les unités graphiques de Pascal soient plus intelligentes, en sachant où elles en sont de leur progrès, dans un travail de rendu par exemple. Ainsi, elles peuvent s'interrompre, sauvegarder les informations de contexte, redémarrer plus tard, là où elles en étaient et être préemptées pour exécuter une tâche dans l'urgence, plus prioritaire, ayant trait à des pixels. Selon NVIDIA, un tel changement de contexte avec le passage à une nouvelle tâche de travail peut être complété en moins de 100 µs.

On retrouve le même genre de support amélioré pour une préemption de type « compute ». Une facilité qui conviendra donc aux programmes CUDA, d'autant que NVIDIA autorise une granularité très fine de l'ordre de l'instruction. Et ce n'est pas le seul avantage attendu, puisque selon NVIDIA cette avancée architecturale de Pascal devrait également profiter aux calculs destinés à la réalité virtuelle.

Moteur SMP : un rendu, plusieurs projections

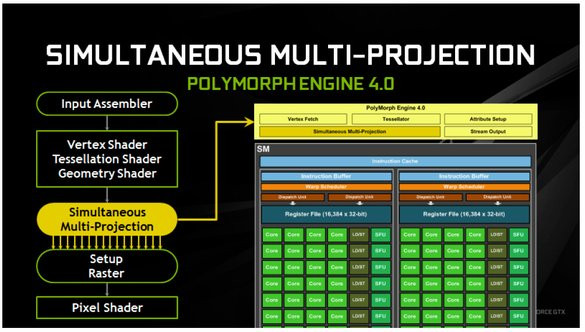

Nous l'avons vu, l'architecture de Pascal est très proche de l'agencement opéré par le constructeur avec Maxwell. S'il n'y a pas de grand redécoupage de la puce ou de ses unités d'exécution, NVIDIA fait évoluer le Polymorph Engine, ce bloc que l'on retrouve à la tête de chaque TPC (souvenez-vous, un TPC désigne maintenant un SM, c'est-à-dire un bloc Streaming Multiprocessor, avec un Polymorph Engine).

Le moteur SMP fait son apparition dans les Polymorph Engine

Traditionnellement, le Polymorph Engine renferme les blocs de géométrie. Pour autant, NVIDIA ne semble pas estimer que nos jeux ont besoin de plus de puissance en la matière ; aussi, la nouveauté n'est pas à chercher du côté de la tesselation. NVIDIA préfère ajouter un bloc baptisé Simultaneous Multi-Projection. Ce nouveau moteur matériel a un rôle simple et pourtant assez crucial pour certains : générer plusieurs projections d'un seul et même flux géométrique. Situé en bout de pipeline géométrique, ce bloc peut gérer jusqu'à 16 projections pré-configurées en partageant deux centres de projection différents ce qui, in fine, peut permettre de répliquer la géométrie jusqu'à 32 fois sans pénalité sur les performances. Mais à quoi cela sert-il me direz-vous ? Simple ! L'idée est de permettre aux possesseurs de systèmes à trois écrans - des écrans généralement placés, non pas en ligne droite, mais avec un angle les uns par rapport aux autres -, d'avoir une perspective correcte et non déformée sur leur ensemble d'affichage. Bien sûr, cela ne s'adresse par à tous les gamers, mais cette fonctionnalité sera vite vite considérée comme un must-have pour les férus de simulation (notamment).

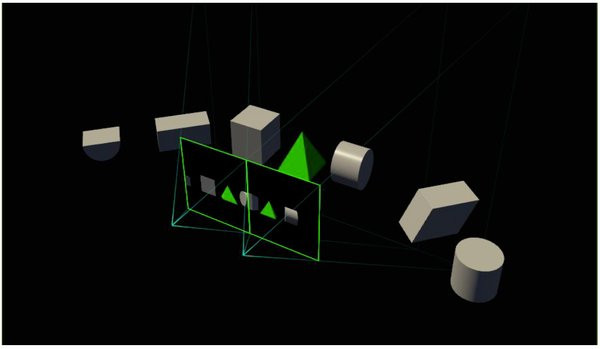

Le SMP par l'exemple

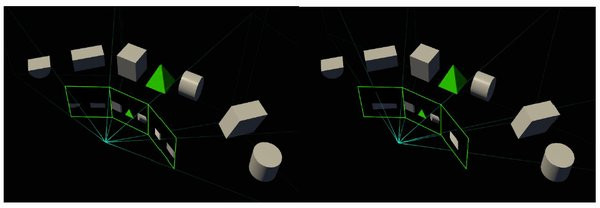

Le cas des configurations d'affichage Surround Gaming n'est pas le seul qui profitera du SMP. La VR, encore elle, saura en tirer profit. L'idée étant d'effectuer en une seule passe le rendu VR nécessaire pour chacun de nos deux yeux. Rappelons, en effet, que dans notre casque de réalité virtuelle, qu'il soit Oculus ou Vive, chaque œil voit une image légèrement différente. Cette possibilité de rendu stéréo en une seule passe (le traitement des vertex n'est fait qu'une seule fois) est baptisée Single Pass Stereo par NVIDIA et devrait logiquement profiter aux performances de rendu avec un casque de réalité virtuelle.

Un autre scénario envisagé par NVIDIA pour tirer profit de son SMP, toujours dans le cadre de la VR, est de faire du Lens Matched Shading. Dans un casque de réalité virtuelle, chaque écran dispose d'une lentille, de sorte que vous voyiez ce qui s'affiche réellement sur des écrans si proches de vos yeux. Traditionnellement, une puce graphique fait un rendu en deux étapes de l'image qui doit s'afficher dans le casque, tandis que la correction de la lentille va déformer l'image ; aussi, cette image déformée pèserait moins lourd si, dès le départ, le GPU faisait un rendu adapté aux lentilles de votre casque. Dans sa documentation, NVIDIA explique pouvoir ramener une image source de 2,1 mégapixels par œil à 1,4 mégapixels par œil grâce au SMP. Pascal va ainsi diviser l'affichage en quatre quadrants, chacun avec son angle de projection, pour s'approcher de la distorsion générée par l'optique de votre casque, se débarrassant au final d'un certain nombre de pixels inutiles dans le pipeline de rendu et libérant mécaniquement de la ressource pour autre chose, ou pour simplement soutenir les 90 images par seconde requises pour une bonne expérience en réalité virtuelle.

Lens Match Shading : image de la première passe à gauche et rendu final à droite

Une puce taillée pour la vitesse

Pour sa première apparition publique, Pascal se décline donc sous la forme d'une puce GP104. Celle-ci compte la bagatelle de 7,2 milliards de transistors, d'après la marque, et est gravée pour la première fois en 16 nm FinFet par TSMC. Un bond significatif face aux 28 nm des Kepler/Maxwell.Et si la puce GP104 compte plus de transistors que le GM104 des GeForce GTX 980 (on passe de 5,2 à 7,2 milliards de transistors), cela reste un poil moins que les 8 milliards de transistors du GM200 des GeForce GTX 980 Ti et Titan X. La taille du die, c'est-à-dire la taille physique de la puce, est également revue à la baisse : 314 mm² contre 398 mm².

Au-delà des gains attendus par un procédé de gravure plus moderne, NVIDIA insiste sur l'optimisation de la conception de la puce en elle-même qui aurait été pensée dès le départ pour atteindre des fréquences supérieures.

De la mémoire GDDR5X

Nous l'évoquions, NVIDIA n'a pas fait le choix de la mémoire HBM pour Pascal, attendant probablement une seconde génération. Si le HBM n'est pas retenu, NVIDIA a sélectionné la GDDR5X, un nouveau standard de mémoire qui se veut à la fois économe en consommation énergétique et capable de monter haut en fréquence. Cela n'est pas sans impact sur le design de la carte qui a du, là encore, être spécialement étudié pour soutenir les débits attendus de la GDDR5X à 10 Gbps. Le constructeur a sélectionné Micron pour lui fournir les composants de mémoire GDDR5X opérant à 1,35v.

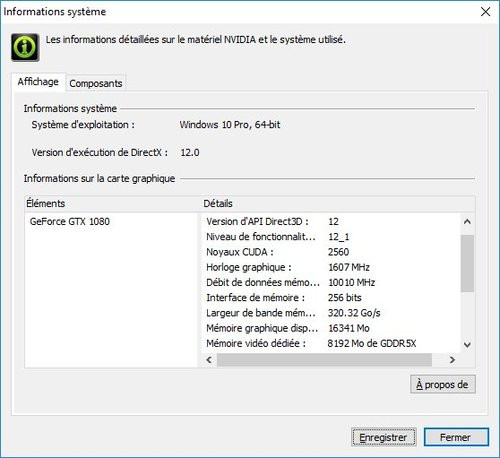

Les fréquences du GP104 vues par les pilotes NVIDIA

Quid des fréquences ?

NVIDIA le martèle, Pascal a été pensé pour la vitesse. Soit, mais qu'en est-il dans les faits ? De base, la puce de notre GeForce GTX 1080 tourne à 1 607 MHz, sa fréquence Boost grimpe à 1 733 MHz. Rappelons tout de même que la génération précédente, pour ce qui est de la GeForce GTX 980, opérait en standard à 1 126 MHz avec un Boost à 1 216 MHz.| GeForce GTX 980 | GeForce GTX 980 Ti | GeForce GTX Titan X | GeForce GTX 1080 | Radeon R9 Fury X | |

| Interface | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen3 |

| Gravure | 0,028 µ | 0,028 µ | 0,028 µ | 0,016 µ | 0,028 µ |

| Transistors | 5,2 milliards | 8 milliards | 8 milliards | 7,2 milliards | 8,9 milliards |

| T&L | DirectX 12 | DirectX 12 | DirectX 12 | DirectX 12 | DirectX 12 |

| Stream Processors | 2048 | 2816 | 3072 | 2560 | 4096 |

| Unités ROP | 64 | 96 | 96 | 64 | 64 |

| Unités de texture | 128 | 176 | 192 | 160 | 256 |

| Mémoire embarquée | 4096 Mo | 6144 Mo | 12288 Mo | 8192 Mo | 4096 Mo |

| Interface mémoire | 256 bits | 384 bits | 384 bits | 256 bits | 4096 bits |

| Bande passante | 224 Go/s | 336,5 Go/s | 336,5 Go/s | 320 Go/s | 512 Go/s |

| Fréquence GPU | 1126 MHz (base) | 1000 MHz (base) | 1000 MHz (base) | 1607 MHz (base) | 1050 MHz (base) |

| Fréquence Stream Processors | 1126 MHz (base) | 1000 MHz (base) | 1000 MHz (base) | 1607 MHz (base) | 1050 MHz (base) |

| Fréquence mémoire | 1750 MHz (GDDR5) | 1750 MHz (GDDR5) | 1750 MHz (GDDR5) | 2500 MHz - GDDR5X | 500 MHz - HBM |

Le caméléon améliore donc les fréquences de fonctionnement, en standard comme en Boost, alors que la puce sera aidée par la mémoire GDDR5 laquelle mouline à 2 500 MHz contre 1 750 MHz précédemment. La bande passante mémoire théorique progresse donc de 224 Go/s pour une GeForce GTX 980 à 320 Go/s pour la GeForce GTX 1080 ! Quand même !

GPU Boost passe la troisième

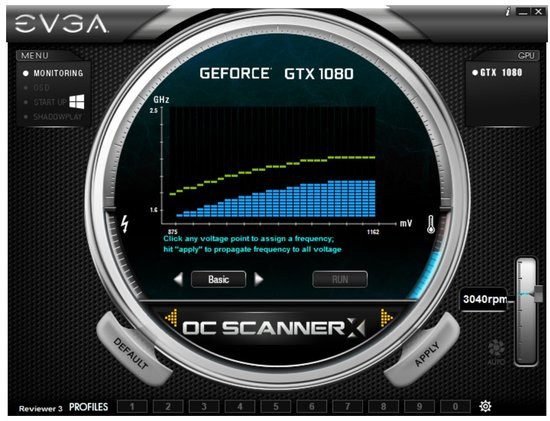

La technologie d'overclocking dynamique de NVIDIA revient sur Pascal en version 3.0. Pas de bouleversement particulier pour cette v3 qui est simplement supposée utiliser à meilleur escient les opportunités de montée en fréquence possible pour une puce graphique donnée à chaque point d'alimentation. Les GPU d'une même série étant loin de tous être égaux, NVIDIA laisse ses partenaires mettre à jour leurs utilitaires pour automatiquement déterminer le delta de fréquence le plus stable pour un point d'alimentation donné. EVGA l'a déjà implémenté dans son utilitaire Beta PrecisionX et il faut un peu de temps et de patience pour la construction de la courbe.

EVGA PrecisionX et sa nouvelle fonction scanner pour soutenir GPU Boost 3.0

Sur notre carte de test, la fréquence de base est bien de 1607 MHz pour le GPU. En Boost, nous atteignons des pointes à 1835 MHz avec une stabilisation autour des 1792 MHz en charge.

Le Boost en action

Le SLI revisité (ou presque)

NVIDIA profite de l'arrivée de Pascal pour dépoussiérer quelque peu sa technologie de rendu multi-GPU, le SLI, qui n'a pas évolué depuis des années, et franchement, depuis le lancement de la GeForce 6800 par-là, hormis quelques tweaks logiciels.Premier changement intéressant à noter, NVIDIA recommande maintenant un SLI à deux cartes. Si les configurations 3-Way et Quad-SLI sont toujours supportées, la marque ne les met plus en avant. Seconde modification : l'interface SLI en elle-même. Sur la carte GeForce GTX 1080, la connectique ne change pas. Ce qui change c'est le dongle : le constructeur recommande maintenant des dongles utilisant les deux connecteurs SLI pour plus de bande passante. La carte reste compatible avec les anciens dongles SLI mais dans ce cas... les performances sont moindres.

La fréquence de l'interface SLI évolue également puisqu'elle tourne maintenant à 650 MHz contre 400 MHz. Cette montée en fréquence, combinée à l'utilisation de deux lignes SLI plutôt qu'une seule, doit permettre de doubler la bande passante entre les GPU par rapport aux précédentes générations de GeForce.

Pour remplacer les anciens bridges SLI, NVIDIA propose des bridges SLI HB (HB signifiant High Bandwidth) vendus sur sa boutique américaine. Pour l'heure, on ne sait pas si les fabricants de cartes mères ou de cartes graphiques intégreront ces nouveaux bridges avec leurs produits. Asus et EVGA, qui proposent des bridges SLI au détail, devraient toutefois apporter rapidement une réponse à cette interrogation. Notez que les dongles SLI existants, embarquant une diode, devraient être compatibles avec la fréquence de fonctionnement de 650 MHz. Et il est toujours possible de brancher deux dongles SLI traditionnels pour obtenir le même résultat.

Reste à savoir si le SLI a encore un avenir. Comme nous l'évoquions largement dans notre dossier consacré aux premiers titres DirectX 12, aucun des jeux majeurs sortis à cette date n'est compatible avec le SLI (ni avec le Crossfire d'ailleurs). Sans refaire l'historique, les développeurs doivent prendre en charge le rendu multi-GPU de leur côté... ce qu'ils ne font pas. Ainsi ni Rise Of The Tomb Raider, ni Quantum Break, ni Hitman ne sont compatibles multi-GPU.

Nouveau dongle SLI HB

Sachez enfin que si le rendu 3-Way et 4-Way n'est plus recommandé - mais toujours supporté -, il passe par la génération d'une clé. Le possesseur d'un système SLI à trois ou quatre cartes graphiques devra exécuter une app en local sur son PC pour générer une signature GPU, afin de s'enregistrer sur un site NVIDIA. Ce dernier délivrera une clé, sorte de certificat, qui débloquera le rendu 3-Way / 4-Way.

Fast Sync entre en scène

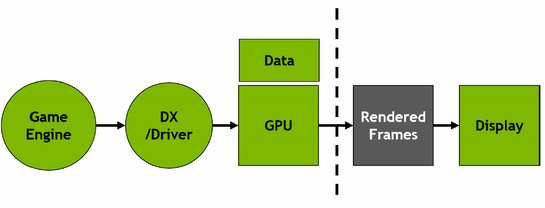

Vous connaissiez la V-Sync et ses effets, vous connaissiez Adaptative Sync et bien sûr, l'ineffable G-Sync. NVIDIA introduit maintenant Fast Sync. Il ne s'agit pas ici de racheter un écran mais bien de faire en sorte que l'affichage soit toujours le plus fluide possible, sans pour autant tirer les performances vers le bas.Pour cela, NVIDIA découple le rendu et l'affichage permettant ainsi au GPU de générer continuellement des images à pleine vitesse avec un stockage éventuel des images dans la mémoire vidéo. De sorte que le moteur du jeu fonctionne comme si la synchronisation verticale était coupée, alors que Fast Sync décide quelle image, dans son intégralité, afficher de sorte à éviter tout effet de déchirement.

En clair, Fast Sync combine les mérites d'une image générée avec la synchronisation activée, à ceux des performances obtenues lorsque la V-Sync est coupée ; et son temps de latence, bien que supérieur à celui d'un rendu avec V-Sync Off, est largement inférieur à celui obtenu en V-Sync On. A essayer donc et à voir si NVIDIA ne complète pas prochainement avec une nouvelle fonctionnalité baptisée en interne Smooth Silkness, mais non encore implémentée dans les pilotes.

Activation du Fast Sync dans les pilotes NVIDIA

Affichage mis à jour : HDR et 4K

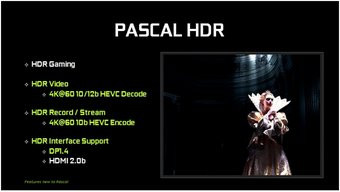

NVIDIA profite de sa nouvelle architecture graphique pour faire évoluer son moteur d'affichage. Avec des avancées notables, puisque si la puce peut toujours gérer jusque six connecteurs et quatre affichages simultanés, elle est maintenant compatible HDMI 2.0b avec HDCP 2.2, mais aussi certifiée DisplayPort 1.2 et qualifiée de prête pour les DisplayPort 1.3/1.4.La carte est également certifiée PlayReady 3.0, du nom de la technologie Microsoft, ce qui permet la diffusion, en streaming, de contenu 4K depuis Netflix, notamment. Pascal est, en effet, capable de décoder matériellement les flux HEVC (profil 10-bit inclus) tout comme il est capable de les encoder matériellement.

Du côté des écrans, il est possible, pour la puce, de piloter des panneaux 4K à 120 Hz et des écrans 5K à 60 Hz. Le constructeur précise prendre en charge les écrans 8K à 60 Hz au moyen de deux câbles. Le HDR n'est pas oublié et si NVIDIA prenait déjà en charge plusieurs techniques de rendu à plage dynamique haute, Pascal améliore encore les choses avec notamment la possibilité de décoder les flux vidéos HDR en 4K 60 Hz 10/12 bits, mais aussi de les encoder sur 10 bits pour la postérité ou, pourquoi pas, faire du GameStream vers sa TV et sa Shield Android TV qui saura les décoder.

Les pères fondateurs

NVIDIA propose, pour ce lancement, son habituel design de référence rebaptisé pour la circonstance en Founders Edition. L'idée étant que les partenaires de la marque continuent de proposer des GeForce GTX 1080 avec le système de refroidissement de NVIDIA tout au long de la durée de vie du produit et pas uniquement les premières semaines du lancement.La carte est finalement assez semblable aux GeForce GTX 980, GeForce GTX 980 Ti et autres Titan. On retrouve un PCB noir, une connectique PCI-Express 16x 3.0, et un format double slot. Le carénage du système de refroidissement a été revu et celui-ci reprend des matériaux soignés avec un radiateur en aluminium. Le look à facettes est plus agressif, mais l'idée demeure avec un ventilateur cage d'écureuil dans son extrémité, qui expulsera l'air chaud à l'extérieur du système en soufflant sur un radiateur de type chambre à vapeur.

Selon les années les crus et les millésimes, la backplate, ou plaque arrière, protégeant l'arrière du PCB de la GeForce va et vient. Elle est de retour avec la GeForce GTX 1080 dans une version un tantinet plus fine que sur GeForce GTX 980 et, toujours, avec la promesse de ne pas causer de problèmes en SLI (on pourra enlever une partie de la backplate pour permettre une meilleure circulation de l'air).

L'étage d'alimentation de la carte évolue pour un design à cinq phases censé aider dans la poursuite d'une meilleure efficacité énergétique. L'alimentation se fait via un seul et unique connecteur PCI-Express 8 broches tandis que la carte est annoncée pour un TDP, ou enveloppe thermique, inférieur à 250 watts : 180 watts pour être précis. NVIDIA propose en sortie un port DVI, un connecteur HDMI et trois ports DisplayPort. On retrouve logiquement les habituels connecteurs SLI sur la tranche de la carte.

Voici la configuration utilisée pour évaluer les performances de Pascal et de cette nouvelle GeForce GTX 1080 :

- Carte mère Asus Z170 Deluxe (BIOS 1702),

- Processeur Intel Core i7 6700K,

- 16 Go (2x 8 Go) Mémoire DDR4-2666 G-Skill @ 2666,

- SSD Samsung Serie 840 Pro 256 Go,

- Alimentation CoolerMaster V1200 Platinum

Sur cette plateforme, une large variété de cartes graphiques sont testées avec, côté NVIDIA, une GeForce GTX 970 modèle overclocké par Gigabyte, une GeForce GTX 980 de référence, une GeForce GTX 980 Ti de référence ainsi qu'une Titan X. Côté AMD, nous nous intéressons à la Radeon R9 390X via un modèle MSI prêtée par Matériel.net que nous remercions mais aussi à la Radeon R9 Fury signée Sapphire (également appelée Fury Pro) et la Radeon R9 Fury X, ici un design de référence AMD.

La machine opère sous Windows 10 64 bits avec les dernières mises à jour disponibles au moment du test. Côté pilotes, nous avons recours aux pilotes GeForce 368.13 et aux pilotes Crimson 16.5.2.1. Nous en profitons pour revoir notre protocole de test et inclure de nouveaux jeux : Rise of the Tomb Raider, Hitman, tous deux en DirectX 12, mais aussi The Division rejoignent notre sélection de benchs avec en prime la version finale et commerciale de Dirt Rally.

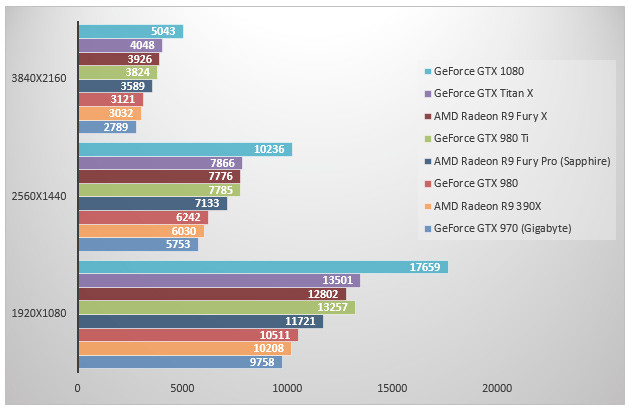

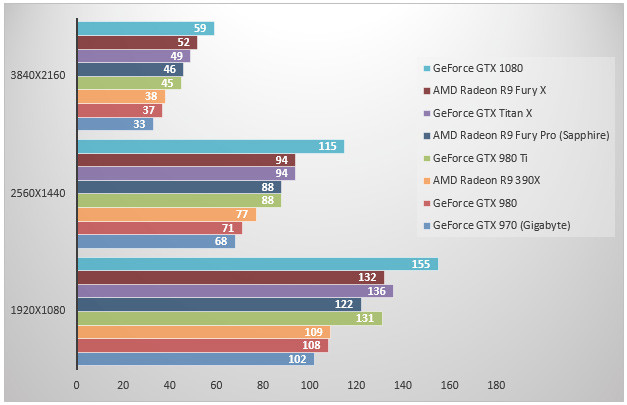

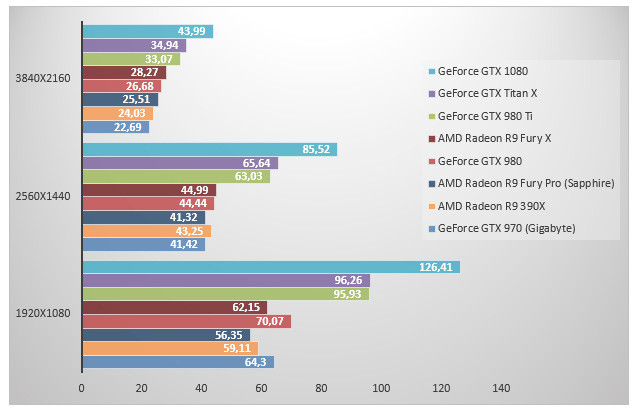

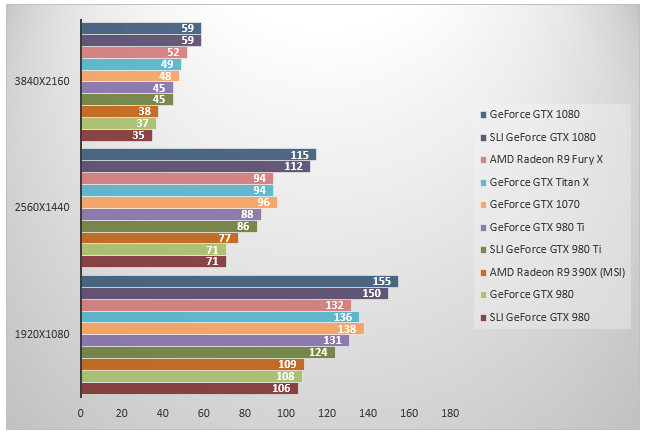

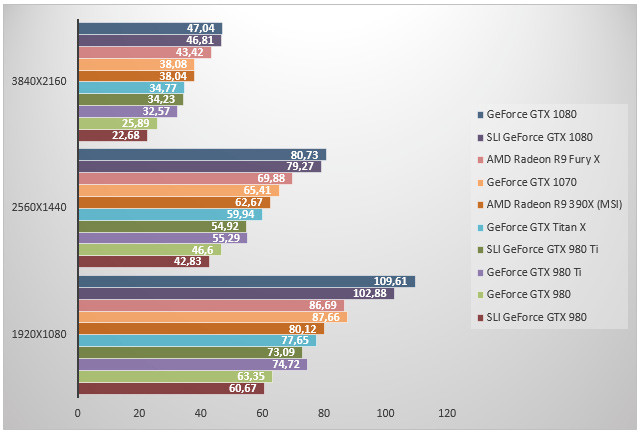

3DMark FireStrike - Ultra

3DMark, qui nous est récemment revenu dans une nouvelle version 2.0, donne sa préférence, à la GeForce GTX 1080. Les scores crèvent le plafond et la GeForce GTX 1080 dépasse toutes les GeForce existantes, Fury X comprise. En 2 560 x 1 440 alors que Titan X et GeForce GTX 980 Ti sont à quasi égalité, la GeForce GTX 1080 se montre 31% plus rapide. Un écart similaire face à la Fury X.

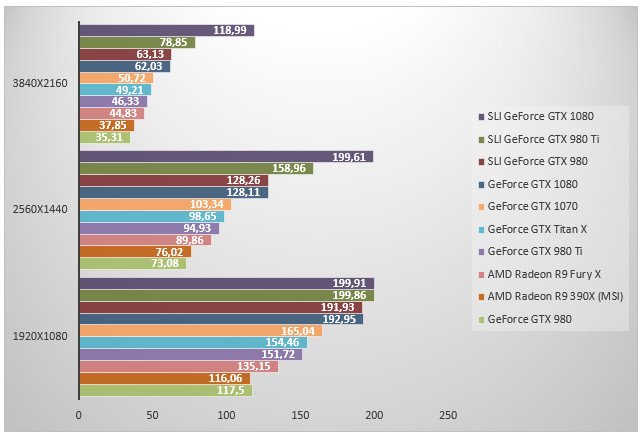

Ashes of the Singularity - Crazy - 4x

A mi-chemin entre le jeu et le benchmark, Ashes of the Singularity est exécuté en mode DirectX 12. Il met en exergue les performances de la GeForce GTX 1080 partout supérieure aux modèles précédents et à sa concurrente la plus évidente chez AMD, la Fury X. En 1080p, la GeForce GTX 1080 est 67% plus rapide que la GeForce GTX 980. Une tendance que l'on retrouve dans les résolutions supérieures alors que l'écart avec une GeForce GTX Titan X est de 35% en 2 560 x 1 440. Si le benchmark est optimisé pour DirectX 12 et semble plus favorable à AMD, la GeForce GTX 1080 se montre 10% plus rapide que la Radeon R9 Fury X en 2 560 x 1 440.

Batman Arkham Knight

Basé sur le moteur Unreal Engine, le dernier opus de Batman a beaucoup fait parler de lui sur PC. Nous le testons sans les effets Gameworks. On retrouve la GeForce GTX 1080 en pôle position avec des performances 22% supérieures à la GeForce GTX Titan X en 2 560 x 1 440 et 62% plus élevées que le score signé par la GeForce GTX 980 en 2 560 x 1 440. En 3 840 x 2 160, la GeForce GTX 970 est laissée sur place avec des performances multipliées par deux en faveur de la GeForce GTX 1080. Face à la Radeon R9 Fury X, la GeForce GTX 1080 est entre 13 et 22% plus rapide.

Battlefield 4 - Ultra - 4x

En attendant Battlefield 1, nous testons Battlefield 4 toujours via FRAPS. Le combat tourne à l'avantage de la GeForce GTX 1080 : largement en 1 920 x 1 080 et 2 560 x 1 440, et plus modestement en 4K. En 2 560 x 1 440, la dernière née de NVIDIA est 35% plus rapide que la GeForce GTX 980 Ti. Un écart qui grimpe, dans la même résolution, à 75% face à la GeForce GTX 980. Battlefield 4 est jouable en 3 840 x 2 160 avec plus de 60 images à la seconde. La GeForce GTX 1080 est 34% plus rapide que la GeForce GTX 980 Ti, à l'identique, donc, de ce que nous observions en 2 560 x 1 440. En revanche l'écart face à la Titan X passe de 29% en faveur de la GeForce GTX 1080 en 2 560 x 1 440 à 26% en 3 840 x 2160. En 4K, la GeForce GTX 1080 est 38% plus rapide que la Radeon R9 Fury X et 64% plus véloce que la Radeon R9 390X.

Bioshock Infinite - Ultra DDOF

C'est l'un des vétérans de l'étape et, comme Batman, Bioshock repose sur l'Unreal Engine. Il nous dresse un tableau cohérent avec une GeForce GTX 1080 qui devance ses camarades... de loin. En 2 560 x 1 440, la carte est 26% plus rapide que la GeForce GTX 980 Ti et 55% plus performante que la GeForce GTX 980. En 4K, la GeForce GTX 1080 est deux fois plus rapide que la GeForce GTX 970, un modèle, pour mémoire, déjà overclocké. Tandis que la Radeon R9 Fury X égale la GeForce GTX 980 Ti en 2 560 x 1 440, tandis que la GeForce GTX 1080 reste 27% plus performante dans cette résolution.

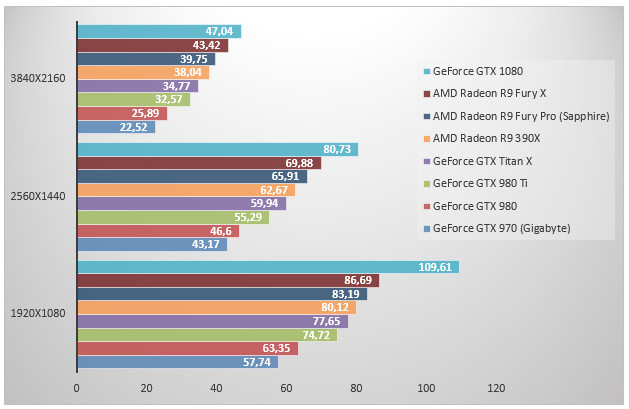

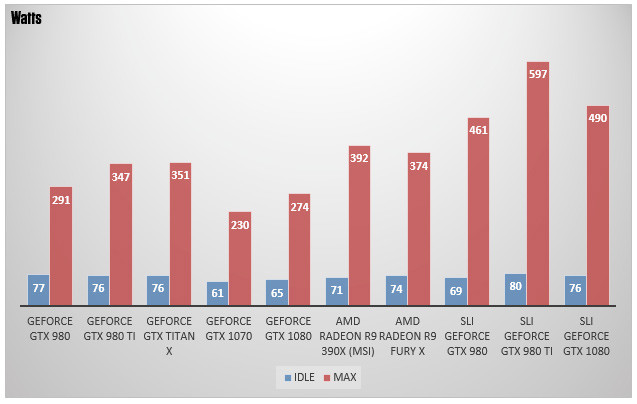

Consommation

Nous avons vérifié la consommation électrique de la GeForce GTX 1080. Pour ce faire, nous mesurons la consommation électrique globale de la machine au moyen d'un wattmètre. La consommation est mesurée à la prise, avec deux relevés : au repos sur le bureau Windows, puis en charge, lors d'un 3DMark plutôt intensif en 4K. Au repos, tous nos systèmes consomment à peu près la même chose : dans les 77 watts... avec un minimum de 65 watts pour la GeForce GTX 1080 qui semble donc moins vorace en idle.En charge, la Radeon R9 390X explose le compteur, immédiatement suivie par les Radeon R9 Fury et la GeForce GTX 980 Ti. La GeForce GTX 1080 réussit de son côté à moins consommer que la GeForce GTX 980 tout en délivrant les performances que l'on sait. A 274 watts engloutis en charge, la GeForce GTX 1080 est même moins gourmande que notre GeForce GTX 970, un modèle overlocké par Gigabyte.

Nous poursuivons notre série de tests, toujours sur la même plate-forme et en considérant les mêmes résolutions que précédemment.

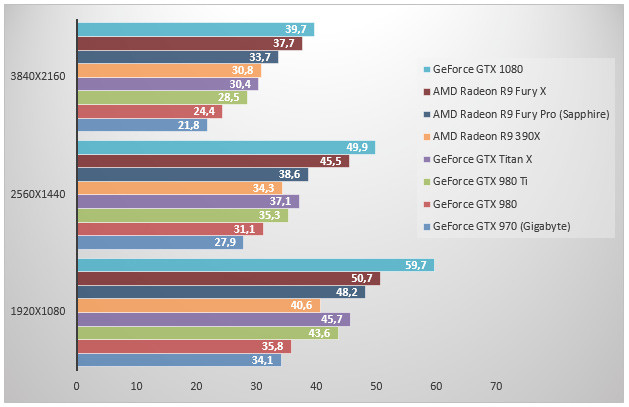

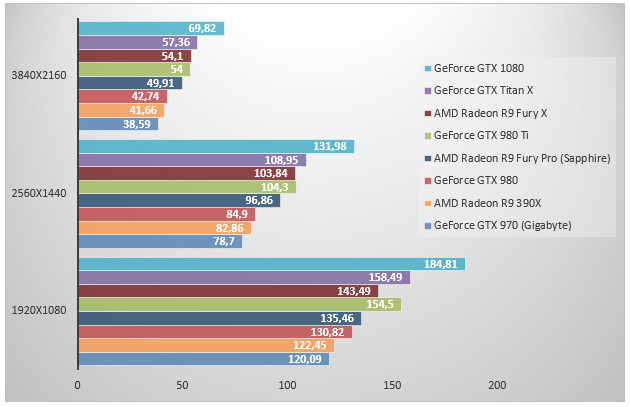

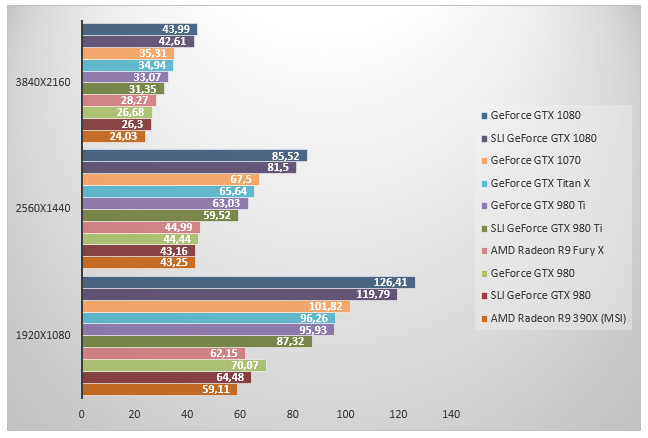

Dirt Rally - Ultra - 4x

Maintenant finalisé, Dirt Rally place la GeForce GTX 1080 largement en tête de notre classement. On retrouve la tendance déjà vue : 23% de performances en plus face à une Titan X en 3 840 x 2 160, 20% plus rapide que la Radeon R9 Furyx en 3 840 x 2 160 et 64% de gain en 2 560 x 1 440 face à la GeForce GTX 980 qu'elle remplace. De quoi faire la course en toute fluidité... et ce, même en 4K !

Tom Clancy's The Division - Ultra

C'est le jeu phénomène de ces derniers mois. Et s'il se limite à DirectX 11, il n'en reste pas moins gourmand. La GeForce GTX 1080 donne de très bons résultats. En 1080p, on gagne 54% de performances face à une GeForce GTX 980 et 49% face à une Radeon R9 Fury X. En 2 560 x 1 440 le gain est même de 61% pour la GeForce GTX 1080 face à la GeForce GTX 980. Et comparée à une Titan X, la GeForce GTX 1080 continue de surprendre : en 2 560 x 1 440 on obtient 20% de performances en sus.

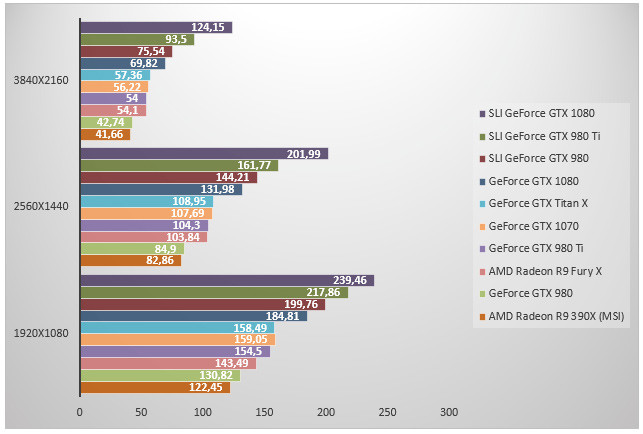

Hitman - DirectX 12 - Ultra - FXAA - SSAO - Aniso 16x

Hitman nous est revenu sur PC dans une toute nouvelle version... à épisodes. Le jeu est exécuté en DirectX 12. La GeForce GTX 1080 est largement en tête avec des performances 35% supérieures à la Titan X en 2 560 x 1 440. En 1080p, la GeForce GTX 1080 est 73% plus rapide que la GeForce GTX 980.

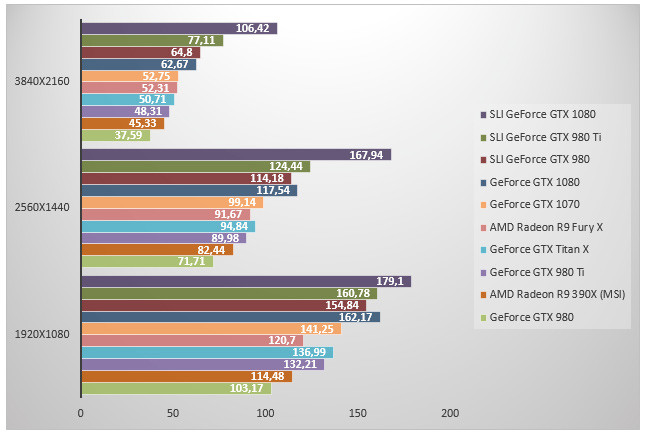

Rise of the Tomb Raider - DirectX 12

Lara nous fait son retour sur PC dans un nouveau volet de ses aventures. Nous exécutons le jeu en DirectX 12 via sa version Steam. La GeForce GTX 1080 domine allègrement les débats. En 1080p, la petite dernière de NVIDIA est deux fois plus rapide que la GeForce GTX 970. Et face à la GeForce GTX 980 Ti, le gain de performance en 1080p s'établit à 32%. En 3 840 x 2 160, la GeForce GTX 1080 conserve de très bonnes performances : elle coiffe au poteau la GeForce GTX Titan X de 26%. La Radeon R9 Fury X d'AMD se défend bien même si la GeForce GTX 1080 fait mieux : 15% plus rapide en 2 560 x 1 440 et 8% en 3 840 x 2 160.

Unigine Heaven 4.0 - Ultra/Norm/4x

Unigine se concentre sur les performances géométrique de nos puces. Dans les résolutions relativement courantes de 1 920 x 1 080 et 2 560 x 1 440, la GeForce GTX 1080 a un bel avantage, y compris face à l'offre AMD. La GeForce GTX 1080 marque le pas en 4K : face à la GeForce GTX 980, on ne gagne plus que 62% contre 77% en 2 560 x 1 440. Et si la GeForce GTX 1080 était 24% plus rapide que notre Titan X en 2 560 x 1 4440, elle ne la devance plus que de 14% en 4K.

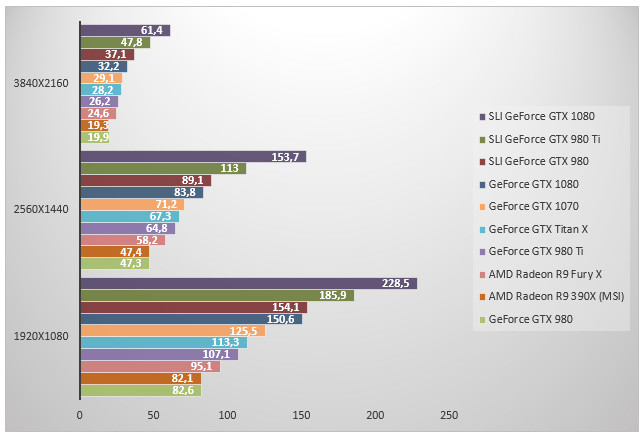

Overclocking

NVIDIA en a parlé de son évènement de lancement, les capacités de Pascal en terme d'overclocking sont censées être saisissantes. Nous avons eu à cœur de le vérifier. Pour ce faire, nous avons simplement utilisé EVGA PrecisionX dans une version Beta livrée par NVIDIA.Nous avons poussé au maximum les coefficients de consommation et de température (+120/+91%) avant de monter de 200 MHz la fréquence de la puce. Nous avons également augmenté la fréquence mémoire d'un petit 50 MHz.

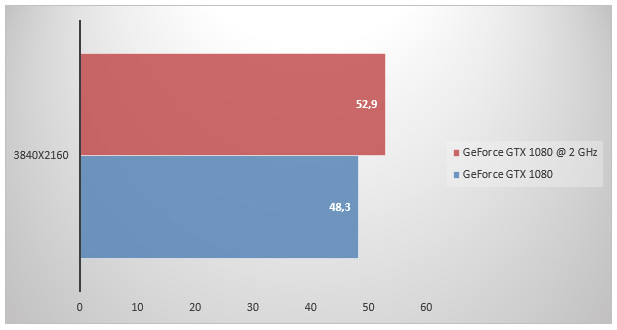

NVIDIA GeForce GTX 1080 overclockée à 2 GHz

Le tout était stable en air cooling même si nous avons eu la main lourde sur le refroidissement, qui à 4000 tours/minute devient il est vrai bruyant !

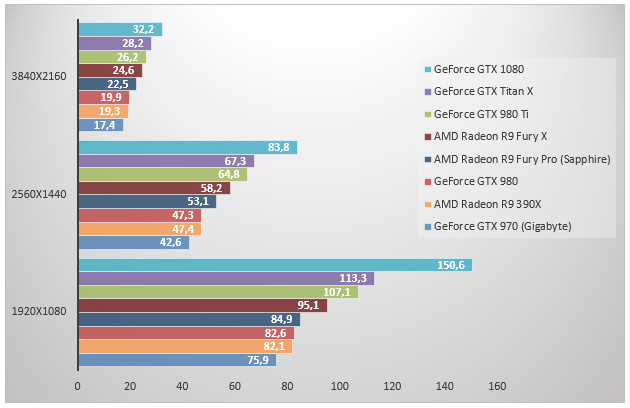

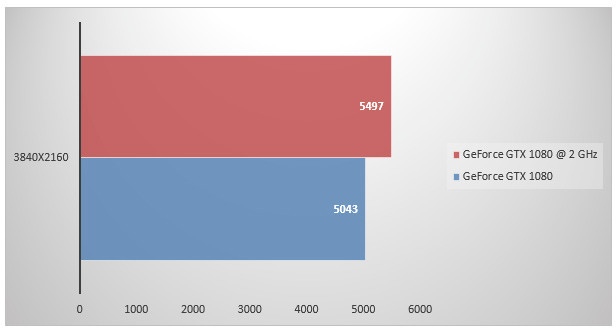

3DMark

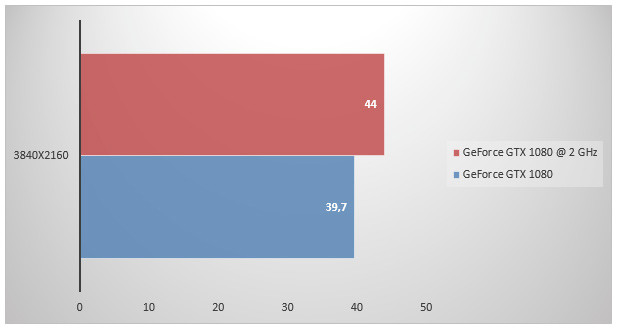

Ashes of the Singularity

Tom Clancy's The Division

Les résultats en pratique de notre overclocking à 2 GHz ont un effet assez net : à 2037 MHz notre GeForce GTX 1080 délivre des scores 9 à 10% supérieurs à la version cadencée à ses fréquences d'usine. Un beau score !

SLI devant !

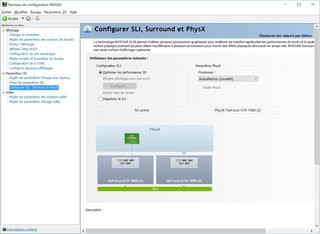

Nous le disions, NVIDIA a revu le fonctionnement de son SLI avec Pascal. Si les avancées de la version destinée au Compute de Pascal comme NVLink ne sont pas encore à l'ordre du jour pour les cartes grand public, l'américain change toutefois quelques petites choses. Pour que le SLI soit pleinement opérationnel, il faut maintenant un dongle qualifié de « High Bandwidth » : NVIDIA commercialise de nouveaux dongles sur sa boutique en ligne comme Asus et EVGA qui déclinent tous deux ce nouveau dongle en accessoire. Un accessoire qui a un coût et qui n'est livré ni avec les nouvelles cartes graphiques GeForce GTX 1080 ni avec les cartes mères haut de gamme ou très haut de gamme du moment.Physiquement, le bridge « High Bandwidth » consiste en réalité en une double connectique : NVIDIA augmente en effet la bande passante pour les échanges entre GPU en liant les deux interfaces qui servaient précédemment en mode 3-Way SLI notamment. Dans la pratique, on peut donc activer le SLI avec un dongle mono connecteur entre les cartes. Toutefois, les performances ne seront pas optimales et un message vous en alertera dans le panneau de configuration de la carte graphique. Et si le nouveau dongle est proposé à la vente, deux anciens dongles suffiront à activer le mode « High Bandwidth » du SLI.

Dongles SLI « High Bandwidth »

Du côté des performances, nous avons fait tourner quelques-uns de nos benchs avec deux GeForce GTX 1080 Founder Edition. Les résultats sont sans grande surprise, notamment pour les jeux en DirectX 12. A l'exception d'Ashes of the Singularity, les jeux triple AAA actuellement commercialisés ne supportent pas le multiGPU. Nous vous en parlions largement au travers de notre dossier consacré à DirectX 12 et force est de constater que depuis, la situation n'a pas évolué. Il faut aussi reconnaître que les titres DirectX 12 à voir le jour sont peu nombreux depuis la version PC de Quantum Break.

Le SLI activé avec un dongle traditionnel puis avec un dongle « High Bandwidth »

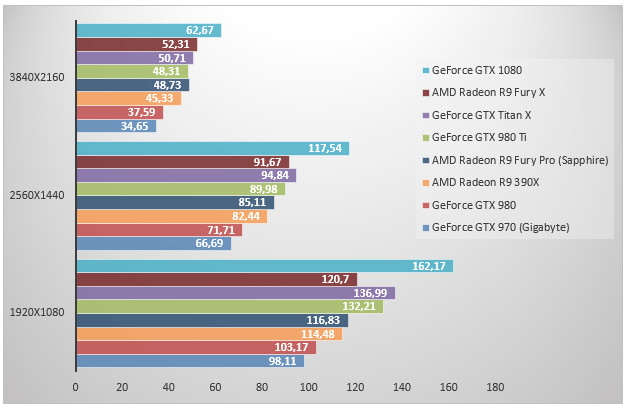

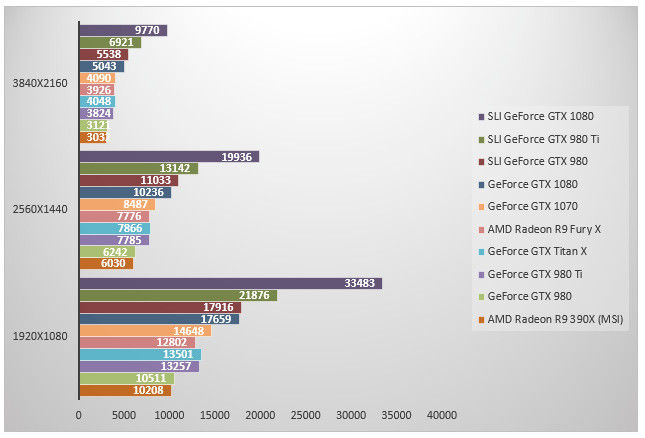

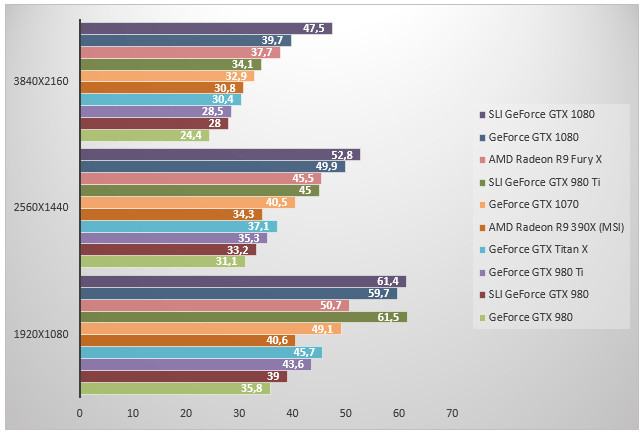

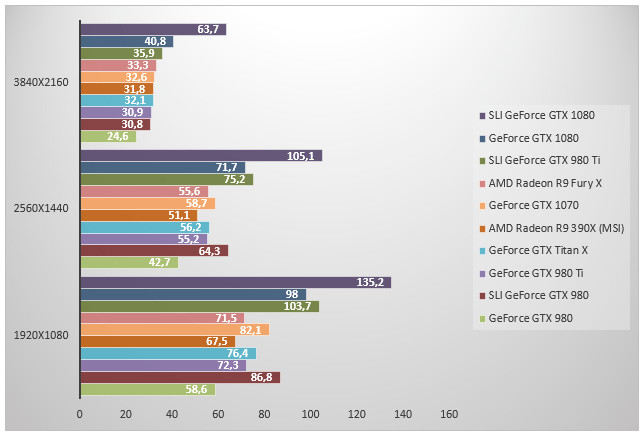

3DMark FireStrike - Ultra

3DMark donne le SLI de GeForce GTX 1080 en tête avec un gain de performances de 94% face à une GeForce GTX 1080 seule. L'écart de performances entre SLI de GeForce GTX 980 Ti et SLI de GeForce GTX 1080 est massif : 51%.

Ashes of the Singularity - Crazy - 4x

Ashes of the Singularity, est un titre DirectX 12. C'est le seul de notre panoplie à gérer le Multi-GPU, option que nous activons ici. Le SLI de GeForce GTX 1080 est en tête à ce détail près que le gain de performances n'est que de 19% entre 1 et 2 cartes en 3 840 x 2 160. Face au SLI de GeForce GTX 980, le gain de performances est tout de même, toujours en 4K, de 69%.

Batman Arkham Knight

Le dernier opus de Batman a fait beaucoup parler de lui. Notamment pour son non support du SLI. Malgré les patchs, le jeu basé sur l'Unreal Engine ne tire aucun avantage du SLI.

Battlefield 4 - Ultra - 4x

Si Batman n'a cure du SLI, Battlefield 4 en profite bien plus largement : les configurations SLI sont en tête. Notre SLI de GeForce GTX 980 équivaut une seule GeForce GTX 980, quand le SLI de GeForce GTX 1080 est, en 2 560 x 1 440, 25% plus véloce que le SLI de GeForce GTX 980 Ti. Face à une seule GeForce GTX 1080, on gagne 56%.

Bioshock Infinite - Ultra DDOF

Lui aussi basé sur l'Unreal Engine, Bioshock Infinite tire profit du SLI. Et pas qu'un peu. Le SLI de GeForce GTX 980 est 9% plus rapide que la GeForce GTX 1080 seule. Face au modèle Founders Edition, le tandem en SLI permet de gagner 53%. Pas si mal !

DIRT Rally - Ultra - 4x

Pour le jeu de courses automobiles DIRT Rally, le SLI aussi a son importance. Particulièrement en 2 560 x 1 440 et 3 840 x 2 160. En 4K, on gagne 69% de performances en passant d'une carte à deux cartes. Et face aux GeForce GTX 980 en SLI, le gain pour l'attelage de GeForce GTX 1080 Founders Edition grimpe à 64%.

Hitman - DirectX 12 - Ultra - FXAA - SSAO - Aniso 16x

Hitman dans son cru 2016 est un jeu DirectX 12. Nous l'exécutons en mode Direct 12 pour constater que le SLI est le parent pauvre. Aucun gain de performance : le SLI n'est simplement pas géré.

Rise of the Tomb Raider - DirectX 12

Autre jeu DirectX 12, Rise of the Tomb Raider dans sa version PC nous amène aux mêmes constatations : le SLI n'est pas géré. On ne gagne donc rien à utiliser deux cartes graphiques c'est même l'inverse.

The Division - Ultra - v1.2

Le dernier titre à succès d'Ubisoft est un jeu DirectX 11. Et, bonne nouvelle, il sait profiter du SLI. On gagne donc 56% de performance en passant d'une GeForce GTX 1080 à deux GeForce GTX 1080 en 4K. Dans cette résolution il n'y a d'ailleurs que la GeForce GTX 1080 qui tire vraiment son épingle du jeu. Le SLI de GeForce GTX 980 Ti sort légèrement la tête de l'eau, mais le SLI de GeForce GTX 980 n'apporte visiblement rien. En 2 560 x 1 440, le SLI de GeForce GTX 1080 est 63% plus rapide que le SLI de GeForce GTX 980.

Unigine Heaven 4.0 - Ultra/Norm/4x

On termine avec Unigine qui profite du SLI. On gagne en 4K 65% entre SLI de GeForce GTX 1080 et SLI de GeForce GTX 980. Face à la GeForce GTX 1080 seule, les performances augmentent de 90%.

Consommation

Plus encore qu'avec une carte seule, la consommation électrique d'un SLI est assez critique. Nous avons mesuré la consommation en SLI de nos diverses configurations, selon notre protocole habituel.

Face à une seule GeForce GTX 1080, la consommation de notre SLI progresse largement, mais n'est pas multipliée par deux. De 274 watts en charge on passe à 490 watts. C'est beaucoup, mais moins que les 597 watts d'un SLI de GeForce GTX 980 Ti. Face au SLI de GeForce GTX 980, la consommation augmente d'un tout petit peu moins de 30 watts, ce qui reste très acceptable. En idle, la consommation de nos diverses configurations reste sensiblement identique.

Quel bilan ?

On l'a vu, le SLI donne des résultats variables avec Pascal. Dans le meilleur des cas, on n'est pas loin du doublement des performances alors que la consommation électrique est logiquement plus avantageuse que celle d'un SLI de GeForce GTX 980 Ti, par exemple. Mais si les résultats sont variables, ce n'est pas tant la technologie de NVIDIA qui est en cause, que l'écosystème ludique. Les développeurs en charge du portage des jeux PC semblent se désintéresser de plus en plus de la question. Ainsi quand un Batman Arkham Knight ne tire pas profit du SLI malgré une foule de patchs, on constate que les jeux DirectX 12, comme Hitman et Rise of the Tomb Raider n'en ont cure. Nous expliquions pourquoi dans notre dossier consacré à la dernière API de Microsoft (voir DirectX 12 : quand le pire côtoie le meilleur), nous mesurons à quel point cela est dommageable aujourd'hui. Il faut espérer pour NVIDIA que les développeurs joueront le jeu à l'avenir pour prendre en charge le SLI. Sinon la solution n'a plus aucun intérêt.Conclusion

Si l'architecture en elle-même ne recèle point de bouleversement, tant elle est proche de la génération précédente, les avancées technologiques d'un point de vue process semblent être extrêmement bénéfiques à la GeForce GTX 1080. Il y a bien sûr la gravure 16 nm FinFet par TSMC, une première que l'on n'attendait presque plus et qui permet aux fréquences de s'envoler (ou presque). Rendez-vous compte, on dépasse enfin le gigahertz avec un refroidissement tout à fait standard !

La mémoire GDDR5X, moins ambitieuse sur le plan technique que la HBM1/2, aide aussi à grimper du côté de la bande passante théorique, ce qui ne fait que profiter aux performances d'ensemble. Le tout est servi dans un carénage bien connu qui a le bon goût de s'échauffer modérément et de rester discret. La consommation électrique de la carte s'affiche clairement comme un point positif puisque la GeForce GTX 1080 réussit le pari consommer autant voir moins que la GeForce GTX 980 qu'elle remplace tout en la laissant sur place sur le plan des performances.

AMD ne peut de son côté pas lutter pour le moment face à Pascal et les meilleures Fury sont simplement dépassées, même si avec certains jeux DirectX 12, l'avantage de Pascal est un peu moins flagrant. Il faudra toutefois voir ce que pourra faire la marque aux Radeon avec sa nouvelle architecture Polaris qui devrait se préciser un peu plus à l'occasion du Computex bien que les premières cartes Polaris sont attendues dans un segment inférieur.

Pour le moment donc, NVIDIA semble avoir, avec la GeForce GTX 1080, une carte à l'architecture plus que prometteuse qui s'affiche comme la nouvelle reine des performances. Cela valait bien un choix technique de la rédaction. Les nouveautés fonctionnelles notamment au niveau du SMP, qui permettent aux joueurs munis de trois écrans d'obtenir une perspective correcte, devraient rencontrer un franc succès alors que d'autres nouveautés logicielles devraient à terme compléter l'écosystème entourant la GeForce GTX 1080. On pense à Ansel, la nouvelle solution pour faire des screenshots in-game notamment, même si celle-ci n'est pas encore disponible publiquement.

Reste que si la carte a tout d'une grande, elle a aussi un prix élevé. Très élevé, trop élevé, et deux déclinaisons : le modèle de base vendu par les partenaires habituels de NVIDIA est annoncé à 599 dollars, soit à peu près 670 euros avec un système de refroidissement propre au partenaire, et le modèle baptisé Founders Edition, autrement dit, le design de référence, qui est annoncé à 699 dollars outre-Atlantique sort finalement en France à 789 euros TTC. C'est quasiment le prix de la GeForce GTX 980 Ti à son lancement, alors même que cette GeForce GTX 1080... n'est pas Ti ! Seul le modèle Founders Edition est censé bénéficier du système de refroidissement signé NVIDIA et il doit être vendu pendant toute la durée de vie de la GeForce GTX 1080. NVIDIA annonce d'ailleurs la commercialisation de la GeForce GTX 1080 Founders Edition pour la France par sa boutique en ligne officielle, une première dans nos contrées.

Reste que son positionnement tarifaire, au-dessus des versions standard de la GeForce GTX 1080, étonne. Qui plus est, NVIDIA n'est pas très clair dans sa communication et il faudra voir la disponibilité effective des premiers modèles non Founders pour se faire une opinion sur ce que le constructeur commercialise véritablement le 27 mai prochain. Car si les tests sont publics ce 17 mai, le lancement commercial est prévu pour le 27 mai.

Autre sujet épineux à nos yeux, les pilotes NVIDIA. Leur l'interface qui remonte à Windows Vista, c'était pour mémoire en 2007, commence à être particulièrement lente à chaque lancement et les pilotes GeForce auraient bien besoin d'une cure de jouvence comme les Catalyst du concurrent qui, depuis qu'ils se sont mués en Crimson, sont tout de même beaucoup plus agréables au quotidien.

N'oublions pas enfin, l'arrivée prochaine, à la mi-juin, de la déclinaison plus abordable de Pascal : la GeForce GTX 1070 que l'on nous promet plus rapide que la GeForce GTX Titan X, à des niveaux de prix en principe plus attractifs puisqu'il est question de 379 dollars soit peu ou prou 420 euros TTC.