NVIDIA : je pense donc G-Sync

Présentée le 18 octobre 2013 à Montréal, la technologie G-Sync de NVIDIA n'a pas encore été intégrée nativement dans un moniteur déjà commercialisé. Il y a eu des annonces de faites au CES, mais pour l'heure, afin de tester le G-Sync, c'est un Asus VG248QE customisé avec un module G-Sync que NVIDIA nous a prêté. Grabuge ou gruge ?Choisir entre déchirements ou saccades

Dans la pratique, le fait qui sème la zizanie c'est que toutes les images ne sont pas traitées à la même vitesse par la carte graphique. Cette cadence (les fps) variable à la source peine en toute logique à se caler sur le rafraîchissement constant de l'écran (60 fois par seconde pour un 60 Hz). Une incompatibilité que NVIDIA résume très bien en trois schémas.

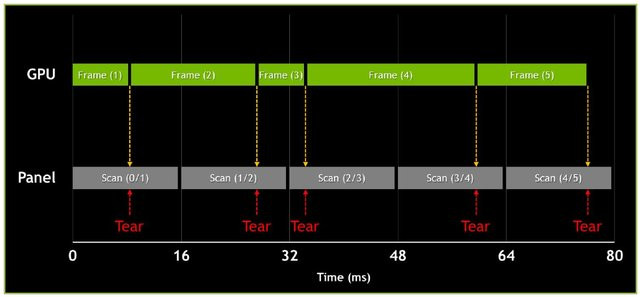

Avec la V-Sync désactivée, les images envoyées par le GPU s'enchaînent à leur rythme, variable mais naturel. A chaque cycle de rafraîchissement d'écran où plusieurs images s'afficheront, l'utilisateur verra du tearing

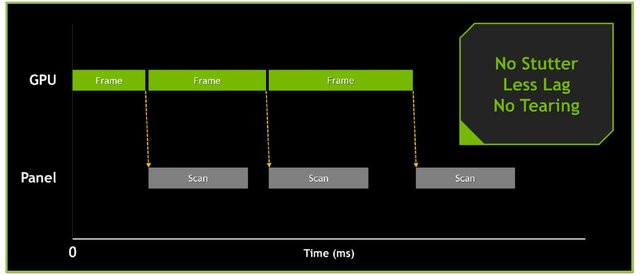

Avec le G-Sync, le rafraîchissement de l'écran se cale sur le rendu d'image du GPU : ça supprime en théorie le tearing et le stutter, et ça compresse le lag au minimum

G-Sync : que faut-il pour jouer ?

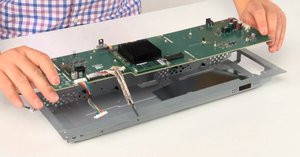

C'est en fait un remplacement intégral de la carte mère Asus d'origine que le kit NVIDIA entreprend. La carte d'époxy embarque principalement un circuit logique programmable (le cœur de G-Sync), de la DDR3 et différents connecteurs (alimentation, rétro-éclairage, DisplayPort, etc.). Le changement visible c'est la disparition des ports VGA et HDMI au profit de l'unique DisplayPort 1.2. Notez que le pass-through audio n'est pas géré, les haut-parleurs de l'écran sont donc condamnés. Egalement, l'OSD est réduit à sa plus simple expression : afficher le statut de l'écran et adapter la luminosité. Tous les autres paramètres seront pilotés depuis une application PC, non fournie nous dit-on sur le site de NVIDIA. Fâcheux, puisque le rendu pâlichon délavé de l'écran mériterait quelques réglages, plus en profondeur.

L'électronique d'origine, et le kit G-Sync

Pour nos tests, nous avons utilisé une GTX 780, un modèle haut de gamme chez NVIDIA, avec bien sûr la dernière version des pilotes (332.21). Notez que la fonction G-Sync est prise en charge en standard depuis la version 331.58. Pour profiter au mieux de G-Sync, il suffit de régler le rafraîchissement sur 144 Hz dans les pilotes, cocher la case activer la fréquence de rafraîchissement variable (FRV) sous l'entrée éponyme et d'imposer la FRV sous l'entrée Synchronisation verticale de l'onglet Gérer les paramètres 3D. Il faut également tourner sous Windows 7 ou 8.1, exécuter ses jeux en plein écran et bien sûr, avoir activé G-Sync au préalable. Car G-Sync ne se lance pas à la volée (il n'y a pour l'heure pas de hotkey). Certains moteurs de jeu doivent de toute façon être redémarrés si vous passez d'une séquence de jeu sans G-Sync à une séquence avec.

NVIDIA ajoute trois consignes supplémentaires, pour faire le test dans les meilleures conditions : utiliser une bonne souris (pour constater la fluidité, c'est mieux), passer les jeux par la moulinette de l'utilitaire Geforce Experience pour optimiser les réglages, et bien se mettre en 144 Hz pour G-Sync et 60 Hz avec les autres modes (avec et sans V-Sync). L'idée, c'est de se placer dans la configuration la plus représentative des conditions réelles d'une majorité de joueurs.

Nous trouvons cette dernière consigne un peu étrange, compte tenu du nombre important de moniteurs 120 Hz commercialisés. Aussi, nous comparerons également G-Sync à du 120 Hz et 144 Hz, sans G-Sync.

G-Sync : est-ce que ça marche ?

Première étape avant de se lancer dans du jeu vidéo : essayer la démo fournie par NVIDIA. Vous savez, celle du pendule qui a déjà beaucoup fait le tour de la toile mais sans que personne ne puisse vraiment constater l'impact. En effet, filmer du tearing sur un écran, ça ne rend rien... si le mal n'est pas visible, le remède non plus. Il va donc falloir nous croire sur parole ! Pour cette séquence, l'écran doit être réglé sur 60 Hz. L'utilisateur peut faire varier six paramètres : sans V-Sync, avec V-Sync et avec G-Sync d'un côté, et 60 fps, 40 à 60 fps et 30 fps de l'autre. Pendant ce temps, le pendule continue son mouvement de balancier.

On constate effectivement ce qui est attendu en théorie, c'est-à-dire que sans V-Sync on voit du tearing, d'autant plus que le framerate s'écarte du rafraîchissement de l'écran (plus à 30 fps donc qu'à 60). Avec le V-Sync, le tearing disparaît. Et à 60 fps, on note très peu de saccades puisqu'on est en phase avec l'écran (la différence avec le G-Sync est alors quasi-imperceptible). En revanche, plus on descend en cadence d'image, plus le rendu saccade. Enfin en G-Sync, l'affichage est parfait à tous les réglages. Quid des jeux ? Nous avons fait trois tests : un peu gourmand (Dirt 3), un assez exigeant (BattleField 4) et un très exigeant (Crysis 3).

Avec Dirt 3

En dépit de paramètres poussés à fond, notre GTX 780 fait tourner Dirt 3 toujours à bloc. Fraps nous indique environ 170 fps quand on désactive la V-Sync. Là, ça ira vite : la G-Sync n'apporte rien par rapport à la V-Sync ou même l'absence de V-Sync. On note une toute petite perte de fluidité avec la V-Sync à 60 Hz mais c'est tout. Et quasiment pas de tearing, même sans V-Sync. Il faut dire que la progression arrière - avant des jeux de course est clairement moins encline à produire du tearing que les balayages latéraux des FPS. La seule différence flagrante, c'est la fluidité qu'apporte le 120 Hz, et plus encore le 144 Hz, par rapport au 60 Hz.

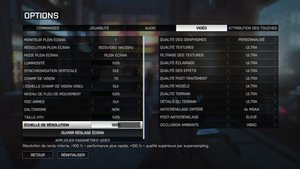

Avec BattleField 4

Ici, on se rapproche du cas d'école évoqué par NVIDIA. Pour ne pas trop excéder les 60 fps, il nous faut pousser l'échelle de résolution à 120 % : on oscille alors entre 45 et 70 fps. Ecran à 60 Hz et tous paramètres désactivés, le jeu apparaît fluide, mais le tearing est assez violent. Si ça reste supportable, les conditions de jeu ne sont à l'évidence pas optimales. En activant la V-Sync, le tearing disparaît. On note toutefois que la fluidité globale du jeu baisse d'un cran. Les balayages d'horizon un peu trop rapides brouillent l'affichage, et des micro-saccades gâchent l'expérience ici et là, de manière ponctuelle.

En passant en 144 Hz avec G-Sync, tout rentre dans l'ordre : l'expérience de jeu devient effectivement idéale. Les mouvements de tête se font en douceur, même à 40 fps. En dessous de 40 fps et à proximité des 30 fps (il nous faut pousser l'échelle de résolution à 150 % au minimum), le G-Sync atteint en revanche ses limites : l'image n'est plus fluide du tout. Mais à ce framerate de toute façon, il ne fallait pas attendre de miracle.

Maintenant, si on reste à 144 Hz et désactive le G-Sync, le rendu ne se dégrade pas outre-mesure. On perd un tout petit peu de fluidité mais ça n'est pas évident et donc encore moins dramatique.

Avec Crysis 3

Plus redoutable encore : Crysis 3. Ici notre GTX 780 reste toujours entre 36 et 60 fps grand maximum (tout en extrême, antialiasing en TXAA 4X). C'est la configuration idéale pour mesurer les bienfaits de G-Sync. Et force est de constater qu'ils sont bien réels. A 60 Hz, avec et sans V-Sync, on observe à peu près les même schémas de rendu que sur BF4, avec peut-être un peu moins de déchirement de base.

Le 120 Hz avec V-Sync constitue une belle amélioration mais sur certaines scènes du jeu, on constate en fixant son regard sur des textures précises que les déplacements ne sont pas tout à fait fluides. Avec le G-Sync en 144 Hz, le rendu est effectivement impressionnant de netteté. Même entre 40 et 50 fps, les balayages d'horizon s'exécutent selon une progression constante. Les plans se meuvent au quart de tour, sans la moindre saccade, c'est aérien ! Et si on reste en 144 Hz et qu'on désactive le G-Sync ? En scrutant attentivement l'image, on note une perte de fluidité : des micro-à-coups dans les déplacements, visibles sur les textures. Ça reste certes discret mais indéniable. Et si on laisse le choix au joueur, avec ou sans G-Sync, il préférera avec, à coup sûr.

Conclusion

Maintenant, d'autres cas de figure sont aussi possibles. Et là le bénéfice est un peu moins flagrant, même si toujours réel. Le joueur qui possède un écran 120 Hz, et il s'en vend quelques-uns sur le marché, souffre en effet un peu moins du déchirement et des saccades. Celui qui joue à des jeux où la puissance graphique l'emporte régulièrement au-delà de 120 fps n'aura pas non plus grand intérêt à investir dans cette technologie. A plus forte raison s'il s'agit de jeu de course.

Car si le G-Sync constitue une avancée de plus à mettre au crédit de NVIDIA, la solution FreeSync d'AMD risquant de ne pas voir le jour avant un ou deux ans, elle est tout sauf insignifiante en termes d'investissement. Qu'on opte pour le kit de mise à jour ou pour un écran neuf G-Sync, il faut compter un surcoût de 150 à 200 € environ, par rapport à une alternative sans G-Sync. Quitte à renouveler leur équipement, certains utilisateurs préféreront peut-être acheter un écran 120 Hz ou 144 Hz qu'ils payeront 150-200 € moins cher et mettre l'argent économisé dans une nouvelle carte graphique plus puissante.

Si on peut critiquer la stratégie « il faut encore cracher au bassinet » de NVIDIA, on ne peut qu'applaudir le progrès accompli. Le joueur qui veut ce qu'il se fait de mieux et sans attendre devra se tourner vers G-Sync. Car l'avantage de la solution NVIDIA par rapport au FreeSync d'AMD, c'est que le G-Sync, ça existe et c'est disponible tout de suite. Il faudra voir comment se comporte G-Sync sur un écran en résolution supérieure, comme l'Asus ROG PG278Q annoncé au CES. Si G-Sync peut permettre de jouer en 2 560 x 1 440 pixels sans perdre en confort, à carte graphique constante, ça deviendra vraiment intéressant !