Et alors qu'en début d'année, GeForce GTX 485M de NVIDIA et Radeon HD6970M d'AMD bataillaient pour s'approprier le titre enviable de puce mobile la plus puissante du marché, NVIDIA sortait, le 28 juin dernier, son nouveau fer de lance, le GeForce GTX 580M. Une puce graphique taillée pour permettre à NVIDIA de passer devant son éternel rival et qui repose sur une architecture Fermi revue et corrigée.

On se souvient en effet que les premières générations de puces pâtissaient d'un rendement assez décevant, qui obligea NVIDIA à désactiver une partie des coeurs CUDA. Depuis, NVIDIA a rectifié le tir et propose des puces en pleine possession de leurs moyens. Quelles sont donc les évolutions et améliorations sur lesquelles compte la firme au caméléon pour asseoir sa suprématie ? Quelles sont les performances de cette nouvelle puce graphique face à l'une de ses concurrentes directes, la Radeon HD 6970M ? Les réponses dans les lignes qui suivent !

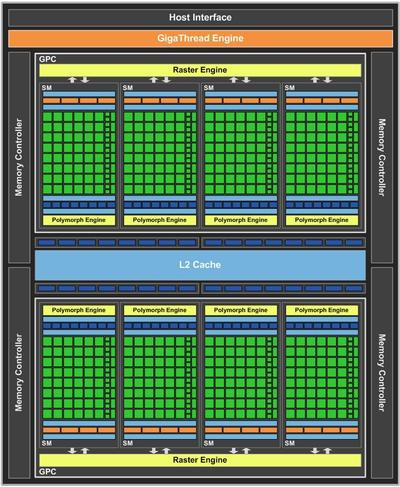

Fermi enfin au complet

Afin de comprendre les améliorations apportées par NVIDIA sur sa nouvelle puce, il convient d'effectuer un petit retour en arrière sur l'architecture Fermi et ses premières déclinaisons mobiles. Pour rappel et depuis le GF104, les puces mobiles de NVIDIA ont toutes en commun la composition de leurs Streaming Multiprocessor (SM), ou multiprocesseurs. Ces derniers comprennent 48 unités de calcul généraliste (les fameux cœurs CUDA) et 8 unités de texture. Le GF100, première déclinaison de l'architecture Fermi, proposait quant à lui 32 cœurs CUDA et 4 unités de texture par SM. Toutes ces déclinaisons possèdent une unité de traitement géométrique (Polymorph Engine) par SM.Ce qui différencie les déclinaisons entre elles est ce nombre de Streaming Multiprocessor. Fermi est constitué de GPC (Graphic Processing Cluster) qui renferme chacun jusqu'à 4 SM. Un GPC peut donc accueillir donc en toute logique jusqu'à 192 cœurs CUDA. Jusqu'ici, tout va bien. Le problème intervient lorsqu'il s'agit de placer deux GPC sur la même puce, afin de disposer de 384 cœurs CUDA. Cest pourquoi une puce comme la GTX 480M ne comportait « que » 352 coeurs. Il a fallu attendre le dernier CES pour voir NVIDIA réussir dans cette entreprise.

En effet, Fermi a longtemps souffert de problèmes de rendement qui empêchait l'activation tous les cœurs sur une puce qui comportait plus d'un GPC. NVIDIA a donc repensé la conception même de la puce au niveau de ses transistors afin d'utiliser des composants plus efficaces. Résultat, une enveloppe thermique et une consommation mieux maîtrisées qui ont permis au constructeur de proposer une GTX 485M dotée de 384 cœurs CUDA. C'était en janvier dernier, donc.

Une GTX 485M overclockée ?

Depuis ? Eh bien pas grand-chose ! En effet, même si la GTX 580M inaugure la déclinaison GF114 (alors que la GTX 485M était basée sur le GF104), force est de constater que les changements sont minimes. A l'image du passage de la série 400M à la série 500M, NVIDIA s'est apparemment contenté ici d'un simple ajustement des fréquences.| Caractéristiques techniques | ||

| GeForce GTX 485M | GeForce GTX 580M | |

| Puce | GF104 | GF114 |

| Cœurs CUDA | 384 | 384 |

| Fréquence des cœurs | 575 MHz | 620 MHz |

| Type de mémoire | GDDR5 | GDDR5 |

| Quantité de mémoire | 2 048 Mo | 2 048 Mo |

| Bus mémoire | 256 bits | 256 bits |

| Fréquence mémoire | 1 500 MHz | 1 500 MHz |

| Bande passante | 96 Go/s | 96 Go/s |

| Puissance | 883,2 GFLOPs | 952,3 GFLOPs |

Les deux puces possèdent 384 cœurs CUDA, 64 unités de textures et 32 ROPs. Elles sont toutes deux gravées en 40 nm et possèdent 2048 Mo de mémoire GDDR5 cadencée à 3 000 MHz et interfacée sur 256 bits. Finalement, seule la fréquence des cœurs change, pour passer de 575 à 620 MHz. Soit une variation à la hausse d'un peu moins de 8%. On gagne parfois plus avec un simple overclocking... D'autant qu'il s'agit là des spécifications maximales. C'est-à-dire que si un fabricant d'ordinateurs portables ne dispose pas d'une enveloppe thermique suffisante, les spécifications pourront être revues à la baisse.

Du côté logiciel, rien de neuf : on conserve bien évidemment la gestion de DirectX 11, PhysX, la compatibilité 3D Vision et les finesses signées NVIDIA comme PureVideo HD (le processeur vidéo VP4 prend en charge la décompression des codecs H.264, VC-1/WMV9 et MPEG-1, -2 et -4) ou l'Audio Bitstreaming. L'HDMI 1.4a est également de la partie.

Alienware M17x-R3

Rares sont encore les portables qui intègrent une GeForce GTX 580M en leur sein. Actuellement, on en compte 4, avec le méconnu Eurocom Panther 3.0, le plus réputé Clevo P150HM et les définitivement célèbres Alienware M17x et M18x. C'est donc l'un de ces derniers modèles que nous avons testé, et plus précisément le M17x-R3.

Comme tout bon modèle Alienware qui se respecte, ce produit est prioritairement destiné aux joueurs enthousiastes qui souhaitent délaisser les tours classiques, trop lourdes et encombrantes, pour des PC portables bien plus faciles à transporter en LAN. Mais ce changement ne doit pas se faire au détriment des performances, et Alienware l'a bien compris. On retrouve donc dans notre M17x de test les composants mobiles les plus puissants du moment : Intel Core i7-2860QM pour le processeur, 8 Go de DDR3 fonctionnant à 1 600 MHz pour la mémoire vive, et bien sûr la GeForce GTX 580M de NVIDIA.

Ce processeur est l'un des derniers Sandy Bridge mobiles dévoilés par Intel, et sa fiche technique est impressionnante : 4 coeurs avec HyperThreading, cadencés à 2,5 GHz (et jusqu'à 3,6 GHz en mode Turbo) et 8 Mo de mémoire cache, pour une enveloppe thermique n'excédant pas les 45 W.

La puce graphique présente au sein de cet ordinateur portable respecte à la lettre les recommandations de NVIDIA : les 384 coeurs CUDA fonctionnent à 620 MHz, les processeurs de flux à 1 240 MHz, et les 2 Go de GDDR5 à 3 000 MHz. Côté stockage nous avons affaire à un Seagate Momentus XT de 500 Go, alors que la connectique proposée par cet Alienware est ultracomplète : HDMI in&out, VGA, mini-displayPort, deux ports USB 3.0, un autre à la norme USB 2.0, un combo eSATA / USB sleep'n charge. Rien à dire. Notez que le circuit sans fil est assuré par un Centrino Ultimate-N 6300 compatible WiDi, alors que le Bluetooth est pris en charge dans sa norme 3.0. Enfin, ce portable propose un combiné lecteur Blu-ray / graveur DVD, une batterie 9 cellules et un clavier dont le rétroéclairage est personnalisable.

Afin d'opposer un adversaire de poids à notre GeForce GTX 580M, nous avons

Tous les autres composants demeurent inchangés, ce qui permettra d'établir une comparaison pertinente entre les deux GPU. Tous nos tests s'effectueront avec les derniers pilotes en date (Verde 285.88 pour NVIDIA et Catalyst 11.11b pour AMD) et sous Windows 7 Edition Familiale 64 bits. Alienware n'a en effet pas jugé utile d'opter pour une version Ultimate ou au moins Professionnelle dans des portables qui valent 2 500 et 3 000 euros, pour les solutions AMD et NVIDIA, respectivement.

Test de performances

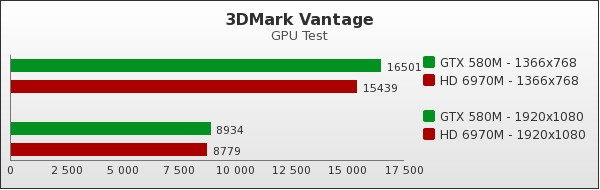

Rien ne vaut une mise en condition réelle pour évaluer les capacités de nos deux GPU, et notamment dans les jeux. Pour cela, nous avons retenu quelques titres, en plus du traditionnel 3DMark Vantage et 3DMark 11.3DMark Vantage - GPU Test

On commence par un bon vieux test synthétique et l'inusable 3DMark Vantage, ici exécuté en deux résolutions différentes, comme l'ensemble de nos tests d'ailleurs : 1 366 par 768 pixels et 1 920 par 1 080. Sur ce test, NVIDIA est devant. Dans la plus faible définition, la différence est d'un peu moins de 7%, mais tombe à moins de 2% en Full HD.

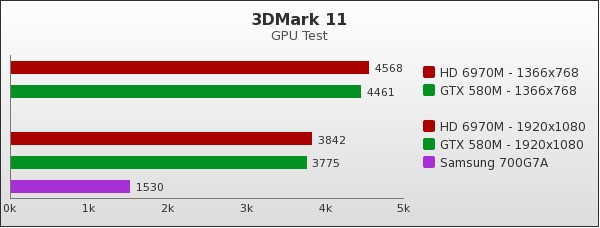

3DMark 11 - GPU Test

Sur le dernier opus de 3DMark, changement de leader : la Radeon HD 6970M prend le pouvoir, quelle que soit la résolution. L'écart reste toutefois assez faible, puisqu'il tourne autour de 2% en 1 366 x 768 comme en 1 920 x 1 080.

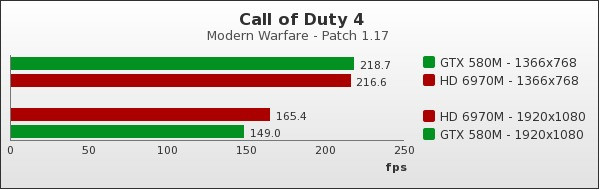

Call of Duty 4 : Modern Warfare - Patch 1.7

Grâce à une séquence de démonstration enregistrée par nos soins, nous pouvons mesurer les performances de nos deux GPU sur COD4 : Modern Warfare. Là aussi, nous effectuons les mesures sur les deux définitions évoquées plus haut. En faible résolution, le rôle du GPU est moindre sous COD4, et celui du processeur plus important. Il n'est pas étonnant de retrouver des performances similaires entre les deux machines. En haute résolution en revanche, c'est la Radeon HD 6970M qui se distingue, avec un score plus de 10% supérieur à la puce NVIDIA.

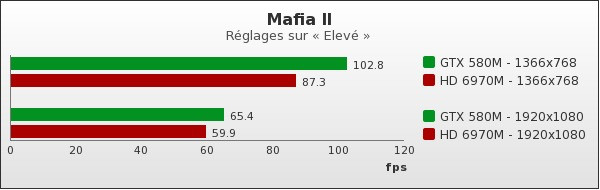

Mafia II

À l'aide du test de performance fourni dans le jeu, il est possible de voir ce que donnent nos deux puces graphiques sur Mafia II. Une fois de plus, les tests ont lieu en 1 366 x 768 et en 1 920 par 1 080. La synchronisation verticale ainsi que PhysX sont désactivés, et les réglages placés sur « Elevé » (anticrénelage désactivé et filtrage anisotrope 16x). Si l'écart est substantiel sur 768 lignes (18%), il l'est moins dans la résolution native des écrans de nos deux portables (9%), mais reste dans tous les cas à l'avantage de la GTX 580M.

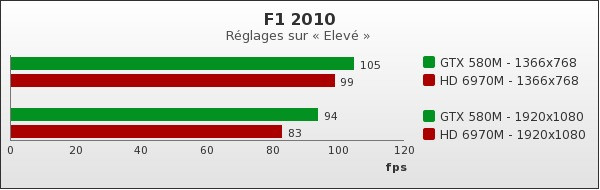

F1 2010

F1 2010 est lui aussi équipé d'un test de performance intégré. Nous l'avons donc appliqué à nos puces en test, toujours sur 768 et 1 080 lignes. Les détails étaient, selon les réglages du jeu, en mode « Elevé » tandis que PhysX et la synchronisation verticale étaient inopérantes. Le combat tourne là aussi en faveur de la puce NVIDIA, notamment en Full HD, alors qu'il est important de noter que les performances de ce jeu sont assez peu sensibles à la résolution employée.

F1 2011

Même combat avec cette nouvelle version de F1, pour lequel les réglages sont identiques. L'écart est sensiblement le même que sous F1 2010, toujours à l'avantage de la puce NVIDIA.

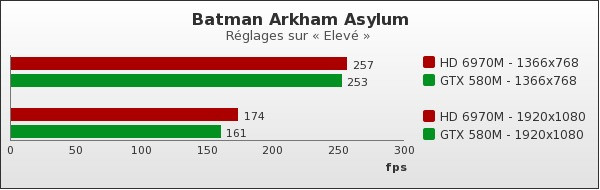

Batman Arkham Asylum

En attendant que les problèmes qui affectent le comportement et les performances du jeu en mode DirectX 11 soient résolus, nous utilisons le test de performance fourni avec Batman Arkham Asylum. PhysX et la synchronisation verticale sont désactivés, le niveau de détails est réglé sur « Elevé ». Ici, c'est la Radeon HD 6970M qui prend la tête, avec un avantage plus net en haute résolution, puisqu'il atteint 8%.

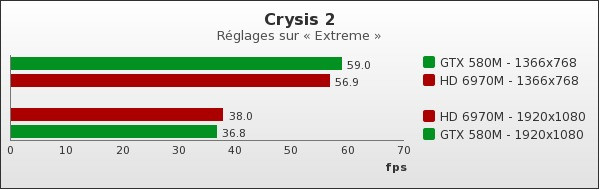

Crysis 2 - Patch 1.9

Crysis 2 a pour réputation de faire transpirer les puces graphiques les plus performantes. Nous l'utilisons en parallèle de Fraps, avec le mode DirectX 11 actif et le pack de textures haute qualité également activé. Ce jeu met quasiment sur un pied d'égalité nos deux configurations, NVIDIA l'emportant en basse résolution quand AMD prend sa revanche en haute définition. Mais dans un cas comme dans l'autre, l'écart est particulièrement faible.

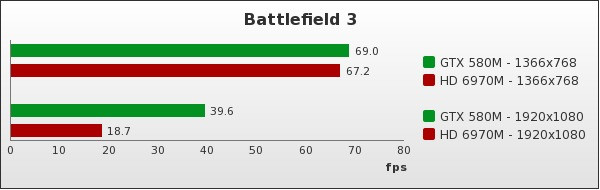

Battlefield 3 -

On termine avec Battlefield 3, testé sous Fraps également. Les détails sont réglés sur « Elevé » (anticrénelage désactivé et filtrage anisotrope 16x) et la synchronisation verticale désactivée. Là encore, les deux résolutions de test demeurent 1 366x 768 et 1 920 x 1 080. Si le processeur nivelait peut-être les performances sous Crysis 2, ce n'est pas le cas sous BF3. Du moins en haute résolution, qui fait la part belle à la puce NVIDIA. Sur ce titre, la GTX 580M se détache clairement de sa concurrente, avec des performances plus que doublées.

Et en 3D ?

Sur un film 3D comme Tempête de boulettes géantes, aucun souci : le rendu est également tout à fait satisfaisant. Finalement, c'est plutôt du côté des performances que le bât blesse. Car si la GTX 580M est une puce puissante, lorsque le débit d'images est doublé, c'est tout de suite plus compliqué sur certains jeux. Sous Battlefield Bad Company 2 par exemple, difficile d'appliquer un niveau de détail supérieur à « Faible » sous avoir de saccades en Full HD. Si on abaisse la définition en 1 366 par 768, on peut pousser à « Elevé ». A contrario, Crysis 2 passe plutôt bien en 1080p et avec le niveau de détail « Très haut » et la synchronisation verticale activée (mais les effets de flou de mouvement désactivés).

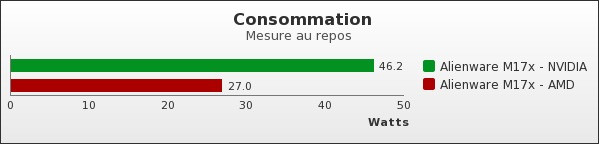

Consommation

À quel point l'absence d'Optimus est-elle préjudiciable au modèle équipé de la GTX 580M ? Face à son jumeau pourvu de la solution AMD et du « graphiques commutables », qui permet de passer sur le HD 3000 du processeur lorsque le PC est au repos, l'écart est important : plus de 71% entre les deux portables !

Sous 3DMark 11, nous avons vu que le GPU test mettait nos cartes sur un pied d'égalité. Qu'en est-il de la consommation durant cet exercice ? Pour le savoir, nous avons utilisé un wattmètre et laissé la mesure se stabiliser avant de relever la consommation. Le résultat est sans appel : la puce AMD est 30% plus économe que sa rivale, à performances égales sur ce test.

Autonomie

Même si un test d'autonomie peut paraître étrange sur des portables de ce type, nous avons voulu voir à quel point l'absence d'Optimus et la consommation plus importante en charge de la GTX 580M pénalisaient le modèle proposant la solution NVIDIA. Évidemment, les deux portables sont pourvus de la même batterie (9 cellules) et sont tous les deux placés en mode économie d'énergie, luminosité moyenne et Wi-Fi activé. Nous utilisons notre test maison, qui sollicite de manière modérée tous les organes du portable, à la manière d'une utilisation bureautique.

Le résultat est sans appel, et pas vraiment à l'avantage de la solution NVIDIA. Le PC équipé de l'AMD Radeon HD 6970M a enduré plus de 4h de notre test quand celui pourvu de la GTX 580M a péniblement atteint les 2h...

Que vaut la GTX 580M ?

NVIDIA peut alors mettre en avant ses technologies maison : PhysX bien sûr, CUDA évidemment, sans oublier 3D Vision. C'est d'ailleurs cette dernière technologie qui pourrait faire peser la balance. En effet, l'aspect immersif que représente la 3D dans certains jeux est indéniable, et certains d'entre vous seront peut-être tentés par cette expérience. D'autant que sur notre portable de test, les résultats sont tout à fait satisfaisants, y compris sur un film 3D.

Oui mais voilà, ces fonctionnalités ont un coût. Un coût non négligeable. Entre une configuration dotée de la puce NVIDIA et d'un écran compatible, et une machine pourvue d'un écran Full HD et d'une Radeon HD 6990M, la différence de prix est actuellement de plus de 450 euros chez Alienware. C'est conséquent, pour ne pas dire plus. Finalement, ceux qui ne recherchent que la performance seront probablement tentés de se tourner vers une solution AMD, nettement plus attractive du point de vue financier. Pour ceux qui veulent jouer en 3D, en Full HD, avec un niveau de détail convenable et de façon nomade, la solution de NVIDIA sera alors la bonne. Mais combien de personnes cela concerne-t-il ?