Le NV20

Depuis un petit bout de temps maintenant, le monde de la carte graphique est dominé par NVIDIA et le coeur de tous les "hardcore gamers" semble battre au rythme des nouveaux Processeurs de la marque, "un tout les six mois" comme il est de coutume de le dire. Cette cadence on ne peut plus soutenue ne reflète pas tout à fait la réalité puisque NVIDIA ne développe en fait de nouvelle technologie qu'une fois l'an.C'est ainsi que nous avons eu droit au TNT, et au TNT2 (en plusieurs versions) puis au premier GPU avec le GeForce 256. Le nombre de modèles s'est alors fortement accrus au point d'embrouiller complètement les moins au fait de l'actualités. Nous aurons vu défiler sur nos étales des GeForce SDR, des GeForce DDR puis des GeForce 2 GTS, Pro et Ultra avec enfin toutes les variations du GeForce 2 MX.

Il était plus que temps pour NVIDIA de faire table rase et de nous proposer par la même occasion de nouvelles innovations technologiques pour distancer ATI et son Radeon. Voici donc venir le NV20 et pour commencer une brève liste de ses caractéristiques :

Parlons tout de suite et très rapidement de "l'accélération" DVD du GeForce 3. Très rapidement car en fait il n'y a pas de différence avec ce que proposait depuis quelques temps le GeForce 2. Il n'y a donc au menu que du motion compensation et on est loin de ce qu'offre le concurrent canadien (ATI) en la matière. Cela suffit toutefois à lire des DVDs de manière très correcte pourvu que le processeur central soit au moins un 400MHz.

Lightspeed Memory Architecture

Si vous regardez attentivement les statistiques du GeForce 3, vous devez certainement être un peu surpris. Les fréquences de fonctionnement du processeur et de la mémoire n'ont rien de franchement impressionnant et la bande passante qui en résulte n'est pas meilleure que pour les GeForce 2 Ultra. Pire le fillrate théorique est même inférieur à celui de cette dernière : 800 Mpixels/s contre 1 Gpixels pour l'Ultra.D'après NVIDIA, là n'est pas le principal, les ingénieurs ont effectivement travaillé sur l'optimisation de cette bande passante. Leurs travaux se résument à ces trois mots : "Lightspeed Memory Architecture". Pour ces trois mots nous avons en fait trois innovations technologiques toutes plus intéressantes et plus compliquées les unes que les autres : Z-Occlusion Culling, Z-Buffer Compression et Crossbar.

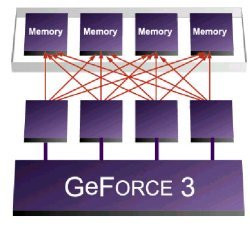

Contrôleur de mémoire "Crossbar"

Il faut en fait détailler un peu plus les choses. Le Crossbar est composé de quatre unités indépendantes capables de traiter chacune des blocs de 64 bits pour donc un total de 256 bits. C'est cette division en quatre unités qui est la clef d'une meilleure gestion de la mémoire. En effet la tendance actuelle est à une plus grande précision dans les scènes 3D. Les personnages et objets sont plus complexes et comportent donc de plus en plus de petits éléments.

Dans ses documentations techniques NVIDIA prend l'exemple certes excessif mais bien compréhensible, d'un triangle d'une taille de 2 pixels représentés en "couleurs vraies" (32 bits). L'ensemble des données couvrant la définition de ce triangle est donc de 64 bits (2*32) et oblige un déchet de 192 bits pour un contrôleur classique. Les quatre modules du Crossbar évitent donc ce gâchis tout en permettant de traiter 256 bits de données par cycle d'horloge en les groupant.

Z-Occlusion Culling

Kézako occlusion culling ? Il est vrai que des trois, c'est certainement la plus difficile à deviner, mais pour vous aider un peu sachez déjà que cela se rapproche pas mal du fameux Tile Rendering du Kyro 2 et qu'il s'agit d'une technique destinée à réduire la quantité d'éléments à être rendus.Actuellement lorsqu'une scène 3D est calculée, elle l'est dans son ensemble et on ne se préoccupe de savoir si telle ou telle partie sera visible qu'au moment de l'affichage proprement dit, une fois que tous les calculs ont été effectués. Le Z-Occlusion Culling se propose de faire cela avant même la phase de rendu et en évitant de calculer les pixels qui ne seront pas visibles, il permet de gagner jusqu'à 50% de bande passante dans les scènes actuelles.

Z-Buffer Compression

Ce système de compression permet évidemment de réduire les données relative à la profondeur des pixels (coordonnée Z, en plus des classiques coordonnées x et y). Pour faire simple c'est cette profondeur qui détermine au moment du rendu final si tel ou tel pixel sera finalement visible à l'écran ou bien masqué par un autre.Plus la scène est complexe et plus les informations relatives à la profondeur seront nombreuses, c'est pour cela et pour éviter une surcharge mémoire issue du trafic généré que NVIDIA a mis au point cette compression. Il s'agit en fait d'un "simple" algorithme qui permet de diviser par quatre ce flux d'information sans aucune perte de qualité pour ne pas altérer le rendu final.

Bye, bye T&L ?

Eh oui ! Aussi étonnant que ça puisse paraître : exit le T&L. Après nous en avoir rabattu les oreilles pendant des mois, après nous avoir dit que tout les jeux allaient très bientôt l'utiliser et que c'était ça qui rendaient leurs cartes plus puissantes que les autres, les ingénieurs de NVIDIA ont décidé que ce Transform & Lightning n'était finalement pas assez bien pour nous... Soit.

Ce remplaçant est peut-être la plus grande innovation du GeForce 3 et se nomme prosaïquement : nfiniteFX. Mis à part un nom à coucher dehors, il faut reconnaître que ses caractéristiques ont vraiment l'air époustouflantes. Ce nouveau moteur est la combinaison de deux modules dont les noms découlent directement de leur cible : d'un côté les Pixel Shaders qui agissent évidemment sur les pixels et de l'autre les Vertex Shaders pour tout ce qui concerne les vertices (sommets des triangles qui composent tout polygone).

L'un comme l'autre, ces deux modules ouvrent des perspectives totalement nouvelles aux développeurs de jeux en leur offrant un contrôle beaucoup plus grand. En utilisant les instructions mises au point par NVIDIA, ils devraient ainsi pouvoir ajouter leurs propres algorithmes au GeForce 3 et ne plus être limités à ce que les ingénieurs du GeForce 3 auront pris soin d'intégrer (une sorte de T&L programmable en fait). Associée aux capacités intrinsèques du chip graphique et à différents effets comme l'Environmental Bump Mapping, cette plus grande liberté devrait ouvrir la voie à un réalisme sans précédent dans les titres avenir.

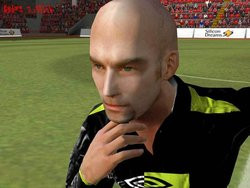

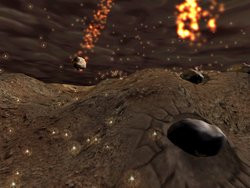

A titre de rappel, le bump mapping de type "Environmental", autrefois réservé aux seuls chips Matrox G400, est un effet 3D qui permet de simuler le relief grâce à des jeux de lumières. La méthode "Environmental" est actuellement ce qui se fait de mieux en terme de Bump Mapping puisqu’elle permet des effets de reliefs très complexes et très réalistes comme on peut le voir dans 3D Mark 2001 ou GL-Mark (cf. photo ci-dessus prise à partir d’une GeForce 3).

L'animation d'un personnage pourra facilement être plus fluide, plus précise, avec un grand soucis du détail pour son visage ou le mouvement de ses vêtement. NVIDIA prend l'exemple simple d'un drapeau qui pourra onduler de manière beaucoup plus réaliste, ou d'un animal dont la respiration pourra se voir aux mouvements de son torse !

La même démo de Zoltar sur GeForce2 sans la technologie nFinite FX

HRAA

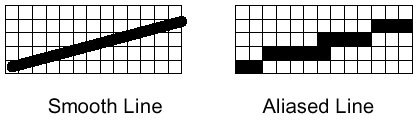

Pour terminer avec cette description technique et avant d'attaquer ce que vous attendez tous à savoir les tests à proprement dit, il faut parler de ce HRAA. Derrière cet acronyme barbare se cache en fait quelque chose que tout le monde connaît : le High Resolution Anti-Aliasing (Anti-crénelage haute-résolution), c'est à dire une sorte de Full-Scene Anti-Aliasing.Le principal défaut de nos scènes 3D est ce que l'on peut résumer à un effet "d'escalier". Il s'agit en fait de limitations propres aux techniques d'affichage employées qui provoquent des déformations d'images. Pour y remédier la technique la plus élémentaire consiste à afficher des résolutions toujours plus élevées mais l'on se heurte alors aux limitations de nos écrans et à la gourmandise des scènes alors générées.

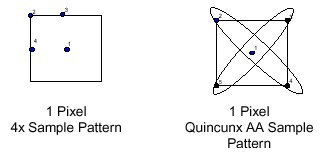

L'idée finalement encore assez récente de feu 3dfx pour contrer cet effet "d'escalier" se nomme Anti-Aliasing. Le principe est on ne peut plus simple : il s'agit de pousser le GPU à calculer en interne (sans que rien ne soit afficher) la scène dans une résolution supérieure à celle qui sera finalement utilisée. Il suffit ensuite au moment du rendu d'appliquer un filtre avant l'affichage à la résolution souhaitée.

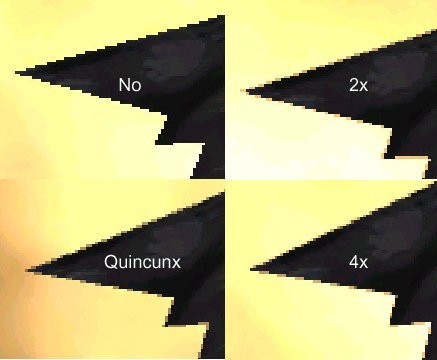

Le GeForce 2 inclue bien sûr cette technique et offre des modes 2x et 4x, qui calculent l'image dans une résolution 2 fois et 4 fois supérieure. Si la qualité d'affichage est correcte, il n'en est pas de même de la vitesse qui chute de manière vertigineuse au point de ne rendre le 4x jouable que sur GeForce 2 Ultra et encore !

Avec son nouveau processeur graphique, NVIDIA inaugure le Quincunx. Cette fonction est censée nous donner la qualité du FSAA 4x, tout en conservant la vitesse du 2x. Pour arriver à cette prouesse, il "suffit" d'opérer une interpolation plus intelligente des points, en se référant sur plus de pixels alentours comme le montre le schéma ci-dessus. Il en résulte une qualité d'image évidemment supérieure et l'exemple ci-dessous fourni par NVIDIA en atteste bien, maintenant il faudra vérifier dans nos tests ce que montrent les résultats officiels pour pouvoir affirmer que les performances n'en patissent pas trop.

High Order Surface

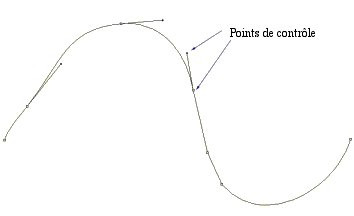

Derrière ce terme, se cache une nouvelle fonction qui va permettre d'économiser la bande passante du port AGP limitée dans le meilleur des cas à 1,056 Go/sec (AGP 4x). Vous ne le savez peut-être pas, mais aujourd'hui les développeurs sont freinés par cette limitation de bande passante. C'est effectivement via le port AGP que sont transférés ce qu'on appelle les Vertices (les sommets des triangles qui composent un scène 3D).Les scènes 3D sont aujourd'hui de plus en plus complexes, car elles utilisent un nombre toujours plus important de triangles et, de ce fait, le port AGP 4x commence à montrer ses limites. Il a donc fallu trouver une solution à ce problème de bande passante, celle que NVIDIA propose aux developpeurs se nomme : HOR (High Order Surface).

Tout n'est toutefois pas rose et bien que cette fonction HOS soit partie intégrante de DirectX 8, elle doit malgré tout être intégrée aux différents moteurs 3D pour être exploitable (dans le cas où il ne s'agit pas du moteur intégré à DirectX). Ceci implique bien sûr d'importantes modifications, que tous les développeurs ne seront pas forcément enclin à faire et le support d'une telle fonction n'est pour le moment qu'hypothétique.

Maintenant que cette longue phase théorique est terminée passons à la pratique avec l'évaluation des performances !

Les performances

Pour évaluer les performances du nouveau bijou technologique de chez NVIDIA nous nous sommes munis de jeux / benchmarks diverses : Quake III , MDK 2, 3D Mark 2001, GL Mark, Giants et Dronez Benchmark pour ne pas les citer.Les résultats obtenus ont été comparés aux performances d'une GeForce2 Pro et d'une GeForce2 Ultra (250/460 Mhz) . Pour mettre cette dernière à égalité avec notre Gladiac 920 et évaluer correctement les performances de la nouvelle architecture du GeForce3, nous avons également fait des mesures en "underclockant" le GeForce3 à la même fréquence que la GeForce2 Pro, c'est à dire 200MHz pour le chip et 400Mhz pour la mémoire.

Pour information voici la configuration sur laquelle les cartes ont été évaluées :

Passons maintenant à la phase que tout le monde attend, celle des résultats !

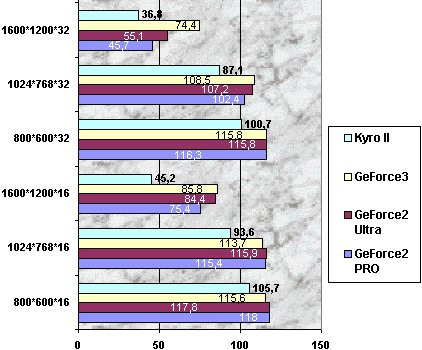

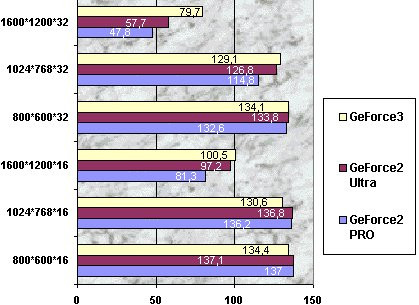

Quake III

Comme vous pouvez le constater sous ce jeu OpenGL le GeForce3 n'apporte pas grand chose en dessous des hautes résolution (1600*1200). A noter qu'avec le GeForce3 il est désormais possible de jouer en 1600*1200*32 High Details à plus de 70 FPS... Autant dire que la fluidité est de mise !

On remarquera également la faible différence de performances entre le GeForce3 et le GeForce2 Ultra, exception faite, là encore, du 1600*1200*32 bits où la version standard du GeForce3 domine avec plus de 19 fps de différence.

Giants

Sous Giants, un jeu optimisé à l'origine pour le GeForce2, les remarques émises pour Quake III restent valables, à savoir que le GeForce3 ne se détache vraiment qu'en très haute résolution (1600*1200) grâce à l'architecture LightSpeed Memory qui fait vraiment bien les choses en haute résolution.

A noter que la version spécialement optimisée pour le GeForce3 qui sera livrée en standard avec la Gladiac 920 n'était hélas pas encore disponible lors de notre test.

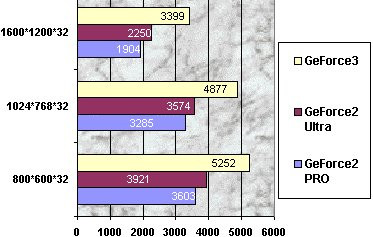

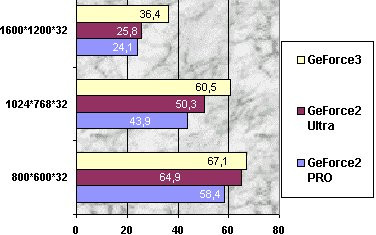

3DMark 2001

Sous 3Dmark 2001, un Benchmark 3D qui exploite la plupart des nouvelles fonctions de DirectX 8 et donc du GeForce3, la situation est vraiment différente : le GeForce2 Pro et le GeForce2 Ultra restent à la traine même quand la Gladiac 920 est cadencée à la même fréquence que la GeForce2 Pro.

L'utilisation des nouveaux effets 3D comme les Pixels Shaders sous 3D Mark 2001 à l'aide du GeForce3 nous laisse imaginer ce que pourront nous offrir les developpeurs de jeux dans quelques mois : une qualité et des détails graphiques incroyables, de plus en plus proche du photo réalisme !

Dronez

Dronez est un jeu OpenGL optimisé pour le GeForce3 puisqu'il supporte des fonctions propres à ce chip comme les Texture Shaders ou la programmation des Vertex (Transform & Lighting). Les textures utilisées dans ce jeu sont vraiment impressionnantes, de part leur qualité mais surtout de part leur taille puisque Dronez utilise un format d'image PNG, un format compressé sans perte de qualité mais qui a le désavantage d'être plus lourd que d'autres formats d'images (toutefois plus destructeurs).

En analysant les résultats obtenus sous Dronez on s'aperçoit que le GeForce3 domine haut la main. La raison ? Avec le GeForce3, Dronez utilise le nfiniteFX pour effectuer les effets de bump (relief) alors qu'avec le GeForce2 Ultra il doit faire sans ce nouveau moteur et plus particulièrement sans les Shaders (Pixel et Vertex). Pour compenser Dronez utilise une sorte d'émulation via l'utilisation du CPU central d'où des différences de performances.

MDK 2

Dans MDK2 , un jeu OpenGL qui supporte le Transform & Lighting, le GeForce3 n'arrive a se détacher du GeForce2 Pro qu'a partir du 1600*1200.

On remarquera notamment les excellentes performances du GeForce3 en 1600*1200*32 qui est supérieur au GeForce2 Ultra de 27%, performances que l'on doit une fois de plus à l'architecture LightSpeed Memory.

Vulpine GL-Mark

Vulpine GL-Mark est en quelque sorte le 3D Mark 2001 de l'OpenGL puisqu'il exploite comme Dronez, certaines fonctions du GeForce3 et en particulier les Pixel et Vertex Shaders.

Comme on peut le voir sur le graphique, le GeForce3 se montre logiquement plus véloce dans ce Benchmark que le GeForce2 Ultra, l'utilisation en hardware des fonctions Shaders associées à l'architecture "Lightspeed Memory" permet d'offrir un gain de performances significatif.

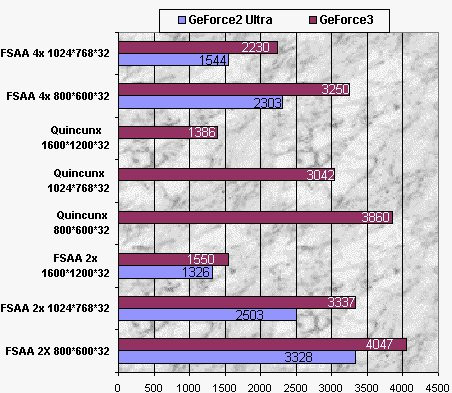

Le FSAA

Le GeForce3 offre 3 modes de Full Scene Anti-Aliaising : le FSAA 2x, le FSAA 4x et le FSAA Quincunx. C'est ce dernier mode qui nous intéresse le plus puisqu'il s'agit d'une exclusivité NVIDIA qui permettrait selon les dires du fabricant, d'obtenir une qualité graphique très proche du FSAA 4x tout en conservant les performances du mode 2x.Bien sur nous ne nous sommes pas privé de vérifier ces informations avec quelques tests de qualité et quelques benchmarks, en commençant par la qualité d'affichage. Voici donc respectivement la qualité graphique que nous avons obtenue dans le jeu Giants à l'aide des modes FSAA 2x, Quincunx et FSAA 4x (cliquez sur l'image de votre choix pour obtenir la photo de l'ensemble de la scène, attention il s'agit de photo très lourdes qui pèsent chacune près de 450 Ko, format JPEG avec taux de compression 0%) :

A titre de comparaison nous avons également effectué quelques tests de qualité sur la même scène avec la GeForce2 Pro qui fait du FSAA grâce à la technique de Supersampling (agrandissement d'une scène en interne puis réduction à la résolution effective grâce à un filtre lissant les effets d'escaliers) :

Comme vous pouvez le constater sur les trois premières photos le mode Quincunx du GeForce3 offre un rendu intermédiaire entre le FSAA 2x et le FSAA 4x, il s'agirait donc là d'un bon compromis qualitatif... A condition que les performances suivent, chose que nous allons maintenant vérifier !

Mais avant voici quelques captures d'écrans FSAA Quincunx supplémentaires afin que vous puissez vous faire une idée plus précise de la qualité de ce mode FSAA :

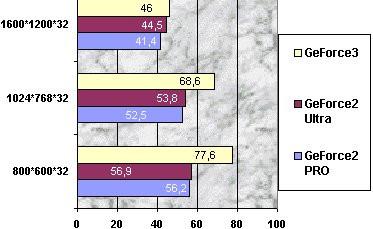

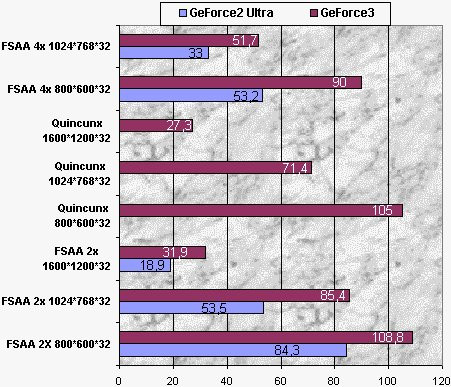

FSAA, les performances

Pas de mauvaise surprise ici, les dires de NVIDIA se confirment et les performances en mode FSAA Quincunx sont relativement proches de celles du FSAA 2x. Un simple bench comme 3D Mark 2001 pour le FSAA étant beaucoup moins parlant qu'un bench dans un jeu, nous avons également effectué cette évaluation dans Quake III.

Comme vous pouvez le constater le GeForce3 à l'aide de son mode Quincunx permet de profiter d'un FSAA digne de ce nom sans pourtant sacrifier la fluidité du jeu puisqu'en 1024*768*32 la bête offre un FPS de 71.4, en d'autres termes une fluidité exemplaire.

On remarquera que le GeForce3 écrase et ce quelque soit le mode et la résolution la GeForce2 Ultra. NVIDIA semble donc avoir bien rattrapé le retard qu'il avait depuis la sortie de la 5 et de son FSAA matériel, il n'avait alors qu'une solution software (le Supersampling du GeForce2 Pro) quasi-inxploitable avec les jeux récents.

Comparatif des différentes cartes GeForce3 du marché

Elsa Gladiac 920

Il s'agit d'une carte équipée de 64 Mo de mémoire DDR 3.8ns alors que les GeForce2 Ultra, pourtant cadencées à la même fréquence, utilisent de la DDR 4ns. Cette mémoire de qualité surmontée de deux gros radiateurs et le ventitaleur particulièrement efficace (mais hélas bruyant) placé sur le GeForce 3 augurent de bonnes aptitudes à l'overclocking, mais nous y reviendrons en temps voulu.

Une sortie TV classique équipe également cette carte qui sera livrée en standard avec une version spéciale du jeu Giants, entièrement optimisée pour le GeForce3.

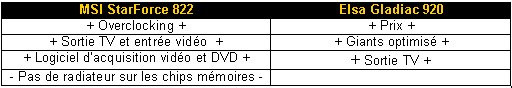

MSI Starforce 822 :

Comme pour la plupart des cartes GeForce3 MSI a équipé sa carte de 64 Mo de mémoire DDR 3.8 ns et d'un système de refroidissement des plus classiques, ainsi un large ventilateur (celui-la même qui équipe l'Elsa Gladiac) est placé sur le chip. Toutefois aucun système de refroidissement n'équipe les chips mémoires, nous verrons plus tard si cette absence à de réelles répercutions sur les possibilités d'overclocking.

L'offre logiciel de la StarForce 822 se compose également des classiques utilitaires "MSI 3D Turbo 2000" et "MSI DVD 3.0". Le premier de ces utilitaires est un panneau de configuration qui ne permet malheureusement pas d'overclocker la carte graphique mais cela pourra être fait sans soucis à l'aide des logiciels NVmax ou Powerstrip.

Quant à l'utilitaire "MSI DVD 3.0" il ne s'agit ni plus, ni moins de l'excellent logiciel de lecture PowerDVD 3.0 accompagné pour l'occassion d'un "Skin" spécial MSI.

Au niveau des accessoires au regrettera que seul le cable pour la sortie TV soit livré en standard, on aurait également aimé trouver les cables relatifs à l'acquisition vidéo.

Comparons maintenant ces différentes cartes sur leurs capacités à supporter plus ou moins bien l'overclocking.

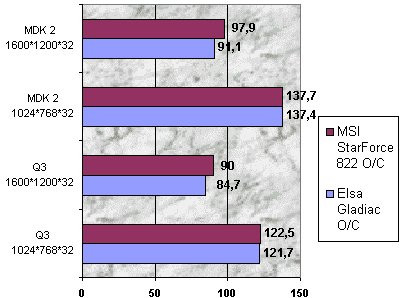

Overclocking

Nous nous sommes ensuite précipité sur l'onglet des pilotes NVIDIA qui permettait d'overclocker les différentes cartes, les résultats ont très diversifiés, puisque nous avons réussi à atteindre la fréquence de 230 Mhz pour le chip (au lieu de 200 MHz initialement) et 510 MHz pour la mémoire avec la Elsa Gladiac 920, tandis qu'avec la carte en provenance de chez MSI nous avons atteint la fréquence de 240 MHz pour le chip et de 550 MHz pour la mémoire !

La StarForce 822 de MSI, semble donc malgré l'absence de radiateurs au niveau des chips mémoires, supérieur pour l'overclocking que la Gladiac 920 (grâce à une mémoire de meilleure qualité ?). Toutefois ces résultats sont à prendre avec des pincettes car comme pour un processeur cental, la capacité à supporter l'overclocking peu varier d'une carte à une autre.

Pour information voici les performances que l'on obtient lorsqu'on overclock les différentes cartes à ces fréquences (Driver utilisé : 12.40 beta).

Comme vous pouvez le voir malgré un excellent overclocking la MSI StarForce 822 n'arrive à distancer l'Elsa Gladiac 920 qu'a partir du 1600*1200*32 Bits, dans les résolutions inférieures les performances des cartes semblent être limitées par le processeur central.

En conclusion, la Gladiac 920 est une excellente carte très bien équipée et félicitons Elsa, qui est l'un des rares fabricants à proposer avec sa carte un jeu récent et spécialement optimisé pour tirer profit du GeForce3, sans pour autant être plus cher que la concurrence.

Autre atout de taille pour la StarForce 822 sa capacité à supporter des overclocking démesurés, reste que deux petits radiateurs placés sur les chips mémoires n'aurait pas été de refus puisque ces mêmes chips ont une fâcheuse tendance à bouillir ...

Compatibilité et stabilité

Les pilotes, bien qu'en phase de beta test, et la carte ont montré pendant les tests une stabilité exemplaire et nous n'avons rencontré aucun problème que ce soit avec des jeux récents (Giants, Black & White, Offroad, Insane) ou anciens (Quake III, Unreal Tournament ...).Une exception toutefois, avec le titre de Microsoft, Midtown Madness 2 où les textures partaient dans tous les sens.

Conclusion

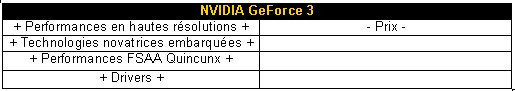

Autant le dire tout de suite, le GeForce3 nous a vraiment bluffé que ce soit par ses performances en haute résolution, par son FSAA "Quincunx" ou encore par les applications optimisées DirectX 8 (dont les fameuses démos technologiques fournies avec la carte, cf photos ci-dessous). Bien plus qu'une simple évolution du GeForce2, ce chip annonce une véritable révolution dans le monde de la 3D non professionnelle.

Une révolution qui a malheureusement un prix exorbitant : près de 3500 francs (3290F TTC pour la Gladiac 920 et 3490 FF TTC pour la MSI StarForce 822). La question de la justification d'une telle somme se pose tout naturellement et y répondre n'est pas simple tant il est vrai que les technologies embarquées dans le GeForce3, si elles offrent des possiblités extraordinaires, ne sont malheureusement par encore exploitées et ne le seront vraisemblablement pas avant Noël 2001.

A l'annonce de cette dernière phrase, je vois déjà votre regard soucieuxet vous vous dites sûrement que NVIDIA essaye de nous refaire le coup du T&L des GeForce première du nom. Cette fois-ci la situation semble toutefois être différente puisque des jeux comme Dronez ou Aquanox, bientôt disponibles, tirent d'ores et déjà profits du GeForce3. Reste à savoir, bien sûr, s'ils présentent un intérêt en dehors de leur formidable qualité graphique (tout le monde se souvient du pitoyable Evolva...).

Alors faut-il craquer pour une GeForce3 ? La réponse à cette question n'appartient finalement qu'à vous ! Si vous souhaitez disposer de ce qu'il y a de mieux pour les jeux actuels et futurs sans regarder à la dépense, c'est évidemment un oui sans appel ! En revanche si vous n'êtes pas de ceux qu'on surnomme les "hardcore gamers", que le FSAA n'est pas primodial ou que votre 17 pouces ne vous permet de toute façon pas d'atteindre le 1600*1200, alors la baisse prochaine des GeForce 2 Ultra ou même une simple carte à base de GeForce2 MX ou de Kyro 2, devrait pleinement vous satisfaire d'autant qu'elles permettent toutes de faire tourner des jeux aussi récent que Black & White sans soucis.