En préparation depuis quelque temps déjà, la GeForce GTX 280 devrait permettre à NVIDIA de renouveler son offre très haut de gamme, mettant ainsi un terme à la navrante stagnation des performances à laquelle nous assistions... impuissants. Et si la GeForce GTX 280 s'annonce sur le papier comme un monstre de performances, c'est aussi pour NVIDIA une nouvelle plate-forme de promotion de ses technologies maisons. Car, plus de douze mois après la sortie de CUDA, l'API qui permet d'utiliser le processeur graphique comme un co-processeur, les premières applications grand public en tirant profit voient le jour. Un petit tour du propriétaire s'impose !

Une architecture unifiée de seconde génération

Vous l'aurez tout de suite noté, la petite dernière de NVIDIA profite d'une toute nouvelle appellation commerciale. Exit, les séries GeForce 9, et bienvenue aux GeForce de la série 200. Avec cette nouvelle nomenclature, NVIDIA essaie de clarifier ses gammes et promet de ne pas commettre les erreurs du passé avec des déclinaisons aussi nombreuses qu'obscures : on jugera sur pièce. En attendant, le GeForce GTX 280, nom de code G200, pouvait difficilement figurer dans la famille GeForce 9 puisque son architecture est sensiblement différente.NVIDIA profite en effet du GeForce GTX 280 pour lancer sa seconde génération d'architecture graphique unifiée. Avec le G80, qui a donné naissance aux GeForce 8 et GeForce 9, NVIDIA avait jeté les bases de sa première architecture graphique unifiée, une architecture où les anciennes notions de pixels pipelines ou d'unités de vertex n'existent plus. Plutôt que de segmenter la puce avec des unités fixes spécialisées dans telle ou telle tâche, NVIDIA a en effet pris le parti, tout comme AMD du reste, de doter sa puce d'unités reconfigurables pouvant travailler indifféremment sur tout type de données.

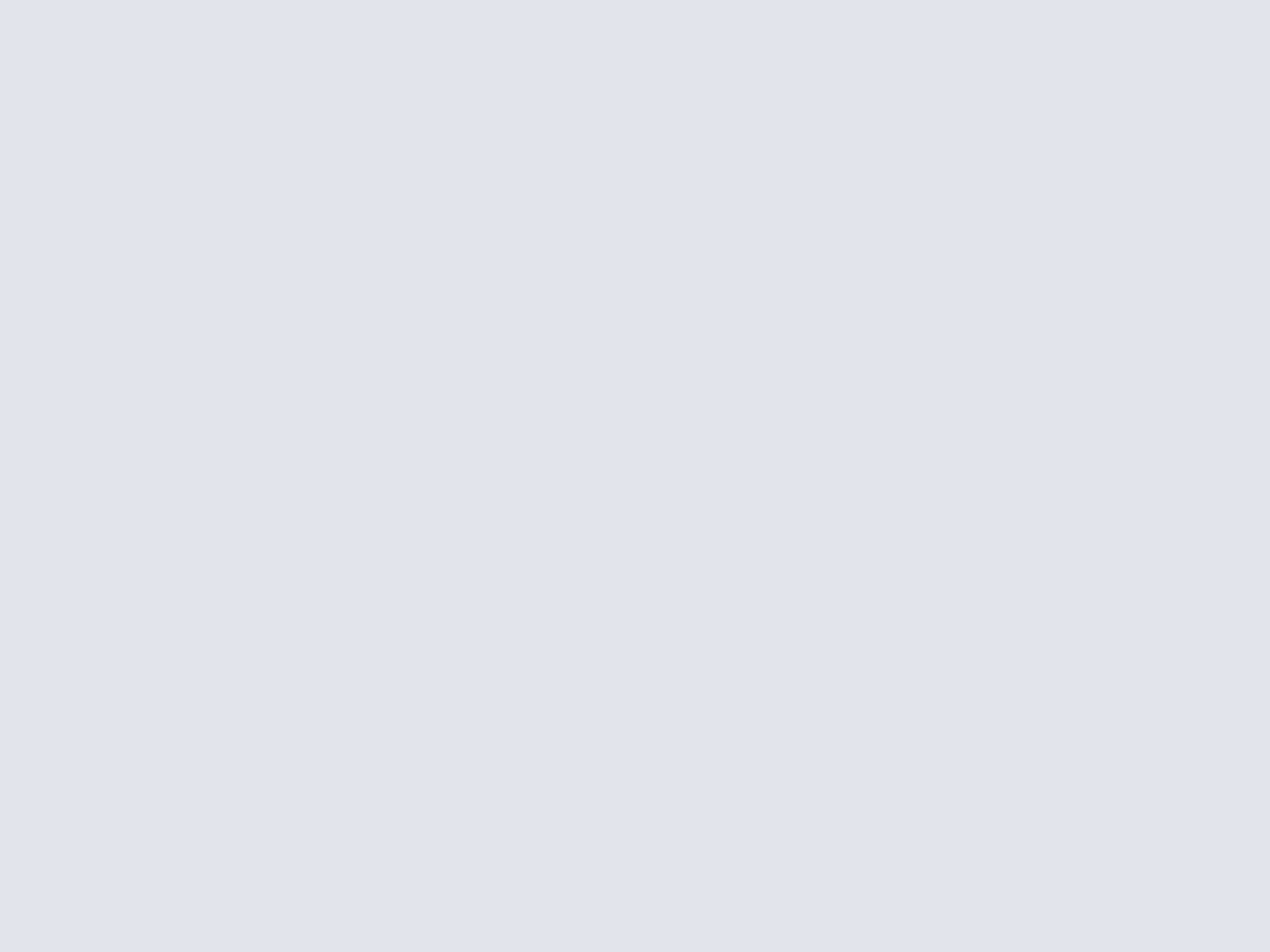

Le pourquoi d'une architecture unifiée

Ainsi, avec une scène massivement chargée en pixels shaders, plutôt que d'avoir comme avec les anciennes architectures DirectX 9, une partie des unités destinées aux Vertex qui ne servent à rien, toutes les unités du processeur sont ici utilisées pour le traitement des pixels shaders : l'avantage est bien réel et aboutit à une utilisation la plus efficiente possible des ressources de la puce. Des ressources qui peuvent être exploitées aussi bien pour le rendu 3D que pour des calculs plus généraux, le GPU pouvant maintenant être programmé pour un usage autre que le graphique.

Une nouvelle ère pour le GPU ?

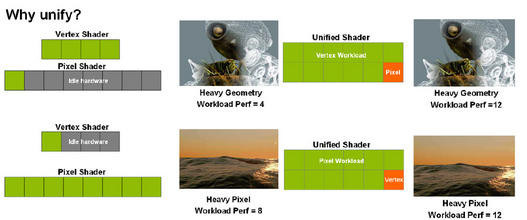

Différence d'architecture entre CPU et GPU

Oui mais voilà, jusqu'à présent, aucun standard n'avait été clairement défini pour exploiter les ressources des GPU, dans un autre contexte que la 3D et le moins qu'on puisse dire est qu'exploiter un GPU comme une unité de calcul est une tâche particulièrement complexe. Les développeurs devaient en effet adapter leur code sous forme de pixel shaders pour utiliser le GPU comme aide au calcul. L'évolution des puces graphiques aidant, ATI et AMD se sont tour à tour penchés sur la question, chacun apportant sa propre solution. Avec le GeForce 8800, NVIDIA introduisait CUDA, sa bibliothèque de développement utilisant un langage assez naturel pour les développeurs, en l'occurrence le C et le C++.

Scindée en une couche logicielle avec un environnement d'exécution d'un côté et un pilote de l'autre, l'API CUDA se veut pratiquement transparente pour le développeur et nécessite naturellement une puce graphique compatible. Avec le GeForce GTX 280, NVIDIA propose diverses améliorations d'ordre architectural pour accélérer le traitement des programmes CUDA tout en prenant en charge, pour la première fois, la double précision, mais nous aurons l'occasion d'évoquer à nouveau le sujet. Pour l'utilisateur, CUDA et les programmes en tirant profit, incarnent la promesse d'une nouvelle ère, celle où la puce graphique assiste le processeur central pour d'autres types de tâches que la 3D. Et NVIDIA a un argument de taille pour aider à la concrétisation de la chose : avec les gammes GeForce 8, GeForce 9 et maintenant GeForce GTX 200, ce sont près de 70 millions de puces graphiques à travers le monde qui peuvent exploiter des programmes CUDA. Qui plus est, la prochaine version de CUDA pourra également s'exécuter sur les processeurs x86.

Deux exemples d'applicatifs utilisant CUDA

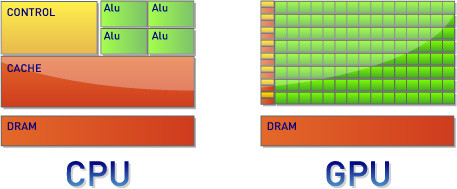

Pour accompagner le lancement du GeForce GTX 280, NVIDIA propose deux applications grand public se basant sur son API CUDA. Il y a tout d'abord la version NVIDIA du client Folding@Home. Un temps disponible dans une version fonctionnant avec les cartes graphiques ATI, Folding@Home a été redéveloppé, par l'université de Stanford, pour fonctionner sur les cartes graphiques NVIDIA via CUDA. Le principe est toujours celui du calcul distribué : un serveur envoie aux clients Folding@Home diverses données à traiter et c'est ensuite la carte graphique qui va résoudre les calculs en question.

Folding@Home tournant sur le GeForce GTX 280

Dans un autre registre, la firme a travaillé avec Elemental Technologies sur le développement d'un convertisseur média logiciel. Baptisé BadaBOOM, celui-ci utilise CUDA et donc les ressources de la puce graphique pour transcoder une vidéo vers le format H.264, divers profils étant du reste proposés (iPhone, iPod, PSP, PS3, Xbox 360, etc.). Attention, il s'agit ici d'une application payante.

L'encodeur vidéo BadaBOOM d'Elemental

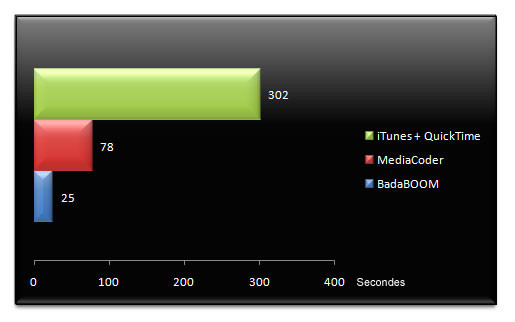

Dans les faits, l'encodage vidéo opéré par BadaBOOM se révèle particulièrement véloce. Nous avons mesuré, chronomètre en main, le temps nécessaire pour encoder une vidéo MPEG2 de 2 minutes au format H.264 avec trois logiciels différents :

On le voit, BadaBOOM, qui utilise notre carte graphique GeForce GTX 280, est le plus rapide à encoder notre vidéo test. Toutefois il faut tempérer ces bons résultats en précisant que l'encodeur vidéo d'iTunes est mono-threadé et n'utilise donc qu'un seul coeur du processeur alors qu'il nous est très difficile d'opérer les mêmes réglages lors de la compression vidéo, les trois logiciels n'ayant pas un seul réglage en commun.

NVIDIA GeForce GTX 280 : l'architecture plus en détails

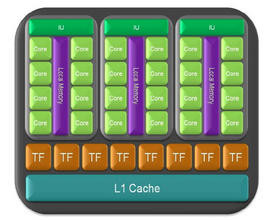

Avec le GeForce GTX 280, l'architecture unifiée reste le maître mot alors que NVIDIA revoit diverses choses, à commencer par le nombre de processeurs de flux et leur organisation au sein de la puce. Alors que le GeForce 8800 était doté de 128 processeurs de flux, le GeForce GTX 280 en comporte240, soit presque deux fois plus. L'occasion pour nous de vous mettre en garde contre la communication de NVIDIA qui tente de mettre en parallèle les 240 processeurs de flux de son processeur graphique aux quatre cœurs que l'on trouve dans les processeurs Intel Penryn notamment. Cette comparaison n'est absolument pas valable, les processeurs de flux du GeForce GTX 280 n'ayant pas du tout les mêmes capacités de calcul que les cœurs d'exécution d'un CPU alors qu'ils ne travaillent pas non plus avec les instructions x86 utilisées par les processeurs AMD ou Intel. Pour en revenir à l'architecture du GeForce GTX 280, les 240 processeurs de flux sont organisés selon 10 grappes ou clusters. Chaque cluster est divisé selon trois unités de traitement multi-processeurs (les SM ou Streaming Multiprocessor), chaque unité étant elle-même dotée de 8 processeurs de flux (les SP ou Streaming Processors).

Gros plan sur le TPC ou Thread Processing Cluster

Chacun des 240 cœurs d'exécution du GeForce GTX 280 peut effectuer des opérations arithmétiques sur des nombres entiers ou des nombres flottants alors qu'ils sont capables d'effectuer des opérations logiques avec un accès à la mémoire. Chaque processeur scalaire est qui plus est multi-threadé de manière matérielle et peut exécuter une instruction par processus et par cycle d'horloge. Rappelons au passage, qu'au contraire des architectures vectorielles précédemment employées au sein des puces graphiques, l'architecture unifiée de NVIDIA travaille non pas sur l'ensemble d'un vecteur mais sur une seule de ses composantes (coordonnées X, Y, Z pour un vertex, valeurs de couleurs RGBA d'un pixel).

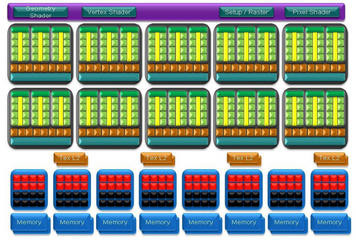

Vue d'ensemble de l'architecture du GeForce GTX 280

En tête d'architecture, on retrouve le « Thread Scheduler », une super unité qui a le rôle d'arbitre et est chargée de dispatcher les calculs, en fonction de leur nature (pixel, géométrie, vertex) vers chacun des clusters de traitement tout en maximisant leur efficacité. Naturellement, avec près de 240 processeurs de flux à faire travailler, NVIDIA s'est sérieusement penché sur l'optimisation des algorithmes de son organiseur de processus avec des gains de performance atteignant jusqu'à 20% dans certains cas bien précis.

NVIDA GeForce GTX 280 : un seul GPU mais deux personnalités...

La charge de travail n'étant pas la même que le GPU traite de la 3D ou qu'il effectue des calculs parallèles pour par exemple encoder une vidéo, l'architecture du GeForce GTX 280 a pour particularité d'offrir deux facettes. Comme sur le G80, le GeForce GTX 280 dispose d'une mémoire locale partagée entre chacun des huit processeurs de flux. Cette mémoire est cruciale puisqu'elle permet l'échange de données directement entre les processeurs de flux, ce qui accélère sensiblement le traitement puisque cela évite à la puce de lire les données depuis une mémoire externe. Avec le GeForce GTX 280, NVIDIA augmente la taille de cette mémoire cache tout en l'exposant de meilleure manière pour les développeurs qui peuvent l'utiliser plus simplement.

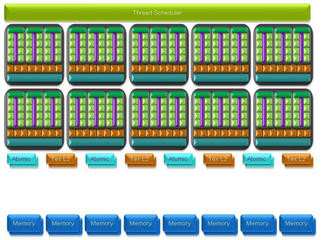

Architecture du GeForce GTX 280 pour les calculs

En mode calcul, les caches dédiés au stockage des textures sont utilisés pour combiner les accès mémoire afin d'offrir une bande passante plus large pour les opérations de lecture/écriture en mémoire. On notera dans le diagramme de la puce des unités baptisées « Atomic » : celles-ci offrent un accès granulaire aux divers emplacements mémoire et permettent d'effectuer des opérations de lecture, écriture et modification.

Gros plan sur un TPC en mode calcul du GeForce GTX 280 : observez l'apparition de mémoire partagée

NVIDIA GeForce GTX 280 : les autres améliorations de l'architecture

L'autre nouveauté majeure de l'architecture du GTX 280 vient de la prise en charge de la double précision, une prise en charge déjà existante chez AMD depuis le RV670 alias Radeon HD 3850/3870. Le calcul 64 bits en virgule flottante se fait ainsi grâce à une unité dédiée. Au total, et bien que la puce GTX 280 comporte 240 processeurs de flux, seule une trentaine fonctionne en double précision sur 64 bits. Double précision oblige, NVIDIA respecte ici le standard international IEEE 754R.

Parallèlement aux améliorations en matière de calcul, NVIDIA revient également sur les unités de texture de sa nouvelle puce vedette. Alors que les GeForce 8800 offraient huit unités de traitement des textures, le GTX 280 en comporte dorénavant une dizaine. Face au GeForce 8800 qui pouvait filtrer jusqu'à 64 pixels par cycle d'horloge, le GeForce GTX 200 peut en filtrer 80. Du côté des ROP, du nom de ses unités en charge des dernières opérations sur les pixels, NVIDIA porte leur nombre de six à huit partitions. Chaque partition peut travailler sur 4 pixels par cycle d'horloge, ce qui nous donne en sortie des unités ROP pouvant travailler sur 32 pixels contre 24 pour le GeForce 8, lors de traitement de pixels complets (couleurs et profondeur Z). Du reste, NVIDIA ne s'est pas contenté d'augmenter le nombre d'unités ROP puisque certains opérations, comme le mélange de pixels U8 (entier 8 bits non signé) se fait deux fois plus rapidement qu'avec les précédentes générations de GPU.

NVIDIA persiste et signe : DirectX 10... mais la géométrie va plus vite !

Avec DirectX 10, Microsoft a inclus pour la première fois dans son API la possibilité pour la puce graphique de générer de la géométrie, une tâche autrefois dévolue au CPU. Les puces graphiques de la famille GeForce 8 prenaient naturellement en charge cette spécificité non sans une certaine lenteur rendant l'exploitation de la géométrie assez hasardeuse. Fort de ce constat, NVIDIA indique avoir augmenté par un facteur de six la structure des tampons internes pour un traitement plus rapide des shaders de géométrie et de meilleures performances lors des opérations dites de « stream out » (rappelons qu'il s'agit d'écrire en mémoire les données résultats d'un traitement des vertex ou geometry shaders avant le traitement des pixel shaders).

NVIDIA GeForce GTX 280 : une puce énorme avec contrôleur mémoire 512 bits

Dotée de la bagatelle de 240 processeurs de flux, contre 128 pour mémoire en ce qui concerne les GeForce 8800 GTX/Ultra, le GeForce GTX 280 est un véritable monstre. Toujours gravée en 65nm par le taïwanais TSMC, la puce comporte en effet un total de 1,4 milliards de transistors, un nombre presque record. Alors que les GeForce 8800 GTX et Ultra ne disposaient pas d'un contrôleur PCI-Express de seconde génération, la GeForce GTX 280 dispose d'un contrôleur PCI-Express 2.0, comme les GeForce 8 et 9 basées sur la puce G92. Côté fréquences de fonctionnement, on retrouve les mêmes spécificités qu'avec le GeForce 8.

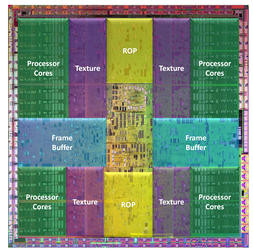

NVIDIA GeForce GTX 280 : Diagramme de la puce

C'est ainsi que la puce opère à 602 MHz (y compris les unités de texture et les ROP) lorsque les processeurs de flux tournent à 1296 MHz, une fréquence un brin curieuse. Théoriquement, la puce affiche une puissance de calcul brute de 933 gigaflops contre 518 gigaflops pour le vénérable G80. Du côté de la mémoire, NVIDIA inaugure pour la première fois un contrôleur 512 bits compatible avec l'actuelle GDDR3 mais aussi avec la GDDR5, au cas où. En attendant, le contrôleur 512 bits du GeForce GTX 280 est en réalité constitué de deux contrôleurs mémoire de 256 bits chacun et NVIDIA dit avoir retravaillé nombre d'algorithmes pour une plus grande efficacité. Dans les faits, la bande passante mémoire passe de 86 Go/s pour une GeForce 8800 GTX à 142 Go/s pour notre GeForce GTX 280. Par défaut, NVIDIA recommande une fréquence de fonctionnement de 1107 MHz pour la mémoire alors que la quantité de cette dernière atteint dorénavant 1 Go sur le modèle GTX 280. Physiquement enfin, la puce adopte un packaging flip-chip avec un heat-spreader métallique semblable à celui déjà présent sur les tous premiers G80.

Pour vous rafraîchir la mémoire, voici un récapitulatif des caractéristiques du GeForce GTX 280 face aux précédentes générations de puces.

| GeForce 8800 GTX | GeForce 8800 GTS 512 Mo | GeForce 9800 GTX | Radeon HD 3870 X2 | GeForce 9800 GX2 | GeForce GTX 280 | |

| Interface | PCI-Ex. 16x | PCI-Ex. 16x - Gen2 | PCI-Ex. 16x - Gen2 | PCI-Ex. 16x | PCI-Ex. 16x - Gen2 | PCI-Ex. 16x - Gen2 |

| Gravure | 0,09 µ | 0,065 µ | 0,065 µ | 0,055 µ | 0,065 µ | 0,065 µ |

| Transistors | 681 Millions | 754 Millions | 754 Millions | 666 Millions | 754 Millions | 1,4 Milliards |

| RAMDAC | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz |

| T&L | DirectX 10 | DirectX 10 | DirectX 10 | DirectX 10.1 | DirectX 10 | DirectX 10 |

| Stream Processors | 128 | 128 | 128 | 320 | 128 | 240 |

| Unités ROP | 24 | 16 | 16 | 16 | 16 | 32 |

| Mémoire embarquée | 768 Mo | 512 Mo | 512 Mo | 2x 512 Mo | 2x 512 Mo | 1024 Mo |

| Interface mémoire | 384 Bits | 256 bits | 256 bits | 256 bits | 256 bits | 512 bits |

| Bande passante | 101.3 Go/s | 62,1 Go/s | 70,4 Go/s | 58,9 Go/s | 64 Go/s | 142 Go/s |

| Fréquence GPU | 575 MHz | 650 MHz | 675 MHz | 825 MHz | 600 MHz | 602 MHz |

| Fréquence Stream Processors | 1350 MHz | 1625 MHz | 1688 MHz | 825 MHz | 1500 MHz | 1296 MHz |

| Fréquence mémoire | 900 MHz | 970 MHz | 1100 MHz | 900 MHz | 1 GHz | 1107 MHz |

NVIDIA GeForce GTX 280 : Hybrid Power à bord et consommation électrique

Tout comme les récentes GeForce 9800 GTX et GeForce 9800 GX2, la GeForce GTX 280 est compatible Hybrid Power. Disponible exclusivement sur les plateformes nForce, et plus précisément sur les seuls nForce 700 pour processeurs AMD, Hybrid Power vise à permettre l'extinction de la carte graphique additionnelle lorsque sa puissance n'est pas nécessaire pour basculer l'affichage sur le circuit graphique intégré à la carte mère. L'idée étant d'économiser de l'énergie lorsque l'on surfe sur l'Internet ou que l'on fait du traitement de texte, les 240 processeurs de flux du GeForce GTX 280 étant effectivement inutiles.En plus du support Hybrid Power, les ingénieurs de NVIDIA ont fait quelques efforts pour réduire la consommation électrique de la puce lorsque celle-ci est peu sollicitée. Alors que nos mesures révèlent une consommation électrique gargantuesque supérieure à 230 Watts sous 3DMark Vantage, la puce dispose de fonctionnalités de clock-gating visant à éteindre des portions du GPU lorsqu'il est peu utilisé. En mode « idle », la consommation de la puce graphique (et non de la carte) tombe à seulement 25 Watts d'après les données constructeur. Seul hic, nos mesures ne nous ont pas permis de valider cette consommation électrique, des mesures effectuées avec notre pince ampèremétrique.

| GeForce 8800 Ultra | GeForce 9800 GTX | GeForce 9800 GX2 | GeForce GTX 280 | Radeon HD3870 X2 | |

| Consommation « idle » | 109,8 Watts | 102,6 Watts | 133 Watts | 111 Watts | 94,2 Watts |

| Consommation en charge | 168 Watts | 154 Watts | 211 Watts | 233 Watts | 195 Watts |

NVIDIA GeForce GTX 280 : PureVideo HD, NVIO 2

Comme la firme l'avait déjà fait avec les GeForce 8800, toute l'électronique gérant l'affichage final (connexions, protocole, etc.) est déportée sur une puce dédiée baptisée NVIO et ce afin de libérer le plus grand nombre possible de transistors. Le protocole HDCP est bien entendu pris en charge alors que l'interface HDMI est supportée via un simple adaptateur (HDMI 1.2). Avec un double RAMDAC de 400 MHz, la puce gère le DVI Dual-Link et propose un support des panneaux d'affichage en 10 bits. Dépourvue de circuit audio interne, la carte graphique se dote d'une entrée audio SPDIF permettant de récupérer le son depuis l'ordinateur pour l'injecter sur l'interface HDMI et ainsi le transférer à votre téléviseur.

NVIDIA GeForce GTX 280 : la carte

Physiquement, la carte GeForce GTX 280 est très proche du récent GeForce 9800 GX2. Double-slot, la carte mesure un tout petit peu moins de 27 centimètres de long alors qu'elle est entièrement carénée, comme les dernières cartes du fabricant. L'électronique de la carte est en effet masquée par un carter métallique noir brillant dont l'extrémité est légèrement de biais ce qui permet, dans certains boîtiers, de ne pas culbuter la cage des disques durs contrairement au GeForce 9800 GX2. Avec un connecteur PCI-Express 16x, la carte est dotée d'un double connecteur SLI, NVIDIA proposant avec le GeForce GTX 280 la prise en charge SLI et 3-Way SLI. Côté alimentation électrique, il faudra disposer d'un connecteur d'alimentation PCI-Express 2.0 (8 broches donc) et d'un connecteur PCI-Express conventionnel (6 broches).

NVIDIA GeForce GTX 280 : la carte

Refroidie par un traditionnel bloc composé d'un radiateur à ailettes métalliques avec un cœur cuivre, la carte embarque un ventilateur type cage d'écureuil en son extrémité droite. L'air chaud est donc expulsé à l'extérieur de l'ordinateur alors que la carte comporte comme connectique deux prises DVI et un connecteur mini-DIN pour les sorties vidéos analogiques (S-Vidéo, YUV, etc). Comportant 1 Go de mémoire vidéo, la GeForce GTX 280 utilise des puces Hynix réparties sur les deux faces du PCB. A noter, la présence d'un connecteur SPDIF sur la tranche de la carte pour récupérer le son du PC et l'envoyer sur l'interface HDMI. Précisons pour terminer qu'en fonctionnement le ventilateur de la carte graphique n'est certes pas le plus discret (lorsque la carte s'échauffe) mais ce n'est pas non plus le bruyant, loin s'en faut.

NVIDIA GeForce GTX 280 : Détails

- Carte mère Asus P5E3 Premium - (BIOS 0402),

- Processeur Intel Core 2 Extreme QX9650 (3 GHz),

- 2x 1 Go mémoire DDR3 Corsair CM3X1024-1800C7 @ 1333,

- Disque dur Western Digital Raptor 150 Go - Serial-ATA 150

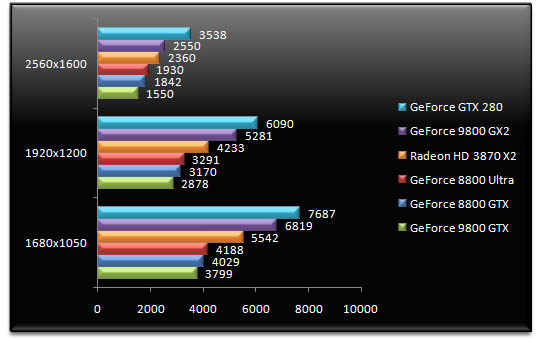

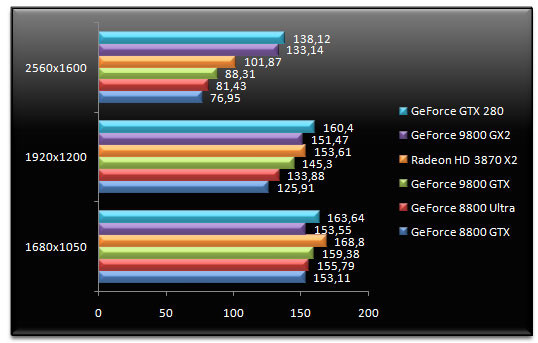

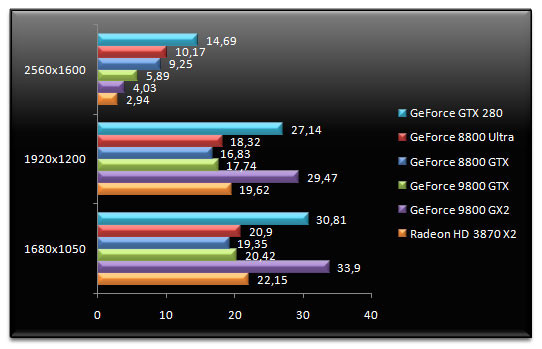

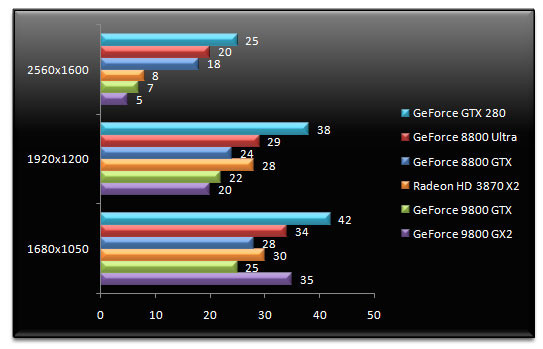

3DMark Vantage

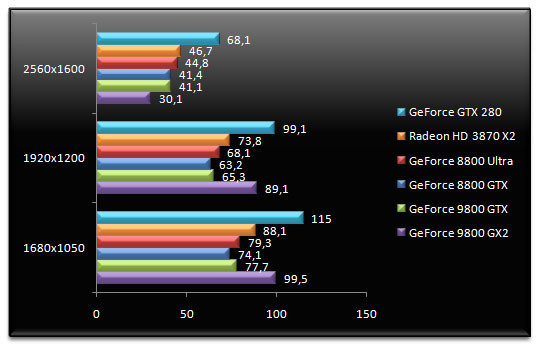

On démarre avec le tout récent 3DMark Vantage, un test qui prend dorénavant en charge DirectX 10. En tête, nous retrouvons, et ce quelle que soit la résolution, le GeForce GTX 280. En 2560x1600, soit la résolution la plus élevée de notre sélection, la petite dernière de NVIDIA est 38% plus rapide que le GeForce 9800 GX2. Face au GeForce 8800 GTX qu'elle remplace, la carte est 92% plus performante. Face au Radeon HD 3870X2, NVIDIA propose ici une carte 50% plus véloce.

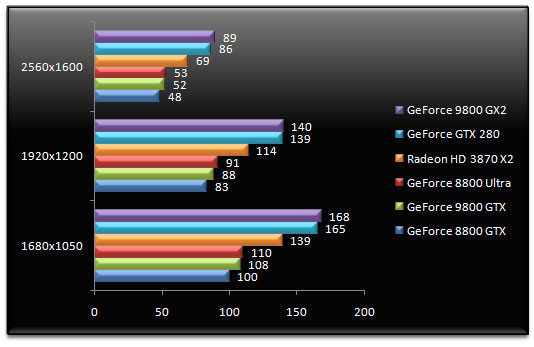

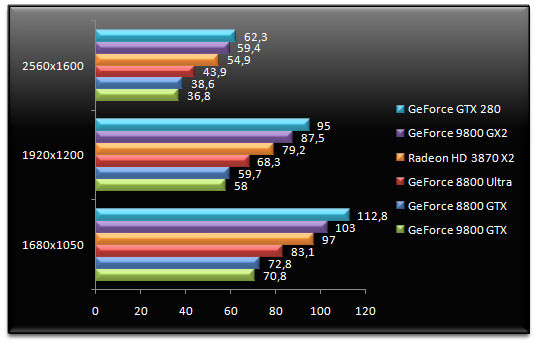

Enemy Territory : Quake Wars - v1.4

On enchaîne avec Quake Wars, ici testé avec notre propre scène. La carte la plus rapide en 1680x1050 et en 1920x1200 s'avère être le GeForce GTX 280, alors qu'en 2560x1600 la dernière-née de NVIDIA cède sa place au GeForce 9800 GX2. Ce dernier est à peine 1,5% plus rapide en 2560x1600. Comparée au Radeon HD 3870 X2, la GeForce GTX 280 est 12% plus performante en 1920x1200 alors que face au GeForce 8800 GTX, le gain atteint, toujours dans cette résolution, 52%.

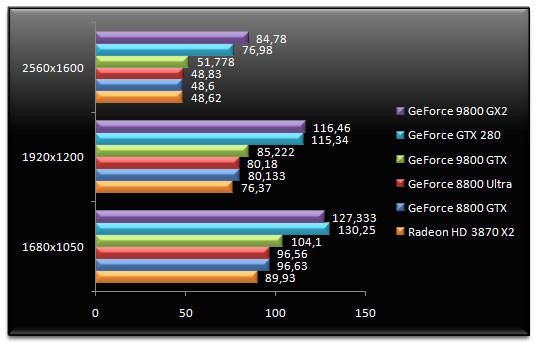

F.E.A.R. - v1.08

Ce bon vieux F.E.A.R. a du mal à départager GeForce GTX 280 et GeForce 9800 GX2. La nouvelle référence haut de gamme de NVIDIA fait en effet jeu égal avec la précédente solution basée, rappelons-le, sur deux puces graphiques. Face au GeForce 9800 GTX, le GeForce GTX 280 est cette fois-ci 65% plus rapide en 2560x1600. Quant au Radeon HD 3870 X2, il ne parvient pas à inquiéter la petite dernière de NVIDIA, ici nettement en tête.

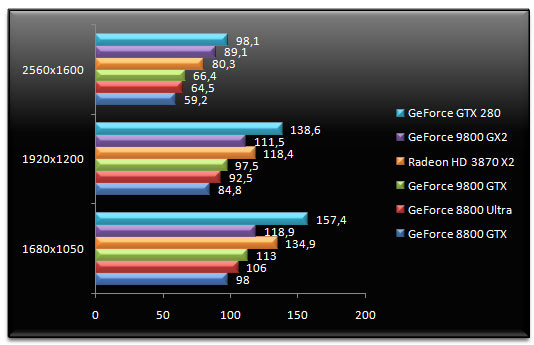

Half-Life 2 - Episode Two

Pour Half-Life 2 - Episode 2, ici testé avec notre propre démo, le GeForce GTX 280 reprend le lead, devant le GeForce 9800 GX2. En 2560x1600, le nouveau GeForce est respectivement 4% plus rapide que le GeForce 9800 GX2 et 35% plus performant que le Radeon HD 3870 X2. La dernière carte haut de gamme d'AMD talonnait pourtant les GeForce les plus rapides en 1680x1050 et en 1920x1200. Du reste, en 1680x1050, la Radeon HD 3870 X2 est plus rapide que le GeForce GTX 280.

Unreal Tournament 3 - v1.2 - War Serenity Bot

Avant d'entamer la seconde page de tests, un petit détour sous Unreal Tournament 3 s'impose. Alors qu'en 1680x1050 et en 1920x1200, le GeForce GTX 280 affiche à peu de choses près les mêmes performances que le GeForce 9800 GX2 ou le Radeon HD 3870 X2, le CPU semblant limiter nos cartes graphiques, la dernière carte de NVIDIA prend son envol en 2560x1600. Ici, ses performances sont 8% supérieures à celles du GeForce 9800 GX2 mais aussi 38% plus élevées que celles du Radeon HD 3870 X2 et 65% supérieures au GeForce 8800 GTX.

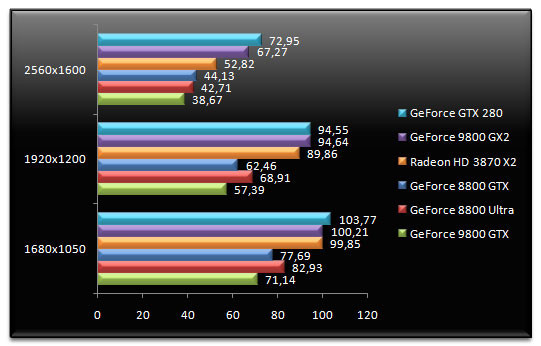

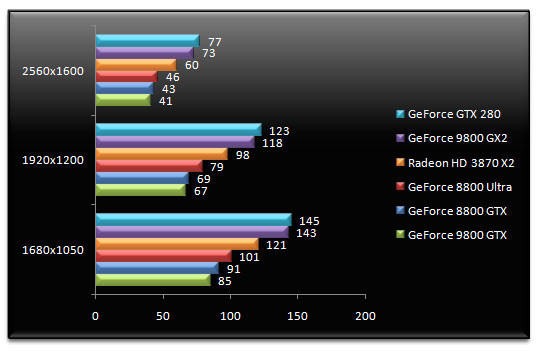

Company Of Heroes - v2.301 - DirectX 10

Après les FPS, nous nous essayons à un autre genre, le RTS avec Company of Heroes. Le GeForce GTX 280 est ici largement en tête, qu'importe la résolution. Face au GeForce 9800 GX2, le gain s'élève tout de même à 21% en 1920x1200 (résolution des écrans 24 pouces) alors que face au GeForce 8800 Ultra, la carte est 78% plus performante. Enfin, comparativement au Radeon HD 3870 X2, le GeForce GTX 280 se montre 49% plus performant.

World In Conflict - DirectX 10 - v1.0007

On reste dans les STR avec World In Conflict. Les observations formulées avec Company of Heroes restent valables puisque notre GeForce GTX 280 continue de mener la danse. En 1680x1050, la nouvelle référence de NVIDIA est 8% plus rapide que le GeForce 9800 GX2. Face au Radeon HD 3870 X2, la petite dernière de la firme au caméléon l'emporte une fois de plus (14% de gain en 2560x1600) alors que le GeForce GTX 280 est 37% plus rapide que le GeForce 8800 GTX en 1920x1200.

Crysis - DirectX 10 - v1.2, réglages très élevés

Jeu ou benchmark ? On ne sait guère... En attendant, Crysis, ici testé avec une démo enregistrée par nos soins, met à rude épreuve nos cartes graphiques et la GeForce GTX 280 affiche ici les meilleures performances... avec la GeForce 9800 GX2. Dans les résolutions courantes, le GeForce GTX 280 est même très légèrement en retrait face au GeForce 9800 GX2. En 1920x1200, la carte est tout de même 38% plus rapide que le Radeon HD 3870 X2 et 53% plus rapide que le GeForce 9800 GTX. En passant à la résolution la plus extrême de 2560x1600, le GeForce GTX 280 lamine la concurrence. La carte se montre en effet 44% plus rapide que le GeForce 8800 Ultra alors qu'elle est presque trois fois plus rapide que le GeForce 9800 GX2. La raison de ce grand écart ? La quantité de mémoire vidéo qui ne permet pas à Crysis de s'exécuter convenablement en 2560x1600 sur les cartes munies de seulement 512 Mo. Avec 1024 Mo de mémoire vidéo, la GeForce GTX 280 est armée pour ce type de résolution avec les jeux DirectX 10. Reste que les 14 images par seconde relevées ne permettent hélas pas de jouer avec fluidité.

BioShock - DirectX 10 - v1.1

Basé sur le moteur graphique Unreal Engine 3, et testé avec notre propre démo, Bioshock donne une petite préférence au GeForce 9800 GX2 ici légèrement plus rapide que le GeForce GTX 280. Mais comparé aux autres cartes, le GeForce GTX 280 est plus que capable... En 1920x1200, la dernière référence de NVIDIA est 35% plus rapide que le GeForce 9800 GTX. Comparé au Radeon HD 3870 X2, la GeForce GTX 280 est 51% plus performante.

Call Of Duty 4 - v1.6

Avec Call Of Duty 4, le GeForce GTX 280 est largement en tête avec des performances parfois 24% supérieures à celles du GeForce 9800 GX2. Mieux, le GeForce GTX 280 est, en 2560x1600, 22% plus rapide que le Radeon HD 3870 X2 et face à son prédécesseur, le GeForce 8800 GTX, le nouveau GeForce se montre 66% plus véloce.

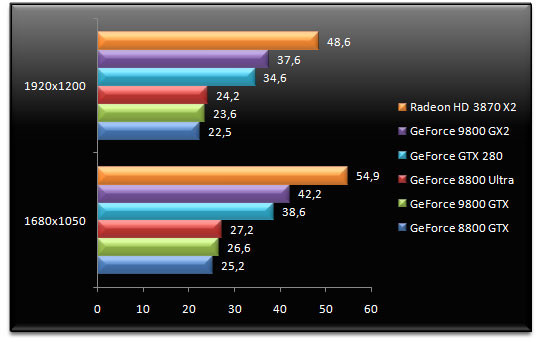

Call Of Juarez - DirectX 10

Call Of Juarez plébiscite le Radeon HD 3870 X2 qui est ici plus rapide que les cartes NVIDIA. En 1920x1200, la solution double puce graphique d'AMD est 40% plus rapide que le GeForce GTX 280. Ce dernier affiche d'ailleurs des performances légèrement inférieures au GeForce 9800 GX2. Mais face au GeForce 8800 GTX, la carte offre des performances 53% supérieures.

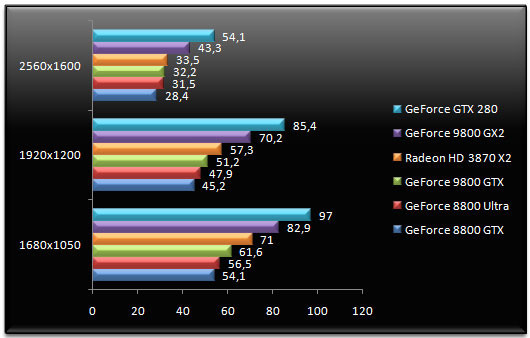

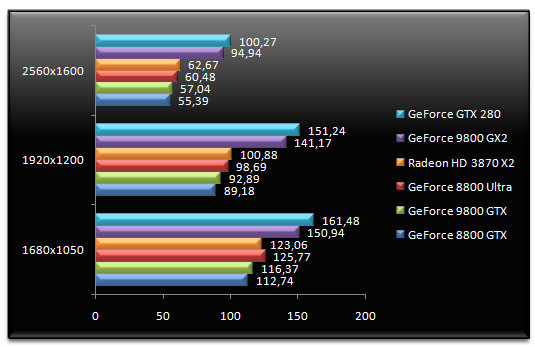

Call Of Duty 4 - v1.6 - FSAA 4x & AF 16x

Retour sous le dernier opus de Call Of Duty, toujours testé avec une démo concoctée par nos soins, où nous activons cette fois l'anticrénelage et le filtrage anisotropique. Le GeForce GTX 280 affiche ici sa suprématie et la carte fait nettement mieux que ses concurrentes. En 2560x1600 elle pulvérise le GeForce 9800 GX2 qui chute du reste à la dernière place. En 2560x1600, le bébé de NVIDIA est 46% plus performant que le Radeon HD 3870 X2 et surpasse le GeForce 9800 GTX grâce à des performances 65% plus élevées.

F.E.A.R. v1.08 - AA 4x AF 16x

Dans les mêmes conditions, le GeForce GTX 280 mène toujours la danse sous F.E.A.R. avec toutefois un avantage plus réduit. En 1920x1200, la dernière carte de NVIDIA est 4% plus rapide que le GeForce 9800 GX2 et 25% plus rapide que le Radeon HD 3870 X2. Face au GeForce 8800 Ultra, le gain de performances atteint, en faveur du GeForce GTX 280, 55%.

Half-Life 2 : Episode Two - AA 4x AF 16x

Half-Life 2 : Episode Two confirme les bonnes prestations du GeForce GTX 280 lorsque les fonctions de filtrage sont activées. La carte devance systématiquement le GeForce 9800 GX2 alors qu'elle se montre 50% plus rapide que le Radeon HD 3870 X2 en 1920x1200 et 70% plus véloce que le GeForce 8800 GTX !

World In Conflict - DirectX 10 - v1.0007 - AA 4x AF 16x

Le jeu de stratégie World In Conflict amplifie nos constatations précédentes puisque la mise en place de l'anticrénelage 4x et du filtrage anisotrope 16x propulsent le GeForce GTX 280 largement en tête. En 1920x1200, la carte est 35% plus rapide que le Radeon HD 3870 X2 alors que cet écart se creuse en 2560x1600 où la dernière puce de NVIDIA est 3 fois plus rapide ! Il faut dire que la carte est aidée par sa généreuse quantité de mémoire vidéo et face au GeForce 8800 GTX, les performances du GeForce GTX 280 sont 38% meilleures en 2560x1600.

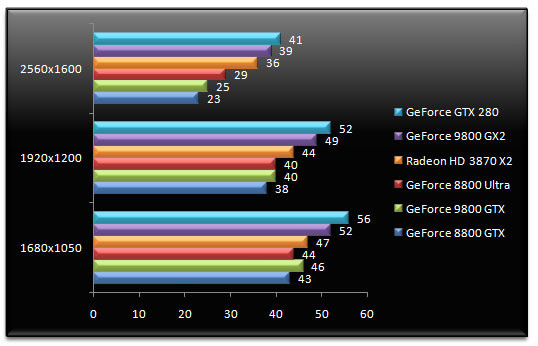

Enemy Territory : Quake Wars - v1.4 - AA 4x - AF 16x

On termine avec Quake Wars, avec l'activation des diverses fonctions de filtrage proposées depuis le menu du jeu. Pas de changement, le GeForce GTX 280 reste en tête et confirme ses très bonnes prestations en matière de filtrage. Visiblement les optimisations des unités ROP sont bien réelles puisque la dernière puce de NVIDIA est 9% plus rapide que le GeForce 9800 GX2 en 1680x1050. La comparaison avec le GeForce 8800 GTX fait toujours mal à ce dernier, l'écart de performance atteignant 61% en 2560x1600. Dans cette résolution, le GeForce GTX 280 fait toujours mieux que le Radeon HD 3870 X2 avec un score 13% supérieur.

Conclusion

Pour concocter le GeForce GTX 280, NVIDIA s'est largement appuyé sur l'architecture unifiée du GeForce 8 tout en rajoutant un certain nombre d'unités de traitement puisque l'on passe de 128 à 240 processeurs de flux. Pour faire face à cette hausse du nombre de cœurs de traitement, NVIDIA a dû revoir la structure de la puce alors que les ingénieurs de la firme ont amélioré nombre de petites choses qui, mises bout à bout, contribuent à augmenter l'efficacité et la puissance de la puce. Et, cerise sur le gâteau, ces améliorations sont non seulement sensibles en 3D mais également efficaces lorsque la puce est utilisée pour des calculs parallèles, un usage qui semble être plus concret aujourd'hui pour le grand public avec l'avènement d'applications comme Folding@Home ou Badaboom, des logiciels qui utilisent la puce graphique plutôt que le CPU pour accomplir leurs tâches. Pour le reste, si l'on regrette le choix de ne prendre en charge que DirectX 10, au détriment de DirectX 10.1, on salue en revanche la prise en charge de la double précision pour ce qui est des calculs ou encore l'arrivée d'un contrôleur mémoire 512 bits pour une bande passante tout simplement monstrueuse.

Reste que comme avec le G80 à son lancement, NVIDIA se montre relativement conservateur dans ses choix technologiques. La firme se cantonne en effet à une finesse de gravure en 65nm alors que côté mémoire, la carte n'est équipée que de GDDR3 quand les prochaines Radeon HD 4870 de son rival AMD devraient être dotées de GDDR5, une mémoire certes plus onéreuse mais aussi beaucoup plus rapide. Tout simplement énormissime, avec ses 1,4 milliards de transistors, la puce qui anime le GeForce GTX 280 s'affiche comme la puce graphique la plus performante de cette fin de printemps 2008. Deux fois plus rapide qu'une GeForce 8800 GTX en moyenne, la GeForce GTX 280 devance fréquemment le GeForce 9800 GX2 qui embarquait rappelons-le deux puces graphiques. Les résultats sous Crysis sont certes un peu décevant, le GeForce 9800 GX2 faisant mieux que la petite dernière, mais l'on notera qu'en 2560x1600, le gigaoctet de mémoire vidéo de la carte permet d'afficher des performances certes insuffisantes pour jouer mais tout de même 3,5 fois supérieures au GeForce 9800 GX2 et ses 512 Mo de mémoire vidéo.

Annoncé à un prix public conseillé de 549 euros TTC (données communiquées par NVIDIA), la GeForce GTX 280 est à n'en pas douter la nouvelle référence en matière de puissance 3D ultime ! En attendant pourquoi pas une version gravée en 55nm de la puce avec de la mémoire GDDR5 ?

- Venez discuter de cet article dans le forum