Le printemps dernier les GeForce3 nous avaient été présentées et en septembre ce fut au tour des modèles Titanium. Aujourd'hui, NVIDIA introduit sa nouvelle génération de processeur graphique avec la gamme GeForce4 et en particulier le modèle que nous testerons plus spécifiquement : le GeForce4 Ti4600.

Une très grande carte...

Pour ce test, nous avons bien évidemment reçu un modèle estampillé NVIDIA, les fabricants n'étant pas encore tout à fait prêts. Cette carte un peu spéciale ne peut donc pas servir de référence absolue en matière de conception générale et d'overclocking.

Une fois la Ti4600 reçue et sortie de sa boîte, on peut dire qu'elle fait forte impression : elle est énorme ! Rien à voir avec les cartes auxquelles NVIDIA nous avait habitué. La présence de 128 Mo de mémoire et de trois connecteurs externes n'est bien sûr pas étrangère à cette taille surprenante, mais on reste malgré tout impressionné.

A titre de comparaison, nous avons fait figurer la GeForce4 Ti4600 à côté d'une GeForce3 Ti200 Leadtek et d'une ATI All-In-Wonder Radeon. Dans un cas comme dans l'autre, les concurrentes ont l'air minuscules ! Il faut dire que la Ti4600 mesure près de trois centimètres de plus que la Ti200 en largeur et presque un centimètre de plus en hauteur.

... Mais d'apparence classique

Si l'on regarde plus en détails cette Ti4600, quelques petites choses sont d'ores et déjà remarquables. La présence du ventilateur NVIDIA frappe évidemment au premier coup d'oeil, mais c'est bien davantage l'absence de refroidisseurs sur les puces mémoire qui finalement étonne son monde. Il faut dire que par rapport au GeForce4, les mémoires restent incroyablement froides même après plusieurs heures de travail intense !La raison de ces basses températures est à chercher dans la nouvelle conception de ces mémoires qui prennent la forme de puces FBGA. Elles sont au nombre de huit sur l'ensemble de la carte pour un total de 128 Mo de mémoire mais surtout elles sont capables de fonctionner à 2.8ns. ! Une sacrée performances si nous comparons ce chiffre au 3.8ns. des pourtant récentes GeForce3 Ti500. Enfin, sachez que cette mémoire est maintenant en 128bits afin de garantir des échanges toujours plus rapides.

Le reste est plus classique et les trois connecteurs externes étaient déjà bien souvent présents sur les GeForce3, à ceci près qu'il est maintenant possible d'utiliser deux sorties simultanément à la manière du TwinView des GeForce2 MX. La puce en charge de la sortie TV est elle-aussi une habituée des cartes nvidia puisqu'il s'agit d'un modèle Conexant tout ce qu'il y a de plus conventionnel.

Caractéristiques techniques

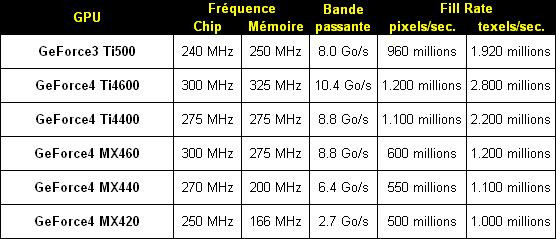

Avant d'attaquer plus avant ce test, et afin de bien situer les choses il convient de faire un rapide tour d'horizon des caractéristiques de cette Ti4600 et tant qu'à faire de toute la gamme des nouvelles GeForce4. A titre de comparaison nous avons aussi fait figurer les données du dernier modèle en date de chez NVIDIA : la GeForce3 Ti500.

Avec de telles chiffres le GeForce4 semble finalement n'être qu'une nouvelle mouture du GeForce3. D'ailleurs d'autres chiffres nous invitent à penser en ce sens : c'est ainsi qu'il est toujours gravé en 0.15 microns, qu'il contient assez peu de transistors supplémentaires (63 contre 57 millions) et que le nombre de pixel shader est le même (un pour le GeForce3 comme pour les GeForce4). NVIDIA a cependant pris soin de ne pas s'arrêter à ces quelques chiffres et d'intégrer quelques nouveautés comme une seconde unité de vertex shaders et surtout de nouvelles fonctions que nous allons maintenant détailler.

Lightspeed Memory Architecture II

Derrière ce nom que l'on connaît depuis la sortie de la GeForce3, se cache les différentes optimisations de la précieuse bande passante mémoire introduites dans les différents chip 3D NVIDIA.La bande passante mémoire a toujours été la bête noire des fabricants de chips graphiques, qui sont capables de produire des chips de plus en plus rapide mais qui ont souvent été bridés par la bande passante mémoire. L'exemple le plus frappant est certainement celui de la GeForce 1, sortie d'abord en version SDRAM puis en version DDR, ce simple changement de mémoire avait donné un coup de fouet remarquable aux performances des cartes GeForce 1.

Depuis lors, les fabricants procèdent tous de la même manière en associant chacun de leur nouveau chip à cette mémoire DDR et en choisissant des puces toujours plus rapides. Toutefois, les deux plus grands du chip 3D que sont ATI et NVIDIA essayent désormais à chaque sortie d'introduire de nouvelles technologies pour économiser cette bande passante.

Le GeForce 4 ne déroge pas à la règle et NVIDIA nous propose avec le Light Speed Memory Architecture II des améliorations significatives que nous allons maintenant détailler. Avant de commencer sachez que nous ne reviendrons pas sur les technologies Lossless Z-Compression et Z-Occlussing qui étaient déjà présentes sur le GeForce3 et qui le sont toujours avec le GeForce4.

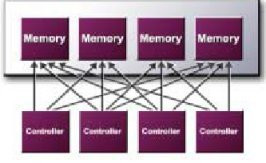

Crossbar Controler

Il faut en fait détailler un peu plus les choses. Le Crossbar est composé de quatre unités indépendantes (deux seulement pour le GeForce4 MX) capables de traiter chacun des blocs de 64 bits pour un total de 256 bits. C'est cette division en quatre unités qui est la clef d'une meilleure gestion de la mémoire. En effet la tendance actuelle est à une plus grande précision dans les scènes 3D. Les personnages et objets sont plus complexes et comportent donc de plus en plus de petits éléments.

Dans ses documentations techniques NVIDIA prend l'exemple certes excessif mais bien compréhensible, d'un triangle d'une taille de 2 pixels représentés en "couleurs vraies" (32 bits). L'ensemble des données couvrant la définition de ce triangle est donc de 64 bits (2*32) et oblige un déchet de 192 bits pour un contrôleur classique. Les quatre modules du Crossbar évitent donc ce gâchis tout en permettant de traiter 256 bits de données par cycle d'horloge en les groupant.

Quad Cache

Le Quad Cache est un nouveau sous-système de mémoire cache introduit par NVIDIA au niveau du contrôleur mémoire du GeForce4. Comme son nom l'indique, le Quad Cache, regroupe quatre caches mémoires capables de stocker une petite quantité d'informations qui sera accessible presque instantanément.Mais l'avantage de ces Quad Cache est qu'ils sont optimisés pour des taches bien précises : l'un se charge des primitives, un autre se charge des vertex, un troisième des textures et le dernier est dédié aux pixels. Chacun de ces caches stockent des données ou des résultats obtenus après avoir été calculé par le GeForce4. Si pendant la phase de calculs de la prochaine image le GeForce4 a besoin à nouveau de ces informations, il pourra directement aller les chercher dans les Quad Cache. Avec le GeForce3 par exemple il aurait été nécessaire d'aller chercher ces données dans la mémoire de la carte (moins rapide que le cache) ou encore de recalculer certains résultats qui n'auraient pas été sauvegardés.

Pour illustrer ce principe prenons un exemple simple, le calcul d'une image d'une scène 3D sur 1280*1024 obtenu par la formule suivante :

1280*1024*(16 bytes + 32 bytes)*2.5*2 = 315 millions de bytes / image

Ces chiffres correspondent respectivement à : le nombre de pixels en horizontal * le nombre de pixels en vertical * (rendu basique + nombre bytes textures par pixel) * la profondeur * par le Full Scene Antialising. Le Quad Cache dédié aux textures permet de diviser le nombre de bytes associés aux textures par pixel par 4, on obtient alors avec le Quad Cache le calcul suivant :

280*1024*(16 bytes + 8 bytes)*2.5*2 = 157 millions de bytes / image

D'où une réelle économie de bande passante !

Auto Pre-Charge

Comme vous le savez certainement, les informations contenues dans n'importe quel type de mémoire sont toujours organisées de la même manière, un peu sous la forme d'un tableau qui contient donc : des lignes, des colonnes et des bancs.Le gros "problème" de cette organisation est qu'elle peut être synonyme de perte de performances si une information contenue dans un autre banc que celui activé actuellement par le chip est demandée. En effet à chaque changement de banc, la mémoire se doit de fermer le banc actuellement activé et ensuite d'activer le nouveau banc pour chercher la ligne et la colonne correspondant à l'information recherchée.

L'ensemble de ces informations prend environ 10 cycles d'horloges mémoires puisqu'il faut ajouter à cela le fait que chaque banc qui va être fermé doit être "pré-chargé". De plus ce "pré-chargement" est également nécessaire pour réactiver un banc. Pendant que ces opérations se déroulent au niveau de la mémoire, le chip graphique attend sans rien faire que la mémoire soit prête.

La fonction Auto Pre-Charge permet au GeForce4 de demander à un banc mémoire qui n'est pas encore utilisé de se "pré-charger". Le GeForce4 prédit ainsi un éventuel changement de banc et peut alors gagner de précieux cycles d'horloges puisque seule la phase d'activation serait encore nécessaire, mais cette dernière ne prendrait que "2 ou 3 cycles d'horloges" selon le type de mémoire utilisé.

Fast Z-Clear

Un peu à la manière d'ATI et de son Hyper Z-II, NVIDIA a introduit dans le GeForce4 une technologie permettant d'effacer plus rapidement le tampon Z, c'est à dire d'inscrire des 0 à la place des anciennes coordonnées dans chaque emplacement du tampon Z. Selon NVIDIA, sa technologie "Fast Z-Clear" permettrait d'augmenter la rapidité d'affichage jusqu'à +10% sans aucune perte de qualité bien entendu.

Avec le GeForce4, NVIDIA va encore plus loin en nous proposant le "nFinite FX II". Ce dernier reprend toutes les fonctionnalités du "nFinite FX" premier du nom (texture 3D, pixel shaders, vertex shaders, shadow buffers...) et ajoute en plus une deuxième unité de calcul vertex shaders et étend quelques peu les capacités des pixels shaders. Ces ajouts offrent la possibilité aux développeurs de créer des effets 3D encore plus impressionnants qu'auparavant.

L'une des possibilités offertes grâce à ces deux unités de calcul vertex du GeForce4, est celle de la création d'un effet de fourrure. Qui n'est jamais resté admiratif à la vue du lion dans le film Jumanji ou encore des cheveux d'Aki dans Final Fantasy ?

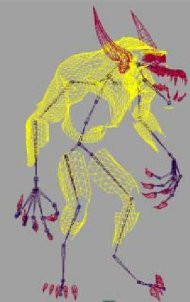

Pour nous démontrer la puissance des deux vertex shaders du GeForce4 NVIDIA nous propose un démo technologique mettant en scène un loup-garou qui met justement en avant ce fameux effet de fourrure que nous allons maintenant étudier. Commençons si vous le voulez bien par une partie d'histoire afin de voir les évolutions qui ont pu être apportée pour réaliser ce fameux effet de fourrure.

Le Fussy Bear

L'un des premiers effets de fourrure a été créé pour rendre en 3D un ours en peluche nommé "Fussy Bear". Cet ours a été réalisé grâce à une texture 3D par les scientifiques de l'institut technologique de Californie. Pour information sachez qu'à l'époque (en 1989) il a fallu pour calculer une seule image de cet ours en peluche, 2 heures de calculs effectués par 16 Processeurs !

Le Fussy Bunny

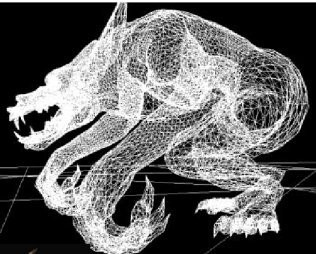

Début 2001, des chercheurs de l'université de Princeton et des ingénieurs de Microsoft se sont penchés sur la possibilité de mettre au point un effet de fourrure qui pourra être rendu en temps réel.Pour cela les ingénieurs se sont basés sur la création de surfaces concentriques également appelées "coquillages" afin de créer la forme globale de l'objet. Sur ces mêmes surfaces étaient ensuite plaquée une texture 3D plus ou moins prononcée en fonction de la taille et de la densité de la fourrure que l'on souhaitait obtenir. Pour finir le rendu de l'objet, une texture spéciale et quelques ajustements géométriques étaient appliqués. Cela permettait notamment d'afficher les éventuels "poils" dépassant de la surface globale de l'objet. Le rendu 3D ainsi obtenu produit un effet de fourrure très réussi, accompagné d'une silhouette très réaliste.

Cette technologie a pu être directement appliquée au GeForce 256 qui offrait une vitesse d'affichage comprise entre 12 et 23 images/seconde avec le seul effet de fourrure appliqué au lapin. Lors de la création de cette technologie, l'université de Princeton et Microsoft ont clairement indiqué que les futurs effets de fourrure, encore plus réalistes, utiliseront les technologies avancées que sont les vertex shaders et des pixels shaders programmables... C'est donc là qu'intervient le GeForce4.

Le WolfMan de NVIDIA

Pour obtenir des mouvements réalistes lorsque le loup-garou bouge, NVIDIA a composé son modèle 3D de 62 "os". Ces "os" sont définis par des vertex qui provoqueront automatiquement des déformations au niveau des surfaces concentriques et donc au niveau de la peau et de l'effet de fourrure appliqué au loup-garou. Ceci permet d'obtenir des animations particulièrement pointues et permet de simplifier le travail des développeurs qui n'ont alors qu'à définir les os et leurs mouvements pour que l'animation dans son ensemble, soit ensuite calculée par le chip graphique.

Grâce aux améliorations apportées au niveau des Pixels Shaders par rapport au GeForce3 (Pixels Shaders 50% plus performants), le GeForce4 est capable de créer un effet de lumière dit "anisotropic" tout en offrant une animation non saccadée. Cet effet complexe se traduira dans la démo technologique par un rendu différent de l'effet de fourrure calculé en fonction de la position, de l'angle et de l'intensité des sources lumineuses.

Le GeForce4 offre donc aux développeurs la possibilité de créer des effets 3D encore plus réalistes. Malheureusement il est difficile de savoir dans combien de temps toutes les capacités avancées du GeForce4 seront exploitées par les développeurs, ces derniers n'utilisant toujours pas toutes les fonctionnalités du GeForce3...

Pour finir avec le nFinite FX II voici un petit tableau récapitulatif concernant l'évolution de l'effet de fourrure dans le temps. Un exemple simple qui nous permet de nous rendre compte assez facilement que le monde des technologies 3D évolue à vitesse grand V !

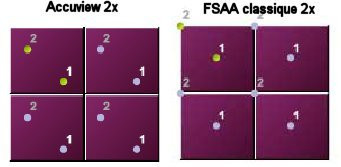

A la différence de certains chips, le GeForce4 utilise un anti-aliasing de type Multisampling. Cette forme d'anti-aliasing permet à l'aide de l'utilisation de pixels dit "virtuels" de calculer une couleur particulièrement adaptée pour chaque pixel dédié à l'effet d'anti-aliasing et ce afin d'obtenir des objets aux bords/courbes particulièrement lisses. Cette technologie est réputée pour être particulièrement efficace mais demande beaucoup de puissance au chip graphique.

L'Accuview

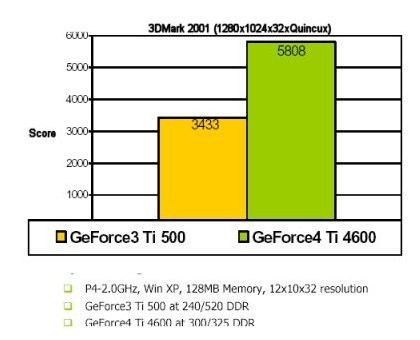

Pour éviter de rencontrer de grosses pertes de performances en utilisant ce type d'anti-aliasing, NVIDIA a dédié une partie de son chip à la gestion "matériel" de cette fonction, une nouvelle technologie baptisée "Accuview" qui s'applique indifférement au mode FSAA 2x, Quincunx, 4x (voir détails dans notre test du GeForce3) et au nouveau mode 4XS propre au GeForce4.L'Accuview se résume à la présence de chemins par lesquels transites les informations relatives à l'anti-aliasing. Selon NVIDIA, ces chemins seraient capables de faire passer un nombre élevé d'informations et utiliseraient une technologie permettant d'économiser la précieuse bande passante mémoire. On notera également qu'un pipeline est dédié au FSAA pour éviter un maximum les pertes de performances. Le Benchmark suivant permet de se faire une idée du gain de performances ainsi obtenu :

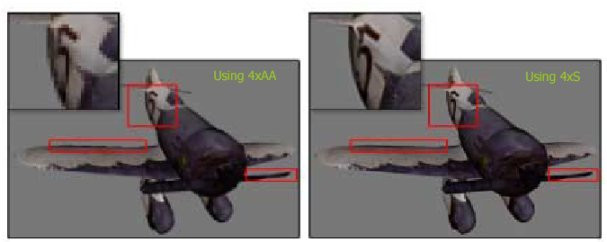

Le FSAA 4XS

Mais l'Accuview ne se résume pas seulement à une réduction des pertes de performances, puisque a travers cette technologie NVIDIA a réussi à améliorer les positions des texels (le plus petit élément constitutif d'une texture - cf. schéma) lors de l'utilisation de l'anti-aliasing en mode 2x ou Quincunx, d'où une meilleure efficacité du FSAA et donc une meilleure qualité d'affichage.

Comme nous l'avons mentionné auparavant, le GeForce4 propose également un nouveau mode de FSAA baptisé 4XS. Ce nouveau mode permet de déterminer avec précision la couleur des pixels à afficher en fonction de leur position dans la scène 3D : soit ils font partie de l'objet, soit ils n'en font pas parti. Une fois cette étude effectuée, le GeForce4 se chargera "de calculer" la couleur finale du pixel grâce à l'ensemble des pixels adjacents. Le mode 4XS permet de faire référence à 50% de pixels-adjacents de plus que les autres modes FSAA, ce qui permet de déterminer avec encore plus de précision la couleur de chaque pixel qui seront utilisés pour créer l'effet anti-aliasing.

Le FSAA 4XS permettrait ainsi d'offrir une qualité d'affichage supérieure aux autres modes, avec des bords/courbes plus lisses et des textures qui ne sont plus délavées après l'application du FSAA, comme ce fut les cas avec les autres modes.

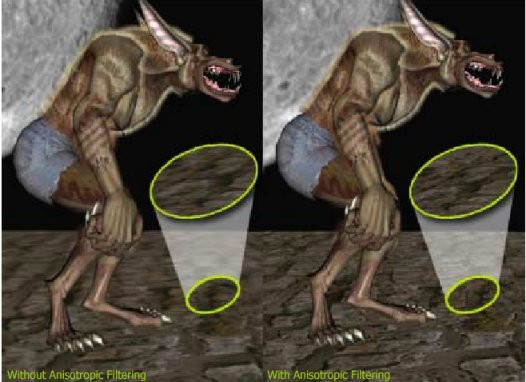

Pour finir, sachez également que l'Accuview supporte l'Anisotropic Filtering sous les applications OpenGL. Nous ne reviendrons pas sur cette technologie qui permet d'éviter les effets de flou trop prononcés lors de l'application des filtrages Tri-Linéaire (particulièrement visible sur certaines "grosses" surfaces, comme par exemple l'affichage d'un sol lointain dans un Quake-Like) , puisqu'elle était déjà présente sur le GeForce3.

Video Processing Engine

Ces dernières années, est apparu une nouvelle norme destinée à la retransmission télévisée, la norme HDTV pour High Definition TeleVision (Télévision Haute Définition). Il est possible grâce à elle de produire une image plus fine en doublant le nombre de ligne de trame. Les États-Unis, l'Europe, et le Japon ont tous développé leur propre système HDTV, tous différents et mutuellement incompatibles. Les principes de base de la HDTV en terme de scanning, luminance et chrominance sont similaires aux systèmes existants. Les trois formats ont en commun le rapport 16:9 privilégié par rapport au 4:3, ce qui les rend plus proches du format utilisé pour les films de cinéma (enregistrés sur de la pellicule 35 mm).La différence entre les formats NTSC (format en vigueur aux Etats-Unis et au Japon) et HDTV est simple. Le NTSC possède une seule résolution de 720x540i pixels ("i" pour entrelacés), le HDTV en possède, lui, 26. Les créateurs de la HDTV ont choisi trois résolutions parmis ces 26 comme étant le standard pour la télévision en direct. Les résolutions choisies sont le 720x540p ("p" pour progressif) avec deux fois plus de pixels que son équivalent NTSC, un format 4x3 et 16x9, le 1280x720p (format 16x9) et le 1980x1080i(format 16x9). A noter que la Xbox est compatible avec ces 3 formats après l'achat du HD pack.

La première caractéristique du Video Processing Engine contenu dans le GeForce 4 concerne sa capacité à décoder le format HDTV. Pour cela, NVidia s'est associé à Ravisent (TV haute définition). Le logiciel Cinemaster HDTV de Ravisent quand il est combiné avec un GeForce 256 décode tous les formats HDTV en qualité optimum à 60fps en format progressif 720 et 30 fps en format entrelacé 1080 sur n'importe quel processeur central actuel.

En comparaison, la RADEON? 8500 est capable de décoder l'ensemble des formats HDTV avec utilisation réduite du CPU et une gestion directe des écrans analogiques et numériques haute définition. La RADEON? 8500 atteint cette capacité de décodage via ses fonctions "motion compensation" et iDCT sans avoir recours à des ressources matérielles externes.

En France, il est clair que pour le moment le HDTV n'intéresse que peu de monde. Mais cette partie du chip destinée au décodage HDTV sait également décompresser les fichiers MPEG2 de manière semi matérielle. Elle prend en charge le motion compensation en sus de la classique conversion YUV vers RGB et du Video Scaling. NVIDIA rattrape ici une partie de son retard sur l'ATI Radeon 8500 qui décode le MPEG2 de manière 100% matérielle.

Le décodage en semi-hardware de videos MPEG n'est toutefois qu'un petit plus à l'heure ou il est possible avec un processeur puissant et une carte vidéo n´accélérant pas la décompression matérielle du MPEG2 de lire des DVD en s'équipant d'un bon logiciel (Cinemaster est à l'heure actuelle le meilleur pour la lecture DVD en software).

De plus nos tests nous ont montré que le GeForce4 ne parvenait pas à atteindre les performances des ATI Radeon en la matière. Lorsque l'accélération hardware est désactivée, c'est environ 30-35% du processeur (un Athlon 1.33GHz) qui était occupé. Une fois l'accélération activée le gain était bien réel (l'occupation chutait alors à 15-20%) mais encore inférieur à ce qu'offre une ATI Radeon (entre 10 et 15% d'occupation CPU).

nView

Sous ce nom bien peu évocateur, se cache la nouvelle technologie multi-écrans mise au point par NVIDIA. Auparavant le concepteur californien avait élaboré le TwinView qui devait permettre de rejoindre Matrox sur son terrain de prédilection : le support du multi-écran. Hélas et malgré des atouts indéniables, cete technologie n'était pas encore assez riche de fonctions et posait parfois quelques problèmes. La gamme des GeForce4 intègre donc la technologie supérieure : le nView.Cette nouvelle technologie peut se caractériser par plusieurs points. En premier lieu, elle dispose de deux réels RAMDACs (350MHz) indépendant l'un de l'autre afin de pouvoir spécifier des paramètres d'affichage différents sur les deux périphériques connectés. Il convient aussi de noter que NVIDIA a intégré un nouveau composant dont nous avons déjà parlé précédemment, le VPE (Video Processing Engine) qui prend une partie de son sens grâce au nView. Enfin le nView offre plusieurs fonctions "logicielles" pour faciliter l'utilisation du multi-écrans.

Un "assistant" de configuration

L'assistant n'est rien de plus qu'un outils permettant de mettre en place le plus simplement du monde le nView selon le profil de chacun. On y choisit donc une à une toutes les options accessibles par les menus, toutes les options que nous allons détailler maintenant.Le multi-affichage peut se faire sur deux écrans et ce quelque soit leur nature pourvu que vous disposiez de la connectique adéquate : écran cathodique, écran LCD ou téléviseur. Il est alors possible d'activer plusieurs modes de fonctionnements mais rien de bien révolutionnaire à ce niveau : mode clone, prolongement horizontal ou prolongement vertical.

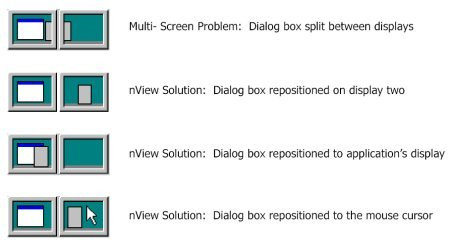

Pour faciliter l'utilisation du multi-affichage, NVIDIA a mis au point un petit outil paramétrable afin de choisir la position des menus contextuels qui peuvent parfois poser un petit problème s'ils sont à la limite entre les deux écrans. Cette élégante solution permet de choisir si les menus seront "attachés" à la fenêtre de l'application, au curseur de la souris ou à un écran donné.

Les bureaux multiples

Très répandu sous Linux, le bureau multiple l'est encore assez peu dans le monde Windows. Malgré de nombreuses initiatives seuls quelques rares utilisateurs exploitent réellement ce genre de fonctions. NVIDIA tente à son tour de faire connaître cette technique via son "Desktop Manager" qui permet de créer jusqu'à 32 bureaux différents.

De nombreux paramètres sont configurables afin d'adapter ces nouveaux bureaux à votre style personnel. Il sera par exemple possible de définir des touches de raccourcis pour différentes actions, d'accélérer la "maximisation" des fenêtre Windows, de rendre leur contenu transparent pendant leur déplacement, d'activer une fonction "zoom" pour voir certains détails...

Configuration de test

Afin d'évaluer les performances de ce GeForce4 Ti4600 nous avons employé notre habituelle batterie de tests, et nous avons ensuite comparé dans la mesure du possible les résultats avec ceux obtenus en employant des cartes concurrentes comme une Radeon 8500 et surtout une GeForce3. Nous avons opté pour une GeForce3 "de base" car elle représentait elle-aussi en son temps une nouvelle gamme, ce qui nous permettra de voir le chemin parcouru par NVIDIA pendant l'année passée.

Avant d'attaquer à proprement parler les tests et pour être tout à fait complet, il est nécessaire de rappeller, même brièvement, la configuration que nous avons utilisé :

- Asus A7M266

- AMD Athlon 1.33GHz

- 256Mo de mémoire DDR CAS2.5

- Disque dur 60GXP 40Go

- Windows XP

Associée aux Cartes Graphiques suivantes : ATI Radeon 8500 (pilotes v7.63), GeForce3 et bien sûr GeForce4 Ti4600 (pilotes v27.30).

Performances Direct3D

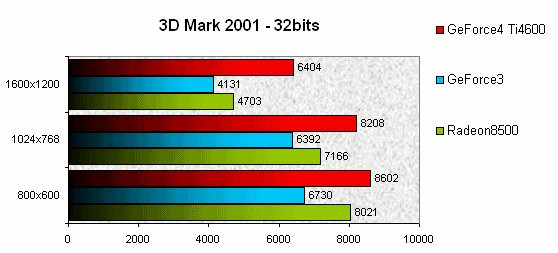

Malgré des optimisations de plus en plus évidentes de la part des différents constructeurs, l'incontournable du bench Direct3D, 3D Mark2001, permet encore de se faire une idée des performances offertes par les cartes. La confrontation entre nos trois cobayes tourne cependant rapidement à la démonstration de la part de la GeForce4.

La Radeon 8500 pourtant très performante à ce test, ne fait pas plus le poids que la GeForce3. Cette dernière n'affiche même pas en 1024x768, les performances de la GeForce4 en 1600x1200, c'est dire l'écart qui sépare les deux générations de Processeurs. D'autres tests sont cependant nécessaires puisque comme nous l'avons dit, les fabricants ont tendance à optimiser leurs cartes/pilotes afin d'être plus performants sous 3D Mark 2001.

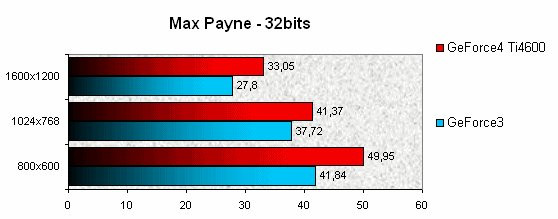

En partie basé sur le même moteur que les 3D Mark2001, Max Payne premet cependant de se faire une idée plus précise puisqu'il s'agit d'une application réelle et non d'une série de tests. Nous avons optés pour une scène bien connue, la séquence finale, pour mesurer les différences entre la GeForce3 et la GeForce4.

Les écarts ne sont pas énormes, mais restent à peu près constants, prouvant encore une fois la nette supériorité de la nouvelle gamme. On notera tout de même qu'aucune des deux ne permettait d'avoir un résultat parfaitement fluide en 1600x1200, même si la GeForce4 n'en était vraiment pas loin.

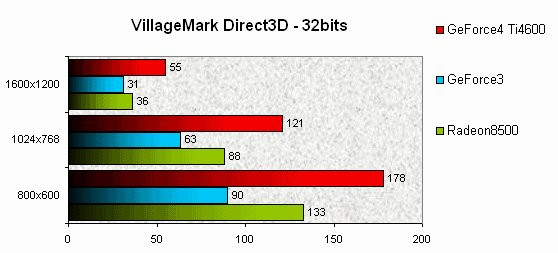

Pour finir, notre habituel VillageMark en mode Direct3D et à nouveau une comparaison intégrant la Radeon 8500 d'ATI. Cette dernière faisait forte impression lors de ce test puiqu'elle s'offrait le luxe de distancer très nettement toutes les GeForce3 comme on peut encore le lire ici (en 1024x768, la Radeon fait jeu égal avec la GeForce3 en 800x600).

On remarque également la réaction de NVIDIA qui n'a pas chômé pour rattraper son retard et le fait de fort belle manière avec la GeForce4. La petite dernière du californien se classe évidemment première quelque soit la résolution utilisée, et affiche même en 1600x1200 un score très proche de celui de la GeForce3 en 1024x768 !

Performances OpenGL

Après l'API mise au point par Microsoft, il est temps de tester cette GeForce4 en mode OpenGL, afin de compléter notre analyse.

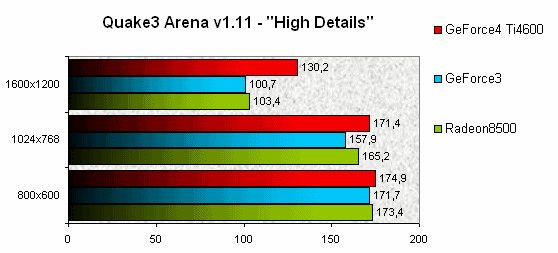

Quake3 Arena n'est plus à présenter et constitue, sans doute, le bench le plus employé à travers le Web. Evidemment et à la manière de 3D Mark 2001, il est la cible de toutes les optimisations de la part des différents constructeurs, mais comme il reste l'un des moteurs 3D les plus utilisés, il ne pouvait être absent de cette série de tests.

Accusant quelques peu son âge, Quake3 n'est plus tout à fait en mesure de mettre en évidence des différences entres les cartes à faible résolution lorsqu'aucun mode de Full Scene Anti-Aliasing n'est activé. Il faudra donc se contenter des résultats en 1600x1200 pour tirer une quelconque leçon. Alors que Radeon 8500 et GeForce3 font jeu égal, on voit que la GeForce4 se détache nettement avec près de 30fps. d'écart !

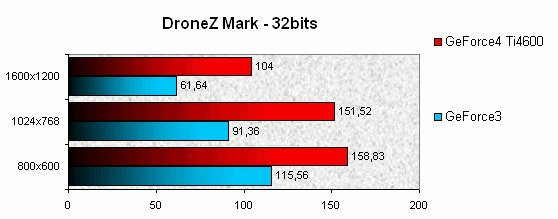

Avec le moteur du jeu de Fishtank, DroneZ, les résultats sont bien différents et la pauvre GeForce3 ne fait illusion bien longtemps. Même avec le simple 800x600, elle accuse près de 40fps. de retard et la montée en résolution ne change rien à l'affaire puisqu'en 1600x1200 on retrouve à peu de choses près les 40fps. d'écart.

Serious Sam 2, enfin, est, au même titre que DroneZ, plus significatif que Quake3 car plus réprésentatif de ce qui se fait aujourd'hui dans le monde du jeu vidéo. Les effets sont plus nombreux et la gourmandise du moteur bien plus évidente. Il est d'ailleurs intéressant de noter que les écarts entre GeForce3 et GeForce4 sous Serious Sam 2 sont très proches de ceux relevés avec DroneZ.

La petite dernière de NVIDIA se permet de reléguer son aïeul à plus de 30fps. en 800x600, par contre et contrairement aux tests sous DroneZ, l'écart ne fait que diminuer à mesure que l'on monte en résolution pour ne plus être que d'une dizaine d'images par seconde (fps.) en 1600x1200.

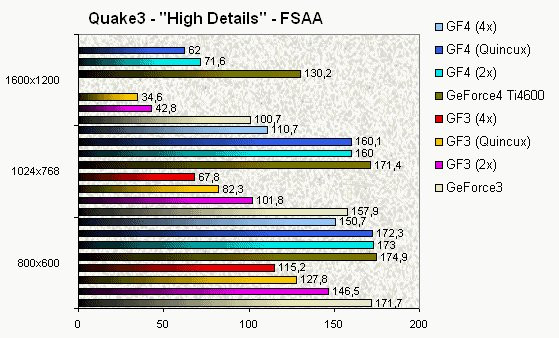

Full Scene Anti-Aliasing (FSAA)

Le FSAA n'est vraiment pas ce que l'on peut appeler une technique nouvelle, on en parle même depuis les c'est dire qu'il ne s'agit absolument pas d'une innovation du GeForce4. Il s'agit cependant d'une technique très gourmande qui met bien souvent à genoux nos Cartes Graphiques. Le GeForce3 intégrait un mode baptisé Quincux censé se rapprocher du FSAA 4X tout en garantissant les performances du mode 2X.Aujourd'hui NVIDIA va plus loin avec le mode 4XS censé apporter un rendu supérieur en terme de qualité au mode 4X. Le problème de la gourmandise de ce genres de procédés est cependant toujours d'actualité, même pour les possesseurs de GeForce3, il convient donc de voir dans quelle mesure le GeForce4 tire son épingle du jeu.

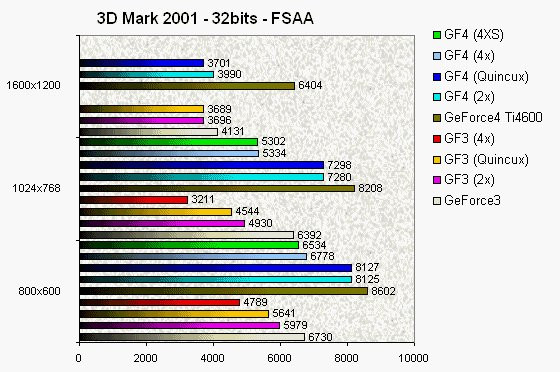

A l'aide de 3D Mark 2001, on voit assez nettement qu'en mode Direct3D, la GeForce4 bénéficie d'une optimisation tout à fait impressionnante. Sa gestion du Full Scene Anti-Aliasing est bien meilleure que celle de la GeForce3 et ce quelque soit la résolution ou le mode de FSAA utilisé. Alors qu'avec cette dernière, il était souvent difficile de pouvoir réellement exploiter cette technique, cela devient tout à fait possible maintenant.

En 800x600, la GeForce4 devance (ou presque) son aïeul même lorsqu'elle exploite le mode 4XS pourtant le plus gourmand ! Dans les autres résolutions si les écarts sont parfois moins significatifs, on remarque une constante : la baisse des performances consécutive à l'augmentation du niveau de FSAA (2x puis 4x...) est toujours nettement moins importante avec la GeForce4 qu'avec la GeForce3, preuve de l'excellent travail d'optimisation effectué par NVIDIA dans ce domaine.

Les conclusions des tests FSAA réalisés sous Quake3 sont pratiquement identiques aux précédentes. La GeForce4 est à nouveau nettement moins handicapée par l'augmentation du FSAA que sa consoeur. Ainsi, alors que la GeForce3 perd pratiquement 50% de son framerate par le passage au FSAA 2X en 1024x768, la GeForce4 ne perd dans le même temps qu'une dizaine d'images par seconde, se maintenant au-dessus des 160fps. !

La comparaison n'a finalement pas franchement lieu d'être entre les deux cartes, tant la GeForce4 est au-dessus. Elle permet même de conserver un framerate suffisant pour jouer en 1600x1200 avec le Quincux d'activé, alors que dans les mêmes conditions, la GeForce3 est tombée sous les 35fps.

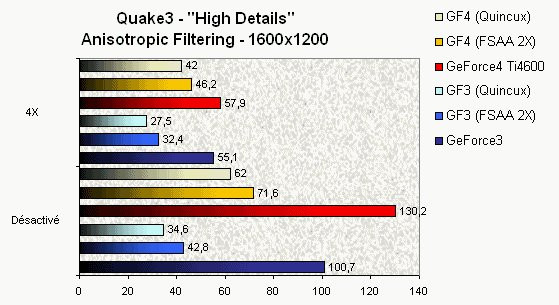

Filtrage Anisotropic

Le FSAA malgré ses nombreuses qualités dispose d'un défaut majeur : la création d'une sensation de floue que certains trouveront vraiment gênante. Pour y remédier il existe une technique simple, mais hélas très gourmande en ressources machines : le filtrage Anisotropic. Il permet, en schématisant, de rendre les zones floues plus nettes en marquant davantage leur relief.

Nous avons choisis de ne comparer que quelques résultats car nous pourrions rapidement crouler sous les graphiques sans que cela ne montre davantage de choses. Premier constat, l'activation des filtres anisotropic provoque une baisse dramatique du framerate. C'est particulièrement vrai avec nos tests en 4X mais l'est également en 2X.

La GeForce4 souffre toutefois beaucoup moins de cette activation et permet encore de conserver dans certains cas une fluidité suffisante. Malgré tout, il semble que le filtrage anisotropic soit la prochaine étape dans l'évolution de nos cartes graphiques. Pour le moment la perte de fluidité occasionnée ne se retrouve pas suffisement fort au niveau graphique pour en justifier l'activation... Mais ne doutons pas de ce que nous préparent les ingénieurs de NVIDIA.

Overclocking

Sans changer quoi que ce soit au système de refroidissement mis en place sur la carte, il nous a été possible de faire passer le processeur à 315MHz et la mémoire au chiffre hallucinant de 700MHz. Comme nous ne pouvons pas savoir si les modèles envoyés par NVIDIA étaient particulièrement performants ou si, au contraire, les produits des constructeurs seront capables d'aller plus loin, nous n'entreront pas davantage dans le détail... Il sera largement temps de voir de quoi il retourne lorsque les premières cartes arriveront.

Conclusion

Bien sûr la GeForce4 affiche des fréquences bien supérieures aux GeForce3 actuelles mais même lorsque les fréquences de fonctionnement sont égales la GeForce4 l'emporte, il est donc bien ici question d'optimisation et non simplement d'augmentation de fréquence. Pour la première fois, il est possible de jouer en activant les modes FSAA un peu n'importe comment : le jeu restera fluide !

De plus, NVIDIA a implémenté quelques petites innovations technologiques afin de rendre son processeur plus polyvalent. De ce point de vue là en revanche, le GeForce4 est une semi-déception. Semi, car ces apports sont toujours intéressants et pourront rendre service à certains d'entre-nous, mais semi également car l'accélération matérielle pour les DVDs par exemple n'est toujours pas au niveau de ce que propose ATI. De même que la sortie TV qui souffre encore de défauts beaucoup trop importants pour faire de l'ombre à la concurrence.

Enfin terminons sur la question qui fâche, celle du prix. Cette Ti4600 risque effectivement de coûter un peu cher et sans atteindre les sommes astronomiques dont il avait été question avant le lancement de la GeForce3, elle devrait se trouver aux alentours de 500€. Alors le jeu en vaut-il la chandelle ? La réponse à cette question dépendra évidemment de votre budget...

Reste maintenant à voir exactement ce que proposeront les différents constructeurs, à voir également ce que vaudra la Ti4400 qui semble devoir épargner davantage nos portefeuilles sans trop réduire les performances. Reste enfin à voir la réaction du concurrent de toujours, ATI, qui vient à nouveau de perdre sa couronne...