Autant dire que les retards successifs de ce produit très attendu par la communauté des joueurs ont défrayé la chronique et fait les beaux jours d'ATI qui peut se targuer d'avoir dominer le marché des chips graphiques pendant plus de six mois, une véritable prouesse ! Le retard du GeForce FX est imputable à plusieurs facteurs : la mise au point du procédé de gravure en 0,13µ, l'éminente complexité du processeur et donc du processus de fabrication des cartes, le coût exorbitant et la rareté de la DDR-2 utilisée par le GeForce FX. Toutes ces raisons, bien que légitimes, ne plaident guère en faveur de NVIDIA qui a du mal a cacher les apparences : de sa tour de Babel la firme de Santa Clara a été prise de cours par son rival et s'est précipitée pour sortir le tant attendu NV30, à tout prix... Reste à savoir si le dernier bébé de NVIDIA est à la hauteur des espérances placées en lui et de la frénésie qui a entourée son lancement.

Aujourd'hui les performances du GeForce FX bien que présumées supérieures à celles d'une Radeon 9700 Pro n'ont toujours pas été confirmées, ni d'ailleurs ses spécifications exactes. Fort heureusement l'attente touche à sa fin et nous sommes enfin en mesure de révéler les premiers résultats obtenus par le GeForce FX. NVIDIA nous a confié une carte GeForce FX finale pendant 2 jours, de quoi l'étudier en profondeur.

GeForce FX : la génèse

Alors que nombre de puces graphiques privilégient les performances au détriment de la qualité visuelle, NVIDIA a toujours pris soin d'améliorer la qualité du rendu de ses cartes. La conception du GeForce FX a donc été guidée par la volonté de créer une solution capable d'effectuer un rendu de qualité cinématographique de scènes complexes en temps réel. NVIDIA place donc la barre très haut et pour atteindre le but fixé, les ingénieurs ont donc du créer un chip qui intègre de nouvelles fonctions inédites.

Design de la carte

Ce système a ceci de critiquable qu'il requiert l'occupation d'un deuxième slot de votre tour et vous privera vraisemblablement d'un précieux port PCI. C'était prévisible et il nous incombe de le signaler, le système de ventilation du GeForce FX est particulièrement bruyant. En mode de fonctionnement normal 2D, la nuisance sonore est supportable mais dès que l'on passe en 3D le bruit devient franchement insupportable.

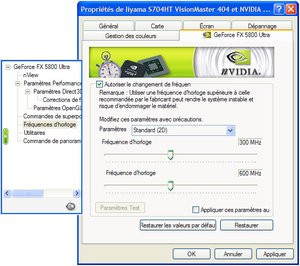

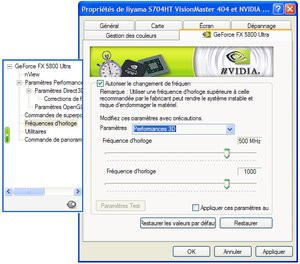

Avec une fréquence de fonctionnement de 500MHz, jamais atteinte auparavant, le GPU, tout comme la mémoire du GeForce FX, ont besoin d'air et ce système est la seule solution trouvée par NVIDIA. Afin de ne pas transformer le GeForce FX en véritable aspirateur, NVIDIA a développé la technologie "FXFlow" qui régule les fréquences des divers composants ainsi que la vitesse de ventilation en fonction de l'utilisation que vous faites de votre ordinateur. En utilisation bureautique, donc principalement 2D, le GeForce FX fonctionnera à une vitesse de 300MHz contre 600MHz pour la mémoire et son ventilateur sera peu pertubateur. En fonctionnement 3D, le GeForce FX passera en mode turbo et atteindra sa vitesse de pointe qui est de 500MHz pour le GPU et 1000MHz pour la mémoire avec pour conséquence l'augmentation notable de la vitesse de ventilation.

Il était prévisible à la lecture des spécifications du GeForce FX que celui-ci requiert une alimentation externe. C'est pourquoi une prise Molex est présente sur la carte afin de délivrer la puissance nécessaire requise pour un fonctionnement à haute vitesse. NVIDIA préconise l'utilisation d'une alimentation de 350 Watts avec la GeForce FX...

Dans le but de nous faire une idée précise du dégagement thermique de la GeForce FX et de son niveau sonore nous avons employé un appareil de mesure professionnel. En mode de fonctionnement normal la GeForce FX atteint les 56 décibels alors que ce chiffre grimpe à 59 décibels dès que le mode 3D est enclenché. A titre de comparaison, une GeForce 4 Ti4600 frise les 52 décibels. Du côté des températures il faut bien dire que le système développé par NVIDIA est des plus efficaces. Boîtier fermé, la température interne était de 30,2 degrés celsius avec notre GeForce FX contre 30,5 pour une GeForce 4 Ti4600. A défaut d'être esthétique et discret, le nouveau système de refroidissement du GeForce FX est donc efficace.

Une carte graphique qui en impose !

GeForce FX : un GPU hors des sentiers battus

Pour son GeForce FX NVIDIA a vu les choses en grand. Aussi la première caractéristique technique de ce dernier tient à sa finesse de gravure. Alors qu'Intel et AMD sont déjà passés à une finesse de gravure de 0,13µ depuis quelque temps déjà, le GeForce FX est le tout premier composant graphique à être gravé avec une telle finesse. Le fondeur taiwanais TSMC qui se charge de la production des puces NVIDIA a connu quelques déboires quant à la mise au point de cette technologie expliquant une partie du retard du GeForce FX. Toutefois la technologie semble aujourd'hui maîtrisée et NVIDIA en profite pour changer la présentation de ses puces en optant pour un design de type Flip Chip qui autorise un meilleur refroidissement du die. Ceci permet également de remplacer les interconnexions en aluminium par du cuivre, bien meilleur conducteur et de réduire de près de 25% la taille des transistors et de près de 36% la consommation électrique.Le nombre de transistors inclus dans le GeForce FX donne le tournis et atteint le chiffre impressionnant de 125 millions. Pour mémoire un Pentium 4 Northwood contient 55 Millions de transistors, un Radeon 9700 Pro est pourvu de 107 millions de transistors alors qu'un GeForce 4 en compte 63 millions. Avec une telle débauche de transistors la puissance brute du GeForce FX est impressionnante. Doté de 8 pixel pipelines et de 2 TMUs, celui-ci peut en effet effectuer le rendu de 16 textures par passe et traiter 350 millions de triangles par seconde. Grâce à ces divers raffinements le GeForce FX tourne à 500MHz, une véritable première dans le monde des Cartes Graphiques. Cette fréquence de fonctionnement devrait conférer à NVIDIA une certaine avance sur le Radeon 9700 Pro qui tourne à "seulement" 325MHz.

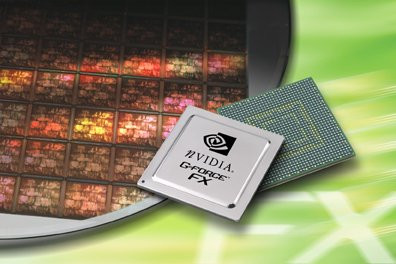

Vues de détail du GeForce FX

L'autre nouveauté majeure du GeForce FX est le type de mémoire employé. Par le passé la firme de Santa Clara a été l'une des premières à opter pour la DDR. Aujourd'hui, NVIDIA innove encore en étant le premier à exploiter la très récente mémoire DDR-II. Outre une augmentation du débit, la DDR-II consomme moins que les précédentes générations de DDR avec un voltage de 1,8v et son temps d'accès est relativement faible et se mesure à 2ns sur la carte de référence que nous avons eu entre les mains. Si le bus mémoire est de seulement 128 bits, la DDR-II cadencée à 1GHz délivre une bande passante de 16Go/s. Les 16Go/s annoncés sont un net progrès face au 10,4Go/s du GeForce 4 Ti4600, toutefois on reste en dessous de la bande passante proposée par ATI et atteignant les 19,6Go/s. Aussi large soit la bande passante mémoire, les performances du système mémoire dépendent énormément de sa gestion par le GPU. Dans ce domaine NVIDIA a toujours excellé et le GeForce FX inclus une architecture LightSpeed Memory encore améliorée comme nous le verrons plus loin.

Enfin notre cher NV30 emploie le bus AGP 8x ce qui lui permet d'échanger avec le système un maximum de 2,1Go de données par seconde. Le système reste bien entendu compatible avec les ports AGP 2 et 4x.

Langage NVIDIA CG

GunMetal : premier jeu programmé en CG

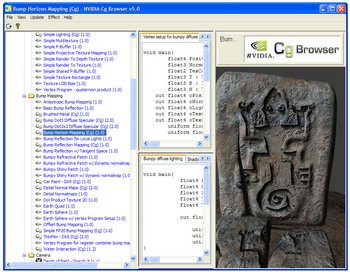

L'un des nombreux atouts du langage CG est la présence du navigateur d'effets intégré au SDK. Celui-ci permet au développeur de sélectionner des effets DirectX 8 ou DirectX 9, en ayant un contrôle total du code source afin d'adapter l'effet au jeu qu'il développe. Le NVIDIA CG Browser inclus également divers effets DirectX 9 optimisés pour le NV30. La communauté des développeurs CG et NVIDIA mettent régulièrement en ligne de nouveaux effets qu'il suffit de télécharger. Programmer un jeu devient plus simple grâce à ce concept.

NVIDIA CG Browser

Chaque génération de processeur graphique inclus de nouvelles fonctions. C'est bien entendu le cas du GeForce FX qui apporte son lot de nouveautés. Toutes ces nouveautés prennent appui sur DirectX 9.0 et vise à améliorer la qualité graphique des jeux.

NVIDIA IntelliSample

Sous cette appellation générique, NVIDIA a regroupé diverses fonctions visant à optimiser l'utilisation de la bande passante mémoire et les performances des modes anisotropic filtering et full scene anti aliasing. Il est un fait que plus la bande passante mémoire est large plus les performances d'un processeur graphique sont élevés. Toutefois la quantité de bande passante mémoire mise à la disposition d'un GPU n'est que peu efficace si ce dernier l'utilise n'importe comment. NVIDIA a donc repris sa fameuse architecture LightSpeed Memory en lui ajoutant quelques raffinements.A cette fin le GeForce FX propose un nouvel algorithme matériel de compression des informations liées aux couleurs. Ce genre d'information est fréquemment requis et génère un nombre certain d'accès mémoire. Grâce à cette nouvelle technologie les informations relatives aux couleurs peuvent être compressées avec un ratio de 1/4 sans aucune dégradation de la qualité permettant ainsi de réduire fortement l'utilisation mémoire tout en optimisant les divers temps d'accès. Autre nouveauté, le Fast Color Clear qui fonctionne à la manière du Fast Z Clear et efface les données stockées dans le frame buffer après chaque image.

Précision de rendu sur 128 bits

FP16 et FP32 permettront également de contourner certains problèmes récurrents comme l'altération de l'image au passage sur l'écran d'un PC. Celle-ci nécessitait auparavant une accentuation de la luminosité pas toujours très heureuse pour se rapprocher du dessin "original". De la même manière, les zones dites sur-exposées ou sous-exposées à la lumière seront beaucoup mieux traitées comme peuvent en témoigner les trois images-exemples ci-dessus. Enfin, le rendu des ombres profitera lui aussi de cette précision supplémentaire. L'apparition de zones tramées ne devrait par exemple plus être qu'un mauvais souvenir et la position des ombres devrait être plus précise évitant ainsi certains problèmes de "raccords".

Améliorations de l'anti-aliasing

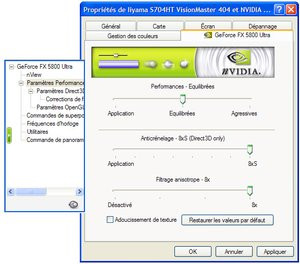

Face aux dernières solutions graphiques d'ATI, les cartes NVIDIA péchaient sérieusement par leurs faibles performances dès que les modes d'anti crénelage tels le FSAA ou l'anisotropic filtering étaient activés. Aussi les ingénieurs de NVIDIA se sont attelés à optimiser les performances de ces modes en intégrant l'Adaptative Texturing Filtering. Le GPU analyse en permanence le type de scène qu'il doit afficher et sélectionne automatiquement le mode de filtrage le plus adapté pour un compromis idéal entre performance et qualité.Deux nouveaux modes d'anti-aliasing font leur apparition avec le GeForce FX : le 6XS et le 8XS. Il n'y a pas vraiment de révolution dans le fonctionnement de ces deux modes, mais du fait de la puissance de calcul du GeForce FX, ils permettront aux utilisateurs très exigeants d'obtenir un antialiasing encore plus fin et encore plus efficace. Dernière amélioration le FSAA n'est plus géré en hardware par une unité dédiée mais par l'utilisation de Shaders via les Drivers.

Mode normal, mode Anisotropic Filtering 8x et FSAA 4x + Anisotropic Filtering 8x

NVIDIA CineFX

NVIDIA promet avec le GeForce FX l'avènement de la réalité cinématographique sur PC. Pour parvenir à ce noble idéal, NVIDIA a conçu le GeForce FX de façon à ce qu'il soit entièrement programmable. Le moteur CineFX a donc été entièrement créé pour DirectX 9.0 et prend en charge les Vertex Shaders 2.0+ et les Pixel Shaders 2.0. Contrairement aux derniers VPU d' ATI, le GeForce FX excède largement les spécifications de DirectX 9.0 ce qui devrait lui conférer une certaine pérennité.Vertex Shaders 2.0+

Le dernier processeur de NVIDIA est capable d'exécuter 256 instructions sur 256 boucles ce qui nous donne un total de 65536 instructions par shader alors que le Radeon 9700 Pro ne peut en traiter que 1024 en même temps. Pour ne pas pénaliser le GPU par ce nombre assez important d'instructions, le GeForce FX est doté de 16 vector registers qui servent de zones de stockage (ATI n'en propose que 12 sur ses derniers VPU). NVIDIA profite également de ce nouveau processeur pour offrir la gestion des loops & branches et le contrôle de flux. Auparavant il n'était pas possible d'agir sur le fonctionnement des Vertex Shaders, une fois qu'un processus était enclenché il fallait attendre qu'il soit achevé avant de passer au suivant. Le GeForce FX en conjonction avec Direct X 9.0 permet de contrôler un processus en cours même une fois que celui-ci est lancé. Le GeForce FX innove en proposant un contrôle dynamique, une fonction de call & return ainsi que des masques conditionnels d'écriture. Les nouvelles techniques de branching et de loop permettent également de réemployer le code précédemment utilisé afin de ne pas recommencer inutilement un processus.

Premières applications du CineFX

Pixel Shaders 2.0+

Avec DirectX 9.0 Microsoft a grandement fait évolué les Pixel Shaders. Des prémices apparues dans DirectX 8.0, les Pixel Shaders 2.0 deviennent beaucoup plus puissants et par la même omniprésents. Dans un proche avenir il est évident que de plus en plus de jeux tireront profit des Pixel Shaders. On a pu le voir avec Rallisport Challenge ou d'autres jeux de la même trempe, l'emploi des Pixel Shaders améliore véritablement le degré de réalisme d'un jeu et cette popularisation ne peut être que bénéfique. Ici aussi NVIDIA ne s'arrête pas aux spécifications de Microsoft et va plus loin en proposant un support exhaustif des Pixel Shaders 2.0+.Les progrès accompli dans ce domaine sont fulgurants et le GeForce FX est capable de traiter en une seule passe 256 fois plus d'instructions visant à gérer les textures qu'une GeForce 4 ! On dénombre pas moins de 1024 instructions, contre seulement 32 sur une Radeon 9700... La gestion des couleurs profite également de ces améliorations et le GeForce FX est capable de traiter, en une seule fois, 1024 instructions de couleurs (contre 64 sur une Radeon 9700) et 1024 instructions de texture. La vitesse de traitement du GeForce FX en matière d'opérations sur les shaders est de 32 instructions par cycle, contre 24 sur une Radeon 9700 Pro.

Comme pour les Vertex Shaders NVIDIA a augmenté le nombre de zones de stockage disponibles en le portant à 64 et ce dans l'optique de ne pas trop ralentir les temps d'exécution des calculs.

Démonstrations conçues par NVIDIA et tirant parties du CineFX

Fonctionnalités 2D

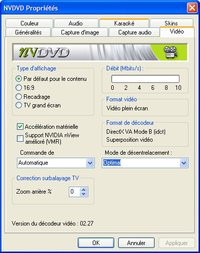

La carte de référence que nous avons reçu possède trois sorties : une VGA, une DVI et une sortie TV. La sortie VGA supporte une résolution maximale de 2048x1536 en 85Hz. Grâce aux fonctions NVIEW, le GeForce FX est capable de gérer un affichage sur deux écrans séparés et intègre deux Ramdac de 400MHz chacun. La sortie DVI de la carte est gérée par une puce Silicon Image Sil 164 qui supporte une résolution maximale de 1600x1200 en UXGA et il est possible d'utiliser un convertisseur pour brancher un second moniteur CRT dessus. La sortie TV supporte les standards PAL/NTSC et offre pour sa part une résolution convenable de 1024x768 et est gérée directement par le GPU. Avec le GeForce FX NVIDIA nous offre enfin un processeur graphique haut de gamme prenant en charge de façon 100% matérielle la décompression MPEG 2, ouf ! Cette technologie, héritée du VPE des GeForce 4 MX, est entièrement compatible avec Microsoft DXVA.

Décodage MPEG 2 matériel sous NVDVD 2.27

Améliorations des drivers

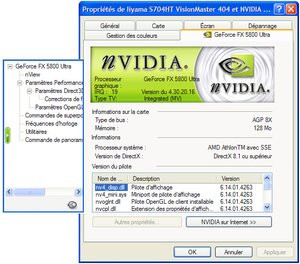

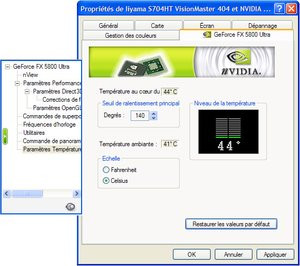

Les drivers livrés avec les premiers GeForce FX porteront visiblement le numéro de version 42.63. Il s'agit là de drivers Detonator standard totalement compatibles DirectX 9.0. On trouve quelques innovations disponibles uniquement sur les cartes GeForce FX telles que le monitoring de la température du GPU et la possibilité de passer manuellement en mode performances 2D et performances 3D.

Drivers 42.63 : le changement dans la continuité

Pour évaluer les performances de la GeForce FX nous avons choisi une plate-forme haut de gamme, dont la composition est détaillée ci-dessous :

-Processeur AMD Athlon XP 2600+

-Carte mère Leadtek K7NCR18D Pro (nForce 2)

-2x256Mo de mémoire DDR333 CAS 2.0

-Disque dur Seagate 120Go UDMA100

Notre machine tournait sous Windows XP Professionnel Service Pack 1 et utilisait la version 42.63 des Drivers Detonator, fournit par NVIDIA. DirectX 9.0 était également de la partie. En reprenant cette plate-forme nous avons effectué notre série de tests avec des cartes NVIDIA GeForce 4 Ti4600 et Hercules 3D Prophet Radeon 9700 Pro afin de les opposer au GeForce FX. Pour ce qui est des drivers ATI nous avons employé les pilotes 7.79.

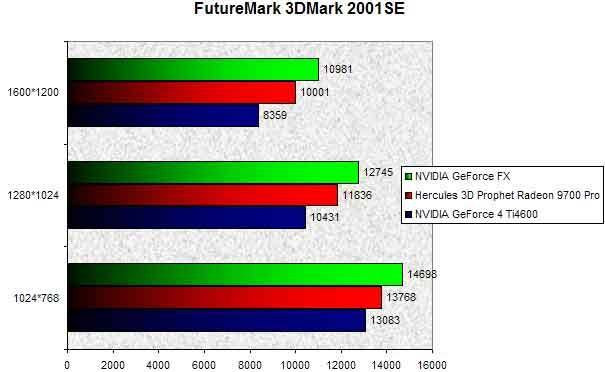

3DMark 2001SE

Avec ce premier test, la carte GeForce FX domine très nettement la GeForce 4 Ti4600 et dispose qui plus est d'une confortable avance sur le Radeon 9700 Pro. 3DMark 2001 SE met en exergue de manière claire que plus la résolution augmente plus le GeForce 4 Ti4600 est à la traîne. Ainsi en 1024x768 le GeForce 4 Ti4600 est 12% plus lent que le GeForce FX, alors qu'en 1600x1200 le vieillissant Ti4600 est 31% plus lent que le tout nouveau GeForce FX ! Toujours en 1600x1200, le GeForce FX est 9.7% plus rapide que la Radeon 9700 Pro.

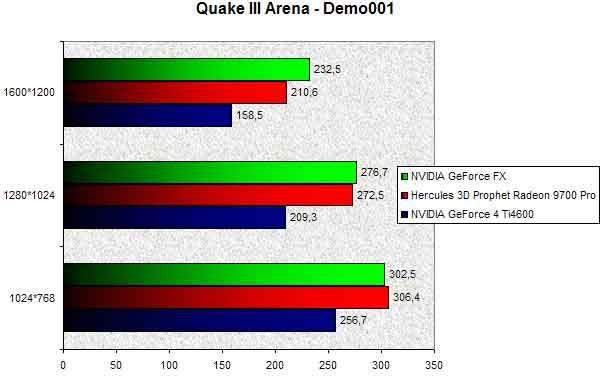

Quake III Arena

Voyons maintenant ce que donne le GeForce FX avec le roi des benchmarks OpenGL, Quake III Arena. Dans les résolutions courantes que sont le 1024x768 et le 1280x1024, le GeForce FX fait jeu égal avec la Radeon 9700 Pro. Si le GeForce 4 Ti4600 n'inquiète nullement les deux premières cartes de ce classement, on note que le GeForce FX reprend la tête de la course en 1600x1200 où il se révèle tout de même 10% plus rapide que le dernier VPU en date du canadien ATI. En 1280x1024 le GeForce FX s'est montré 30% plus rapide que le GeForce 4 Ti4600 !

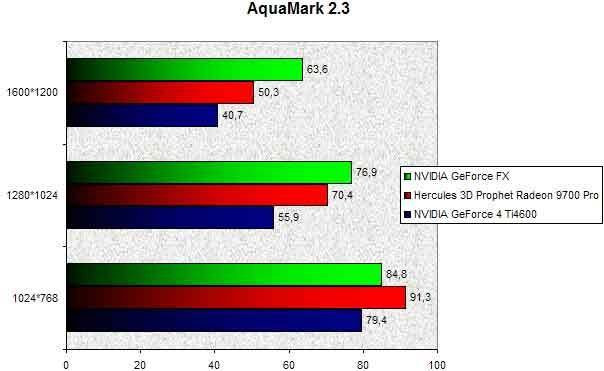

AquaMark 2.3

AquaMark, issu du célèbre jeu Aquanox, permet de tester les aptitudes des Cartes Graphiques à manier les Pixel Shaders. Premier accroc pour la GeForce FX, en 1024x768 la carte se fait distancer par le Radeon 9700 Pro d'environ 8%. Dans cette résolution le GeForce FX est seulement 6.8% plus rapide que son ainé le GeForce 4 Ti4600. La donne s'inverse dès que la résolution augmente et cela est sensible à partir du 1280x1024. Ici le GeForce FX est tout de même 9% plus rapide que le Radeon 9700 Pro et 37% plus performante que le GeForce 4 Ti4600 ! Que de progrès accomplis en un peu moins d'un an... Enfin en 1600x1200 le GeForce FX est de nouveau en tête et double aisément le Radeon 9700 Pro grâce à un framerate 26.4% plus élevé.

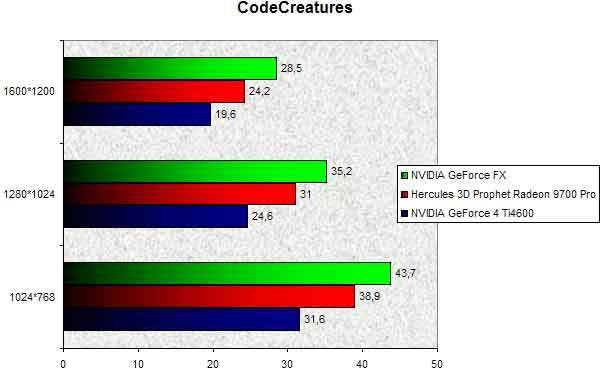

CodeCreatures

Avec CodeCreatures, autre bench testant les Shaders, le GeForce FX s'en tire plutôt pas mal en devançant systématiquement le Radeon 9700 Pro. En 1280x1024 le GeForce FX est 13% plus performant que le Radeon 9700 Pro, et 43% plus rapide que le GeForce 4 Ti4600 ! L'augmentation de la résolution confirme cette situation puisqu'en 1600x1200, le GeForce FX surclasse le Radeon 9700 Pro de près de 17%.

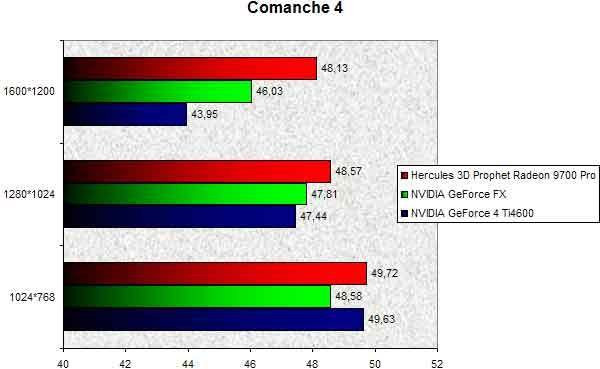

Comanche 4

Comanche 4 est l'un des tout premiers jeux à avoir utiliser les Shaders. Ici les shaders sont plutôt préhistoriques car programmés en assembleur. Le Radeon 9700 Pro tire particulièrement profit de ce test et surclasse largement la GeForce FX, qu'importe la résolution. En 1024x768, le GeForce FX est même moins performant que le GeForce 4 Ti4600 qui égale une Radeon 9700 Pro ! En 1600x1200 le Radeon 9700 Pro est 4,5% plus rapide que le GeForce FX. Avec la même résolution, le GeForce 4 Ti4600 se fait mettre en pièces par le VPU d'ATI qui demeure 10% plus rapide.

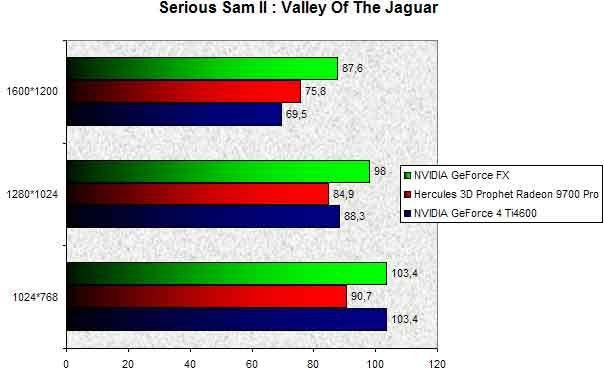

Serious Sam II

Serious Sam II, autre jeu OpenGL, est assez intéressant en particulier avec la démo 'Valley Of The Jaguar' qui est des plus gourmandes. Première surprise, en 1024x768 les deux cartes NVIDIA sont plus rapides que le Radeon 9700 Pro. Ce constat se confirme en 1280x1024 où le GeForce FX est 15% plus rapide que le Radeon 9700 Pro. Ce dernier se fait dammer le pion par un GeForce 4 Ti4600 qui est 4% plus efficace. En 1600x1200, le GeForce FX reste en tête, mais le Radeon 9700 Pro parvient à reprendre l'avantage sur le GeForce 4 Ti4600. Dans cette résolution la dernière puce graphique de NVIDIA est 15% plus rapide que le Radeon 9700 Pro.

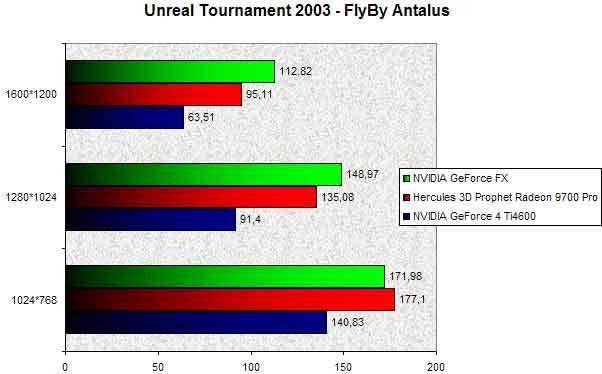

Unreal Tournament 2003

Actuellement, Unreal Tournament 2003 dispose d'un des moteurs graphiques les plus complexes. Il est donc intéressant de voir comment se comporte notre GeForce FX avec ce jeu et de comparer les résultats avec une carte ATI. En 1024x768 le GeForce FX est 3% plus lent que le Radeon 9700 Pro mais devance largement le GeForce 4 Ti4600 avec une avance appréciable de 22% ! En montant les résolutions la donne s'inverse et le GeForce FX domine assez nettement la compétition. En 1280x1024 le GeForce FX est 10% plus véloce que le Radeon 9700 Pro. En 1600x1200 l'écart se creuse un peu plus et le GeForce FX sort du lot avec une avance de 18% sur le Radeon 9700 Pro. Dans cette résolution le Radeon 9700 Pro est 49% plus rapide que le GeForce 4 Ti4600 alors que le GeForce FX est 77% plus rapide que le GeForce 4 Ti4600 !

Jusqu'à présent le GeForce FX s'est montré beaucoup plus performant que le GeForce 4 Ti4600 mais guère plus costaud que le Radeon 9700 Pro, sauf en haute résolution où l'écart se creuse de manière significative. Voyons maintenant ce que donne le GeForce FX avec les modes d'antialiasing connus pour leur gourmandise excessive.

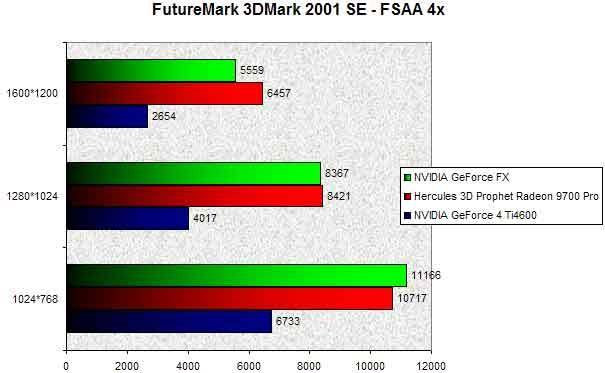

FutureMark 3DMark 2001SE - FSAA 4x

Pour ce premier test nous avons activé le mode FSAA 4x. Si le GeForce FX devance le Radeon 9700 Pro en 1024x768 il n'en va pas de même en hautes résolutions où le GeForce FX prend une sévère déculotté. En 1280x1024 le GeForce FX est très légèrement en retrait face au Radeon 9700 Pro, mais en 1600x1200 le GeForce FX est 16% plus lent que le Radeon 9700 Pro ! Toujours dans cette résolution le GeForce 4 Ti4600 montre clairement les limites de son architecture assez ancienne et le Radeon 9700 Pro l'explose avec un résultat 143% meilleur !

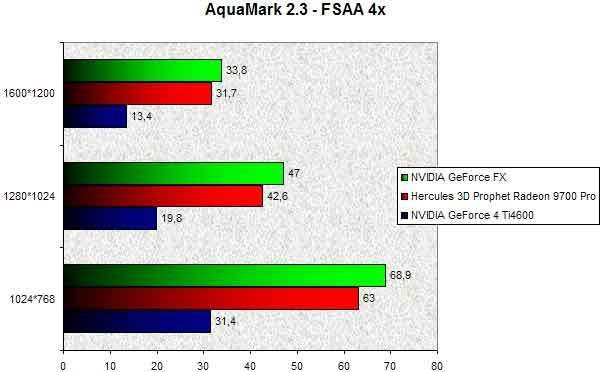

Aquamark 2.3 - FSAA 4x

Sous Aquamark lorsque le mode FSAA 4x est activé le GeForce FX, dans un sursaut de dignité, parvient à devancer dans toutes les résolutions le Radeon 9700 Pro. Toutefois plus la résolution monte plus l'écart qui sépare le GeForce FX du Radeon 9700 Pro se réduit. Ainsi en 1024x768 les deux puces sont séparées par un écart de 9%, en 1280x1024 cet écart grimpe à 10% avant de chuter à 6,5% en 1600x1200. On peut observer qu'ici aussi le GeForce 4 Ti4600 a les plus grandes peines du monde et ne peut prétendre rivaliser un seul instant avec les deux solutions haut de gamme d'ATI et NVIDIA.

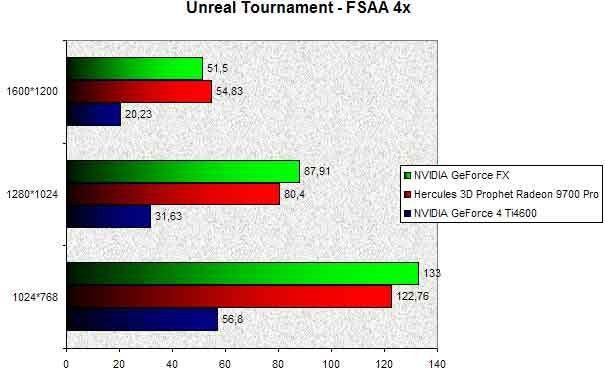

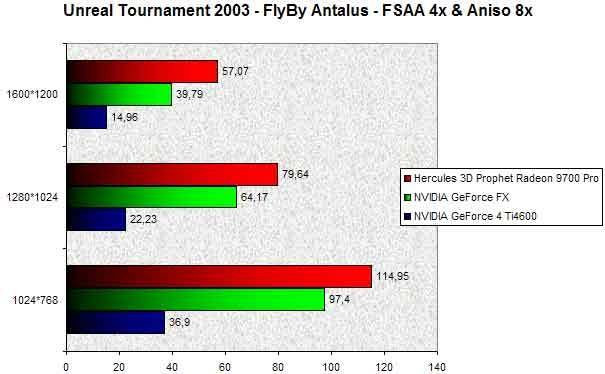

Unreal Tournament 2003 FlyBy Antalus - FSAA 4x

Sous Unreal Tournament 2003, l'activation du mode FSAA 4x réserve quelques surprises. Dans les résolutions courantes le GeForce FX s'en sort plutôt bien en devançant le Radeon 9700 Pro et son prédécesseur le GeForce 4 Ti 4600. En 1280x1024 le GeForce FX obtient un score 9% plus élevé que le Radeon 9700 Pro et atomise le GeForce 4 Ti4600 avec un score supérieur de 177% ! Hélas pour NVIDIA le GeForce FX est mis à mal en 1600x1200 puisque le Radeon 9700 Pro est devant avec un joli score supérieur de 6,5% à celui du NV30.

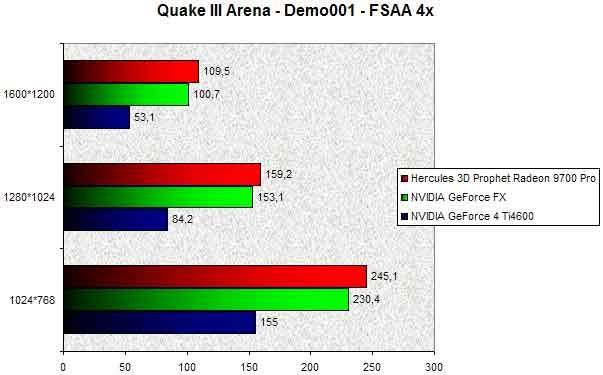

Quake III Arena - FSAA 4x

Avec Quake III l'utilisation du FSAA 4x met à mal le GeForce FX et celui-ci ne parvient pas un seul instant à devancer le Radeon 9700 Pro. Ainsi en 1024x768 le Radeon 9700 Pro est 6% plus véloce que le GeForce FX et achève le GeForce 4 Ti4600 avec un score 58% plus élevé ! En 1280x1024 l'avance du Radeon 9700 Pro se réduit mais il devance tout de même de 4% le GeForce FX. Enfin en 1600x1200 le VPU haut de gamme du canadien reprend du poil de la bête et surclasse le GeForce FX de 8%.

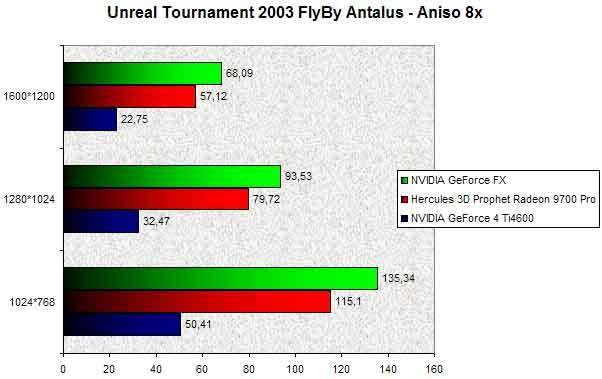

Unreal Tournament 2003 - Anisotropic Filtering 8x

Si en FSAA 4x le GeForce FX est particulièrement décevant, il en va tout autrement lorsque l'Anisotropic Filtering 8x est activé. Ici le GeForce FX domine très nettement ses compétiteurs. En 1024x768, le GeForce FX est 17% plus rapide que le Radeon 9700 Pro et 168% plus performant que le GeForce 4 Ti4600. En 1280x1024 le GeForce FX devance notre carte graphiques Hercules dans les mêmes proportions. Enfin en 1600x1200 l'écart se creuse et le GeForce FX maintient sa suprématie en étant 19% plus rapide que la puce R300 d'ATI.

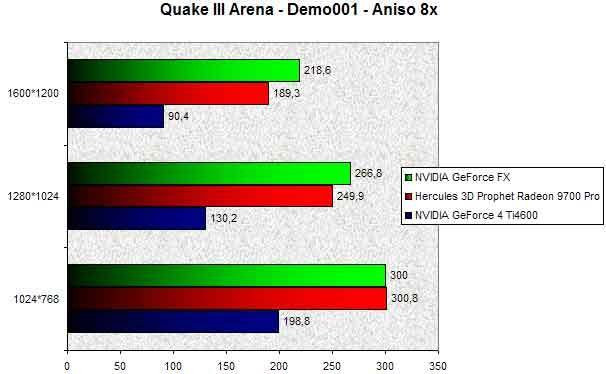

Quake III Arena - Anisotropic Filtering 8x

Sous Quake III en 1024x768 l'Anisotropic Filtering 8x ne permet pas de départager le Radeon 9700 Pro du GeForce FX. On note toutefois que le GeForce FX est 50% plus performant que le GeForce 4 Ti4600. En 1280x1024 le GeForce FX prend la tête et double le Radeon 9700 Pro grâce à un score 6,7% meilleur. Enfin en 1600x1200 le GeForce FX confirme son leadership et dispose d'une large avance de plus de 15% sur le Radeon 9700 Pro.

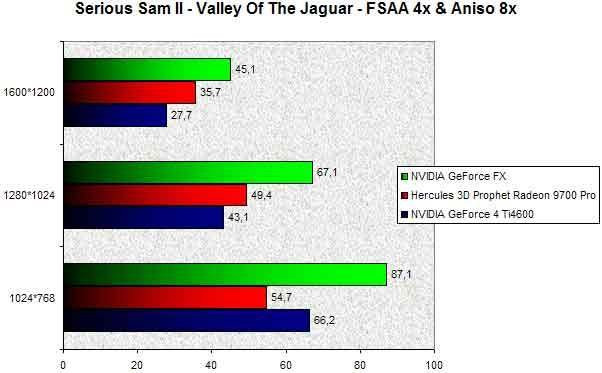

Serious Sam II : FSAA 4x et Anisotropic Filtering 8x

Il est intéressant d'observer le comportement de nos diverses Cartes Graphiques lorsque les modes FSAA 4x et Anisotropic Filtering 8x sont activés et donc cumulés. Première surprise en 1024x768, le GeForce 4 Ti4600 est 21% plus rapide que le Radeon 9700 Pro ! Dans cette même résolution le GeForce FX grille le R300 avec un score 59% plus élevé ! En 1280x1024, le Radeon 9700 Pro repasse devant le GeForce 4 Ti4600 mais reste 35% plus lent que le GeForce FX. Enfin en 1600x1200 le GeForce FX maintient ses performances et reste 26% plus rapide que le Radeon 9700 Pro.

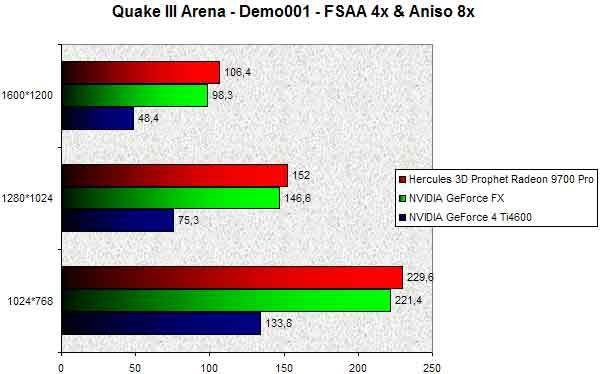

Quake III Arena : FSAA 4x et Anisotropic Filtering 8x

Sous Quake III, lors de l'utilisation conjointe du FSAA 4x et de l'Anisotropic Filtering 8x, le GeForce FX ne parvient pas à confirmer les résultats observés plus haut. En effet le Radeon 9700 Pro est perpétuellement en tête. Ainsi en 1024x768 le Radeon 9700 Pro est 3,7% plus rapide que le GeForce FX, en 1280x1024 l'écart reste le même alors qu'en 1600x1200 le GeForce FX s'est montré 8% plus lent que le Radeon 9700 Pro.

Unreal Tournament 2003 : FSAA 4x et Anisotropic Filtering 8x

Pour terminer notre série de test nous avons opté pour Unreal Tournament 2003. Ici les observations faites lors du test Quake III en FSAA 4x et Anisotropic Filtering 8x se confirment et le Radeon 9700 Pro domine encore plus nettement le GeForce FX. En 1024x768 le R300 est 18% plus rapide que le NV30, en 1280x1024 l'avance du Radeon 9700 Pro augmente et il est 24% plus véloce que le GeForce FX, enfin en 1600x1200 le GeForce FX s'est révélé 43% plus lent que le Radeon 9700 Pro.

Bilan

Au vu de nos divers tests, le moins que l'on puisse dire est que le GeForce FX donne des résultats fort peu homogènes bien que largement meilleurs que ceux d'une GeForce 4 Ti4600. Si en mode d'affichage normal le GeForce FX termine généralement premier, son avance est trop souvent restreinte. D'autre part lorsque les techniques d'anticrénelage avancées telles le FSAA 4x sont activées les résultats du GeForce FX font pâle figure face à ceux d'une Radeon 9700 Pro. Si le mode Anisotropic Filtering 8x plaide en faveur de NVIDIA, ce n'est pas le cas du mode FSAA 4x où le GeForce FX subit la loi d'ATI. NVIDIA nous indique que les prochains Drivers devraient conférer au GeForce FX de biens meilleurs résultats particulièrement avec les techniques d'antialiasing. En attendant ces futurs drivers et en considérant les résultats actuels de la carte il est bien difficile de justifier la différence de coût qui existe entre un Radeon 9700 Pro et un GeForce FX.Conclusion

Après plusieurs mois d'attente, le GeForce FX se concrétise enfin avec l'arrivée des premières cartes l'exploitant. Ce nouveau processeur graphique, fruit d'un long développement, intègre nombre de technologies innovantes parmi lesquelles on retiendra la gravure 0,13µ et l'utilisation de mémoire DDR-II. Le revers de la médaille est que ces technologies de pointe sont à l'origine d'une grande partie du retard du GeForce FX et de son prix fort élevé atteignant les 599€ en version Ultra.En terme de performances il faut bien dire que les premiers résultats du GeForce FX déçoivent, en particulier avec les modes d'anti-aliasing. Certes les scores du GeForce FX sont bien meilleurs que ceux d'une GeForce 4 Ti4600 et montrent un bond technologique certain... Mais face à une Radeon 9700 Pro force est de constater que le GeForce FX n'est hélas pas toujours à la fête avec une avance moyenne n'excédant que rarement les 10%.

Imposant, bruyant, pas forcément compétitif, le GeForce FX n'est pas pour autant un mauvais produit. Dans l'état actuel des choses il est pénalisé par des Drivers encore immatures et une interface mémoire étriquée de seulement 128 bits là où ATI offre 256 bits. NVIDIA nous a indiqué que la prochaine génération des drivers Detonator devrait augmenter de près de 25% les performances et nous ne manquerons pas de le vérifier dans un prochain test.

Quoiqu'il en soit l'architecture du NV30 est comme toujours chez NVIDIA des plus innovantes et marque une vraie rupture avec les GeForce 4. Regorgeant de fonctionnalités inédites, le GeForce FX est une merveilleuse vitrine technologique qui se paye le luxe d'excéder les spécifications de DirectX 9.0 et offre, il est vrai, des possibilités surprenantes. La simple vue de la démonstration Dawn vous convaincra de la puissance du GeForce FX et de la qualité quasi-cinématographique de ses rendus. Grâce à sa conception le GeForce FX devrait se bonifier dans le temps avec notamment l'arrivée de meilleurs drivers et l'apparition de diverses déclinaisons. De plus il nous est pour l'instant impossible de nous prononcer sur les performances DirectX 9.0 de la carte, faute de bench adéquat ! L'arrivée prochaine de 3DMark 2003 devrait fort heureusement permettre d'y voir plus clair entre les diverses Cartes Graphiques DirectX 9.0 disponibles. Il ne restera plus qu'à attendre les jeux adéquats !

Au final le GeForce FX devrait faire ses preuves d'ici quelques mois et il nous paraît judicieux de laisser mûrir le produit avant de se précipiter dessus. Nous ne manquerons bien sûr pas de suivre l'évolution du nouveau processeur vedette de NVIDIA dans un prochain article.