Pendant ce temps ATI n'est pas resté les bras croisés et à lancé sa série X850, à laquelle NVIDIA n'a d'ailleurs pas jugé utile de répliquer, sans omettre l'arrivée du fracassant Radeon X800 XL en fin d'année dernière. Le canadien fourbit qui plus est ses armes en mettant actuellement les dernières touches à sa nouvelle architecture R520... En attendant la nouvelle génération d'ATI, le GeForce 7800 GTX vise à succéder au valeureux GeForce 6 qui a indiscutablement redonné à NVIDIA une part de son prestige d'antant. Alors révolution ou évolution ?

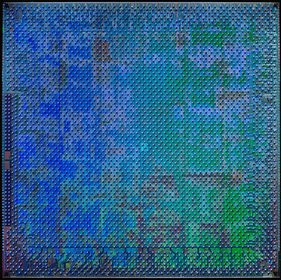

Wafer NVIDIA GeForce 7800 GTX

NVIDIA G70 : du rififi dans les noms de code

Alors que depuis la nuit des temps, NVIDIA utilise pour désigner ses puces graphiques le même type de nom de code, commençant systématiquement par le préfixe NV, le fabricant effectue un virage à 180° en affublant son dernier-né de l'étrange nom de code « G70 ». Dès lors on peut se demander à quoi correspond ce G70 dans les anciennes roadmaps de NVIDIA ? Le NV50 ? Assurément non, vu qu'il ne s'agit pas d'une vraie nouvelle architecture, non le G70 serait plus proche du NV47 et les mauvaises langues seraient tentées de dire que ce changement de dénomination intervient à point nommé pour nous faire oublier que le GeForce 7800 GTX a un lien de parenté évident avec les GeForce 6... Au-delà des querelles de nom de code NVIDIA annonce aujourd'hui exclusivement le modèle GeForce 7800 GTX, les futures déclinaisons comme le modèle GT devant être dévoilées un peu plus tard.

Julien intrigué par la nouvelle GeForce de NVIDIA

NVIDIA G70 : un NV40 amélioré

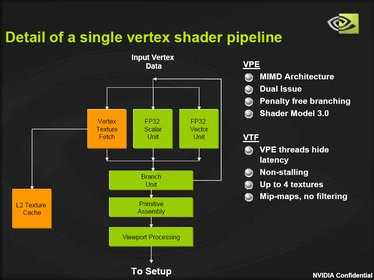

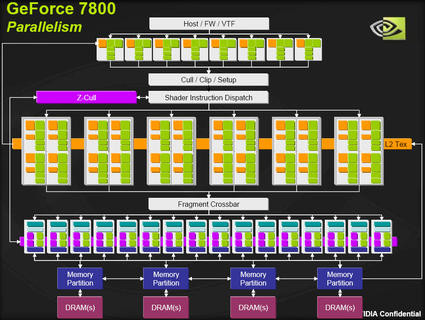

Fort du succès de son NV40, NVIDIA a décidé de capitaliser sur les atouts de cette architecture ce qui ravira au passage nombre de développeurs de jeux leur évitant ainsi de revoir leur façon de coder. Pour donner naissance au GeForce 7, les ingénieurs de la firme de Santa-Clara avaient donc pour mission d'identifier les principaux points faibles du GeForce 6 et d'y remédier. Le fruit de ce travail est l'arrivée du moteur de rendu CineFX 4.0 qui apporte quelques améliorations de ci, de là. Le premier changement introduit par ce nouveau processeur graphique DirectX 9.0c concerne sa puissance géométrique. Partant du constat que la géométrie est encore et toujours à la base de la 3D, les équipes de NVIDIA ont augmenté le nombre de vertex pipelines du GeForce 7. Celui-ci peut donc s'appuyer sur 8 unités indépendantes de traitement des vertices contre six auparavant, soit une augmentation de 33%, ce qui aura pour effet premier d'autoriser le traitement d'un plus grand nombre de figures géométriques en parallèle et sera particulièrement bénéfique aux applications effectuant notamment des rendus d'ombre. NVIDIA ne s'est pas arrêté en si bon chemin et les unités de vertex ont été légèrement optimisées.

Architecture d'un Vertex Pipeline

Deuxième grosse nouveauté à signaler, le passage de 16 pixels pipelines à 24 pixels pipelines grâce à l'adjonction de deux quads supplémentaires (les pipelines sont distribués sur six blocs comprenant chacun quatres pixels pipelines d'où la notion de quad). A l'inverse les ROP (Raster Operation) Engine sont, comme sur le GeForce 6, toujours au nombre de 16. Pour mémoire les unités ROP gèrent certaines opérations comme le mélange, la compression Z-Buffer ou l'anti-aliasing et supportent le Multiple Render Targets (MRT).

Architecture du GeForce 7

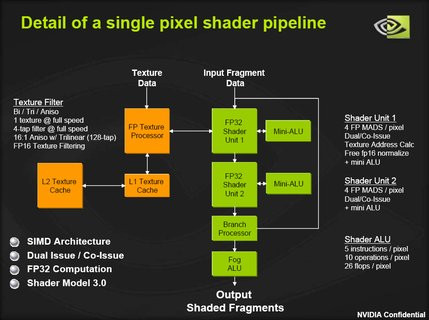

Quant à l'architecture même du pipeline 3D elle a été légèrement revue afin d'améliorer les performances mathématiques brutes de la puce. Car aujourd'hui si le GeForce 6800 est relativement costaud, il manque tout de même de pèche pour certains domaines de plus en plus cruciaux comme l'exécution des Shaders 3.0 et plus particulièrement ceux disposant d'un grand nombre d'instructions. Comment y parvenir ? Rappelons tout d'abord que le GeForce 7, tout comme son prédécesseur d'ailleurs, dispose d'une architecture parallèle de type SIMD (Single Instruction Multiple Data) ce qui se traduit dans les faits par la présence, sur chaque pipe, de deux unités de calculs dédiées aux shaders et travaillant en FP32, calculs en virgule flottante avec une précision de 32 bits. Après avoir analysé plus de 1300 des shaders les plus courants les ingénieurs de NVIDIA ont déterminé que pour augmenter leur vitesse de traitement il fallait booster les MADD. Mais qu'est ce qu'un MADD ? Un MADD est une instruction mathématique de type Multiply & Accumulate (en gros une multiplication suivie d'une addition) fréquemment utilisée dans la plupart des programmes d'éclairage, de transformations ou de calcul de texture. Avec le GeForce 7 NVIDIA a revu les capacités des mini-ALU (Arithmetical Logic Unit) pour que chaque unité de pixel shader puisse maintenant exécuter 4 MADD en virgule flottante pour la puissance brute totale de la puce avoisine les 200 gigaflops (unité de mesure des opérations en virgule flottante effectuées à la seconde). Grâce à ce changement NVIDIA espère que le temps de traitement des shaders sera divisé par deux. Face au GeForce 7, le GeForce 6 ne pouvait lui exécuter que 2 MADD sur une seule des deux mini-ALU. On notera au passage que le nombre de registres du GeForce 7 reste identique à son prédécesseur.

Architecture d'un pipe Pixel Shader du GeForce 7

Tout comme le GeForce 6, chaque pipeline du GeForce 7 dispose de sa propre unité de texture. Cette dernière a toutefois été sensiblement revue pour permettre un accès plus rapide aux textures avec en sus la possibilité d'obtenir certains éléments composant les textures (autrement dit les texels), et ce dans différentes tailles, toujours dans le but d'accélérer l'exécution des shaders. De plus le moteur de textures dispose d'un mécanisme de cache amélioré ce qui, combiné aux améliorations précédentes, devrait augmenter les performances du filtrage des textures 64 bits rendus en virgule flottante ce qui profitera principalement aux effets HDR (High Dynamic Range). Sans rentrer dans les détails le HDR permet d'intégrer dans les jeux de saississants effets de contre-jour qui sont calculés en temps réel en fonction des sources lumineuses et de la position du personnage. Vous trouverez plus de détails sur le HDR dans notre test du GeForce 6 que vous pouvez compulser ici. Les fonctions de filtrage anisotropique devraient également profiter de ses améliorations. Enfin du côté du contrôleur mémoire, le GeForce 7 profite toujours d'un bus mémoire sur 256 bits dont certains algorithmes auraient été optimisés.

GeForce 7800 : un peu de neuf dans l'antialiasing

Outre les nouveautés énumérées précédemment, le GeForce 7800 dispose de modes d'anti-crénelage améliorés accessibles depuis les propriétés avancées des pilotes NVIDIA. C'est ainsi qu'apparaissent les Transparent Supersampling et Multisampling qui visent à améliorer la finesse de lissage des petits objets comme les feuilles d'un arbre par exemple. Pour cela les textures Alpha, donc avec transparence, sont converties en textures opaques de sorte que même les pixels à l'intérieur d'un polygone profitent d'un anti-aliasing. Imaginons une scène 3D avec un grillage devant un mur ; le GPU lorsqu'il doit effectuer l'anti-crénelage voit alors deux couleurs différentes : du noir qui correspond au grillage et du rouge pour les briques du mur. Avec le Transparent Supersampling en voyant qu'il y a à l'avant plan une couleur différente de celle du mur qui occupe plus de place en taille, le GPU va recréer des pixels supplémentaires pour l'avant plan, ce qui n'est pas fait en temps normal. Le Transparent Multisampling est pour sa part un peu moins efficace que le mode Supersampling mais offre l'avantage de consommer moins de ressources. En effet alors qu'en Multisampling un shader n'est exécuté qu'une seule fois (il faudra tout de même procéder au fetching des textures et couleurs, calculer les valeurs Z et faire quatre fois une comparaison du Z buffer), le Supersampling exécute quatre fois le même shader et procède aux opérations de fetching également quatre fois. Du coup l'utilisation mémoire explose, alors que le pixel pipeline est pris d'assaut. Bien que supportant toujours le Supersampling NVIDIA préfère donc s'orienter vers le Multisampling, moins coûteux en terme de performances et assez proche d'un point de vue qualitatif. Voilà ce que donne le Transparent Antialiasing sous Far Cry :

De gauche à droite : Far Cry en mode normal, Far Cry en FSAA 4x + Aniso 8x

Far Cry en FSAA 4x + Aniso 8x + Transparency AA en Multisampling et le même en Transparency AA SuperSampling

On termine avec le screenshot de Far Cry en FSAA 4x + Aniso 8x sur une ATI Radeon X850 XT PE

Au regard de ces captures on voit que le Transparency Antialiasing tient plutôt bien ses promesses. Les feuilles et la végétation sont beaucoup plus fines et on le note principalement en observant le buisson qui apparaît sur la gauche de nos captures. En activant l'antialiasing conventionnel le buisson reste assez crénelé alors qu'en activant le mode Transparency AA il est plus fin, plus net, plus propre. Le Transparency AA en mode SuperSampling semble pour sa part rendre les objets un peu plus flous. Reste que si le Transparency AA est efficace il ne concerne que des détails de l'image et non pas l'intégralité d'une scène. Mais quel est l'impact de ces réglages sur les performances ? La réponse ci-dessous avec Far Cry :

On note que le Transparency AA en multi-échantillonnage se fait gratuitement puisque son activation n'a pratiquement aucune incidence sur les performances. A l'inverse le Transparency AA en super-échantillonage consomme plus de resources. En l'activant on perd jusqu'à 9% de performances. Le GeForce 7 profite par ailleurs, tout comme le GeForce 6, de la grille rotative. Celle-ci est dorénavant programmable et se base sur quatre échantillons par pixel, ceux-ci étant positionnés de guingois et non en carré comme habituellement pour offrir un meilleur respect des couleurs. Le Gamma Correct Antialiasing fait également son apparition sous la forme d'une option supplémentaire dans les pilotes de la carte. Il s'agit ici d'appliquer une correction gamma des couleurs avant le sous-filtrage pour préserver les nuances de couleur.

Le retour de PureVideo

Avec PureVideo, NVIDIA respecte scrupuleusement les dernières normes de Microsoft en matière de vidéo ce qui permet à la firme de Santa-Clara d'accélérer le décodage des WMV9 en déchargeant le processeur central. Pour en bénéficier il faut installer le dernier patch DXVA du Windows Media Player et activer le mode 'Haute Qualité'. Celui-ci force l'utilisation du VMR plutôt que de l'habituel Overlay. Le VMR consiste à traiter la vidéo comme une texture sur une surface 3D, ce qui permet de profiter de certaines accélérations. Toutefois lors de nos tests nous ne constations aucun gain de performances en activant le DXVA à la lecture d'un flux WMV9 HD en 1080i. Pourquoi ? Nul ne le sait encore mais nous pouvons risquer l'hypothèse que le patch DXVA de Microsoft ne prend pas totalement en charge les systèmes français.

Par ailleurs, PureVideo offrira une accélération des flux H.264, lorsque les premiers médias en MPEG 4 AVC seront d'actualité. Hélas rien n'est encore prévu pour l'encodage et même en décodage fort peu de codecs sont actuellement supportés (toujours pas de support du DivX ou du Xvid). En fait via la couche DXVA le Windows Media Player 10 profite des accélérations PureVideo que lorsqu'il est patché et il faura impérativement installer le codec logiciel PureVideo de NVIDIA pour l'accélération du MPEG 2. A noter que NVIDIA affiche dorénavant une volonté d'ouverture de sa technologie, Cyberlink et Intervideo se penchant tous les deux sur l'implémentation des accélérations PureVideo pour leurs prochains logiciels. Supportant le HDTV mais aussi les DRM de type HDCP, le moteur vidéo, via son codec logiciel PureVideo, offre des fonctions 3:2 et 2:2 pull-down ainsi que des fonctions de deblocking et d'antialiasing censées améliorer la qualité générale de l'image. Le procédé Inverse Téléciné également dit 3:2 ou 2:2 pulldown consiste à supprimer l'effet de flou qui apparaît lorsqu'un film originalement enregistré en 24 FPS est traduit en 25 ou 30 fps pour être pressé sur DVD.

NVIDIA G70 : la puce, la carte

Alors que le GeForce 6800 atteignait déjà des records en matière de densité de transistors, le GeForce 7800 GTX va encore plus loin. Si le NV40 comporte quelques 200 millions de transistors, le G70 voit ce nombre porté à 302 millions, selon les données constructeur. La puce est donc toujours aussi impressionnante et est fabriquée par TSMC en 0,11µ ce qui devrait garantir un échauffement moindre face au GeForce 6. Question fréquences NVIDIA est resté inhabituellement conservateur en cadençant son GeForce 7800 GTX à 430 MHz alors que la mémoire GDDR3 opère à 1,2 GHz soit une bande passante atteignant les 38,4 Go/s. Rappelons que la version PCI-Express du GeForce 6800 Ultra tournait à 425 MHz pour une mémoire opérant à 1,1 GHz. Outre les améliorations propres au pipeline, le G70 dispose d'une interface PCI-Express 16x native. C'est important de le préciser car jusqu'alors l'offre haut de gamme de NVIDIA utilisait pour fonctionner en PCI-Express un bridge, le fameux HSI, induisant ainsi des temps de latence supplémentaires. Nativement PCI-Express donc, le GeForce 7800 GTX ne devrait pas être proposé en version AGP, du moins pour l'instant.

Le Die du GeForce 7

Autre nouveauté, le GeForce 7 dispose du clock-gating : il s'agit ici de désactiver certaines portions de la puce lorsqu'elles ne sont pas utilisées afin de diminuer sa consommation électrique et son échauffement. NVIDIA veut en effet mettre en avant les efforts consentis sur le G70 au niveau des performances par Watt. Face au GeForce 6800 Ultra qui consomme entre 110 et 120 watts, le GeForce 7800 ne consomme qu'entre 100 et 110 Watts, soit une petite baisse. Si la baisse de la consommation électrique n'est pas flagrante on pourra toutefois féliciter NVIDIA de ne pas l'avoir augmentée ! Durant nos tests nous avons ainsi pu faire fonctionner deux GeForce 7800 GTX en SLI avec une alimentation de 460 Watts. Seul Doom 3 nous a forcé à débrancher notre second disque dur et le lecteur de CD-Rom pour fonctionner convenablement en 1600x1200 en FSAA 4x + Aniso 8x. Pour le SLI la recommandation en matière d'alimentation reste donc à un minimum de 500 Watts. Côte 2D, le GeForce 7800 intègre un double RAMDAC à 400 MHz pour offrir une résolution maximale de 2048*1536 en 85 Hz.

Puce NVIDIA GeForce 7800 GTX

Concernant la carte, les équipes de design de NVIDIA sont là encore restées très sages. Ainsi le GeForce 7800 GTX est une carte single-slot qui dispose d'un ventirad monobloc peu épais : oublié donc le pachydermique ventirad de la GeForce 6800 Ultra ! Le système de refroidissement est pratiquement similaire à celui d'une GeForce 6800 GT et constitué de deux blocs radiateurs à ailettes métalliques (un pour le GPU et un pour la mémoire) reliés entre eux par un heat-pipe et enchâssés dans une coque recouverte d'un plastique translucide. On retrouve à l'extrémité de cette dernière un ventilateur. Ce dernier signé Delta Electronics (un modèle BFB0712H) est plutôt silencieux et on notera, que comme sur les derniers ventilateurs de référence Intel, le câble qui l'alimente est constitué de quatre fils et non trois ou deux comme habituellement ce qui est censé permettre une régulation thermique dynamique plus fine. Notez à ce sujet que le GeForce 7800 est cadencé à 275 MHz lorsqu'il s'agit de fonctionner en 2D. Non loin du système de refroidissement, NVIDIA a positionné un radiateur noir sur l'étage d'alimentation, alors qu'au dos de la carte figure un autre radiateur, beaucoup moins épais, qui recouvre les puces mémoires et contribue également au maintient du système de refroidissement principal. Comme sur les GeForce 6800, une plaque de métal noir, aux extrémités en étoile, est située juste au dos du processeur graphique et sert à fixer le radiateur qui surmonte - de l'autre côté - le processeur graphique. Lors de nos tests le GPU s'échauffait autour des 63° C en pleine charge ce qui reste fort raisonnable.

Carte de référence NVIDIA GeForce 7800 GTX

Avec un PCB vert rallongé d'un centimètre et demi face à un GeForce 6800 GT, la carte de référence que nous avons testé est pourvue d'un connecteur SLI et d'une prise d'alimentation électrique au standard PCI-Express. Les 256 Mo de mémoire qu'elle embarque sont constitués de puces Samsung GDDR 3 certifiées à 1,6ns. On notera que si NVIDIA propose pour l'heure une seule version 256 Mo du GeForce 7800 GTX le PCB de la carte comporte les emplacements pour accueillir 512 Mo de mémoire. La carte est de plus munie d'une puce Philips de dernière génération pour la prise en charge des fonctions VIVO, une SAA7115HL, et il est à noter que sa double sortie DVI est gérée directement par le processeur graphique, NVIDIA n'ayant plus recours à un TDMS externe. On notera également que le connecteur vidéo est pour la première fois, du moins sur une carte de référence, blindé.

| NVIDIA GeForce 6800 GT | NVIDIA GeForce 6800 Ultra | NVIDIA GeForce 7800 GTX | ATI Radeon X850 XT PE | |

| Interface | PCI-Express bridgé | PCI-Express bridgé | PCI-Express 16x natif | PCI-Express 16x natif |

| Gravure | 0,13µ | 0,13µ | 0,11µ | 0,13µ low-k |

| Transistors | ~200 Millions | ~200 Millions | ~302 Millions | ~180 Millions |

| Ramdac | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz |

| T & L | DirectX 9.0c | DirectX 9.0c | DirectX 9.0c | DirectX 9.0b |

| Pixel Pipelines | 16 | 16 | 24 | 16 |

| Vertex Pipelines | 6 | 6 | 8 | 6 |

| Mémoire embarquée | 256 Mo | 256 Mo | 256 Mo | 256 Mo |

| Interface mémoire | 256 bits | 256 bits | 256 bits | 256 bits |

| Bande passante mémoire | 32,7 Go/s | 35,2 Go/s | 38,4 Go/s | 37,7 Go/s |

| Fréquence GPU | 350 MHz | 425 MHz | 430 MHz | 540 MHz |

| Fréquence mémoire | 500 MHz | 550 MHz | 600 MHz | 590 MHz |

Overclocking

Côté overclocking la carte de référence à base de GeForce 7800 GTX que nous a confiée NVIDIA s'avérait assez souple. Ainsi alors que la puce est en temps normal cadencée à 430 MHz nous avons facilement pu lui faire atteindre les 475 MHz soit une augmentation de quasiment 10% tout en passant la mémoire de 1.2 à 1.3 GHz. Dans ces conditions la carte a parfaitement encaissée le choc y compris en 1600x1200. La preuve avec un rapide test sous Far Cry en FSAA 4x & Aniso 8x. On le voit plus la résolution est élevée plus le gain en terme de performances est appréciable, ainsi en 1600x1200 on gagne jusqu'à 10% !

Les Pilotes

Avec le GeForce 7, NVIDIA nous propose une nouvelle génération de Drivers, les ForceWare 77.62. Pour l'utilisateur final force est de reconnaître qu'il y a bien peu de nouveautés tangibles. L'interface demeure identique et seul le panneau SLI profite d'une nouvelle cosmétique. Côté fonctionnalités il n'est hélas pas encore question d'activer le SLI sans rebooter pas plus d'ailleurs qu'il n'est possible d'exploiter l'antialiasing 16x promis au lancement du GeForce 7 par NVIDIA. Il est vrai que ses fonctions devraient, si tout va bien, faire leur apparition d'ici quelques mois. On se contentera donc dans ces nouveaux pilotes de deux nouvelles fonctions ayant trait à l'anticrénelage et masquées par défaut. Accessibles en activant les options avancées les fonctions en question permettent de profiter du Transparency Antialiasing et du Gamma Correct Antialiasing. Pour le reste les ForceWare 77.62 profitent de diverses optimisations du côté des performances, qui affectent également les GeForce 6, et intègrent un plus grand nombre de profils avec notamment l'arrivée d'un profil pour Unreal Tournament 2004 alors qu'il n'existe toujours pas de profil pour Chronicles of Riddick.

Pilotes NVIDIA ForceWare 77.62

- Asus A8N SLI Deluxe (BIOS 1011),

- AMD Athlon 64 3800+ Venice,

- 2x512 Mo Corsair TwinX 3200LL,

- Disque dur Hitachi T7K80 80 Go (Serial-ATA II)

Aquamark 3

On commence cette longue série de tests avec AquaMark 3. Ici la configuration SLI à base de GeForce 7800 GTX prend la tête en surpassant même le SLI à base de GeForce 6800 GT. Seule la GeForce 7800 GTX s'avère plus performante qu'une Radeon X850 XT PE et ce aussi bien en 1280x1024 qu'en 1600x1200. Face au haut de gamme d'ATI, la dernière-née de NVIDIA est ici 11% plus véloce. Comparativement au GeForce 6800 Ultra, le GeForce 7800 GTX se montre 15% plus performant alors qu'il surpasse le GeForce 6800 GT de près d'une trentaine de pourcents.

3DMark 2005

On enchaîne avec 3DMark 2005. Le GeForce 7800 GTX semble ici s'envoler en s'adjugeant un score qui atteint les 7600 points. La dernière carte de NVIDIA fait ici nettement mieux que le Radeon X850 XT PE alors qu'elle surclasse largement ses prédécesseurs. La mise en SLI de deux GeForce 7800 GTX permet de briser de nouveaux records avec un score qui flirte autour des 10000 points.

Unreal Tournament 2003

Premier constat flagrant avec Unreal Tournament 2003 : les performances semblent limitées par le CPU en 1024x768 et 1280x1024. Le GeForce 7800 GTX dispose ici encore d'une confortable avance sur ses pairs, puisqu'il est 14% plus performant que le GeForce 6800 Ultra. On note qu'en SLI les deux GeForce 7800 GTX font moins bien que la carte seule, preuve que le moteur graphique d'Unreal Tournament ne sait pas exploiter le SLI. Si le X850 XT PE d'ATI tient la dragée haute au GeForce 7 en 1024x768 et en 1280x1024, il cède du terrain en 1600x1200 au profit de NVIDIA.

Splinter Cell : Chaos Theory 1.03

Dans sa dernière mouture, Splinter Cell Chaos Theory profite d'un moteur graphique supportant le Shader Model 3.0. Hélas les cartes ATI n'offrant pas de prise en charge pour ce mode nous faisons tourner toutes nos cartes en Shader Model 1.1. Le GeForce 7 est en tête et le gain de performances face au Radeon X850 XT PE atteint tout de même 25% et le GeForce 7800 GTX fait mieux que deux GeForce 6800 GT en SLI. Le GeForce 7800 GTX SLI offre pour sa part un gain impressionant de 83% face aux performances relevées avec une carte seule.

Far Cry v1.31

Far Cry, ici en version 1.31, nous indique clairement qu'en 1024x768 et en 1280x1024 la plupart des GPU sont limités par la puissance processeur. Il faut donc grimper en 1600x1200 pour mettre en avant des différences tangibles entre nos diverses Cartes Graphiques. Face au GeForce 6800 Ultra, le GeForce 7800 GTX est ici 8% plus véloce alors qu'il bat le Radeon X850 XT PE de quelques 6%. Le SLI n'apporte strictement rien, la GeForce 7800 GTX seule étant plus performante que deux 7800 GTX réunies. On notera d'ailleurs que nos deux GeForce 6800 GT en SLI font quasiment aussi bien que le GeForce 7800 GTX.

Half-Life 2

Sous Half-Life 2 les écarts de performances se notent principalement en 1600x1200. Là encore la mise en SLI de deux GeForce 7800 GTX n'apporte pas grand chose, la GeForce 7800 GTX seule étant plus performante du moins avec notre démo. Face à son concurrent le plus direct, le Radeon X850 XT PE, le gain de performances ici constaté est assez réduit puisqu'il ne dépasse pas les 3%. Face à l'ancienne génération GeForce, le dernier-né de NVIDIA est 14% plus rapide que le GeForce 6800 Ultra.

Doom 3

On continue avec l'incontournable Doom 3. Comme on pouvait s'y attendre les GeForce sont largement en tête et ce quelque soit la résolution. Le GeForce 7800 GTX apporte ici un gain de performance de près de 31% en 1600x1200 face au GeForce 6800 Ultra. Ces excellentes performances ne permettent toutefois pas à la carte seule de surpasser les performances obtenues avec deux GeForce 6800 GT en SLI. A propos de SLI le fait de coupler deux GeForce 7800 GTX permet d'atteindre de nouvelles performances avec un score ahurissant de 187,5 FPS en 1600x1200 soit un bond de 60% face à la carte seule !

Chronicles of Riddick - Escape from Butcher Bay - SODIMI

Chronicles of Riddick, ici en version 1.1, propose divers modes de rendu en fonction du GPU installé dans votre système. Le mode Shader Model 2+ n'étant pas supporté par les cartes Radeon, nous nous sommes rabattu sur le mode 2.0 pour toutes nos cartes. Les cartes ATI semblent ici bien en peine, le Radeon X850 XT PE ayant les plus grandes difficultés à surpasser son adversaire le GeForce 6800 GT. Le GeForce 7800 GTX affiche ici de très bonnes performances puisqu'il se révèle jusqu'à 33% plus rapide que le GeForce 6800 Ultra en 1600x1200. On notera que malgré ces très bonnes performances, le GeForce 7800 GTX ne fait pas mieux que deux GeForce 6800 GT en SLI. Le SLI justement parlons-en puisque nos deux GeForce 7800 GTX pulvérisent les précédents records : ici le gain enregistré en passant d'une GeForce 7800 GTX à deux frise les 84% en 1600x1200.

Half-Life 2 - FSAA 4x & Aniso 8x

Revenons à Half-Life 2 où les performances en activant les diverses technologies d'anticrénelage sont particulièrement affectées en 1600x1200. Dans les autres résolutions les performances des Cartes Graphiques de dernière génération semblent limitées par le processeur central. En très haute résolution le GeForce 6800 GT montre ses limites alors que le Radeon X850 XT PE fait mieux que deux GeForce 6800 GT en SLI ou qu'une seule GeForce 6800 Ultra. Ici le GeForce 7800 GTX est 48% plus performant que le GeForce 6800 Ultra, mais cet écart retombe à seulement 3% quand on compare le dernier-né de NVIDIA au Radeon X850 XT PE. Enfin la mise en SLI de deux GeForce 7800 GTX permet ici de gagner au mieux 5% de performances.

Far Cry v1.3 - FSAA 4x & Aniso 8x

Sous Far Cry v1.3 en activant le FSAA 4x et l'anisotropic filtering 8x le Radeon X850 XT PE s'en sort toujours bien en dépassant allégrement les GeForce 6800 Ultra et GT. Reste que le nouveau GeForce 7800 GTX fait un peu mieux, sans toutefois atteindre le niveau de performances de deux GeForce 6800 GT en SLI. Si en 1024x768 et en 1280x1024 nos deux GeForce 7800 GTX en SLI n'apporte aucun gain de performance tangible, il n'en va pas de même en 1600x1200 où le framerate est 36% supérieur à celui d'une GeForce 7 seule.

Splinter Cell - Chaos Theory v1.03 - FSAA 4x & Aniso 8x

L'activation de l'Anisotropic Filtering 8x et de l'Antialiasing 4x sous Splinter Cell Chaos Theory propulse, du moins en très haute résolution, le GeForce 7 au sommet avec pour premier constat flagrant que le SLI à base de GeForce 7800 GTX est presque deux fois plus rapide que le GeForce 7800 GTX seul. Ce dernier l'emporte d'ailleurs haut la main sur les GeForce 6 grâce à des performances près de 48% meilleures en 1600x1200.

Doom 3 - FSAA 4x & Aniso 8x

Avec Doom 3 les performances en FSAA 4x & Anisotropic filtering 8x confirment ce que nous observions sans l'antialiasing. Le GeForce 7800 GTX profite d'un gain assez intéressant qui atteint 20% face au GeForce 6800 Ultra. Les cartes ATI referment ici la marche, et le SLI à base de GeForce 7800 GTX s'adjuge la première marche du podium. Face à une seule GeForce 7800 GTX, le SLI offre un gain de près 33%.

Splinter Cell Chaos Theory - v1.03 - Rendu Shader Model 3.0

Pour clôturer notre série de tests, nous nous repenchons sur Splinter Cell Chaos Theory en activant cette fois-ci le mode de rendu Shader Model 3.0 qui permet notamment de profiter du HDR. On notera d'ailleurs que comme nous le signalions déjà lors du test du jeu certains effets graphiques en Shader Model 3.0 sont quelque peu exagérés. Les cartes ATI ne supportant pas ce mode, elle ne figure pas dans le graphique. L'intérêt de ce test est de mesurer les progrès accomplis entre le GeForce 6 et le GeForce 7 en ce qui concerne la rapidité d'exécution des shaders. On constate ici un net progrès puisqu'en 1600x1200 le GeForce 7800 GTX est 45% plus rapide que le GeForce 6800 Ultra, sans toutefois rivaliser avec le GeForce 6800 GT en SLI. La mise en SLI de deux GeForce 7800 GTX permet d'obtenir un gain tout à fait intéressant, de l'ordre de 92% ! On le voit le SLI s'il ne profite pas à tous les jeux, semble particulièrement taillé ceux qui font un usage intensif des Shaders.

Conclusion

Nous voilà arrivé au terme de cet article sur le GeForce 7 et pour ceux d'entre vous qui n'auraient parcouru que les benchs, je vais tâcher de résumer la situation en me mettant dans la peau d'un grand chef cuisinier. Selon le vieil adage « c'est dans les vieux pots qu'on fait les meilleures soupes », NVIDIA a littéralement repris les bases de l'architecture du GeForce 6 pour concevoir son successeur que certaines mauvaises langues baptiseront GeForce 6900. Certes il y a bien une pincée de pixel pipelines en plus, un soupçon de vertex engines supplémentaires et un nuage d'ALU optimisée, le tout saupoudré de quelques nouvelles fonctions et mijoté à feu doux en 0,11µ mais au final le GeForce 7 n'est ni plus ni moins qu'un GeForce 6 revu et corrigé. On y retrouve essentiellement plus de puissance pour affronter les shaders, particulièrement en version 3.0, la bête noire de la série précédente. Avec des performances jusqu'à deux fois supérieures, qui se ressentent essentiellement dans les jeux les plus gourmands faisant massivement appel aux shaders et lorsque le système n'est pas limité par le processeur central, le GeForce 7 a de quoi séduire. D'autant que la sagesse des équipes de design de NVIDIA a fait que la carte est pour une fois plutôt attractive. Pensez-vous un GeForce compact, peu bruyant et qui ne chauffe pas trop, on avait pas vu ça depuis trop longtemps !Bien sûr le SLI est toujours d'actualité avec cette nouvelle génération et permet des gains sensibles plus particulièrement avec les programmes qui font appel, une fois encore, aux Pixel Shaders. Si le SLI est toujours aussi efficace en terme de gain de performances il conserve néanmoins les mêmes inconvénients à savoir les contraintes thermiques/accoustiques et énergétiques, la nécessité de recourir systématiquement à des profils ou bien le fait qu'il n'est opérationnel que sur des Cartes mères à base de chipset nForce 4 SLI. NVIDIA promet de corriger à l'avenir certains défauts du SLI et il nous tarde que la firme au caméléon s'exécute sur ce point précis, même si le SLI se destine aujourd'hui à un public très fortuné. Avant de passer aux quelques regrets que nous pouvons avoir il nous faut évoquer PureVideo. Avec le GeForce 7 PureVideo commence à prendre tournure et si tout n'est pas encore très clair notamment au niveau du support H.264, faute de médias, la volonté de NVIDIA d'ouvrir sa technologie à des partenaires est louable tout comme son intégration dans toute la gamme du GeForce 6200 au Quadro 4400 SDI... Grâce aux divers SDK et au recrutement massif que NVIDIA opère actuellement dans ce domaine, PureVideo commence à trouver un débouché dans le monde professionnel ou divers plugins existent déjà pour exploiter les capacités des puces NVIDIA sur des applications comme Premiere Pro. A l'avenir on pourrait retrouver PureVideo dans des applications grand public comme Studio et qui sait le SLI pourrait un jour profiter à PureVideo, ce qui n'est hélas pas le cas aujourd'hui.

Malgré ce bilan positif il ne faut pas oublier que NVIDIA n'est pas seul et que certains points du GeForce 7 laissent sérieusement à désirer. On regrettera par exemple le conservatisme de NVIDIA dans le choix de la fréquence tout comme l'absence d'évolution du contrôleur mémoire qui demeure identique pour une bande passante en très légère hausse. Cela permet certes de proposer une carte plutôt silencieuse, qui ne consomme pas plus que les GeForce 6 actuelles, mais cela sera-t'il suffisant pour combattre le futur R520 d'ATI qui ne devrait plus trop tarder ? Car tout est là si aujourd'hui le GeForce 7800 GTX est assurément la puce graphique la plus rapide, qu'en sera-t'il face à la prochaine génération d'ATI ? En cas de besoin NVIDIA pourrait évidemment sortir de son chapeau un GeForce 7 Ultra au risque de massacrer son rendement et de chambouler ses gammes, mais cela sera peut être un mal nécessaire... Côté tarif le prix public européen tourne autour des 549€ TTC ce qui est certes élevé mais constitue depuis quelque temps déjà le prix communément admis pour un GPU haut de gamme. Enfin on décernera un bon point à NVIDIA puisque comme promis les cartes sont disponibles le jour du lancement.

Le GeForce 7800 GTX de NVIDIA vous intéresse ? Retrouvez la dans le comparateur de prix de Clubic.com