Les ordinateurs portables NVIDIA Optimus comportent en effet deux puces graphiques : la première est l'IGP, c'est-à-dire le circuit graphique intégré Intel, la seconde est une puce GeForce. Ce n'est pas franchement nouveau me direz-vous. Exact, sauf que jusqu'à présent le passage d'une solution graphique à l'autre se faisait manuellement, il fallait donc y penser, avec parfois un redémarrage du système, la fermeture des applications en cours d'exécution ou parfois un écran qui reste noir de longues secondes.

Avec Optimus, NVIDIA propose un passage à la volée d'une solution graphique à l'autre : l'utilisateur n'a plus à se soucier de rien alors qu'Optimus ouvre la voie à des ordinateurs portables équipés de solutions GeForce dont l'autonomie n'a rien à envier aux canons du genre. Gros plan sur cette technologie.

NVIDIA Optimus : le principe

NVIDIA se propose donc de rendre ce passage transparent pour l'utilisateur puisque le pilote graphique fait tout, tout seul, en tâche de fond. Mais encore plus intéressant, c'est la puce graphique intégrée Intel qui est utilisée la plupart du temps, ce qui est plutôt une bonne chose vu qu'elle ne consomme rien et suffit en 2D, alors que le pilote NVIDIA n'activera le circuit GeForce embarqué que lorsque le besoin de puissance 3D est réel : accélération de la technologie Flash, décodage vidéo, jeu vidéo ou création 3D ne sont que quelques exemples.

NVIDIA Optimus : la technologie détaillée

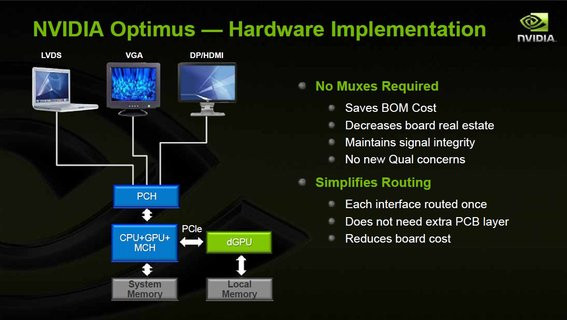

L'un des principes les plus déroutants de la technologie Optimus est à n'en pas douter le fait que la puce graphique Intel est toujours utilisée, tout le temps. C'est donc la puce graphique Intel qui gère l'affichage et la résolution de ce dernier même lorsque le GeForce est mis à profit. C'est pour cette raison que la technologie Optimus est plus facile à implémenter, d'un point de vue constructeur, puisqu'au contraire de l'Intel Switchable Graphics il n'est pas nécessaire d'ajouter des multiplexeurs sur la carte mère de l'ordinateur ni de tracer de nouvelles routes sur celle ci.Techniquement, lorsque le GeForce est utilisé pour un rendu 3D, il doit copier son rendu dans la mémoire du circuit graphique Intel afin que ce dernier affiche le résultat de son travail à l'écran. Problème avec une puce graphique GeForce standard : cette opération met en pause le reste des tâches de rendu 3D ce qui amoindrirait considérablement les performances.

Du coup NVIDIA implémente un moteur asynchrone de copie, le Copy Engine : celui-ci va se charger d'envoyer les données issues du moteur 3D à la mémoire système, sans bloquer le travail de rendu de la puce graphique. On peut alors redouter un éventuel impact négatif sur les performances lié à la bande passante du bus PCI-Express utilisé pour la communication entre la puce NVIDIA et le circuit graphique intégré d'Intel. Légitime, cette crainte n'est toutefois pas fondée avec un lien PCI-Express 16x de seconde génération qui offre une bande passante de 8 Go/s, dans chaque voie. Si le bus n'est pas un souci, l'opération de copie ajoute effectivement un certain temps de latence de l'ordre de 3ms selon NVIDIA. Notez que toutes les dernières puces graphiques NVIDIA à destination des ordinateurs portables sont dotées du Copy Engine.

Revers de la médaille pour NVIDIA : en choisissant de toujours utiliser la puce Intel, cette dernière est toujours alimentée, même lorsque le circuit GeForce s'enclenche. Dans ce cas de figure donc ce sont donc deux puces qui se trouvent alimentées et non une seule...

NVIDIA Optimus : l'implémentation logicielle

Nous l'avons vu, l'infrastructure matérielle pour implémenter la technologie NVIDIA Optimus est relativement légère. Côté logiciel en revanche, les choses se compliquent quelque peu. Le pilote graphique NVIDIA se place en aval de DirectX et va s'occuper de router le rendu 3D vers la puce graphique NVIDIA lorsque cela est nécessaire.

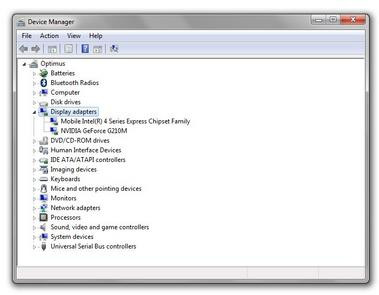

Le gestionnaire de périphériques Windows : deux puces graphiques dans un seul portable

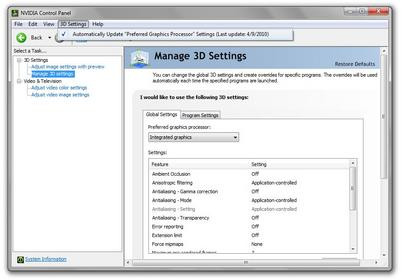

Pour ce faire, le pilote NVIDIA fait appel à une liste de profils stockés à distance sur un serveur et récupérés via une connexion Internet de manière régulière. Le pilote va alors identifier les applications et les jeux qui peuvent bénéficier d'une accélération GPU. Dans ce cas, le pilote NVIDIA démarre automatiquement la puce graphique et commence à effectuer le rendu en lieu et place du circuit graphique Intel. On notera au passage que l'opération de mise en route de la puce graphique NVIDIA prend environ 200 ms.

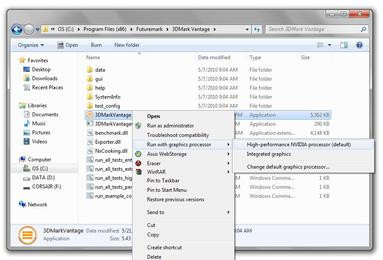

Naturellement, il est possible de créer manuellement ses propres profils, si besoin. De plus, les pilotes NVIDIA ajoutent sur les machines Optimus une commande additionnelle au menu contextuel Windows, permettant à l'utilisateur de choisir si l'application va s'exécuter avec la puce Intel ou la puce GeForce. Reste que pour être totalement pertinente, la technologie Optimus de NVIDIA nécessite des mises à jour logicielles. Ca tombe bien puisque NVIDIA proposera prochainement, dans le cadre de son programme Verde, des mises à jour régulières de ses pilotes pour les ordinateurs portables.

NVIDIA Optimus : seulement pour Intel !

Pour cette première implémentation de sa technologie Optimus, NVIDIA se limite à la seule prise en charge de la plate-forme mobile Intel. La firme au caméléon prend en charge les ordinateurs portables équipés des plate-formes Intel Arrandale (Core i3/i5/i7), Intel Penryn (Core 2 Duo) et Intel PineTrail (Atom N4xx). Exit donc les plate-formes mobiles AMD, un choix qui semble plus politique et stratégique que véritablement justifié par des limitations techniques.Un premier portable Optimus : l'UL50Vf d'Asus

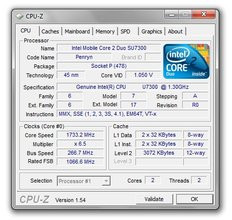

Asus propose avec l'UL50Vf une version NVIDIA Optimus de son UL50Vt, un ordinateur avec écran 15,6 pouces et processeur double-cœur, Intel Core 2 Duo SU7300 (à 1,3 GHz). Affichant une résolution de 1366x768 pixels, l'écran bénéficie d'un traitement brillant, une particularité qui ne plaira pas à tout le monde. Doté d'un chipset Intel GS45, l'ordinateur d'Asus ne se distingue pas extérieurement de l'UL50Vt. On est donc en présence d'un portable plutôt sobre, d'aucuns diront austère, dont la coque métallique brossée révèle un clavier chiclet entouré par un revêtement de plastique noir brillant.

Avec de larges repose-poignets, le portable comporte un touchpad multipoint dont la finition est invisible : il est intégré au châssis et se matérialise simplement par une zone comportant quelques picots. Agréable à utiliser, notamment avec ses gestes à la Apple (deux doigts font défiler les ascenseurs dans n'importe quelle application), le touchpad ne saurait faire oublier l'absence de rétroéclairage du clavier : difficile de frapper les bonnes touches dans le noir.

Pourvu d'un bouton de mise en route, d'un bouton Turbo et de quatre diodes de fonctionnement, l'UL50Vf d'Asus se distingue par son pavé numérique intégré. Côté connectique, on retrouve trois ports USB 2.0, un connecteur HDMI, une prise VGA, un lecteur de cartes mémoires au format SecureDigital (compatible MMC et Memory Stick), un connecteur RJ45 et deux prises mini-jack pour casque et microphone.

Détails sur l'Asus UL50Vf

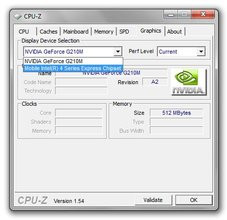

Equipé d'un lecteur optique des plus standards et d'un disque dur 320 Go (5400rpm), le portable, s'il ne change guère par rapport au modèle UL50Vt, profite d'une carte mère dont la conception a évolué pour se débarrasser des circuits inutiles au fonctionnement de la technologie Optimus. Avec 4 Go de mémoire vive, l'UL50Vf dispose d'une carte graphique GeForce G210M embarquant 512 Mo de mémoire vidéo dédiée. Techniquement, la puce GeForce compte 16 cœurs d'exécution CUDA. C'est peu, et les fréquences de fonctionnement sont elles aussi réduites : 606 MHz pour la puce graphique, 1468 MHz pour les unités de shaders et 790 MHz pour la mémoire accompagnant la puce. Mémoire qui au passage est interfacée en 64 bits. La bande passante mémoire ne sera donc pas exceptionnelle, loin de là, alors que la puce graphique est connectée au reste du système par une liaison PCI-Express 8x. En clair, les performances 3D du petit dernier d'Asus ne devraient guère donner le tournis.

Parmi les autres équipements du portable Asus, signalons la présence d'un circuit Bluetooth, l'inclusion d'une webcam 1,3 Mégapixels tout à fait moyenne qui ne possède pas de témoin d'activité, ou encore la présence d'un circuit Wi-Fi de classe i802.11n et signé Atheros. Et Asus de proposer sa technologie ExpressGate sur son UL50Vf pour permettre l'accès immédiat, dès la mise sous tension de l'ordinateur, à certaines fonctions comme un navigateur Web ultra-léger ou des fonctions de voix sur IP par Skype.

Mise à jour du 10 mai 2010 : Asus France nous indique que l'UL50VF ne sera finalement jamais commercialisé. Le constructeur propose toutefois d'autres modèles Optimus avec les N61JV et N71JQ.

Optimus à l'épreuve du feu !

Durant nos tests, la technologie Optimus s'est montrée relativement convaincante. Tout l'intérêt d'Optimus est le passage à la volée d'un rendu effectué par le circuit graphique Intel intégré au rendu effectué par la puce graphique NVIDIA. De ce côté-là, pas de souci : le système mis au point par NVIDIA semble opérationnel puisque nous n'avons rencontré aucun problème lors du passage de Windows à un jeu comme World In Conflict par exemple. Le temps de chargement du jeu est dans la moyenne et l'initialisation du circuit graphique ne semble pas ralentir outre mesure son démarrage.Même chose pour une application moins typée qu'un jeu : la puce NVIDIA s'enclenche de manière totalement transparente lorsque sous Internet Explorer nous lançons la lecture d'une vidéo Flash sur YouTube (via Flash 10.1 Beta). Si le passage du circuit graphique intégré à la puce NVIDIA se fait effectivement de manière invisible et automatique pour l'utilisateur, celui-ci s'en apercevra tout de même au bout de quelques minutes : le système de ventilation du portable ayant tendance à se faire entendre dès lors que le GeForce prend du service.

Au fil de nos tests nous sommes tout de même tombés sur quelques limitations ennuyeuses de la technologie NVIDIA Optimus. Tout d'abord lorsque l'ordinateur portable est relié à un écran en HDMI, la puce graphique NVIDIA est active, tout le temps et ce même si nous ne faisons rien. De plus, puisque c'est la puce Intel qui gère in-fine la gestion de l'affichage sur le moniteur final, on retrouve les mêmes limitations que sur les GMA traditionnels. Impossible par exemple de connecter un écran dont la résolution d'affichage est supérieure à 1920x1200 pixels. Les circuits graphiques d'Intel ne sont pas compatibles avec le Dual-Link DVI, une norme pourtant standardisée sur toutes les puces graphiques depuis l'époque des GeForce 7 !

Enfin, nous avons testé la lecture d'un Blu-ray avec PowerDVD 10 et notre système Optimus. La puce graphique NVIDIA est effectivement mise à contribution et l'utilisation processeur moyenne tourne autour des 22% lors de la lecture de notre Blu-ray de référence, Casino Royale.

PowerDVD 10 : lecture de Blu-ray sur portable Optimus

Les performances... de l'intérêt d'une puce graphique dédiée

- Processeur Intel Core 2 Duo SU7300,

- 4 Go Mémoire DDR3-1066,

- Intel GMA4500HD ou GeForce G210M

- Disque dur 300 Go

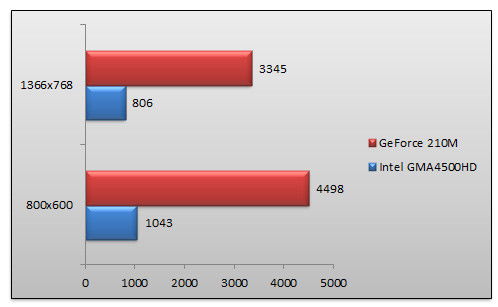

3DMark 06

Premier test de ce rapide survol des performances graphiques de l'Asus UL50Vf : 3DMark est sans appel. Le GeForce G210M, bien que des plus modestes, mouche littéralement le circuit graphique Intel avec des performances au bas mot quatre fois supérieures.

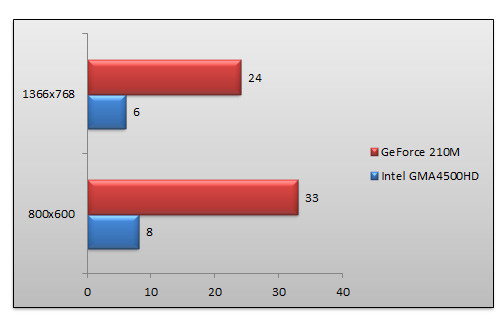

World In Conflict - Réglages moyens

Fameux jeu de stratégie, World In Conflict n'est pas plus tendre avec le GMA 4500 HD d'Intel ! Là aussi les performances du GeForce G210M sont ébouriffantes face au GMA d'Intel : le nombre d'images à la seconde étant quatre fois supérieur au poussif GMA.

Ces deux tests confirment une fois de plus, les piètres prestations des puces graphiques d'Intel dont les performances sont tout bonnement insuffisantes pour faire convenablement tourner le moindre jeu.On rappelera au passage que World In Conflict est un jeu sorti... en début d'année 2007 ! Tout cela vient évidemment conforter la démarche de NVIDIA en démontrant l'intérêt de pouvoir passer à la volée sur un circuit graphique dédié lorsque le besoin de puissance se fait sentir, alors que l'usage de la puce Intel sera parfaitement satisfaisant pour les tâches bureautiques quotidiennes.

Quid de l'autonomie ?

Un mot enfin sur l'autonomie, une valeur que nous avons mesuré avec le programme BatteryEater. Hélas celui-ci a refusé de s'exécuter sur le GeForce G210M. L'autonomie que nous avons donc mesurée est celle du portable Asus UL50Vf en mode Power4Gear Battery Saving et en utilisant le GMA 4500 HD d'Intel donc. Ainsi, nous avons obtenu une autonomie de 4 heures et 32 minutes avant l'arrêt pur et simple de Windows. Naturellement, la luminosité de l'écran était fixée à une valeur moyenne alors que le Bluetooth était désactivé. Le Wi-fi était en service et connecté.Conclusion

Il s'agit bien sûr de répondre en premier lieu aux problématiques d'autonomie en utilisant la puce graphique, nécessairement plus gourmande que le circuit graphique intégré, uniquement lorsque celle-ci est véritablement nécessaire. Toute la force de la technologie Optimus réside dans l'élégance de son implémentation puisque le passage d'une puce à l'autre se fait de manière transparente et automatique pour l'utilisateur. Si précédemment, l'utilisateur devait lui-même penser à passer d'une solution graphique à l'autre en changeant le mode d'alimentation de son ordinateur portable, ce qu'il ne faisait en vérité jamais, la solution Optimus le fait à sa place, au moment opportun.

Qui plus est, l'activation ou la désactivation de la puce graphique NVIDIA se fait sans impacter le travail de l'utilisateur, l'écran ne passant pas au noir ou ne clignotant pas contrairement à ce qui se passe généralement avec les ordinateurs portables équipés de l'Intel Switchable Graphics.

Reste qu'on ne peut s'empécher de faire le parallèle avec les derniers ordinateurs portables d'Apple, les célèbres MacBook Pro. Ceux-ci disposent en effet d'une technologie similaire à Optimus mais vraisemblablement plus aboutie encore : le passage au circuit graphique dédié désactive automatiquement la puce graphique intégrée Intel alors qu'Apple a pris soin de gérer les cas particuliers comme les écrans 30 pouces utilisant une connectique DVI Dual-Link.