Moins de deux mois après le lancement du GeForce GTX 680 et donc de l'architecture Kepler, NVIDIA revient sur le devant de la scène et complète par le haut la famille GeForce 6 ! Une façon de procéder inattendue puisque l'on attendait plutôt les déclinaisons milieu de gamme de Kepler à destination des PC de bureau.

Qu'importe, en attendant un éventuel GeForce GTX 670, NVIDIA nous propose sa solution très haut de gamme avec une carte graphique de tous les superlatifs ou presque. Car non content de réunir deux GeForce GTX 680 sur une même carte, NVIDIA a particulièrement soigné le design et la finition de celle-ci en employant des matériaux particulièrement nobles, une première pour une carte graphique. Mais le ramage se rapporte-t-il au plumage ? C'est précisément la question qui nous animera dans les pages qui suivent alors que le prix de la carte s'annonce record : autour des 1000 euros !

GeForce GTX 690 : deux c'est mieux qu'un !

On l'avait souligné dans notre récent dossier consacré à Kepler et au GeForce GTX 680 (voir NVIDIA GeForce GTX 680 : la réponse au Radeon HD 7970 ?) : la dernière architecture en date de NVIDIA affiche de très bonnes prestations en terme de consommation électrique et d'échauffement. C'est précisément grâce à ces aptitudes, en partie expliquées par la gravure en 28nm, que la firme au caméléon est en mesure de nous proposer une carte bi-GPU, dont les spécifications de chacune des puces sont identiques à celles du GeForce GTX 680.Les deux puces GK104 qui animent la GeForce GTX 690 ne souffrent donc d'aucune amputation d'aucune sorte et sont pleinement fonctionnelles. C'est ainsi que l'on retrouve 1536 cœurs d'exécution CUDA, 128 unités de texture et 64 ROP par puce. Le bus mémoire reste interfacé sur 256 bits et chaque puce dispose de 2 Go de GDDR5.

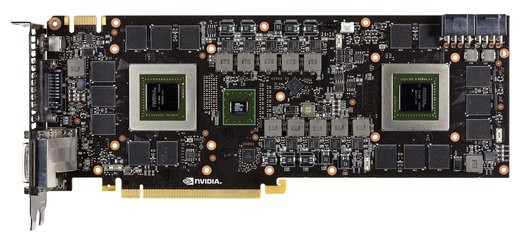

La carte mise à nue

Seule concession opérée par NVIDIA : la fréquence de fonctionnement qui est revue à 915 MHz pour chaque puce, soit en dessous des 1006 MHz du GeForce GTX 680. De son côté, la fréquence GPU Boost est annoncée à 1019 MHz, soit 9 petits MHz de plus que la même GTX 680. En théorie donc, à supposer que les puces de la GeForce GTX 690 opèrent tout le temps à leur fréquence maximale GPU Boost, les performances devraient être supérieures à celles d'un SLI de GeForce GTX 680. C'est ce qu'indique du reste NVIDIA dans sa communication officielle. En pratique, on sait très bien que ce scénario est peu crédible puisque le GPU Boost n'est qu'un artifice marketing où la fréquence annoncée de 1019 MHz n'est jamais maintenue constante, mais varie en permanence à la hausse ou à la baisse et dépend de plusieurs facteurs : de la qualité de la puce graphique et son aptitude à effectivement monter en fréquence, de l'environnement thermique de la carte, etc.

| Radeon HD 7970 | GeForce GTX 590 | GeForce GTX 680 | GeForce GTX 690 | |

| Interface | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen2 | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen3 |

| Gravure | 0,028 µ | 0,040 µ | 0,028 µ | 0,028 µ |

| Transistors | 4,3 Milliards | 3 Milliards (par puce) | 3,54 Milliards | 3,54 Milliards (par puce) |

| T&L | DirectX 11.1 | DirectX 11 | DirectX 11.1 | DirectX 11.1 |

| Stream Processors | 2048 | 1024 | 1536 | 3072 |

| Unités ROP | 32 | 96 | 32 | 64 |

| Unités de texture | 128 | 128 | 128 | 256 |

| Mémoire embarquée | 3072 Mo | 3072 Mo | 2048 Mo | 2048 Mo (par puce) |

| Interface mémoire | 384 bits | 768 bits | 256 bits | 512 bits |

| Bande passante | 264 Go/s | 327 Go/s | 192,26 Go/s | 358 Go/s |

| Fréquence GPU | 925 MHz | 607 MHz | 1006 MHz (base) | 915 MHz (base) |

| Fréquence Stream Processors | 925 MHz | 1215 MHz | 1006 MHz (base) | 915 MHz (base) |

| Fréquence mémoire | 1375 MHz - GDDR5 | 850 MHz - GDDR5 | 1502 MHz - GDDR5 | 1502 MHz - GDDR5 |

En ce qui concerne la mémoire, les fréquences sont identiques à ce que NVIDIA propose avec le GeForce GTX 680 soit 1503 MHz. À noter, l'utilisation par NVIDIA d'un nouveau type de bridge PCI-Express en remplacement de ses anciens bridges maison. Les puces GK104 bénéficiant d'une interface PCI-Express 3.0 native, NVIDIA a recours à un bridge tiers PLX compatible PCI-Express 3.0.

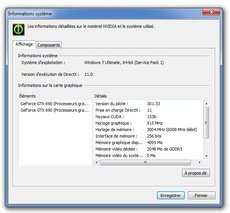

La carte vue par les pilotes NVIDIA

GeForce GTX 690 : une carte à la finition exceptionelle

Au-delà des spécifications techniques finalement sans surprise, c'est le design de la carte qui étonne, dans le très bon sens du terme. Ne tournons pas autour du pot, la GeForce GTX 690 est de mémoire de journaliste, la carte graphique la mieux finie jamais passée à la rédaction de Clubic. Si le look volontairement inspiré du monde de l'automobile est finalement très masculin, c'est la qualité des matériaux retenus qui force le respect.Avec un PCB de 28 centimètres, la carte est aussi longue que la GeForce GTX 590 qui la précède. On retrouve du reste une conception similaire en ce qui concerne le système de refroidissement avec un ventilateur central alors que la carte n'occupera pas plus de deux emplacements dans votre tour. Si dans les grandes lignes le système de refroidissement ne subit aucun changement significatif dans sa conception, les matériaux employés sont incomparables.

Chaque puce graphique est surmontée d'un radiateur aux ailettes nickelées alors que le concept de chambre à vapeur est bien entendu d'actualité pour chacun des radiateurs. Le support central pour le large ventilateur est usiné de sorte à créer des flux d'air alors que l'ensemble de la chambre accueillant le ventilateur est fait d'un alliage de magnésium. Selon NVIDIA l'utilisation de ce matériau permet de maximiser la dissipation de la chaleur tout en absorbant mieux les vibrations. Quant au ventilateur, il est annoncé comme disposant d'ailettes optimisées pour un meilleur angle de pénétration du flux d'air.

Pour ce système de refroidissement, le carter de protection est fait d'aluminium chromé, avec deux vitres en polycarbonate sur chacun des radiateurs. Robuste, sans le moindre plastique mal clipsé ou mal ajusté, l'ensemble est effectivement d'une qualité jamais vue pour une carte graphique. Mais... une fois la carte installée dans votre tour, cela a-t-il vraiment de l'importance ? Nous vous laisserons répondre à cette question et pour ce qui nous concerne nous regrettons l'absence d'une plaque de protection au dos du PCB de la carte. À ce niveau de finition c'est tout de même dommage.

Avec un connecteur SLI sur sa tranche (oui il est possible de faire du Quad-SLI), la carte profite d'un logo GeForce GTX qui s'allume dès la mise sous tension du système. Son alimentation électrique passe par deux connecteurs PCI-Express à 8 broches chacun et l'on trouve en sortie trois connecteurs DVI Dual-Link et un connecteur mini-DisplayPort. Le poids de la carte, pour les amateurs de ce genre de données est de 1030 grammes : c'est 12 grammes de moins que la GeForce GTX 590.

Techniquement, le PCB de cette GeForce GTX 690 est composé de dix couches, et d'un étage d'alimentation sur 10 phases. Le TDP de la carte est annoncé à 300 Watts par NVIDIA : c'est beaucoup certes, mais moins que les 365 Watts de la GeForce GTX 590 ! Quant aux nuisances de la carte elles sont en fonctionnement particulièrement bien contenues : l'échauffement se situe en général autour des 72° C en charge tandis que le refroidissement s'avère assez silencieux. Sous Windows, le ventilateur dépasse rarement les 1200 tours/minute alors qu'il va bien sûr accélérer en charge autour des 2000 tours/minute : à ce niveau la carte se fait entendre, mais nous semble dans les faits plus silencieuse qu'un SLI de GeForce GTX 680.

NVIDIA GPU Boost

Dans les faits, la fréquence GPU Boost ne correspond pas à grand-chose : la puce est certifiée pour l'atteindre, mais aussi et surtout la dépasser. En réalité, la fréquence de fonctionnement de la puce varie en permanence en fonction des paramètres précités et de la complexité graphique de la scène, à la hausse ou à la baisse par rapport au GPU Boost annoncé.

Observation des variations de fréquence liées à GPU Boost : d'un GPU à l'autre, la fréquence maximale n'est pas la même

Sur notre exemplaire de test, on a pu voir un comportement différent d'une puce à l'autre pour notre GeForce GTX 690. Ainsi la première puce oscille entre une fréquence de 1058 MHz au plus haut et 1019 MHz au plus bas avec une stabilité certaine autour de 1032 MHz quand la deuxième puce semble tourner de manière assez stable à 1058 MHz. Ici, c'est la température qui semble influer sur le GPU Boost puisque dès que nous dépassons les 70° C la fréquence chute.

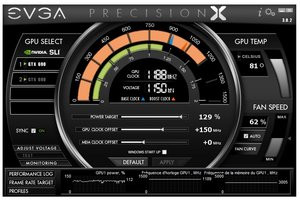

Overclocking

Du côté de l'overclocking, en passant par l'utilitaire Precision Tool d'EVGA nous avons pu augmenter la fréquence des puces de 100 MHz dans un premier temps et même 150 MHz, en jouant naturellement sur le seuil de tolérance du TDP. Au-delà, et alors que les puces flirtent avec les 80° C la stabilité n'était plus au rendez-vous. Nous avons donc pu atteindre un maximum de 1201 MHz pour la première puce et 1189 MHz pour la seconde lors de nos tests avec bien sûr des oscillations en fonction de la charge notamment.

Tentatives d'overclocking du GeForce GTX 690 : +150 MHz

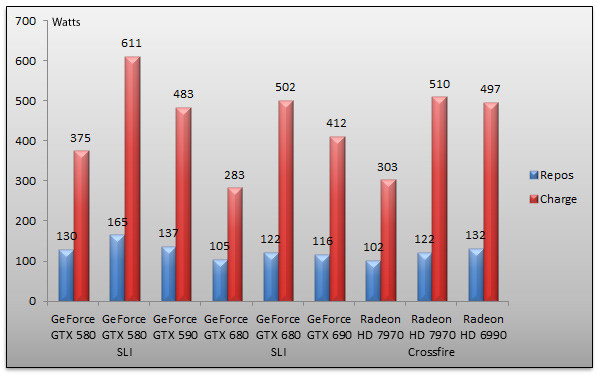

Consommation

Comme à notre habitude, nous avons vérifié la consommation électrique de nos cartes graphiques. Nous procédons à deux mesures : au repos, sur le bureau Windows, puis en charge avec un 3DMark 11 Extreme s'exécutant en 2560x1600. La mesure est effectuée à la prise, au moyen d'un wattmètre. Il s'agit donc de la consommation électrique globale de notre machine de test.

Le premier enseignement est la baisse de la consommation des solutions multi-GPU au repos. Quand notre SLI de GeForce GTX 580 faisait consommer 165 Watts au repos à notre système, le SLI de GeForce GTX 680 n'en fait consommer plus que 122 Watts contre 116 Watts pour le GeForce GTX 690. Chez AMD, le CrossFire de Radeon HD 7970 consomme en veille 122 Watts soit autant que le SLI de GeForce GTX 680. Naturellement cette baisse de la consommation se retrouve également en charge. 611 Watts... c'est la consommation de notre SLI de GeForce GTX 580, notre compteur EDF en frétille encore ! Le SLI de GeForce GTX 680 ne consomme plus que 502 Watts quand la GeForce GTX 690 consomme 412 Watts dans les mêmes conditions. C'est un bon point, d'autant que la précédente carte bi-GPU, la GeForce GTX 590 consomme tout de même 483 Watts en charge... La consommation des solutions bi-GPU en charge est à peu près identique chez AMD : 510 Watts pour le Crossfire de Radeon HD 7970 et 497 Watts pour la vieillissante Radeon HD 6990.Au cœur de ce test, nous retrouvons le sujet des performances. Voici la configuration utilisée :

- Carte mère Asus Maximus Rampage IV Extreme (BIOS 1202),

- Processeur Intel Core i7 3960X,

- 16 Go (4x 4 Go) Mémoire DDR3-1600 Corsair @ 1600,

- SSD Samsung Serie 830 256 Go

Côté pilotes, nous avons utilisé les 12.3 finaux et les pilotes NVIDIA 301.10 pour l'ensemble des GeForce, la GeForce GTX 690 étant testée avec les pilotes 301.33. Naturellement la machine opérait sous Windows 7 Edition Intégrale avec Service Pack 1 x64. Nous retenons deux résolutions pour ce test : le 1920x1080 des écrans 23,6/24 pouces notamment, et le 2560x1600.

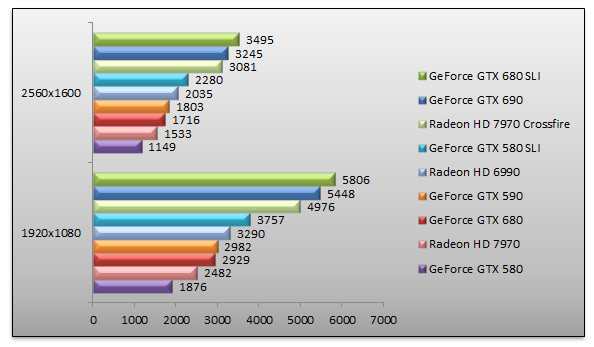

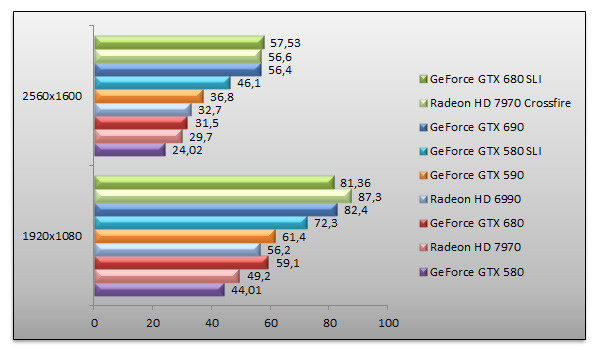

3DMark 11 - Mode Extrême

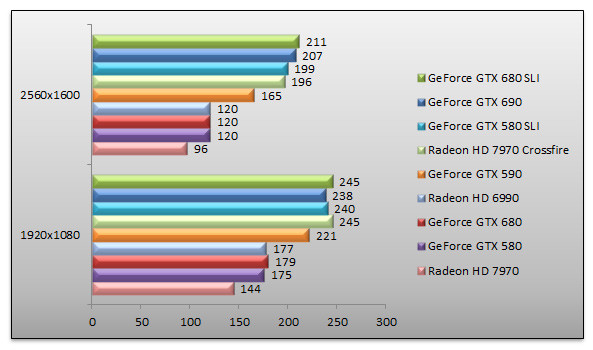

On commence avec un classique 3DMark 11. En tête, le SLI de GeForce GTX 680 suivi de la GeForce GTX 690. L'écart de performance est ici de 7%. Face à une GeForce GTX 680 seule, la GeForce GTX 690 se montre 89% plus véloce. Face au Crossfire de Radeon HD 7970, la nouvelle GeForce GTX 690 est 5% plus rapide.

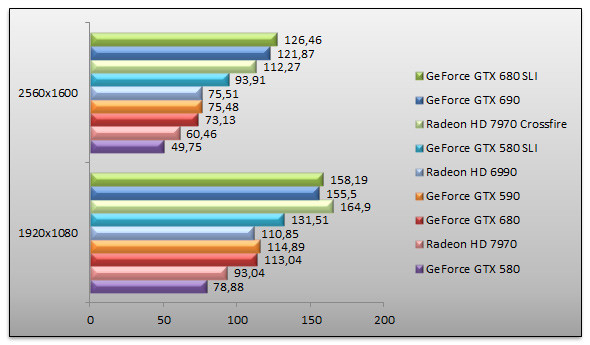

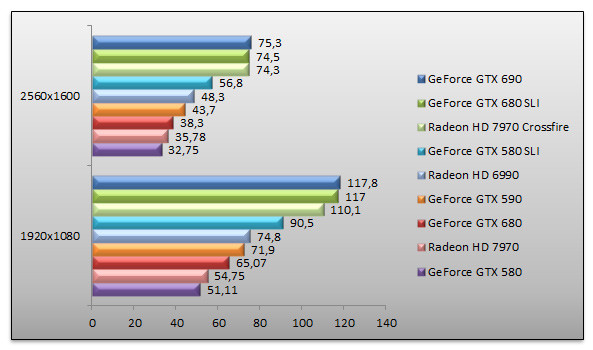

Dirt 3 - Ultra - 4x

Le jeu de courses Dirt 3 a ceci d'intéressant qu'il profite de DirectX 11. Nous l'exécutons ici avec les réglages les plus élevés. En tête, nous retrouvons le SLI de GeForce GTX 680 avec des performances 3% supérieures à la GeForce GTX 690 qui arrive en seconde position. À noter le très bon score du Crossfire de Radeon HD 7970 en 1920x1080, un score qui, hélas, ne suit pas en 2560x1600, la solution bi-GPU d'AMD tombant alors à la troisième place. Face au GeForce GTX 680, le GeForce GTX 690 est 66% plus rapide.

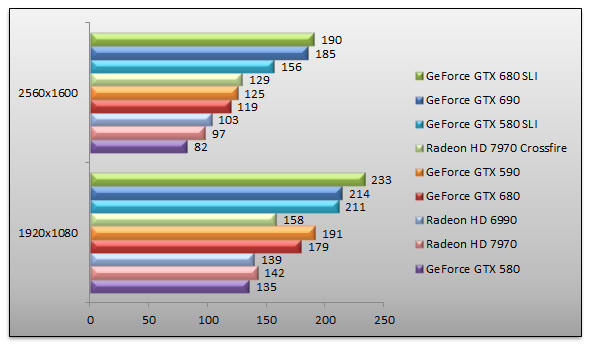

Mafia II - AA - AF 16x

Retour sous Mafia II où l'on constate qu'en 1920x1080 les solutions bi-GPU d'AMD semblent avoir un problème de performance : le Crossfire de Radeon HD 7970 affiche des résultats à peine 27% supérieurs à la Radeon HD 7970 quand cet écart grimpe à 75% entre les deux configurations en 2560x1600. Bref. Le SLI de GeForce GTX 680 reste premier, alors que la GeForce GTX 690 est littéralement à égalité. Face au GeForce GTX 680, le GeForce GTX 690 est 73% plus performant en 2560x1600.

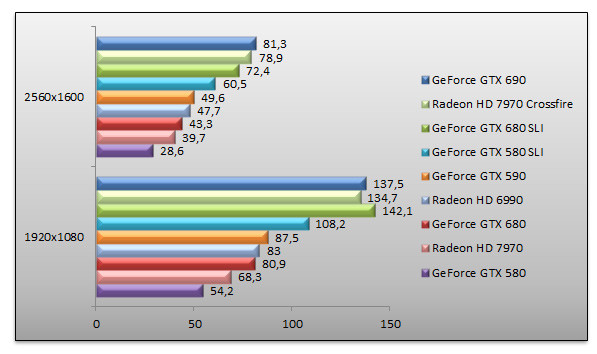

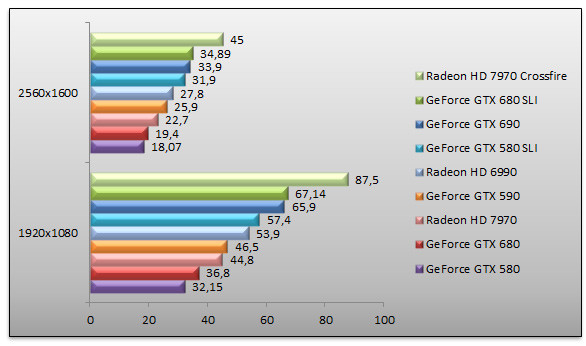

Unigine 2.5 - Heaven - High - AF 16x

Unigine est peut-être plus synthétique que pratique, en attendant il évalue les performances de nos puces graphiques notamment en matière de géométrie. Le test donne lieu à quelques surprises : si le GeForce GTX 690 domine les débats en 2560x1600, le SLI de GeForce GTX 680 SLI semble nettement plus rapide en 1920x1080. Quant au Crossfire de Radeon HD 7970 il n'est franchement pas loin, la GeForce GTX 690 étant tout juste 3% plus rapide en 2560x1600. Reste que face au GeForce GTX 590, la petite dernière de NVIDIA est 64% plus rapide.

Batman Arkham City - FXAA - MVSS - HBAO

Le dernier épisode de Batman donne sa préférence au SLI de GeForce GTX 680. Nos deux cartes sont en tête alors que la petite dernière, à savoir la GeForce GTX 690 termine deuxième. Ici le SLI de GeForce GTX 680 affiche des performances 1,6% supérieures à la nouvelle solution bi-GPU de NVIDIA. Autant dire pas grand-chose. Face au Crossfire de Radeon HD 7970, la GeForce GTX 690 est 18% plus rapide. À noter le gain de performances de la GeForce GTX 690 face à la GeForce GTX 590 : 53%.

Crysis 2 - DirectX 11 - Ultra - Textures HR

Crysis dans sa dernière mouture est ici testé avec FRAPS, toutes options à fond, le mode DirectX 11 étant bien entendu actif. Le SLI de GeForce GTX 680 se retrouve en tête en 2560x1600 alors qu'il est devancé par le Crossfire de Radeon HD 7970 en 1920x1080. Le GeForce GTX 690 est somme toute très proche du SLI de GeForce GTX 680, cette dernière configuration étant 2% plus rapide. Quant au gain de performances entre le GeForce GTX 690 et le GeForce GTX 680 de base, il atteint 79%.

Battlefield 3 - Ultra - AA 4x / AF 16x - Kaffarov

Sous Battlefield 3, nous employons également FRAPS. La scène testée est ici l'attaque de la villa de Kaffarov. Le GeForce GTX 690 arrive en tête, alors que le SLI de GeForce GTX 680 est sur ses talons : l'écart entre les deux solutions est nul. Il est intéressant de constater qu'en 1920x1080 le GeForce GTX 690 est 7% plus rapide que le Crossfire de Radeon HD 7970 alors qu'en 2560x1600 les deux systèmes offrent des performances identiques, à un cheveu près.

STALKER - Call Of Pripyat - Extrême

STALKER propulse le SLI de GeForce GTX 680 en tête : nettement en 1920x1080 (8%) et de manière anecdotique en 2560x1600 face au GeForce GTX 690 (3%). Dans tous les cas, les performances sont toujours supérieures au Crossfire de Radeon HD 7970 qui termine quatrième, le SLI de GeForce GTX 580 réussissant à lui passer devant. Les performances de la GeForce GTX 690 sont 48% supérieures à celles de la GeForce GTX 590 et 79% plus élevées que celles de la Radeon HD 6990 en 2560x1600.

Metro 2033 - Très haut - AAA - AF 16x

Autre titre DirectX 11, Metro 2033 est testé avec FRAPS. Sans grande surprise, le Crossfire de Radeon HD 7970 s'adjuge la première place, largement aidé par une quantité de mémoire vidéo plus généreuse. Le SLI de GeForce GTX 680 est ici 3% plus rapide que la nouvelle GeForce GTX 690 qui du coup s'adjuge la troisième marche du podium. Face au GeForce GTX 590, le GeForce GTX 690 est 31% plus performant en 2560x1600.

Tom Clancy's H.A.W.X. 2 - DirectX 11

On termine avec H.A.W.X. 2, testé avec les fonctions de tesselation activées. Pas de révélation ici : le SLI de GeForce GTX 680 termine à la première place, avec des performances 2% supérieures au GeForce GTX 690 en 2560x1600. Il est intéressant de constater que l'écart de performances avec un autre SLI, le SLI de GeForce GTX 580 est ici nul : 4% en 2560x1600 en faveur du GeForce GTX 690. Face au Crossfire de Radeon HD 7970, le GeForce GTX 690 est 5% plus rapide.

Conclusion

Il faut reconnaître que les très bonnes aptitudes de l'architecture Kepler que nous soulignions à l'époque du test de la GeForce GTX 680 permettent à NVIDIA de concevoir une carte bi-GPU sans concession. La consommation et l'échauffement des puces étant des paramètres relativement bien maîtrisés avec les puces GK104, NVIDIA n'a pas besoin de sacrifier des unités de traitement comme c'était le cas sur les dernières générations de solutions bi-GPU. La seule véritable concession concerne la fréquence de fonctionnement : en baisse face au GeForce GTX 680 lorsque l'on regarde la fréquence de base, mais très légèrement en hausse pour la fréquence GPU Boost. Ce dernier nous apparaît toujours comme un argument marketing non déterminant avec des effets de bord certains.

Mais à vaincre sans péril, NVIDIA triompherait-il sans gloire ? Que nenni ! La marque a en effet porté un soin tout particulier au design et à la finition de la carte. Exit les plastiques et la finition en mode « à peu près » auxquels nous sommes habitués sur les cartes graphiques depuis des années et place à des matériaux nobles : magnésium, aluminium, polycarbonate sont autant de composants utilisés pour la fabrication de cette carte. Une carte qui semble robuste, solide, et à la finition qui n'est pas sans évoquer certaines berlines allemandes. Si l'on aime le beau, si l'on ne peut que féliciter NVIDIA pour ce travail inédit, notre esprit critique s'interrogera sur la finalité de la chose une fois la carte dans votre PC. Prévoyez d'ailleurs un PC avec une paroi transparente, il serait dommage de se priver du logo GeForce qui s'illumine sur la tranche de la carte !

Du côté des performances, la GeForce GTX 690 s'approche sans toutefois l'égaler d'un SLI de GeForce GTX 680. Certains trouveront cela un peu décevant, pour notre part l'écart variant entre 1 et 10%, nous considérons que pour la première fois l'utilisateur en quête d'une solution multi-GPU a un véritable choix sans compromis : carte simple ou solution à deux cartes. D'autant que les nuisances sonores de cette GeForce GTX 690 nous ont paru maîtrisées, la carte semblant plus discrète que notre SLI de GeForce GTX 680. Et la consommation est également un plus appréciable : au repos ou en charge, la GeForce GTX 690 consomme moins que le SLI de GeForce GTX 680.

En définitive donc... cette GeForce GTX 690 s'impose comme une carte qui fera date. Tout d'abord pour ses performances, quasi-équivalentes à un SLI de deux cartes, mais aussi pour sa finition tout simplement jamais vue pour une carte graphique. Reste un détail... de taille. Le prix. NVIDIA annonce un prix public conseillé de 999 euros TTC. J'en vois certains bondir, mais c'est peu ou prou le même prix que deux GeForce GTX 680 qui offrent pour mémoire des prestations similaires, la finition en moins. Notre seule crainte est que ce tarif de 999 euros TTC flambe très vite au vu de la faible quantité de pièces, avec le risque qu'au final la carte soit bien plus onéreuse que ce que NVIDIA nous promet.