Les pros comme les joueurs du dimanche ont tous plus ou moins entendu parler de ces termes, mais à quoi correspondent-ils vraiment et en quoi ces technologies sont-elles utiles ? Place au décryptage.

La quête de performances

L'industrie vidéoludique ne lésine pas sur les efforts pour proposer aux joueurs des technologies leur permettant de profiter pleinement des derniers jeux sortis et de ceux à venir. Alors que les jeux améliorent sans cesse leurs graphismes, nous offrant toujours plus d'immersion et de réalisme en tirant parti de technologies comme le Ray Tracing et le HDR, la quête de performances ne s'arrête pas à la qualité des graphismes.Le confort visuel est ainsi une préoccupation majeure dans l'univers gaming, aussi bien pour NVIDIA et AMD que pour les constructeurs d'écrans. On peut dès lors évoquer des paramètres comme la taille et le type de la dalle (TN, IPS, VA, etc.), sa résolution, ou encore les techniques de rétroéclairage comme le local dimming ou le miniLED, en attendant que la très prometteuse technologie OLED (encore très marginale et onéreuse) émerge et se fasse une place parmi les moniteurs gaming.

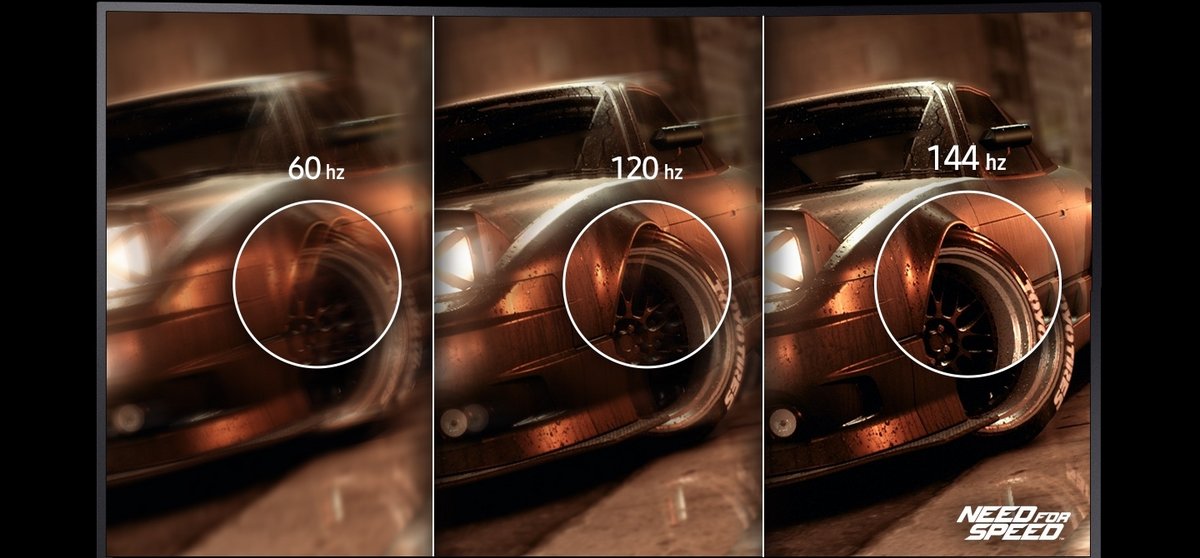

La vitesse de rafraichissement de l'écran est également devenue un critère de choix pour les gamers, du moins pour ceux qui optent pour une résolution autre que 4K et qui souhaitent profiter de l'expérience de jeu la plus fluide possible. Une véritable course au taux de rafraichissement s'opère chez les fabricants, de 60 Hz à 120 Hz, nous avons vu apparaitre des moniteurs de plus en plus véloces en mesure d'atteindre des taux de 144 Hz, puis 180 Hz pour aller jusqu'à 240 Hz. Plus récemment, lors du CES 2020, Asus a dévoilé un nouveau moniteur ROG Swift, capable de grimper jusqu'à 360 Hz et donc d'afficher, potentiellement 360 images par seconde.

Le secteur gaming fait l'objet d'une véritable course à la performance ! Le marketing y joue un rôle important avec des valeurs floues et discutables concernant le temps de réponse d'une dalle ou son taux de contraste. Malgré tout, les fréquences élevées et le taux de rafraichissement variable (VRR) apparaissent aujourd'hui comme l'une des évolutions prégnantes de ce marché porté par NVIDIA et AMD avec leurs solutions respectives (G-Sync et FreeSync).

Si des noms comme Asus, Acer, Samsung, AORUS, et autres MSI se livrent une rude bataille sur ce marché en pleine croissance, la confrontation entre NVIDIA et AMD est d'autant plus rigoureuse qu'il s'agit, pour l'heure, d'un duel. Et comme nous le verrons un peu plus tard, les deux géants ont récemment révisé et fait évoluer leur technologie d'affichage, l'occasion pour nous de se pencher sur le sujet et faire le point.

Input lag, stuttering, tearing : une histoire de synchronisation

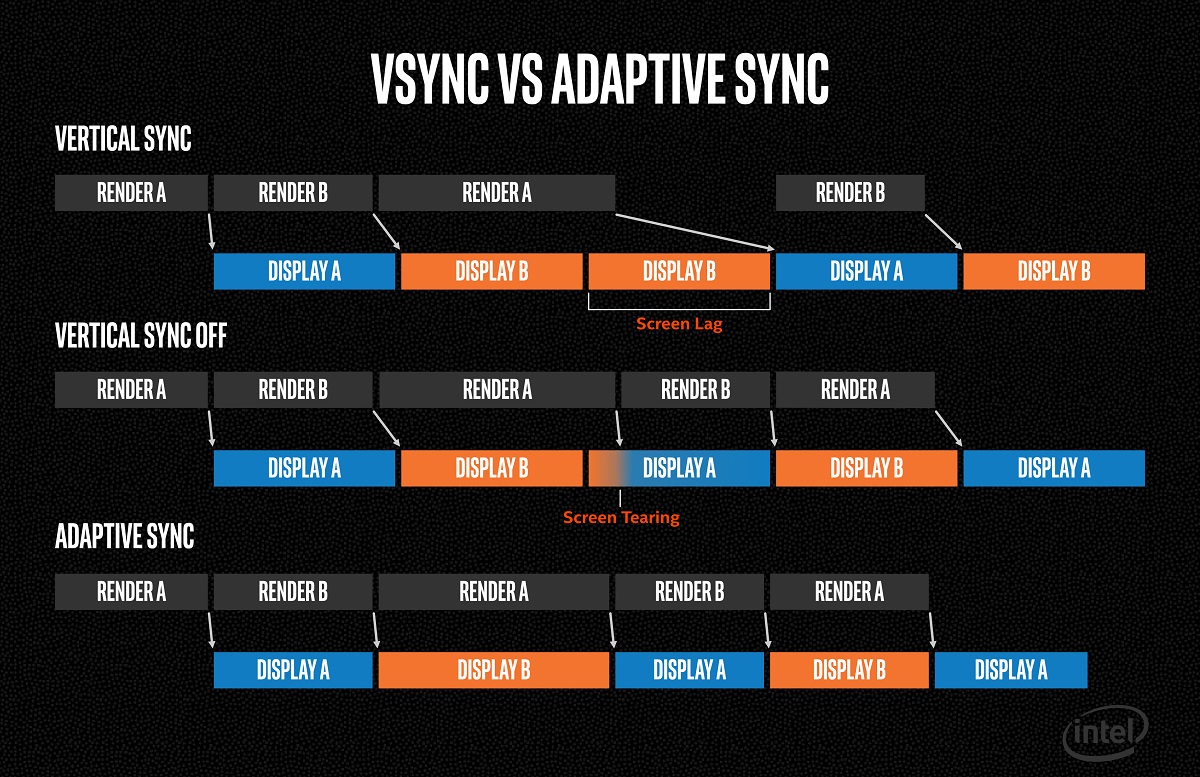

Pour beaucoup d'entre nous, le passage d'un écran de 60 Hz à un modèle HFR (avec un taux de rafraichissement supérieur à 60 Hz) a considérablement changé la donne, améliorant le sentiment de fluidité et la netteté des images. Seulement, à 60 ips - images par seconde - comme au-delà, il reste un problème de taille : celui de la synchronisation entre votre carte graphique et votre écran !Le constat est simple : l'écran rafraichit les images de manière fixe. Prenons l'exemple d'un moniteur de 60 Hz. Celui-ci interroge le GPU 60 fois par seconde, plus précisément toutes les 16,67 millisecondes, son fonctionnement est donc régulier ce qui n'est évidemment pas le cas de la carte graphique. Alors que l'écran se contente d'effectuer un balayage régulier de l'image, le GPU est sollicité de manière plus ou moins grande pour produire l'image à afficher. Le volume de données qu'il traite est variable et irrégulier, en fonction des mouvements de caméra, des effets visuels et des scènes générées par le jeu, etc. Par conséquent, le temps nécessaire aux calculs de l'image dépend de plusieurs facteurs, à commencer par le volume variable de données à traiter, mais aussi de la puissance de votre machine.

Écran et carte graphique font leur travail indépendamment et c'est problématique. Sans aucune synchronisation à l'œuvre le GPU fournit plus d'images que l'écran est en mesure d'en afficher, ou pas suffisamment. Une plaie puisque c'est lors de ces instabilités que le tearing (déchirement) fait son apparition. Pour faire simple, un déchirement de l'image se fait voir lorsque le temps de calcul du GPU est trop instable et en décalage avec le rafraichissement de l'écran.

V-Sync : une solution imparfaite

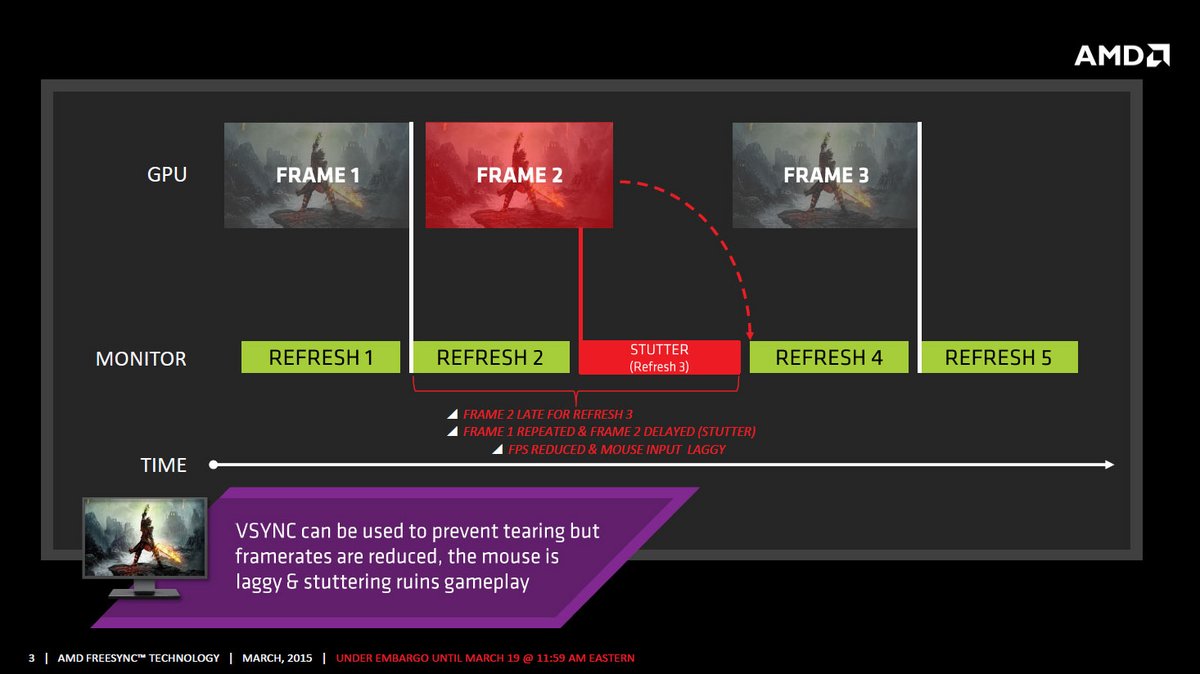

Pour éviter ce phénomène, les fabricants de GPU ont d'abord voulu s'attaquer à sa source : la carte graphique. Ils ont ainsi déployé la technologie de synchronisation verticale, ou V-Sync. Généralement accessible dans les paramètres graphiques de nos jeux, la V-Sync permet à la carte graphique de se synchroniser avec le taux de rafraichissement du moniteur. Ainsi, le GPU ne produira pas plus de 60 images par seconde si nous utilisons un écran de 60 Hz.Cette fonctionnalité préventive permet d'éviter le tearing grâce à une limitation des FPS. Le GPU attend en effet le signal de l'écran, appelé vblank, pour lui transmettre la dernière image produite. V-Sync implique cependant d'autres problèmes, le retard de calcul généré par l'attente du GPU entraine ainsi de l'input lag, et pire puisque si votre carte graphique peine à maintenir un taux d'image égal à la fréquence de rafraichissement de l'écran, vous aurez à faire au stuttering, des micro-saccades ou « bégaiement » affichant plusieurs fois la même image et réduisant donc considérablement l'impression de netteté et de fluidité.

Bien conscients du problème, AMD et NVIDIA ont chacun tenté d'améliorer cette technologie avec l'Adaptive V-Sync et la FastSync d'un côté et l'Enhanced Sync de l'autre. Sans entrer dans le détail, ces technologies permettent d'activer ou de désactiver automatiquement la V-Sync en fonction de la fréquence d'image en jeu, ou encore de combiner cette synchronisation dynamique avec l'utilisation de la triple mémoire tampon - triple buffering.

Malheureusement aucune de ces solutions n'offre un résultat parfait, car il dépend grandement des jeux, de la puissance de votre machine et aussi de vos préférences en fonction du type de jeu.

G-Sync et FreeSync au secours des joueurs

NVIDIA et AMD ont littéralement inversé la tendance à partir de 2013. Au lieu de s'attaquer une nouvelle fois aux problèmes posés par la V-Sync, les deux géants ont proposé leur solution respective pour que ce ne soit plus le moniteur qui dicte la vitesse du rafraichissement.Désormais, l'écran s'adaptera en temps réel à ce que la carte graphique est en mesure de produire. En clair, si le GPU ne produit que 82 FPS, l'écran fonctionnera à 82 Hz ! Lors de scène moins complexe à calculer, votre GPU produit 125 FPS ? Alors l'écran se calera à la fréquence de 125 Hz, c'est aussi simple que ça.

Le taux de rafraichissement variable est né, porté par G-Sync et FreeSync ! C'est un véritable coup de force de l'industrie vidéoludique que d'avoir réussi à imposer cette technologie aux fabricants d'écrans, qu'il s'agisse de moniteurs PC ou de TV puisque certains téléviseurs embarquent maintenant cette technologie, tout comme la Xbox (qui, on le rappelle, est équipée d'un GPU AMD).

La guerre des Syncs

Si les deux technologies fonctionnent selon le même principe et permettent d'obtenir un gameplay fluide, sans aucun lag, tearing ou stuttering, elles sont toutefois différentes sur plusieurs points.NVIDIA a en effet conçu un système propriétaire fermé, nécessitant d'intégrer un module hardware G-Sync à chaque écran. Malheureusement cette technologie propriétaire a un coût, qui est d'autant plus élevé que le caméléon exige sa part de royalties sur chaque produit commercialisé, un positionnement qui a certainement été influencé par le monopole que détient l'entreprise sur le secteur gaming. Après tout, si 80 % des joueurs sont équipés d'une carte graphique NVIDIA, pourquoi ne pas en profiter ? C'est à partir de cette politique lucrative qu'une nouvelle bataille des normes a débuté.

De son côté, la solution d'AMD ne fait appel à aucun hardware à intégrer à l'écran, elle repose sur un standard VESA qui était déjà en place depuis 2009 et dont le but était d'économiser de l'énergie en réduisant la fréquence d'affichage lorsque cela est possible sur les écrans d'ordinateurs portables. Intégré à la norme d'interface vidéo DisplayPort 1.2a en 2014, l'Adaptive Sync (à ne pas confondre avec l'Adaptive V-Sync) ne demande qu'un support logiciel adapté pour fonctionner sur les écrans compatibles. AMD a malgré tout conservé l'appellation FreeSync pour désigner les écrans qui prendront en charge l'Adaptive Sync à l'aide d'une Radeon compatible.

Les conséquences de cette guerre des Syncs entre les rouges et les verts ont surtout été préjudiciables pour le consommateur. Si les écrans FreeSync sont déjà plus couteux que la plupart, les produits estampillés G-Sync sont quant à eux près de 30 % plus chers que les moniteurs affichant une compatibilité avec la solution rouge. Au final la complexité du G-Sync a eu un résultat quelque peu contradictoire : alors que NVIDIA est leader sur le marché, les écrans G-Sync ont mis du temps à apparaitre et ne sont pas sortis en nombre des usines, contrairement aux modèles compatibles FreeSync. Cette politique discutable a très certainement eu pour effet de convaincre certains joueurs à se passer de cette technologie, ou même à choisir un écran gaming compatible FreeSync en se basant sur d'autres critères (taille, résolution, temps de réponse) alors qu'ils possèdent un GPU NVIDIA.

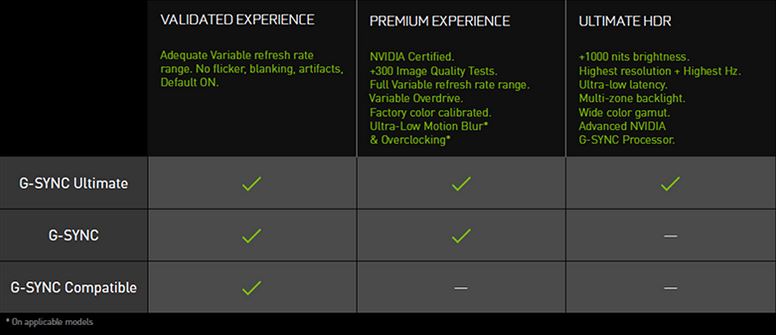

Il faut toutefois reconnaitre que la G-Sync a plus souvent reçu l'éloge des critiques pour sa qualité de mise en œuvre et ses performances. C'est d'ailleurs là un argument repris par le fabricant californien qui souhaite que l'appellation G-Sync soit synonyme de qualité.

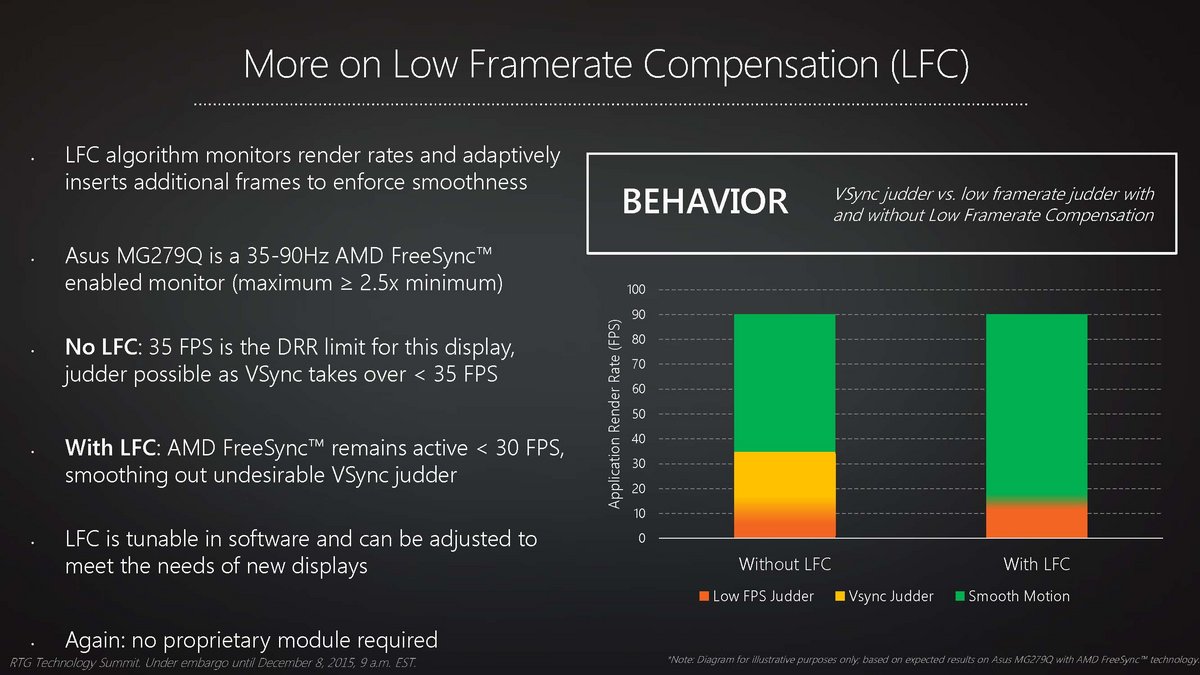

Dans les faits, le module G-Sync effectue des tâches supplémentaires en vue de réduire le ghosting (flou de mouvement) et optimise l'affichage lors de chutes de FPS. Jusqu'à l'arrivée des pilotes supportant le LFC (Low Framerate Compensation), le FreeSync gérait relativement mal les chutes de FPS en dessous de la limite basse de la plage de fréquences de l'écran, alors que le module de NVIDIA permet une synchronisation sur des intervalles plus larges. Il aura fallu plus de deux ans à AMD pour s'attaquer à ce problème épineux et faire en sorte que l'écran ne retombe pas à une fréquence fixe obligeant les joueurs à retomber dans les travers de la V-Sync.

G-Sync Compatible : la fin d'une rude bataille ?

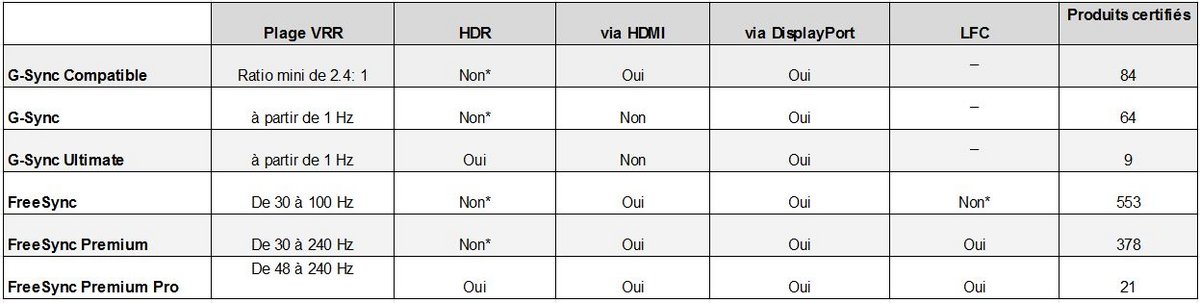

Comme nous l'avons vu, l'opposition entre NVIDIA et AMD s'est renforcée avec l'avènement du VRR débouchant sur une énième guerre des normes. Les deux certifications ont toutefois bien évolué depuis leur lancement, notamment avec le support du LFC du côté d'AMD, mais aussi avec la prise en charge du HDR dans les deux camps avec FreeSync 2 et G-Sync HDR.

Les lignes ont cependant (enfin) bougé en 2019 lorsque NVIDIA a annoncé son ouverture à la norme VESA Adaptive-Sync, ce qui signifie que le module G-Sync n'est plus forcément nécessaire à un écran pour profiter du VRR et de la bénédiction du caméléon. Autrement dit : les écrans FreeSync vont pouvoir fonctionner avec une carte graphique NVIDIA !

Pour ce faire NVIDIA a lancé une nouvelle certification "G-Sync Compatible". Au moment de cette annonce, seuls 12 écrans sur 400 testés ont reçu l'aval de l'entreprise et obtenu cette certification. Depuis janvier 2019, 72 références supplémentaires ont été approuvées, portant ainsi le nombre total d'écrans G-Sync Compatible à 84.

Pour récapituler avant de détailler les caractéristiques des différentes certifications G-Sync / FreeSync, ce tableau nous montre dans l'ensemble à quoi l'on peut s'attendre en choisissant parmi les trois catégories de chaque fabricant :

Dans l'absolu un grand nombre de moniteurs FreeSync récents pourraient se voir accoler la mention G-Sync Compatible, mais NVIDIA impose une série de tests pour qu'un tel écran soit mentionné comme étant compatible.

Le fabricant demande en effet un seuil de qualité minimum et veut s'assurer de l'absence d'artefact visuel, notamment de blanking, flickering, pulsing et ghosting. En outre, NVIDIA impose une plage VRR d'au minimum 2,4 : 1, ce qui correspond, par exemple, à un intervalle de fonctionnement compris entre 60 et 144 Hz. C'est en raison de ces règles strictes que le nombre d'écrans certifiés est encore faible à l'heure actuelle. Malgré tout, les propriétaires d'écrans reconnus comme non compatibles ou pas encore testés peuvent tenter leur chance en activant manuellement la G-Sync, chose que nous verrons dans un prochain article.

Évolution des nomenclatures : on fait le point

Cette surprise que l'on attendait plus de la part de NVIDIA a entrainé quelques changements d'un côté comme de l'autre. Forts des centaines de moniteurs et des dizaines de TV prenant en charge FreeSync, les rouges ont clarifié les choses en présentant trois catégories FreeSync dont le FreeSync Premium, une nouveauté dévoilée lors du CES 2020.Pour résumé, chez AMD on retrouve donc des moniteurs :

En ce qui concerne NVIDIA, on retrouve des moniteurs :

Liens utiles

Avant de conclure cet article par un petit lexique regroupant des termes parfois mal compris, nous avons jugé pertinent de vous fournir quelques liens utiles qui vous permettront d'en savoir plus et peut-être à vous aider à choisir votre prochain écran gaming.Tout d'abord, vous pouvez consulter notre comparatif des meilleurs modèles d'écrans PC gamer avec une sélection qui contient aussi bien des écrans G-Sync, FreeSync, ou compatibles avec les deux technologies.

Si jamais vous avez un doute ou attendez la compatibilité ou la venue d'un nouvel écran du côté de NVIDIA, les caméléons tiennent une liste complète des moniteurs compatibles, toutes catégories confondues (G-Sync, G-Sync Compatible et G-Sync Ultimate).

AMD tient également une liste à jour des moniteurs compatibles FreeSync. Il sera cependant nécessaire de bien affiner la recherche, car les références présentent dans cette liste atteignent aujourd'hui un total qui se rapproche du millier. Si vous cherchez à connaitre les jeux HDR optimisés pour FreeSync Premium Pro, AMD en dresse une liste sur son site.

Enfin, pour savoir comment profiter de la VRR sur un écran FreeSync alors que vous êtes équipé d'une carte graphique NVIDIA, nous avons réalisé un tutoriel dédié qui lève le voile sur cette question. Nous vous y montrons notamment la marche à suivre pour tester un écran qui n'a pas été reconnu comme G-Sync Compatible par NVIDIA.

Lexique : apprenez à bien parler la langue des Sync

Comme promis nous avons concocté un petit lexique pour détailler les quelques acronymes cités dans cet article, mais aussi pour succinctement revenir sur des termes qui ne sont pas toujours simples à saisir.Input lag : le « retard à l'entrée » est le délai nécessaire à un moniteur pour traiter et afficher les informations qu'il reçoit. Il dépend des tâches exécutées par l'écran pour traiter les signaux (ajustement du contraste, mise à l'échelle, HDR, etc.), c'est pour cette raison qu'il est souvent bien plus élevé sur les téléviseurs, le traitement de l'image y étant plus complexe. Un input lag élevé influe fortement sur l'expérience de jeu surtout s'il s'agit de jeux rapides et compétitifs comme les FPS. Il entraine inévitablement un délai entre vos commandes de claviers, souris et autres, et le fait de voir les répercussions à l'écran. Attention à ne pas confondre l'input lag avec la réactivité d'un écran (son temps de réponse).

Le tearing ou screen tearing est un déchirement d'image qui se produit lorsque le flux vidéo n'est pas synchronisé avec le taux de rafraichissement de l'écran. Un écran sans VRR rafraichissant son image à une fréquence fixe de 60 Hz interroge le GPU toutes les 16,67 ms, il est alors courant qu'il envoie son signal lorsque le GPU échange son back buffer et son front buffer, autrement dit ses zones de mémoires où il stocke la dernière image calculée et l'image en cours de calcul. Deux images distinctes constituent alors l'image affichée, faisant apparaitre une ou plusieurs lignes horizontales à l'écran.

Le stuttering est un terme générique qui désigne des ralentissements et des freeze et qui s'apparente à des saccades d'images lorsque le phénomène est visible, d'où son nom de stuttering (bégaiement). C'est un problème courant que l'on rencontre même sur des configurations de jeux véloces, contrairement au tearing il existe de nombreuses causes de stuttering qui peuvent aussi bien être liées à des problèmes logiciels que matériel.

LFC - Low Framerate Compensation : cette technologie vient corriger l'un des grands défauts de la FreeSync avec des écrans compatibles qui ont souvent une plage VRR restreinte. Le LFC permet de dupliquer des images lors de chutes de FPS pour ainsi faire en sorte de maintenir FreeSync activé en ne tombant pas en dessous de la limite basse de la plage VRR de l'écran. Sans le LFC, il est courant que FreeSync s'active et se désactive, perturbant ainsi la fluidité du jeu avec tous les problèmes que cela implique (tearing, blanking, etc.).

IPS : acronyme d'images par seconde, que l'on rencontre plus souvent sous le terme anglophone FPS - Frames per second.

(superbe écran au passage !)

(superbe écran au passage !)