Jeffrey Kaplan (à ne pas confondre avec le 'Game Design Chief' de chez Blizzard...), directeur de THINKstrategies, un cabinet de consultants indépendants basé aux Etats-Unis, définit le Cloud Computing comme « un ensemble d'outils et de services basés sur le web, qui permettent d'acquérir des ressources informatiques et des capacités de développement pour réaliser ou maintenir des applications, ou réaliser des fonctions spécifiques pour lesquelles vous ne payez que ce que vous utilisez » (1). Pas sûr que cette définition soit plus utile que les termes marketing qu'elle entend rendre explicites.

Un départ inattendu

En 2002, alors que l'Internet comptait encore moins de 600 millions d'utilisateurs dans le monde (Internet World Stats), Amazon, le géant du e-commerce, avait décidé d'investir dans un parc informatique pour ne pas être victime de surcharge des serveurs informatiques dédiés au site de commerce durant les fêtes de fin d'année, étant donné que la toile était de plus en plus fréquentée, et qu'avec cela les achats en ligne augmentaient. Seulement, une fois ces fêtes passées, la société se retrouvait avec une quantité importante de ressources non utilisées, et a donc décidé de louer ces dernières à des entreprises, sans se douter qu'une nouvelle façon de consommer l'informatique et l'Internet était en train de naître. Mais ce n'est qu'en 2006 qu'Amazon a réellement compris le potentiel de ce mode de fonctionnement.

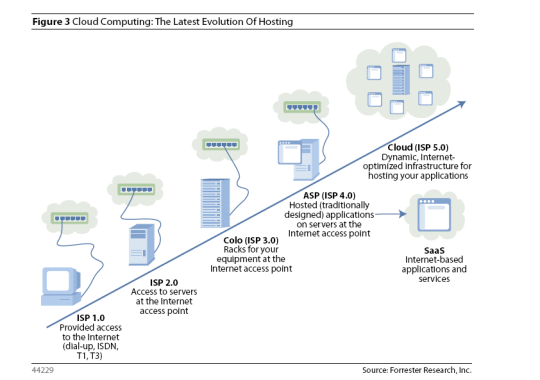

Toutefois, la démocratisation des connexions Internet haut débit a permis d'entrevoir de nouveaux schémas de fonctionnement, et a ouvert la voie vers de nouveaux contextes.

1 : En anglais dans le texte : « a set of web-based tools and services which permit users to acquire computing resources and development capabilities to build or support applications, or perform specific IT functions on a pay-as-you-go basis ».

Le Cloud Computing, qu'est-ce que c'est ?

Parler du Cloud Computing sans le définir, sans tenter de comprendre de quoi il est constitué, et sur quoi il repose serait une aberration, c'est pourquoi nous avons décidé de vous le présenter, ainsi que les technologies principales qui le constituent.Le fonctionnement du Cloud : un 'patchwork' technique

Pour louer ses infrastructures, Amazon, comme les autres prestataires naissant, devaient avant tout bénéficier d'une bande passante importante. On ne saurait imaginer une entreprise qui utilise des ressources situées à 1000 kilomètres de ses locaux et possédant une connexion en 56k.

Un point important que nous venons de souligner ici est le fait que la proximité entre ressources informatiques (matérielles comme logicielles) et utilisateurs n'est aujourd'hui plus, en théorie, un facteur bloquant dans le choix d'un prestataire informatique. Le fait de pouvoir louer des ressources et services situés à des centaines voire des milliers de kilomètres de là permet de se concentrer sur l'offre en elle-même, c'est-à-dire sur les services proposés, et sur les prix pratiqués. D'autant qu'il est possible pour les entreprises de tester les solutions en ligne avant de les adopter. Autant dire que la perte de temps liée aux aléas techniques tend à être balayée, au profit d'une concentration sur le 'cœur de métier', ce qui présente donc de multiples avantages pour les entreprises.

On l'aura compris, avant toute chose, l'intérêt du Cloud Computing se trouve dans le fait qu'il constitue une nouvelle manière de consommer, relative à l'Internet lui-même, et qu'il laisse entrevoir un potentiel énorme de nouvelle économie pour les prestataires de services web et informatiques. Plutôt qu'une révolution technologique, on pourrait y voir une évolution profitant mieux des possibilités offertes par l'Internet.

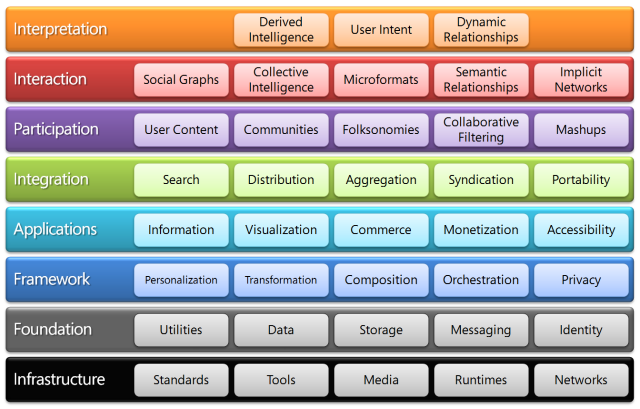

Une production iconographique du cabinet d'étude Gartner nous montre les champs d'intérêts applicatifs du Cloud Computing :

On constate que les champs d'applications sont divers, et que les intérêts sont donc multiples. Si cette image décortique assez en profondeur ces champs d'applications, il ne faut pas pour autant voir le fonctionnement du Cloud Computing ainsi, mais plutôt comme un ensemble de briques mises bout à bout pour composer une recette sur mesure 'dédiée' au client.

Déclinaisons du Cloud Computing

Le « Public Cloud », tout d'abord, repose sur l'hébergement d'applications. Ce sont le plus souvent des applications Web (exécutables dans un navigateur), placées dans un environnement partagé avec un certain nombre d'utilisateurs.

Ce « modèle » permet entre autre de louer les ressources, et l'utilisateur final ne paiera que ce qu'il a utilisé : c'est ce que l'on nomme le « pay per use », ou « pay as you go ». Les sommes dues sont calculées par heure d'utilisation, ou même par rapport aux ressources CPU utilisées.

Le « Private Cloud », quant à lui, peut être vu de deux manières différentes : du point de vue de l'entreprise, il s'agit de remodeler le paysage informatique interne, en optant pour une voire plusieurs solutions de virtualisation. On peut ainsi automatiser la livraison de ressources selon les besoins du personnel. On parlera parfois d'« Internal Cloud ». Du point de vue de l'Hébergeur, il sera plutôt question de dédier une infrastructure, c'est-à-dire un ensemble de ressources, à un seul client.

L' « Hybrid Cloud », enfin, qui est un mélange de public et de private Cloud. Supposons qu'un « Private Cloud » connaisse une période de fort trafic, ou « montée en charge » : on pourra le seconder avec des «Publics Clouds » pour faire face temporairement à la demande.

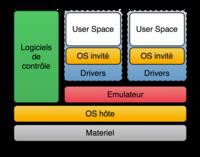

La virtualisation

Nous l'avons évoquée précédemment : la virtualisation est une technologie qui permet de disposer de plusieurs machines virtuelles sur une seule machine physique. Certains noms, comme VMware ou encore VirtualBox vous seront peut-être familiers.Alors que certains serveurs possèdent des ressources matérielles importantes, celles-ci peuvent n'être exploitées qu'à 10% de leurs capacités ! Les prestataires d'offres de Cloud Computing y installent donc des outils de virtualisation qui vont permettre, sur une seule machine, de disposer de plusieurs systèmes d'exploitation. Lorsque l'on sait qu'un serveur qui monte à 90% de sa charge ne consomme pas beaucoup plus qu'un serveur à seulement 20%, on comprend logiquement la démarche des prestataires de services de Cloud.

La techniques des "isolateurs", qui permet d'isoler des applications dans certaines zones d'exécution uniquement.

L' "espace utilisateur", qui exécute un système dans le même espace que l'utilisateur (par exemple le "chroot" très connu sous Unix).

L' "hypervirtualisation", propose d'émuler directement les systèmes virtuels sur le système hôte à l'aide d'un hyperviseur. On en distingue deux types :

-le type 1 est un noyau hôte allégé, qui alloue directement les ressources matérielles au système invité demandeur : Les performances sont très bonnes dans ce cadre, puisque le système hôte contrôle directement les ressources matérielles et le système invité a conscience d'être virtualisé. On fera généralement tourner des systèmes invités optimisés pour la plateforme matérielle sur laquelle repose le système hôte. Par exemple, un système hôte contrôlant une plateforme x86 recevra initialement des systèmes invités optimisés pour cette même plateforme. On retrouve des hyperviseurs bien connus dans le monde des entreprises, comme "Xen" de Citrix, ou ESX Server de WMware.

-le type 2 est mieux connu du grand public : VirtualBox, VMWare Fusion, QEMU, etc. sont autant de logiciels qui s'exécutent à l'intérieur d'un système d'exploitation. De ce fait, on ne distingue plus deux couches logicielles comme dans le type 1, mais trois couches, avec le système hôte, le logiciel de virtualisation et le système invité. L'avantage est que les systèmes invités n'ont pas conscience d'être virtualisés : vous pouvez donc exécuter des systèmes sans optimisation matérielle. L'inconvénient est que les performances seront amoindries, puisqu'une couche logicielle supplémentaire est requise.

Appliquées à l'échelle d'une entreprise, ces technologies permettent de mettre à profit les ressources d'une seule machine de façon à en faire un « serveur » capable d'alimenter plusieurs « clients ». Certes, les performances sont parfois moins bonnes que sur une machine réelle, mais dans l'ensemble, ces solutions présentent plus d'avantages que d'inconvénients, et sont transparentes pour l'utilisateur.

Qui sont les cibles commerciales?

Pour comprendre quelles technologies et services sont proposés, il faut comprendre qui est "visé". On parle depuis le début de ce dossier de l'utilisateur final, mais qui est-il ? A qui s'adressent donc les offres de Cloud Computing ? Il semble évident que les entreprises consommatrices de ressources informatiques ont tout intérêt à se pencher sur les différentes formules de Cloud Computing, et que ces dernières leur sont d'ailleurs en grande partie consacrées. Mais qu'en est-il du 'grand public', de nous autres, simples particuliers ?Si l'on regarde de plus près les champs applicatifs couverts par le Cloud Computing, on s'aperçoit que les réseaux sociaux, les boîtes mail et autres espaces de stockage en ligne constituent une base qui existait bien avant la démocratisation des termes marketing actuels. Ainsi, on peut dire que le Cloud Computing dans sa forme archaïque existait pour le grand public avant d'exister pour les entreprises. Comment discerner les offres aux particuliers face aux offres aux entreprises ? Peut-on catégoriser tout cela afin de savoir ce qui semble être le plus adapté ? Il est nécessaire de prendre en compte trois modes de distribution des services de Cloud Computing :

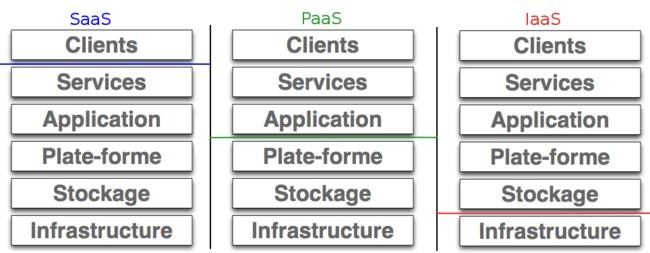

Le "SaaS", ou Software as a Service, avant tout, est la forme la plus courante de Cloud Computing. C'est à quelques détails près ce dont nous parlons lorsque nous évoquons les boites mail comme Hotmail, Gmail, Yahoo Mail, etc. Cette vision, ou modèle de distribution, se concentre sur l'application en elle-même. Le client est déchargé de tout suivi, mais dépend du mode de fonctionnement de l'application.

Le "PaaS", pour Platform as a Service, où le client se concentre sur les applications, mais peut (et doit) définir leur modes de fonctionnement. Il est plus libre de définir les sauvegardes, les versions utilisées, etc. sous réserve que la plateforme soit compatible. Lorsque l'on parle de plateforme, il faut y voir un ensemble de technologies (python et java pour Google AppEngine, .NET pour Microsoft Windows Azure, etc.) mises en place d'après les spécifications requises par l'hébergeur et les solutions de virtualisation utilisées.

Le "IaaS", pour Infrastructure as a Service, où seuls les matériels ne sont pas contrôlés par le client. Si ce modèle de distribution présente plus de souplesse pour l'utilisateur, c'est aussi à lui de maintenir ses applications, son environnement de développement et sa configuration. On se rapproche donc d'une solution d'hébergement classique.

Le "StaaS", ou Storage as a Service, où il est tout simplement question d'hébergement de données.

Il faut voir cela comme des modes de distributions qui donnent droit à différents niveaux de souplesse, mais également à différentes contraintes selon le mode choisi.

Après ce rapide descriptif, on situe mieux l'intérêt pour le grand public (on ne parle pas des développeurs chevronnés que sont certains d'entre vous !) d'opter pour du SaaS, voire d'opter pour une simple utilisation des applications, où le fait de ne pas avoir à se soucier des opérations diverses et fastidieuses de maintenance et de configuration permet de se concentrer sur ce qui est produit. Reste encore à choisir les solutions ou applications qui vous conviennent.

Beaucoup d'entre nous aurons pour but unique de choisir un hébergement, peu importe les options proposées. Mais il est indispensable aujourd'hui de bien comprendre que l'espace de stockage n'est pas le seul critère à prendre en considération.Amazon, Microsoft, Google, Salesforce, IBM : autant d'acteurs majeurs dont il faut parler pour comprendre les directions que prendra le Cloud Computing d'ici peu. Car, qu'on le veuille ou non, le Cloud dépend en grande partie de ces géants du web et de l'informatique, mais également de nos équipements de télécommunications : comment bénéficier de la « magie du Cloud » sans de bonnes grosses lignes ADSL boostées à foison, ou même de la fibre optique sous nos pieds?

L'Etat, ou l'acteur implicte et indispensable

Au risque d'en décevoir certains, nous ne parlerons pas de politique ici (avouez que vous êtes déçus !), mais uniquement de la vision globale que nous donne le Cloud Computing à cet instant précis : sans équipements, point de Cloud Computing.A la question de savoir si les offres et les solutions vont pouvoir se développer, on peut rétorquer tout simplement que le Cloud Computing est une tendance de fond, suivie par des acteurs majeurs du monde du web et informatique en général ; son utilisation prolifère à grande vitesse. On constate que le PaaS et le SaaS sont déjà adoptés par une majorité des utilisateurs de solutions e-commerce, et ceci entraîne une augmentation importante des échanges commerciaux à travers le web. La FEVAD observe régulièrement l'évolution de ce secteur.

Les différents états qui jouissent d'un potentiel "e-commercial" ne veulent pas rater le train, et ont saisi l'importance des équipements de télécommunications. Un récent article démontre que l'équipement des foyers Français n'est plus aussi mauvais qu'il a pu l'être par le passé. La Commission Européenne finance à hauteur de 16 millions d'euros un projet de sécurisation des Clouds. Baptisé "Vision Cloud", ce projet est mené de front par IBM et aura pour but de définir des standards en matière de migration de bases de données et la sécurisation des échanges, le tout permettant donc d'améliorer globalement la sécurité.

Aussi, des associations comme Rezopole tentent d'ailleurs d'améliorer l'accès à l'Internet de manière générale, en animant des rencontres autour de ce thème sur le sol Français.

Au-delà des équipements territoriaux, ce sont les acteurs médiatisés, et prestataires de services qui ont toute notre attention.

Amazon : l'acteur venu d'ailleurs

Qui aurait pu croire en 2002 qu'Amazon, site marchand de renommée internationale certes, mais loin de la sphère informatique pure, lancerait "Amazon Web Services" ? Le 'fait divers' que nous évoquions en introduction, relatant la location des ressources non-utilisées par le site-marchand à des entreprises, a donné l'idée à la société de Seattle de mettre en place un ensemble de services web destinés à plusieurs types de clients.

SalesForce, le pionnier des offres Cloud Computing

Certes, le grand public peut utiliser certains outils dans certaines conditions, mais l'offre gratuite est plutôt limitée, ce qui risque d'en arrêter plus d'un. En bref, les pros trouveront peut-être leur intérêt; les particuliers, à moins d'aimer jouer avec un CRM (Customer Relationship Management), ne se tourneront sans doute pas vers ce prestataire.

Microsoft Azure, ou quand le géant de Redmond change de cap !

Dans son livre Comment Google mangera le monde, Daniel Ichbiah nous fait comprendre que si Google a pris une si grande place sur la scène de l'Internet mondial, c'est aussi parce que Microsoft n'a pas su voir le potentiel de la toile dans ses années d'éclosion rapide. Le modèle économique de Microsoft était basé sur les ventes de licences des logiciels. Et c'était tout ou presque.Aujourd'hui, comme en témoigne une récente interview de David Thompson, vice-président de la division Online, Microsoft est à un tournant dans son existence, et si Windows 8 pourrait bien sortir en 2012 (voir l'article associé), Steve Ballmer, CEO de Microsoft, préfère se concentrer sur le Cloud Computing. C'est pourquoi il a récemment animé le 4 mars 2010, à l'université de Washington, une conférence dédiée à la vision du Cloud qu'à adoptée Microsoft.

Cette vision, c'est Ray Ozzie, invité à la conférence et aujourd'hui en passe de partir à la retraite et détaché de la division 'Online' de la société, qui l'a insufflée il y a cinq ans. Lors de cette conférence Steve Ballmer a fait une véritable déclaration d'amour au Cloud Computing, en affirmant que le départ de Ray Ozzie n'aurait aucun impact sur cette vision que Microsoft cultive désormais. Ballmer a déclaré que la société investirait jusqu'à 90% de sa force de travail sur des projets en rapport avec le Cloud Computing dans un futur proche.

Avec son site dédié au Cloud, « Cloud: We're all in », la firme de Redmond entend bien faire la promotion de ses 'produits phares', à savoir Office 365 et Windows Azure.

Pour résumer, Microsoft met à disposition depuis très peu de temps des outils susceptibles de reprendre des parts de marché à Google (en adaptant ses offres aux petites entreprises), et de conquérir des entreprises désireuses d'opter pour une solution « fraîche » de Cloud Computing, mais aucun véritable signe de changement majeur dans le quotidien du commun des utilisateurs grand public.

Google, l'ami du peuple?

Certes, des limitations techniques existent comme des restrictions sur les API (Application Programming Interface, ou Interface de programmation), la durée des requêtes, etc. mais que peut-on reprocher à des services ouvert au plus grand nombre, et gratuites. Notons tout de même que les GoogleApps sont un cran en dessous des "Office Web Apps" de Microsoft (sur lesquelles nous reviendrons), et que ces dernières bénéficient d'un fait considérable : l'habitude d'utilisation des consommateurs.

Aussi, il est regrettable que Google ne propose pas d'offre adaptée aux « Grands Comptes », ceci permettant certainement de gagner en notoriété dans ce secteur, et de s'engager sur le terrain des entreprises, ce qui favoriserait la concurrence. Il convient toutefois de souligner que certaines start-ups utilisent ces outils.

Google semble donc vouloir mettre en place une stratégie "par le bas", en s'attaquant au grand public. Sur ce terrain, la firme de Mountain View semble bien partie, malgré des fonctionnalités trop basiques et en retrait par rapport aux Office Web Apps.

Oracle

Le géant des bases de données a lui aussi son mot à dire dans cette immense bataille qui s'engage. Siebel CRM, PeopleSoft ou encore Beehive sont autant d'outils qu'Oracle entend proposer en mode hébergé. Oracle a d'ailleurs signé un partenariat avec Amazon, ce dernier proposant désormais aux développeurs de travailler avec les bases de données d'Oracle.IBM, Dell et HP

Mettre ces trois poids lourds de l'informatique dans le « même panier » est peu conventionnel. Néanmoins, leur activités sont quelque peu similaires dans le domaine.C'est IBM, tout d'abord, qui se distingue le plus. D'abord parce que la société a investi dans 13 Data Centers à travers le monde (soit 2 de plus que l'objectif de 11 Data Centers évoqué par Microsoft...), et a proposé une solution hébergée de bureautique et de travail collaboratif dès 2008 avec « Lotus Live ». Aujourd'hui, on pourrait dire qu'IBM propose des services adaptés pour les grands comptes et apporte sa part d'innovation, avec des technologies qui semblent toutefois aux antipodes de l'interopérabilité, sur laquelle nous reviendrons. IBM a également misé sur des partenariats en nombre, avec une solution de réseau social rattachée à LinkedIN, des compatibilités avec Salesforce.com ou encore une solution de communication assurée par Skype.

Dell et HP ont été plus médiatisés qu'IBM concernant le Cloud, notamment avec le rachat de 3par, société spécialisée surtout dans le stockage massif de données qu'ils se sont disputé. Après plusieurs épisodes d'un feuilleton épique, le rachat final a été opéré par HP. Mais ce n'est pas pour autant que Dell a abandonné l'idée de faire son entrée dans le monde du Cloud, et c'est ainsi qu'après le rachat d'EqualLogic en 2008, société spécialisée dans la virtualisation, la société texane vient d'acquérir Boomi, spécialisé dans le Cloud Computing et plus précisemment dans une solution SaaS baptisée AtomSphere. Ainsi, Dell compte homogénéiser son offre en proposant des services web qui viendront se greffer aux solutions de stockage déjà existantes.

La constitution d'une chaîne technique allant du matériel (en amont) vers l'aval (services) semble donc au programme de toutes les sociétés. Dell, HP et IBM, grands noms sur le secteur des serveurs, ont donc a coeur de compléter leurs offres.

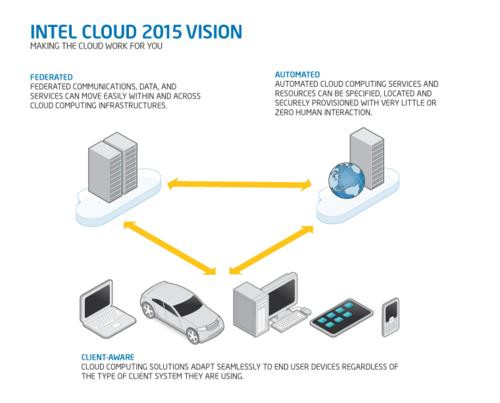

Intel, le fondeur dans les nuages?

Intel n'est pas à proprement parler, un acteur du Cloud Computing dans le mesure où il ne propose pas de service lié au Cloud. Néanmoins, Intel a une influence sur le monde de l'informatique (non ? sans blagues ?), et entend apporter sa pierre à l'édifice. Car il faut bien admettre que jusque là, le Cloud Computing nous apparaît plus comme un édifice en construction que comme une forteresse consolidée.Et pour Intel, justement, une bonne brique semble être une brique interopérable. Dans son programme « Cloud 2015 », dont une vidéo présente les grandes lignes, Intel avance l'interopérabilité et la flexibilité comme conditions sine qua none de réussite pour l'industrie du Cloud. Intel préconise donc de mettre en place un consortium d'entreprises collaborant afin de définir des règles (peut-on déjà parler de standards?) dans la réalisation de « Data Centers » qui seraient uniformisés afin de faciliter les connexions de tous types d'appareils. Car l'interopérabilité ne signifie pas uniquement que différents OS puissent être utilisés, mais également que les plateformes mobiles qui arrivent en masse sur le marché soit compatibles avec les technologies utilisées dans le nuage.

Intel voit les choses à long terme, mêlant le « tendance » au fonctionnel, et c'est ce qui fait de la société un influent acteur malgré le fait qu'elle ne propose pas de solutions de Cloud Computing tel qu'on le conçoit habituellement. Cette influence a en grande partie contribué à donner naissance à l' « Open Data Center », censée définir une sorte de cahier des charges fonctionnel des Cloud, et pour lequel participeront des sociétés bien connues telles que Canonical, Cisco, Dell, HP, IBM, Microsoft, Wmware, etc. Si l'Open Data Center doit donc servir à définir des spécifications techniques fonctionnelles, c'est l'« Intel Cloud Builders » qui recensera les innovations matérielles et logicielles afin d'en garder une trace et de faciliter leur intégration.

Mais si l'interopérabilité est un bien joli mot, il pourrait ne pas plaire à tout le monde, ou n'être à son tour qu'un argument marketing ! D'autant que les membres initiaux de l'Open Data Center sont des utilisateurs, comme BMW, UBS ou encore China Life :autant dire que leurs connaissances en informatique risquent de poser problème lors des réunions de réflexion sur l'interopérabilité.

Quelle sera la portée de ce consortium ? Quels rôles auront les grands noms du monde de l'informatique, puisque les membres initiaux semblent plus proches du monde des finances ? Affaire à suivre.Sachant que le marketing est omni-présent dans le domaine du Cloud Computing, on comprend aisément l'appropriation de concepts idéologiques par les prestataires, afin de mieux servir leurs desseins commerciaux.

L'interopérabilité, clé de la réussite du Cloud ou concept irréalisable?

Lorsqu'il Intel parle d'interopérabilité, c'est pour définir et spécifier un ensemble de pratiques industrielles et de services permettant une certaine transparence au sein d'un consortium d'entreprises : les uns pourront plus aisément utiliser les technologies des autres, ou du moins favoriser leur intégration/utilisation. Une sorte de fédération, en somme, mais l'utilisateur, n'y verra pas obligatoirement plus clair.On voit mal certaines entreprises comme Microsoft rallier les rangs d'un tel procédé. D'autant que si l'intention est louable, les objectifs seront-t-ils respectés ?

Dans son texte explicatif sur le Cloud, Intel parle de solutions « ouvertes ». Doit-on y voir la définition d'outils Open Source ? Pas si sûr, au vu des noms constituant le consortium..

L'Open Source est-elle liée au Cloud Computing?

Là où l'Open Source pourrait se distinguer, c'est sur la politique de sécurité, qui devient un sujet récurrent dans les discussions liées au stockage en ligne. On remarque justement que pour réaliser des systèmes d'exploitation utilisables sur le web et sécurisés, beaucoup s'en remettent à des outils libres/Open Source. On peut penser à Jolicloud, plus clairement destiné au grand public, ou encore eyeOS. Mais si un système comme Jolicloud permet de mettre les deux pieds dans le Cloud, ça ne règle pas la question de confidentialité des données.

« Mes données hébergées et sécurisées ! » : « Dans tes rêves ! »

Nous évoquions en février dernier les enjeux de la sécurité des solutions de Cloud Computing. Le fait est qu'utiliser des solutions hébergées est une chose, mais qu'en est-il du stockage des données ? Qu'est-ce qui nous assure que l'hébergeur, et/ou mainteneur d'applications n'en fait pas une base documentaire ou encore une source d'espionnage ? Sans rentrer dans une théorie extrêmiste comme celle de Richard Stallman, dont les propos assurent que le Cloud Computing n'est qu'un moyen d'emprisonner les utilisateurs petit à petit dans des systèmes propriétaires, on est en droit de douter des capacités des hébergeurs quels qu'ils soient en matière de protection des données.Bien que des accords de confidentialité puissent être signés, le traitement et le stockage de l'information, qui rappelons-le, peut peser aujourd'hui plus que la production d'une entreprise en tant que telle, pourrait attirer les convoitises d'entreprises tierces susceptibles de trouver dans ces bases de données de quoi s'assurer de beaux jours, moyennant finances, ou encore, ces bases de données pourraient subir les assauts de « hackers » malveillants. En bref, la question reste épineuse, et on voit encore mal certaines entreprises confier toutes leurs données à des sociétés basées à l'étranger, et dont on ne connaît rien de leur fonctionnement. A l'inverse, il pourrait être intéressant pour certaines entreprises d'exporter des données qui poseraient des problèmes de légalité, ou plus concrètement quelques soucis juridiques dans leur pays, vers des destinations plus « exotiques ».

Globalement, les entreprises ont plutôt tendance, d'après le cabinet Gartner, à investir massivement dans des Cloud privés, ce qui leur permettra d'avoir un contrôle accru de l'allocation des ressources. Etant donné que le Cloud est une transformation des Systèmes d'Information (SI) des entreprises, nombre d'entre elles se focaliseront précisément sur les Cloud privés internes, qui leur garantira un meilleur niveau d'intégrité des données, notamment concernant les données sensibles. Toujours d'après le cabinet d'études, cette tendance demeurera ainsi jusqu'en 2012, après quoi les Cloud publics auront gagnés en maturité, et les modèles hybrides se seront développés. D'autres études de ce type risquent donc de fleurir dans les mois et années à venir.

Une pointe verte dans le nuage

Notons que l'utilisation de la virtualisation permettrait de mettre en place un modèle présentant un intérêt également écologique. Le programme « Eco Tic » de Green IT, soutenu par l'ADEME (Agence de l'Environnement et de la Maîtrise de l'Energie), démontre les intérêts du Cloud computing et de la virtualisation. Un exemple avec Dot River, société qui met en avant le fait que le client, possédant parfois de vieilles machines trop faibles en performance pour les applications métier actuelles, mais encore fonctionnelles pour être utilisées comme 'simples navigateurs web', n'a pas à renouveler son matériel grâce aux offres de Cloud Computing adaptées. Là encore, l'idéologie sert le marketing.Et demain?

On est en droit d'imaginer des solutions applicatives adaptées au grand public. D'abord avec des bureaux en ligne réactifs et assez bien pensés par exemple, comme le propose déjà en partie Eyeos. Ensuite, avec des applications susceptibles de gérer des flux multimedias en masse, ce qui n'est pas encore le cas de manière efficace : lire des fichier audio ou vidéo hébergés sur nos espaces de stockage en ligne est une possibilité qui manque aujourd'hui, mais qui pourrait arriver demain avec la fibre par exemple.Plus loin encore, on pourrait imaginer comme certains l'ont déjà fait des solutions de jeux vidéos en ligne. Pas question ici de parler de « FarmVille », ou de « ZumaDeluxe » : on parle de jeu ! (un truc qui poutre quoi !). Des services tels qu'OnLive permettent d'entrevoir ce que pourrait être l'expérience de « jeu dans le Cloud » (fonctionne uniquement avec versions Windows et Mac 32 bits, sous certains navigateurs). Mais il faut bien admettre que beaucoup de questions se posent concernant la qualité de la bande passante, comme le montre cet article. On constate malgré les avancées possibles en matière d'équipement qu'il est difficile d'entrevoir une adaptation massive de ce type de technologies dans un futur proche. Aussi, certains pensent déjà à créer des jeux sous d'autres formes, notamment avec HTML5 et Javascript, comme Quake2 GWT. Certes, le rendu graphique est loin d'égaler un Crysis, ou autres, mais pourrait faire penser que l'avenir est dans le navigateur web. Trop tôt pour le dire...

Une autre approche pourrait être celle du calcul scientifique. L'avènement des plateformes telles que Tesla, de Nvidia, apporte de nouveaux horizons dans ce domaine. Peer 1 Hosting propose donc de ne pas se soucier des problématiques d'hébergement tout en bénéficiant de ressources de calcul importantes.

Que faut-il retenir de ce paysage en construction qu'est le Cloud Computing?

Pour commencer, les définitions sont bien belles, mais cela reste du marketing : le concept s'explique, se discute et surtout n'est pas une révolution. On ne le répétera jamais assez. Le développement du Cloud Computing passera certainement par son adoption au sein des etreprises, pour qui les offres commencent à être nombreuses. La rentabilité étant l'objectif numéro 1, ces entreprises sont susceptibles de payer beaucoup plus que les particuliers, et sont les cibles principales du Cloud, les offres gravitant autour d'applications et d'environnements métier. Reste la question de la sécurité et de la confidentialité des données stockées, qui sont potentiellement exposées à des négligences, voire pire. Etant donné que le modèle économique du Cloud repose sur un système d'abonnements (notamment pour les solutions proposées par Windows), il est encore trop tôt pour proposer des solutions au grand public.Ce dernier regrettera donc qu'on ne lui accorde pas plus d'importance, et trouvera son bonheur dans des solutions d'hébergement, ou encore par l'utilisation des GoogleApps. Mais finalement, est-ce nouveau ? Non, car cela fait un moment que nos messageries sont délocalisées sur des serveurs, qu'il s'agisse de Gmail, Hotmail ou d'autres. Cela fait un moment également que les GoogleApps sont disponibles, que nos communications passent par des réseaux sociaux comme Facebook ou GoogleTalk. Nos habitudes ne changeront donc pas, et l'utilisation des applications web auxquelles nous sommes habituées connaissent seulement une « reclassification » : d'applications utilisées librement, elles passent à l'état de SaaS, par exemple. Ceci va d'abord permettre de définir des champs d'applications, mais également de distinguer des niveaux de support, et enfin et surtout d'appliquer des prix. L'idée est donc simple : faire en sorte que les prestataires de services de Cloud structurent les offres sur différents niveaux. Quant à l'avenir des applications web, il est la plus grande question. C'est par ces applications que le grand public trouvera ou non son compte dans le concept : aujourd'hui axée sur la productivité en entreprise. Demain axée sur le divertissement ? Développement à suivre, donc.

Quoi qu'il en soit, le Cloud Computing est encore trop "frais" pour tirer des conclusions. On ne peut toutefois qu'apprécier le fait de pouvoir synchroniser tous types d'appareils vers des espaces de stockage, qu'il s'agisse de PC, de smartphones ou autres : tout est fait pour centraliser le traitement et la gestion des données, et c'est plutôt une bonne chose. Laissons les différents acteurs contribuer au développement du Cloud Computing, en espérant toutefois que le succès du concept ne crée pas une trop forte demande, ce qui ferait grimper les prix. Gardons donc un oeil sur ces ensembles de termes, sans quoi nous pourrions vite nous retrouver noyés sous un raz-de-marée marketing, puisque cette discipline devient de plus en plus avantageuse pour les prestataires et éditeurs, mais de plus en plus pénible pour la compréhension des internautes.