Bienvenue à Laval Virtual

Laval, chef lieu de la Mayenne, accueille depuis dix ans un salon consacré à la réalité virtuelle. Pourquoi ce salon, qui est le plus grand en Europe sur ce thème, a-t-il vu le jour dans ce département du grand Ouest ? Simplement parce que, il y a plus d'une décennie de cela, de nombreux acteurs ont eu la volonté de développer un pôle d'excellence autour de la réalité virtuelle. Ce choix a permis à Laval de se doter progressivement d'équipements (écoles d'ingénieur, centre de recherche...), de mettre en place des rendez-vous et d'attirer les entreprises spécialisées. A présent reconnu, le salon Laval Virtual est un événement qui attire tant les professionnels que le grand public. Quels ont été les temps forts de cette édition 2008 ?La réalité virtuelle peut prendre mille visages et s'inviter dans des domaines aussi variés que l'apprentissage technique, l'architecture, l'aide à la décision ou encore le jeu et la création artistique. Nous vous invitons à présent à un retour vidéo sur cet événement haut en couleurs.

| S1283754W150 | S1283756W150 | S1283758W150 | S1283832W150 |

| ATI - Paris 8 : l'oreiller rêveur | CEA List : apprentissage virtuel | Château des Ducs : Nantes en 1757 | ENSAD : une table musicale |

| S1283848W150 | S1283888W150 | S1283892W150 | S1283760W150 |

| Immersion : l'Eye Tracker | Intuilab : une table interactive | Kyushu University : jeu casse-tête | Futurim@ge : les écrans 3D |

| S1283894W150 | S1283904W150 | S1283928W150 | S1283936W150 |

| Projet Part@ge : maquette virtuelle | SAS Cube : qui a tué... ? | Total Immersion : la réalité augmentée | Visimmo 3D : maisons virtuelles |

ATI - Paris 8 : un oreiller qui invite au rêve

Un salon centré sur les technologies et qui laisse une place à l'expression artistique, ce n'est pas si fréquent. C'est pourtant le cas de Laval Virtual qui permet à des étudiants de venir présenter leurs réalisations de fin d'études, que celles-ci aient vocation à avoir un avenir industriel... ou pas. C'est pour le moment à cette seconde catégorie qu'appartient le projet sur le thème du rêve présenté par Armella Leung, une étudiante de l'école ATI (Arts et technologie de l'image - Université Paris 8).Son installation artistique prend la forme d'un oreiller dont la surface blanche dissimule des capteurs sensitifs (7 rangées de 7, qui quadrillent la surface de l'oreiller pour détecter la position de la ou des mains, soit 49 capteurs au total) et sert de support de projection à cinq animations oniriques. Les capteurs sont plus précisément disposés à 2 cm sous la surface, sous une couche de mousse, et sont capables de réagir dès que l'on s'approche à moins de 3 cm de l'oreiller. Il aurait été possible d'avoir une détection sans contact avec ce genre de capteurs capacitifs, mais ici le but était d'avoir la sensation douce du tissu sous les doigts. L'installation fait également appel à quatre capteurs de pression, un à chaque coin, pour détecter le moment où l'on enfonce sa main dans l'oreiller.

Le but du dispositif est de retranscrire modestement quelques aspects du rêve, tout en simulant le phénomène de sommeil de plus en plus profond. Au tout début, l'oreiller est parfaitement blanc, comme un oreiller normal. Puis le visiteur qui le touche voit apparaître des ondes à sa surface et découvre ainsi qu'il y a une interactivité. Pour plonger véritablement dans le rêve, il lui faut alors enfoncer sa main plus profondément. C'est à nouveau une pression prononcée qui lui permet de passer à la séquence suivante et d'aller ainsi de rêve en rêve. Chacune des cinq animations tente d'illustrer l'une des facettes du rêve parmi lesquelles :

- l'exploration d'univers fantastiques ;

- l'ambiguïté de la frontière entre rêve et réalité (pendant notre sommeil, nous pouvons par exemple être amenés à ressentir une chaleur qui n'a plus rien de réel lorsque l'on se réveille) ;

- la toute-puissance (pouvoir déclencher la pluie...) ;

- la présence d'une logique différente qui fait que l'histoire vient par bribes et que le rêve semble être raconté dans le désordre.

CEA List : la réalité augmentée au service de l'apprentissage

Quel étudiant n'a jamais rêvé de voir un ordinateur prendre la relève d'un professeur mal-aimé ou peu compétent ? Même si les contenus multimédia ont déjà largement bousculé les méthodes d'apprentissage traditionnelles, un pas supplémentaire semble avoir été franchi depuis l'intégration de la réalité virtuelle dans les supports d'apprentissage. Comment sont conçus ces nouveaux dispositifs, et que peuvent-ils nous apporter ? Telles sont les questions auxquelles nous avons tenté de répondre en nous rendant sur le stand du CEA List (Laboratoire d'Intégration des Systèmes et des Technologies) pour découvrir deux projets qui préfigurent peut-être ce que sera l'apprentissage dans les années à venir.L'humain virtuel au travail dans l'usine du futur

L'un des projets présentés sur le stand du CEA List a pour nom de code Perf RV2 et concerne « l'humain virtuel au travail dans l'usine du futur ». L'environnement représenté est celui d'un opérateur sur une chaîne de montage. La simulation est rendue possible par la présence de capteurs de position sur l'opérateur et par l'utilisation d'une interface haptique à retour d'effort qui lui permet de ressentir les contacts et les collisions. La position des capteurs est analysée par des caméras de tracking qui simulent en temps réel le déplacement de l'avatar dans la scène virtuelle.La contrainte du temps réel se fait particulièrement sentir dans ce type d'application où il faut que le « clone virtuel » bouge à la même vitesse que l'opérateur qu'il représente. Le but du projet montré ici est de tester la faisabilité d'un montage tout en prenant en compte la personne qui réalise la tâche. Les pièces vont-elles bien s'assembler ? L'opérateur risque-t-il de faire obstacle à l'assemblage dans certaines situations ? Cette dernière question est en effet essentielle, et un exemple simple peut suffire pour nous en convaincre : faire passer une feuille sous une barrière. L'opérateur commencera ce geste très simplement jusqu'au moment où son bras se trouvera bloqué par cette même barrière, l'empêchant de finir son geste. D'où l'importance de valider l'accessibilité d'un opérateur dans un environnement complexe tel qu'une chaîne de montage.

Une plateforme d'apprentissage aux gestes techniques

Créée à la demande de Renault, la seconde plate-forme en démonstration sur le stand du CEA List est destinée à l'apprentissage des gestes techniques. Le principe n'est plus ici de simuler en temps réel le comportement de l'opérateur, mais d'augmenter la réalité (le pistolet et les contours des objets) au moyen d'une information virtuelle (le mastic), de façon à lui permettre de tester un geste technique.A l'heure actuelle, Renault dispose déjà en interne d'écoles de dextérité qui forment les opérateurs à des gestes et à des exercices métier. Si le constructeur s'intéresse toutefois à une plateforme de formation telle que celle qui est développée par le CEA, c'est parce qu'elle présente l'avantage d'être facile à déployer dans les usines, de permettre de minimiser les coûts (le formateur est moins présent, on ne gâche plus de mastic) et de soulager le formateur.

Le scénario présenté ici permet de s'entrainer à la pose d'un joint de colle (autour d'une fenêtre, autour d'un phare...), lequel geste est bien plus délicat à réaliser qu'on ne pourrait le croire. Les capteurs sont ici présents sur le pistolet et non plus sur l'opérateur. On retrouve toutefois le principe de la caméra infrarouge chargée de capter les signaux émis par le pistolet, le type de pression sur la gâchette, l'inclinaison de l'embout... Chaque essai fait l'objet d'une évaluation automatique qui permet à l'opérateur de connaitre sa marge de progression. L'application est également conçue pour permettre à l'utilisateur de disposer d'assistances pour mieux guider son geste.

Initié depuis un an, ce projet tire à présent vers sa fin. Une fois livré à Renault, le module fera l'objet d'une évaluation sur site avant d'être déployé dans les usines, en remplacement ou en complément d'un formateur. Faut-il y voir, comme nous le laissions entendre en introduction, la préfiguration de ce que seront les formations dans les années à venir ? Quoi qu'il en soit, ce projet a retenu l'attention du jury du salon qui lui a décerné le Trophée Laval Virtual, catégorie Industrie Automobile, Aéronautique et Transport, ce qui peut être vu comme un encouragement à continuer sur cette lancée.

Château des Ducs de Bretagne : bienvenue dans le Nantes de 1757

La ville de Nantes était représentée sur le salon Laval Virtual, via son musée d'histoire. Ré-ouvert en février 2007 suite à une restauration et installé dans le château des Ducs de Bretagne, ce musée présente une particularité, celle d'être jalonné de dispositifs multimédia.Au moment de l'élaboration du cahier des charges du projet « Nantes en 1757 », les solutions techniques retenues étaient pour le moins ambitieuses comme en témoigne le choix de la haute définition pour l'ensemble des programmes audiovisuels et multimédia. Ambitieux, le budget l'était lui aussi avec une enveloppe de trois millions d'euros (soit 5 % du budget global consacré à la restauration) répartis pour 1/3 dans les investissements matériels et pour 2/3 dans les contenus multimédia. Les moyens mis à disposition ont notamment permis au projet de bénéficier de sept écrans 23 pouces et de sept bornes interactives en 1 920 x 1 200 que les visiteurs peuvent piloter au moyen de joysticks. Tous les moyens ainsi déployés ont pour vocation de permettre de raconter la ville au moment où l'on abat l'enceinte médiévale et qu'elle prend sa physionomie moderne.

L'application débute par un survol automatique de Nantes et se poursuit par une reprise en main au moyen du joystick qui permet au visiteur de se promener dans la ville à hauteur d'homme. Le poids des bases a obligé à fragmenter la visite en onze quartiers de façon à favoriser le chargement des nouvelles bases de textures. Le dispositif a été testé pendant un an auprès du public. Parmi les remarques qui sont remontées, il en est une récurrente venant de visiteurs perdus dans le Nantes de l'époque, faute de points de repère avec la ville d'aujourd'hui. Plutôt que d'inclure les noms de rues (différents de ceux que la ville portait en 1757), l'équipe a alors fait le choix de placer des colonnes lumineuses donnant accès à un panorama de la ville aujourd'hui. Cette fenêtre ouverte sur le Nantes du XXIe siècle permet de se rendre compte de façon plus saisissante encore de son évolution : un bras de rivière qui disparait, des maisons surélevées de quelques étages et dont on ne reconnait plus la physionomie, etc. Si la visite s'adresse surtout aux nantais ou aux amateurs d'histoire, le dispositif a pour sa part suffisamment d'arguments pour convaincre d'autres municipalités de s'essayer à la reconstitution virtuelle.

ENSAD : une table musicale qui simule les formes de vie

L'idée de départ était de travailler les algorithmes en temps réel et de façon interactive au travers d'une démarche artistique. Pour cela, l'équipe s'est inspirée des travaux de simulation de vie artificielle de Craig W. Reynolds. L'installation proposée par cette équipe pluridisciplinaire permet d'observer la mutation des formes de vie des boïds (le nom de ces drôles de petits poissons) dont le comportement est organisé selon trois règles de base :

- cohésion ;

- séparation ;

- alignement.

La table est en plastique plexiglas thermoformé. Deux capteurs sonores (placés de chaque côté de la table) lui sont reliés. Le son, qui est une des dimensions les plus importantes du programme, est spatialisé au moyen de quatre haut-parleurs et d'un caisson de basse. L'espace de projection situé en arrière-plan de la scène projette un flux HD d'images qui sont retravaillées en temps réel en fonction des informations transmises par la table. Comment peut-on interagir avec ces boïds ? La réponse en images.

Immersion : un dispositif pour suivre l'œil à la trace

Le stand de la société bordelaise Immersion abritait un étrange dispositif baptisé Eye tracker. Contrairement à ce qu'un rapide coup d'œil pouvait laisser à penser, l'outillage disponible sur le stand n'avait pas vocation à analyser le fond de l'œil, mais bien à régler une caméra capable ensuite de suivre la pupille dans chacun de ses déplacements.Un dispositif tel que le Eye tracker est un préalable à bien d'autres applications de réalité virtuelle. Au moyen de ce système de recueil et de suivi de la position de l'œil, il est en effet ensuite possible de synchroniser des casques, des systèmes de projection, des capteurs, etc. Ce dispositif trouve également des applications en ergonomie. Son principal avantage est de libérer le sujet du port du casque et de permettre d'enregistrer le mouvement des yeux sur n'importe quelle surface (un moniteur, un écran de projection...).

Dis-moi ce que tu regardes, et je te dirai...

La calibration se fait au moyen d'une mire neuf points : l'opérateur enregistre le vecteur de position en demandant au sujet de regarder tour à tour chacun de ces neuf points. Cet ajustement permet d'obtenir une précision de l'ordre de 1°.Le dispositif fait appel à deux caméras :

- une première chargée d'enregistrer les mouvements de la tête ;

- une seconde de type infrarouge qui illumine la pupille et qui est asservie électroniquement au traqueur de tête.

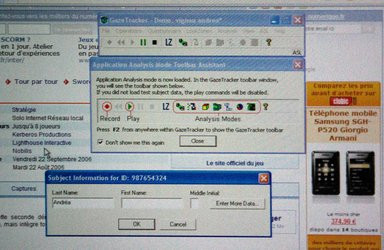

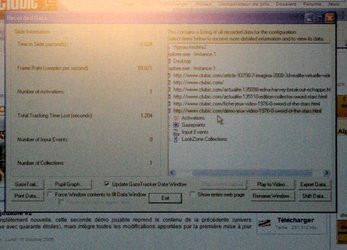

Une fois la calibration effectuée, il est possible de récupérer en temps réel le parcours oculaire du sujet. Sur les écrans de contrôle, la direction du regard est ainsi matérialisée au moyen d'un point rouge. Toutes ces informations sont ensuite recueillies numériquement pour faire de l'analyse a posteriori du comportement. A partir des différentes trajectoires rapportées, il peut ainsi être intéressant de comparer le parcours de la souris à celui de l'œil, sachant quelle celle-ci bouge en mode exploratoire tandis qu'elle se fige en mode recherche. Le logiciel Gaze tracker permet ensuite une relecture instantanée, comme sur un magnétoscope. D'autres vues sont également disponibles, telles que celle par page sur laquelle sont reproduites toutes les trajectoires du regard ainsi que tous les clics de souris.

Le logiciel Gaze tracker permet une relecture instantanée comme sur un magnétoscope ainsi qu'une consultation des résultats page par page

Intuilab : une table interactive pour partager ses photos

Si Surface de Microsoft est assurément la plus connue des tables tactiles, elle est loin d'être la seule disponible sur le marché comme en témoignent notamment les solutions proposées par Immersion ainsi que par la société toulousaine Intuilab. Sur le stand de cette dernière était ainsi présentée une table tactile multipoints équipée d'une application de partage de photos.Mieux que Flickr, la table Intuilab ?

Contrairement à Immersion (une société qui édite une solution concurrente sur laquelle nous revenons plus bas) qui se concentre sur la technologie de la table, laissant aux entreprises la charge d'imaginer d'éventuelles applications pratiques, Intuilab a à cœur de proposer des solutions concrètes comme en témoigne celle que l'on découvre notre vidéo et qui permet d'organiser ses photos de façon intuitive au moyen de trois étapes :1 - la récupération de l'information temporelle contenue dans les Exifs de façon à disposer les images sur un slide show ;

2 - la géolocalisation des photos sur la planisphère (les données viennent de Google Maps, le moteur de chez Intuilab) ;

3 - le tagging lexical (réponse aux traditionnelles questions « Où ? », « Quoi ? » et « Comment ? »).

La table mise au point par Intuilab a également ceci de spécifique qu'elle met l'accent sur le dialogue avec d'autres périphériques. La table peut ainsi être reliée à un vidéo-projecteur pour diffuser l'information à une large échelle et faciliter le partage avec le public ou encore être reliée à un Pocket PC. D'une façon plus générale, l'idée est de faciliter les échanges et les allers-retours entre un espace collaboratif (la table) et des espaces privés (le Pocket PC par exemple). D'autres usages sont également envisagés : borne interactive dans un musée, etc.

Du côté de la technologie

La technologie utilisée est de type FTIR (Frustrated Total Internal Refraction). Elle fait appel à des diodes infrarouges placées à un centimètre sous la surface de la table, sur ses deux côtés. Cette technologie est concurrente de celle appelée DI (Direction Illumination) choisie par Immersion et qui fait appel à un réseau de diodes qui illuminent toute la surface au lieu d'être implantées uniquement sur les côtés. La conséquence la plus manifeste de ce choix est une sensibilité supérieure dans le cas de la technologie DI, sensibilité qui ne doit pas être vue uniquement comme un avantage. Chez Immersion, le simple fait d'approcher la table peut en effet être détecté, ce qui n'est pas forcément souhaitable (déplacements non souhaités d'objets...). Qu'en est-il justement de la solution proposée par Immersion ?Retour sur la solution d'Immersion

Pour l'utilisateur, le changement le plus sensible concerne la surface qui dispose à présent d'un rendu plus doux et qui permet une meilleure glisse. Alors que l'agrandissement des images nécessitait l'intervention des deux mains et un geste d'étirement très accentué, cette même manipulation est à présent obtenue au moyen d'un simple effleurement des doigts d'une même main. Outre les améliorations apportées à la surface et aux algorithmes, cette table « V2 » intègre une nouvelle fonction de reconnaissance des formes qui permet aux objets physiques d'interagir avec les objets virtuels. La prise en compte des objets réels dans la simulation permet aux utilisateurs de disposer d'une nouvelle possibilité d'interaction. L'un des usages suggérés concerne l'architecture et plus particulièrement les maquettes de villes qui pourront à présent mélanger informations réelles (de vrais bâtiments que l'on posera sur la table) et informations virtuelles (les plans des constructions à venir).

La dernière nouveauté prend la forme d'un écran secondaire qui fonctionne comme une extension de la table (il est possible de faire passer un document de la table vers le moniteur au moyen d'un simple jeter). Cet écran déporté permet également à des utilisateurs distants de visualiser une partie de ce qui se passe dans l'espace de travail collaboratif. La technologie est à présent jugée suffisamment mature par Immersion pour passer à la production et à la commercialisation à partir de cahiers des charges spécifiques confiés par les clients (intégration de la vidéo, utilisation d'un projecteur HD...).

Kyushu University : un jeu de constructions impossibles

Le salon Laval Virtual permettait aux visiteurs de faire quelques pauses ludiques sur leur parcours. Pour autant, il est certains créateurs pour qui jouer ne signifie pas forcément renoncer à tout effort cérébral, loin de là ! Tel était le cas sur le stand de l'université de Kyushu où un post-doctorant - Jun Fujiki -, présentait plusieurs de ses travaux.Basés sur le principe de la 3D synthétique, ces travaux exploitent les possibilités d'illusions optiques offertes par la 3D, s'inspirant en cela des constructions impossibles du graphiste Escher. Tous les tableaux sont créés au moyen des cinq éléments de base que sont :

- le cube ;

- le bonhomme ;

- le trou ;

- le trampoline ;

- l'escalier.

Le principe a séduit Sony qui en a fait un jeu pour PSP et PS3. Déjà sorti au Japon sous le nom de Mugen Kairou, ce jeu de réflexion sera disponible à compter de mai en Europe sous le nom de Echochrome. En attendant la sortie et pour aller plus loin dans la découverte des travaux de Jun Fujiki, vous pouvez vous rendre sur son blog sur lequel il présente ses nombreuses réalisations.

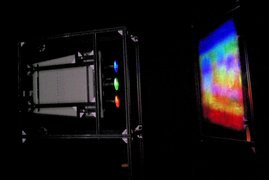

Futurim@ge : des écrans 3D pour s'immerger dans les vidéos

Réseau lenticulaire ou barrière parallaxe ?

Quelles sont donc les solutions qui permettent de voir en relief sur un écran LCD classique, et ce, sans avoir à utiliser de lunettes spécifiques ?Une première technologie est celle qui fait appel à un réseau lenticulaire. Il s'agit de la solution retenue par un constructeur tel que Philips. La technologie lenticulaire nécessite un filtre 3D rajouté devant un écran plat 2D sur lequel on diffuse un contenu spécifique. Le principe consiste à reproduire la vision binoculaire humaine, c'est à dire à afficher sur l'écran deux vues légèrement décalées de la même scène, une pour chaque œil, le cerveau se chargeant ensuite de les rassembler pour créer le relief. Le filtre 3D sert à diffuser les vues dans des directions différentes afin que chaque œil ne reçoive que la vue qui lui est destinée. Les neuf vues affichées par l'écran permettent au spectateur de se déplacer latéralement tout en conservant une vision en relief.

La seconde solution présente sur le stand fait pour sa part appel à un écran spécifique équipé d'une barrière parallaxe et à un contenu spécifique. C'est le choix fait notamment par Sharp et Newsight. Ces moniteurs font appel à une alternance de lignes optiques et transparentes qui cachent certains sous-pixels de façon à ce que les deux yeux ne voient pas la même chose. Chaque image est ainsi composée à partir d'informations pixel en provenance de huit images.

Si ces deux solutions présentent chacune son lot d'avantages, toutes deux souffrent surtout du fait d'être des technologies propriétaires et de nécessiter des formats d'entrée spécifiques. D'où la nécessité, comme cela a été fait pour la TVHD, de poursuivre des travaux en normalisation du transport de la TV3D pour tous.

Les autres solutions pour bénéficier du relief

Quelles sont les solutions pour produire des contenus en relief ?- Filmer avec plusieurs caméras : cette solution suppose que les caméras soient parfaitement alignées, ce qui est très complexe à mettre en œuvre.

- Utiliser une caméra équipée d'un capteur qui génère automatiquement la carte de profondeur : cette technologie est à l'étude, mais elle n'est pas encore au point.

- Convertir les contenus 2D en contenus 3D : cette solution peut se comparer à la celle de colorisation des films noir et blanc. Elle permet de donner un second souffle à des contenus, mais elle ne peut faire véritablement illusion.

Projet Part@ge : travail en équipe sur une maquette virtuelle

La plateforme Part@ge accueillait de nombreux projets portant sur le travail collaboratif en temps réel au travers d'une maquette numérique.L'un d'entre eux, confié par EDF à des chercheurs de l'INSA, est un cas pratique concernant une simulation d'écoulement de l'air dans une pièce. Le but de la modélisation est d'améliorer la compréhension des phénomènes physiques et permettre l'optimisation des dispositifs industriels. Cela peut par exemple consister à étudier l'efficacité énergétique du moyen de chauffage sur le cas présenté, ou encore le transfert de chaleur au sein d'une centrale électrique. Si une modélisation et un outil collaboratif de ce type s'avèrent utiles, c'est parce que les quantités de données disponibles sont si phénoménales qu'il se produit un goulot d'étranglement au niveau de l'étape d'analyse. A quoi bon des données, si on ne peut pas les exploiter ?

Une fois les données mises en forme, les chercheurs bénéficient d'outils pour naviguer à l'intérieur des représentations et les annoter. Chacun a la possibilité de modifier la taille de son avatar de façon à adopter une échelle plus adaptée aux données qu'il souhaite observer. En cas de phénomène digne d'intérêt, le chercheur peut ensuite déposer un marqueur pour attirer l'attention de ses collègues et les inviter à le rejoindre. Il peut également faire venir directement l'un de ses collaborateurs en prenant le contrôle de son avatar. Chaque point de vue déjà annoté sur lequel se rend un chercheur lui offre directement la bonne orientation et la bonne échelle pour voir ce que son collaborateur souhaite lui montrer. Outre les marqueurs déjà évoqués, les participants disposent d'un casque qui leur permet de se coordonner vocalement.

La démonstration de travail collaboratif à laquelle nous avons assisté regroupait trois utilisateurs situés sur des postes distants, l'infrastructure étant d'ores et déjà capable de gérer une vingtaine d'utilisateurs simultanés. Les solutions de ce type, qui permettent à des spécialistes distants d'accéder à la donnée de façon collaborative dans un univers en 3D, sont-elles amenées à se développer et à modifier ainsi les habitudes de travail dans les labos ?

SAS Cube : pour entrer de plain-pied dans la réalité virtuelle

En-dehors des salons tels que Laval Virtual pour les besoins desquels il est démonté et transporté, le SAS Cube est présent à demeure à CLARTE et mis à disposition des entreprises pour leur permettre de bénéficier des avantages de la virtualisation sans avoir à réaliser des investissements hors de portée pour elles. Malgré son côté ludique, le SAS Cube a donc une vocation industrielle. Il permet en effet aux entreprises de faire du prototypage virtuel, ce qui se révèle précieux dans le cas de réalisations trop coûteuses pour permettre de procéder par essais et erreurs. C'est le cas notamment des avions et des bateaux pour lesquels il faut faire bon du premier coup de façon à éviter les coûts de reprise. Pour des projets industriels de ce type, le SAS Cube peut donc aller jusqu'à remplacer le prototypage traditionnel.

Comment est construit le SAS Cube ?

Le système est composé de quatre écrans qui servent d'espaces de projection pour quatre vidéoprojecteurs capables d'afficher de la stéréo active (ce qui permet d'avoir l'image en relief). Il est également équipé de quatre caméras situées à chacun des angles supérieurs et chargées de suivre la position des marqueurs présents sur les lunettes du joueur. L'installation est complétée par quatre PC haut de gamme équipés de cartes NVIDIA Quadro.

Le dispositif du SAS Cube fait notamment appel à 4 projecteurs et 4 caméras situées à chacun des angles de la structure et chargées de capturer la position des marqueurs

Les marqueurs présents sur les lunettes permettent à l'ordinateur de connaitre la position de l'utilisateur à l'intérieur du SAS et de calculer ainsi des images dont la perspective est correcte, ce qui est une démarche différente de celle du jeu vidéo où l'on est obligé de changer la perspective avec la souris. Quant au pistolet - et pour poursuivre l'analogie avec le jeu -, il est conçu pour permettre d'interagir avec la scène à la façon d'un joystick sans fil. Le dispositif fait enfin appel à un moteur de jeu (3D Virtools) qui dispose de modules de réalité virtuelle. Le SAS Cube emprunte donc largement à la technologie du jeu vidéo tout en y ajoutant des dispositifs qui permettent une meilleure immersion et une meilleure interaction.

Qui a commis un meurtre dans le SAS Cube ?

À l'occasion de notre passage dans le SAS Cube, nous avons pu expérimenter le simulateur virtuel d'investigation criminelle (SiVIC) conçu pour permettre l'analyse d'une scène de crime virtuelle. Place à la démonstration de ce scénario mis au point par des étudiants de l'ESCIN.Total Immersion : quand des objets du quotidien prennent vie

Comment la réalité virtuelle peut-elle ainsi se matérialiser de façon très concrète via des objets du quotidien ? Pour répondre à cette question, il suffit de se rapporter au cœur de métier de Total Immersion - la réalité augmentée -, c'est à dire les techniques d'enrichissement d'un objet au moyen de données 3D. Cet enrichissement peut prendre la forme d'une image 3D, d'une animation ou encore d'un clip vidéo qui viennent se superposer sur l'image en suivant un scénario pré-établi. Deux solutions de tracking étaient visibles sur le stand de Total Immersion, faisant chacune appel à un modèle de référence spécifique : une surface plane dans le premier cas, une forme de visage dans le second.

Quand une surface plane s'anime

Pour « tracker » un objet, il faut d'abord caractériser l'image de référence (qui devra être assez riche, comme l'est la boîte de Lego montrée dans l'animation), puis définir ce que l'on souhaite mettre dessus. Cette image de référence est ensuite détectée par la caméra qui appelle le scénario prédéfini. Pour une brochure double-page telle que celle qui est montrée dans la vidéo, il faut compter deux à trois semaines de travail (modélisation, intégration des animations puis réglages sur place).Parmi ses clients, Total Immersion compte le Futuroscope de Poitiers pour lequel elle a développé la partie logicielle de l'animation « Les animaux du futur ». Les technologies de tracking et de réalité augmentée peuvent également trouver des applications dans le domaine de l'événementiel, avec par exemple une personne équipée d'un flipboard sur lequel on rajoute des informations et des chiffres. A plus longue échéance, une autre application pourra consister à disposer des bornes dans les supermarchés de façon à délivrer plus d'informations sur le produit (remises éventuelles, prix, précautions d'utilisation...). Pourquoi ne pas imaginer, également, les internautes que nous sommes, accédant au moyen d'une simple webcam devant laquelle on placera le produit, à son guide d'utilisation, aux fiches techniques des différentes versions, etc. ?

Miroir, mon beau miroir...

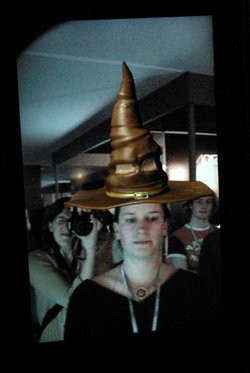

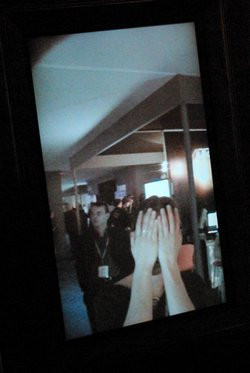

La seconde animation du stand se base sur la reconnaissance des visages. Dès qu'une personne se présente devant le « miroir magique », elle se voit aussitôt affublée d'un accessoire de type lunette ou chapeau qui la suivra dans ses déplacements. Pour faire cesser l'animation, il suffit de passer la main devant son visage. De cette façon, le tracking s'interrompt pour reprendre ensuite sous une nouvelle forme : choixpeau magique, casque de légionnaire...

Lorsque le miroir magique repère un visage (sa forme de référence), il l'agrémente d'un accessoire. Pour faire cesser l'animation et passer à la suivante, il faut passer les mains devant son visage de façon à interrompre le tracking

Visimmo 3D : quand une maison s'anime

Visimmo 3D est une entreprise dont le cœur de métier est l'immobilier, et plus particulièrement l'aménagement et la décoration intérieure. Ses clients sont principalement les groupements de constructeurs de maisons individuelles auxquels elle offre des outils qui leur permettent de mieux communiquer auprès de leurs clients et de réduire les coûts de commercialisation.Une maquette pour prendre possession de sa maison

La situation qui est au cœur de sa solution est celle de l'acheteur d'une maison individuelle qui, une fois l'acte de vente signé, doit patienter dix bons mois ou plus avant de voir les plans prendre vie. Les maquettes virtuelles réalisées par Visimmo 3D lui permettent donc de prendre possession de son bien avant qu'il ne soit livré. En prenant comme point de départ le plan d'architecte, Visimmo 3D s'attache à modéliser la maison ou l'appartement et à l'intégrer dans son environnement. Cette maquette 3D est ensuite enrichie au moyen d'un module de vue 3D en temps réel (Intérieur / Extérieur) et hébergée en ligne de façon à permettre à l'utilisateur d'y accéder depuis n'importe quel ordinateur. Alors que de nombreuses solutions se contentent de proposer des visites guidées programmées (de simples vidéos), l'originalité de la solution de Visimmo 3D tient à la possibilité de se déplacer dans l'environnement en temps réel et à celle de pouvoir faire la visite en ligne (sans installation de logiciel préalable donc). Les déplacements se font au moyen de la souris et du clavier. L'interface intègre un plan qui permet de repérer sa position dans l'environnement tandis qu'un outil de capture offre à l'utilisateur la possibilité de prendre des photographies virtuelles de l'espace sous les angles de son choix.Pour une surface inférieure à 200 m2, il en coûtera environ 15 € / m2 (soit 2 000 à 3 000 euros pour une maison individuelle). Un projet de cet ordre nécessite cinq jours de réalisation, de la réception du plan à la mise en ligne, le client étant associé à toutes les phases du projet de façon à éviter d'éventuels retours en arrière coûteux et chronophages. Quant aux promoteurs qui ont fait appel à ce type de solutions, ils peuvent en tirer partie pour permettre la réservation directe d'un bien sur Internet, ce qui est autant de gagné sur les coûts de commercialisation de leurs programmes immobiliers.

Un salon à organiser en mode collaboratif

Autre type de réalisation auquel s'intéresse Visimmo 3D : la réalisation de salons dédiés. Les clients disposent d'une interface qui leur permet de puiser dans une bibliothèque d'objets réalisée à partir de photos communiquées par l'organisateur. Tous les éléments du salon (stands, merchandising...) sont personnalisables au moyen de textures, coloris ou encore visuels en provenance des documents personnels de l'utilisateur. L'un des points forts du dispositif est de disposer d'un mode collaboratif basé sur un système de droits (Administrateur / Utilisateurs / Visiteurs). Dans le cadre d'un salon, chaque entreprise peut ainsi créer son stand et voir ce qu'il donne au moyen d'une visite virtuelle avant de le valider.Dernière utilisation suggérée : la réservation virtuelle de places de théâtre. Via une interface très intuitive, certains lieux de spectacles permettent dès à présent aux spectateurs de choisir et réserver ainsi leurs places.