Nous ne parlerons aujourd'hui que de ce dernier, qui constitue donc le processeur graphique (GPU) le plus performant disponible à ce jour. Les cartes architecturées autour de lui ne sont pas encore disponibles mais ne devraient plus tarder (on parle de novembre) et leurs prix devraient se situer sous la barre symbolique des 3000 francs.

Un GeForce3 Ultra ?

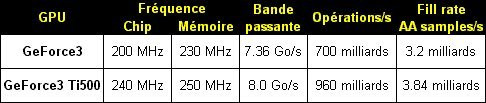

Forcément comme nous venons de faire le parallèle entre le cheminement du GeForce2 et celui du GeForce3, parler d'un chip plus puissant que ce dernier fait immédiatement penser à une sorte de GeForce3 Ultra. Sans que ce soit l'exacte réalité, on peut toutefois dire qu'il y a une part de vrai. Mais avant d'entrer dans les détails rappelons brièvement quelques petites choses du GeForce3 pour tout ceux qui n'auraient pas lu notre précédent article.Les caractéristiques principales des GeForce3 et GeForce3 Ti500 sont effectivement les mêmes. Ils possèdent tout deux le même nombre de transistors (57 millions) et de Pixel Pipelines (4) mais diffèrent légèrement dans leur gravure puisque le Ti500 fait appel à une technologie 0.15 micron dite "avancée". En quoi consiste-t-elle exactement ? Nous pouvons raisonnablement supposer qu'il s'agit simplement d'une optimisation afin de permettre au core d'atteindre des fréquences plus élevées. En effet, le GeForce3 doit se contenter d'un 200MHz pour le core et 230MHz (DDR) pour la mémoire, là où le GeForce3 Ti500 se permet un core cadencé à 240MHz et de la mémoire à 250MHz (DDR).

Ces changements de fréquences jouent évidemment en faveur du GeForce3 Ti500, qui peut donc se vanter de proposer des performances théoriquement supérieures. En particulier la bande-passante passe à 8.0Go/s quand elle n'était "que" de 7.36Go/s sur le GeForce3 de base.

En dehors de cela l'aspect purement technique du GeForce3 Ti500 ne diffère que très peu. Le nombre de textures simultanées par pixel reste inchangé à 2, de même que le nombre maximum de textures actives par pixel et par passe (4). Enfin le nombre d'opérations de Pixel Shading (36) et d'instructions par Vertex par passe (128) restent eux aussi identiques.

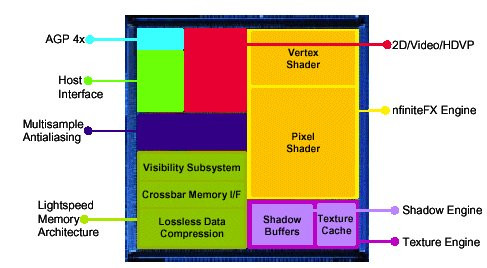

Lightspeed Memory Architecture et nfiniteFX

Les caractéristiques techniques du GeForce3 Ti500 sont donc très proches de celles du GeForce3, ce n'est pas surprenant si l'on considère que NVIDIA compte bien remplacer ce dernier par son nouveau bébé. S'il n'a pas daigné améliorer ses caractéristiques préférant procéder à une augmentation de fréquence, NVIDIA a toutefois ajouté une petite touche non-négligeable aux capacités du petit nouveau.C'est au sein du moteur nfiniteFX qu'il faut aller chercher ces "innovations", répondant aux doux noms de Shadow Buffers et 3D Textures. Parler d'innovations est un petit peu fort puisque ces fonctions existaient déjà dans le GeForce3 de base mais n'étaient pas activées au niveau logiciel... C'est maintenant chose faite. Avant de détailler plus avant ces fonctions, il me semble opportun de rappeler à tout ceux qui encore une fois seraient passé à côté des descriptifs techniques du GeForce3, en quoi ce GPU changeait la donne.

Les trois pages suivantes sont donc largement reprises de notre précédent test. Ceux l'ayant déjà lu, peuvent dès lors directement se rendre en page 5, pour y découvrir les 3D Textures et les Shadow Buffers.

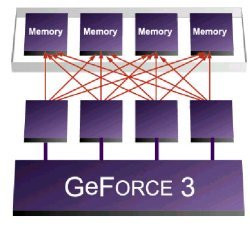

Contrôleur de mémoire "Crossbar"

Il faut en fait détailler un peu plus les choses. Le Crossbar est composé de quatre unités indépendantes capables de traiter chacune des blocs de 64 bits pour donc un total de 256 bits. C'est cette division en quatre unités qui est la clef d'une meilleure gestion de la mémoire. En effet la tendance actuelle est à une plus grande précision dans les scènes 3D. Les personnages et objets sont plus complexes et comportent donc de plus en plus de petits éléments.

Dans ses documentations techniques NVIDIA prend l'exemple certes excessif mais bien compréhensible, d'un triangle d'une taille de 2 pixels représentés en "couleurs vraies" (32 bits). L'ensemble des données couvrant la définition de ce triangle est donc de 64 bits (2*32) et oblige un déchet de 192 bits pour un contrôleur classique. Les quatre modules du Crossbar évitent donc ce gâchis tout en permettant de traiter 256 bits de données par cycle d'horloge en les groupant.

Z-Occlusion Culling

Kézako occlusion culling ? Il est vrai que des trois, c'est certainement la plus difficile à deviner, mais pour vous aider un peu sachez déjà que cela se rapproche pas mal du fameux Tile Rendering du Kyro 2 et qu'il s'agit d'une technique destinée à réduire la quantité d'éléments à être rendus.Actuellement lorsqu'une scène 3D est calculée, elle l'est dans son ensemble et on ne se préoccupe de savoir si telle ou telle partie sera visible qu'au moment de l'affichage proprement dit, une fois que tous les calculs ont été effectués. Le Z-Occlusion Culling se propose de faire cela avant même la phase de rendu et en évitant de calculer les pixels qui ne seront pas visibles, il permet de gagner jusqu'à 50% de bande passante dans les scènes actuelles.

Z-Buffer Compression

Ce système de compression permet évidemment de réduire les données relative à la profondeur des pixels (coordonnée Z, en plus des classiques coordonnées x et y). Pour faire simple c'est cette profondeur qui détermine au moment du rendu final si tel ou tel pixel sera finalement visible à l'écran ou bien masqué par un autre.Plus la scène est complexe et plus les informations relatives à la profondeur seront nombreuses, c'est pour cela et pour éviter une surcharge mémoire issue du trafic généré que NVIDIA a mis au point cette compression. Il s'agit en fait d'un "simple" algorithme qui permet de diviser par quatre ce flux d'information sans aucune perte de qualité pour ne pas altérer le rendu final.

Bye, bye T&L ?

Eh oui ! Aussi étonnant que ça puisse paraître : exit le T&L. Après nous en avoir rabattu les oreilles pendant des mois, après nous avoir dit que tout les jeux allaient très bientôt l'utiliser et que c'était ça qui rendaient leurs cartes plus puissantes que les autres, les ingénieurs de NVIDIA ont décidé que ce Transform & Lightning n'était finalement pas assez bien pour nous... Soit.

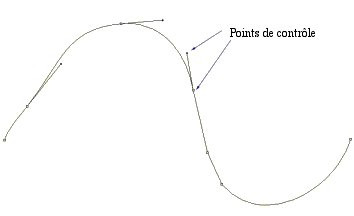

Ce remplaçant est peut-être la plus grande innovation du GeForce3 et se nomme prosaïquement : nfiniteFX. Mis à part un nom à coucher dehors, il faut reconnaître que ses caractéristiques ont vraiment l'air époustouflantes. Ce nouveau moteur est la combinaison de deux modules dont les noms découlent directement de leur cible : d'un côté les Pixel Shaders qui agissent évidemment sur les pixels et de l'autre les Vertex Shaders pour tout ce qui concerne les vertices (sommets des triangles qui composent tout polygone).

L'un comme l'autre, ces deux modules ouvrent des perspectives totalement nouvelles aux développeurs de jeux en leur offrant un contrôle beaucoup plus grand. En utilisant les instructions mises au point par NVIDIA, ils devraient ainsi pouvoir ajouter leurs propres algorithmes au GeForce3 et ne plus être limités à ce que les ingénieurs du GeForce3 auront pris soin d'intégrer (une sorte de T&L programmable en fait). Associée aux capacités intrinsèques du chip graphique et à différents effets comme l'Environmental Bump Mapping, cette plus grande liberté devrait ouvrir la voie à un réalisme sans précédent dans les titres avenir.

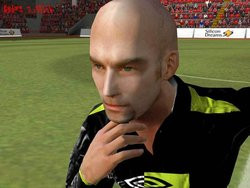

A titre de rappel, le bump mapping de type "Environmental", autrefois réservé aux seuls chips Matrox G400, est un effet 3D qui permet de simuler le relief grâce à des jeux de lumières. La méthode "Environmental" est actuellement ce qui se fait de mieux en terme de Bump Mapping puisqu'elle permet des effets de reliefs très complexes et très réalistes comme on peut le voir dans 3D Mark 2001 ou GL-Mark (cf. photo ci-dessus prise à partir d'une GeForce 3).

L'animation d'un personnage pourra facilement être plus fluide, plus précise, avec un grand soucis du détail pour son visage ou le mouvement de ses vêtement. NVIDIA prend l'exemple simple d'un drapeau qui pourra onduler de manière beaucoup plus réaliste, ou d'un animal dont la respiration pourra se voir aux mouvements de son torse !

La même démo de Zoltar sur GeForce2 sans la technologie nFinite FX

HRAA

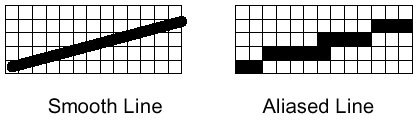

Pour terminer avec cette description technique et avant d'attaquer ce que vous attendez tous à savoir les tests à proprement dit, il faut parler de ce HRAA. Derrière cet acronyme barbare se cache en fait quelque chose que tout le monde connaît : le High Resolution Anti-Aliasing (Anti-crénelage haute-résolution), c'est à dire une sorte de Full-Scene Anti-Aliasing.Le principal défaut de nos scènes 3D est ce que l'on peut résumer à un effet "d'escalier". Il s'agit en fait de limitations propres aux techniques d'affichage employées qui provoquent des déformations d'images. Pour y remédier la technique la plus élémentaire consiste à afficher des résolutions toujours plus élevées mais l'on se heurte alors aux limitations de nos écrans et à la gourmandise des scènes alors générées.

L'idée finalement encore assez récente de feu 3dfx pour contrer cet effet "d'escalier" se nomme Anti-Aliasing. Le principe est on ne peut plus simple : il s'agit de pousser le GPU à calculer en interne (sans que rien ne soit afficher) la scène dans une résolution supérieure à celle qui sera finalement utilisée. Il suffit ensuite au moment du rendu d'appliquer un filtre avant l'affichage à la résolution souhaitée.

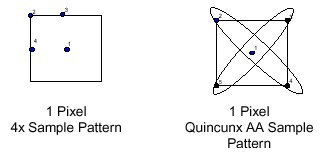

Le GeForce 2 inclue bien sûr cette technique et offre des modes 2x et 4x, qui calculent l'image dans une résolution 2 fois et 4 fois supérieure. Si la qualité d'affichage est correcte, il n'en est pas de même de la vitesse qui chute de manière vertigineuse au point de ne rendre le 4x jouable que sur GeForce 2 Ultra et encore !

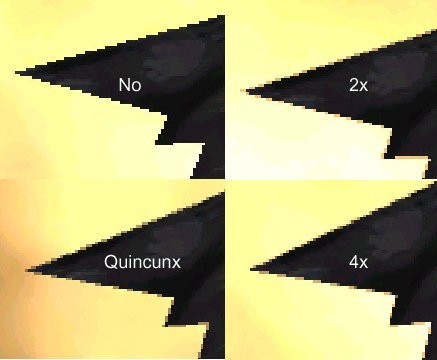

Avec son nouveau processeur graphique, NVIDIA inaugure le Quincunx. Cette fonction est censée nous donner la qualité du FSAA 4x, tout en conservant la vitesse du 2x. Pour arriver à cette prouesse, il "suffit" d'opérer une interpolation plus intelligente des points, en se référant sur plus de pixels alentours comme le montre le schéma ci-dessus. Il en résulte une qualité d'image évidemment supérieure et l'exemple ci-dessous fourni par NVIDIA en atteste bien, maintenant il faudra vérifier dans nos tests ce que montrent les résultats officiels pour pouvoir affirmer que les performances n'en patissent pas trop.

High Order Surface

Derrière ce terme, se cache une nouvelle fonction qui va permettre d'économiser la bande passante du port AGP limitée dans le meilleur des cas à 1,056 Go/sec (AGP 4x). Vous ne le savez peut-être pas, mais aujourd'hui les développeurs sont freinés par cette limitation de bande passante. C'est effectivement via le port AGP que sont transférés ce qu'on appelle les Vertices (les sommets des triangles qui composent un scène 3D).Les scènes 3D sont aujourd'hui de plus en plus complexes, car elles utilisent un nombre toujours plus important de triangles et, de ce fait, le port AGP 4x commence à montrer ses limites. Il a donc fallu trouver une solution à ce problème de bande passante, celle que NVIDIA propose aux développeurs se nomme : HOR (High Order Surface).

Tout n'est toutefois pas rose et bien que cette fonction HOS soit partie intégrante de DirectX 8, elle doit malgré tout être intégrée aux différents moteurs 3D pour être exploitable (dans le cas où il ne s'agit pas du moteur intégré à DirectX). Ceci implique bien sûr d'importantes modifications, que tous les développeurs ne seront pas forcément enclin à faire et le support d'une telle fonction n'est pour le moment qu'hypothétique.

Maintenant que cette longue phase de rappels est terminée, il est temps de voir les innovations que NVIDIA a ajouté au GeForce3 Ti500 !NVIDIA n'a donc pas inclus d'énormes innovations à son GeForce3 Ti500 et s'est en fait contenté d'activer avec ses nouveaux Detonator XP deux technologies de son fameux nfiniteFX. Technologies que nous détaillons maintenant, puisque cela n'avait pas été fait lors du test du GeFroce3 de base.

3D Textures

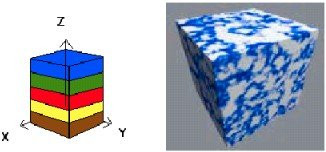

Evolution technologique oblige, NVIDIA a décidé de passer la vitesse supérieure avec le GeForce3 Ti500 en introduisant le support des textures 3D qui permettent aux développeurs d'appliquer enfin un effet de profondeur (axe Z) dans la réalisation de leurs textures. Cet ajout de la 3ème dimension aux textures permet aux développeurs de concevoir des objets 3D beaucoup plus réalistes.

Cependant l'utilisation des textures 3D peut parfois poser des problèmes. NVIDIA propose ainsi aux développeurs une série de technologies que nous allons maintenant détailler et qui permettent de les résoudre.

La compression de textures 3D

Vous l'aurez certainement deviné l'utilisation de texture 3D consomme plus d'espace mémoire qu'une simple texture 2D du fait de la gesiton de la profondeur. Par conséquent, une simple texture 3D de 256x256x256 suffit à remplir les 64 Mo de mémoire des cartes GeForce3 Ti. Pour venir à bout de ce problème, NVIDIA propose un système de compression des textures qui offre deux taux de compression (4/1 et 8/1) ce qui permet de réduire la taille de cette texture 3D à seulement 8 Mo. Malheureusement cette réduction de taille doit certainement se faire au détriment de la qualité.La distorsion des textures 3D

La prise en compte du facteur profondeur avec les textures n'est pas sans posé des problèmes de distorsion. Ainsi, l'application d'une texture 3D de type cubique sur un objet sphérique risque de faire apparaître à l'écran un objet avec une texture pour le moins déformée. Pour résoudre ce problème NVIDIA propose d'appliquer un effet Mip-mapping au texture 3D pour améliorer leur aspect à l'écran.Sur le schéma ci-dessous, la première photo représente l'aspect de l'objet avant mip-mapping puis la deuxième montre l'amélioration apportée par le mip-mapping :

Meilleure gestion du cache

Mais si la texture est déformée l'utilisation de ces références seront faussées et ne serviront strictement à rien. Elles monopoliseront en revanche la mémoire cache pour rien, d'où l'intérêt d'utiliser le Mip-mapping capable de venir à bout de ce problème en affichant des textures non déformées.Observons désormais ce que les textures 3D vont permettre aux développeurs de créer :

- Imposters : Cette technologie permet aux développeurs d'économiser les ressources graphiques nécessaires pour afficher certaines scènes 3D. Cette technologie repose sur un procédé bien connu que nous allons maintenant décrire.

Il est toujours plus coûteux en puissance de calcul de faire le rendu complet d'un objet 3D (où le chip graphique doit calculer, filtrer, tester chaque pixel pour voir s'il devra être affiché à l'écran ...), que d'afficher une simple texture 2D qui sera devra représenter l'objet 3D, à partir d'une position de vue.

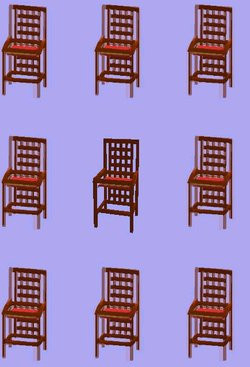

Le graphique ci-dessous illustre d'ailleurs parfaitement bien ce principe, la chaise du milieu est celle modélisée en 3D alors que les autres ne sont que des "clônes" représentées sous la forme de textures 2D.

Ce même procédé était utilisé dans les anciens jeux comme Doom ou Duke 3D pour afficher les monstres qui n'étaient en fait modélisé que sous 8 angles (vue de face, vue arrière, vue de gauche, vue de droite et les quatre diagonales) différents, auxquels correspondaient 8 textures 2D différentes.

L'une de ces textures était affichée selon l'angle sous lequel on observait le monstre. Autant dire que les possibilités de voir les monstres sous plusieurs angles étaient très limités, et quand cela avait lieu sous vos yeux on ressentait un gros effet de saccade (on voit le monstre de face, puis d'un seul coup on le voit de dos).

Grâce à l'utilisation de la profondeur, les textures 3D viennent à bout de ce problème, puisque les objets "clônes" affichés à partir de textures 3D ne sont plus plats.

- Les textures 3D peuvent également être utilisée pour créer de nombreux autres effets, comme la possibilité de créer des explosions plus réalistes, ou des effets de plasma.

Shadow Buffers

Pas plus nouveaux que les 3D Textures, ces Shadow Buffers sont eux-aussi activés grace aux Detonator XP et n'avaient donc pas été décrit lors du test du GeForce3... C'est maintenant chose faite...Ces Shadow Buffers sont finalement assez simples à comprendre. La motivation de NVIDIA quant à l'élaboration de cette technologie est élémentaire. Dans les jeux actuels la recherche de l'image la plus réaliste possible nécessite la mise en place de plus de détails par toujours facile à rendre. Parmi les plus délicats figurent sans conteste les éclairages et surtout les ombres qu'ils induisent.

Afin de parvenir à rendre de la meilleure façon possible ces ombres NVIDIA a mis au point une technique visant à créer une sorte de "carte" des objets éclairés pendant la scène. Cette "carte" portant la dénomination anglaise de Shadow Map, est justement stockée dans la zone nommée Shadow Buffer, accessible par le reste du hardware du GeForce.

Si NVIDIA a opté pour une carte des zones éclairées plutôt que pour les zones dans l'ombre, c'est tout bonnement que cela simplifie et donc accélère nettement les temps de calcul. En effet alors qu'il n'existe qu'un seul point "lumineux" par coordonnée XY, ce dernier induit plusieurs points d'ombres. En outre, NVIDIA a pu, grâce à ces Shadow Buffer, utiliser les techniques de filtrage des textures afin de créer des ombres moins brutales, avec des transitions plus douces.

Pour résumer, voici, illustrés, les avantages de la technique de Shadow Mapping de NVIDIA que permettent les Shadow Buffers, sur les autres techniques existantes:

- Le rendu de scènes complexes: le shadow mapping fonctionne aussi bien sur des scènes dites "légères", que sur d'autres extrêmement chargées en objects.

- Adoucissement des contours des ombres: grâce à un algorithme propriétaire, le shadow mapping peut adoucir les ombres en employant les 256 niveaux d'ombrages.

- Self shadow: les objets peuvent se refléter sur eux-mêmes (le bras d'une personne se reflète sur son torse).

- Compatible avec le rendu à multiples textures.

Ouf ! La partie à proprement parler "technique" est terminée, il faut donc maintenant voir un peu ce que ces merveilles technologiques peuvent apporter en terme de performances.

L'Hercules 3D Prophet Ti500

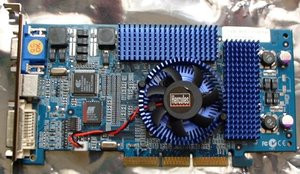

Hercules nous propose donc logiquement une carte basée autour du dernier chip haut de gamme du spécialiste de la 3D : la Hercules 3D Prophet III Ti 500. Physiquement, la carte ne présente quasiment aucun changement par rapport au design utilisé pour la 3D Prophet III basée autour du GeForce3.

Le désormais célèbre PCB bleu, qui semble bien devoir devenir la marque de fabrique d'Hercules, est donc de la partie. Bleu qui est également présent sur les indispensables accessoires que sont les radiateurs placés sur la RAM et le combiné radiateur/ventilateur placé directement sur chip graphique.

Si l'on ôte délicatement ces petits radiateurs RAM on s'aperçoit que Hercules a pencher en faveur d'une classique mémoire de type 3.8ns de marque EliteMT. Les autres caractéristiques de la carte restent communes autres cartes GeForce3 : sortie TV gérée par un chip Conexant, sortie DVI ...

Cependant, le bundle sort un peu de l'ordinaire, puisqu'on notera la présence de l'excellent logiciel lecteur multimédia/MPEG2 PowerDVD, dans sa version 3.0, du Hercules Tweaker pour les bidouilleurs et d'une planche d'autocollants pour ceux qui souhaiteraient décorer leur tour.

Au niveau overclocking nous avons dû nous limiter lors de nos tests à un déjà satisfaisant 260 MHz/575 MHz pour le chip graphique et la mémoire. La carte semblait pouvoir accepter des fréquences mémoire plus élevées mais malheureusement au bout d'une vingtaine de minutes elle restait plantée sous 3DMark 2001.

Gainward Ti500 Golden Sample

Gainward est une marque de carte graphique qui commence (enfin) à voir le jour chez certains revendeurs français, nous avons donc logiquement testé leur dernière carte graphique haut de gamme basée sur un chip Ti500.Il est toutefois important de préciser que Gainward proposera en plus de cette Ti500 Golden Sample, une version "XP" qui sera visiblement équipée d'une mémoire d'excellente qualité.

Comme les autres cartes signées Gainward, la Ti500 Golden Sample se présente sous la forme d'une carte à dominante rouge (PCB, ventilateur, radiateur). Le design de la carte est à ce sujet plutôt réussi, agréable à regarder pour toutes les personnes n'étant pas allergique à la couleur rouge.

Mis à part cela, on retrouve sur la Ti500 GS de Gainward la classique sortie VGA et les sorties DVI / TV désormais communes à toutes les GeForce3 Ti500. Afin d'exploiter au mieux la sortie TV (lecture de DVD principalement), cette Ti500 est livrée avec le très bon logiciel WinDVD 3.0.

A propos d'overclocking sachez que comme toutes les cartes Gainward, cette Ti500 Golden Sample est livrée avec le tweaker propre à la marque : Expert Tool (cf. capture d'écran ci-dessous).

Configuration et logiciels de test

Les GeForce3 et GeForce3 Ti500 sont tout deux des chips on ne peut plus récents. Il est donc à peu près évident que les logiciels traditionnellement utilisés pour analyser les performances des Cartes Graphiques sont moins à même de mettre en évidence une quelconque différence.Sans être particulièrement novateurs nous avons, comme certains de nos confrères l'ont déjà fait, décidé d'élargir quelque peu nos tests en faisant participer d'autres programmes comme AquaMark ou DroneZMark en plus du classique Quake3. Le toujours renouvelé 3D Mark sera évidemment de la partie dans sa version 2001, de même que Giants pour prendre un exemple plus concret.

L'ensemble des tests ne s'est pour le moment fait qu'avec le système d'exploitation Windows 98 Second Edition. Nous avons choisi d'écarter Windows 2000 du fait de sa relative confidentialité et surtout, nous ajouterons des tests sous Windows XP sitôt que ce nouvel OS sera disponible. De plus nous avons choisi de ne comparer que les GeForce3 entre eux et d'écarter toute autre compétition peu significative... Le seul concurrent du GeForce3 Ti500 est pour le moment le GeForce3, bien que le Radeon 8500 arrive.

La configuration utilisée n'a rien de révolutionnaire, c'est un machine puissante mais qui compte tenu du prix des composants n'est pas inaccessible. L'absence d'Intel se justifie par le coût vraiment très faible des composants AMD. Notez enfin qu'un ultime test portera sur une machine architecturée autour d'un Duron 800 afin de voir le comportement du Ti500 sur un processeur plus "faible".

Asus A7M266

Athlon 1.33Ghz (bus 266MHz)

256Mo de mémoire DDR

Disque dur 60GXP 40Go

Pilotes VIA 4en1 v4.33

GeForce3 64Mo DDR

GeForce3 Ti500 64Mo DDR

A titre d'information nous avons également décidé d'intégrer aux différents graphiques les résultats obtenus, uniquement en 32 bits, avec les cartes Ti500 de Hercules et de Gainward une fois overclockées.

Performances OpenGL

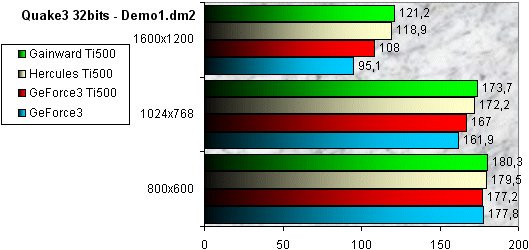

Les tests OpenGL commencent invariablement par les résultats de ce bon vieux Quake3. Il ne tire peut-être pas pleinement parti de l'architecture du GeForce3 mais après tout c'est aussi le cas de beaucoup d'autres titres et puis son moteur est encore assez répandu...

Que ce soit en 65000 couleurs ou en 16 millions, on ne peut pas dire que les différences soient éclatantes. Quake3 n'est pas à même de surcharger suffisamment les Processeurs graphiques pour que le Ti500 puisse tirer son épingle du jeu.

Il est cependant un petit peu au-dessus dès que la charge devient plus importante (1024x768 en 32 bits) et se démarque encore plus nettement en très haute résolution. En 1600x1200 couleurs 32bits, on peut ainsi observer un peu plus de 10fps d'écart entre les deux cartes.

De leur côté, les cartes Ti500 d'Hercules et de Gainward offrent un gain de performances réellement significatif qu'avec le 1600x1200 et malgré une différence de 15 MHz au niveau de la fréquence mémoire entre le modèle Hercules et celui de Gainward, les deux cartes restent difficilement départageables.

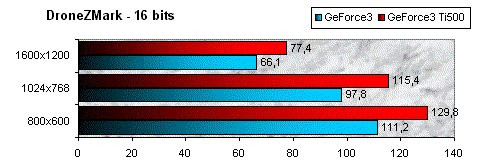

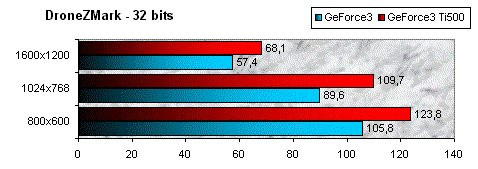

DroneZ offre des résultats quelques peu différents même si en définitive la conclusion restera à peu près identique. Les écarts sont plus importants et toujours en faveur du GeForce3 Ti500, il n'y a plus les petites surprises qui ne veulent rien dire du 800x600. Il y a par contre une nette domination du Ti500 en 1600x1200.

En effet quelque soit le nombre de couleurs, on peut voir plus de 10 images par seconde d'écart, preuve que l'accroissement de la bande passante est loin d'être inutile.

Après avoir vu les résultats en OpenGL, il faut s'intéresser au Direct3D, nettement majoritaire dans les jeux actuels.

Performances Direct3D

Comme nous venons de le dire, Direct3D est l'API dominante dans le monde du jeu PC, il est donc plus qu'important de voir comment se comporte le Ti500 avec des titres à ce standard.

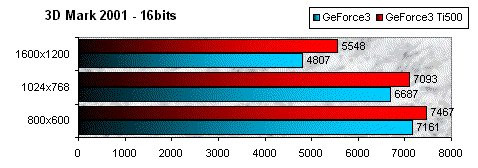

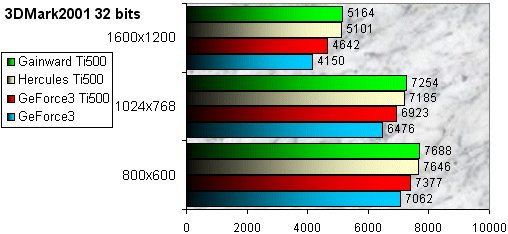

Les benchs de 3D Mark 2001 fournissent une gamme complète de tests afin d'analyser la plupart des fonctions 3D actuelles. Les tests sont longs mais plutôt précis et à ce jeu là le GeForce3 Ti500 fait des merveilles.

Sans pouvoir parler d'écarts énormes, les différences restent significatives. Le GeForce3 Ti500 est toujours devant et les écarts se creusent à mesure que la résolution augmente pour atteindre un peu plus de 700 points en 1600x1200 65000 couleurs.

Une fois de plus, c'est seulement en 1600x1200 que la puissance offerte par les cartes Ti500 d'Hercules et de Gainward une fois overclockées, est réellement perceptible. La différence entre les deux quoique minime, est en faveur de la carte de chez Gainward.

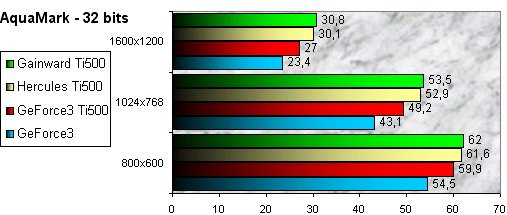

AquaMark est un bench dérivé d'AquaNox le jeu à venir de Fishtank. Il présente l'avantage d'être particulièrement optimisé pour les GeForce3 et les résultats obtenus par nos deux compétiteurs le montrent assez bien, même si les différences restent faibles.

On notera que là encore, ce n'est qu'avec le 1600x1200 que le GeForce3 Ti500 parvient à réellement se détacher même s'il est devant de manière bien visible dans tout les cas de figure.

Une fois n'est pas coûtume, les cartes d'Hercules et de Gainward offrent cette fois-ci un gain de performances d'environ 11% en 1600x1200x32 une fois overclockées. Différence non négligeable s'il en est, alors que l'écart entre les deux modèles tient à trois fois rien.

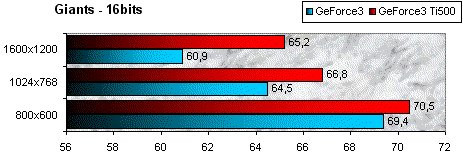

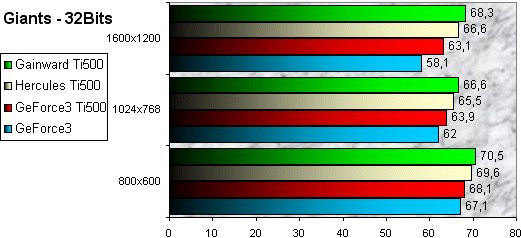

Enfin, pour compléter tout cela nous avons choisi un jeu bien connu pour sa gourmandise : Giants. Il fut aussi l'un des premiers jeux à nous faire envie avec sa version optimisée GeForce3...

Giants ne modifie en rien les résultats que nous avons par ailleurs observés. Il vient les confirmer une nouvelle fois et apporte une ultime preuve de la supériorité du GeForce3 Ti500 dès que les très hautes résolutions sont atteintes. Les GeForce3 sont en fait confrontés à un problème lié à leur (presque ?) trop grande puissance : les Processeurs suivent difficilement et les jeux ne peuvent les surcharger à plus "faible" résolution.

Il semble qu'il faille attendre que les développeurs incorporent davantage de détails pour que l'on puisse vraiment profiter de ces petites merveilles... A moins de s'essayer au très gourmand Full-Scene Anti-Aliasing...

La réserve de performances offerte par les cartes overclockées des fabricants Gainward et Hercules est ici moins significative que pour AquaMark, puisqu'en 1600x1200, elle n'est que de 7.4%.

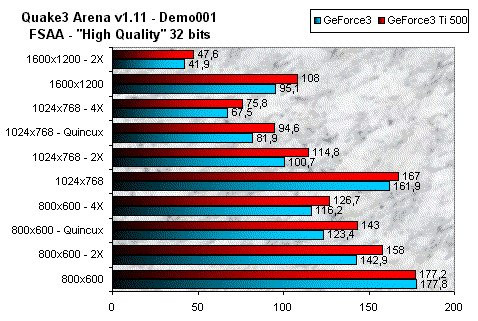

Performances en Full-Scene Anti-Aliasing

Si certains sont allergiques au flou engendré par ce procédé, on ne peut nier que c'est un moyen assez redoutable de diminuer l'effet d'escalier de nos moteurs à base de 3D polygonale. C'est aussi un excellent moyen de tester les Cartes Graphiques tant la charge de travail imposé par un mode 4X à de quoi mettre à genoux n'importe quel chip graphique.

Nous avons tout d'abord effectué nos tests avec Quake3 qui surprend un peu par les faibles écarts affichés. On aurait ainsi pu penser que le mode spécial de NVIDIA, le Quincux, aurait mis en évidence une certaine optimisation du GeForce3 Ti500 mais il n'en est rien.

Encore une fois, les différences existent mais ne sont pas très marquées, nécessitant l'emploi de très hautes-résolutions pour être notables.

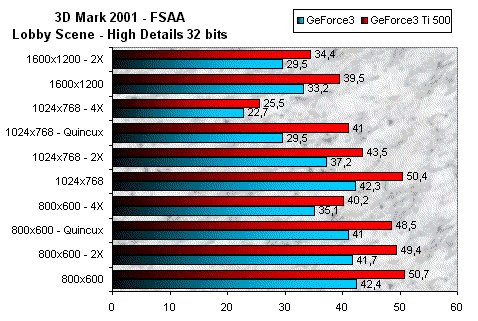

3D Mark 2001 nous permet de confirmer les résultats obtenus sous Quake3 et démontre donc très clairement la supériorité du GeForce3 Ti500 dès lors que la charge de calcul devient très importante, mais il n'y a pas d'écrasante victoire.

La bande passante supplémentaire du Ti500 n'est bien sûr pas étrangère à cette prestation. On peut toutefois être un peu déçu que les augmentations, assez importantes, de fréquences entre les deux modèles ne soient pas davantage perceptibles.

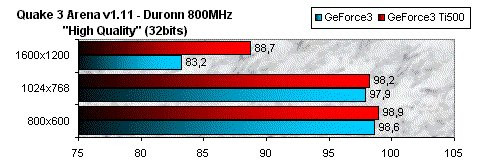

Performances avec un Duron

Nous avons décidé de terminer cette série de tests par une ultime mesure des performances sous Quake3, mais cette fois sur une machine dotée d'un processeur moins performant : un Duron 800. La carte mère employée étant une Abit KT7.

Les différences entre GeForce3 "standard" et Ti500 sont ici encore plus faibles qu'avec les autres tests, preuve que le pauvre Duron est bien loin de permettre au dernier né de NVIDIA d'exprimer toute sa puissance.

Le GeForce3 ne commence à être exploité qu'avec le 1600x1200 qui permet là encore de distinguer les deux modèles, le Ti500 signant un joli 88.7fps quand le GeForce3 standard se contente de 83.2fps. Il n'en demeure pas moins que l'intérêt de telles cartes graphiques sur des machines équipées de Processeurs "modestes" est très limité.

Conclusion

Alors le GeForce3 Ti500 simple instrument marketing afin de couper l'herbe sous le pied d'ATI dont le prochain Radeon 8500 aurait des performances au niveau du GeForce3 standard ? Il y a sûrement un peu de cela, mais aussi certainement une réelle volonté de NVIDIA de clarifier sa gamme. Le GeForce3 Ti500 s'inscrit effectivement dans une plus large optique qui vise à revoir une partie de l'offre du constructeur avec trois modèles de processeurs graphiques : GeForce2 Ti, GeForce3 Ti200 et notre GeForce3 Ti500.

Les cartes Ti500 en elles-mêmes sont, de plus, proposées aux mêmes tarifs que les modèles GeForce3, il n'y a donc pas vraiment lieu de se plaindre. Plutôt qu'une révolution, NVIDIA nous propose donc une évolution tranquille de son produit phare dont l'argument principal est bien sûr le prix.

Désigner un vainqueur au duel Gainward / Hercules tient vraiment de la gageure tant les deux cartes sont proches. Que l'on parle de performances, d'offre logicielle ou de prix (450€, environ 2950FF TTC). Reste alors pour les départager, la légère supériorité de la mémoire équipant la Gainward permettant un overclocking un peu plus important.

Il faut toutefois ajouter que les cartes Gainward restent encore plus difficile à trouver que celles du français Hercules. A défaut de mettre la main sur une Ti500 Gainward vous pourrez donc, sans soucis, opter pour la petite de chez Hercules.