Vous pensiez avoir échappé aux mauvaises surprises « high-tech » de l'année 2009 ? Cette petite séance de rattrapage remettra les pendules à l'heure ! Elle donnera aussi l'occasion de se retrouver pour partager les moments de solitude consécutifs aux petites déceptions liées aux nouvelles technologies. Vous avez acheté un PSP go et regardez votre pile d'UMD avec un air songeur ? Vous essayez de surfer avec une Livebox 2 ? Vous découvrez avec bonheur un échéancier sur 10 ans pour payer votre facture 3G ? Les exemples qui prouvent que les nouvelles technologies ne sont pas toujours synonyme de progrès ne manquent pas, notre grappe de flops 2009 est là pour le rappeler à notre bon souvenir !

Les produits « phares » de l'année...

Livebox 2 : le pire de la Livebox ?

Après l'effroyable Livebox Mini, dont nous nous étions fait l'écho des nombreux et inénarrables bugs, nous avions fondé de grands espoirs dans la Livebox 2. Succédant à la Livebox Mini, celle-ci offrait quelques nouveautés sympathiques comme la présence de quatre connecteurs Ethernet (pratique pour éviter la multiplication des switchs) ou encore l'intégration du Wi-Fi i802.11n sans oublier l'arrivée du mode full-routé ! De quoi s'agit-il me direz-vous ? De proposer sur le même câble Ethernet les services de TV numérique et d'accès au réseau local. En d'autres termes, si votre décodeur TV n'est pas directement relié à votre Livebox, la liaison que vous lui offrez via CPL par exemple, permet non seulement de transmettre les programmes TV mais aussi un accès au réseau. En mettant donc un simple switch on peut alors bénéficier de l'Internet sur ses consoles (exemple) alors que le décodeur Orange reçoit les programmes TV. C'est séduisant sur le papier puisque les précédentes Livebox, hors Livebox Mini, n'offrent pas cette subtilité.Convaincus par l'intérêt de cette fonctionnalité, et persuadé qu'Orange ne commettrait pas une deuxième fois l'erreur de mettre un produit non finalisé sur le marché, nous nous sommes empressés d'acquérir cette Livebox 2. Bilan, celle-ci fut changée au bout de 15 jours... le temps de s'apercevoir qu'Orange, visiblement confronté à un problème de chauffe sur ses Livebox 2 a modifié leur carénage pour doter les nouveaux modèles d'une très élégante coque perforée pour une meilleure dissipation thermique (et un meilleur encrassement, elle est déjà toute... noire !).

Malgré l'échange, les problèmes demeurent, le firmware D0 comporte divers bugs reconnus dont un plantage de la connexion Internet lors de l'utilisation de réseaux point à point. En clair en moins d'une heure d'utilisation d'uTorrent, la connexion Internet tombe. Et si d'aventure vous n'utilisez pas de logiciel point à point, il faudra tout de même redémarrer régulièrement la box car le service TV affiche un écran désespérément noir et ce malgré le bandeau indiquant le nom de la chaîne et le programme en cours. Heureusement, sur cette Livebox 2, Orange a eu la bonne idée de positionner un bouton de mise en marche facilement accessible : pratique pour les nombreux redémarrages ! Bilan des courses : après plus d'un mois de galères avec non pas une mais deux Livebox 2, retour à la Livebox Pro première génération certes sans mode full routé mais fiable et avec un service TV qui fonctionne en permanence.

Inutile de dire qu'à la rédaction on attend avec impatience la Livebox 3... au tournant !

Palm : le bonheur n'est pas dans le pré

Une fois n'est pas coutume, un excellent appareil débarque dans notre sélection annuelle de flops. Ce mauvais présage prouve - s'il en était besoin - que les meilleurs produits ne sont pas nécessairement ceux qui se vendent le mieux. Avant sa sortie, le Palm Pré a été annoncé en fanfare. Souvenez-vous, il n'y a pas si longtemps que cela, Palm faisait figure de référence incontestable dans le domaine des assistants personnels de poche aussi appelé « PDA » (il n'était pas encore question d'intégrer des fonctions de téléphonie). Pour diverses raisons que nous ne détaillerons pas, la célèbre marque américaine est passée du statut de leader à celui - peu enviable - d'outsider. Palm comptait sur son tout nouveau « Pré » pour opérer un retour en force dans le marché des Smartphones.L'appareil est loin de manquer d'atouts (OS flambant neuf convaincant, processeur identique à l'iPhone 3G S, clavier coulissant), mais il semble nous prouver à nouveau que le meilleur des produits doit toujours être accompagné d'une stratégie commerciale viable pour avoir une chance de connaitre le succès qu'il mérite. Malheureusement, avec le Pré, Palm semble enchainer les erreurs stratégiques. Tout d'abord, lors de son lancement le 6 juin sur le territoire américain, les ventes ont été freinées par une pénurie dont se serait volontiers passé le Pré. Cette erreur prévisionnelle est d'autant plus regrettable qu'à la même date était également commercialisé un concurrent de poids : l'iPhone 3G S.

Autre problème et non des moindres : depuis le début et jusqu'à ce jour, Palm à choisi de signer un contrat d'exclusivité avec Sprint qui n'est autre que le quatrième opérateur de téléphonie mobile aux États-Unis et au Canada. Quoi de mieux pour limiter l'impact des ventes du Pré ? La sortie européenne aurait pu laisser espérer un revirement stratégique, mais cette fois encore, la déception est grande. Alors que le constructeur s'efforce d'expliquer à qui veut bien l'entendre qu'il attache de l'importance aux stratégies de commercialisation internationale, le 14 octobre, Palm nous refait le coup du partenariat douteux. En effet, le Pré est sorti en Europe en exclusivité chez Telefónica (en Allemagne, Angleterre, Irlande et en Espagne). Vous ne parveniez pas à mettre la main sur un Pré dans l'Hexagone ? Logique, cet opérateur de téléphonie mobile n'est pas présent sur notre territoire ! Heureusement, cette exclusivité ne durera que 6 mois, mais en attendant, l'iPhone 3G S pourra continuer sereinement son ascension prodigieuse (50% de part de marché des Smartphones en France à l'heure où nous écrivons ces lignes). L'excellent Pré devrait finalement sortir en France à partir d'avril, mais alors qu'un quatrième iPhone verra logiquement le jour quelques mois après, les jeux ne sont-ils pas déjà faits ?

Windows Mobile 6.5 : quand Microsoft s'appuie sur les constructeurs tiers

Même si l'on est adepte du système nomade de Microsoft, il faut bien se rendre à l'évidence. Depuis l'arrivée en fanfare des nouveaux environnements pour smartphones, Windows Mobile a pris un très sérieux coup de vieux. Certes, l'ancêtre possède encore de beaux restes (logithèque exhaustive, multitâche, possibilités de personnalisation, outils bureautiques natifs, etc.), mais face à Android (Google) et à l'iPhone OS (Apple), l'interface semble provenir d'un autre âge. Windows Mobile 6.1 n'avait pas apporté d'améliorations significatives, tous les espoirs se toueraient donc vers l'énigmatique Windows Mobile 6.5.Il faut dire que deux ans après la sortie de l'iPhone en France, on était en droit d'attendre une réponse forte de la part de Microsoft. Une réelle refonte semble être nécessaire pour éviter de perdre des parts de marché progressivement grignotées par Apple (et Google dans une moindre mesure). Le premier septembre 2009, le verdict tombe : Windows Mobile 6.5 n'incarnera toujours pas l'évolution (ou la révolution) tant attendue. Finalement, il faudra se contenter d'améliorations qui vont dans le bon sens, certes, mais qui ne permettent toujours pas de piloter intégralement l'appareil sans avoir à dégainer constamment son stylet. Cet immobilisme est d'autant plus incompréhensible lorsqu'on sait qu'une autre buisness unit de Microsoft a donné naissance à une interface tactile bien plus novatrice (voir notre test vidéo du Zune HD).

Même si Microsoft a d'ores et déjà annoncé la sortie prochaine d'une version 6.5.1 de Windows Mobile (tant qu'à faire, persistions dans l'erreur), il faudra vraisemblablement attendre la version 7 pour pouvoir contempler le « saut quantique » promis par le géant du logiciel. Est-il nécessaire d'attendre si longtemps ? Pas si sûr... Au vu du test récent du Touch HD 2, on constate que certains constructeurs n'ont pas attendu le géniteur du système pour apporter une véritable vague de fraicheur. Par exemple, sur le Touch HD 2 d'HTC, le remaniement de l'interface est tel que l'on en oublierait presque que l'on est en présence de Windows Mobile. Il est étrange qu'il faille compter sur les constructeurs tiers pour finaliser un système, mais en attendant les véritables changements, il faudra se contenter de cet état de fait, ou passer à la concurrence.

Du SSD à tous les étages... pas avant 2010 !

Il ne fait aucun doute que le disque dur tel que nous le connaissons depuis plus de vingt ans est sur le point de rendre les armes. Son remplaçant est d'ailleurs bien connu de tous les amateurs de haute technologie et son nom tient en trois petites lettres : SSD. Un remplaçant qui tarde toutefois à remplir son rôle de pourfendeur des procédés archaïques et cette année 2009 aura été l'occasion de bien des désillusions sur le front du SSD. Si les prix ont effectivement réalisé un joli plongeon, il faut reconnaître qu'en la matière le vieux disque magnétique fait mieux que se défendre. Malgré la chute vertigineuse des tarifs du SSD, le disque dur traditionnel est au gigaoctet aujourd'hui environ 35 fois moins cher et encore, nous parlons alors des SSD d'entrée de gamme qui n'offrent pas les performances ou la fiabilité des modèles de pointe à plus de 150 fois le tarif au gigaoctet de nos disques magnétiques !Mais là n'est pas l'unique problème de la technologie SSD et 2009 aura été l'année de tous les dangers pour les amateurs de nouvelles technologies convertis à la nouvelle « norme » de stockage. Entre les problèmes de performances dégradées au fil de l'utilisation, de partitions perdues « comme par magie » ou de firmware défectueux, nous n'avons pas été à la fête et même les plus grands noms de l'industrie y sont allés de leur « cagade ». Intel a connu de gros problèmes avec la mise à jour de ses fameux SSD 'Postville' et ne semble même pas capable de proposer l'indispensable fonction trim sur ses modèles de génération précédente.

Samsung ne semble pas plus à son aise avec cette fonction que l'on attend toujours sur les produits du Coréen alors que chez OCZ la mise à jour implique la suppression de toutes les données présentes sur le disque. Nul doute donc que le SSD remplacera à terme les disques durs classiques. Il offre effectivement un gain appréciable en performances et en confort d'utilisation, mais il semblerait que les constructeurs doivent trimmer encore un moment avant d'être en mesure de proposer des produits aussi exemplaires que bon marché !

Sony et la PSPgo : je t'aime, moi non plus ?

Chez Sony, l'année 2009 aura été celle de la découverte de la dématérialisation. Si les joueurs PC sont déjà bien en phase avec ce phénomène, il touche encore peu les amateurs de consoles et Sony a tenté un bien étrange pas dans cette direction avec la PSPgo. Petite portable présentée comme une simple évolution de la fameuse PSP, cette nouvelle venue est arrivée en octobre dernier et... a fait un bide retentissant !S'il semble clair que pour Sony il ne s'agissait que de tester la réaction des joueurs, on se demande un peu comment le fabricant espérait nous convaincre avec les arguments qui étaient les siens. Certes, la machine est plus légère et moins volumineuse que sa grande sœur. Certes, la disparition de l'UMD pouvait être une bonne chose pour l'autonomie et la fiabilité de la bête. Mais voilà, ce sont les seuls arguments que Sony avait mis dans la balance...

... et les défauts sont autrement plus décisifs. Cela commence par la nécessité de disposer d'une connexion Internet pour obtenir le moindre jeu. Jeu qu'il faut télécharger et qui ne tarde pas à poser la question du stockage à long terme : la bête ne dispose que de 16 Go de mémoire ! Pire, Sony n'avait prévu aucune exclusivité pour sa machine et le tarif des jeux à télécharger est au mieux équivalent sinon carrément plus élevé que celui des UMD !

Des UMD qu'il est bien sûr possible de vendre / acquérir via le marché de l'occasion alors qu'aucune solution de ce type n'existe avec les jeux à télécharger pour sa PSPgo. Dans de telles conditions, on comprend mieux le chiffre décevant de 8000 exemplaires écoulés en France durant les trois premiers jours de la commercialisation de la bête... Ce sera sans doute pour la prochaine fois M. Sony.

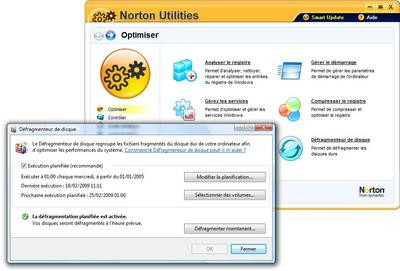

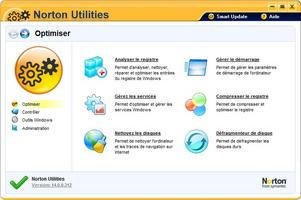

Norton Utilities 14 : le retour raté d'une vieille gloire

Norton Utilities 14 : Comme un air de famille ?

Explication : en 2007, Symantec fait l'acquisition de PC Tools, éditeur australien de solutions de sécurité (Spyware Doctor, notamment) et du logiciel d'optimisation Desktop Maestro. Plutôt que de développer un nouveau logiciel sur les bases de Norton 360 ou du vieillissant System Works, Symantec s'est contenté de reprendre Desktop Maestro tel quel, en prenant soin de repeindre l'interface en jaune (sans changer les icônes qui jurent avec le style habituel de Symantec).

Comme son modèle qui ne brillait pas franchement par ses fonctionnalités, Norton Utilities 14 se contente ainsi du strict minimum : correction des erreurs du registre, gestion assez basique du démarrage de Windows ou encore gestion des services. Le reste n'est composé de quelques raccourcis vers des fonctionnalités plus ou moins cachées de Windows. La palme revient sans aucun doute au module de défragmentation : alors que Symantec dispose de sa propre technologie dans SystemWorks et Norton 360, l'éditeur opte ici pour un simple raccourci vers le module, perfectible s'il en est, de Windows ! Et ce ne sont pas les deux outils de benchmark et de gestion des processus, hérités in extrémis de SystemWorks lors d'une mise à jour, qui sauvent le produit du naufrage. Depuis, une version 14.5 compatible Windows 7 a vu le jour, et on peut s'attendre à une nouvelle version « majeure » début 2010, mais à moins d'un miracle, TuneUp Systems et Iolo Software (éditeur de System Mechanic) peuvent dormir sur leurs deux oreilles...

Quand la technologie « révolutionne » son temps

Intel Larabee : circulez il n'y a rien à voir

Après son aventure il y a plusieurs années dans le monde des cartes graphiques avec la puce i740, Intel avait définitivement abandonné ce marché, préférant se consacrer aux solutions avec circuit graphique intégré, comme les fameux chipsets de série G, que l'on retrouve dans la plupart des ordinateurs portables notamment. En se désintéressant du marché de la carte graphique, Intel a ouvert une voie royale à ATI, depuis racheté par AMD, et NVIDIA. À tel point que la concurrence des puces graphiques de ses derniers est devenue intolérable pour Intel : le GPGPU taille en effet des croupières aux sacro-saintes offres professionnelles d'Intel... Quand une puce graphique offre de meilleures performances pour du calcul générique que le plus élaboré des processeurs Xeon... Intel voit rouge !Sentant le vent tourner, Intel a donc annoncé il y a plusieurs années son retour sur le marché de la carte graphique avec la mise au point d'une puce graphique fonctionnant en x86 et permettant d'effectuer un rendu de type lancé de rayons en temps réel. Révolutionnaire sur le papier, la puce en question étant censée embarquer plusieurs dizaines de cœurs x86, et Intel s'était donné les moyens de ses ambitions en constituant le Visual Computing Group, une unité de travail dédiée à la mise au point du projet connu sous le nom de code Larabee et en investissant des millions de dollars. Maintes fois reporté, Larabee a peu à peu pris l'eau et la dernière apparition publique d'une carte Larabee lors de l'IDF 2009 faisait peine à voir. Très loin du lancé de rayons en temps réel, la démo 3D saccadée rappelait l'époque ... du GeForce 2 ! Depuis, Intel a du annoncer publiquement que la première génération de Larabee ne verrait pas le jour sous la forme d'un produit commercial... Elle servira de plate-forme de développement pour les développeurs de jeu en attendant la deuxième génération !

Fini donc l'époque des déclarations tonitruantes d'Intel annonçant que la 3D d'aujourd'hui était condamnée, que Larabee serait bien plus performant que la plus rapide des cartes graphiques d'AMD ou de NVIDIA... Avec un tel nom... la traversée du désert était-elle... prédestinée ?

NVIDIA : pas de DirectX 11... en 2009 !

L'arrivée du GT 200 et de la série 200 des GeForce aura permis à NVIDIA de restaurer son leadership pour quelques mois à peine... Coûteuse, massive, la puce ne prenait toujours pas en charge DirectX 10.1, un véritable péché d'orgueil aujourd'hui inexcusable. Pas plus excusable d'ailleurs que la politique de prix de la firme qui a tout fait pour maintenir des prix élevés sur ses solutions alors qu'AMD cassait les prix, quitte à rendre son offre bien moins concurrentielle. Cela ne plaira pas au marketing de NVIDIA mais CUDA ou PhysX ne justifient pas un investissement de 80 à 100 euros supérieur à l'offre de la concurrence...

Et il aura fallu de très longs mois à NVIDIA avant de pouvoir décliner l'architecture trop ambitieuse du GT 200. Bilan quand NVIDIA parvient enfin, un an après la sortie du GeForce GTX 280, à proposer une première déclinaison de l'architecture avec le GeForce GT 240, AMD propose... une gamme complète de puces graphiques DirectX 11 ! NVIDIA a donc raté le virage DirectX 11, et si le géant de la puce graphique doit bientôt combler cette lacune avec les cartes issues de l'architecture « Fermi », il est cruellement en retard. Espérons pour NVIDIA que les développeurs de jeu ne lui fassent pas payer le prix fort pour ce retard...

Femtocell : flop 2009, top 2010 ?

En juin 2008, un communiqué de presse de Motorola annonçait fièrement que 2009 allait être une année-clé pour l'adoption de la technologie Femtocell en Europe. D'après ce constructeur, une étude aurait démontré que 40 % des personnes interrogées se déclaraient prêtes à investir dans une solution Femtocell. Ce pourcentage surprenant nous rappelle une phrase de Mark Twain qui prétendait qu'il existe trois types de mensonges : les mensonges, les sacrés mensonges et... les statistiques. Le bilan est sans appel : en ce début d'année 2010, la majorité des internautes amateurs de nouvelles technologies n'ont encore jamais entendu parler de cette fameuse technologie mystère.Le déploiement technique est tout aussi désastreux : pour l'heure ces équipements ne sont pas en vente et aucun fournisseur d'accès n'a encore mis le pied à l'étrier. Quel procédé se cache sous ce nom barbare ? Pour faire simple, cette technologie consiste en l'intégration d'une puce 3G à l'intérieur d'une passerelle résidentielle (routeur, box, etc.). L'intérêt du procédé est multiple, mais on retiendra surtout trois points forts. Tout d'abord, le Femtocell pourra entrainer une réduction de coût non négligeable pour le client final. En effet, un mobile 3G pourra se connecter directement à une box (et non à l'antenne relais d'un opérateur) pour acheminer les appels sur un réseau VoIP.

En ensuite, on pourra ajouter que le procédé permet d'améliorer la couverture 3 G à l'intérieur des habitations (dans les grands ensembles, la propagation du réseau est souvent perturbée). Troisième point et non des moindres : l'arrivée massive de box compatibles Femtocell pourrait permettre à un fournisseur d'accès de créer rapidement un embryon de réseau mobile en agglomération ! À l'heure où Free a officialisé l'obtention de sa licence de téléphonie mobile, le déploiement du Femtocell pourrait bien connaitre un essor rapide. Alors, ce flop 2009 se transformera-t-il en top 2010 ? Réponse en janvier prochain. Une seule chose est certaine : les associations qui luttent pour la réduction des antennes relais ne verront pas forcément l'arrivée du Femtocell d'un très bon œil.

Snow Leopard : 64 bits et technologies innovantes pour tous ... mais pas tout de suite !

Des promesses ambitieuses ...« Snowie » intègre une multitude de nouveautés, mais malheureusement pour le géant de la « Com », elles sont essentiellement sous le capot. Au menu, on retrouve la généralisation du 64 bits, l'OpenCL permettant d'utiliser la carte graphique pour des calculs autres que le rendu 3D / 2D, le Grand Central Dispatch optimisant la gestion des configurations multicoeurs pour les applications et enfin QuickTime X. Si les promesses semblent alléchantes sur papier, elles apparaissent rapidement ambitieuses voir irréalisables actuellement dans la pratique.

Tout d'abord, le fameux 64 bits pour tous. Démarrant par défaut sur le noyau 32 bits, « Snow Leopard » a besoin à la fois d'un processeur et d'un EFI 64 bits pour passer sur le noyau 64 bits. Il est évidemment possible, comme sous Leopard, de lancer des applications 64 bits avec un noyau 32 bits, mais l'intérêt du noyau 64 bits est justement de gérer de manière plus efficace les grandes quantités de mémoire vive rendues possibles par le 64 bits. En plus d'exclure de nombreux Mac, somme toute récents, de l'exécution de ce noyau, on découvre que des machines possédant les caractéristiques requises ne parviennent pas à le lancer pour autant. Au final, seuls les derniers modèles d'iMac, les MacBook Pro à partir de la génération Penryn, certains Mac Pro et XServe pourront en bénéficier réellement. A condition bien sur de disposer d'applications qui l'exploitent : si la plupart des modules de Mac OS X sont passés au 64 bits, c'est encore le désert au niveau des applications majeures. Même Logic et Final Cut, que l'on pensait revus et corrigés pour Snow Leopard, restent en 32 bits dans leurs dernières versions, alors que Photoshop devra attendre la version CS5 pour bénéficier du 64 bits. La jouissance et l'intérêt immédiat du 64 bits sont pour le moins remis en cause.

Concernant l'OpenCL. Un grand nombre de Mac Intel et notamment d'iMac n'en verront jamais la couleur. Seuls les possesseurs de cartes NVIDIA Geforce 9400M, 9600M GT, 8600M GT, GT 120, GT 130, GTX 285, 8800 GT, 8800 GS, Quadro FX 4800, Quadro FX 5600 ou ATI Radeon 4850 et 4870 pourront en bénéficier. Même topo pour QuickTime X, outre ses quelques fonctions novatrices, on apprend que la prise en charge de l'accélération graphique sera réservée aux heureux propriétaires de Geforce 9400M. Pour Grand Central Dispatch, bien que certaines applications intégrées exploitent déjà cette technologie, pour l'heure aucun autre programme indépendant ne l'utilise.

Failles de sécurité et pertes de données : Outre les quelques bogues que l'on a l'habitude de constater à la sortie d'un nouvel OS, « Snow Leopard » s'est offert deux cafouillages supplémentaires des plus étonnants. D'une part « Snowie » embarquait la version 10.0.23.1 du Flash Player d'Adobe et bien qu'Adobe ait fait le nécessaire pour publier Flash Player 10.0.32.18, le processus de mise à jour vers Snow Leopard écrasait le correctif installé pour le remplacer par la version truffée d'une douzaine de failles de sécurité. D'autre part, de nombreux utilisateurs ont eu la mauvaise surprise de voir l'intégralité de leurs données et préférences supprimées après avoir accédé à un compte invité. Apple aura attendu la version 10.6.2 de Mac OS X pour corriger ce bogue pour le moins handicapant.

Les interfaces tactiles (pour les desktops) : la vérité est ailleurs ?

L'arrivée de Windows 7 pouvait changer la donne : le dernier opus du système d'exploitation de Microsoft gère le multipoint, contrairement à son prédécesseur, et le géant de Redmond s'est même fendu d'un Touch Pack comprenant six applications entièrement dédiées à l'interface tactile. Ces dernières sont plutôt bien conçues et plaisantes, mais n'ont malheureusement rien d'indispensable... En tout cas rien de suffisamment motivant pour s'infliger des douleurs certaines au bras.

Car le problème se situe bien là : intégré dans une table à la façon Surface, un tel PC aurait probablement plus de succès que sous sa forme actuelle, où il hésite entre PC classique et PC multimédia, avec un écran tactile qui ne répond pas à un réel besoin de l'utilisateur. Le tactile sur le PC n'est probablement pas mort, mais la façon dont il est utilisé aujourd'hui nous laisse sceptiques sur la réussite commerciale des produits proposés.

les jeux Free : après trois ans d'attente, la déception

Lorsque qu'Iliad, maison-mère de Free, a présenté sa Freebox HD courant 2006, la télécommande associée à ce boîtier a évidemment suscité la curiosité : ses boutons de couleurs, son joystick et les boutons latéraux laissaient sans l'ombre d'un doute présager une utilisation ludique. C'était il y a 3 ans et demi. L'idée n'était donc pas neuve chez Free lorsqu'en novembre de cette année, le FAI a présenté son dernier bébé. Difficile donc d'excuser la faiblesse de cette nouveauté qui présente un certain nombre de défauts relativement gênants, à commencer par l'impossibilité d'effectuer des sauvegardes.

La télécommande infrarouge n'est pas non plus le meilleur périphérique pour jouer à un jeu vidéo. Tout d'abord, le léger temps de latence inhérent à cette technologie entraine une hécatombe avec les jeux de plate-forme (par exemple). De plus, avec l'avènement de la commande radio sur les consoles « nex gen », on avait presque oublié la gêne provoquée par une personne qui passe entre la commande et la box. Ne parlons même pas des FPS fortement pénalisés par l'absence de stick analogique. Pas de chance : Free a justement misé sur les ancêtres du FPS que sont Duke Nukem 3D et Doom pour son offre de « jeux 3D ».

Free confirme sa volonté d'innover, mais il faut bien avouer que les amateurs de jeux « old school » s'attendaient vraiment à mieux. La donne n'est pas encore définitive, il n'est pas impossible qu'une éventuelle mise à jour providentielle vienne apporter les fonctionnalités majeures qui font défaut aux émulateurs de la partie « jeux » de le Freebox. Il ne nous reste plus qu'à bruler un cierge pour qu'une option de sauvegarde - et pourquoi pas - deux nouvelles émulations de consoles 16 bits s'invitent dans l'interface de notre boite à images bien aimée !

Les pratiques commerciales douteuses

L'illimité limité : le concept de la décennie

Si cette évolution est positive en tout point (si l'on oublie les problèmes de qualité qui vous donnent l'impression de communiquer avec Dark Vador en personne), on ne pourra pas en dire autant des premiers abonnements Web mobiles. En effet, depuis la démocratisation de ces derniers, nos opérateurs bien-aimés ont eu l'idée de génie d'inventer un concept qui donnerait des sueurs froides à nos académiciens : les abonnements 3G illimités... limités en volume de données ! Au final, parfois, l'illimité pourra être facturé 159 212 euros ou 45 900 euros pour les plus chanceux. Rassurez-vous, tout problème à sa solution : les clients fidèles auront peut-être droit à un échéancier sur 10 ans.

À ces pratiques commerciales douteuses s'ajoute une série de bridages difficilement compréhensibles pour les néophytes. Par exemple, on pourra parler des limitations de ports qui font la différence entre un forfait 3G+ et 3G+ « full Internet » chez SFR, des fameux « fair use » (limitation du débit consécutive à un volume de données consommé), et bien d'autres joyeusetés de cet acabit. Alors, 2010 sera-t-elle l'année de la transparence en matière de haut débit mobile ? Les chances sont minimes, mais l'espoir fait vivre.

DLC : et le jeu vidéo vend son âme au diable

Aujourd'hui, la tendance est pourtant inquiétante et pour nombre d'éditeurs, un jeu ne constitue plus une fin en soi. Le développement d'un titre ne se satisfait plus de la seule boîte que nous pouvons retrouver chez notre revendeur préféré. Il s'accompagne forcément de contenus additionnels destinés - sur le papier - à rendre l'expérience ressentie par le joueur encore plus enivrante et à en prolonger la durée de vie.

Sur le papier, le DLC a effectivement tout pour séduire et on aurait bien tort de cracher sur ce supplément offert par nos développeurs préférés. Seulement voilà, le supplément en question n'est pas offert, il est vendu et parfois même très cher quand on pense aux coûts engendrés par la création de quelques costumes pour Street Fighter IV, de cartes pour Call Of Duty ou, pire, d'un véritable épilogue pour Prince Of Persia.

Eh oui, chez Ubisoft, le DLC est parfois le moyen de conclure une aventure alors que pour BioWare la publicité pour les DLC est directement intégrées aux options de dialogues de Dragon Age. Le plus grave, c'est que les DLC rapportent : ceux de Call Of Duty ont engrangé près de 50 millions de dollars aux Etats-Unis. Les DLC ont pris une telle ampleur que leur annonce se fait avant même la sortie du jeu et qu'ils sont pensés dès les premières phases de développement d'un jeu... au risque que des idées soient retirées du projet inital pour être vendues plus tard. Heureusement, il nous reste encore la possibilité de ne plus acheter ces DLC abusifs : la balle est dans notre camp.

Nero Essentials FREE : Pas vraiment gratuit, pas vraiment utile !

Se limitant aux fonctions de gravures, les logiciels tels que CDBurnerXP, BurnAware Free et InfraRecorder parviennent à séduire les débutants comme les utilisateurs avancés, offrent une prise en main rapide et outre le fait d'être excellents, ont l'atout majeur de faire cela gratuitement. Dans un sursaut de lucidité, Nero AG a eu la fausse bonne idée de publier au cours de l'été 2009 une version allégée du mastodonte Nero 9. Comme son nom l'indique, Nero Essentials FREE aurait eu pour objectif d'offrir gratuitement quelques fonctions indispensables de gravure. C'est justement sur les termes de gratuité et de fonctionnalités essentielles que le bât blesse. Au menu des options proposées, on ne peut faire plus pingre : gravure et copie de disques de donnée uniquement. Il est impossible de créer une image disque, encore moins de graver un fichier ISO. Exit les gravures multi-session, il faut se préparer à consommer du CD/DVD à la pelle puisque les disques de données sont automatiquement finalisés. Pour ces deux fonctions, l'installateur fait 55 Mo, l'installation est laborieuse comme le premier démarrage.

Mieux encore, on retrouve l'interface déroutante de Nero 9 avec un seul but précis, proposer aux utilisateurs d'acheter les modules désactivés. Aussi, en plus des incessants rappels d'achat de fonctions supplémentaire à chaque démarrage, Nero AG ne pouvait s'empêcher d'y glisser une petite AskToolbar en guise de cerise sur le gâteau. Au final, on ne peut rester qu'étonné devant l'attitude étrange de la firme allemande qui n'a décidément pas le sens de la mesure entre le trop et le pas assez. Elle devrait s'informer de toute urgence sur la signification du concept de gratuité. Un flop monumental, un coup de séduction publicitaire raté qui ne fait que desservir l'image d'une marque déjà trop écornée !

Les fausses notes de la musique numérique : This is it ?

Dans la chanson Paint A Vulgar Picture, aux paroles exquises (pour les anglophones), le groupe The Smiths décrivait de manière cynique le comportement des maisons de disques à la mort d'une pop star : « on réédite, on reconditionne, et on ajoute un inédit, une photo souvenir et un badge ». Ecrite en 1987, cette chanson s'est révélée tristement d'actualité à la mort de Michael Jackson, où on a atteint un degré de n'importe quoi marketing affligeant, une véritable incitation au piratage. Evidemment, avant de disparaître, le chanteur avait dans ses cartons des inédits, et Sony Music allait forcément les exploiter avec une compilation souvenir. Néanmoins , le cynisme a atteint ici son paroxysme à la sortie de ladite compilation, Sony refusant de commercialiser au détail la chanson inédite, This Is It. Selon les plates-formes, il est indispensable d'acheter toute la compilation, ou un EP numérique incluant d'autres fonds de tiroir. C'était bien la peine de dématérialiser la musique pour se retrouver enchainé de la sorte...

Conclusion

Comme nous avons pu le constater à nos dépens, cette année 2009 ne déroge pas à la règle. Cette fois encore, il ne fut pas difficile de mettre la main sur une brochette d'une quinzaine de produits, services ou offres commerciales dont on se serait volontiers passés (mention spéciale aux nombreux trophées décrochés par notre agrume national). Certains prétendants au titre nous ont peut-être échappés (leurs géniteurs ne nous en voudront probablement pas), mais si tel est le cas, n'hésitez pas à nous faire part de vos retours en utilisant le fil de discussion qui est attaché à cet article.Cette fois, nous pouvons enfin refermer la parenthèse des flops 2009 pour « reprendre une activité normale » comme le dit ce cher PPD. L'année qui se profile sera-t-elle tout aussi riche en surprises touchantes, risibles ou agaçantes ? Restons sur nos gardes, les premiers feux d'artifice de la Saint Sylvestre pourraient bien laisser entrevoir une série de pétards mouillés. Sur les nombreux événements et/ou commercialisations que peut compter une année, nul doute que certaines tentatives se prendront les pieds dans le paillasson. Ne souhaitons pas de mal à nos constructeurs, fournisseurs d'accès ou opérateurs de téléphonie pour autant, en cas de problèmes, il ne faut pas oublier que le client final est souvent le premier perdant.

En attendant la prochaine série, il ne nous reste qu'à vous souhaiter une excellente et heureuse année 2010 !