Meilleures ou moins bonnes, il serait temps que les cartes graphiques Intel se décident à sortir pour de bon, avant qu'il ne soit trop tard.

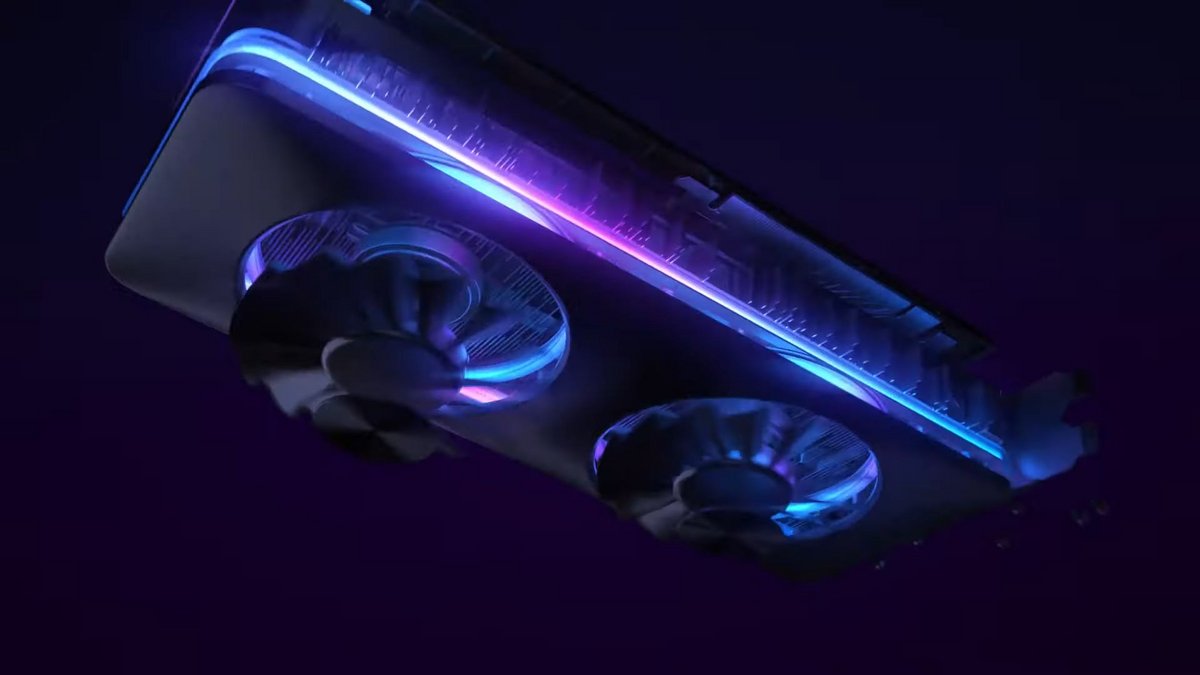

La communication parfois déroutante d'Intel autour de sa gamme de GPU Arc a au moins le mérite de traiter à peu près tous les sujets, et ce, de manière assez didactique, comme cet épisode consacré au ray tracing.

Le ray tracing par l'exemple

Comme à son habitude, Intel documente donc bien les choses. Ainsi, sur son site officiel, son message débute par une explication de ce qu'est le ray tracing et en quoi il consiste.

La technique est logiquement opposée à la rastérisation, mais Intel précise aussi que l'on peut adopter une approche dite « hybride » qui mêle les deux méthodes. Le fabricant détaille ensuite comment ses solutions graphiques font pour gérer au mieux le ray tracing.

Là, les choses sont un peu plus délicates pour Intel, qui tente d'expliquer en quoi les GPU Arc disposent d'un matériel performant pour gérer le ray tracing. Pourquoi « un peu plus délicates » ? Parce qu'Intel compare alors ses performances à celles de NVIDIA.

L'Arc A770 environ 14 % supérieur à la RTX 3060

Intel décide donc de comparer les résultats obtenus en ray tracing par un GPU Arc A770 à ceux que l'on peut avoir avec une GeForce RTX 3060.

Au total, les performances sur 17 jeux sont présentées, depuis Cyberpunk 2077 jusqu'à Metro Exodus, en passant par F1 2022 ou Ghostwire Tokyo. Sans surprise (après tout, il s'agit d'une communication d'Intel), c'est la solution Arc A770 qui se montre en moyenne la plus performante.

D'aucuns prendront cependant un malin plaisir à lire entre les lignes. En effet, alors qu'il avait plutôt tendance à comparer la GeForce RTX 3060 à sa solution milieu de gamme, l'Arc A750, pour le ray tracing, Intel doit dégainer l'Arc 770 pour se mesurer la carte NVIDIA.

Comme toujours, il conviendra d'attendre des tests indépendants, s'ils arrivent un jour, avant de conclure quoi que ce soit, mais Intel semble bien un net cran derrière NVIDIA pour la prise en charge du ray tracing, ce qui n'a d'ailleurs rien de surprenant pour sa première tentative en la matière.

Source : Intel