On arrête plus l’IA. Le groupe chinois Alibaba a présenté récemment son nouveau modèle d’intelligence artificielle surnommé « EMO ». Ce dernier permet d’animer une photo avec un réalisme saisissant.

Après les deepfakes, voilà une nouvelle prouesse de l’IA qui pourrait causer bien des soucis. Dans un article de recherche publié le 27 février 2024, le groupe chinois Alibaba (qui tient notamment le site de e-commerce AliExpress) a détaillé le fonctionnement de son modèle de génération de vidéo EMO qui est capable d’ajouter des mouvements et une voix à une simple photo.

Faire dire (et chanter) n’importe quoi à n’importe qui

En utilisant un algorithme qui retranscrit directement l’audio reçu d’une part en mouvement faciale de l’autre part et « sans avoir recours à des modèles 3D intermédiaires ou à des points de repère faciaux » EMO se permet donc de faire parler ou chanter des photos avec des mouvements de tête et de lèvres extraordinairement proches de la réalité.

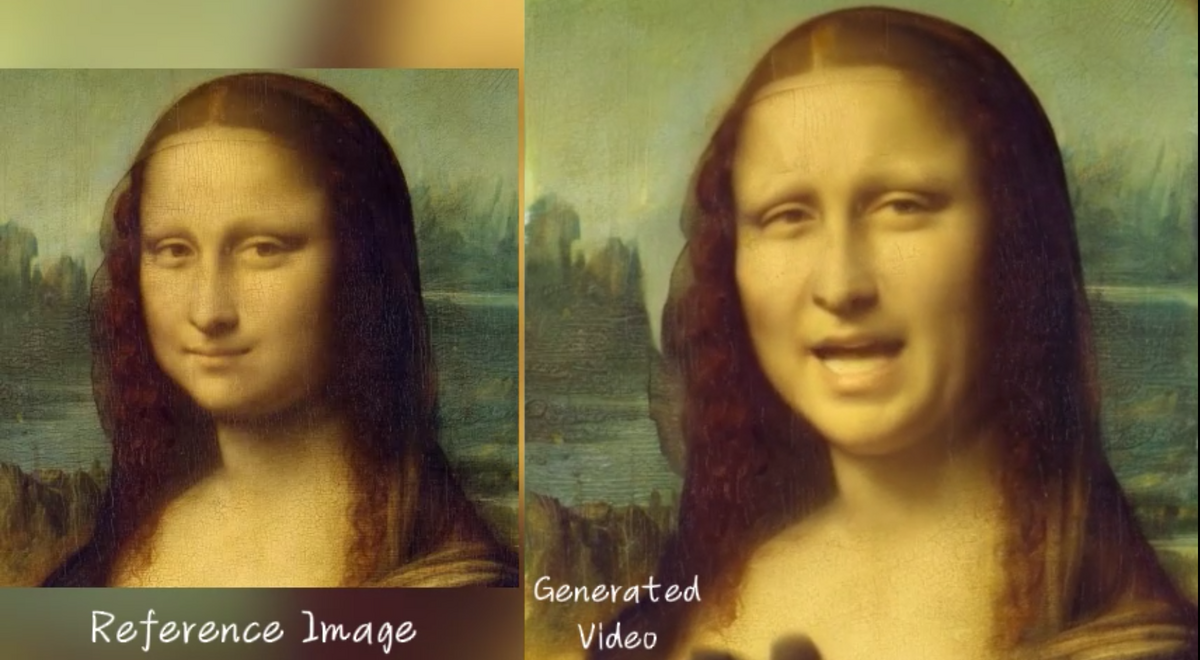

Ainsi, en faisant passer une simple photo d’Audrey Hepburn dans la moulinette d'EMO, il devient possible de faire chanter du Ed Sheeran à l’actrice aujourd’hui décédée. Vous voulez faire chanter du Eminem à une photo de Leonardo DiCaprio à 20 ans ? Pas de problème non plus. Plus impressionnant encore, le logiciel se débrouille très bien avec des personnages dessinés ou peint, puisqu’Alibaba se permet même de faire déclarer à La Joconde un monologue de Shakespeare, avec les expressions faciales qui vont avec.

Une arme de désinformation massive ?

Pour entrainer EMO, les chercheurs ont « constitué une base de données audio-vidéo riche de 250 heures de contenus et de 150 millions d’images », précise l’article. « Les contenus audio sont riches en information concernant les expressions faciales, permettant théoriquement de générer un large panel de mouvements faciaux », poursuivent les ingénieurs dernières EMO. La tâche n’est pas pour autant facile, les modèles de diffusion (similaire à ce que fait Stable Diffusion) pouvant parfois se perdre dans la retranscription des mouvements faciaux.

Bien évidemment, en y regardant de près il est possible de voir quelques artefacts et les vidéos en elle-même dégagent quelque chose qui se rapproche parfois un peu de la vallée dérangeante, mais pour une première version du système les résultats sont tout de même époustouflants… et un peu inquiétants. La possibilité de faire dire n’importe quoi à n’importe qui en n’ayant besoin de rien de plus qu’une image en relativement bonne qualité pourrait être utilisée comme une arme de désinformation massive, surtout si son utilisation est encore plus aisée que ce qui se fait aujourd’hui avec les deepfake.

25 mars 2025 à 15h08

Source : Arxviv - Alibaba Group