Les géants de l'intelligence artificielle se livrent une bataille acharnée sur la plateforme Chatbot Arena. Entre Google et OpenAI, c'est désormais à celui qui revendiquera la première place, quitte à sortir des mises à jour à un rythme effréné qui frise l'absurde.

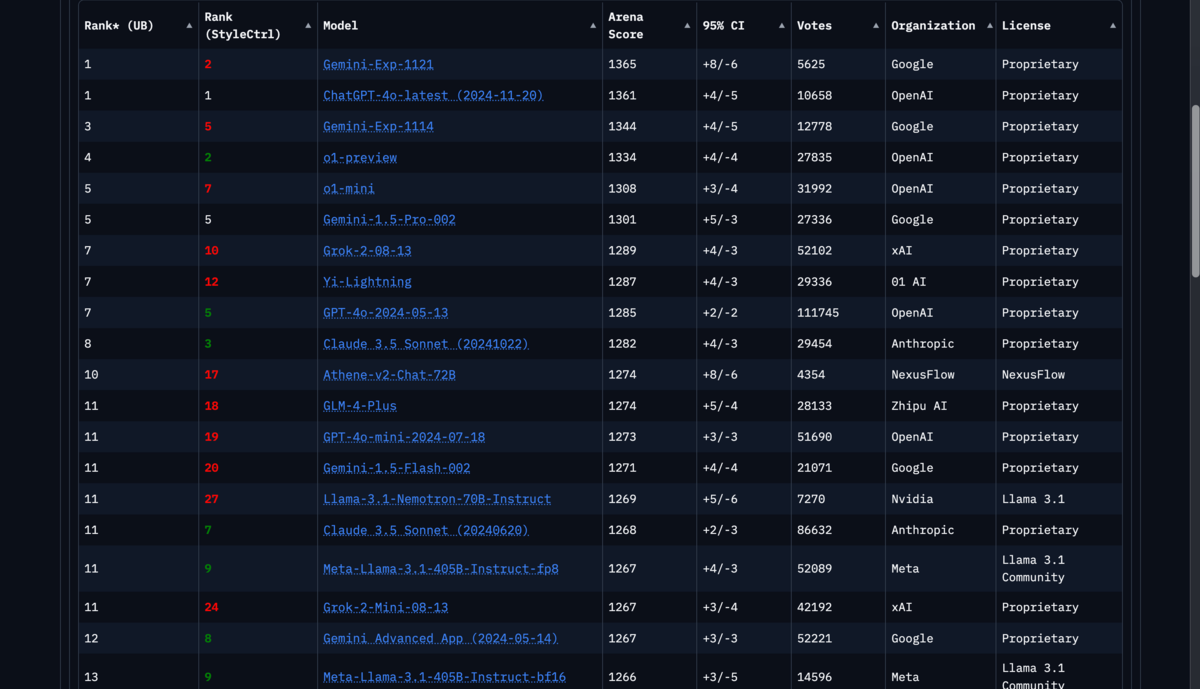

La guerre des benchmarks fait rage dans le monde de l'IA générative. D'un côté, OpenAI qui redouble d'efforts avec une mise à jour de GPT-4o pour reconquérir son trône. De l'autre, Google avec son modèle Gemini-Exp-1121 qui a créé la surprise en atteignant un score de 1 361 points, à peine 5 jours après le modèle Gemini-Exp-1114 qui avait déjà déclassé GPT-4o.

Une course effrénée aux performances

En début de semaine, Google semblait avoir pris l'avantage avec son modèle expérimental Gemini. Les résultats parlaient d'eux-mêmes : une domination dans six domaines différents, notamment en mathématiques et en écriture créative. Face à cette offensive, OpenAI n'est pas resté les bras croisés. L'entreprise de Sam Altman a contre-attaqué avec une mise à jour majeure de GPT-4o, améliorant notamment ses capacités de lecture et d'écriture de fichiers.

… mais c'était sans compter sur l'obstination de Google qui, à défaut de proposer de nouveaux modèles, entend bien rester au sommet des tableaux avec une nouvelle version expérimentale de Gemini sobrement nommée gemini-exp-1121. Cette version remonte dans le classement pour dépasser d'un seul point le nouveau GPT-4o… déployé la veille.

Cette surenchère perpétuelle pose question. Les deux géants investissent des sommes colossales dans le développement de leurs modèles, avec des coûts d'entraînement qui peuvent atteindre les 100 millions de dollars. Au-delà des communications qui commencent à devenir redondantes, on peut au moins se réjouir d'une chose : la concurrence force les différents acteurs de l'IA à améliorer leurs modèles, et le faire rapidement. Nous sommes aujourd'hui loin de l'époque où ChatGPT avait un quasi-monopole sur le marché des chatbots.

Les limites d'une guerre des chiffres

Les progrès ne sont plus aussi spectaculaires qu'auparavant. Les entreprises du secteur se heurtent à un mur : la difficulté croissante de trouver des données de qualité pour entraîner leurs modèles. Les classements actuels ne reflètent pas toujours la réalité des performances. Lorsque l'on contrôle certains facteurs comme le formatage des réponses, les écarts entre modèles se resserrent considérablement.

Cette obsession des benchmarks masque des enjeux plus profonds. Les modèles excellent peut-être dans les tests standardisés, mais peinent encore à gérer des situations délicates du monde réel, notamment dans les domaines médicaux ou éthiques. La véritable innovation ne réside peut-être plus dans la taille des modèles ou leurs scores aux tests. L'avenir pourrait se jouer dans leur capacité à accomplir des tâches pratiques, comme la réservation de vols ou l'envoi de mails intelligents.

04 février 2025 à 14h11

Sources : Google et OpenAI sur X.com, LMARENA