Google DeepMind vient de présenter deux modèles d'intelligence artificielle (IA) spécialement pensés pour alimenter des robots. Conversation, mouvements, compréhension… Le résultat est très prometteur.

La convergence entre la robotique et l'IA continue de s'accroître. Depuis plusieurs mois, les entreprises développant des robots humanoïdes réalisent d'importants progrès en intégrant l'intelligence artificielle à leurs appareils, donnant un second souffle à un secteur qui semblait piétiner. Basés sur Gemini 2.0, le grand modèle de langage made in Google, ces deux dispositifs vont justement dans ce sens.

Généralité, interactivité et dextérité

Le premier, Gemini Robotics, est un modèle vision-langage-action (VLA) avancé, c'est-à-dire qu'il ajoute les actions physiques comme nouvelle modalité de sortie pour contrôler directement différents types de robots, qu'ils soient humanoïdes ou non (bras robotisés, etc.). Il permet des avancées significatives dans trois domaines qui, selon Google DeepMind, sont essentiels au développement de robots utiles : la généralité, l'interactivité et la dextérité.

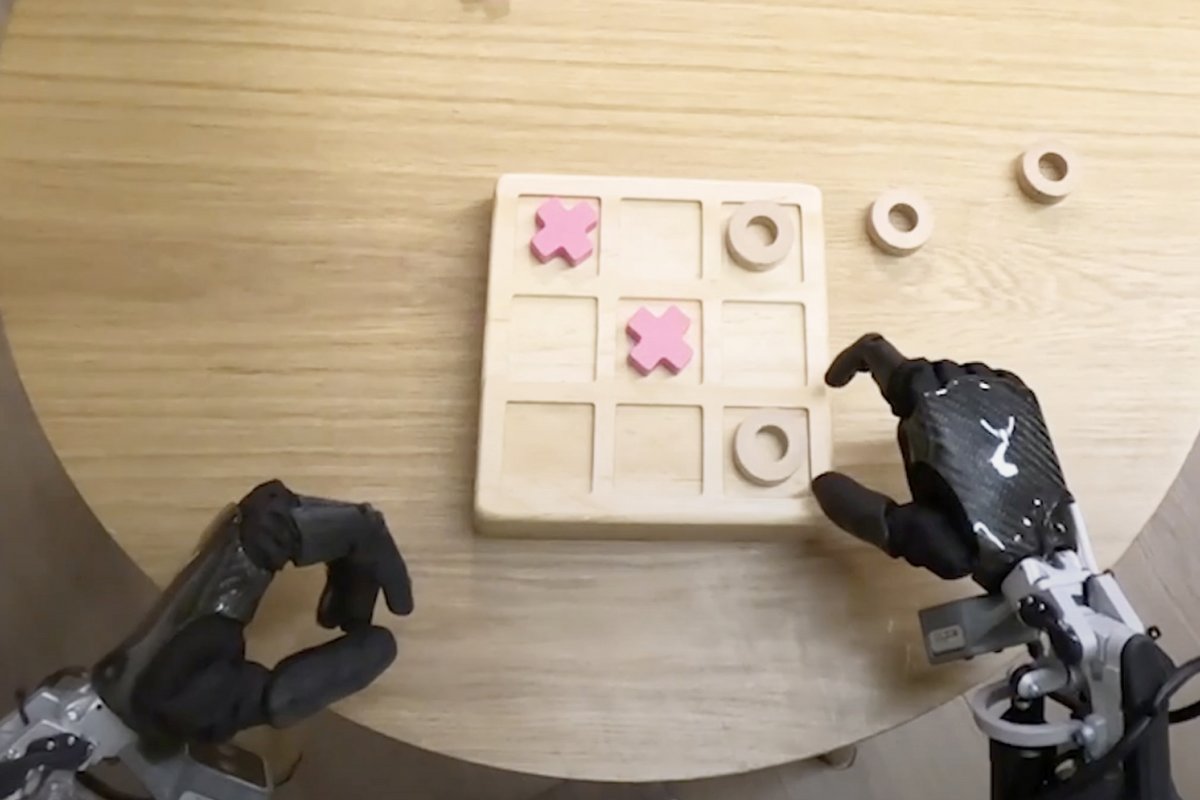

Il leur octroie la capacité à s'adapter à différentes situations et à résoudre des tâches jamais vues auparavant, à comprendre et répondre aux commandes en langage naturel, et à accomplir des tâches complexes nécessitant une manipulation précise, comme plier des origamis. Selon Google, Gemini Robotics garantit « des robots plus performants, plus réactifs et plus robustes face aux changements de leur environnement ».

Un pont entre le robot et le monde physique

Gemini Robotics-ER (Embodied Reasoning), lui, est décrit comme un modèle langage-vision. Il a vocation à révolutionner la manière dont les fabricants conçoivent leurs robots. Le dispositif agit comme un interprète sophistiqué entre l'intelligence artificielle et le monde physique, dotant les machines d'une compréhension spatiale proche de celle des humains. Par exemple, ils peuvent distinguer la meilleure façon de saisir une tasse de café ou d'éviter un obstacle imprévu.

Là où les développeurs devaient auparavant programmer manuellement chaque mouvement, ce nouveau modèle génère automatiquement les instructions nécessaires après avoir simplement observé quelques démonstrations humaines. Cette approche « intuitive » permet aux robots d'accomplir des tâches jamais explicitement programmées. Cela représente un gain de temps considérable dans le développement de machines toujours plus adaptables à notre monde quotidien.

Des modèles déjà en test

L'entreprise a noué un partenariat stratégique avec Apptronik, spécialiste des robots humanoïdes, qui va intégrer sa technologie. La firme ouvre également sa technologie à un cercle restreint de « testeurs de confiance », parmi lesquels figurent Boston Dynamics, connu pour ses robots Spot et Atlas, ainsi que les fabricants Agile Robots, Agility Robots et Enchanted Tools.

Le but est avant tout d'explorer les possibilités offertes par la technologie avant de la déployer à grande échelle. Cette phase pourrait permettre aux ingénieurs d'affiner les applications pratiques tout en résolvant les défis éthiques et sécuritaires inhérents aux robots humanoïdes. De quoi drastiquement accélérer l'évolution des humanoïdes ?

30 décembre 2024 à 11h18

Sources : The Verge, Google DeepMind