Face à l'émergence des puces ASIC optimisées pour l'inférence en intelligence artificielle, le leader incontesté du marché des GPU voit son monopole potentiellement menacé. NVIDIA accélère sa diversification vers ces circuits intégrés spécialisés pour préserver sa position dominante dans un écosystème technologique en pleine mutation.

L'intelligence artificielle a propulsé NVIDIA au sommet de la valorisation technologique mondiale grâce à ses GPU ultraperformants qui alimentent les centres de données. Cependant, une évolution majeure se dessine avec l'émergence des ASIC (Application-Specific Integrated Circuits), des puces conçues pour des tâches spécifiques d'IA. Cette transition pourrait redéfinir l'équilibre des forces dans l'industrie des semi-conducteurs, forçant le géant américain à adapter sa stratégie.

Une réorientation stratégique face aux nouveaux défis

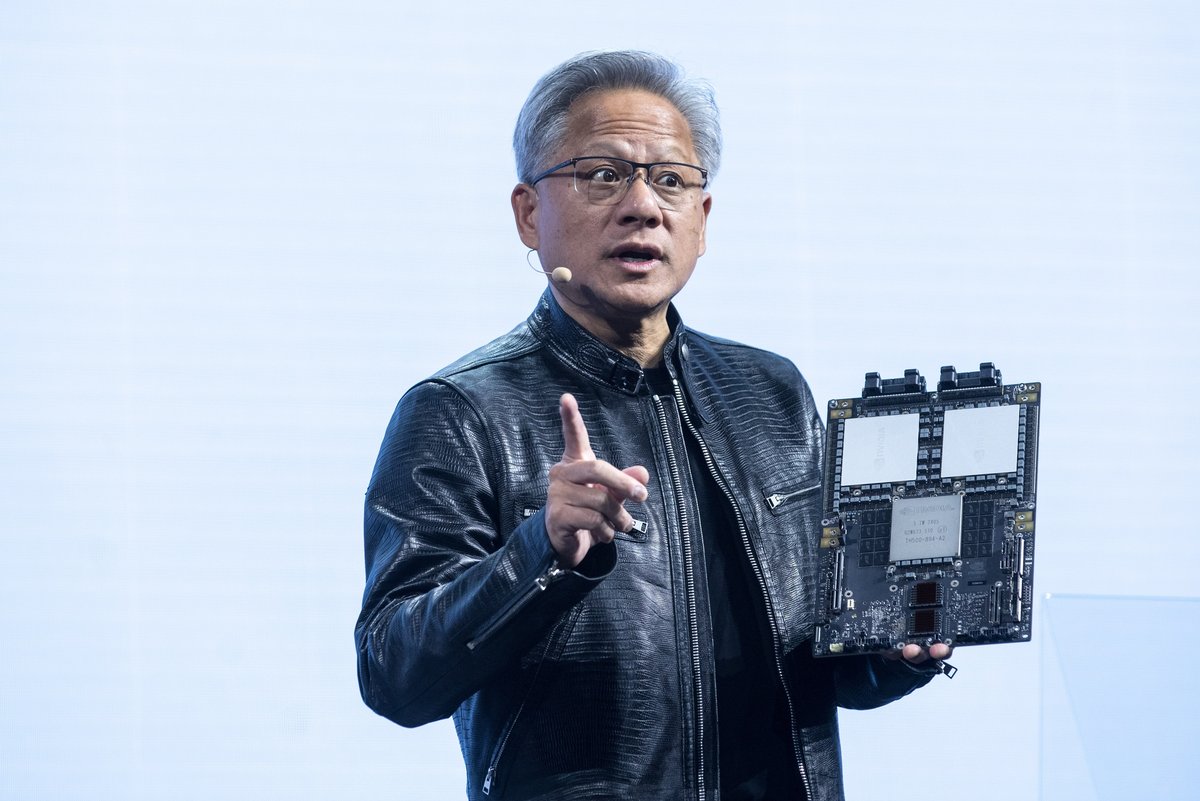

NVIDIA intensifie son recrutement d'ingénieurs spécialisés en ASIC, particulièrement à Taiwan, signe d'une accélération de ses efforts dans ce domaine. Comme nous l'évoquions dans notre précédent article sur l'évolution de NVIDIA des cartes graphiques vers les circuits intégrés spécialisés, l'entreprise anticipe clairement l'étape suivante de l'évolution technologique. Le PDG Jensen Huang reconnaît lui-même que l'industrie de l'IA traverse une phase de transition, passant de l'entraînement des modèles à leur déploiement massif via l'inférence.

Le marché de l'inférence IA pourrait dépasser 90 milliards de dollars d'ici la fin de la décennie. Les ASIC, contrairement aux GPU généralistes, se concentrent sur des fonctions précises, offrant une efficacité énergétique supérieure et des performances optimisées pour des tâches spécifiques. Pour les entreprises déployant des services d'IA à grande échelle, cet avantage se traduit par des économies substantielles en consommation électrique.

La confrontation entre GPU et ASIC reflète une dichotomie fondamentale entre polyvalence et spécialisation. Les GPU de NVIDIA excellent dans les tâches diversifiées et l'entraînement des modèles d'IA, tandis que les ASIC peuvent offrir jusqu'à 50% d'efficacité supplémentaire sur des opérations ciblées, avec une consommation énergétique réduite d'environ 30%. Cette différence devient critique à l'échelle des centres de données, où chaque watt économisé compte.

GPU vs ASIC : deux approches complémentaires pour l'IA

Des analyses de Morgan Stanley révèlent que si les GPU de NVIDIA conservent un avantage en performances brutes, les ASIC présentent un coût initial inférieur. Sous un même budget, les puces Trainium 2 d'AWS peuvent accomplir des tâches d'inférence plus rapidement que les GPU H100 de NVIDIA, avec un rapport coût-performance amélioré de 30 à 40%.

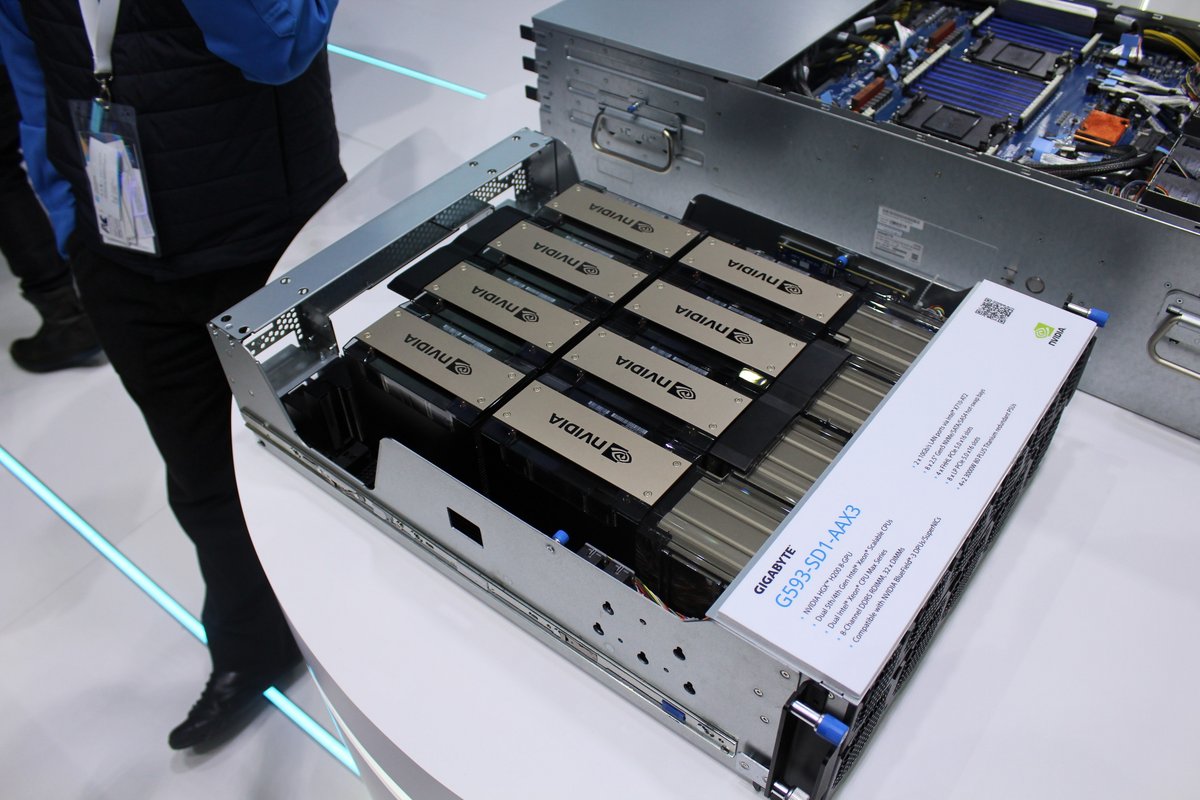

NVIDIA n'est pas seul sur ce créneau : Google, Broadcom et Marvell développent activement leurs propres solutions ASIC. Cette concurrence s'intensifie, comme en témoigne la récente présentation par NVIDIA de ses stations de travail DGX Desktop, une réponse à la miniaturisation des modèles d'IA.

Malgré ces défis, NVIDIA dispose donc d'avantages considérables pour préserver sa position dominante. Son écosystème logiciel CUDA, fruit d'une décennie de développement, constitue une barrière à l'entrée significative pour les concurrents. L'entreprise a également annoncé sa nouvelle puce Vera Rubin et le processeur Blackwell Ultra GPU, démontrant sa capacité à faire évoluer son offre matérielle.

Source : WCCFTECH