Mise à jour du 07/11/2018 : ajout des tests des GeForce RTX 2070 de chez MSI (Armor et Gamin-Z).

Attention, les bloqueurs de publicité peuvent empêcher l'affichage des graphiques hébergés sur Infogram.

Mise à jour du 11/10/2018 : Nous avons mis à jour le test avec les performances des différentes cartes en overclocking, les benchmarks d'un modèle partenaire (la MSI 2080 Ti Duke 11G OC), ainsi que les performances en HDR. D'ici peu nous ferons une mise à jour avec les performances en ray tracing sur les premiers jeux compatibles.

Plus de deux ans. C'est le temps qu'il aura fallu patienter pour que NVIDIA se décide à annoncer ses nouvelles cartes graphiques grand public, les Geforce RTX. Mais en coulisses, cela fait près de 10 ans que la firme au caméléon travaille sur le Saint Graal de l'informatique graphique : le rendu en temps réel avec le ray tracing. Alors, ça donne quoi ?

Introduction

C'est en août, lors du SIGGRAPH, que NVIDIA a levé le voile, après des mois de rumeurs, sur sa nouvelle architecture « Turing ». D'abord présentée avec les Quadro RTX 8000, 6000 et 5000 réservées aux professionnels, c'est pendant la Gaming Celebration à la Gamescom que nous avons pu découvrir les Geforce RTX, déclinaisons Turing pour le grand public.Si NVIDIA s'est décidé à renommer ses cartes GTX en RTX, c'est parce que la marque considère qu'il s'agit de la plus grande évolution technologique depuis l'avènement des cœurs CUDA en 2006. Nous allons voir ce qu'il en est tout au long ce test.

Une nouvelle architecture taillée pour le Ray tracing et boostée à l'IA

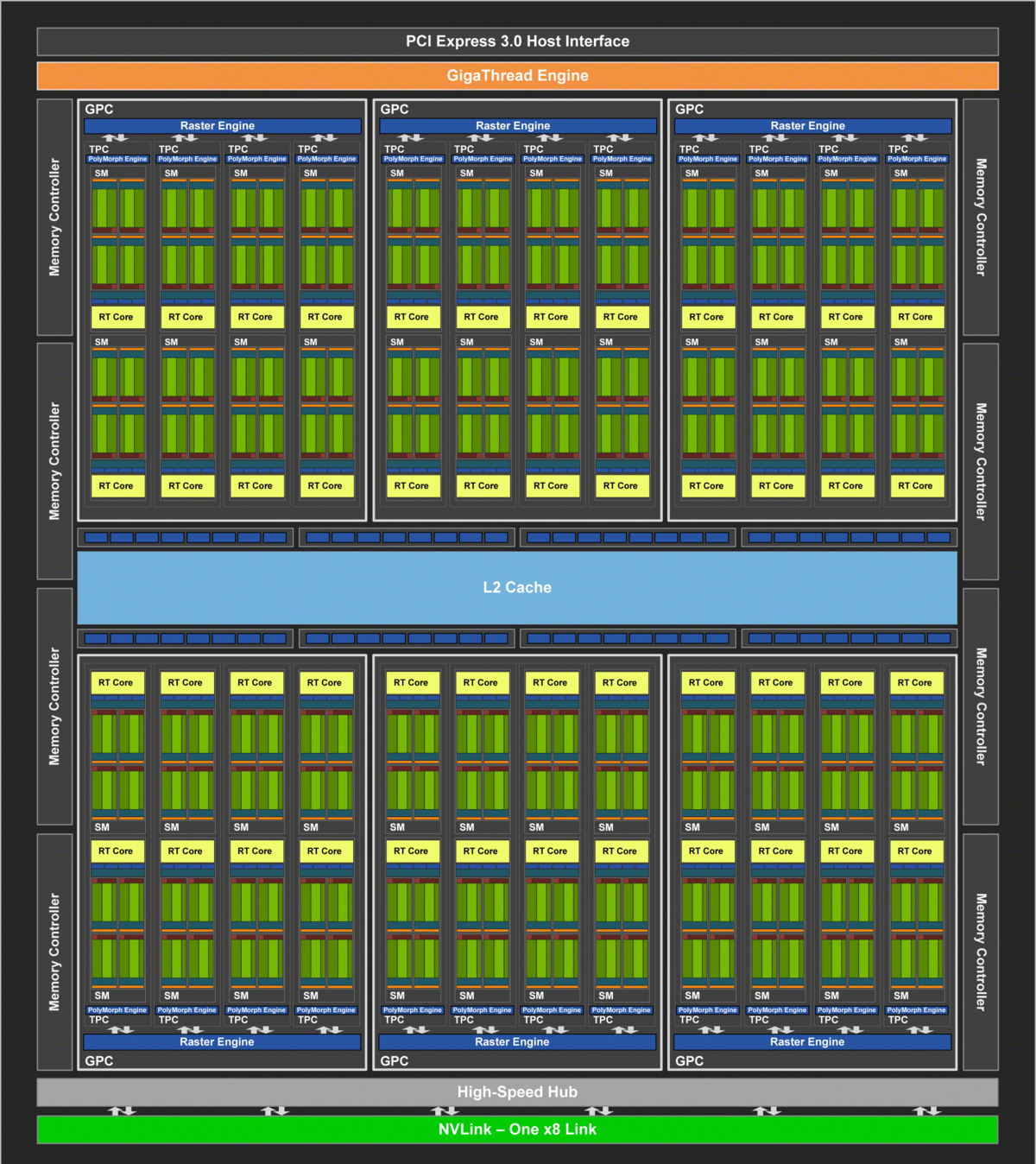

NVIDIA a annoncé pour l'instant trois modèles, les plus hauts dans la gamme. Les TU102, TU104 et TU106. Leurs noms commerciaux :- GeForce RTX 2080 : TU104

- GeForce RTX 2080 Ti : TU102

- GeForce RTX 2070 : TU106

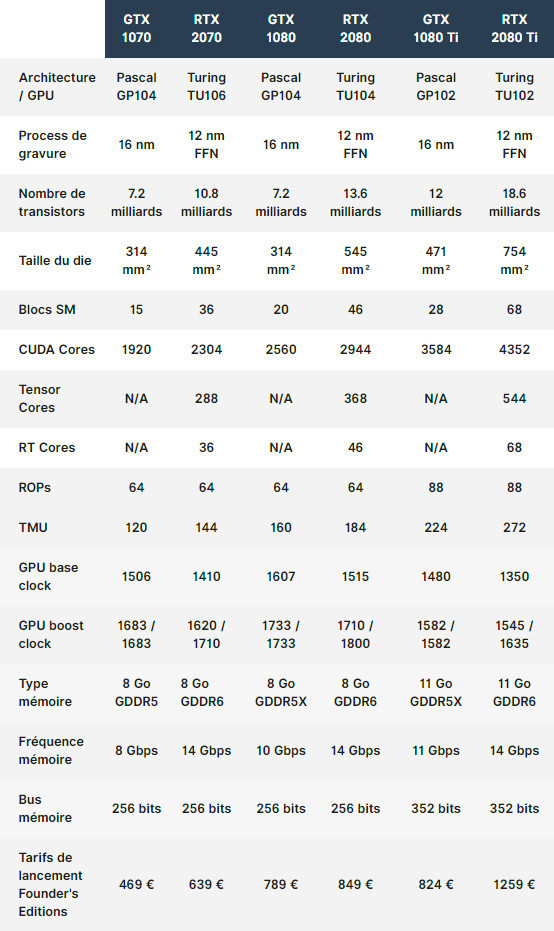

On se rappelle qu'entre ces deux générations, le nombre de cœurs CUDA avait augmenté de 25-30%, selon les modèles, et les fréquences de fonctionnement des GPU s'étaient envolées avec plus de 40% d'amélioration.

Cette année, si l'on se base uniquement sur les cœurs CUDA et les fréquences des GPU, l'écart est beaucoup plus modéré :

- RTX 2080 : +15% de cœurs CUDA / +4% fréquence GPU VS GTX 1080

- RTX 2080 Ti : +21% de cœurs CUDA / +7% fréquence GPU VS GTX 1080 Ti

D'autant plus que l'augmentation des prix annoncée par rapport à la génération précédente (au lancement) est elle-même beaucoup moins modérée. Le passage de la finesse de gravure de 16 à 12 nm ne semble pas suffisant pour un bond important sur les fréquences des GPU.

Mais si on y regarde bien, la taille du die et le nombre de transistors se sont envolés par rapport à la génération précédente, avec une augmentation de près de 88% pour la RTX 2080, et de 55% pour la RTX 2080 Ti. Mais alors à quoi servent ces transistors supplémentaires ?

Et c'est bien là qu'il est important de comprendre que nous sommes en présence d'une toute nouvelle architecture, qui s'appuie notamment sur deux nouveautés essentielles dans le pipeline de rendu : les RT Cores pour le ray tracing, et les Tensor Cores pour l'IA et le deep learning.

NVIDIA semble avoir décidé qu'il était temps de faire bouger l'industrie !

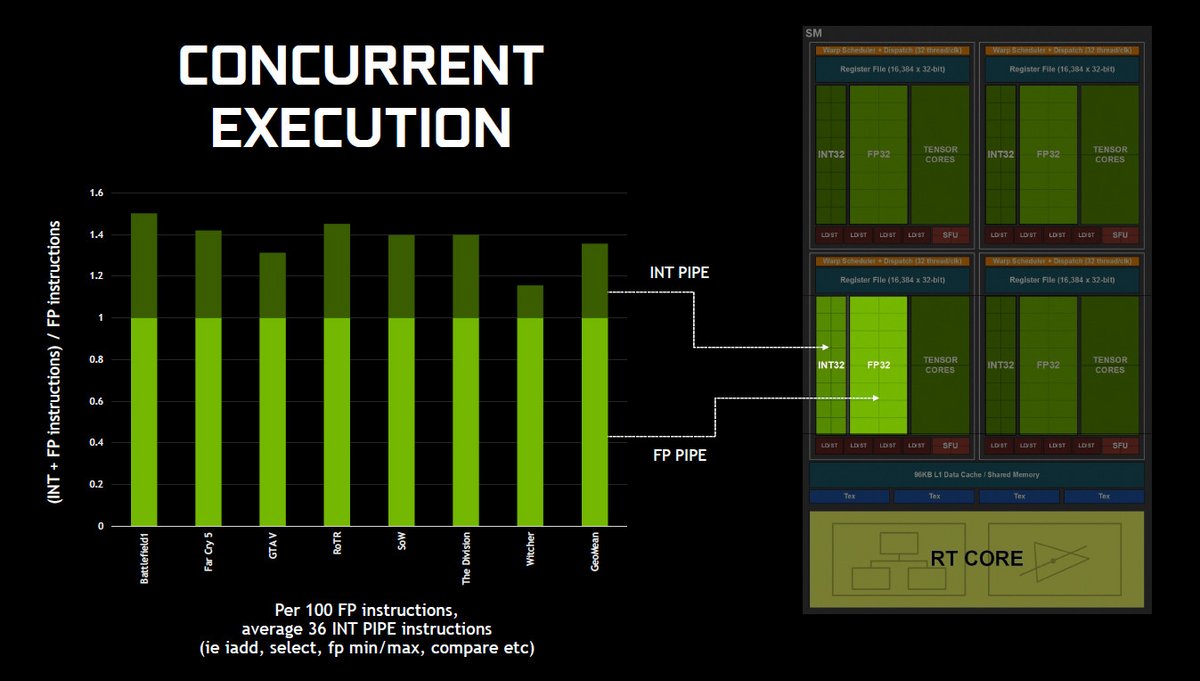

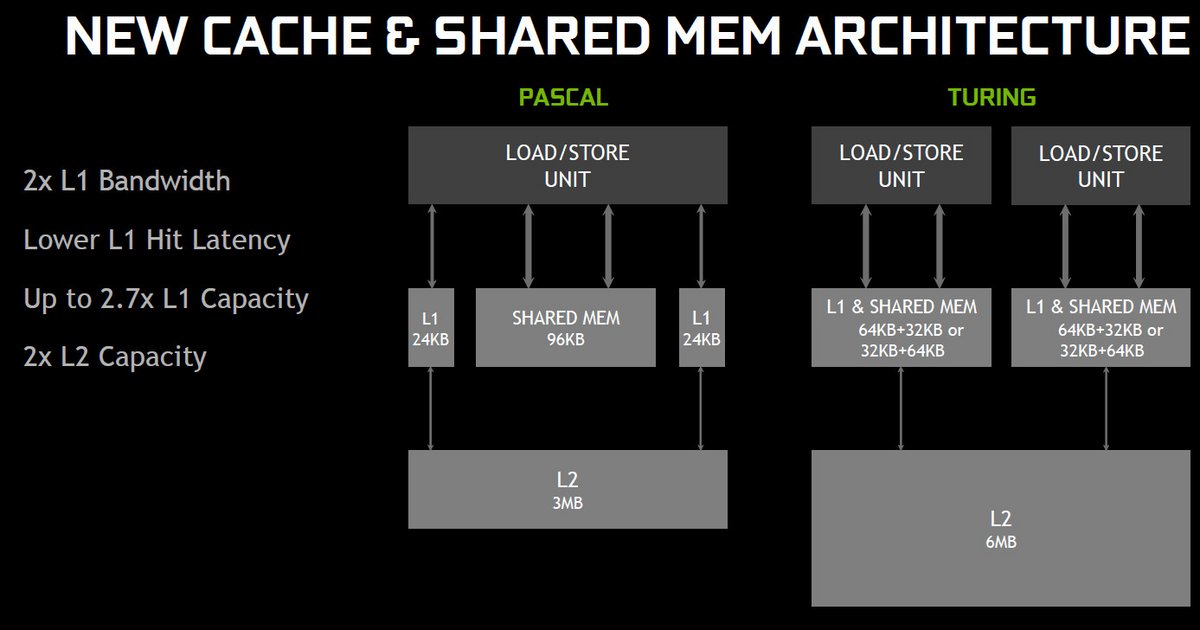

Le SM selon Turing

Avant d'aborder en détails les RT Cores et Tensor Cores, il est nécessaire de prendre un peu de temps pour analyser les nouveautés concernant le nouveau streaming multiprocessor (SM). Annoncé, selon NVIDIA, plus performant à hauteur de 50% sur le traitement des shaders que sur la génération Pascal, le nouveau SM voit arriver deux changements majeurs dans son architecture.Premièrement, Turing emprunte à Volta son support de l'exécution simultanée des instructions FP32 et INT32. Sur les générations précédentes, ces types d'instructions ne pouvaient pas s'exécuter en même temps. Sur Turing on trouve des cœurs dédiés FP32 et des cœurs dédiés INT32 pour chaque bloc SM, alors que sur la génération Pascal on avait affaire à des cœurs CUDA non spécialisés.

Le fait d'avoir des cœurs dédiés à chaque type d'instruction et gérés de façon complètement indépendante permet donc d'effectuer les calculs simultanément.

A cela s'ajoute une gestion de la mémoire revue, afin d'unifier la mémoire partagée et le cache L1 en une seule et unique unité.

Troisième changement majeur, le passage à la mémoire GDDR6 sur un bus 352-bit qui permet d'améliorer significativement la vitesse des échanges entre les cœurs et la mémoire. On parle d'une amélioration de plus de 27% de bande passante par rapport à la génération Pascal.

L'objectif de NVIDIA est d'offrir un maximum de souplesse aux développeurs, qui pourront exploiter Turing selon leurs besoins.

Du ray tracing en temps réel via un rendu hybride

L'une des grandes nouveautés mise en avant par NVIDIA sur Turing est bel et bien le ray tracing en temps réel. Si vous voulez en savoir plus sur le ray tracing, nous vous invitons à lire notre article précédent sur le sujet.Sachez juste que le ray tracing permet de donner aux jeux un rendu photo-réaliste avec des ombres, lumières et reflets générés de manière naturelle et réaliste.

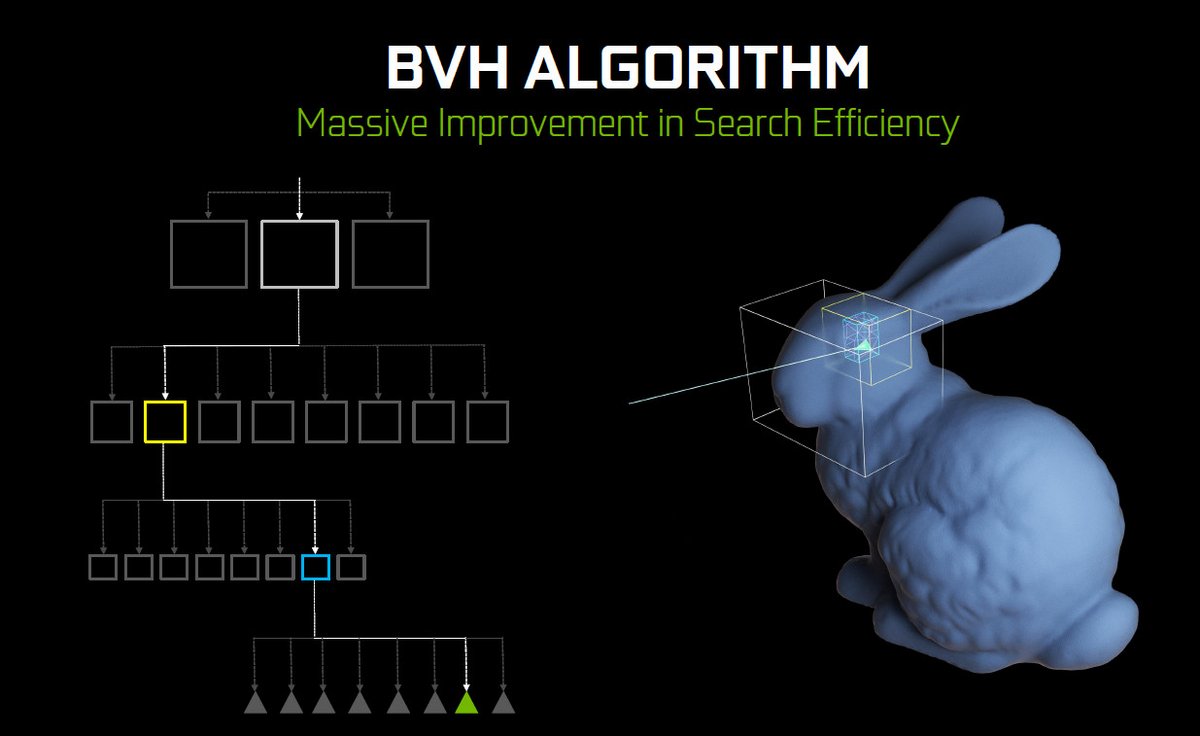

En résumé, cette méthode de rendu - extrêmement gourmande en puissance de calcul - sera accélérée sur Turing grâce aux RT Cores. Ceux-ci seront dédiés aux fonctions BVH (Bounding Volume Hierarchy) traversal et aux tests d'intersection entre les rayons (ray) et les triangles. Ces deux fonctions sont essentielles aux algorithmes de ray tracing.

Aujourd'hui, le seul moyen d'effectuer du ray tracing en temps réel est en effet de découper une scène géométrique en différentes « boites » afin de faciliter les calculs permettant de définir l'endroit où un rayon généré viendra frapper l'un des triangles de la forme géométrique (le lapin dans l'exemple ci-dessus). Sans ces « boites », l'algorithme serait forcé de chercher l'intersection dans toute la scène.

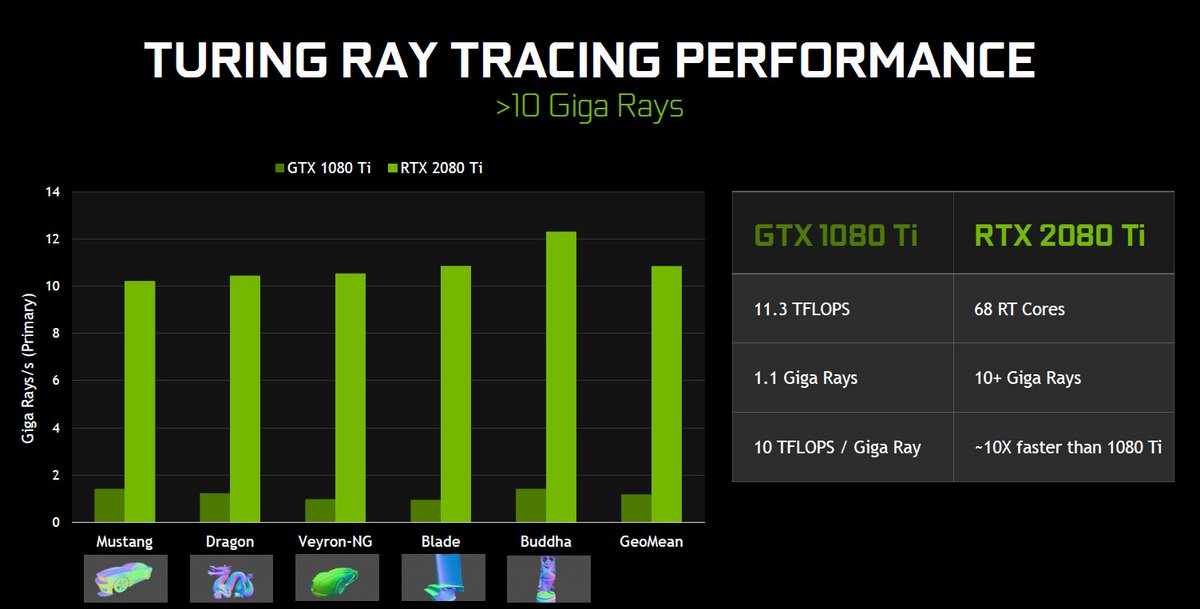

D'après NVIDIA, une Geforce GTX 1080 Ti peut générer 1,1 milliard de rayons par seconde en utilisant ses cœurs CUDA - alors que la RTX 2080 Ti peut en générer environ 10 milliards avec ses RT Cores. Mais cela ne reste pas suffisant pour générer une scène 3D complète en temps réel. C'est pour cette raison que NVIDIA a créé un nouveau pipeline de rendu hybride, impliquant de la rasterization traditionnelle pour le rendu géométrique, et du ray tracing via les RT Cores pour gérer les lumières ou les ombres, par exemple.

Il faut reconnaître que cette technologie permet de créer des images impressionnantes de réalisme dans les démos qu'il nous a été donné de voir. En revanche, ce sont bel et bien les développeurs qui auront la lourde tâche de l'utiliser et d'en faire quelque chose d'incontournable... ou non.

A l'heure où nous écrivons ce test, plus de 10 jeux seront compatibles avec l'hybrid rendering, et donc le ray tracing.

Deep Learning & Tensor Cores

Les Tensor Cores représentent l'autre grande nouveauté mise en avant par NVIDIA, et issue également de l'architecture Volta. Comme sur celle-ci, les Tensor Cores sont des unités spécialisées sur les opérations matricielles, qui sont les principales fonctions utilisées dans le Deep Learning. Ces Tensor Cores vont permettre d'accélérer drastiquement ce type d'opérations et d'apporter de nouvelles techniques - comme le DLSS, pour Deep Learning Super Sampling.L'exemple du DLSS est le premier à nous avoir été montré en démo temps réel. Il s'agit d'un « super » anti-aliasing qui se rapproche du résultat du TAA, très utilisé dans les jeux du moment. Le DLSS utilise beaucoup moins de ressources grâce à l'utilisation de moins de samples - les Tensor Cores se chargeant de créer les éléments intermédiaires grâce à l'IA - et aux modèles d'instructions fournis par NVIDIA via des mises à jour de pilotes.

Ces fameux modèles d'instructions sont calculés chez NVIDIA avec leur nouveau framework NGX, qui utilise les réseaux neuronaux pour améliorer les graphismes, rendus et autre application coté client. Pour faire simple, NVIDIA va utiliser ses supercalculateurs DGX SaturnV pour générer des images de la meilleure qualité possible, en super haute résolution. Puis entraîner un modèle d'IA pour qu'il génère des images intermédiaires dans une résolution plus basse mais aussi fidèle que possible.

On imagine qu'à terme d'autres améliorations pourront être mises en place, mais déjà plus de 25 jeux ont annoncé la prise en charge du DLSS. Le gros du travail étant effectué coté NVIDIA, on peut comprendre qu'il soit facile de convaincre les développeurs.

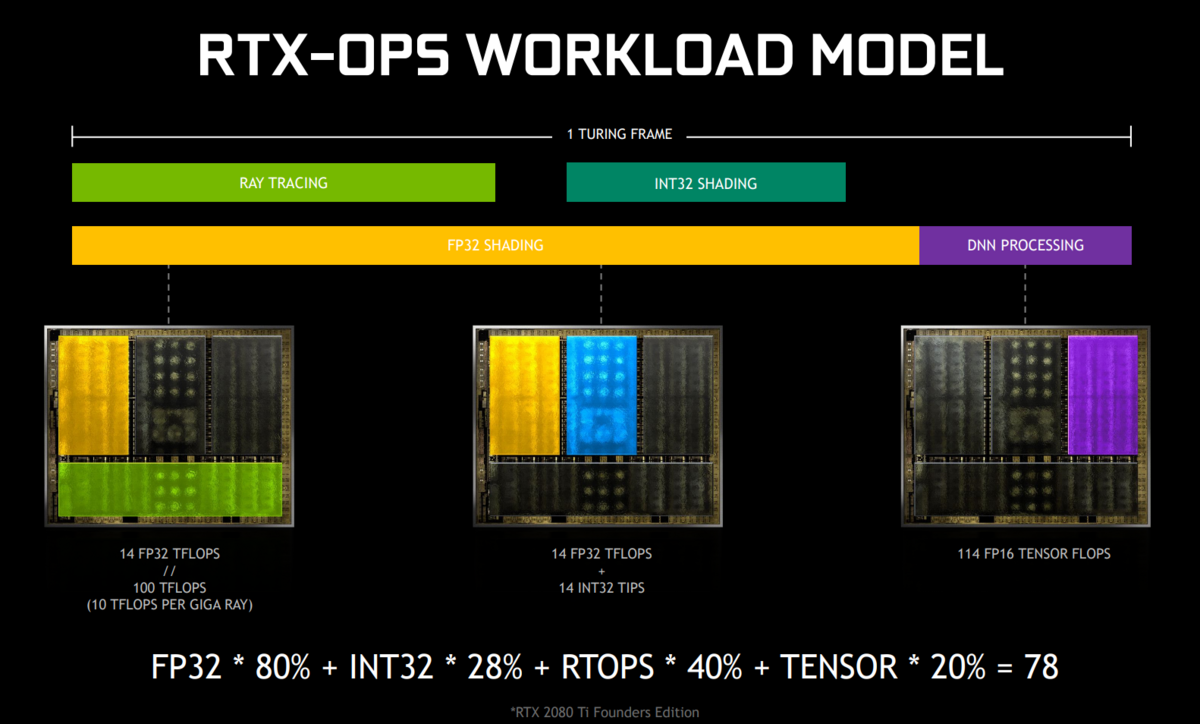

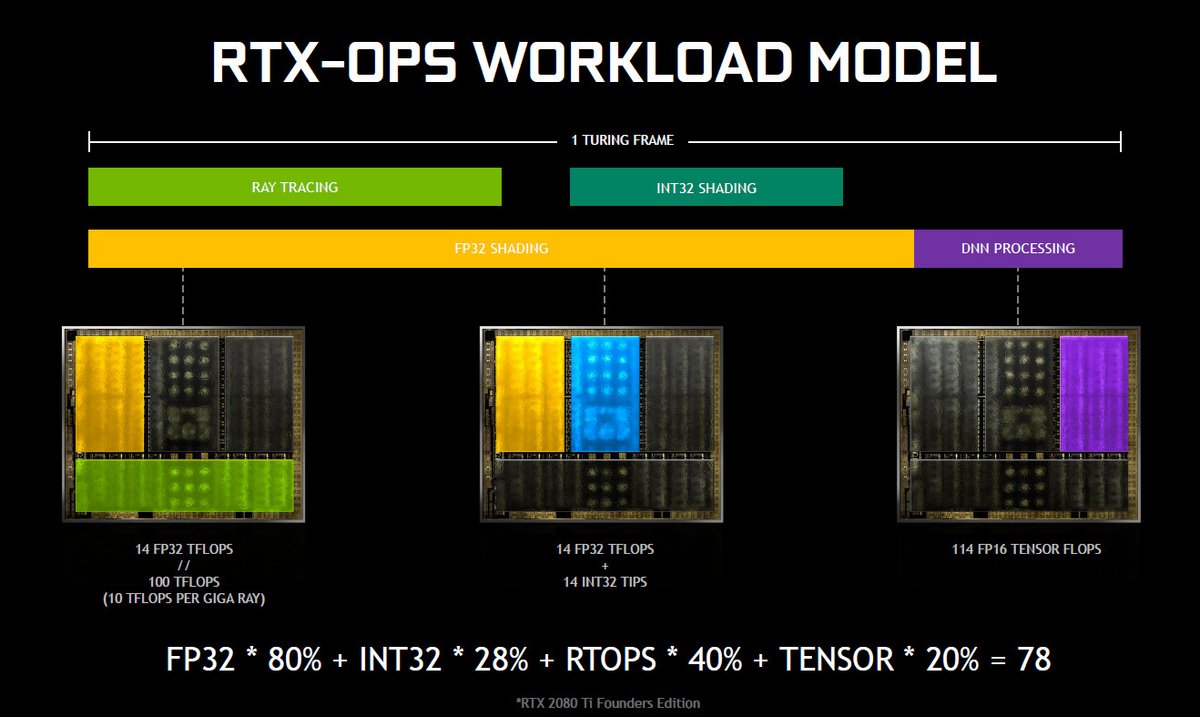

RTX-OPS : une nouvelle unité de mesure des performances

La nouvelle architecture Turing introduite par NVIDIA ne permet plus de mesurer les performances brutes des GPU en téraflops (TFLOPS). En effet, en plus des instructions INT32 et FP32, les RT Cores et les Tensor Cores doivent être pris en compte dans l'équation.C'est pour cette raison que NVIDIA a jugé nécessaire de créer une nouvelle unité de mesure qui refléterait les capacités totales de la carte, aussi bien sur la rasterisation que sur le ray tracing et le deep learning.

Il faudra probablement attendre un certain temps avant que cette nouvelle unité de mesure - les RTX-OPS - ait du sens, puisque qu'au moment du lancement des RTX, aucun jeu ne prend encore en charge le ray tracing et le DLSS.

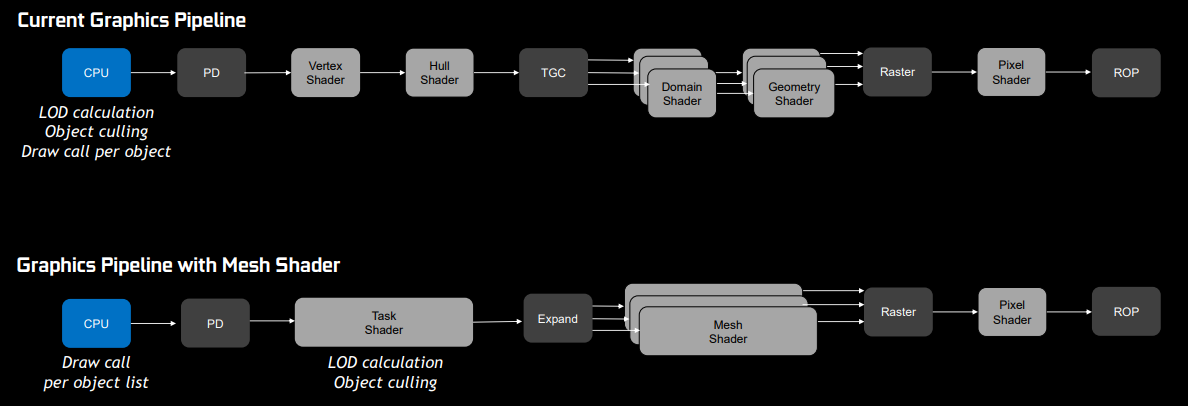

Mesh Shading, HDR natif et VirtualLink

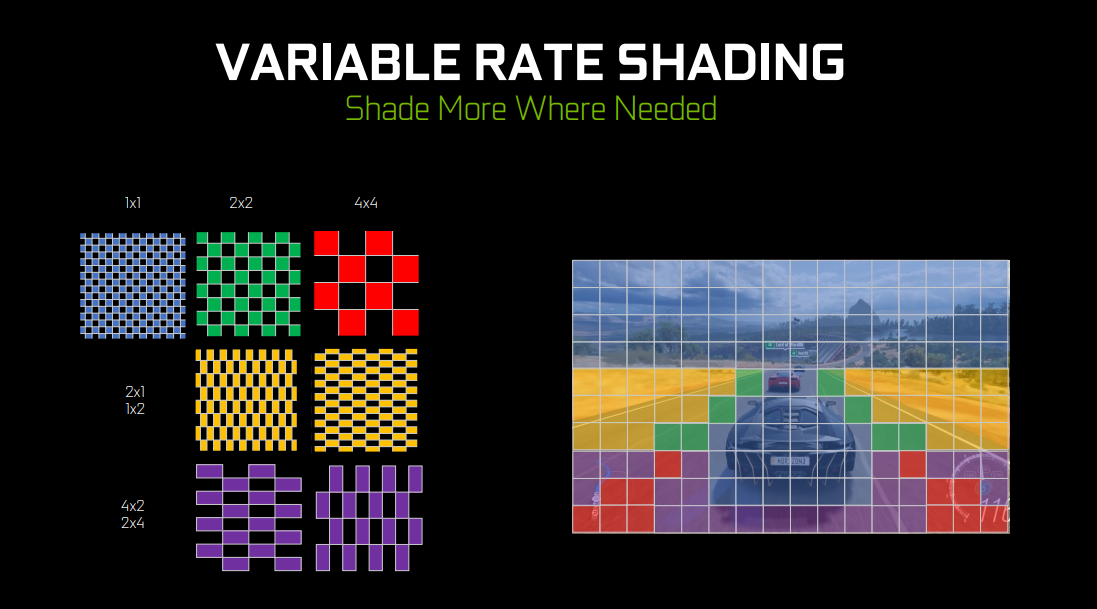

Derniers points avant de rentrer dans le vif du sujet. NVIDIA a introduit deux nouveaux procédés de shading avec Turing : le Mesh Shading et le Variable Rate Shading.Ces nouveaux procédés sont intéressants, puisqu'ils profitent d'ores et déjà aux jeux disponibles aujourd'hui.

Le Mesh Shading devrait améliorer le niveau de détails (LOD), cette technique qui permet d'affiner les détails des objets en fonction de la distance d'affichage en déchargeant le CPU de cette tâche.

De son coté, le Variable Rate Shading permet d'exécuter le rendu de certaines parties de l'image en moindre qualité, sans que cela soit perceptible dans le rendu final. On pourra par exemple privilégier la partie centrale de l'écran, où se déroule l'essentiel de l'action.

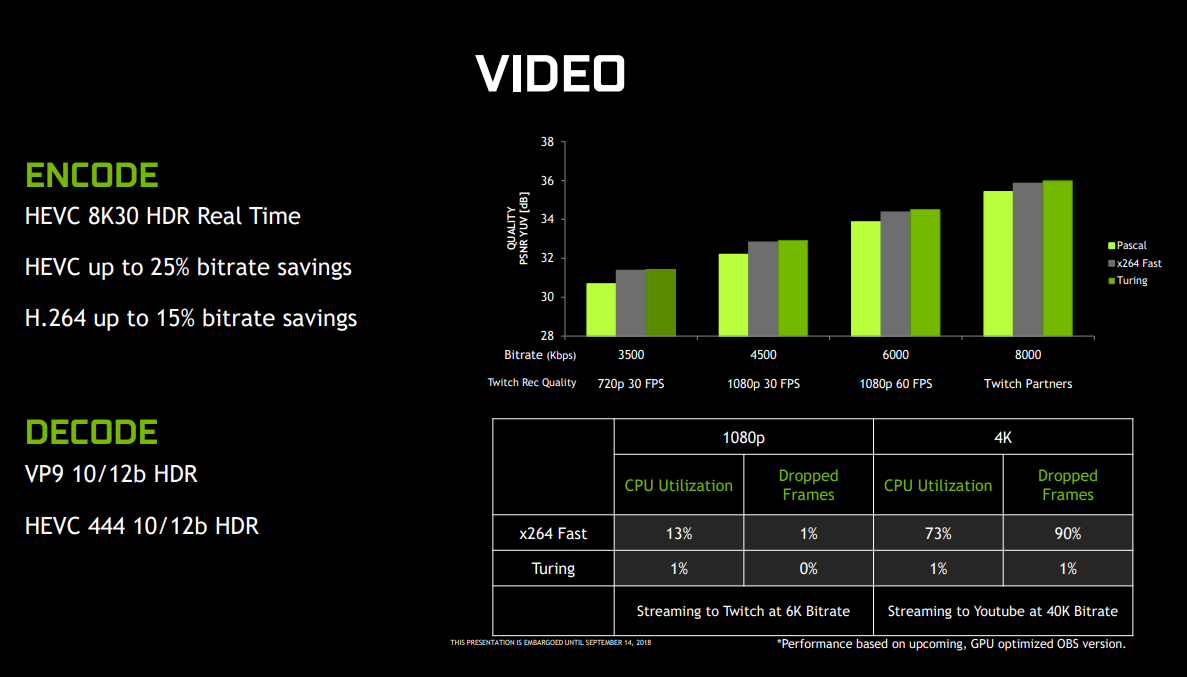

Sur la génération Pascal, les GPU avaient besoin d'appliquer un traitement logiciel qui rajoutait de la latence, avec un impact négatif sur les performances. Sur Turing, c'est terminé ! Tout le processus est réalisé au niveau du hardware grâce à un nouveau moteur vidéo.

Celui-ci est pleinement compatible avec le protocole DisplayPort 1.4a, dont on retrouve 3 connecteurs sur les cartes Founders Edition, ainsi qu'une sortie HDMI 2.0b et la nouvelle interface VirtualLink.

De quoi supporter jusqu'à quatre moniteurs en simultané, dans une résolution pouvant atteindre 8K grâce au Display Stream Compression (sur les ports DisplayPort uniquement).

C'est aussi le DSC qui permet d'utiliser des moniteurs en 4K 120 Hz, notre ROG Swift PG27U s'en lèche déjà les babines.

Enfin, un petit mot sur le VirtualLink : cette nouvelle interface utilise un port USB Type-C reconfiguré pour profiter au maximum aux casques de réalité virtuelle. Nous en reparlerons lorsque les casques disposant de ce nouveau standard seront disponibles.

Les modèles Founders Edition de NVIDIA

Les deux modèles sur lesquels nous allons nous attarder aujourd'hui sont les Founders Edition de NVIDIA. La RTX 2080 est déjà disponible dans toutes les bonnes crèmeries, au tarif de 849 €, tandis que la RTX 2080 Ti sera disponible dès le 27 septembre au prix de 1259 €.Anciennement appelées « design de référence », le caméléon les a renommées en Founders Edition lors de la sortie des cartes graphiques grand public de la génération Pascal.

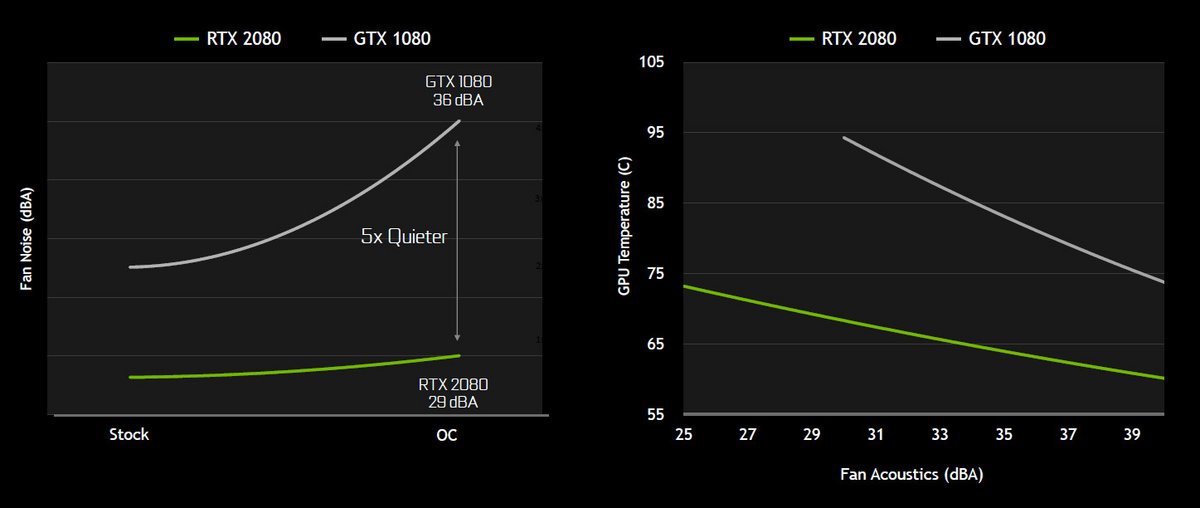

NVIDIA a décidé d'abandonner leur blower propriétaire (pour notre plus grand plaisir), pour se concentrer sur un système à double ventilateurs beaucoup moins bruyant ! Le blower avait pour particularité d'extraire tout l'air chaud à l'extérieur du boitier ; cette technique issue des datacenters n'avait plus vraiment de sens que dans les petits boitiers avec peu de volume pour le refroidissement.

Les partenaires de NVIDIA doivent s'en mordre les doigts : sur la génération Pascal leurs systèmes de refroidissement alternatifs leur permettaient de se différencier des Founders Edition. Pour se consoler, ils pourront cette fois-ci proposer des design blower !

Un petit mot sur les nuisances sonores avec la 2080 et la 2080 Ti. Lors de nos tests en conditions réelles boitier fermé (pas particulièrement optimisé pour pour le silence), les cartes sont très silencieuses, même en pleine charge dans les jeux exigeants. Aucune comparaison possible avec les blower de la génération précédente.

Protocole de test, consommation électrique et benchmarks généralistes

Avant de vous détailler la configuration de test utilisée, ainsi que le panel de cartes graphiques testées, nous tenons à préciser deux points :- Premièrement, nous n'avons pas pu intégrer les Radeon Vega 56 et 64 dans les benchmarks, car nous n'avons pas réussi à obtenir les cartes à temps. Nous comparerons donc Turing à Pascal. Lors de sa prise d'indépendance, Clubic est reparti à zéro au niveau du matériel. MAJ du 07/11/2018 : ajout de la Radeon RX Vega 64 Nitro+ de Sapphire dans les benchmarks.

- MAJ du 11/10/2018 : nous avons reçu le moniteur ASUS ROG Swift PG27U, la rolls des moniteurs gaming PC (4K HDR 144 hz Gsync) et nous avons donc pu tester les performances en HDR dans la section dédiée.

- Processeur Intel Core i7-8700K (3.7 GHz)

- Carte Mère MSI Z370 GAMING PRO CARBON (Chipset Intel Z370)

- DDR4 Corsair Vengeance LPX, 2 x 8 Go, 3000 MHz, CAS 15, PC-24000

- SSD Samsung Série 960 EVO, 250 Go, M.2 (Type 2280)

- Disque Dur Seagate BarraCuda, 2 To

- Alimentation Be Quiet ! Straight Power 11, 850W Plus Gold

Tous les tests sont effectués sous Windows 10 Pro (1803) avec les dernières mises à jour disponibles via Windows Update. La version des pilotes NVIDIA fournie est la 416.33.

Voici la liste des cartes que nous avons testées :

- GeForce GTX 1070 FE

- GeForce GTX 1080 FE

- GeForce GTX 1080 Ti FE

- GeForce RTX 2070 Armor (MSI)

- GeForce RTX 2070 Gaming Z (MSI)

- GeForce RTX 2080 FE

- GeForce RTX 2080 Ti FE

- GeForce RTX 2080 Ti Duke (MSI)

- Radeon RX Vega 64 Nitro+ (Sapphire)

Pour notre premier test, la RTX 2080 Ti dépasse de près de 46% la GTX 1080 Ti, et la RTX 2080 supplante la GTX 1080 de près de 43% ! Du coté des RTX 2070, on est 53% plus performant que la GTX 1070, et 18% plus rapide que la GTX 1080.

La 2080 Ti se place bien évidemment devant la 2080 avec une amélioration de près de 32% sur ce test.

Sur Unigine 2 en 4K, la RTX 2080 Ti surpasse la GTX 1080 Ti de près de 52%, alors que le RTX 2080 est 27% plus rapide que la GTX 1080.

Ces écarts sont presque similaires en 1440p, mais se réduisent lorsque l'on passe en 1080p.

Notre premier test du nouvel antialiasing (anticrénelage) est très impressionnant. Certes, il s'agit de démos et non de jeux en conditions réelles ; mais le gain observé est vraiment important et augure le meilleur pour cette technologie. D'autant plus que la qualité d'image finale est vraiment propre, et la différence avec du TAA classique est imperceptible.

Nous mesurons la consommation totale du PC avec un wattmètre à la prise, au repos sur le bureau, puis en pleine charge dans un jeu exigeant.

Pour obtenir la consommation des cartes au repos, nous comparons la consommation du PC avec et sans carte graphique insérée, sur le circuit graphique intégré.

Malgré la finesse de gravure un peu plus importante (12 nm VS 16 nm), l'augmentation de l'enveloppe thermique se traduit forcément par une consommation énergétique plus vorace.

La RTX 2080 est environ 40% plus gourmande que la GTX 1080 en charge, tandis que la RTX 2080 Ti est 25% plus énergivore que la GTX 1080 Ti. A noter que la consommation au repos des RTX est plus importante que la moyenne.

NVIDIA a d'ors et déjà annoncé travailler sur une mise à jour des pilotes pour régler le problème.

Performances dans les jeux

Sur l'ensemble des jeux que nous avons testé, c'est en 4K que les nouvelles RTX se démarquent le plus. La GeForce RTX 2080 est en moyenne près de 41% plus performante que la Geforce GTX 1080, et 10% plus rapide que la 1080 Ti.Tandis que la GeForce RTX 2080 Ti est elle 36% plus véloce que la GeForce GTX 1080 Ti, et 20% plus performante que sa petite soeur, la RTX 2080.

Lorsque la résolution baisse, l'écart se lisse de plus en plus, et en 1080p (FHD), c'est le CPU qui devient un facteur limitant. Quoi qu'il en soit, lorsqu'on s'offre une RTX 2080 ou 2080 Ti, le 1080p n'est pas l'objectif en vue !

Notez bien que l'intégralité de ces tests sont basés sur des jeux actuels, utilisant un rendu à base de rastérisation classique. Nous ne pouvons pas encore tester le rendu hybride avec le ray tracing, il faudra pour cela attendre au minimum la mise à jour d'octobre de Windows 10. Celle-ci devrait embarquer la première version publique de DXR au sein de DirectX 12.

Les développeurs devraient rendre disponible en même temps, les mises à jour spécifiques des jeux compatibles. Nous mettrons bien évidement ce test à jour à ce moment là.

Nous vous laissons découvrir les résultats par jeu et par résolution d'écran :

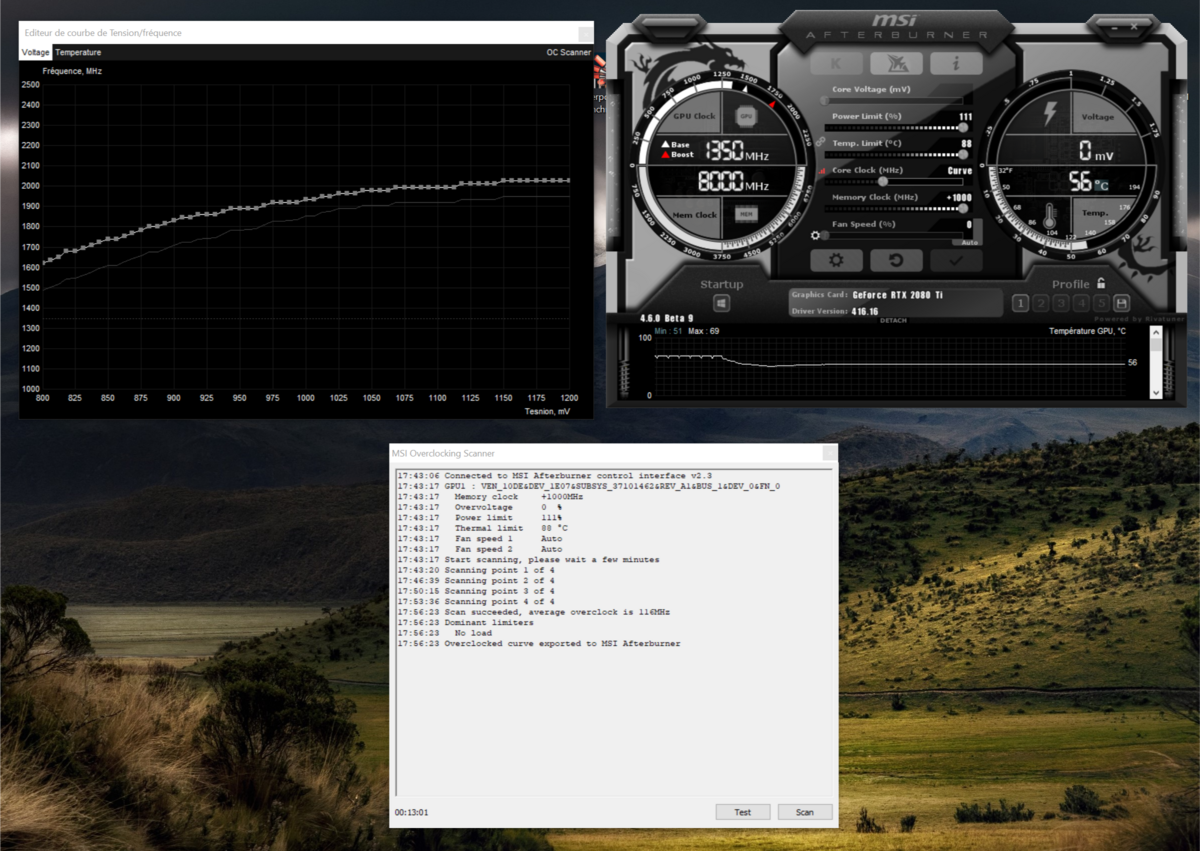

Overclocking

Après avoir testé en détails nos différents modèles de test, il ne reste plus que l'épreuve de l'overclocking pour pousser ces GeForce RTX dans leurs derniers retranchements. Sur la génération Turing, Nvidia a fait des efforts sur le refroidissement de ses cartes Founders Edition, afin de pouvoir améliorer les fréquences de fonctionnement des GPU.Rappelons nous que plus le refroidissement est efficace, plus la fréquence "boost" peut être augmentée. Un bon overclocking est un compromis entre performances, température et nuisances sonores.

Et ça tombe bien parce qu'avec Turing, Nvidia inaugure une nouvelle technologie appelée OC Scanner, sensée nous permettre d'effectuer un overclocking idéal et stable en un seul clic. Les cartes Founders Edition ainsi que les modèles partenaires embarquent un ensemble d'algorithmes dédiés à l'overclocking, permettant de tester le ratio fréquence/tension sur différents scénarios de charge.

L'avantage de ce système, c'est de pouvoir effectuer une analyse d'environ 10-20 minutes sans crash du PC. Le programme va mesurer les erreurs et mémoriser le dernier état stable avant le crash, permettant d'obtenir une courbe fréquence/tension idéale.

A l'heure actuelle seules les versions beta de EVGA Precision X1 et MSI Afterburner prennent en charge l'OC scanner.

Sur les trois cartes que nous avons overclockées, les résultats obtenus via l'OC Scanner sont très proches de ceux obtenus via un overclocking manuel. A 5-10 Mhz près, nous n'avons pas fait mieux "à l'ancienne". En revanche l'overclocking automatique n'a aucun impact sur les fréquences mémoire, alors que nous avons pu sans problème faire un +1000 Mhz sur les trois cartes.

Maintenant place aux résultats :

Nous avons réussi à pousser notre RTX 2080 à 2010 Mhz, notre RTX 2080 Ti Duke de MSI à 2040 Mhz, et enfin la RTX 2080 Ti Founders Edition a atteint les 2070 Mhz !

Si l'on traduit ça en terme de performances, sur le test TimeSpy Extreme de 3D Mark, en 4K, on mesure le Graphics score :

- GeForce RTX 2080 Founders Edition : +10%

- MSI GeForce RTX 2080 Ti Duke 11G OC : +9%

- GeForce RTX 2080 Ti Founders Edition : + 14%

A noter tout de même qu'à ces fréquences élevées, les ventilateurs tournent très vite et deviennent bruyants. Seule la carte de MSI reste relativement silencieuse, au détriment de l'overclocking le moins efficace.

Du coté des RTX 2070, nous avons pu pousser la Armor à 1980 Mhz, et le modèle Gaming Z à 2010 Mhz. En terme de performances, toujours sur TimeSpy Extreme en 4K, on obtient :

- RTX 2070 Armor : +12%

- RTX 2070 Gaming Z : +6%

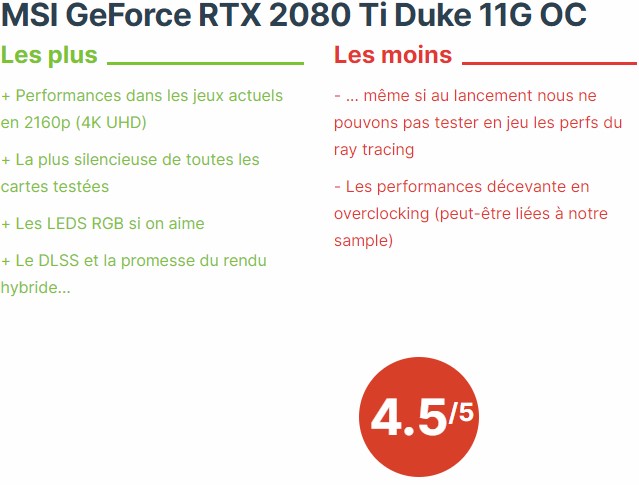

Test MSI GeForce 2080 Ti Duke 11G OC

La première candidate des modèles partenaires que nous allons tester est la monstrueuse RTX 2080 Ti Duke 11G OC de MSI. Celle-ci fait la bagatelle de 31,2 cm de longueur, 12 cm de hauteur, et un poil plus de 5 cm d'épaisseur pour un poid de près de 2 kg !Son imposant système de refroidissement surmonté de trois ventilateurs Torx Fan 2.0 de 90 mm, promet un refroidissement des plus efficace, tout en limitant les nuisances sonores. Au niveau des sorties, on y trouve trois DisplayPort 1.4a, un connecteur VirtualLink (USB C) pour la VR, et une sortie HDMI 2.0b. Finalement exactement la même chose que sur le modèle de référence de NVIDIA.

Au niveau de l'alimentation, on reste sur deux connecteurs 8-pin. La carte est bien évidemment compatible avec le système Mystic Light de MSI, afin de contrôler les LED RGB qui décorent la tranche visible, venant illuminer de tous feux le logo Duke.

Coté fréquences de fonctionnement, la fréquence de base reste à 1350 Mhz comme sur le modèle de référence, mais le mode boost passe à 1665 Mz (VS 1635 Mhz), une petite augmentation de 2%. Au niveau de la mémoire, on reste sur une fréquence de 1750 Mhz.

La carte de MSI est également capable de fonctionner en mode totalement silencieux, en coupant ses ventilateurs lorsque la charge est légère.

La RTX 2080 Ti Duke 11G OC de MSI est un monstre de puissance, à même de tenir tête aux jeux les plus gourmands en 4K HDR à 60 images/sec, voire au delà. Bien sûr ce niveau de performances -inégalé sur le marché- a un prix très élevé. Il vous en coûtera 1319 €, soit 60 € de plus que le modèle Founders Edition de Nvidia.

Finalement la 2080 Ti Duke perd quelques points à cause de ses performances en overclocking, décevantes face à la Founders Edition. C'est d'autant plus dommage que cet énorme système de refroidissement laissait augurer du meilleur. Peut être que nous n'avons pas eu de chance avec la puce T102 de notre sample, étant donné que d'autre testeurs ont pu pousser leurs fréquences au delà des nôtres.

Si on laisse de coté l'overclocking, la carte de MSI est en tête de notre classement, environ 3,5% plus rapide que la Founders Edition, à vous de voir si la différence de prix est justifiée. Notons tout de même que le système de refroidissement est le plus silencieux de tous les modèles que nous avons testé, un très bon point pour MSI.

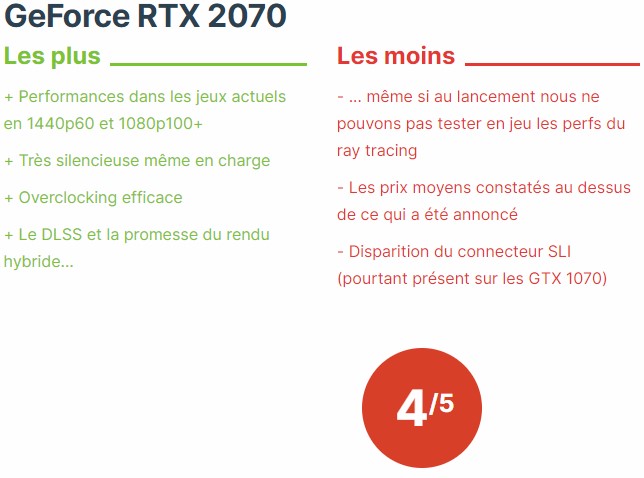

Conclusion RTX 2070

Après avoir testé sous toutes les coutures les GeForce RTX 2080 & 2080 Ti, intéressons-nous aujourd'hui à leur petite sœur plus abordable, la GeForce RTX 2070 de NVIDIA. Annoncée également pendant la Gaming Celebration à la Gamescom, elle est disponible dans toutes les bonnes crèmeries depuis le 17 octobre, à partir de 519 € pour les modèles partenaires et 629 € en Founders Edition (overclockée d'usine avec le design de référence NVIDIA).La GeForce RTX 2070 est basée sur un GPU de la génération Turing, la TU106 avec 2304 cœurs CUDA, 288 Tensor Cores et 36 RT Cores, le tout supporté par 8 Go de mémoire GDDR6. Il s'agit de « l'entrée » du haut de gamme des RTX.

Cette fois-ci, nous avons testé deux modèles partenaires, la MSI GeForce RTX 2070 Armor 8G et la MSI GeForce RTX 2070 Gaminz Z 8G. Celles-ci sont affichées respectivement à 519 € et 679 €.

519 €, c'est le prix « plancher » annoncé par NVIDIA lors de sa présentation à la Gamescom. Il s'agit du billet d'entrée vers les technologies de ray tracing et de deep learning (DLSS). Attention, dans les faits, les stocks étant faibles au lancement, les marchands ne jouent pas le jeu et pratiquent des tarifs plus importants. A l'heure où nous écrivons ces lignes, il est impossible de trouver en stock le modèle Armor à 519 €. Au mieux ce même modèle est dispo sous 15 jours à... 590 €. En revanche le modèle Gaming Z, plus performant, est lui bien disponible immédiatement au prix annoncé de 679 € chez plusieurs gros e-commerçants.

D'après nos recherches, le modèle le plus accessible et disponible immédiatement, sous la barre des 523 €, est un modèle d'ASUS, la GeForce RTX 2070 - TURBO. Celle-ci profite d'un refroidissement de type « blower », moins efficace et plus bruyant que les doubles ventilateurs. Ce type de refroidissement a néanmoins l'avantage d'expulser l'intégralité de l'air chaud à l'extérieur du boitier, ce qui est intéressant dans le cas de configurations compactes.

Mais à qui se destine cette nouvelle carte ?

La GeForce RTX 2070 est idéale pour les gamers qui souhaiteront profiter de tous les jeux récents à plus de 60 images/sec en 1440p (WQHD) avec tous les réglages au maximum. Les joueurs qui possèdent des écrans à plus de 120Hz pourront également jouer à des taux de rafraîchissement supérieurs à 100 images/sec en 1080p (FULL HD), très utile pour les jeux compétitifs notamment. La RTX 2070 vient jouer sur le terrain des GTX 1080 et des Radeon Vega 64 que nous avons ajoutées récemment à nos benchmarks.Dans les faits, la RTX 2070 est plus efficace que la GTX 1080 dans l'intégralité de nos tests, avec plus de 10% d'amélioration. Dans certains jeux (BF1, FarCry 5), la Radeon Vega 64 se rapproche des résultats de la RTX 2070 en 1440p - au prix d'une consommation électrique importante - mais à un tarif moyen constaté en dessous des RTX 2070.

A la vue des tarifs actuellement affichés, on aurait pu se poser la question de l'intérêt d'acheter une RTX 2070 face à une GTX 1080 beaucoup moins chère. Sauf que les stocks de GTX 1080 sont quasiment épuisés, et que sur ce créneau de performances il vous faudra faire le choix entre l'équipe rouge et l'équipe verte.

Bien entendu, avec la GeForce RTX 2070, NVIDIA nous fait la promesse du ray tracing et des technologies liées au deep learning comme le DLSS. Très prometteuses sur le papier et sur les démos techniques, on attend toujours de pouvoir tester ça en jeu. Il n'appartient qu'à NVIDIA et aux développeurs de jeux de transformer l'essai, et de rendre indispensables ces nouvelles technologies.

NVIDIA signe donc une GeForce RTX 2070 très efficace, mais au positionnement tarifaire encore incertain si proche du lancement. Gageons que l'amélioration des stocks jouera en faveur des intéressés, et que les premiers patch RTX pour les jeux dévoileront tout le potentiel de cette carte graphique.

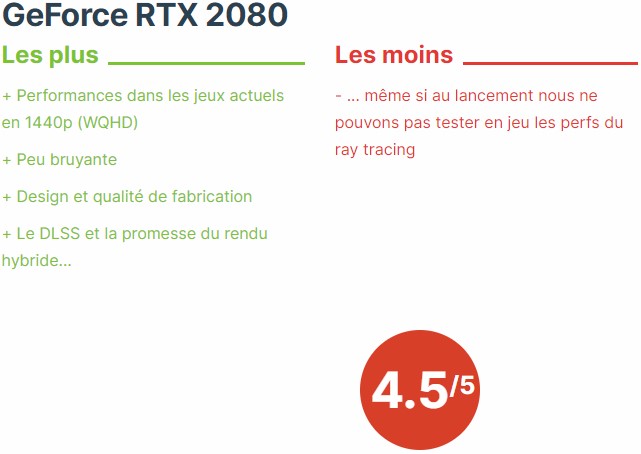

Conclusion RTX 2080

Lancée il y a plus de deux ans, il était grand temps de trouver un digne successeur pour la vénérable GeForce GTX 1080. Il faut dire que dans l'industrie des cartes graphiques, c'est la première fois que l'attente est aussi longue.La GeForce RTX 2080 vient donc reprendre le flambeau, équipée d'améliorations significatives en termes de performances pour les jeux actuels, elle embarque aussi une toute nouvelle architecture taillée pour le futur du gaming selon NVIDIA.

Mais à qui se destine cette nouvelle carte ?

La GeForce RTX 2080 est idéale pour les gamers qui souhaiteront profiter de tous les jeux récents à plus de 80 images/sec en 1440p (WQHD) avec tous les réglages au maximum.Nous ne pouvons que conseiller les joueurs qui recherchent ce type de performances d'investir dans une RTX 2080, plutôt qu'une GTX 1080 Ti, pour une différence de prix minime.

D'autant plus que les promesses du rendu hybride et des technologies liées au deep learning sont très intéressantes sur le papier.

On regrettera juste que NVIDIA ait décidé de précipiter le lancement de ses nouvelles GeForce, sans nous laisser la possibilité de tester les performances du rendu hybride sur des jeux réels. Comptez sur nous pour le faire dès que possible !

Conclusion RTX 2080 Ti

Du coté de la RTX 2080 Ti, l'attente fut moins longue que pour sa petite soeur, puisque la GeForce GTX 1080 Ti est sortie il y a un peu plus d'un an.Cette fois-ci pour sa génération Turing, NVIDIA a décidé de commercialiser sa déclinaison Ti dès le lancement.

La GeForce RTX 2080 Ti vient donc reprendre le flambeau, équipée d'améliorations significatives en termes de performances pour les jeux actuels, elle embarque aussi une toute nouvelle architecture taillée pour le futur du gaming selon NVIDIA.

Mais à qui se destine cette nouvelle carte ?

La GeForce RTX 2080 Ti est idéale pour les gamers qui souhaiteront profiter de tous les jeux récents à plus de 60 images/sec en 2160p (4K UHD) avec tous les réglages au maximum.Dans nos tests, seul le dernier Tomb Raider est juste en dessous, mais nous ne doutons pas que les mises à jour successives de pilotes viendront améliorer les choses.

Certes, le prix demandé est important (1259 €), mais à ce jour seule la RTX 2080 Ti permet l'exploit du gaming 4K sans concession à plus de 60 images/sec.

D'autant plus que les promesses du rendu hybride et des technologies liées au deep learning sont très intéressantes sur le papier.

On regrettera juste que NVIDIA ait décidé de précipiter le lancement de ses nouvelles GeForce, sans nous laisser la possibilité de tester les performances du rendu hybride sur des jeux réels. Comptez sur nous pour le faire dès que possible !