Des parents ont découvert dans un dessin animé proposé par YouTube des passages dérangeants simulant une tentative de suicide. Cette affaire illustre une nouvelle fois les problèmes de modération rencontrés par la plateforme de Google.

« Nous travaillons sans relâche pour que YouTube ne soit pas utilisé dans le but d'encourager les comportements dangereux. Nous appliquons des règles strictes interdisant les vidéos encourageant l'automutilation. Nous nous appuyons sur le signalement des utilisateurs et des outils de détection automatisés afin d'identifier rapidement ces contenus et les soumettre à nos équipes pour une vérification humaine. Chaque trimestre, nous supprimons des millions de vidéos et chaînes qui enfreignent nos politiques. La majorité de ces vidéos sont supprimées avant même qu'elles ne soient visualisées. Nous nous efforçons d'améliorer nos systèmes dans le but de supprimer encore plus rapidement ces contenus illicites. »

Une mère de famille qui souhaite rester anonyme a fait une découverte absolument sordide en regardant des dessins animés avec son fils sur YouTube. Après sept minutes, le dessin animé s'est interrompu pour montrer un homme donnant des conseils sur la meilleure manière de se taillader les poignets. Après quelques secondes, le cartoon a repris comme si de rien n'était.

Un passage malsain caché dans un dessin animé tous publics

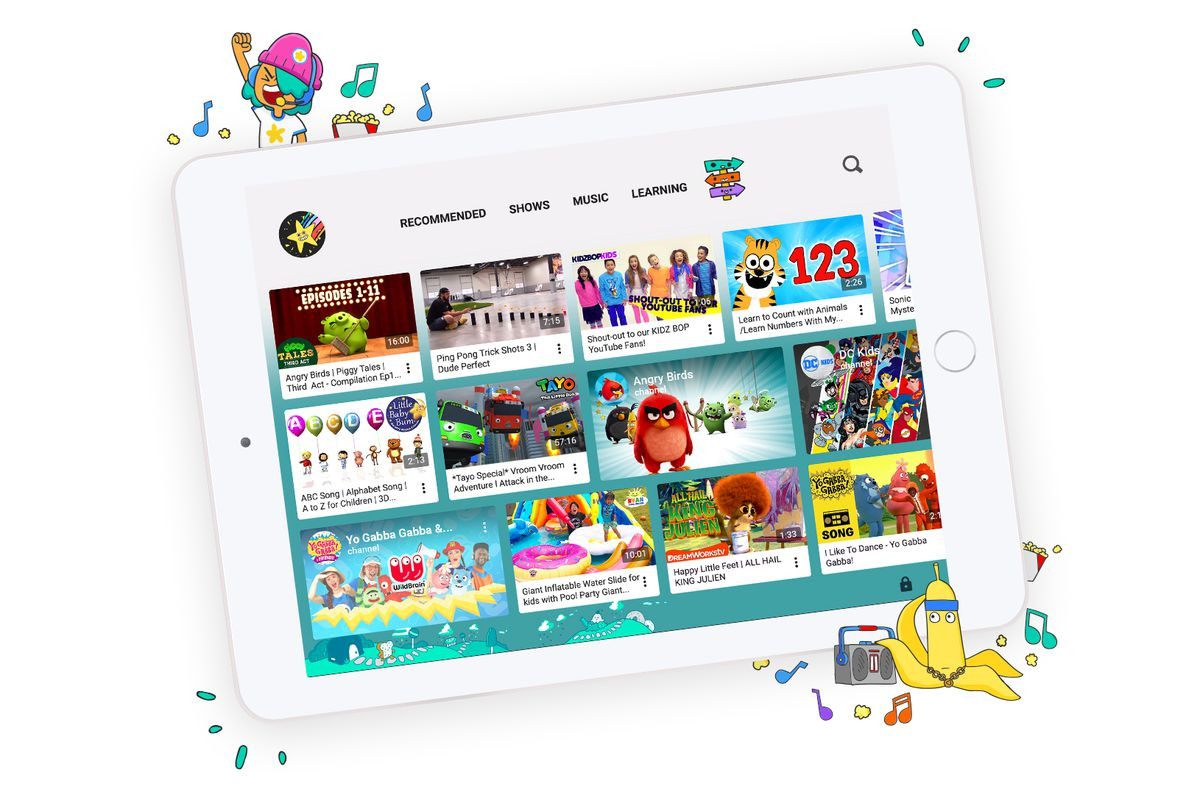

Dégoûtée par ce qu'elle a vu, la mère de famille a immédiatement supprimé l'application de ses appareils et interdit son utilisation à ses enfants. Elle a ensuite raconté son histoire sur le site Pedimom, un blog de conseils pédiatriques, pour alerter des dangers encourus par les plus jeunes à utiliser la version pour enfants de YouTube.La vidéo incriminée a été retirée immédiatement de la plateforme de streaming, mais on peut constater que les premiers signalements ont débuté 8 mois auparavant.

YouTube modère souvent a posteriori, un problème pour le développement des plus jeunes

YouTube a répondu à la polémique dans un communiqué. Le service assure que « les vidéos signalées sont examinées manuellement 24 heures sur 24, 7 jours sur 7 et toutes les vidéos qui n'appartiennent pas à l'application sont supprimées ».Ce n'est pas la première fois que la modération mise en place par le géant du streaming vidéo est pointée du doigt. Il y a quelques jours à peine, une sombre affaire de vidéos de jeunes filles dans des positions suggestives avait été dévoilée. Des annonceurs avaient aussitôt annoncés retirer leurs investissements publicitaires pour ne plus être associés à ces contenus contraires à leurs valeurs, malgré les décisions rapides prises par YouTube pour supprimer les contenus et les commentaires jugés indécents.

Mais pour Nadine Kaslow, ancienne présidente de l'Association américaine de psychologie, le simple retrait de ces vidéos n'est pas suffisant : « Pour les enfants qui ont été exposés, ils ont été exposés. Ils doivent être accompagnés désormais. C'est pourquoi cela ne va pas ». Elle rappelle que les plus jeunes pourraient également essayer de reproduire ce qu'ils ont vu dans les vidéos par curiosité.

Aux États-Unis, le suicide est la troisième cause de décès chez les jeunes de 10 à 24 ans, avec 157 000 passages à l'acte recensés chaque année.

Source : Ars Technica