Ce modèle d'IA délaisse la conception en cascade classique pour une approche plus aboutie ; avec des résultats assez prometteurs.

Alors que les générateurs d'images par intelligence artificielle sont désormais légion et souvent bien aboutis, des outils similaires pour la vidéo restent moins nombreux et bien moins convaincants. Une équipe de chercheurs, dont plusieurs officient pour le compte de Google Research, compte bien y remédier avec Lumiere, un modèle d’IA de génération de vidéo d’un nouveau genre.

Un modèle qui adopte une approche différente

La réalisation d’une vidéo par l’IA est plus complexe que celle d’une image statique pour plusieurs facteurs. Le principal est la cohérence des mouvements : difficile de rendre une démarche naturelle par exemple. Il peut également y avoir des problèmes de saccades ou de gestion des interactions avec le décor.

Pour pallier ce problème, plutôt que d'assembler une succession d’images individuelles aboutissant à un agglomérat plus ou moins satisfaisant, Lumiere façonne l'ensemble de la vidéo en un seul processus via une gestion simultanée du placement des objets et de leur mouvement.

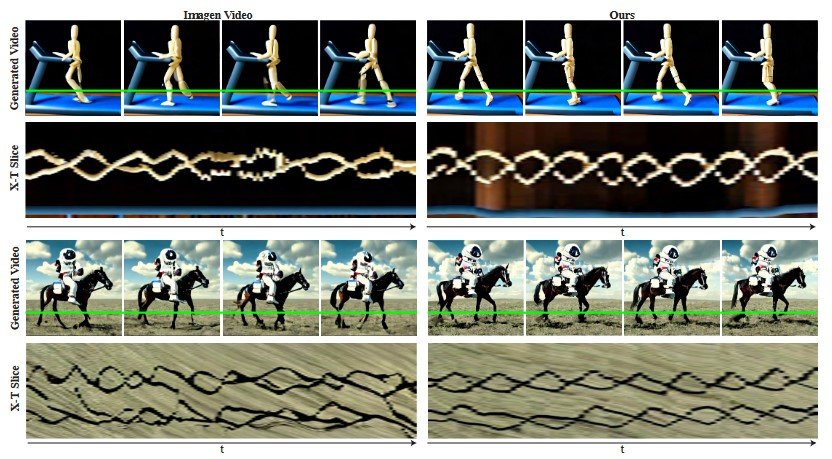

Les auteurs précisent : « L’architecture Space-Time U-Net génère toute la durée temporelle de la vidéo en une seule fois, par le biais d'un seul passage dans le modèle. Cela contraste avec les modèles vidéo existants qui synthétisent des images clés distantes suivies d'une super-résolution temporelle, une approche qui rend intrinsèquement difficile la cohérence temporelle globale ».

Hila Chefer, l'une des contributrices, a publié quelques démos sur son compte X.com.

Les chercheurs comparent la cohérence offerte par Lumiere par rapport à celle d’Imagen Video – un autre outil vidéo IA de Google – basé sur une conception en cascade plus traditionnelle.

Le résultat auquel aboutit Lumiere est également montré dans la vidéo ci-dessous.

Des clips de 5 secondes

Lumiere est en mesure de générer 80 images à une fréquence de 16 images par seconde, ce qui correspond à une séquence de 5 secondes. On reste loin du long métrage (et même du court), mais cette durée est raccord avec la majorité des solutions actuelles. Le modèle de Stable Video Diffusion par exemple aboutit à des séquences de 14 à 25 images pour des taux de rafraîchissement compris entre 3 et 30 images par seconde. En outre, la définition est de 576 x 1024 pixels contre 1024 × 1024 pour Lumiere. Parmi les autres solutions concurrentes, citons aussi celle de Pika Labs.

Lumiere peut générer des vidéos à partir de différentes requêtes, à commencer par celle text-to-video. À l’instar d’un générateur d’images classique, c’est une simple description écrite de la demande ; « un chien portant des lunettes de soleil qui conduit une voiture » pour prendre l'une de celles exprimées dans la vidéo d’illustration.

Lumiere accepte également une invite image-to-video. Elle consiste à générer une vidéo à partir d’une image. Il est également possible de demander des vidéos stylisées à partir d’une image de référence. Enfin, outre la génération de vidéos, le modèle peut éditer des vidéos existantes, pour animer ou remplir certaines zones, ce qui est moins ordinaire.

Il n’est pas possible de faire mumuse avec Lumiere pour le moment ; cela reste un projet de recherche. Une seule certitude, dans un avenir relativement proche, les générateurs de vidéos par intelligence artificielle deviendront aussi faciles d’accès que les générateurs d’images.

Vous trouverez des détails sur les différents modèles TSR et STUNet pour terminer. N'hésitez pas à consulter la source si vous souhaitez approfondir le sujet.

Source : Google Research