Meta aurait délibérément conçu ses modèles Llama 4 pour exceller dans les tests d'évaluation standardisés plutôt que dans des applications réelles. Cette optimisation ciblée, révélée par des chercheurs indépendants, remet en question les performances supposément « supérieures » vantées par l'entreprise de Mark Zuckerberg.

Après avoir vanté des performances « supérieures à celles de Google et OpenAI » pour ses nouveaux modèles Llama 4, Meta fait face à des accusations embarrassantes d'optimisation artificielle pour les benchmarks. L'entreprise qui avait récemment déployé son assistant Meta AI en France pourrait avoir succombé à la tentation d'adapter spécifiquement ses modèles aux tests d'évaluation standards. Cette pratique controversée rappelle étrangement la stratégie commerciale dissimulée derrière l'apparente générosité de son approche open source, révélée plus tôt cette année.

Quand l'IA apprend trop bien les tests d'évaluation

Le phénomène d'overfitting, ou surapprentissage, se produit lorsqu'un modèle d'intelligence artificielle est tellement optimisé pour un ensemble spécifique de données qu'il perd sa capacité à généraliser efficacement sur de nouvelles données. Dans le cas de Llama 4, des chercheurs ont découvert que les modèles Scout et Maverick excellaient sur les benchmarks standardisés comme LMArena, mais présentaient des performances nettement inférieures face à des problèmes légèrement modifiés.

Cette pratique s'apparente à un élève qui mémoriserait parfaitement les réponses aux examens types sans comprendre véritablement les concepts sous-jacents. En analysant le comportement des modèles Llama 4, les experts ont identifié des schémas de réponses qui suggèrent une connaissance préalable des questions d'évaluation, particulièrement pour les tâches de raisonnement et de codage.

Meta aurait délibérément exposé ses modèles Llama 4 aux données d'évaluation pendant la phase d'entraînement, créant ainsi une illusion de performance supérieure. Cette tactique questionnable permet à l'entreprise d'afficher des scores impressionnants pour attirer clients et investisseurs, tout en dissimulant les véritables capacités de ses systèmes dans des scénarios réels imprévisibles.

Une stratégie de communication trompeuse qui s'inscrit dans un pattern

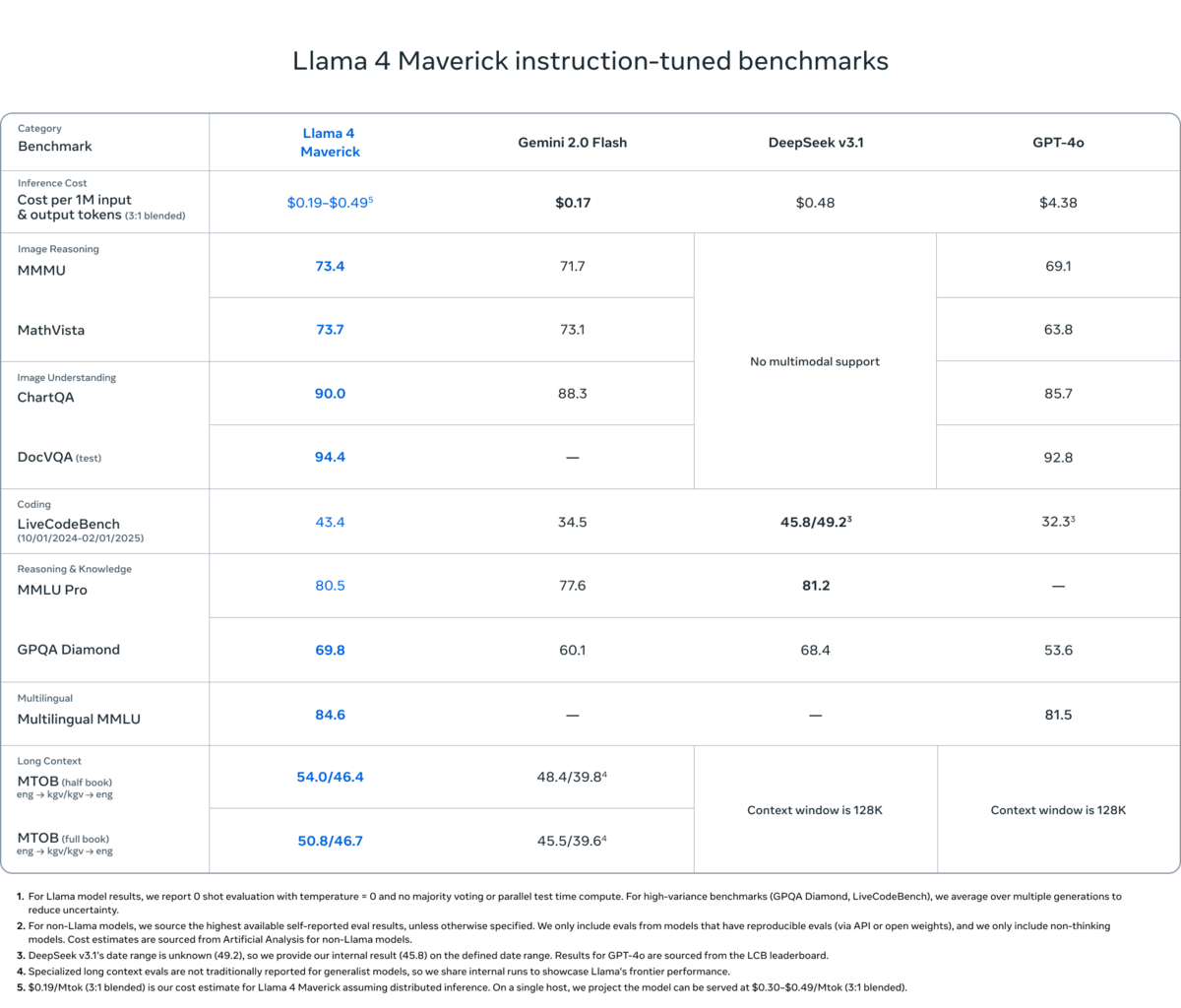

Ce n'est pas la première fois que Meta joue avec les limites de la transparence dans sa communication. Rappelons que l'entreprise présentait Llama comme totalement open source alors qu'un document judiciaire a révélé l'existence d'accords de partage de revenus avec des partenaires hébergeant ces modèles, contredisant directement les affirmations publiques de Mark Zuckerberg. L'architecture MoE (Mixture of Experts) vantée par Meta comme une innovation majeure de Llama 4 pourrait avoir été spécifiquement configurée pour optimiser les scores sur les benchmarks populaires. Les 128 experts de Maverick semblent avoir été entraînés pour reconnaître et exceller sur les types précis de problèmes présents dans les évaluations standardisées, au détriment de la polyvalence nécessaire en conditions réelles.

Prévenir l'overfitting, c'est l'un des défis fondamentaux en apprentissage automatique. Les bonnes pratiques incluent la diversification des données d'entraînement, l'utilisation de techniques comme la régularisation ou le early stopping, et surtout, la validation sur des jeux de données totalement indépendants. Les benchmarks actuels montrent leurs limites face à des acteurs qui peuvent optimiser leurs modèles spécifiquement pour ces tests. La communauté scientifique plaide désormais pour des évaluations dynamiques qui changeraient régulièrement leurs paramètres, rendant l'overfitting bien plus difficile.

Source : The Verge