Le Radeon HD 2600 est la première puce graphique DirectX 10 véritablement orienté milieu de gamme d'AMD. Utilisant l'architecture du R600, le Radeon HD 2600 inaugure par ailleurs l'UVD, du nom du fameux moteur de décompression vidéo haute définition de nouvelle génération. En prime, AMD utilise ici pour la première fois une finesse de gravure de 65nm, un procédé visiblement à l'origine de bien des tracas. Et comme un bonheur n'arrive jamais seul, AMD en profite pour également lever le voile sur le Radeon HD 2400, une puce à l'orientation plus entrée de gamme. Comment se comporte l'architecture R600 une fois déclinée ? Quelles sont les caractéristiques des Radeon HD 2600 et HD 2400 ? Le Radeon HD 2600 XT est-il en mesure d'inquiéter le GeForce 8600 GTS de NVIDIA ? Autant de questions qui devraient trouver une réponse dans cet article.

Microsoft DirectX 10 : Bref rappel pour les absents

Autre nouveauté liée à DirectX 10, l'unification du modèle de programmation. Les programmeurs apprécieront cette attention de Microsoft, pixel shaders, vertex shaders et geometry shaders se programmant dorénavant avec le même langage. Bien sûr, DirectX 10 introduit d'autres nouveautés comme la prise en charge de textures haute définition ou encore la réduction de la consommation processeur liée à l'utilisation de la bibliothèque. En effet, Microsoft s'est séparé avec DirectX 10 de tout l'héritage lié à la compatibilité descendante avec les anciennes versions de DirectX, DirectX 10 n'opérant qu'avec les puces graphiques DirectX 10. C'est d'ailleurs pour cette raison que Windows Vista comporte deux versions de DirectX : DirectX 10 et DirectX 9.0.

AMD Radeon HD 2000 : architecture unifiée

Succédant aux Radeon X1000, la famille Radeon HD 2000 profite d'une architecture unifiée de deuxième génération, héritée en partie des travaux menés par ATI sur la puce graphique Xenos de la Processeurs du Radeon HD travailler sur ce type de données alors qu'un jeu utilisant massivement la géométrie profitera d'une plus grande puissance de traitement, toutes les unités de la puce graphique travaillant alors sur ce type de données. Ce concept d'architecture unifié a été mis en place pour la première fois par ATI avec la console de jeux de Microsoft, mais c'est NVIDIA qui fut le premier à lancer une puce graphique DirectX 10 dont l'architecture était unifiée avec le GeForce 8.

Le pourquoi de l'architecture unifiée par AMD

Sans revenir dans le détail sur les choix technologiques opérés par AMD avec son R600, préférant pour cela vous renvoyer à notre article sur le Radeon HD 2900 XT, il nous faut toutefois revenir sur l'une de ses particularités les plus importantes, particularité qui se situe au niveau des unités de calcul. Au sein des puces graphiques dont l'architecture est unifiée, on retrouve une somme de petits processeurs, les processeurs de flux, qui travaillent directement sur les instructions scalaires ou sur les composantes d'un vecteur. Rappelez-vous qu'une puce graphique travaille sur des tableaux de données où chaque pixel est décrit par un vecteur à quatre composantes (rouge, vert, bleu et sa composante Alpha pour la transparence). Sur les précédentes générations de puces graphiques, Radeon X1000 et GeForce 7 comprises, l'architecture des unités était dite co-issue (ou 3+1), le shader pouvant appliquer simultanément deux traitements à un pixel: l'un au groupe de composantes de couleur (RGB), l'autre aux informations de transparence.

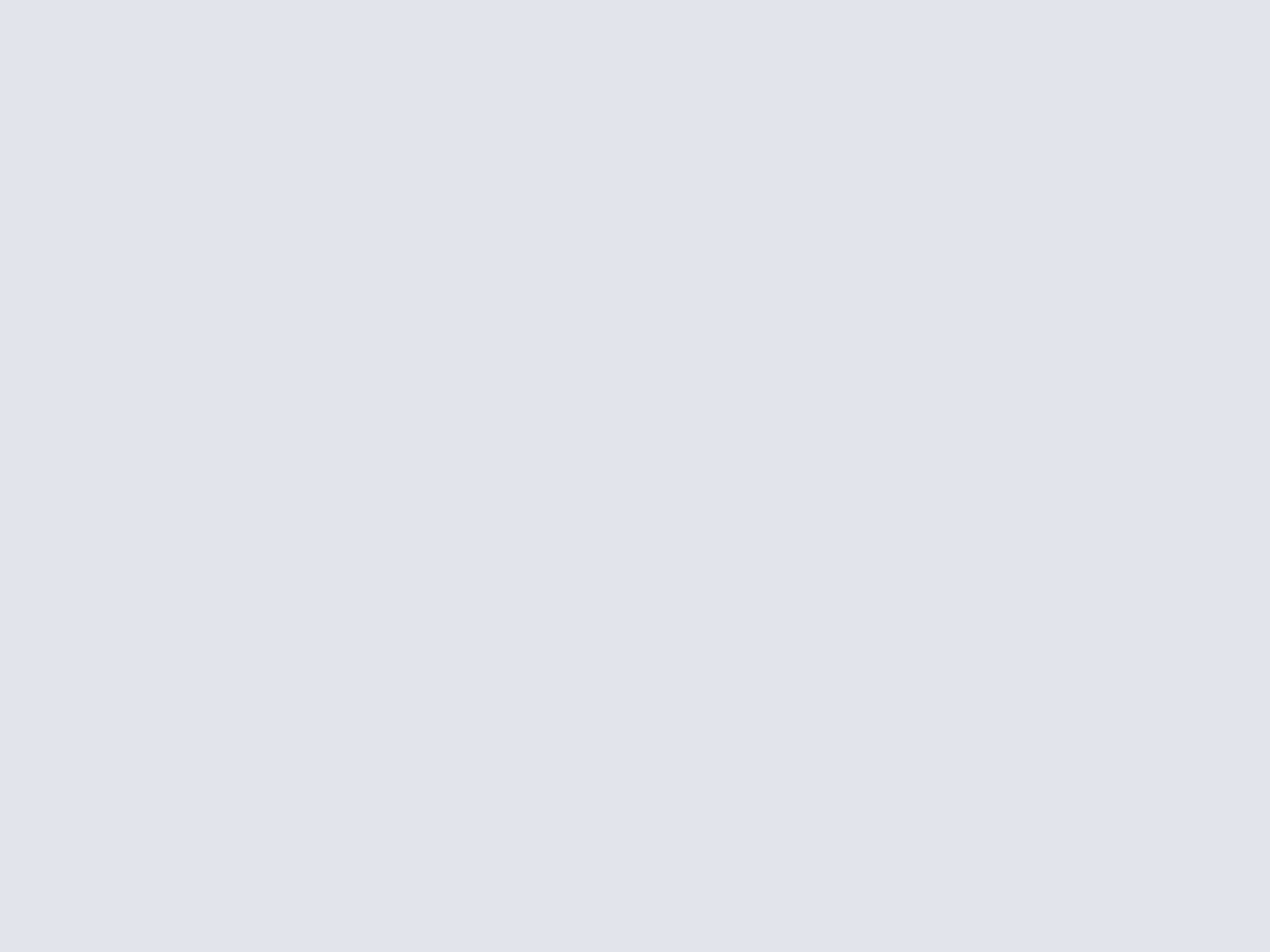

Détail d'une unité de calcul

Avec le GeForce 8, NVIDIA a introduit pour la première fois des unités scalaires qui travaillent chacune, et de manière indépendante, sur une instruction pour chacune des quatre composantes d'un pixel. De son côté, AMD a retenu une solution bien différente avec son R600, puisque chaque unité de calcul peut sur le papier traiter jusqu'à cinq instructions. Seulement voilà, les unités d'AMD ne sont pas franchement indépendantes les unes des autres alors que l'agencement même des processeurs de flux en leur sein fait qu'un seul processeur sur les cinq est capable d'effectuer certaines opérations arithmétiques plus complexes. Bref, si AMD peut se targuer d'avoir un plus grand nombre d'unités que son rival NVIDIA, leur souplesse est nettement moindre. D'autant que NVIDIA dispose d'une arme redoutable dans son arsenal avec la fréquence de fonctionnement de ses processeurs scalaires. Ceux-ci opèrent en effet à une fréquence supérieure au reste de la puce, ce qui permet d'augmenter considérablement le rendement et l'efficacité de l'architecture GeForce 8 en général.

AMD Radeon HD 2600 et 2400 : les détails de l'architecture

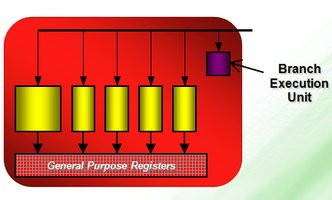

Si les nouvelles Radeon HD héritent de l'architecture du R600, quelques différences subsistent fort logiquement. Le premier changement de taille concerne le nombre de Processeurs de flux qui a été ramené à 120 pour le Radeon HD 2600 et à seulement 40 pour le Radeon HD 2400. Ils sont agencés sur le Radeon HD 2600 selon trois blocs SIMD de 40 processeurs chacun alors que le Radeon HD 2400 dispose de deux blocs SIMD de 20 processeurs chacun. Rappelons, que le Radeon HD 2900 est de son côté muni de 320 processeurs de flux dans son édition XT. Autre différence, le Radeon HD 2600 ne compte plus que deux unités de texture (contre quatre pour le Radeon HD 2900) soit 8 unités en charge du filtrage sur le Radeon HD 2600. Si ce dernier conserve les caches de texture de niveau 1 et 2 présents sur le R600, le Radeon HD 2400 en est dépourvu et doit faire avec une seule unité de texture soit 4 unités en charge du filtrage. Filtrage qui, au passage, a été amélioré par rapport à celui des Radeon X1xxx sans toutefois atteindre le niveau de qualité des dernières GeForce 8.

Gros plan sur l'architecture des Radeon HD 2600 et HD 2400

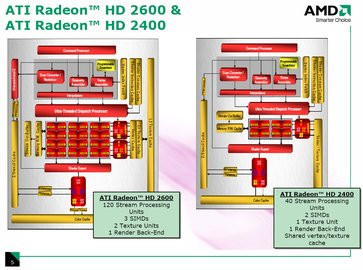

Du côté des ROP, du nom de ces unités en bout de puce chargées des dernières opérations sur les pixels (comme le mélange des couleurs ou l'anticrénelage), AMD a fait le choix, à l'image des pipelines qui étaient très souvent groupés en quad, de regrouper quatre unités ROP dans une seule grosse unité baptisée Render Back End. Radeon HD 2400 et 2600 n'en comptent ici qu'une seule, soit quatre ROP quand les GeForce 8600 disposent de huit ROP. Puisqu'il est question de ROP, signalons que les fonctions d'anticrénelage des puces de la série Radeon HD 2000 se sont enrichies avec l'arrivée du CFAA ou Custom Filtering Anti-aliasing. Ce nouveau procédé consiste à offrir plus de flexibilité que les filtres classiques à matrice fixe, puisque deux nouveaux filtres s'ajoutent avec le filtre narrow-tent ou le filtre wide-tent. Utilisant plus de pixels pour le mélange, ces filtres programmables sont censés donner de meilleurs résultats au niveau du lissage des bords. Les deux Radeon HD 2400 et HD 2600 proposent le mode CFAA, avec pour la HD 2600 un mode 24x contre 12x maximum pour la Radeon HD 2400.

Principe du CFAA

Continuons notre tour d'horizon de l'architecture des Radeon HD milieu et entrée de gamme en précisant que les deux puces proposent l'unité de tesselation programmable introduite par le R600 et déjà utilisée par le Xenos. Rappelons qu'il s'agit de multiplier les formes géométriques depuis une figure simple en appliquant à chaque polygone une sub-division récursive. Concrètement, l'unité de tesselation permet d'augmenter les détails géométriques à moindre frais et sans impact sur les performances. Hélas, aucun jeu PC n'en tire encore parti et tant que DirectX n'imposera pas la présence d'une unité de tesselation il y a fort à parier que les développeurs ne l'utiliseront pas.

La tesselation : partir de figures simples pour arriver à une forme complexe

Côté mémoire, les Radeon HD 2600 et HD 2400 se contentent d'un contrôleur classique interfacé sur 128 bits pour la 2600 et sur 64 bits pour la 2400. Chez la concurrence, le GeForce 8600 GT doit lui aussi faire avec un bus mémoire 128 bits. En revanche, là où NVIDIA ne propose que de la mémoire GDDR3, AMD a fait en sorte que son Radeon HD 2600 soit également à même de fonctionner avec de la GDDR4, tout en le rendant compatible avec la DDR2 et la GDDR3. C'est ainsi que l'édition XT du Radeon HD 2600 est accompagnée de mémoire GDDR4, un choix qui permet, grâce à des fréquences de fonctionnement supérieures, d'offrir une bande passante mémoire plus large. A cela s'ajoute, en ce qui concerne la Radeon HD 2400, la prise en charge de la technologie HyperMemory qui permettra à la puce d'utiliser la mémoire du système pour y stocker des textures et autres résultats de calcul au cas où la mémoire embarquée serait saturée.

HDCP, HDMI et moteur UVD : en avant la vidéo

Très ressemblant au moteur PureVideo de seconde génération introduit par NVIDIA sur ses GeForce 8600, l'UVD a pour lui quelques subtiles différences. Non content de prendre en charge le décodage de l'algorithme CABAC utilisé par les films en H.264, comme chez NVIDIA, AMD gère également le décodage entropique utilisé par le format VC1 employé sur les HD DVD. AMD indique que son UVD peut effectuer le décodage de films haute définition dont le débit atteint les 40 Mbps. Au-delà de l'assistance au décodage, qui devrait résulter en une utilisation processeur moindre lors de la lecture de films HD, AMD complète son moteur UVD avec les effets de post-processing AVIVO HD qui touchent à la gestion du désentrelacement ou encore à la mise à l'échelle des flux vidéo.

Autre nouveauté concernant la vidéo, les puces graphiques HD 2400 et HD 2600 intègrent les clés HDCP. Inutile donc pour le fabricant de carte graphique d'ajouter une puce CryptoROM, les dernières Radeon gérant nativement le protocole HDCP. Chez NVIDIA, la prise en charge du HDCP n'est toujours pas native ce qui fait que certaines cartes GeForce 8 sont dépourvues de la précieuse puce CryptoROM, les rendant incompatible avec le HDCP. Qui plus est, les Radeon HD supportent le HDCP sur les sorties Dual-Link DVI, sorties utilisées pour les écrans 30 pouces notamment, un raffinement que l'on retrouve depuis peu chez NVIDIA, mais pas sur le haut de gamme !

Enfin, les Radeon HD intègrent nativement la gestion de l'interface HDMI avec en prime un contrôleur audio. Oui, les dernières puces graphiques AMD disposent d'un contrôleur audio 5.1 natif qui permet de transmettre non seulement la vidéo mais également l'audio via la sortie HDMI, et ce sans nécessiter de câblage compliqué pour récupérer le son décodé par la puce audio de la carte mère (ou de la carte son) avant de l'injecter dans la sortie HDMI. C'est plutôt bien vu mais hélas AMD se borne aux spécifications 1.2 de la norme HDMI, fermant de fait la porte aux formats audio avancés comme le Dolby TrueHD ou le Lossless pourtant utilisés par les HD-DVD et autres Blu-ray... On devra donc se contenter du Dolby Digital et du DTS 5.1. Par ailleurs aucune carte de la série Radeon HD 2000 n'est dotée d'un connecteur HDMI physique. AMD a en effet mis au point un adaptateur DVI/HDMI propriétaire capable de transmettre le flux audio, mais hélas celui-ci ne sera livré qu'avec les cartes XT, les modèles Pro en étant dépourvus.

Carte Radeon HD 2400 XT avec adaptateur DVI/HDMI

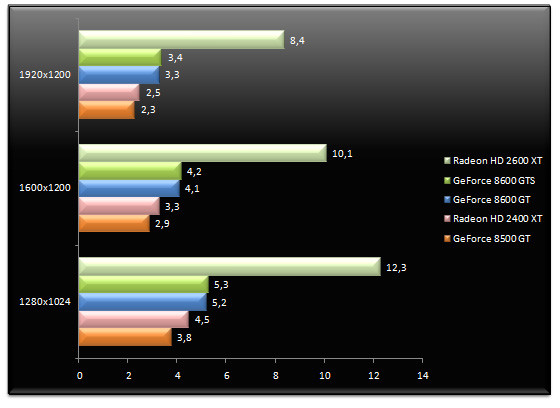

UVD et performances en H.264 et VC-1

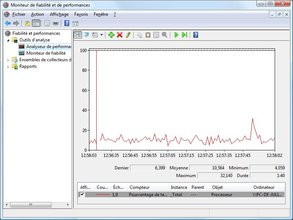

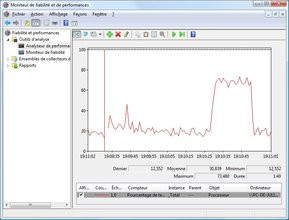

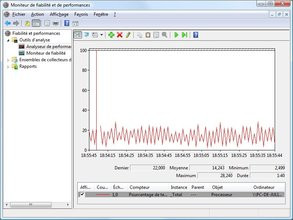

Les Radeon HD 2400 et HD 2600 disposant nativement du nouveau moteur UVD, nous avons cherché à mesurer l'efficacité de ce dernier. Pour cela nous recourons à notre Lecteur Hd-Dvd externe mais également à la version 7.3 de PowerDVD Ultra. Nous vérifierons ici l'occupation processeur lors de la lecture des flux H.264 mais également avec les flux VC-1. On commence avec le H.264 en utilisant le HD-DVD Babel encodé à ce format. Notre test consiste à relever l'occupation processeur lors du décodage de la même scène et ce via l'outil de performances intégré à Windows Vista dont voici les résultats :

A gauche, l'occupation processeur avec le GeForce 8600 GTS, à droite la même chose avec le Radeon HD 2600 XT

Comme on peut le voir, le Radeon HD 2600 XT est plus efficace que le GeForce 8600 GTS pour soulager le processeur central lors du décodage H.264. Alors que l'occupation moyenne est de 10,5% avec PureVideo, cette dernière tombe à 8,4% avec l'UVD d'AMD. Un très bon point ! Voyons maintenant ce qui se passe avec le VC-1 en employant le HD-DVD Le Dernier Samurai :

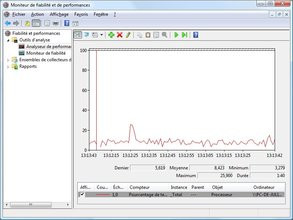

A gauche, l'occupation processeur VC-1 avec le GeForce 8600 GTS puis avec le Radeon HD 2600 XT

Sans grande surprise l'occupation processeur avec le GeForce 8600 GTS tourne autour des 30% alors qu'elle n'est que de 14% avec l'UVD du Radeon HD 2600 XT. Cette différence s'explique par le fait que le moteur PureVideo assiste matériellement le processeur uniquement avec les flux H.264, le VC-1 passant à la trappe.

AMD Radeon HD 2600 & 2400 : les puces

Les puces Radeon HD 2600 et HD 2400 sont les toutes premières puces graphiques AMD à profiter d'une finesse de gravure en 65nm selon le procédé mis au point par le taïwanais TSMC. Répondant au nom de code RV630, le Radeon HD 2600 compte un peu plus de 390 millions de transistors, soit nettement plus son concurrent le GeForce 8600 GTS qui en compte un peu moins de 300 millions. De son côté, le Radeon HD 2400, nom de code RV610, se contente de 180 millions de transistors. Comme nous l'indiquions un peu plus haut, alors que le Radeon HD 2600 dispose d'une interface mémoire 128 bits, le Radeon HD 2400 doit lui se contenter d'une interface mémoire sur 64 bits.En matière de fréquence de fonctionnement, le Radeon HD 2600 XT voit sa puce graphique cadencée à 800 MHz alors que la mémoire opère à 800 MHz s'il s'agit de GDDR3 ou à 1100 MHz s'il est question de GDDR4. De fait, la bande passante mémoire d'une Radeon HD 2600 XT en GDDR3 sera de 26 Go/s contre 35 Go/s pour la même carte en GDDR4. Concernant le Radeon HD 2400 XT, AMD recommande une fréquence de 700 MHz pour la puce graphique et de 800 MHz pour la mémoire. Interface 64 bits oblige, la bande passante est ici plus que réduite avec seulement 13 Go/s.

Puce AMD RV630 (Radeon HD 2600 XT)

Pour le reste, les deux puces intègrent dorénavant l'électronique CrossFire, le fameux compositing engine qui était autrefois un composant externe faisant maintenant parti intégrante des puces. Radeon HD 2400 XT et Radeon HD 2600 XT peuvent donc être utilisées en CrossFire, sur les Cartes mères compatibles, en ajoutant simplement le dongle interne souple généralement livré avec les cartes. En ce qui concerne les sorties vidéos, et outre l'aspect HDMI/HDCP déjà évoqué plus haut, les puces disposent d'un double RAMDAC à 400 MHz et d'un double encodeur DVI. Alors que le Radeon HD 2600 XT dispose de deux sorties DVI en Dual-Link, le Radeon HD 2400 XT se contente d'une seule sortie Dual-Link, du reste parfaitement opérationnelle avec notre écran 30 pouces .

| GeForce 8500 GT | GeForce 8600 GT | GeForce 8600 GTS | Radeon HD 2400 XT | Radeon HD 2600 XT | |

| Interface | PCI-Express 16x | PCI-Express 16x | PCI-Express 16x | PCI-Express 16x | PCI-Express 16x |

| Gravure | 0,08µ | 0,08µ | 0,08µ | 0,065µ | 0,065µ |

| Transistors | 289 Millions | 289 Millions | 289 Millions | 180 Millions | 390 Millions |

| RAMDAC | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz | 2x 400 MHz |

| T&L | DirectX 10 | DirectX 10 | DirectX 10 | DirectX 10 | DirectX 10 |

| Stream Processors | 16 | 32 | 32 | 8 vec5 | 24 vec5 |

| Unités ROP | 8 | 8 | 8 | 4 | 4 |

| Mémoire embarquée | 256 Mo | 256 Mo | 256 Mo | 256 Mo | 256 Mo |

| Interface mémoire | 128 Bits | 128 Bits | 128 Bits | 64 Bits | 128 Bits |

| Bande passante | 12,8 Go/s | 22,4 Go/s | 32 Go/s | 13 Go/s | 26 Go/s (GDDR3) 35 Go/s (GDDR4) |

| Fréquence GPU | 450 MHz | 540 MHz | 675 MHz | 700 MHz | 800 MHz |

| Fréquence Stream Processors | 900 MHz | 1190 MHz | 1450 MHz | 700 MHz | 800 MHz |

| Fréquence mémoire | 400 MHz | 700 MHz | 1000 MHz | 800 MHz | 800 MHz (GDDR3) 1100 MHz (GDDR4) |

Côté consommation électrique, nous avons relevé la consommation maximale de notre système, consommation observée lors du test Deep Freeze de 3DMark 06 en 2560x2600. Comme indiqué dans le tableau ci-dessous, le Radeon HD 2600 XT consomme plus que le Radeon X1650 XT. Pire, la dernière puce d'AMD se paye le luxe d'afficher une consommation supérieure à celle observée avec le GeForce 8600 GTS alors même que ce dernier exige une alimentation additionnelle, ce qui n'est pas le cas du Radeon HD 2600 XT.

| Consommation électrique globale du système | |

| GeForce 8600 GTS | 180 Watts |

| Radeon X1650 XT | 179 Watts |

| Radeon HD 2600 XT | 189 Watts |

AMD Radeon HD 2600 XT : la carte

La première chose qui surprend avec la version GDDR4 du Radeon HD 2600 XT c'est bien entendu la longueur de la carte ! AMD propose en effet une carte de 23 centimètres de long, chiffre que l'on rapprochera des 18 centimètres de la GeForce 8600 GTS. Heureusement simple slot, la carte ne nécessite aucun adaptateur électrique externe, le bus PCI-Express 16x suffisant à l'alimenter ce qui n'est pas le cas du GeForce 8600 GTS. AMD dote son dernier bébé d'un système de refroidissement assez proche de celui qui équipe les Radeon X1950 Pro. Il est constitué d'un radiateur en cuivre reposant sur la puce graphique et enchâssé dans un support en aluminium lui-même recouvert d'une coque de plastique rouge translucide dont l'extrémité est pourvue d'un ventilateur. Des pads thermiques sont présents entre les puces mémoires et le radiateur alors que l'étage d'alimentation profite également d'un refroidissement par le biais du radiateur. Une fois démonté, le radiateur laisse apparaître la révision de la puce Radeon HD 2600 XT, révision A15...

Carte graphique AMD Radeon HD 2600 XT

Embarquant 256 Mo de mémoire vidéo, la carte utilise des puces Samsung de GDDR4 certifiées à 0,9ns. Côté fréquences, la carte opère à 800 MHz pour la puce graphique et 1100 MHz pour la mémoire alors que la fonction OverDrive des pilotes CATALYST est ici accessible. Le Radeon HD 2600 XT se dote également des nouveaux connecteurs CrossFire et on retrouve en sortie deux connecteurs DVI et une sortie vidéo analogique de type mini-DIN.

AMD Radeon HD 2400 XT : la carte

Entrée de gamme oblige, la carte de référence AMD à base de Radeon HD 2400 XT est beaucoup plus modeste que le Radeon HD 2600 XT. Bien plus courte, la carte se présente au format PCI-Express 16x et ne nécessite là encore pas d'alimentation électrique. En forme de L, avec un morceau de PCB curieusement manquant, la carte adopte un système de refroidissement on ne peut plus modeste consistant en un simple radiateur métallique avec ventilateur en son centre.

Carte graphique AMD Radeon HD 2400 XT

Ce dernier, de par sa petite taille, est du reste assez bruyant. Munie de 256 Mo de mémoire vidéo DDR2, la carte utilise des puces Hynix certifiées à 1,1 ns. En matière de fréquences de fonctionnement, la carte respecte les données constructeur avec 700 MHz pour la puce graphique et 800 MHz pour la mémoire. Dotée de deux connecteurs CrossFire, la carte offre en sortie une prise DVI, un connecteur VGA DB15 et une sortie vidéo en mini-DIN.

- Carte mère Asus P5B Deluxe,

- Processeur Intel Core 2 Duo X6800,

- 2x1 Go Corsair Twin2X 6400C4 DDR2-800,

- Disque dur Western Digital Raptor 150

Côté pilotes, les choses sont assez compliquées puisque nous utilisons les CATALYST 7.5 pour toutes les cartes Radeon sauf les HD 2400 XT et HD 2600 XT avec lesquelles nous employons la version 7.6 Beta des mêmes pilotes CATALYST. Du côté de NVIDIA nous utilisons les ForceWare 158.24 pour les puces GeForce de génération DirectX 9.0 alors que nous avons recours aux ForceWare 158.45 pour les puces GeForce DirectX 10.

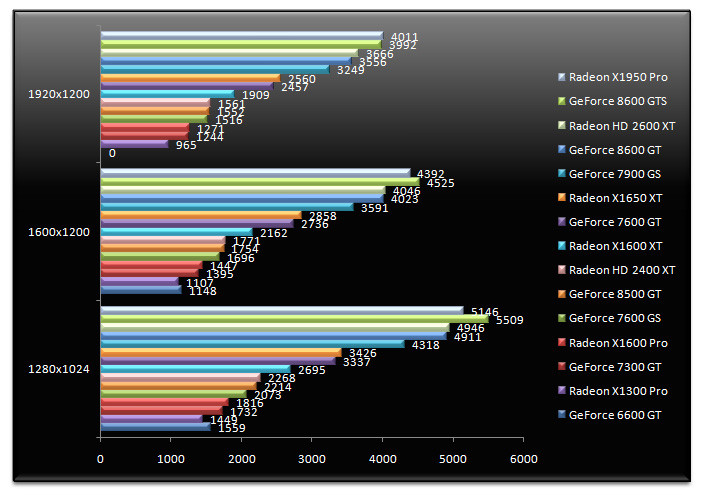

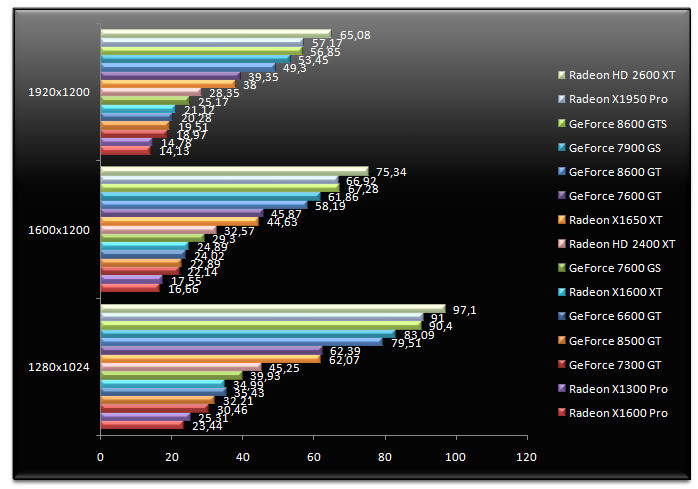

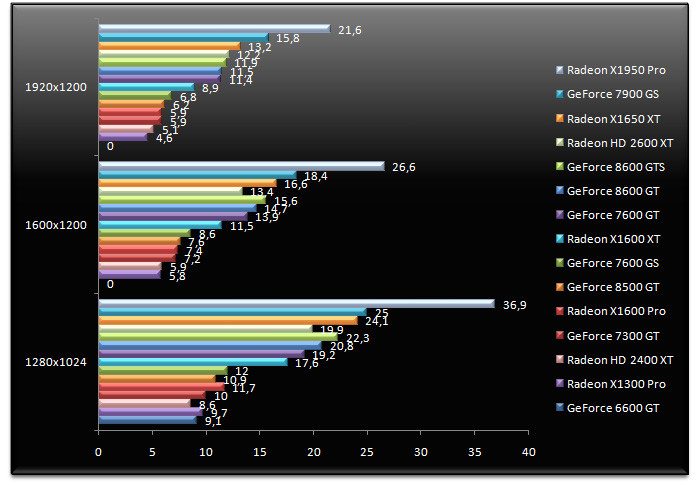

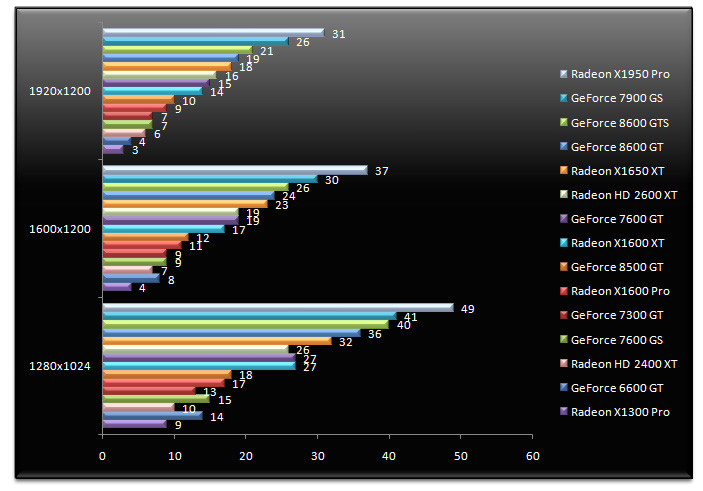

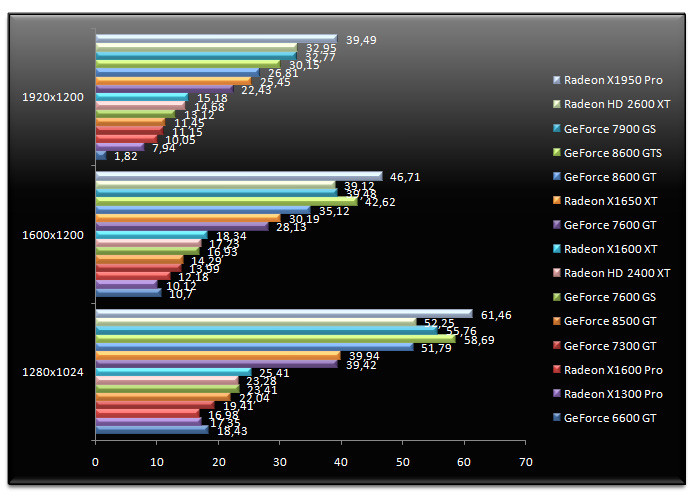

3DMark 06 - v1.1.0

Démarrons avec 3DMark 06, outil de bench synthétique par excellence. En tête, on retrouve les Radeon X1950 Pro et GeForce 8600 GTS sans grande surprise. Le Radeon HD 2600 XT réussit ici à s'intercaler entre le GeForce 8600 GT et le GeForce 8600 GTS. En 1920x1200 le Radeon HD 2600 XT se montre 3% plus rapide que le GeForce 8600 GT alors qu'il surpasse son prédécesseur le Radeon X1650 XT de 43%. Ces bons chiffres ne permettent hélas pas à la dernière puce d'AMD de devancer le GeForce 8600 GTS. De son côté, le Radeon HD 2400 XT fait mieux que ses prédécesseurs tout en étant plus rapide que le Radeon X1600 Pro. La nouvelle puce entrée de gamme d'AMD s'affiche ici plus performante que les GeForce 7300 GT et 7600 GS. Toutefois son avantage face au GeForce 7600 GS est très réduit alors qu'elle est à égalité avec le GeForce 8500 GT.

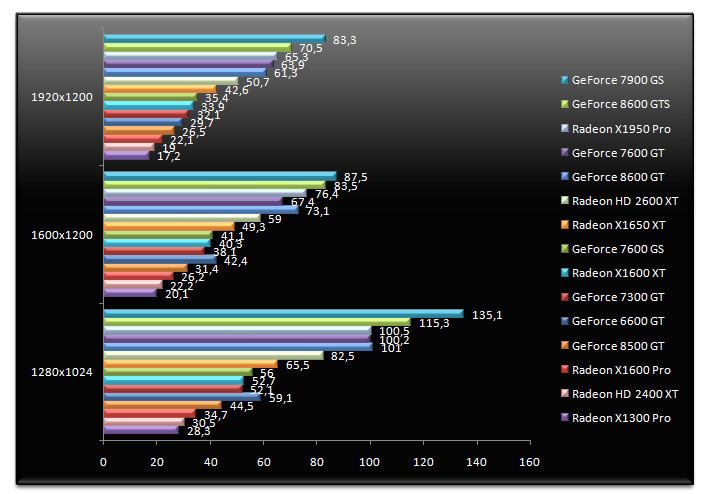

Doom 3 - v1.3

Jeu OpenGL emblématique, Doom 3 profite logiquement aux puces NVIDIA dont les divers réprésentants sont largement en tête. Notre Radeon HD 2600 XT est ici incapable de lutter face aux GeForce 8600 GT ou GTS, alors que son avantage sur le Radeon X1650 XT passe de 43% sous 3DMark 06 à 19% en 1920x1200... Mais face au Radeon X1600 XT, le petit HD 2600 XT est 49% plus performant toujours en 1920x1200. Le Radeon HD 2400 XT se fait ici massacrer, il n'y a pas d'autre mot, puisque la puce termine avant dernière. Face au Radeon X1300 Pro, le Radeon HD 2400 XT est 7% plus rapide.

Far Cry v1.4

FarCry, ici testé sans effet HDR la version finale du patch 1.4 étant incompatible avec ce type de rendu sous Windows Vista, donne le Radeon X1950 Pro grand gagnant devant les GeForce 7900 GS et 8600 GTS. Le Radeon HD 2600 XT termine ici en net retrait face à son prédécesseur, le Radeon X1650 XT, ce dernier étant 24% plus rapide en 1600x1200. Fort de ce médiocre résultat, le GeForce 8600 GT passant même devant le Radeon HD 2600 XT, c'est logiquement qu'on retrouve notre Radeon HD 2400 XT sur l'avant dernière marche du podium. 10% plus rapide que le Radeon X1300 Pro, le Radeon HD 2400 XT n'est pas capable de concurrencer le GeForce 8500 GT ni même le GeForce 7300 GT, et ce, même dans les résolutions les plus faibles.

F.E.A.R. - v1.08

F.E.A.R. donne le Radeon X1950 Pro grand vainqueur de ce test à égalité avec le GeForce 8600 GTS. Face à ces deux leaders, le Radeon HD 2600 XT est à la traîne puisque moins rapide que le GeForce 8600 GT ! Comparé au Radeon X1650 XT, le Radeon HD 2600 XT est 27% plus performant. De son côté, le Radeon HD 2400 XT parvient à supplanter les Radeon X1300 et X1600 Pro ainsi que le GeForce 6600 GT. En revanche, le GeForce 8500 GT est très légèrement supérieur en terme de performances si l'on considère la résolution de 1280x1024.

Splinter Cell Chaos Theory v1.05

L'ami Sam Fisher donne le Radeon X1950 Pro grand vainqueur avec un confortable avantage sur le GeForce 8600 GTS dont les performances sont presque identiques au GeForce 7900 GS. De son côté, le Radeon HD 2600 XT s'intercale entre nos deux GeForce 8600. 7% plus rapide que le GeForce 8600 GT, il est 6% plus lent que le GeForce 8600 GTS. En ce qui concerne les cartes entrée de gamme, le Radeon HD 2400 XT fait ici mieux que les GeForce 7300 GT et GeForce 8500 GT sans toutefois égaler le GeForce 7600 GS. Comparé au Radeon X1300 Pro, le Radeon HD 2400 XT est 27% plus véloce en 1280x1024. Face au GeForce 8500 GT, cet avantage tombe à 10%.

Half-Life 2 Lost Coast

Half-Life 2 est l'occasion d'une belle surprise puisque le Radeon HD 2600 XT s'adjuge contre toute attente la première place devant le Radeon X1950 Pro et le GeForce 8600 GTS. Fort de cette très bonne prestation, qui propulse le Radeon HD 2600 XT 14% devant le GeForce 8600 GTS, le Radeon HD 2400 XT affiche lui aussi d'excellents résultats. La puce entrée de gamme devance ici le GeForce 8500 GT de 42% alors qu'elle surpasse les Radeon X1300 Pro, GeForce 7300 GT et même le Radeon X1600 XT ! Ce brusque écart semble assez logique, AMD indiquant que les Radeon HD 2000 profitent de gains de performances sous Half-Life 2 avec ses pilotes 7.6.

Call Of Duty 2 - v1.3

Call Of Duty 2 malmène ici nos nouvelles puces AMD. Alors que le Radeon X1950 Pro pulvérise les sommets, le Radeon HD 2600 XT est à égalité avec le GeForce 8600 GT alors qu'il ne parvient pas à égaler son prédécesseur, le Radeon X1650 XT ! Le Radeon X1650 XT est, en 1920x1200, 9% plus rapide que la nouvelle puce d'AMD... Au vu des piètres prestations du HD 2600 XT sous ce jeu, nous ne serons pas surpris de voir le HD 2400 XT se comporter aussi mal. La puce est ici aussi performante que le Radeon X1300 Pro alors qu'elle ne parvient pas à inquiéter le GeForce 8500 GT, 3% plus rapide en 1280x1024.

Supreme Commander

Sous Supreme Commander, le RTS à la mode en ce moment, le Radeon X1950 Pro tire son épingle du jeu tout comme le Radeon HD 2600 XT qui termine ici second devant le GeForce 8600 GTS. Une fois de plus les Radeon HD montrent leur manque d'homogénéité en terme de performance, d'un test à l'autre leurs performances variant du tout au tout. Le Radeon HD 2400 XT termine donc devant les GeForce 7600 GS et 8500 GT alors qu'en 1280x1024, le Radeon HD 2400 XT est 63% plus rapide que le Radeon X1300 Pro.

STALKER v1.0001

Avec STALKER, le jeu de tir prenant pour cadre Tchernobyl, les GeForce 8600 paradent en tête, devant le GeForce 7900 GS et le Radeon X1950 Pro. Ici, le Radeon HD 2600 XT termine troisième, devant le Radeon X1950 Pro, mais derrière les GeForce 8600 GT et GeForce 8600 GTS. En 1600x1200, le GeForce 8600 GT est 25% plus rapide que le Radeon HD 2600 XT. Face au Radeon X1650 XT, le Radeon HD 2600 XT se révèle 44% plus rapide. Quant au Radeon HD 2400 XT il se situe ici à égalité avec le Radeon X1650 XT alors qu'il devance de 4% le GeForce 8500 GT en 1280x1024. Sous ce jeu le Radeon HD 2400 confirme un avantage certain sur le Radeon X1300 Pro.

Tests DirectX 10

Avertissement : Les tests de performances DirectX 10 ont été effectués sur les cartes NVIDIA avec les pilotes ForceWare 158.45. Malheureusement pour NVIDIA, ces pilotes ne sont pas optimisés pour DirectX 10 et les GeForce 8600 et 8500, la firme au caméléon indiquant que les pilotes 158.45 ont été avant tout optimisés pour les GeForce 8800 sous DirectX 10. Malheureusement, les pilotes 162.15 sont arrivés trop tard pour nous permettre d'exécuter les tests DirectX 10 avec ceux-ci ce qui explique probablement les piètres prestations des GeForce 8600 et 8500 dans les tests qui suivent.

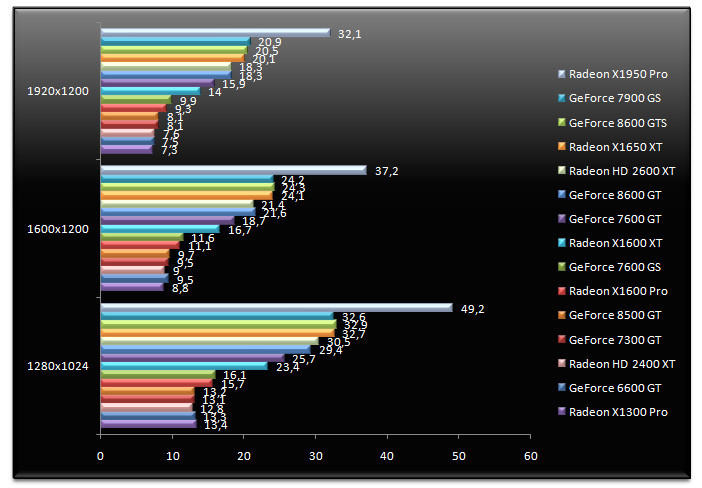

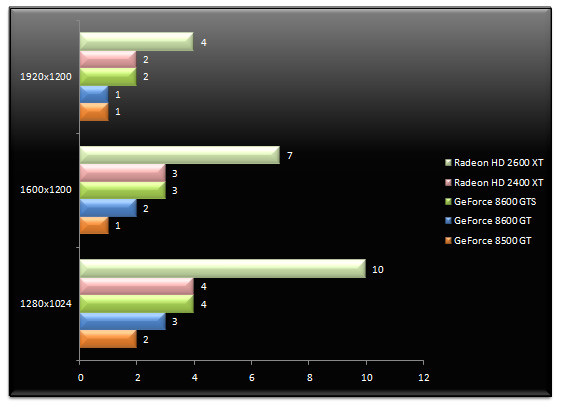

Company Of Heroes - v1.70 - DirectX 10

Puisque nos nouvelles cartes sont DirectX 10, nous utilisons ici les tous premiers tests DirectX 10. Company Of Heroes place le Radeon HD 2600 XT en tête alors que les GeForce 8600 GTS et 8600 GT sont assez nettement en retrait avec des performances deux fois moindres. De son côté, le Radeon HD 2400 XT devance le GeForce 8500 GT, mais d'une moindre mesure. L'avance du Radeon HD 2600 XT sur les GeForce 8600 peut surprendre et NVIDIA indique que ses pilotes 158.45 ne sont pas encore optimisés pour la prise en charge de DirectX 10 sur les GeForce 8600. Il faudra donc vérifier ce point à l'avenir. Mais dans tous les cas, que l'on considère le Radeon HD 2600 ou le GeForce 8600, les performances sont insuffisantes pour jouer convenablement en DirectX 10.

Lost Planet Extreme Condition - DirectX 10

La démo de Lost Planet donne les mêmes résultats que Company Of Heroes. Le Radeon HD 2600 XT est dominateur alors que le Radeon HD 2400 XT parvient à égaler le GeForce 8600 GTS. Bref les GeForce 8 milieu et entrée de gamme ne semblent pas encore à l'aise en DirectX 10. Mais là encore, qu'il s'agisse de 4 ou de 10 FPS, le jeu est tout simplement inutilisable dans sa version DirectX 10.

Call Of Juarez - DirectX 10

On termine cette seconde page avec Call Of Juarez dont la version finale a récemment été publiée. Controversé et sujet à polémique, le test DirectX 10 n'est guère plus flatteur pour NVIDIA, les deux Radeon HD supplantant les puces de la firme au caméléon. Là encore le nombre d'images à la seconde est par trop insuffisant pour jouer convenablement quelque soit la carte en DirectX 10.

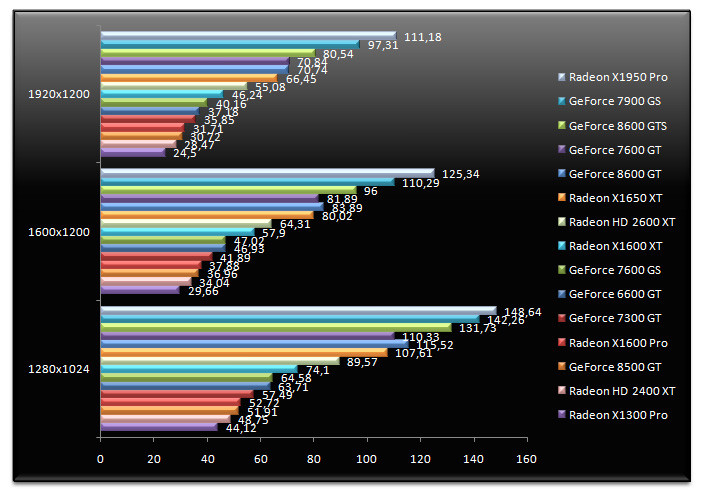

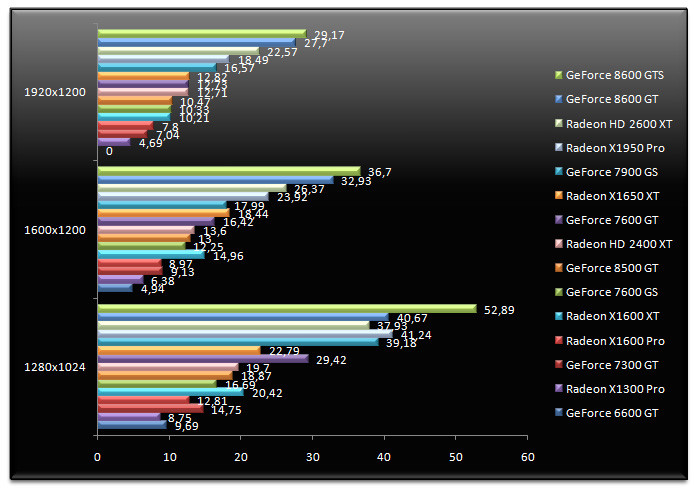

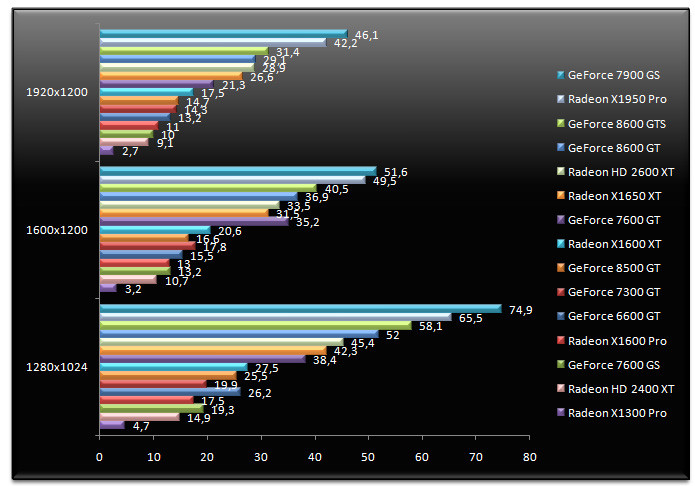

Call Of Duty 2 - v1.3 - AA 4x & AF

Pour démarrer cette troisième page de tests, nous jetons notre dévolu sur Call Of Duty 2. Cette fois-ci nous activons les fonctions de filtrage. En tête figure le Radeon X1950 Pro suivi du GeForce 7900 GS. Alors que les GeForce 8600 font mieux que le Radeon HD 2600 XT en 1280x1024 et en 1600x1200, celui-ci reprend l'avantage en 1920x1200, d'une courte tête il est vrai. Mais face à son prédécesseur, en l'occurrence le Radeon X1650 XT, le Radeon HD 2600 XT ne peut hélas rien. Pour sa part, le Radeon HD 2400 XT signe une prestation équivalente, sans plus, au Radeon X1300 Pro alors que le GeForce 8500 GT se montre nettement plus rapide : 26% de plus en 1280x1024.

Doom 3 - v1.3 - AA 4x

Sous Doom 3, l'activation des fonctions de filtrage est particulièrement pénalisante pour les puces les moins puissantes et si le Radeon X1300 Pro est bon dernier, le Radeon HD 2400 XT est lui sensiblement plus performant sans toutefois égaler un GeForce 8500 GT beaucoup plus rapide. Le Radeon HD 2600 XT fait pour sa part mieux que le Radeon X1650 XT, mais cela est hélas insuffisant face à un GeForce 8600 GT 10% plus performant en 1600x1200. Quant au GeForce 8600 GTS il est plus rapide... de l'ordre de 21% toujours dans cette résolution.

F.E.A.R. v1.08 - AA 4x - AF16x

Même traitement sous F.E.A.R. où en plus d'activer l'AA 4x nous mettons en place le filtrage anisotropique 16x tout en désactivant la diffusion des ombres. Mauvaise nouvelle, le Radeon HD 2600 XT affiche ici des performances inférieures non seulement au GeForce 8600 GT, mais également au Radeon X1650 XT... Quant au Radeon HD 2400 XT il ne brille guère. Ses performances ont beau être pratiquement deux fois supérieures à celles du Radeon X1300 Pro, cela ne permet nullement d'approcher le GeForce 8500 GT.

Half Life 2 Lost Coast - AA4x - AF16x

On termine avec Half-Life 2 Lost Coast. A l'instar de ce que nous observions sans l'activation des effets de filtrage, les Radeon HD affichent ici un véritable sursaut d'orgueil. Le Radeon HD 2600 XT égale donc le GeForce 8600 GTS, battant de fait le Radeon X1650 XT et le GeForce 8600 GT. Mieux, le Radeon HD 2400 XT semble avoir décollé avec des performances supérieures de 5% au GeForce 8500 GT. Ici le Radeon HD 2400 XT égale pratiquement le Radeon X1600 XT ! La raison de cette montée des performances ? L'ajout d'optimisations dans les pilotes AMD Catalyst 7.6 pour Half-Life 2 lorsque rendu HDR et anticrénelage sont actifs, optimisations qui se montrent visiblement efficaces et son réservées aux seules Radeon HD.

Conclusion

Bien que nous nous félicitions de l'arrivée de ces nouvelles Radeon, il ne faut pas croire que tout est rose chez le géant vert AMD car ce n'est malheureusement pas le cas et sur le strict plan des performances, la firme de Sunnyvale nous refait le coup du Radeon HD 2900 XT, le Radeon HD 2600 XT dans sa version la plus évoluée n'étant pas capable de lutter contre le GeForce 8600 GTS. AMD expliquera alors bien volontiers que son Radeon HD 2600 XT est proposé à 149 euros TTC quand la concurrence est habituellement autour des 180 euros TTC (cf. le GeForce 8600 GTS), le positionnement prix n'excuse en rien les trops faibles performances du Radeon HD 2600 XT, des performances qui hormis quelques trop rares bonnes surprises, font tâche. Par la force des choses, le HD 2600 XT est donc positionné en face du GeForce 8600 GT, AMD ayant une fois encore failli à opposer une concurrence sérieuse à NVIDIA sur le terrain des performances, et ce alors même que le GeForce 8600 GTS était considéré comme un effort minimal de la part de NVIDIA, la firme au caméléon ne s'étant pas franchement foulée sur les caractéristiques de cette puce. Pire pour contrer le GeForce 8600 GTS, AMD prévoit de proposer une version Gemini du Radeon HD 2600 XT, avec deux puces graphiques sur la même carte...

Autre point noir, AMD axe la communication sur les Radeon HD 2400 XT et Radeon HD 2600 XT, cette dernière en version GDDR4, alors même que ces modèles risquent d'être les plus exotiques de la gamme. Plusieurs partenaires, dont Sapphire, nous ont confié que le Radeon HD 2600 XT dans son édition GDDR4 serait particulièrement peu diffusé. Et quand on se souvient de la différence de bande passante mémoire théorique qu'il existe entre le Radeon HD 2600 XT en GDDR3 et la même puce en GDDR4 (22 Go/s contre 35 Go/s), on réalise que les performances du Radeon HD 2600 XT GDDR3 risquent d'être sérieusement en retrait face au modèle GDDR4. Difficile donc d'être vraiment enthousiasmé par le Radeon HD 2600 XT d'autant que la carte est particulièrement volumineuse pour des performances parfois inférieures au Radeon X1650 XT et une consommation toujours importante.

Tout n'est pas totalement désespéré et si le Radeon HD 2600 XT ne convainc pas franchement, il offre l'avantage de ne pas nécessiter d'alimentation électrique supplémentaire contrairement au GeForce 8600 GTS alors qu'il sera décliné en version AGP, idée que NVIDIA a visiblement abandonné. Autre bon point, le moteur UVD d'AMD est nettement plus efficace que celui de NVIDIA, non seulement sur les flux VC1 mais également sur les flux H264 en déchargeant mieux le processeur central que ne le fait PureVideo 2. Qui plus est, AMD offre une prise en charge HDMI sur tous ces modèles XT, alors que la gestion du HDCP est systématique, des arguments absents chez NVIDIA. Bien sur on aurait aimé une prise en charge du HDMI 1.3 sur ces puces Radeon HD, mais cela sera pour une prochaine fois...

Quant au Radeon HD 2400 XT, son positionnement autour de la soixantaine d'euros paraît cohérent et si les performances sont loin de permettre de jouer convenablement, la carte profite d'un connecteur DVI Dual-Link mais aussi de la prise en charge HDCP en plus du moteur de décompression vidéo de nouvelle génération. AMD passe ici sous silence la présence de la technologie HyperMemory, alors que nous espérons que les partenaires du fondeur prendront le soin de changer le ventilateur de référence qui s'avère franchement bruyant. Bref, faute de révolutionner le genre et de pulvériser les performances, la nouvelle offre d'AMD devrait tirer son épingle du jeu grâce à des prix très attractifs mais aussi grâce à des fonctionnalités vidéos plus poussées que chez la concurrence.