L'informatique quantique promet de révolutionner les usages dans les prochaines années, en augmentant sensiblement la puissance de calcul des machines. Comment fonctionne cette technologie ? Où en est-on de son développement ? Combien de temps faut-il encore attendre avant d'en bénéficier ? Le CNRS propose un rappel sur l'histoire et les évolutions de ce domaine en plein essor.

À l'origine, l'informatique quantique était un concept imaginé par le physicien Richard Feynman, prix Nobel de physique en 1965. L'idée était de transposer les propriétés de la mécanique quantique au domaine de l'informatique. Un rêve qui pourrait se concrétiser prochainement avec la naissance de véritables ordinateurs quantiques.

L'informatique quantique, c'est quoi ? Comment ça marche ?

Si l'informatique traditionnelle s'appuie sur les bits, l'informatique quantique repose sur les bits... quantiques, ou qubits. A la différence de son collègue binaire, le qubit n'est pas cantonné aux seuls 0 et 1, puisqu'il est capable de prendre ces deux valeurs à un même instant. C'est ce qu'on appelle le principe de superposition des états.Mais ce n'est pas la seule particularité de ces drôles d'éléments. Car deux qubits peuvent également interagir, leurs états s'entremêlant et devenant interdépendants. On parle alors d'intrication.

Ces caractéristiques ne sont pas sans conséquence quant à la puissance de calcul d'une machine. En effet, contrairement à un ordinateur traditionnel qui doit procéder étape par étape, un ordinateur quantique peut accéder à une multitude de résultats d'un seul coup.

Pour avoir un aperçu des possibilités, prenons l'exemple de la décomposition d'un nombre en un produit de nombres premiers (utilisée notamment dans le chiffrement de données). Là où l'opération peut nécessiter des centaines d'années à une machine classique pour un nombre élevé, tandis qu'un ordinateur quantique pourrait n'y passer que quelques minutes.

Comment produire des qubits ?

Pour bénéficier des fabuleux atouts de l'informatique quantique, il faut donc disposer de qubits, et en grand nombre. Le problème, comme évoqué précédemment, c'est qu'à l'origine, il ne s'agissait que d'une théorie. Par conséquent, des chercheurs du monde entier ont multiplié les expériences pour trouver des candidats crédibles.Après de nombreux essais plus ou moins fructueux, deux systèmes semblent aujourd'hui se détacher. Le premier est constitué d'ions piégés, c'est-à-dire d'atomes privés d'un ou plusieurs électrons et « emprisonnés » sous vide grâce à des lasers. Ce dispositif affiche les meilleures performances quantiques obtenues jusqu'à présent. Mais il n'est pas sans inconvénient : les ions piégés sont lents à manipuler et les techniques employées sont difficiles à reproduire à grande échelle.

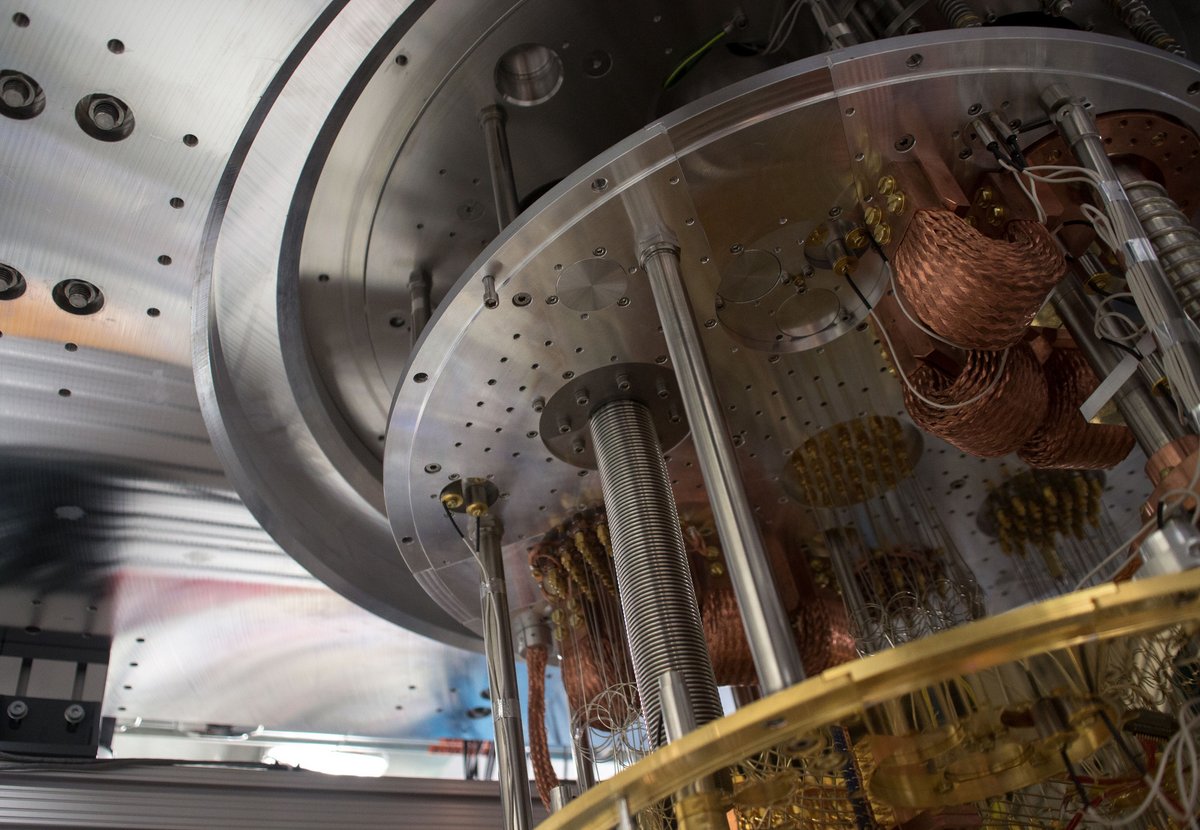

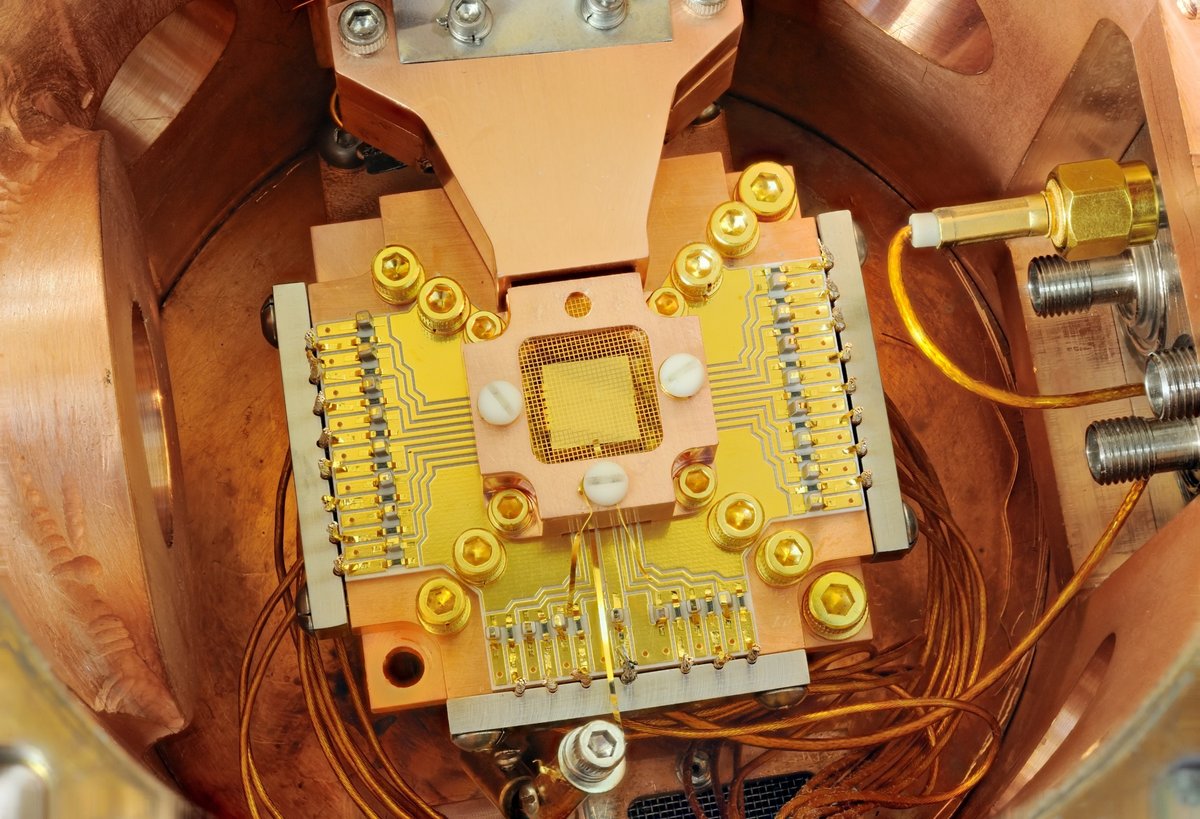

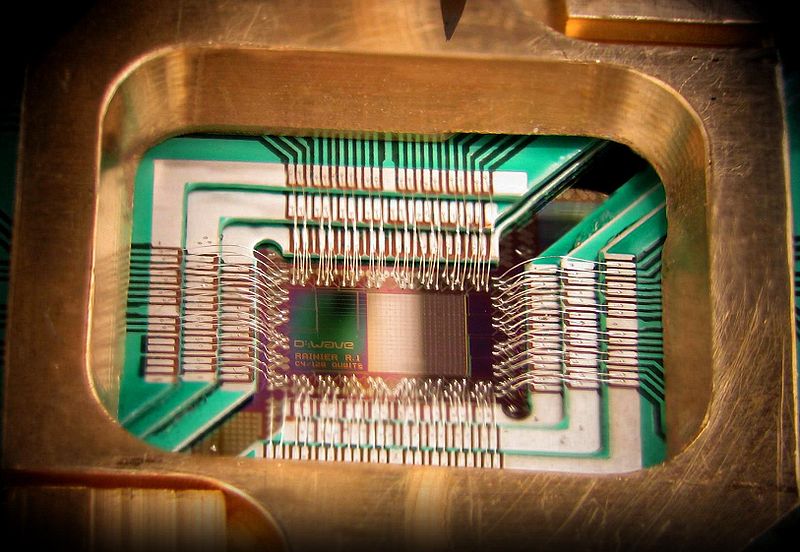

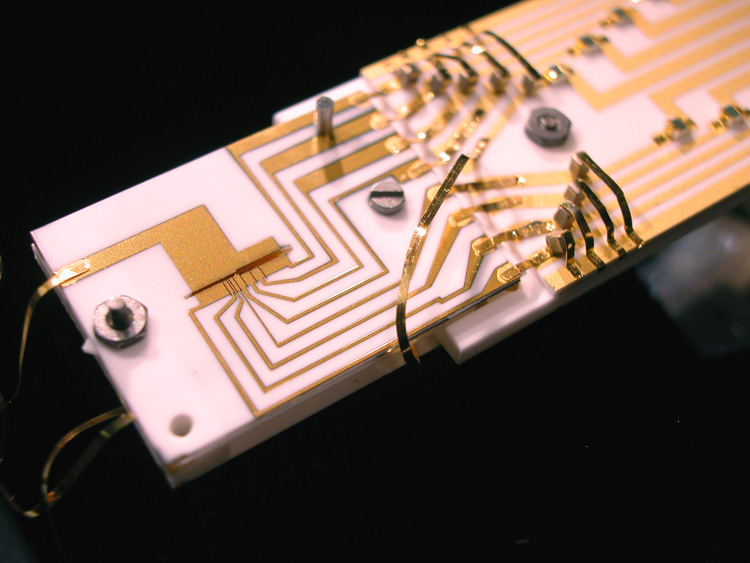

Autre solution : les circuits supraconducteurs, capables de conduire l'électricité sans résistance. Leur comportement se rapprochant d'atomes artificiels, des scientifiques ont réussi à manipuler leur état quantique. Et si leurs résultats sont moins bons que ceux des ions piégés, les circuits supraconducteurs présentent l'avantage d'être relativement faciles à fabriquer. Ce qui pousse certains acteurs majeurs, tels qu'IBM ou Google, à privilégier cette approche.

Néanmoins, une troisième solution a vu récemment le jour. Elle consiste à exploiter, dans une matrice de silicium, des « spins » d'électrons, c'est-à-dire les rotations des éléments sur eux-mêmes. Une technologie encore balbutiante, mais porteuse d'espoir pour de nombreux spécialistes.

Décohérence : le grain de sable dans la mécanique quantique

Il est pour l'heure impossible de prédire quelle approche tirera son épingle du jeu. Et chacune fait face à un problème inhérent à l'informatique quantique : la décohérence.Car un des problèmes du qubit réside dans sa « fragilité ». À cause de son environnement (température, champ magnétique...), un élément quantique a souvent tendance à perdre une partie de ses propriétés. C'est ce phénomène qu'on appelle « décohérence ». La durée de conservation des propriétés quantiques, quant à elle, porte le nom de « temps de cohérence ».

Et pour faire fonctionner un ordinateur quantique, il ne faut pas que cette durée soit inférieure au temps de calcul nécessaire. Il s'agit donc d'un enjeu majeur pour les industriels, qui doivent investir dans du matériel permettant de limiter la décohérence. Mais ces composants sont généralement très coûteux...

En parallèle, des chercheurs travaillent à la correction d'erreurs provoquées par ce phénomène. Leur idée : un algorithme capable de rectifier ces écarts plus rapidement qu'ils ne se forment. Mais cette théorie entraînerait un accroissement du nombre de qubits nécessaires.

Concrètement, où en est-on aujourd'hui ?

Aujourd'hui, le record du nombre de qubits intriqués s'établit à 20. De son côté, Google a annoncé, en 2018, avoir produit un processeur quantique composé de 72 qubits. Mais on ne sait pas combien d'entre eux ont véritablement passé le révélateur de l'intrication.Et à titre de comparaison, on estime généralement que, dans l'idéal, un ordinateur quantique devrait renfermer quelques milliers de qubits. On est donc encore loin du compte...

Par conséquent, la tendance actuelle consiste à revoir les prétentions à la baisse. En attendant de pouvoir disposer de machines parfaites, l'idée serait de produire des dispositifs intermédiaires possédant moins de qubits, afin de prouver la supériorité du calcul quantique sur l'informatique classique.

Ainsi, d'après des experts, des microcalculateurs quantiques dotés de 50 à 100 qubits pourraient voir le jour d'ici environ cinq ans.

Les futures applications de l'informatique quantique

Bien entendu, ces premières machines ne seront pas prioritairement destinées au grand public.L'informatique quantique pourrait servir à réaliser des simulations complexes dans le but, par exemple, de mettre au point de nouveaux matériaux ou de nouvelles molécules aux propriétés inédites.

Les nouvelles machines pourraient également être utiles dans des missions d'optimisation utiles pour le trafic routier, le transport de l'énergie ou les prédictions financières.

Enfin, les ordinateurs quantiques pourraient apporter des améliorations dans le domaine de l'intelligence artificielle, en particulier du machine learning. L'apprentissage automatique, via le traitement statistique d'énormes quantités de données gagnerait en effet à voir sa rapidité d'analyse démultipliée. Cela pourrait avoir de multiples applications, dont le perfectionnement des moteurs de recherche. C'est d'ailleurs l'une des raisons pour lesquelles Google s'intéresse autant à ce domaine...

Source : Le Journal CNRS