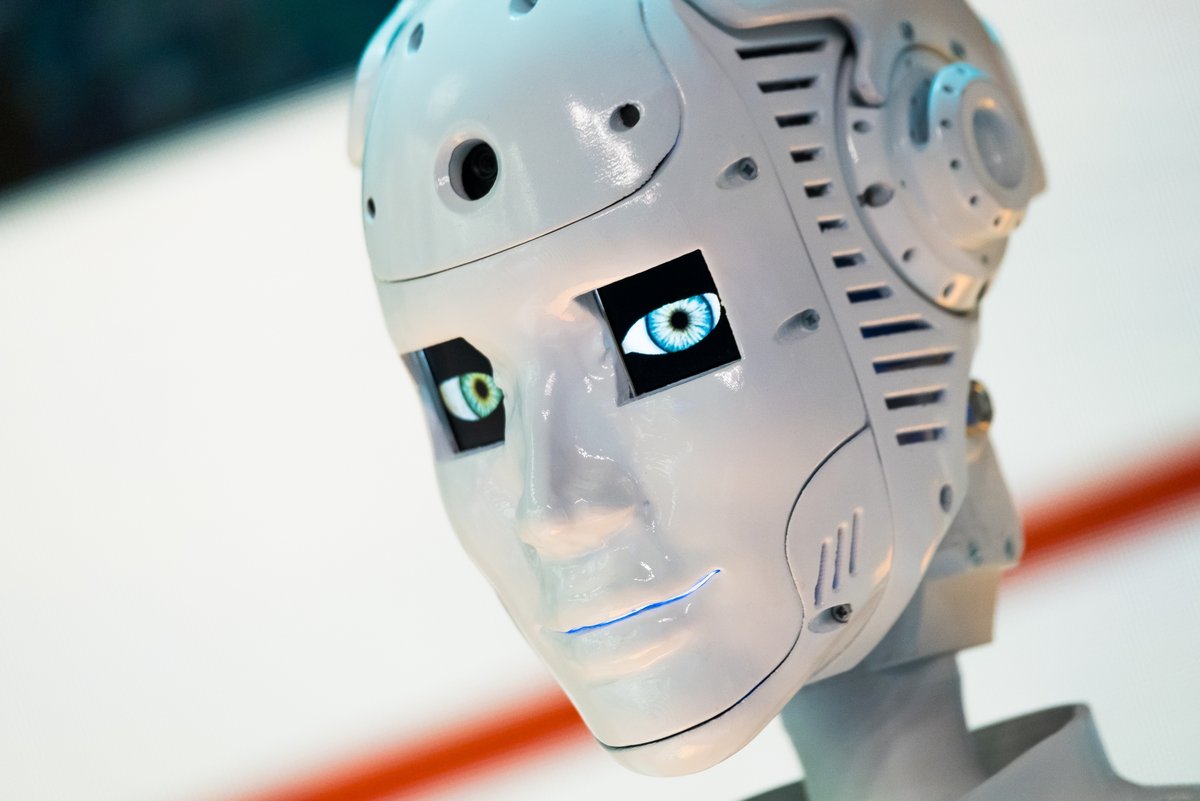

OpenAI vient de lancer une alerte. Un certain nombre d'utilisateurs de son nouveau modèle GPT-4o, intégré à ChatGPT, développeraient des attaches émotionnelles avec l'IA.

La présentation au mois de mai dernier du nouveau modèle GPT-4o d'OpenAI a été une étape importante pour la firme américaine, avec un chatbot qui semblait particulièrement humain dans ses échanges avec le testeur. Une réussite totale, qui se traduit par des revenus toujours plus en hausse pour la société de Sam Altman ces derniers mois. Mais la réussite est peut-être trop forte, au vu des liens qui se tissent entre l'IA et certains utilisateurs…

Des liens émotionnels se forment avec l'IA

On parle souvent de sécurité quand on évoque l'IA ces derniers mois. Beaucoup ont notamment peur des conséquences des affabulations dont peut quelques fois faire preuve la technologie. Mais un nouveau danger semble bien pointer le bout de son nez. Des utilisateurs développent en effet des liens trop « humains » avec l'IA, pouvant aller jusqu'à une forme d'amour.

C'est ce qui a poussé OpenAI à lancer l'alerte, avec la publication d'une note sur son blog. La société californienne explique ainsi que, « au cours des premiers essais, nous avons observé que les utilisateurs utilisaient un langage susceptible d'indiquer qu'ils établissaient des liens avec le modèle. Il s'agit par exemple d'un langage exprimant des liens communs, comme "C'est notre dernier jour ensemble". »

L'IA pourrait couper les utilisateurs des relations humaines

Et ça n'aurait rien de banal. OpenAI craint en effet que les utilisateurs n'aient de cesse d'approfondir leurs relations avec l'IA, et qu'avec ces liens toujours plus forts, les clients se coupent dans le même temps du reste des êtres humains. De quoi accélérer la tendance à se reclure que l'on observe depuis une vingtaine d'années et l'explosion internet ?

Le problème, c'est que si OpenAI s'inquiète, le partenaire de Microsoft n'a pour le moment aucune contre-mesure à proposer. « Nous avons l'intention d'étudier plus avant le potentiel de dépendance émotionnelle et la manière dont une intégration plus poussée des nombreuses caractéristiques de notre modèle et de nos systèmes avec la modalité audio peut induire un comportement » se contente d'indiquer la note.

- Chat dans différentes langues, dont le français

- Générer, traduire et obtenir un résumé de texte

- Générer, optimiser et corriger du code

Source : Techradar