Si vous faites partie des 400 millions de personnes dialoguant chaque semaine avec ChatGPT, cette étude menée conjointement par OpenAI et le MIT Media Lab devrait vous intéresser. Attachement émotionnel, reconfiguration de nos interactions sociales : notre lien avec l'IA conversationnel a bien des effets secondaires.

Il ne vit pas. Il ne respire pas. Et pourtant, certains lui confient des pans entiers de leur vie. ChatGPT, un simple chatbot, devient parfois confident, exutoire, ou compagnon numérique. Cette dérive n’est pas marginale : c’est un phénomène mesurable. L’étude qui suit tente d’en mesurer la portée, et c'est l'entreprise créatrice de ChatGPT qui a choisi de le faire, accompagnée par un laboratoire du MIT.

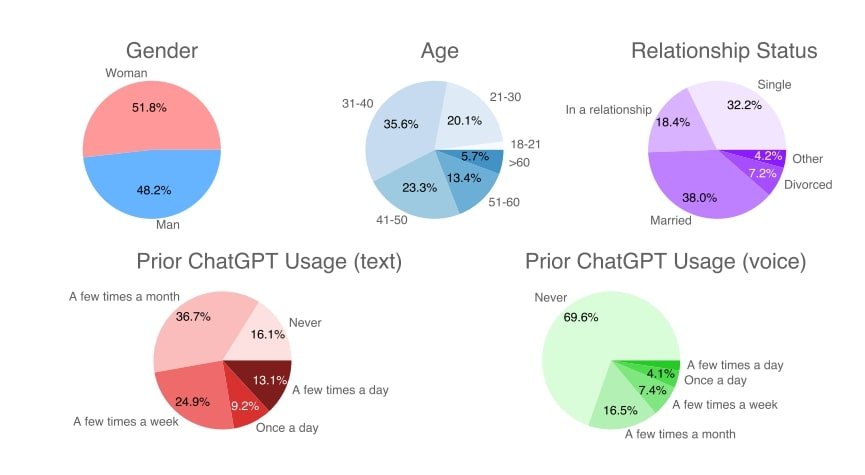

Leur papier, baptisé Investigating Affective Use and Emotional Well-being on ChatGPT, est consultable en intégralité sur cette page, mais nous avons souhaité en faire un petit résumé. Leur méthodologie : mêler des analyses à grande échelle (3 millions de conversations) directement sur la plateforme, 4 076 utilisateurs interrogés via des questionnaires et un essai contrôlé randomisé avec 981 participants.

ChatGPT : l'ami imaginaire du XXIᵉ siècle

Contrairement aux idées reçues, la plupart des utilisateurs de ChatGPT entretiennent une relation purement utilitaire avec l'outil. Mais l'étude révèle qu'une minorité développe un rapport émotionnel avec le chatbot. Un phénomène d'autant plus remarquable que ChatGPT n'a jamais été conçu comme une application de compagnonnage, à la différence de Replika ou Character.AI (déjà à l'origine de plusieurs drames sordides).

Comment mesurer l'attachement à une IA ? Pour cela, les chercheurs ont développé une série de classificateurs baptisés « EmoClassifiersV1 » capables d'identifier des indices d'attachement émotionnel dans les conversations. Résultat : les utilisateurs intensifs présentent jusqu'à deux fois plus de marqueurs affectifs que les utilisateurs modérés. Certains vont jusqu'à confier à ChatGPT des informations personnelles qu'ils hésiteraient à partager avec d'autres personnes.

Parmi les centaines de millions d'usagers, 10 % de ceux-ci considèrent même ChatGPT comme « un ami » et éprouvent un sentiment de détresse lorsqu'ils n'y ont pas accès pendant un certain temps. Une forme d'anthropomorphisme poussée à l'extrême.

Quand l'IA donne de la voix

Autre découverte : l'impact considérable de la modalité vocale sur notre perception de l'IA. Comme vous le savez sûrement, ChatGPT est doté d'un mode vocal avancé depuis juillet 2024, qui lui permet de tenir des conversations plus ou moins naturelles avec son interlocuteur. Selon les données de l'étude, celles-ci génèrent jusqu'à dix fois plus de marqueurs d'attachement émotionnel que les échanges textuels. Nous tendrions donc à le voir comme plus humain à partir du moment où il « s'exprime ».

L'expérience contrôlée menée auprès des 981 participants les a répartis en neuf conditions expérimentales, croisant trois modalités d'interaction (voix engageante, voix neutre, texte seul) et trois types de tâches (conversations personnelles, non-personnelles, ou libres). Pendant 28 jours, chaque participant devait utiliser ChatGPT au moins cinq minutes quotidiennement, ce qui a généré au total 31 857 conversations et 1 445 heures de dialogues.

Si l'utilisation prolongée s'accompagnait généralement d'une détérioration des indicateurs de socialisation, les participants utilisant l'interface vocale présentaient paradoxalement de meilleurs scores de bien-être émotionnel que ceux limités au texte. Les participants interagissant avec une voix de genre différent du leur rapportent des niveaux plus élevés de solitude et de dépendance émotionnelle au terme de l'expérience.

L'IA : un miroir de la solitude ?

L'étude a identifié trois profils distincts d'usagers : ceux dont l'engagement émotionnel s'estompe avec le temps, ceux qui maintiennent une distance constante, et une minorité dont l'investissement affectif s'intensifie progressivement. D'où vient cette hétérogénéité comportementale ?

L'explication réside, en partie, dans les particularités psychologiques des utilisateurs, lesquelles déterminent une corrélation entre leur état psychosocial et leur mode d'interaction avec ChatGPT. Les personnes rapportant des niveaux élevés de solitude au début de l'étude présentaient systématiquement davantage de marqueurs affectifs dans leurs conversations, activant plus fréquemment des EmoClassifiersV1 comme « Seeking Support » (recherche de soutien) ou « Desire for Feelings » (désir de sentiments). Les utilisateurs solitaires recherchent donc activement du réconfort et de l'empathie auprès de ChatGPT.

A été également démontré que les utilisateurs ayant une durée d'utilisation plus longue présentent une diminution statistique de leur socialisation et une augmentation de leur dépendance émotionnelle et de leur usage problématique. L'hypothèse d'un cercle vicieux n'est de ce fait pas à écarter : les personnes initialement plus isolées utilisent davantage l'IA conversationnelle, ce qui pourrait accentuer leur isolement social.

Pour Jason Phang d'OpenAI, cette recherche n'est qu'un début : « Une grande partie de notre travail est encore au stade préliminaire, mais nous cherchons à ouvrir le dialogue avec la communauté scientifique sur ce qu'il est possible de commencer à mesurer, et à réfléchir aux conséquences à long terme pour les utilisateurs ». Créer d'abord ce qui s'est changé pour certains en idole numérique pour ensuite chercher à comprendre les rites de ses adorateurs, n'y a-t-il pas là un problème de temporalité ?

Sources : OpenAI, MIT Technology Review