Les études se suivent et se ressemblent. La conclusion est toujours la même : le marché du Cloud Computing bénéficie d'une forte croissance. « Malgré les incertitudes économiques actuelles, IDC prévoit que les fournisseurs de services Cloud - à la fois publics et privés - seront parmi les plus dépensiers parmi les fournisseurs de produits et services IT », estime Richard Villars, vice-président systèmes de stockage chez IDC. Cette évolution concerne notamment la France. Selon l'étude « Cloud France 2011 : le marché des services informatiques dans le nuage », réalisée par le cabinet Pierre Audoin Consultants (PAC), le marché hexagonal devrait atteindre plus d'1 milliard d'euros cette année avec une progression de près de 30 % en un an. La part des dépenses Cloud dans les dépenses informatiques globales devrait passer de 4% en 2010 à 20% à horizon 2020.

- Pour un rappel des principaux acteurs et notions concernés, voir Comprendre le Cloud Computing : acteurs et enjeux

HP s'attaque à Amazon

Cette acquisition intervient quelques mois après le rachat de RightNow Technologies par Oracle. En déboursant 1,5 milliard de dollars, Oracle entend damer le pion à son concurrent direct dans les solutions de gestion de clientèle, Salesforce.com. Oracle veut offrir « aux clients un large panel de solutions Cloud, incluant l'automatisation des forces de ventes, les ressources humaines, la gestion des talents, le réseautage social, les bases de données et Java comme parties d'Oracle Public Cloud ». On est loin des propos quelque peu « méprisants » de Larry Ellison, le PDG de Oracle. En septembre 2009, il qualifiait le Cloud Computing de concept marketing qui englobe tout et n'importe quoi.

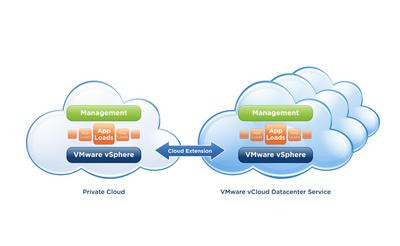

D'autres acteurs tout aussi importants se sont également lancé sur ce créneau. Cet été, Dell a lancé... Dell Cloud avec Vmware. L'offre s'appuie sur VMware vCloud Datacenter Services pour des offres publiques, privées et hybrides. HP s'intéresse aussi à l'informatique dans les nuages. Début 2011, il a lancé son offre Cloud Hybrid Delivery. Le californien va aussi s'attaquer aux ténors du IaaS (Infrastructure-as-a-Service). En septembre dernier, il a lancé une version bêta de HP Cloud Compute Object Storage qui devrait être le concurrent direct des Amazon Web Services et d'EC2 mais aussi des offres de IBM, Microsoft et Rackspace.

Dernier larron à proposer ses services, Dropbox. Fin octobre, la société a décidé de commercialiser une formule ciblant les petites entreprises. Baptisée Dropbox for Teams, elle coûte 795 dollars par an pour 5 utilisateurs qui bénéficient d'une capacité de stockage d'1 To sur les serveurs configurés sur ceux d'Amazon S3.

Plus vite, plus efficace

Face à l'arrivée de ces nouveaux prétendants, les « pionniers » du secteur (Amazon, Google, IBM... ) veulent maintenir leur leadership. Tous se vantent d'avoir l'offre la plus complète, la plus facile à gérer et la plus rapide ! Ces poids lourds multiplient surtout les versions et déclinaisons afin de satisfaire tous les besoins des entreprises, qu'il s'agisse d'une multinationale ayant de nombreuses filiales ou d'une PME.

Très actif dans le domaine avec son offre Azure, Microsoft a ainsi publié en octobre dernier une mise à jour de Windows Intune, son service cloud d'administration de parc informatique destiné aux TPE/PME de moins de 500 postes. Cette nouvelle version permet notamment d'installer à distance la plupart des logiciels de l'éditeur. De son coté, IBM met en avant son Cloud Workload Deployer, un logiciel permettant de concevoir et de déployer des architectures Cloud Privé de manière rapide et efficace.

A propos d'efficacité, Google a annoncé mi novembre la fin de la version bêta de son service Cloud d'analyse de données en volume, BigQuery. Selon le moteur de recherche, ce service (gratuit pour le moment) permet aux entreprises d'injecter de vastes quantités de données dans le Cloud, d'opérer des requêtes précises sur ces mêmes données, et d'en extraire des analyses.

Les principales offres françaises : la riposte

Face à la montée en puissance américaine, les Français tentent de résister. Différents opérateurs, SSII et hébergeurs ont mis en place des solutions... franco-américaines tandis que des éditeurs ont développé des services SaaS rapides à déployer.Orange Business Services

Le Cloud Computing est l'une des 8 priorités de croissance du plan stratégique Conquêtes 2015. L'objectif d'Orange Business Services est de générer 500 millions d'euros d'ici 2015 sur ce marché. Pour atteindre cet objectif, Orange Business Services s'est allié avec les grands acteurs du Cloud Computing, du stockage et de la virtualisation comme Microsoft, VMware, EMC, Cisco, IBM, Citrix... Après avoir lancé il y a deux ans Flexible Computing à destination des grandes entreprises, Orange commercialise Flexible Computing Express pour les PME. Cette offre à la carte propose un datacenter virtuel (au minimum 100 Go d'espace disque) facturé à l'usage, avec ses serveurs physiques et virtuels et un espace de stockage pouvant évoluer, en temps réel.

Selon l'opérateur, cette solution d'infrastructure IT aura une disponibilité contractuelle de 99,95%. Dans le pire des cas, le client aurait 18 minutes d'indisponibilité par mois. Cette solution compte une vingtaine de clients parmi lesquels le CIRAD (Centre de coopération internationale en recherche agronomique pour le développement), un Établissement public à caractère industriel et commercial.

Orange Business Services propose aussi Backup « as a Service ». Cette solution de protection des données informatiques (sauvegarde des postes de travail fixes ou nomades, des serveurs physiques et machines virtuelles) a convaincu d'importantes sociétés parmi lesquelles Arkema, acteur majeur de la chimie mondiale présent dans plus de 40 pays avec un effectif de 14 000 personnes.

SFR Business Team

Même s'il a lancé une offre d'hébergement de données en 2010, l'opérateur est resté discret sur le marché de l'informatique dans les nuages. La situation va évoluer dans les prochains mois car SFR se montre ambitieux en renforçant ses partenariats avec des éditeurs, des SSII et HP. La société américaine fournira sa solution pour l'offre de Cloud public proposée par SFR. Ce dernier commercialisera également des offres de Cloud privé (très sécurisé et a priori réservé aux grands comptes) et « privatif » (géolocalisé en France). L'opérateur dispose de 8 centres dans l'Hexagone pour un total de 20 000 mètres carrés de serveurs.

Cette volonté d'investir massivement le secteur du Cloud pourrait se traduire notamment par l'allocation de ressources télécoms à la demande. Les solutions PBX (autocommuateur) seraient disponibles dans le Cloud (PBX hébergé).

Une disponibilité maximale de 99,99999 % !

Différentes SSII proposent également leurs services : Steria s'est associé à Vmware en 2010 tandis que Capgemini a signé un partenariat avec le leader mondial du stockage EMC pour lancer différentes offres en 2012 dont une concernant le stockage en ligne.

L'intégrateur et revendeur multi-régional Quadria a signé en avril dernier un accord d'exclusivité avec Dell. La société française devient ainsi le revendeur exclusif, pour le territoire français, des offres cloud de Dell. En septembre, Quadria a aussi signé un partenariat avec VMware pour proposer à ses clients les outils du spécialiste de la virtualisation comme vCloud Director.

Dans ce panorama, non exhaustif, il ne faut pas oublier les hébergeurs (Netissime, Prosodie...). L'externalisation croissante de l'informatique les a conduit à moderniser leurs infrastructures afin de proposer des offres Cloud. C'est le cas principalement de OVH qui apparaît comme l'un des concurrents directs de l'offre d'Orange Business Services. Pour convaincre les entreprises, OVH peut se vanter d'être le premier hébergeur français certifié « vCloud Powered », un label accordé par Vmware à seulement 15 autres entreprises européennes. Grâce à cette certification, OVH a investi 10 millions d'euros pour proposer depuis cet été une offre IaaS à la carte avec... les solutions de Vmware (VMware vSphere, VMware vCenter, VMware vShield...).

Baptisée « Private Cloud », elle permet aux entreprises de créer une infrastructure externalisée dans des délais très rapides (en quelques minutes) et en tenant compte de ses besoins spécifiques. Plus fort qu'Orange, l'hébergeur garantit une disponibilité maximale de 99,99999 % ! Le Cloud hybride étant un concept très tendance en ce moment, l'hébergeur s'appuie sur le vCloud Director de Vmware pour commercialiser une telle offre.

A coté des solutions de stockage virtuel, des éditeurs français tentent aussi de relever le défi face à l'hégémonie américaine dans les services applicatifs (SaaS). Un pari audacieux car la concurrence est rude. Selon une étude publiée au printemps dernier par le cabinet Markess International, 83% des prestataires interrogés s'accordent pour avancer que le modèle traditionnel de vente de licences logicielles devrait progressivement basculer en France vers le modèle SaaS.

Citons la start-up Bittle, créée en 2009, qui vise les PME en proposant une solution simple et bon marché. Reposant sur les technologies de Google (Google App Engine), sa solution décisionnelle permet de construire rapidement des tableaux de bord et du reporting en ligne pour piloter l'ensemble des activités d'une structure. Un argument qui ne séduit pas que les PME puisque Sanofi Pasteur utilise cette solution pour suivre l'activité de ses 900 visiteurs médicaux en France et au Benelux.

Passer au Cloud vaut-il le... coût ?

« Anywhere, anydevice, anytime » ! Pour les vendeurs de Cloud Computing la réponse est évidente : c'est oui ! Les entreprises ont tout intérêt à mettre leur informatique dans les nuages. Pour différentes raisons : elles n'achètent pas la licence du produit et elles n'ont pas besoin de s'occuper des mises à jour du logiciel et de la maintenance des équipements. Autres arguments avancés : l'absence d'investissement dans d'importantes infrastructures (la plupart du temps, la salle informatique est une pièce standard du bâtiment dans laquelle on a ajouté une climatisation - rarement redondée - et un onduleur...) une mise en service très rapide (un serveur peut être activé en quelques minutes) et une meilleure flexibilité (pour les IaaS et PaaS).Les coûts engendrés sont surtout liés au fonctionnement du service (paiement à l'usage, maintenance, support...) et non à l'amortissement d'investissements (matériels, logiciels, projets ...). Selon IBM, en moyenne, le Cloud aide les entreprises à diviser par deux leurs coûts opérationnels. « Une informatique unifiée, c'est une maintenance 30 % moins chère. L'automatisation de la répartition des charges représente 11 % d'économies en plus sur le coût de la gouvernance », affirme Ian Brooks, en charge de la promotion du Cloud chez HP.

« Dans l'étude que nous avons faites pour le Fonds stratégique d'investissement, nous avons constaté des gains de 30% pour certaines applications courantes et simples (messagerie, stockage en ligne). Cependant, si vous mettez votre SAP en mode Cloud cela peut coûter beaucoup plus cher ; tout dépend de l'architecture de l'entreprise », précise Mathieu Poujol, consultant au cabinet Pierre Audoin Consultants (PAC).

Le Cloud pour mieux travailler

En matière de SaaS, le Cloud apparaît aussi comme un moyen de réduire ses coûts puisqu'un logiciel SaaS est facturé comme un service. Dans la majorité des cas, c'est une facture mensuelle ou annuelle par utilisateur. A titre d'exemple, Google Apps, la solution SaaS qui remplace les anciens outils bureautiques tels que Office, Notes ou Exchange, coûte 40 € par an et par personne.

« Nous sommes au moins dix fois moins chers qu'une solution en client serveur. Notre solution présente notamment un investissement de départ beaucoup plus bas », indique Christophe Suffys de la start-up Bittle évoquée plus tôt. L'essentiel (80 %) des fonctionnalités de la solution décisionnelle de Bittle est accessible gratuitement et sans limitation dans le temps. La solution payante fait passer l'espace de stockage de 1 à 20 Go et elle donne accès à des graphiques plus élaborés et automatise la remontée de données qu'il faut initier avec la version gratuite. Le SaaS peut également permettre à l'entreprise de mieux maîtriser ses risques de conformité (audit de licences par exemple).

De façon plus générale, « l'informatique dans les nuages permet de confier aux solutions SaaS les usages transverses, génériques, industrialisables (comme le CRM, la communication et la collaboration). Pour les directions informatiques des entreprises, cette "répartition" des tâches libère du temps et des ressources et permet de se concentrer sur les applications "cœur de métier", porteuses de compétitivité et de différentiation », explique Louis Naugès, Président de Revevol, premier partenaire international dédié à Google Apps.

Mathieu Poujol cite le cas d'EDF qui a développé un Cloud privé : « avant pour provisionner un serveur il leur fallait attendre plusieurs jours. Avec leur Cloud, l'opération se fait sous 24 heures. Autre exemple montrant l'intérêt du Cloud avec la PME Onduline, leader français de la tôle ondulée. Elle a fait appel à la solution de Master data management (gestion des données de référence) en mode Cloud d'Orchestra Networks, un éditeur français fondé en 2000 et leader dans son domaine. Pour la PME, le nuage a présenté deux avantages : un déploiement rapide (4 mois) et complet (une gouvernance centralisée de toutes les données relatives à ses produits). Selon les responsables d'Onduline, ils n'auraient pas utilisé un Master data manager sans le Cloud car l'investissement aurait été trop important pour l'installer dans ses 40 filiales et ses 8 usines dans le monde ».

Des économies d'énergie : un argument marketing ?

Pour convaincre les plus réticents, les services marketing ont sorti l'argument écolo. Tout peut-être affirmé puisque, pour l'instant, aucune analyse scientifique n'a mesuré précisément l'impact écologique de l'informatique dans les nuages. Résultat, les chiffres les plus fous circulent sur le web et sont repris par tous les médias. Le meilleur exemple est l'étude « Cloud Computing: The IT Solution for the 21st Century ». Menée par Verdantix pour le Carbon Disclosure Project (une organisation internationale représentant un groupe de 475 grands investisseurs, dont les actifs s'élèvent à... 55 000 milliards de dollars), elle affirme que les grandes entreprises américaines (plus de 1 milliard de dollars de chiffre d'affaires) pourraient réduire leurs consommation d'énergie d'environ 200 millions de barils de pétrole par an en 2020.

Trop beau pour être vrai ? Cette étude ne tient pas compte de l'effet rebond. Lorsqu'une entreprise bascule une partie de ses ressources informatiques dans le nuage, elle a tendance à demander un niveau de service (SLA - Service Level Agreement) supérieur à celui sur lequel elle s'engageait en interne. Les opérateurs de « nuages informatiques » mettent donc en place des infrastructures plus disponibles mais qui consomment théoriquement plus d'énergie.

Les offres d'hébergement les plus « sérieuses » reposent souvent sur des datacenters ayant la classification Tier III ou Tier IV. Selon cette classification (pas une norme, mais un ensemble de recommandations) établie depuis 2007 par Uptime Institute, un Tiers III est composé de plusieurs circuits électriques pour l'énergie et pour la distribution de refroidissement. Un seul circuit est actif mais il y a des composants redondants et le taux de disponibilité est de 99,982 %. Le Tier IV est composé de plusieurs circuits électriques pour l'énergie et pour la distribution de refroidissement, il a des composants redondants et actifs et il offre un taux de disponibilité de 99,995 %. Un Tiers IV met donc principalement en avant l'aspect préservation du process grâce à une réponse autonome du système face à n'importe quelle défaillance.

Apparemment, tout le monde n'a pas de plan B. Fin novembre, le datacenter Level3 à Nanterre a pénalisé (ralentissement ou accès impossible) des sites français qu'il héberge. En cause : une panne du système de climatisation au milieu de la nuit !

Autre faiblesse de cette étude : la mesure de l'efficience énergétique lors de la phase d'utilisation. La construction du bâtiment et des serveurs n'est pas retenue. « Le cloud Computing repose presque exclusivement sur de nouveaux datacenters géants de plusieurs milliers de m2. La construction de ces bâtiments émet forcément beaucoup de CO2 », précise Frédéric Bordage, consultant Green IT.

Coup de froid

L'initiative prise cet été par l'EPFL (École Polytechnique Fédérale de Lausanne) de lancer le projet EcoCloud est donc la bienvenue. Composé d'un consortium de 12 laboratoires et doté d'un budget annuel de 1,2 million d'euros, le projet est financé en partie par des entreprises (HP, IBM, Intel, Microsoft, Oracle et Crédit Suisse) et la Commission européenne. L'objectif est de créer un centre de compétences reconnu au niveau européen dans le domaine de l'optimisation énergétique du cloud Computing. Le projet permettra notamment de réfléchir à de nouvelles techniques de refroidissement et de climatisation et d'améliorer les composants eux-mêmes. Vaste programme.

Mais il faut néanmoins rester positif. Selon Adrienne Corboud Fumagali, vice-présidente de l'innovation à l'EPFL, « une requête sur Google est l'équivalent de 10 secondes d'une ampoule électrique, une information que m'a donnée le moteur de recherche en Suisse ».

Enfin, il faut saluer l'exploit de Marilyn qui... revendique le titre de premier datacenter écologique haute densité au monde. Après des essais industriels concluants, le modèle de refroidissement par l'air ambiant est validé avec une charge à 1 MW. Depuis octobre, ce centre de données informatiques (officiellement inauguré le 24 novembre) accueille les clients entreprises de l'opérateur Celeste.

Automatisation = facture salée ?

Les entreprises doivent aussi être très vigilantes. La facilité d'utilisation de certains services est en effet à double tranchant. C'est le cas par exemple d'EC2 (Elastic Compute Cloud, un des composants d'AWS, Amazon Web Services). Ce service permet d'utiliser des machines virtuelles selon ses propres besoins. En un mot, le client ne paie que s'il utilise une ou plusieurs machines virtuelles et des capacités de stockage. Il n'y a pas d'abonnement minimum.

Seul soucis : si l'entreprise lance une machine virtuelle et qu'elle oublie de l'éteindre, le compteur tourne. Et le risque est d'autant plus important que la plate-forme EC2 a été conçue pour l'automatisation : si le programme qui crée des machines virtuelles présente un bug, il peut créer des dizaines d'instances. « Il est nécessaire de surveiller de près sa consommation (Amazon fournit une excellente page Web pour cela, dans la console d'AWS - Account Activity) », prévient sur son blog Stéphane Bortzmeyer, architecte systèmes et réseaux à l'AFNIC (Association française pour le nommage Internet en coopération).

Le Cloud Computing : les atouts de l'Open Source

Face à ces différentes incertitudes, des fournisseurs proposent des solutions Open Source. Le plus connu d'entre eux est Red Hat qui a décidé de se lancer à l'assaut de VmWare et de Microsoft avec CloudForms. Construite à partir de technologies Open Source comme la RHEL (Red Hat Enterprise Linux),RHEV (Red Hat Enterprise Virtualization) et le projet Deltacloud, cette solution IaaS donne le choix aux utilisateurs. Ils peuvent en effet construire des systèmes déployables sur tout type d'infrastructures (VmWare, RHEV, Amazon, etc) et disposer ainsi de « nuages » hybrides ou privés.

A coté de ce poids lourd américain, il existe d'autres projets capables de satisfaire ou d'intéresser de nombreuses entreprises :

- Eucalyptus : initié en 2008 au sein de l'Université de Californie, cet outil permet de construire des infrastructures de Cloud Computing sur la base de serveurs en cluster. Il est également compatible avec l'interface de commande d'Amazon EC2.

- Joyent / Reasonably Smart : Joyent, fournisseur global de solutions et technologies Cloud, a fait l'acquisition en 2009 de Reasonably Smart . Il s'agit d'une plate-forme basée sur JavaScript et Git. Les applications sont développées en HTML pour l'interface et en JavaScript pour la partie serveur . Elles disposent d'outils pour stocker les données. Une fois développée, l'application n'a plus qu'à être déployée sans ce soucier de l'infrastructure nécessaire à son fonctionnement.

- Globus Nimbus : il s'agit d'une boite à outils Open Source permettant de transformer un cluster de serveurs en nuage.

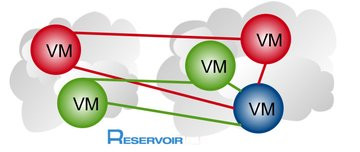

- Reservoir : il s'agit de la principale initiative européenne de recherche sur les infrastructures virtualisées et le Cloud Computing. Coordonnée par IBM avec treize acteurs européens, elle ambitionne de développer une technologie Open Source pour permettre le déploiement et la gestion de services IT complexes. Le projet a comme objectif d'implémenter une architecture abstraite de type Cloud, composée de trois couches. La première est responsable de la gestion des demandes de déploiement de machines virtuelles par les utilisateurs et assure le suivi de l'exécution. La deuxième couche est responsable du respect des SLA (Service Level Agreements). Elle gère le placement des machines virtuelles sur les machines physiques, ainsi que la migration des machines virtuelles d'une machine physique à une autre. La troisième et dernière couche gère l'exécution des machines virtuelles et forme une couche d'abstraction autour de la technologie d'hyperviseur qui est utilisée, par exemple VmWare ou Xen.

La sécurité : le maillon faible ?

Sur le papier, les principaux avantages des offres de Cloud Computing semblent évidents :- Faire passer les données non sensibles sur un Cloud réduit l'exposition des informations internes sensibles puisqu'elles devraient être (théoriquement...) mieux surveillées et protégées

- L'homogénéité d'un « nuage » simplifie l'audit et les tests de sécurité

- Ils permettent une gestion automatisée de la sécurité

- La disponibilité des données va de pair avec une bonne gestion de la sécurité informatique : redondance, récupération en cas de désastre.

Mais il y a aussi des défis à relever et des inconnues :

- La dispersion de données et le respect de la vie privée

- La garantie des qualités de service

- La sécurité des systèmes d'exploitation virtuels

- Les possibilité d'interruption massive de service

- Les détournement de(s) compte(s)

- L'importance des contrats.

Cette dichotomie explique la position délicate des entreprises et leurs réticences à confier leurs données à des prestataires extérieurs et encore plus s'ils sont étrangers. C'est la raison pour laquelle de nombreux grands comptes optent d'abord pour un Cloud privé, selon l'étude du cabinet Pierre Audoin Consultants. Et l'actualité de ces derniers mois semble les conforter dans leur choix.

L'œil de la NSA...

Cet été, Microsoft a en effet reconnu que les données de ses clients européens d'Office 365 pouvaient être transférées aux États-Unis, sans consentement ou information préalable, dans le cadre de l'application du Patriot Act. « Pour rassurer les entreprises françaises, des offres Cloud américaines expliquent qu'elles ont des datacenters en Europe. Mais si le fournisseur est américain, ses obligations vis-à-vis du Patriot Act ne changent pas », prévient Jérémy d'Hoinne, responsable produit chez NETASQ. « D'autres sociétés américaines déclarent qu'elles vont ouvrir des filiales en Europe. Mais là aussi, il s'agit d'une subtilité car personne n'est capable de dire si une filiale est soumise ou non au Patriot Act ».

Fin octobre, des chercheurs allemands ont découvert des failles de sécurité dans Amazon Web Services (AWS). Informé, Amazon les a corrigés. Néanmoins, l'équipe de chercheurs de la Ruhr-Universität Bochum (RUB) estime que, « dans la mesure où l'architecture Cloud standard rend incompatible la performance et la sécurité », des attaques similaires pourraient réussir contre d'autres services Cloud...

35 risques identifiés

Cette inquiétude n'est pas récente. En 2009, les experts présents lors de la RSA Conference ont évoqué les risques du Cloud Computing et notamment ceux liés à la surveillance du réseau de l'entreprise. Les spécialistes expliquent que les responsables de la sécurité informatique ne peuvent plus repérer les tentatives d'intrusion et encore moins les attaques puisque les ressources sont délocalisées et gérées par le fournisseur de Cloud Computing.

La même année, l'ENISA (European Network and Information Security Agency - Agence européenne chargée de la sécurité des réseaux et de l'information) publie un rapport de 123 pages. Intitulé « Cloud Computing : avantages, risques et recommandations pour la sécurité de l'information », il ne repose pas sur des études techniques ayant testé les forces et faiblesses de ce genre d'infrastructure mais sur l'avis d'une dizaine d'experts de chez Microsoft, Kaspersky, Symantec, Google, etc. Pas vraiment objectifs !

Quoi qu'il en soit, ce rapport pointe 35 risques plus ou moins élevés et liés à la sécurité. « C'est ce qui préoccupe le plus les entreprises interrogées : comment puis-je être sûr de la fiabilité de ce service et faire confiance au fournisseur de services informatiques via l'Internet en lui confiant mes données et même, dans certains cas, la totalité de l'infrastructure de mon entreprise ? », constate Giles Hogben, expert à l'ENISA et éditeur de ce rapport.

La principale menace concerne donc les données, qu'il s'agisse des informations confidentielles (ou sensibles) ou de l'image de l'entreprise. « Pour une entreprise qui envisagerait de passer au Cloud, la première mesure à prendre est de décider quelles données sont elligibles à être déportées dans un "nuage". S'il s'agit de la messagerie, elle doit être attentive aux données qui y circulent ; sont-elles confidentielles ? Doivent-elles être chiffrées ? », explique Jérémy d'Hoinne.

Mais ce genre de réflexion en amont n'est pas toujours possible : « des offres Cloud sont souvent "poussées" par les identités "métier" et elles ne laissent parfois pas le choix aux responsables de la sécurité informatique de l'entreprise. Ce cas de figure intervient plus souvent dans de jeunes entreprises que les grands comptes, ces derniers nous demandant d'identifier les applications et usages qui pourraient ne pas être autorisées », constate Jérémy d'Hoinne.

Un Cloud franco-français

« Le risque est réel de laisser à des acteurs non européens l'accès aux données stratégiques des entreprises françaises et européennes et de leur transférer la responsabilité de la sécurité et de la fiabilité de nos systèmes », peut-on lire dans les documents relatifs à Andromède.

D'où le but de « concevoir, bâtir et opérer une infrastructure de "centrale numérique" de confiance et sécurisée, au service de la compétitivité de l'économie et de la société française, à vocation européenne ».

Bénéficiant d'un budget de 285 millions d'euros, ce projet a donné naissance le 1er novembre à la société Andromède. Les dirigeants de cette co-entreprise sont obligatoirement « indépendants des partenaires industriels ». Le point essentiel est que les données devront être stockées dans des datacenters implantés en France ou éventuellement, en Europe, tout comme les infrastructures permettant d'accéder au système d'information.

Un refuge anti Patriot Act

Depuis, le Patriot Act américain est devenu un argument « commercial ». Fin novembre, Severalnines (fournisseur d'automatisation et de logiciels de gestion dans le Cloud) et City networks ont lancé le premier « Database SaaS 100% européen ». « Le City Cloud Database Service est exploité dans l'Union Européenne et offre aux clients européens une pleine conformité avec la directive 95/46/CE concernant la protection des données, et un refuge contre de possibles répercussions du Patriot Act américain », annonce le communiqué. Le service est disponible gratuitement pour la durée de la période bêta, qui se poursuivra jusqu'au début de l'année 2012.

Les poids lourds du Cloud Computing n'ont pas attendu les ripostes française et européenne pour tenter de rassurer les entreprises. Plusieurs travaux et initiatives ont été lancés de manière à proposer des guides sur la sécurité du Cloud :

- La Cloud Security Alliance (CSA) propose le Cloud Controls Matrix (CCM) conçue pour apporter des principes de sécurité fondamentale de manière à guider les fournisseurs de Cloud et à assister les futurs clients dans l'évaluation du risque de sécurité général d'un fournisseur. La CSA a aussi mis en place le Trust and Assurance Registry (STAR) qui met à disposition des entreprises des documents détaillant les contrôles de sécurité en place dans leur solutions en nuage. Mais pour l'instant, STAR n'est pas encore reconnue par des organismes tiers, comme les assureurs des entreprises clients...

- The Trusted Computing Group (TCG) a mis en place, fin 2010, le Trusted Multi-Tenant Infrastructure Work Group, dont l'objectif est de développer un framework de sécurité pour l'informatique en nuage.

- Novell a lancé TCI (Trusted Cloud Initiative) avec CSA, Microsoft, Dell, Qualys, HP, Intel, Cisco... L'objectif de cet accord est de sensibiliser et d'informer les différents acteurs du Cloud en mettant en place le premier programme de certification dédié à la sécurité des applications dans les nuages. La TCI est donc un guide des bonnes pratiques concernant essentiellement la gestion des identités numériques et le filtrage des accès. Les autres points abordés seront la portabilité et l'interopérabilité.

Quand le Cloud Computing joue aux abonnés absents

Avoir à sa disposition, à la demande et sans limite: des capacités de calcul, des données et des applications. C'est la promesse du Cloud Computing. Mais la mariée est-elle aussi belle ? Le prétendant pourrait déchanter en découvrant qu'il est pieds et poings liés ! A vouloir mettre tous ses œufs dans le même panier on peut se retrouver le bec dans l'eau. Certaines entreprises l'ont apprises à leurs dépens en ayant leurs principales applications dans les nuages. Lorsque le fournisseur est victime d'une panne, le service est inaccessible.C'est ce qui est arrivé en avril dernier lors d'une panne d'Amazon Web Services (AWS). Résultat : des dysfonctionnements chez des milliers de clients américains pendant cinq jours. La cause ? une erreur de routage lors d'une mise à jour qui a provoqué la surcharge d'un réseau de secours du service de stockage Elastic Block Storage (EBS). Cette surcharge a entraîné l'arrêt de machines virtuelles EC2 et de bases de données RDS.

Cet exemple, assez rare (même s'il existe une loi des séries : quelques heures après Amazon, Vmware a été victime d'une panne sur son service Cloudfoundry), rappelle que la disponibilité 24h sur 24 d'un service est une illusion. Les entreprises doivent donc disposer d'une solution de rechange et ne pas avoir tous leurs services et applications dans le même Cloud. Aucun service Cloud n'est à l'abri d'une panne ou d'un coup de foudre un peu trop violent comme ce fut le cas cet été pour les datacenters d'Amazon et de Microsoft.

Ce constat est un casse-tête pour les entreprises. Selon une étude du Cigref parue en septembre 2010, tous les coûts inhérents à une panne (mais aussi à la maintenance des services en ligne ou à la refonte du système d'information pour s'adapter) sont difficiles à évaluer. La disponibilité et la performance d'une application peuvent en effet dépendre autant du serveur qui l'héberge que de la performance du réseau entre l'utilisateur et ce serveur.

L'informatique dans les nuages mais... les pieds sur terre

Malgré les différents avantages du Cloud Computing, les grandes entreprises pointent quelques aspects négatifs d'un point de vue contractuel entre autre. Interrogées par leur réseau Cigref (fin 2010), elles déplorent le manque d'indépendance vis-à-vis du fournisseur chez qui elles hébergeraient leurs données. Elles invoquent le cas de la propriété intellectuelle (à qui appartient les applications développées en ligne ?), l'absence de maîtrise du service rendu (en cas de grosse panne) ainsi que la durée des contrats (le cas de réversibilité est-il toujours prévu si l'on veut changer de fournisseur ou si celui-ci fait faillite ?).

Une confiance absolue en son partenaire est une erreur à ne pas commettre. « Quand une entreprise veut se lancer dans le Cloud, elle doit gérer cette offre comme un contrat d'outsourcing, ce qui n'existe pas généralement avec les Clouds les plus connus. Or, il faut avoir des garanties de rupture et des assurances précises », précise Mathieu Poujol, consultant au cabinet Pierre Audoin Consultants (PAC).

D'où l'importance des fameux SLA (Service Level Agreements) ou en français « Contrats de service ». Le prestataire doit s'engager sur la qualité et les performances de son « nuage ». Ce contrat permet de veiller au respect, par le prestataire et ses éventuels sous-traitants, des niveaux de service associés aux architectures techniques ainsi qu'aux solutions applicatives. Le SLA peut également inclure d'autres référentiels de qualité et de sécurité liés à l'externalisation du ou des systèmes d'information (mise en place de tests et jeux d'essais, clause de recette, audits internes ou externes, politique de sécurité..).

Une clause de pénalité peut sanctionner tout manquement à ces différents points. Mais cette clause est souvent difficile à décrocher lors des négociations... Une clause de réversibilité, précisant les garanties apportées par le prestataire pour assurer la continuité du service sans remise en cause des niveaux de services attendus, est également souhaitable. Et c'est là que le bât blesse entre obligations de moyen et obligations de résultat...

Les fournisseurs ne se mouillent pas

Toutes les plates-formes mettent en avant la pérennité comme point fort. Mais cela ne se traduit pas clairement par des engagements dans le SLA. Ainsi, celle d'Amazon est plus une description des efforts réalisés pour limiter la défaillance des donnés qu'un réellement engagement : « pour ceux qui veulent encore plus de durabilité, Amazon EBS offre la possibilité de créer des instantanés cohérents de vos volumes, à un moment donné, qui sont ensuite stockés sur Amazon S3, et automatiquement répliqués à travers plusieurs zones de disponibilité ». En clair, le client doit prendre lui-même les mesures pour éviter des pertes de données. Pour Windows Azure, le SLA fait uniquement mention d'échecs de transaction. Pour Google Apps, rien n'est mentionné spécifiquement dans le SLA sur la pérennité des données.

Quant à la responsabilité du fournisseur, elle n'est pas non plus rassurante pour les clients : « L'Engagement de Service ne s'applique pas à toute indisponibilité, suspension ou résiliation de Amazon S2, ou tout autre problème de performance de Amazon S2 (...) causé par des facteurs échappant raisonnablement à notre contrôle, dont les cas de force majeure, les problèmes d'accès à internet ou les problèmes en rapport au delà du point de démarcation de Amazon S2 ». Les SLA de Microsoft et de Google ne sont pas plus rassurants.

Bons princes, ces grosses plates-formes peuvent consentir un « crédit de service » (ça fait mieux que « dédommagement ») si leur responsabilité est engagée. Reste à le prouver. Quant aux plates-formes françaises, les SLA ne sont pas plus avantageux...

Savoir raison garder : conclusion et évolutions

Le Cloud Computing a changé les méthodes de travail des entreprises. Il leur permet de bénéficier de capacité de stockage et d'applications adaptées à leurs besoins à un moment précis. Mais cette souplesse a prix, celui de la dépendance vis-à-vis d'un fournisseur. Il faut raison garder. L'analyse précise des besoins et des différentes offres présentes sur le marché est indispensable. Les contrats présentent une importance majeure pour ne pas être trop lié à un prestataire. Enfin, les entreprises doivent toujours disposer d'un plan B en cas de panne ou de disparation du fournisseur (tous les acteurs n'ont pas l'assise financière d'un Google ou Microsoft...).Du coté des hébergeurs et intégrateurs, la donne a également changé. Ils vont devoir revoir leur modèle économique et ne plus proposer des offres Cloud qui sont en réalité des offres traditionnelles d'infogérance et d'externalisation d'infrastructures. Toutes ces précautions et remises en cause sont indispensables car le Cloud Computing va encore évoluer dans les mois.

Parmi les nouvelles « applications » qui commencent à se développer, on trouve notamment le Data-as-a-Service. Pour les entreprises, ce service permet de bénéficier d'une base de données « à la demande ». Les poids lourds du Cloud ont déjà commencé à investir ce domaine : Microsoft avec SQL Azure et SalesForce avec Database.com. Cet été, VMware a annoncé le lancement d'un catalogue de base de données pré-paramétrées appelé vFabric Data Director.

Le « Cloud à la papa »

Pour Marc Benioff, le PDG de Salesforce.com, Google et Amazon c'est un peu le Cloud à la papa. Place aujourd'hui au « Cloud Computing next-gen », avec comme maîtres mots mobilité et social. Les exemples à suivre seraient donc Facebook, Twitter, ou YouTube du côté du web. Pour le logiciel, il faudrait adopter le modèle de l'App Store.

Salesforce.com applique à la lettre les prédictions de son PDG en lançant en mars dernier la version 3 de son Service Cloud. Elle intègreChatter (plate-forme collaborative en temps réel, élaborée sur le modèle de Facebook), Facebook et Twitter. Les messages et commentaires des réseaux sociaux peuvent par exemple être convertis pour se retrouver dans Service Cloud 3. Les utilisateurs peuvent accéder au service à partir de n'importe quel appareil mobile, y compris l'iPad.

Mais « le nuage ne doit pas être une solution en quête de problème. Ce n'est, aujourd'hui comme hier, qu'un outil avec ses promesses et ses limites, qui doit être progressivement intégré dans le portefeuille des entreprises pour ce qu'il sait bien faire avec pragmatisme et discernement », rappellent à juste titre trois anciens présidents du CIGREF (réseau des grandes entreprises) dans une tribune publiée en juillet 2011.