OpenAI vient de déployer trois nouveaux modèles audio pour l'API : gpt-4o-transcribe, gpt-4o-mini-transcribe et gpt-4o-mini-tts. Ces innovations promettent une meilleure reconnaissance vocale et une synthèse plus naturelle. Les développeurs peuvent désormais personnaliser le ton des voix générées, tout en respectant les préréglages contrôlés par l'entreprise.

Avec le lancement de trois nouveaux modèles audio, OpenAI souhaite améliorer les capacités vocales de ses chatbots. Deux d'entre eux, gpt-4o-transcribe et gpt-4o-mini-transcribe, se consacrent à la conversion de la parole en texte avec une précision affûtée. Le troisième modèle, gpt-4o-mini-tts, permet de transformer le texte en parole avec des nuances expressives inédites.

Ces outils s'adressent aux développeurs du monde entier pour créer des applications vocales plus naturelles et intuitives. Les modèles sont déjà accessibles via l'API d'OpenAI, avec une tarification variant de 0,3 à 1,5 cent par minute selon le service utilisé. Cette nouvelle offre enrichit les capacités multimodales de l'entreprise au-delà du texte.

OpenAI développe des capacités qui vont au-delà du texte pour créer des agents vocaux plus intelligents

OpenAI a lancé le 20 mars 2025 trois nouveaux modèles audio disponibles via son API. Cette nouvelle génération de technologies complète les outils d'agents textuels comme Operator, Deep Research, Computer-Using Agents et l'API Responses. Les nouveaux modèles élargissent l'offre vers la dimension vocale : deux modèles de reconnaissance vocale (gpt-4o-transcribe et gpt-4o-mini-transcribe) et un modèle de synthèse vocale (gpt-4o-mini-tts).

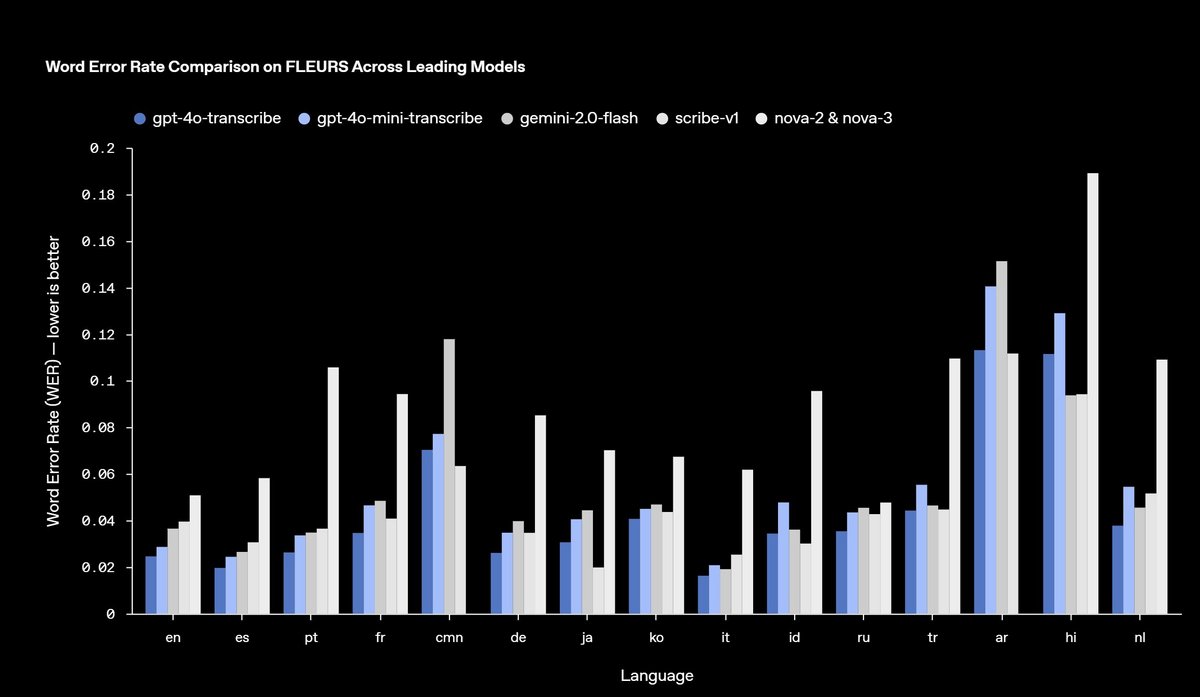

Selon l'entreprise, ces modèles améliorent considérablement la précision et la fiabilité de la transcription, particulièrement dans des conditions complexes comme les accents, les environnements bruyants ou les variations de débit de parole. Les tests montrent que ces modèles surpassent les solutions existantes, y compris les précédents modèles Whisper développés par OpenAI.

Le gpt-4o-mini-tts introduit pour la première fois la possibilité de spécifier comment le texte doit être prononcé. Par exemple, un développeur peut demander au modèle de « parler comme un agent du service client sympathique ». Ces nouveaux modèles utilisent les architectures GPT-4o et GPT-4o-mini, mais bénéficient d'un pré-entraînement avec des jeux de données audio spécialisés.

Les innovations techniques sont accompagnées de précautions éthiques et économiques

Les nouveaux modèles vocaux d'OpenAI intègrent trois avancées techniques essentielles. D'abord, ils bénéficient d'un pré-entraînement sur des jeux de données audio spécialisés. Ensuite, ils utilisent des méthodologies de distillation avancées pour transférer les connaissances des grands modèles vers des versions plus petites et performantes. Enfin, pour les modèles de transcription, un paradigme d'apprentissage par renforcement améliore la précision et réduit les hallucinations.

Ces modèles sont maintenant accessibles à tous les développeurs, avec une tarification établie. La transcription avec gpt-4o-transcribe coûte environ 0,6 cent par minute, tandis que gpt-4o-mini-transcribe est proposé à 0,3 cent par minute. La synthèse vocale avec gpt-4o-mini-tts revient à environ 1,5 cent par minute.

OpenAI précise que les modèles de synthèse vocale sont actuellement limités aux voix artificielles prédéfinies. L'entreprise surveille ces préréglages pour garantir leur caractère synthétique reconnaissable. Cette restriction répond aux voix qui s'élèvent quant à l'éthique et l'usurpation vocale, après notamment l'affaire « Her », dans laquelle le papa de ChatGPT avait été accusé par l'actrice Scarlett Johansson d'avoir plagié sa voix.

- Chat dans différentes langues, dont le français

- Générer, traduire et obtenir un résumé de texte

- Générer, optimiser et corriger du code

« À l'avenir, nous prévoyons de continuer à investir dans l'amélioration de l'intelligence et de la précision de nos modèles audio et d'explorer des moyens permettant aux développeurs d'apporter leurs propres voix personnalisées pour créer des expériences encore plus personnalisées, conformément à nos normes de sécurité », indique l'équipe d'OpenAI.

L'entreprise poursuit ses discussions avec les décideurs politiques, chercheurs, développeurs et créatifs sur les défis et opportunités des voix synthétiques. OpenAI promet également des investissements dans d'autres modalités, notamment la vidéo, pour permettre la création d'expériences agentiques multimodales.

Pour les développeurs qui travaillent déjà avec des modèles textuels, OpenAI recommande l'utilisation du SDK Agents pour créer facilement des agents vocaux. Pour les applications nécessitant une faible latence, l'API Realtime est conseillée.