Avec le GeForce GTX Titan, NVIDIA vise en effet à proposer la carte graphique mono-GPU la plus puissante du marché. Et pour ce faire, plutôt que de recréer une nouvelle architecture qui pourrait constituer les fondements d'une nouvelle gamme, NVIDIA recycle le GK110, une puce conçue pour ses familles de cartes professionnelles, les Tesla et Quadro.

Du reste NVIDIA ne s'en cache pas puisque le nom de cette carte graphique, Titan, est une référence directe au super-ordinateur du même nom qui a, le 12 novembre dernier, décroché le titre de supercalculateur le plus rapide. Un superordinateur évidemment équipé par NVIDIA avec des Tesla K20X. Si la GeForce GTX Titan ne renie pas ses origines, elle n'en demeure pas moins pensée pour les joueurs.

Que peut-on attendre concrètement de cette nouvelle GeForce ? Quelles sont ses performances face bien sûr aux GeForce précédentes mais aussi face à l'offre d'AMD ? AMD dont l'offre n'évoluera pas pour mémoire dans le courant de l'année 2013. Voilà autant de questions auxquelles nous allons tenter de répondre.

Kepler aux stéroïdes

Nous l'écrivions dès l'introduction, au cœur de cette GeForce GTX Titan nous retrouvons une puce GK110. Celle-ci est toujours basée sur l'architecture Kepler inaugurée il y a un an maintenant par le GeForce GTX 680. Nous ne reviendrons donc pas ici sur les détails de l'architecture, préférant vous renvoyer à notre prose de l'époque (voir NVIDIA GeForce GTX 680 : la réponse au Radeon HD 7970 ?).Architecture Kepler oblige, l'agencement de la puce GK110 est très proche de celui observé pour le GK104. À ceci près bien sûr que le GK110 compte plus d'unités de calcul, puisqu'il s'agit là d'un des points clés de la puce. Face au GK104 du GeForce GTX 680, le GK110 voit son nombre de GPC ou Graphic Processing Cluster passer de quatre à cinq. Et chaque GPC renferme non plus deux SMX mais trois SMX. Au total donc, la puce GK110 dispose de 15 SMX, chaque SMX renfermant 192 cœurs CUDA, soit les plus petites unités de calcul de la puce capables de travailler sur les instructions 3D envoyées par les jeux.

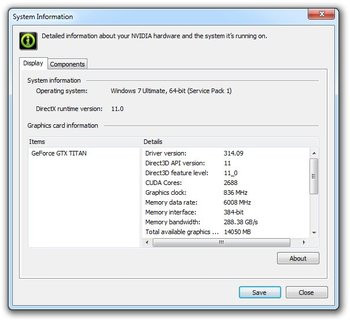

Si physiquement la puce GK110 compte 15 SMX et donc 2880 cœurs CUDA potentiels, NVIDIA a choisi de n'en activer que 14, limitant de fait le nombre total d'unités de calcul à 2688. Avec 14 SMX, la puce GK110 compte tout de même la bagatelle de 224 unités de texture et 48 ROPs (rappelons que les ROPs sont ces unités spécialisées dans les derniers traitements à apporter aux pixels comme le mélange ou l'anticrénelage par exemple). Côté interface mémoire, on passe d'un bus 256 bits pour la GeForce GTX 680 à un bus 384 bits pour le GK110 permettant un gain notable en terme de bande passante théorique alors que NVIDIA couple la puce à 6 Go de mémoire GDDR5. Avec une fréquence mémoire de 1503 MHz, la puce GeForce GTX Titan bénéficie d'une bande passante mémoire théorique impressionnante de 269 Go/s.

Le GeForce GTX Titan vu par les pilotes NVIDIA

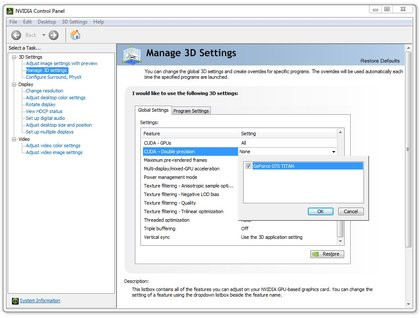

Encore quelques mots d'architecture. Si la puce GK110 ne prend pas en charge DirectX 11.1, elle conserve à son actif les unités de calcul double-précision initialement implémentées pour les puces Quadro et Tesla. Mieux, NVIDIA permet d'activer les unités en question et d'en profiter : cela sera particulièrement utile pour ceux d'entre vous qui ne voient pas en Titan une carte graphique, mais plutôt un monstre de puissance de calcul capable de plier de la protéine avec les applications GPGPU par exemple. Contrairement à un GeForce GTX 680 qui dispose de 8 unités double-précision par SMX, Titan profite de 64 unités double-précision par SMX. Sa puissance en la matière est donc bien supérieure : il peut traiter les calculs double-précision à un tiers du débit simple précision contre 1/24ème avec le GK104. NVIDIA évoque une puissance brute de 1 Teraflop en double-précision. Pour activer les unités DP sur Titan il faudra faire un détour par les pilotes pour cocher l'option « CUDA - Double Precision ». Attention, dans cette configuration, la fréquence de fonctionnement de la puce sera réduite.

Activation des unités Double Precision depuis les pilotes

La puce GK110 : 7,1 milliards de transistors

Avec une telle augmentation du nombre d'unités de calcul, la puce GK110 est tout simplement massive ou monstrueuse. Toujours gravée en 28 nm par TSMC, elle compte pas loin de 7,1 milliards de transistors d'après NVIDIA ! Un chiffre qui donne le tournis : un processeur hexa cœurs Intel, comme le Core i7 3960X, embarque pour sa part seulement 2,3 milliards de transistors...

Puce NVIDIA GK110 : massive tout simplement !

Passé ces considérations, il nous faut revenir aux fréquences de fonctionnement. NVIDIA annonce une fréquence de 837 MHz pour la puce avec un turbo annoncé de 876 MHz. Ce dernier peut du reste flirter ou dépasser le gigahertz suivant les conditions grâce à GPU Boost. Un GPU Boost qui évolue en version 2.0 comme nous allons le détailler dans la page suivante.

| Radeon HD 7970 | GeForce GTX 680 | GeForce GTX 690 | GeForce GTX Titan | |

| Interface | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen3 | PCI-Ex. 16x - Gen3 |

| Gravure | 0,028 µ | 0,028 µ | 0,028 µ | 0,028 µ |

| Transistors | 4,3 Milliards | 3,54 Milliards | 3,54 Milliards (par puce) | 7,1 Milliards |

| T&L | DirectX 11.1 | DirectX 11 | DirectX 11 | DirectX 11 |

| Stream Processors | 2048 | 1536 | 3072 | 2688 |

| Unités ROP | 32 | 32 | 64 | 48 |

| Unités de texture | 128 | 128 | 256 | 224 |

| Mémoire embarquée | 3072 Mo | 2048 Mo | 2048 Mo (par puce) | 6144 Mo |

| Interface mémoire | 384 bits | 256 bits | 512 bits | 384 bits |

| Bande passante | 264 Go/s | 192,26 Go/s | 358 Go/s | 269 Go/s |

| Fréquence GPU | 925 MHz | 1006 MHz (base) | 915 MHz (base) | 837 MHz (base) |

| Fréquence Stream Processors | 925 MHz | 1006 MHz (base) | 915 MHz (base) | 837 MHz (base) |

| Fréquence mémoire | 1375 MHz - GDDR5 | 1502 MHz - GDDR5 | 1502 MHz - GDDR5 | 1503 MHz - GDDR5 |

NVIDIA GPU Boost 2.0

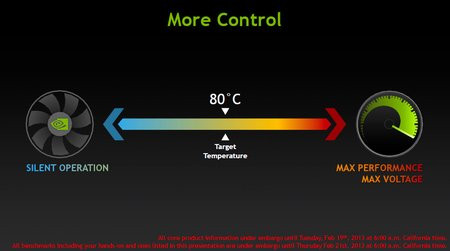

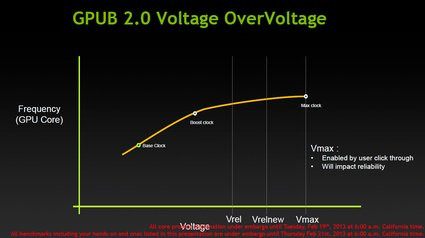

Conscient de certaines limitations, NVIDIA profite du GeForce GTX Titan pour mettre sur les rails la seconde itération de sa technologie GPU Boost. Le principe de base reste le même : augmenter la fréquence de la puce graphique pour améliorer ses performances. Un postulat simple, bien plus simple en vérité que le mode de fonctionnement de la technologie. Dans sa première implémentation, celle-ci augmentait la fréquence de la puce tant que la consommation électrique de cette dernière restait dans une fourchette prédéterminée. Un modus operandi qui s'avérait limitant notamment lorsque la température de la carte était trop faible.

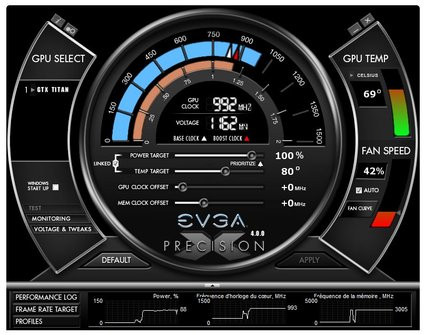

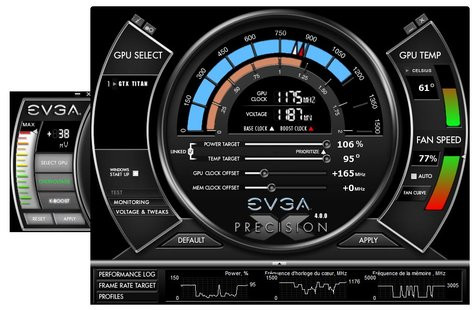

C'est pourquoi la technologie GPU Boost 2.0 ne prend plus le TDP comme valeur de référence, mais la température. Une température fixée à 80° C. En clair : la puce voit ses fréquences et tensions ajustées à la hausse tant qu'elle reste en dessous des 80° C. A partir de 80° C il n'y a tout simplement plus d'overclocking automatique. Cela implique bien sûr un suivi constant de la part de la puce de sa température, et les utilisateurs pourront modifier la température de référence à la baisse ou à la hausse via les utilitaires tiers de type EVGA PrecisionX par exemple. NVIDIA n'a en effet pas cru bon d'inclure ce contrôle directement à ses pilotes graphiques.

PrecisionX qui continue de permettre à l'utilisateur de régler une valeur cible pour la consommation électrique de la carte afin de réguler le comportement du GPU Boost. A ceci près que la valeur ne concerne plus la consommation moyenne typique de la carte mais sa consommation maximale. Dans la pratique, en ajustant la température depuis PrecisionX, on joue également sur le réglage cible de consommation, alors que la température maximale autorisée semble être de 95° C.

Le GPU Boost 2.0 à l'oeuvre avec PrecisionX

Comme on peut le voir, notre GeForce GTX Titan affiche une fréquence Boost de 992 MHz soit une hausse de la fréquence de 13% par rapport aux 876 MHz promis par NVIDIA et un gain d'environ 18% par rapport à la fréquence de base de la puce.

De nouvelles options d'overclocking

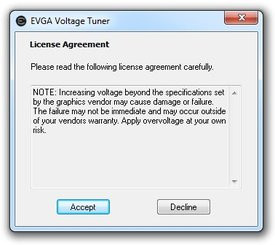

Avec Titan et sa technologie GPU Boost 2.0, que l'on s'attend du reste à retrouver dans de prochaines GeForce, NVIDIA modifie donc le contrôle de l'overclocking. Plutôt que de jouer avec une valeur limite de consommation, l'utilisateur ajustera la limite de température qu'il souhaite ne pas dépasser. Mais ce n'est pas tout. NVIDIA propose également, toujours via les logiciels tiers, d'activer une suralimentation de la puce, overvoltage en anglais. Puisque la fréquence de boost de la puce et sa tension d'alimentation sont dorénavant liées à la température, NVIDIA offre plus de liberté du côté de la tension d'alimentation en permettant d'aller plus haut.

Par défaut, les tensions d'alimentation de Titan se situent dans une fourchette qualifiée par les ingénieurs de NVIDIA. Les utilisateurs les plus curieux pourront aller au-delà avec l'overvoltage en activant une option spécifique des logiciels comme PrecisionX et en cliquant sur un message d'avertissement quant à la dangerosité de l'opération. NVIDIA nous indique que le fait d'accepter cet avertissement ne remet nullement en cause la garantie constructeur. Toutefois les partenaires de la marque peuvent choisir d'autoriser ou non l'overvoltage et d'en contrôler les limites.

Reste qu'en pratique overclocker son Titan n'est pas forcément évident. Il faut déjà intégrer la notion de température qui peut sévèrement limiter l'exercice tout comme les paramètres de tension d'alimentation ou de consommation électrique limite. C'est ainsi qu'il est tout à fait vraisemblable de régler une valeur d'offset pour la fréquence GPU qui reste sans effet parce que la température maximale est déjà atteinte à moins qu'il ne s'agisse de la consommation limite ! Dans les faits, notre exemplaire de test a pu encaisser un overclocking conséquent. En réglant l'offset à 150 MHz nous avons atteint les 1 036 MHz. En poussant un peu, et en augmentant notamment la tension, nous avons atteint les 1 175 MHz. Au prix il est vrai d'une gêne accrue en terme de nuisance sonore puisque nous avons également augmenté la vitesse de ventilation.

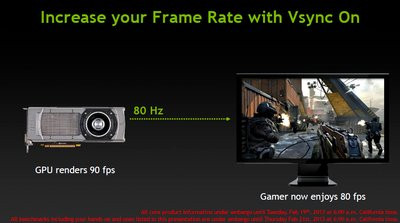

Overclocker son écran ?

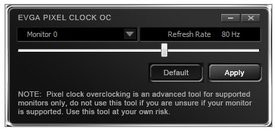

Aujourd'hui la plupart des joueurs activent la synchronisation verticale, en vue de limiter les effets de déchirement à l'écran lors des mouvements rapides. Avec pour conséquence de limiter le framerate à 60 images seconde, la plupart des écrans LCD ayant typiquement un taux de rafraichissement de 60 Hz. NVIDIA propose avec GPU Boost d'overclocker son écran en augmentant son taux de rafraichissement. L'idée n'est pas nouvelle et devrait permettre de gagner en fluidité tout en conservant la synchronisation verticale activée.

Dans les faits, il faut encore passer par un utilitaire tiers proposé par le fabricant de la carte graphique. Celui-ci permet par exemple de régler la fréquence d'affichage à 80 Hz si et seulement si votre écran le supporte. Ici, le succès de l'opération est aléatoire certains écrans supportant la chose d'autres non.

Overclocking de l'écran depuis l'utilitaire EVGA

NVIDIA GeForce GTX Titan : la carte

Pour sa Titan, NVIDIA nous propose une carte qui fleure bon le déjà-vu. La firme au caméléon reprend en effet le design étrenné avec la GeForce GTX 690 et visiblement inspiré de belles mécaniques. Au format double-slot, la carte adopte un PCB noir qui mesure 26,5 centimètres : c'est quasiment 1 centimètre de plus qu'une GeForce GTX 680. Le système de refroidissement est constitué d'un radiateur à ailettes d'aluminium dont le cœur en cuivre renferme une chambre à vapeur. NVIDIA nous indique ici utiliser une nouvelle graisse pour le contact entre la puce graphique et le radiateur dans le but d'améliorer la dissipation et l'efficacité de la chambre à vapeur. Le ventilateur de type cage d'écureuil est situé à l'extrémité de la carte (et non au centre comme avec la GeForce GTX 690) afin d'expulser l'air chaud à l'extérieur du système. NVIDIA insiste sur le choix des matériaux pour son ventilateur, notamment pour amortir les vibrations et autres désagréments, un ventilateur qui s'avère effectivement très discret en fonctionnement.La base du carénage de la Titan comporte une plaque d'aluminium reposant sur divers composants du PCB et permettant là encore une meilleure évacuation de la chaleur. Mais si la partie supérieure du PCB profite de cette plaque d'aluminium, NVIDIA a décidé de conserver le dos de la carte à nu. C'est dommage selon nous d'autant que des puces mémoires sont présentes au dos de la carte.

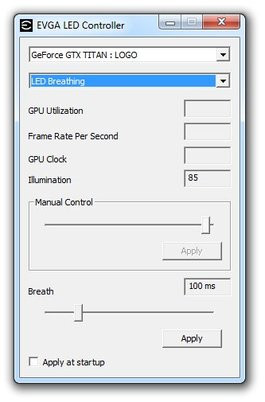

Le carter de cette Titan utilise, comme pour la GeForce GTX 690, des matériaux inhabituels pour une carte graphique à savoir de l'aluminium en lieu et place du plastique. Le radiateur reste visible via une fenêtre en polycarbonate et l'on retrouve sur la tranche de la carte le logo GeForce GTX qui s'illumine de vert dès la mise en route du système. Petite nouveauté : ce rétroéclairage peut être contrôlé par des utilitaires tiers en vue par exemple de lier l'intensité lumineuse à la charge d'utilisation du GPU : plus le GPU travaille plus le logo brille !

Contrôle du rétroéclairage GeForce

Côté alimentation électrique, la carte comporte un connecteur PCI-Express 8 broches et un connecteur PCI-Express 6 broches. On note également la présence de deux languettes SLI alors que la carte embarque 6 Go de mémoire vidéo GDDR5, NVIDIA faisant ici confiance à des puces Samsung. En sortie, ce sont deux connecteurs DVI Dual-link, un port HDMI pleine taille et un connecteur DisplayPort qui nous sont proposés. Sachez enfin que le TDP, ou enveloppe thermique, annoncée pour cette GeForce GTX Titan est de 250 Watts.

Le PCB de la GeForce GTX Titan mis à nu

- Carte mère Asus Maximus Rampage IV Extreme (BIOS 3404),

- Processeur Intel Core i7 3960X,

- 16 Go (4x 4 Go) Mémoire DDR3-1600 Corsair @ 1600,

- SSD Samsung Serie 830 256 Go

Côté pilotes, nous avons utilisé les derniers pilotes 13.2 Beta d'AMD et les derniers pilotes NVIDIA 314.07 pour nos GeForce. Nous retenons deux résolutions pour ce test : le 1920x1080 des écrans 21,6/24 pouces notamment, et le 2560x1600. En prime, nous faisons légèrement évoluer notre protocole de test avec l'inclusion de Far Cry 3, Hitman Absolution sans oublier Call of Duty Black Ops II et le tout dernier 3DMark.

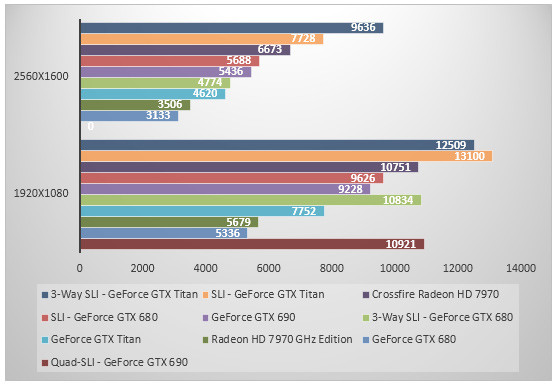

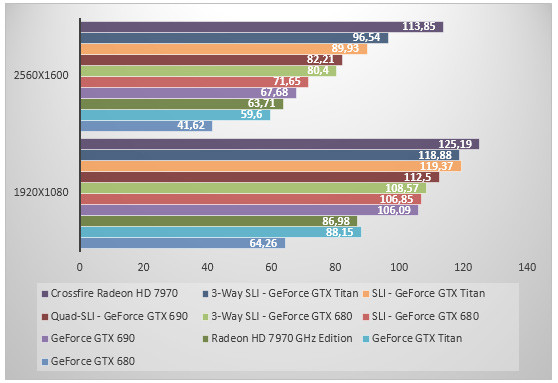

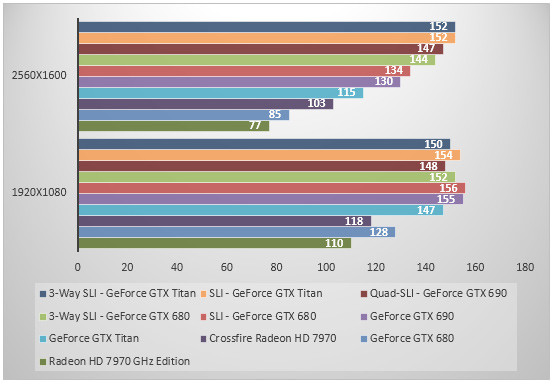

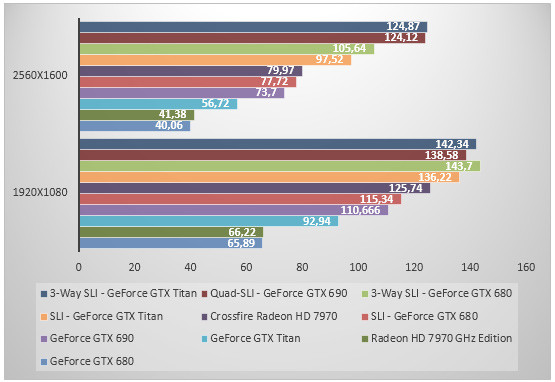

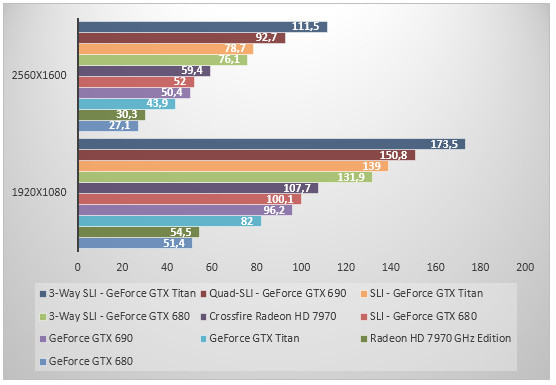

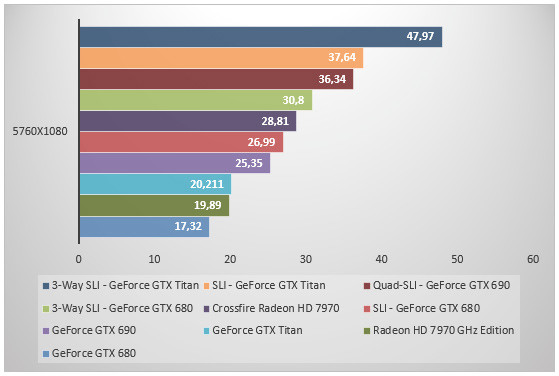

3DMark FireStrike - Extreme

On démarre avec le tout dernier 3DMark, ici exécuté avec les réglages extrêmes. En tête nous retrouvons le 3-Way SLI de GeForce GTX Titan suivi du SLI de GeForce GTX Titan, du moins si nous considérons la résolution la plus élevée. Seule, la GeForce GTX Titan se montre ici 47% plus rapide que la GeForce GTX 680 et vient ainsi taquiner la Radeon HD 7970 GHz Edition. Le passage d'une GeForce GTX Titan à deux GeForce GTX Titan en SLI augmente les performances de 67%. Quant au Quad-SLI de GeForce GTX 690 il déraille en 2560x1600 et est tout bonnement inutilisable... Reste qu'en 1920x1080, le SLI de GeForce GTX Titan fait mieux que notre Quad-SLI de GeForce GTX 690.

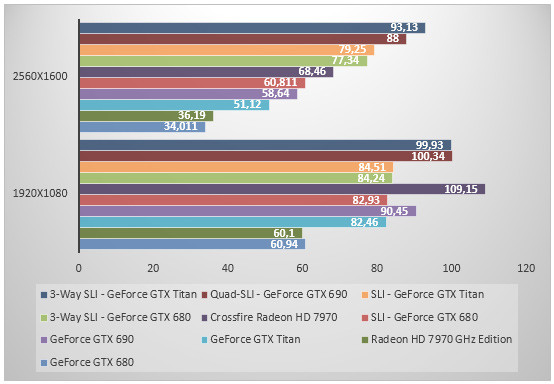

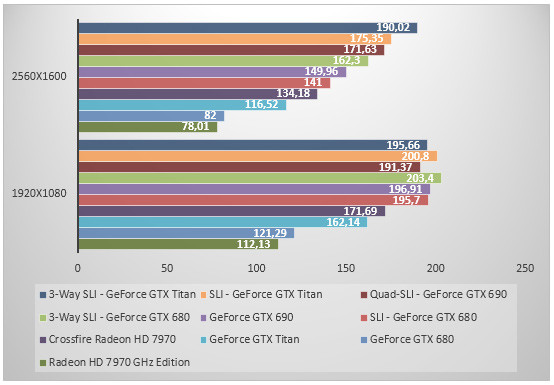

Dirt Showdown - Ultra - 4x

On enchaîne avec le dernier opus de Dirt qui reste largement favorable à AMD malgré les diverses optimisations apportées par NVIDIA à ses pilotes. Nous le testons en mode « Ultra » avec l'option d'éclairage avancé active. La pôle position revient donc au Crossfire de Radeon HD 7970 et ce sans questionnement. En 2560x1600, la GeForce GTX Titan est 43% plus rapide que la GeForce GTX 680. Le SLI de GeForce GTX Titan permet de booster les performances de près de 51%. Quant au 3-Way SLI il permet de grappiller encore 7% de performances face au SLI de GeForce GTX Titan. Quant à notre Quad-SLI de GeForce GTX 690 il ne tient pas la route et baisse pavillon face au SLI GeForce GTX Titan. Il fait tout de même mieux, d'un cheveu, que notre 3-Way SLI de GeForce GTX 680. Face au 3-Way SLI en GeForce GTX 680, le 3-Way SLI de GeForce GTX Titan est 20% plus rapide.

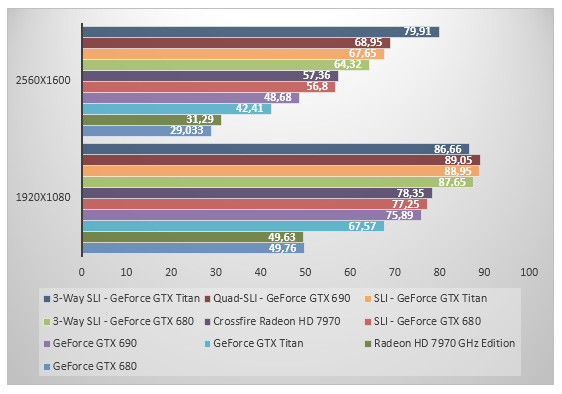

Batman Arkham City - FXAA - MVSS - HBAO

Retour à Arkham City ! En tête nous avons les SLI et 3-Way SLI de GeForce GTX Titan. La troisième place revient au Quad-SLI de GeForce GTX 690. Face au GeForce GTX 680 seul, la GeForce GTX Titan est 35% plus rapide. Dès lors, le gain de performance face à un Radeon HD 7970 GHz Edition à 49%. On retiendra également que le 3-Way SLI de GeForce GTX Titan n'apporte ici strictement rien face au SLI et ce même en 2560x1600. Le SLI augmente quant à lui les performances de 32%.

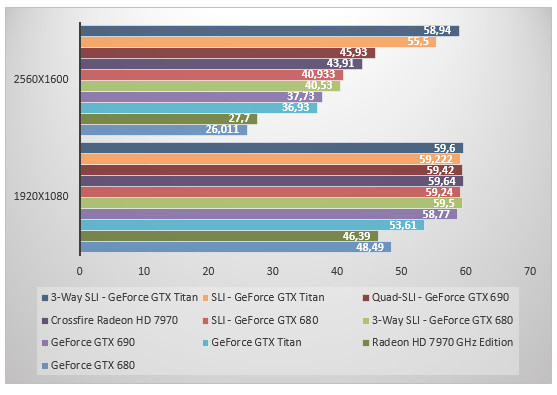

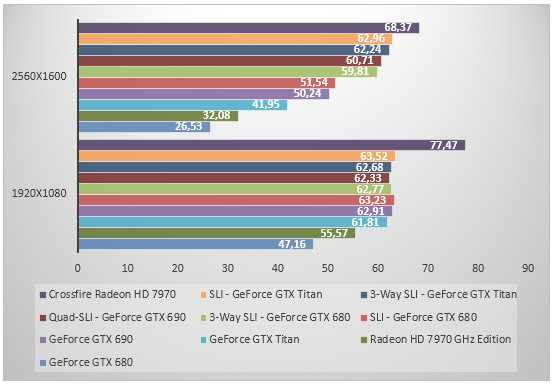

Crysis 2 - DirectX 11 - Ultra - Textures HR

Nous aurons prochainement l'occasion de nous arrêter sur Crysis 3 mais en attendant... nous nous contenterons des performances sous Crysis 2, toujours testé par le biais de FRAPS. Ici, le 3-Way SLI de GeForce GTX Titan domine les débats alors que le Quad SLI de GeForce GTX 690 arrive second (enfin un bench où le Quad SLI n'est pas ridicule !). Un 3-Way de Titan qui permet de gagner 17% de performances face au SLI de GeForce GTX Titan. La petite dernière de NVIDIA est 41% plus rapide que la Radeon HD 7970 GHz Edition et 50% plus performante que le GeForce GTX 680 en 2560x1600 ! Tout de même. Le GeForce GTX 690 conserve un net avantage sur Titan de l'ordre de 15% en 2560x1600 (contre 9% en 1920x1080).

Crysis 3 - v1.2 - Extrêmes

Crysis 3 est sorti dans la foulée du lancement de la GeForce GTX Titan. Nous avons testé l'ensemble de nos cartes avec les derniers drivers alors disponibles (les 314.14 pour NVIDIA et les 13.2 Beta 7 pour ATI) avec le dernier jeu de Crytek, le tout sous FRAPS. Si en 1920x1080, les diverses cartes semblent limitées, ne parvenant pas à dépasser les 60 fps, les résultats sont bien différents en 2560x1600. Ici le 3-Way SLI de GTX Titan s'offre la première place devant le SLI de GeForce GTX Titan. Mais l'écart est faible : le passage du SLI au 3-Way SLI augmente les performances de 6%... pas plus ! Le Quad-SLI se défend et fait à peine mieux qu'un Crossfire de Radeon HD 7970 qui s'affiche ici comme extrêmement intéressant. Quand au GeForce GTX Titan seul il se montre 42% plus rapide que le GeForce GTX 680 mais c'est insuffisant pour talonner le GeForce GTX 690 qui reste plus rapide, d'un cheveu il est vrai (à peine 2%).

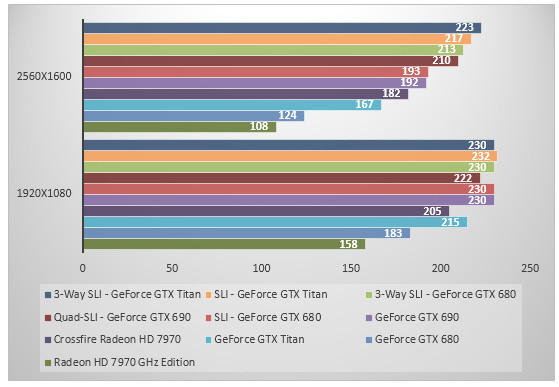

STALKER - Call Of Pripyat - Extrême

Stalker donne sa préférence aux configurations multi-GPU et c'est parfaitement logique. Le 3-Way SLI de Titan est en tête tout comme le SLI en 2560x1600. On notera toutefois que l'écart entre les deux solutions est franchement minime voire en la défaveur du 3-Way SLI en 1920x1080. Dans cette résolution d'ailleurs le 3-Way SLI de GeForce GTX 680 fait aussi bien que celui de Titan. Le SLI de GeForce GTX Titan est 12% plus rapide que le SLI de GeForce GTX 680 et 19% plus rapide que le Crossfire de Radeon HD 7970. Dans tous les cas, le Quad-SLI ne brille guère : tout juste parvient-il à faire mieux que notre SLI de GeForce GTX 680. Seule la GeForce GTX Titan est 34% plus rapide que la GeForce GTX 680 et cet écart grimpe à 54% face au Radeon HD 7970 GHz Edition.

Battlefield 3 - Ultra - AA 4x / AF 16x - Kaffarov

Comme nombre de titres, Battlefield 3 permet de hiérarchiser nos GPU essentiellement en 2560x1600. Rappelons que nous utilisons FRAPS pour évaluer les performances de nos cartes. Le GeForce GTX Titan se révèle 37% plus rapide qu'une Radeon HD 7970 GHz Edition et 41% plus performant que le GeForce GTX 680. Ces très bonnes performances sont insuffisantes pour contrer le GeForce GTX 690 qui demeure 30% plus rapide. En tête, nous retrouvons le 3-Way SLI de GeForce GTX Titan à égalité avec le Quad-SLI de GeForce GTX 690 (oui c'est possible!). Le SLI de GeForce GTX Titan augmente les performances de 72% et parvient presque à taquiner notre 3-Way SLI de GeForce GTX 680. L'écart de performances entre le SLI de GeForce GTX Titan et le 3-Way SLI de Titan est ici de 28%.

Call Of Duty - Black Ops II - AA 8x - FXAA

Retour sur l'une des meilleures ventes de la fin d'année 2012, ici au moyen de FRAPS. Call Of Duty place le 3-Way SLI de Titan en tête avec un gain de performances de 8% sur le SLI de Titan. Le Quad-SLI arrive troisième d'une courte tête devant le 3-Way SLI de GeForce GTX 680. Le SLI de GeForce GTX Titan se montre 31% plus rapide que le Crossfire de Radeon HD 7970. Quant à notre Titan seule, elle se montre 42% plus rapide que la GeForce GTX 680 et 49% plus véloce que la Radeon HD 7970 GHz Edition.

Far Cry 3 - SSAO - MSAA 4x

FarCry 3 fait partie de ces titres testés par le biais de FRAPS. Alors que nos configurations multi-GPU semblent limitées par le processeur en 1920x1080, la résolution de 2560x1600 permet d'observer une véritable hiérarchie. Et surprise le 3-Way SLI de GeForce GTX Titan s'adjuge la première place loin devant notre Quad-SLI de GeForce GTX 690 : 16% d'avance pour le 3-Way SLI tout de même ! Titan confirme ses très bonnes prestations : 46% plus que le GeForce GTX 680 et 35% plus performant que le Radeon HD 7970 GHz Edition. Si ces chiffres impressionnent, cela ne suffit pas à devant un GeForce GTX 690 qui reste 15% plus rapide en 2560x1600.

Hitman Absolution - 4x - Ultra

L'agent 47 aime... le Crossfire de Radeon HD 7970 ! C'est inattendu, mais visiblement les cartes NVIDIA souffrent en multi-GPU d'un problème de performance et ne parviennent jamais à dépasser les 64 fps alors même que la Vsync est désactivée. On retiendra que la GeForce GTX Titan est 30% plus rapide que la Radeon HD 7970 et 58% plus performante que la GeForce GTX 680. Face à Titan, la GeForce GTX 690 conserve un avantage de 19%.

Unigine 4.0

La dernière mouture d'Unigine vise toujours à mettre en exergue les capacités en matière de géométrie et tesselation de nos cartes. Titan excelle ici littéralement avec des performances 62% supérieures au GeForce GTX 680 en 2560x1600 et 45% plus élevées face au Radeon HD 7970 GHz Edition. Si le GeForce GTX 690 reste plus rapide que Titan c'est de 15%. Le 3-Way SLI de GeForce GTX Titan décroche la première marche du podium avec un score 20% supérieur au Quad-SLI de GeForce GTX 690. Face au SLI de GeForce GTX Titan, le 3-Way SLI permet de gagner 42% de performances.

Trois écrans sur trois Titan...

Avec une telle puissance graphique, nous avons tenté de pousser Titan dans ses retranchements en l'adossant à trois écrans. Titan mais pas seulement puisque nous faisons subir le même traitement aux autres cartes de notre comparatif alors que nous nous intéresserons tout particulièrement au 3-Way SLI de GeForce GTX Titan.

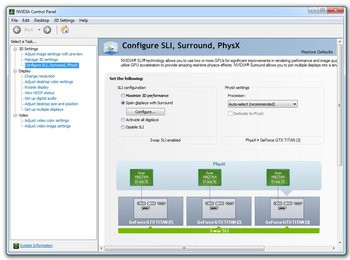

Activation du 3-Way SLI avec des GeForce GTX Titan

Pour activer la fonction Surround (ou l'Eyefinity chez AMD) nous avons recours à trois moniteurs Acer de 27 pouces, des écrans HN274H. Une fois les trois écrans connectés à nos cartes, nous obtenons une surface d'affichage de 5760x1080 pixels ! De quoi faire chauffer nos GPU.

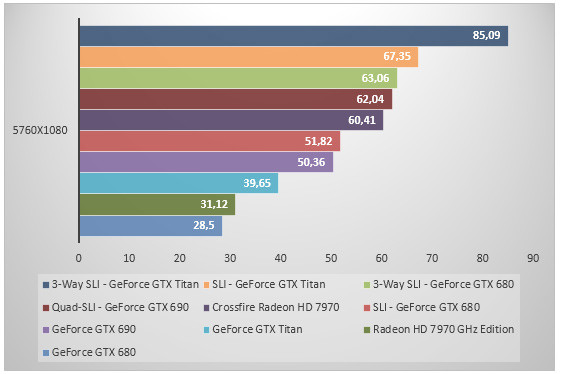

Battlefield 3 - Ultra - AA 4x / AF 16x - Kaffarov

Avec Battlefield 3, c'est logiquement le 3-Way SLI de GeForce GTX Titan que nous retrouvons en tête. Ses performances sont 26% supérieures au SLI de Titan. Le Quad-SLI de GeForce GTX 690 n'impressionne guère tandis que l'écart entre 3-Way SLI de GeForce GTX 680 et 3-Way SLI de GeForce GTX Titan grimpe à 35%. La bonne surprise ici c'est le comportement appréciable du Crossfire de Radeon HD 7970 qui est plus véloce qu'un SLI de GeForce GTX 680 de l'ordre de 16%. Seule, la GeForce GTX Titan est 40% plus rapide que la GeForce GTX 680 et 27% plus performante que notre Radeon HD 7970 GHz Edition.

Far Cry 3 - SSAO - MSAA 4x

Far Cry 3 confirme en 5760x1080 les très bonnes prestations du 3-Way SLI avec un framerate qui flirte avec les 60 images seconde. Reste que la sensation en jeu n'est pas forcément la même du fait de microsaccades spécifiques aux systèmes multi-GPU que nous reproduisons d'ailleurs avec la configuration Crossfire. On retient le bon scaling entre SLI de GeForce GTX Titan et 3-Way SLI : 35% de gain. Du reste on note que seule la GeForce GTX Titan égale quasiment la GeForce GTX 690 ! De son côté le Quad-SLI patauge...

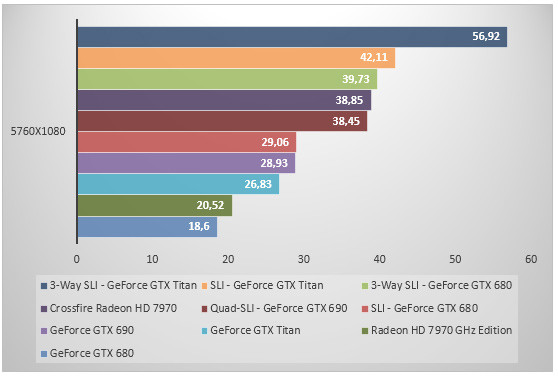

Crysis 3 - v1.2 - Extrêmes

Que donne Crysis 3 en 5760x1080 ? Le 3-Way SLI de GeForce GTX Titan s'adjuge la première place, loin devant le SLI avec un écart de 27%. Pour autant n'allez pas croire que l'expérience de jeu est fluide dans cette résolution. Quand bien même le framerate très honorable, on constate des micro-freeze bien trop réguliers qui viennent clairement gâcher le plaisir. Un phénomène propre aux configurations multi-GPU que l'on observe aussi sur la solution Crossfire mais dans une moindre mesure. Ces temps de latence sont particulièrement flagrants avec la configuration 3-Way SLI et le Quad-SLI de GeForce GTX 690. Seul, le GeForce GTX Titan fait ici aussi bien qu'une Radeon HD 7970 ce qui surprend. Et face au GeForce GTX 680, le gain de performance est de 17%.

Mafia II - AA - AF 16x

Mafia II nous permet de vérifier le comportement de nos cartes en 5760x1080 avec des titres qui ne sont plus tout jeunes. Ici le 3-Way SLI de Titan est en tête mais de très peu : un avantage de 3% face au SLI de Titan et le Quad-SLI de GeForce GTX 690 parvient à s'intercaler entre nos configurations les plus véloces. A noter qu'utilisée seule la GeForce GTX 690 propose des performances 18% supérieures à la GeForce GTX Titan. Cette dernière étant assez constante dans sa comparaison avec la GeForce GTX 680 puisqu'elle offre une fois encore 40% de performance en plus !

Tom Clancy's H.A.W.X. 2 - DirectX 11

H.A.W.X. 2 place contre toute attente le Quad-SLI de GeForce GTX 690 en tête alors que le 3-Way SLI de GeForce GTX Titan est juste derrière. Globalement le gain entre SLI et 3-Way SLI est bien trop timoré ici pour être justifié : à peine 2%. On retient toutefois que le SLI de GeForce GTX Titan devance le 3-Way SLI de GeForce GTX 680. Du côté des cartes seules, la Titan reste la plus rapide : 13% de performances en plus face au Radeon HD 7970 GHz Edition et 18% face au GeForce GTX 680.

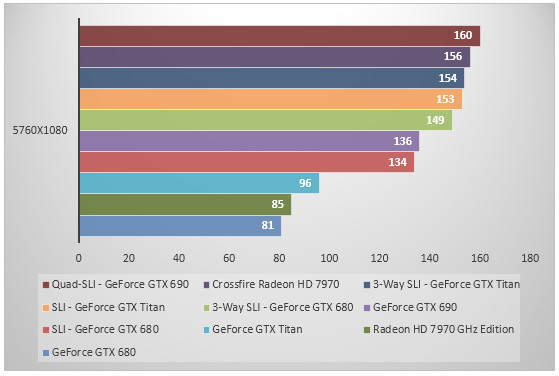

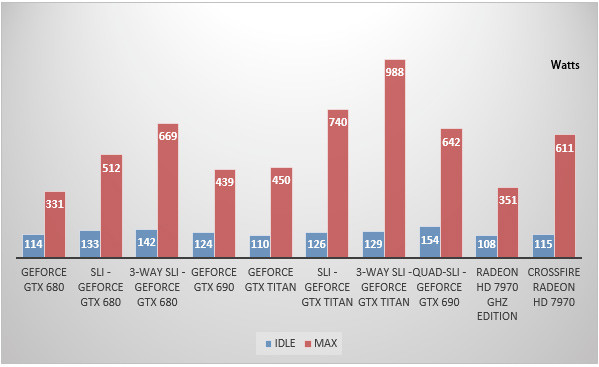

Consommation

Nous avons bien sûr eu à coeur de vérifier la consommation électrique du GeForce GTX Titan. Pour ce faire nous mesurons la consommation électrique globale de la machine au moyen d'un wattmètre. La consommation est mesurée à la prise, avec deux relevés : au repos sur le bureau Windows puis en charge lors d'un 3DMark un tantinet intensif.

Il en ressort une consommation en charge de 450 Watts pour notre système avec une GeForce GTX Titan soit à peu de choses près la même consommation qu'avec la GeForce GTX 690. De fait face aux autres cartes mono-GPU de notre comparatif, la consommation en charge de Titan paraît bien supérieure. Mais ramené au ratio performance/watt, cela serait presque raisonnable. Notre système muni d'une GeForce GTX 680 ne consomme pour sa part que 330 Watts contre 350 Watts pour une Radeon HD 7970 GHz Edition. Le 3-Way SLI de GeForce GTX Titan réussit pour sa part à engloutir pas loin de 988 Watts en charge ! Au repos, la consommation électrique de Titan paraît correcte mais pas aussi basse que celle d'une Radeon HD 7970 GHz Edition par exemple.

Conclusion

Entre le prix mirobolant, annoncé à 1000 euros TTC, et le nom commercial de la carte « GeForce GTX Titan », il y a de quoi perdre son latin. Commençons par évoquer le sujet qui fâche : le prix. Pour l'utilisateur celui-ci est déroutant car il place la GeForce GTX Titan au même niveau de prix que la GeForce GTX 690 pourtant dotée de deux GPU. Pour NVIDIA il s'agit précisément d'affirmer qu'un GPU puissant comme celui de la Titan a en quelque sorte une valeur plus élevée que deux GPU. Et nul doute qu'en effet la puce GK110 du Titan est monstrueuse et donc coûteuse d'autant que la marque l'accompagne de 6 Go de mémoire vidéo et d'une finition remarquable sur laquelle nous reviendrons. Qui plus est, la dénomination commerciale de la carte, en dehors des gammes habituelles, permet à NVIDIA de positionner son Titan comme une carte sortant de l'ordinaire et donc confinant à la série limitée. Et c'est précisément parce que NVIDIA ne va fabriquer qu'un certain nombre de cartes que la marque peut s'offrir le luxe de les proposer à ce tarif, qui il faut bien l'écrire trouvera de toute façon preneur auprès d'une audience évidemment confidentielle.

Et ne vous y trompez pas, si la Titan trouve ses racines dans le monde des supercalculateurs, offrant même la possibilité d'exploiter ses unités double-précision pour les scientifiques, c'est bien le monde du jeu vidéo qui est visé par NVIDIA. À défaut de s'adresser à tout un chacun, la GeForce GTX Titan s'affiche sans conteste comme la carte graphique la plus rapide du moment. Le processeur qui l'anime n'y est pas étranger : c'est une véritable débauche de transistors, plus de 7 milliards, et d'unités de calcul (jusqu'à 75% de plus que dans le GK104) ! Et dans les faits, la puce se paye le luxe d'être entre 40 et 50% plus rapide que le GeForce GTX 680 notamment. Il est vrai qu'elle est aidée par les très généreux 6 Go de mémoire vidéo. Face à cet arsenal, AMD ne peut pas vraiment lutter, le Radeon HD 7970 GHz Edition ne faisant clairement pas le poids.

Reprenant la finition exemplaire de la GeForce GTX 690, la GeForce GTX Titan s'avère relativement silencieuse en fonctionnement, ce qui reste appréciable. En revanche, et c'est assez logique au vu de la complexité de la puce, la consommation électrique augmente. Et si la valeur absolue paraît élevée, elle reste acceptable ramenée au ratio performance/watt. Parallèlement la température devient le paramètre permettant dorénavant de réguler la technologie d'overclocking automatique GPU Boost qui passe en version 2.0. Une version 2.0 qui nous paraît intéressante sur le papier même si la valeur retenue par NVIDIA, à savoir une température de 80°C, est bien trop vite atteinte... particulièrement dans les configurations à deux ou trois GPU. Il faut donc modifier manuellement cette valeur pour espérer tirer le meilleur de sa Titan.

Et puisque nous nous sommes penchés sur la question du 3-Way SLI, si l'on salue la prouesse technologique qui en tant que telle n'est pas nouvelle, l'intérêt nous semble aujourd'hui surtout se trouver dans les solutions trois écrans. Ainsi quand le 3-Way SLI permet péniblement de gagner 18% de performances face à un SLI de GeForce GTX Titan en 2560x1600, l'écart grimpe à 35% en faveur du 3-Way SLI en 5760x1080. Du reste, on aura aisément pu constater que le 3-Way SLI donne le meilleur de lui-même avec les jeux les plus récents et les plus gourmands, son apport étant parfois nul dans les faibles résolutions ou avec des jeux anciens.

En définitive, NVIDIA signe avec la GeForce GTX Titan une carte graphique d'exception basée sur un processeur impressionnant. Il faut dire qu'avec une base comme le GK110 déjà à l'œuvre sur les cartes professionnelles Tesla notamment, c'était quasiment pari gagné pour NVIDIA. Finalement, cette GeForce GTX Titan est si impressionnante que nous aurions aimé qu'elle soit accessible à toutes les bourses. Ce n'est hélas pas le cas et c'est dommage. Le positionnement retenu par NVIDIA, qui semble ignorer la crise, place la Titan hors de portée du commun des mortels. À défaut donc d'être accessible, la GeForce GTX Titan fera assurément rêver. Et c'était peut-être bien là le but recherché par NVIDIA.