C'est la question que se sont posés des scientifiques du MIT, qui ont créé une IA complètement psychopathe en l'exposant à des données graphiques et morbides.

Une intelligence artificielle psychopathe

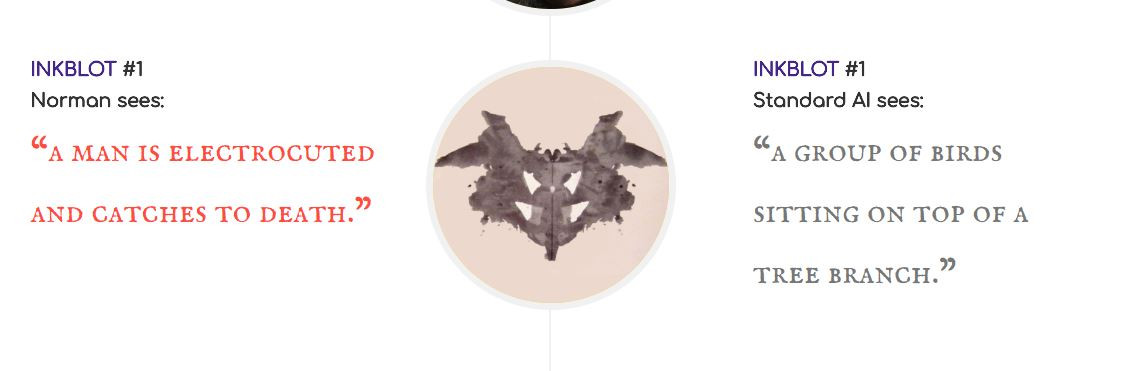

Créée par des scientifiques du MIT dans le cadre d'une expérience, Norman est la première intelligence artificielle à voir le côté sombre des choses. Cette intelligence artificielle a été exposée aux "coins les plus sombre de Reddit" et est en fait une étude de cas sur les dangers de l'IA, dans le cas où des données biaisées sont utilisées pour nourrir les algorithmes de machine learning.Concrètement, Norman est formée pour effectuer du sous-titrage d'images. Cette intelligence artificielle a été exposée à des données biaisées, provenant d'un Reddit dédié à "documenter et observer la réalité dérangeante de la mort". Ses réponses ont ensuite été comparées avec celles données par une intelligence artificielle plus habituelle, sur des taches d'encre de Rorschach, souvent utilisées par les psychologues pour évaluer l'état d'esprit d'un patient.

Là où l'IA "normale", voit un groupe d'oiseaux assis au sommet d'un arbre, Norman voit quelqu'un être électrocuté. Quand l'IA "normale" voit un couple de personnes debout côte à côte, Norman voit un homme sauter d'une fenêtre. Pour l'ensemble des taches d'encre, Norman s'est donc illustrée en proposant des descriptions très graphiques et morbides. Vous pouvez retrouver l'ensemble de ces descriptions sur le site dédié à Norman.

De l'importance des données pour l'IA

En fait, l'expérience visait à prouver que les données sont plus importantes que l'algorithme en tant que tel. Comme l'indique l'équipe de chercheurs sur le site de présentation, "lorsque les gens parlent des algorithmes d'intelligence artificielle qui sont biaisés et peu justes, le coupable n'est souvent pas l'algorithme lui-même, mais les données avec lesquelles il a été nourri". Il s'agit donc d'une étude de cas pour montrer que l'intelligence artificielle peut mal tourner en fonction des données de départ sur lesquelles elle se base. Une étude de cas plutôt réussie, n'est-ce pas ?Par chance, VOUS pouvez aider Norman à aller mieux en remplissant un sondage permettant de nourrir Norman avec des descriptions moins négatives.