Un groupe de chercheurs américains a publié un rapport pour alerter l'opinion publique quant aux risques engendrés par le recours de plus en plus fréquent aux logiciels d'intelligence artificielle. Ceux-ci seraient notamment employés pour des entretiens d'embauche à distance et promettraient une reconnaissance des émotions du candidat, en dehors de tout fondement scientifique.

L'AI Now Institute (AI Now) est un groupe de recherche de l'université de New York (États-Unis), qui étudie les implications de l'intelligence artificielle sur la société. Dans son rapport annuel publié aujourd'hui, il attire l'attention sur les conséquences néfastes des nouvelles technologies utilisées, qui auraient pour effet de creuser les inégalités.

Recrutement et reconnaissance des émotions

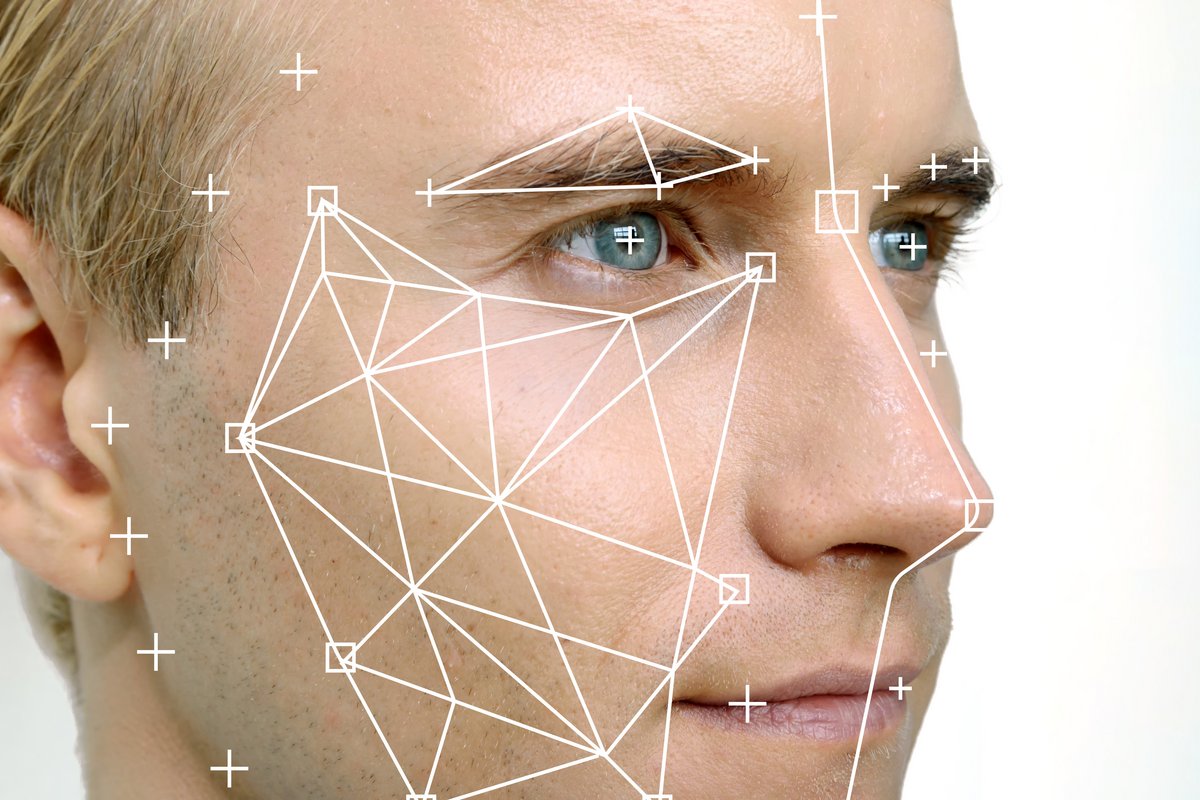

Parmi les usages les plus dangereux, selon les chercheurs, figure la reconnaissance faciale, et, plus précisément, l'identification automatique d'émotions. De tels systèmes commenceraient à être employés par les entreprises, pour leurs recrutements, mais également par des services médicaux ou par les autorités publiques.L'organisme américain cite l'exemple de la société HireVue, qui propose une solution de vidéoconférence pour les entretiens d'embauche. La solution, déjà utilisée par de grandes entreprises telles qu'Unilever ou Hilton, embarquerait une intelligence artificielle capable de reconnaître les émotions des individus, en analysant les mouvements du visage, le ton de la voix ou le débit de parole. Les résultats seraient alors communiqués à l'employeur, mais jamais au candidat. Une approche qui ne reposerait pas sur une démarche véritablement scientifique, d'après AI Now.

Les biais de la technologie

De son côté, HireVue n'a pas souhaité apporter de commentaires sur cette accusation. L'entreprise a toutefois indiqué que sa technologie permettait de contourner les biais humains intervenant dans le recrutement. Une affirmation qui ne serait que partiellement vraie.En effet, si le recours à un logiciel doit théoriquement garantir une meilleure objectivité, les programmes reposant sur l'IA doivent préalablement être entraînés sur des jeux de données. Or, cette phase d'apprentissage s'appuie sur un état actuel de la situation. Ainsi, par exemple, si des discriminations ont conduit à empêcher des femmes d'accéder à certains métiers, un logiciel pourra avoir tendance à privilégier les hommes pour le même type de poste, aggravant ainsi les discriminations initiales.

Par ailleurs, AI Now rappelle que la manifestation des émotions peut grandement varier selon les cultures. Ces nuances ne seraient pas suffisamment prises en compte par la technologie aujourd'hui, rendant l'analyse peu fiable et pouvant, une nouvelle fois, entraîner des discriminations.

En conséquence, les chercheurs appellent les entreprises à limiter leur recours à l'intelligence artificielle et les gouvernements à encadrer strictement son utilisation et ce, jusqu'à ce que les risques associés soient pleinement mesurés.

Source : Reuters