La technologie de la détection de visage est connue depuis des années maintenant. Ce domaine de la reconnaissance d'objets ou d'être humain par la machine continue cependant son évolution, avec des multinationales telles qu'Amazon en fer de lance. L'API de reconnaissance du groupe, baptisée Rekognition, peut désormais déceler une nouvelle émotion : la peur.

Ce nouvel apport donne une idée de ce qu'a déjà apporté le deep learning, tout en posant de nouvelles questions éthiques.

Une nouvelle émotion au programme

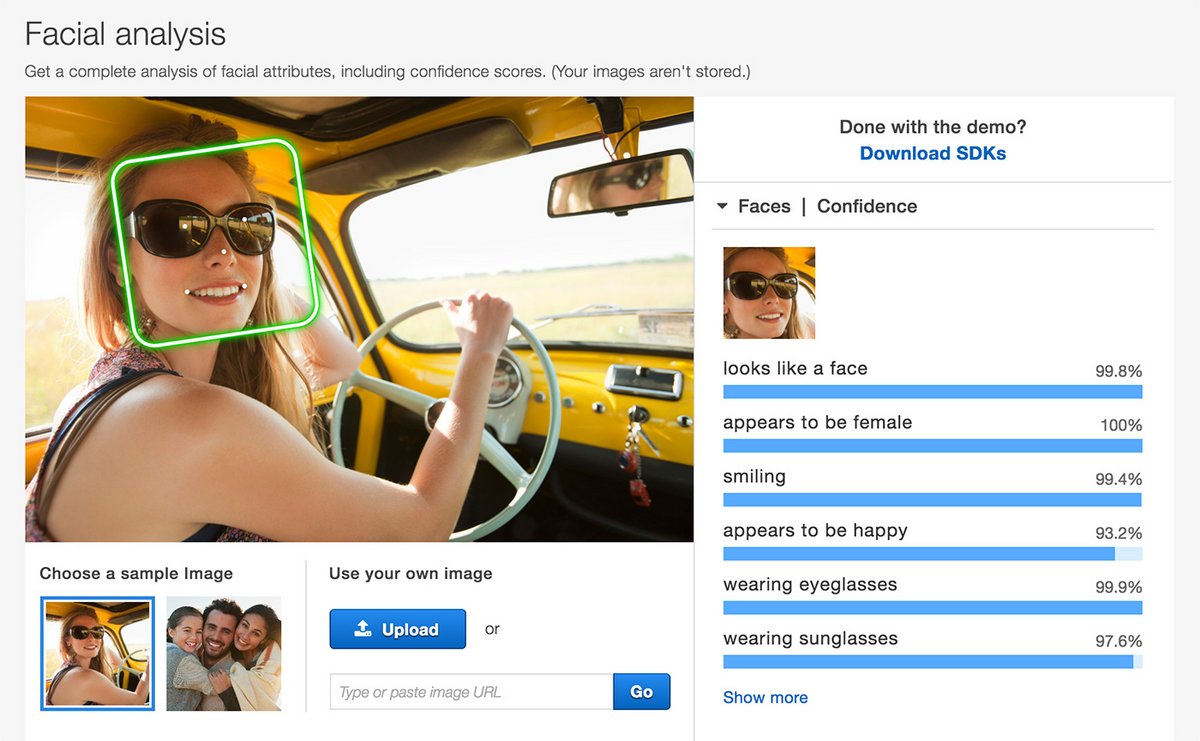

Rekognition fait partie des Amazon Web Services. C'est une application Web qui peut, à partir d'une image ou d'une vidéo, reconnaître une multitude d'éléments concernant les êtres humains : sexe, tranche d'âge, caractéristiques du visage, etc. Elle peut ainsi déterminer, dans le cas d'une célébrité, à qui elle a affaire. Les dernières mises à jour ont d'ailleurs amélioré l'estimation de la tranche d'âge et du sexe, et lui ont ajouté la possibilité de détecter des contenus violents (comme le sang, les armes, les cadavres ainsi que le contenu érotique ou pornographique).L'application peut également déceler des émotions. Amazon résume la nouveauté de cette façon : « Nous avons amélioré la précision de la détection des émotions ("Joie", "Tristesse", "Colère", "Surprise", "Dégoût", "Calme" et "Confusion") et ajouté une émotion, "Peur" ». C'est ici que le géant du e-commerce est confronté à un dilemme d'ordre éthique et moral.

Déceler le visage d'une personne « calme » ou « joyeuse » n'a pas tant d'intérêt en soi. Mais d'après Amazon, le deep learning peut désormais fournir à un ordinateur les clés pour détecter la peur. Dans ce cas, on peut imaginer des caméras utiles pour repérer plus rapidement, par exemple, un braquage en cours. La reconnaissance faciale étant toujours plus perfectionnée, elle pourrait aussi aider à retrouver le suspect de ce braquage, à partir de sa photo ou d'un enregistrement vidéo.

Lire aussi :

La reconnaissance faciale d'Amazon, Google et Microsoft dans le collimateur de 90 associations

La reconnaissance faciale d'Amazon, Google et Microsoft dans le collimateur de 90 associations

Un débat déjà sur la table

De telles caméras n'existent pas encore, mais la possibilité pour un ordinateur de déceler la peur est une nouvelle étape posant, une fois de plus, la question de la limite entre liberté et sécurité. Que se passera-t-il dans le cas d'un piratage d'un tel système ?Sur le blog du groupe, Brad Smith, le président de Microsoft (et homme de loi), écrit : « Cette technologie apporte d'importants et même d'excitants bénéfices sociaux, mais aussi d'éventuelles dérives ».

Amazon, de son côté, ne semble pas de cet avis. Pour la compagnie, l'abus reste marginal. Elle a déclaré dans un communiqué : « Notre qualité de vie sera bien pire si, aujourd'hui, nous définissons une technologie comme hors-la-loi simplement parce que quelques personnes décident d'en abuser. Imaginez si des clients ne pouvaient pas acheter un ordinateur au prétexte qu'il est possible de l'utiliser à des fins illicites ? ». Avant d'ajouter : « Comme tous les services d'AWS, nous attendons de nos clients qu'ils les utilisent en conformité avec la loi, et d'être responsable lorsqu'ils utilisent Amazon Rekognition ».

Source : The Next Web