Des chercheurs sont parvenus à tromper plusieurs systèmes d'aide à la conduite, en projetant des images 2D sur la trajectoire des véhicules ou au bord de la route. Ils ont ainsi pu pousser les voitures à freiner ou à changer de direction, un comportement qui pourrait mettre en danger leurs conducteurs ou les autres usagers.

Une récente étude universitaire a mis en exergue un nouveau défaut de sécurité sur les systèmes d'aide à la conduite de plusieurs véhicules. En l'occurrence, les scientifiques ont testé deux technologies : l'Autopilot de la Tesla Model X HW 2.5 et Mobileye 630 PRO, employé notamment chez Renault, Honda ou Mazda.

Suivre les mauvaises lignes ou de faux panneaux

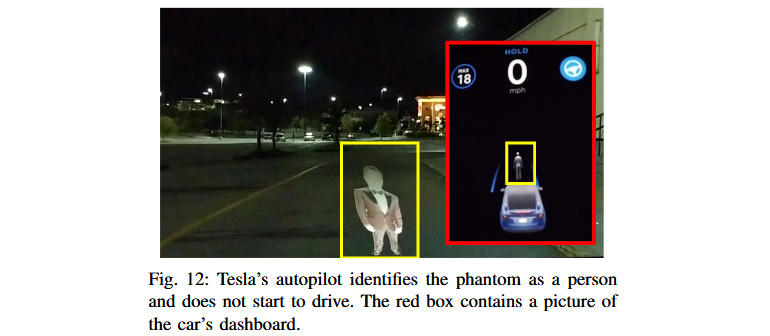

Le principe de leurs expériences était plutôt simple : projeter des images en 2D sur la route, ou au bord de celle-ci, et observer la réaction automatique des voitures. Et les résultats obtenus ne sont pas vraiment rassurants.Ainsi, les deux systèmes ont été incapables de différencier une projection d'un individu ou d'un véhicule d'un véritable obstacle. Ils ont à chaque fois décidé de ralentir ou de freiner. Plus dangereux encore, les chercheurs ont projeté des lignes factices sur la route, qui ont alors été confondues avec le vrai marquage au sol, entraînant un changement de trajectoire dont les conséquences pourraient être dramatiques.

General Motors dévoile des navettes autonomes, mais elles ne sont pas pour tout de suite

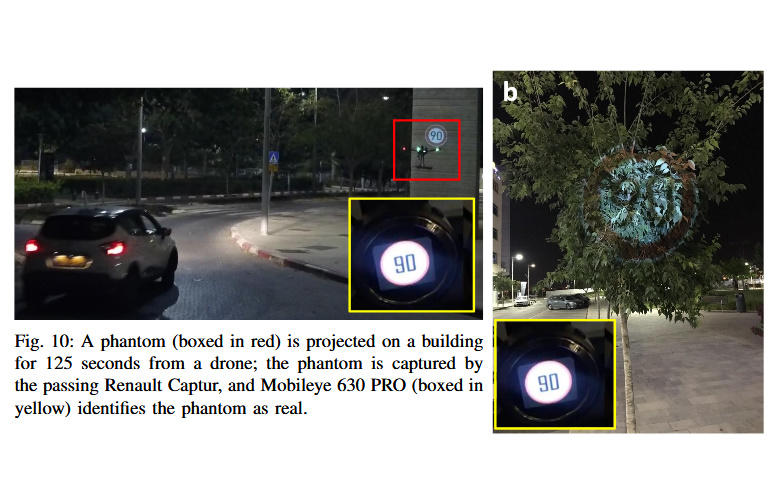

Et la manœuvre fonctionnait également sur le bord de la route. Les systèmes d'aide à la conduite ont en effet été trompés par des images de panneaux de signalisation, adaptant alors leur vitesse à ces fausses indications. Un stratagème qui s'est révélé efficace dans le cas d'une projection sur un mur ou sur un arbre, mais aussi en intégrant le panneau factice au sein d'une publicité vidéo diffusée sur le mobilier urbain.

De potentielles attaques invisibles ?

D'après les auteurs de l'étude, ces failles sont d'autant plus inquiétantes qu'elles nécessitent peu de moyens pour être exploitées. Il suffit d'un projecteur vendu dans le commerce, porté à la main ou installé sur un drone, pour détourner la trajectoire d'un véhicule.De plus, de telles attaques pourraient survenir, tout en étant invisibles à l'œil nu. Car les scientifiques indiquent qu'une exposition de quelques centaines de millisecondes seulement aux fausses images pourrait suffire à leurrer l'Autopilot ou Mobileye 630 PRO.

Les constructeurs auraient été prévenus de ces dysfonctionnements, mais n'auraient pas encore apporté de solution. Charge à eux désormais de résoudre le problème, peut-être en s'inspirant des technologies de reconnaissance faciale, capables de distinguer un visage humain d'une photo.

Source : ZDNet