En début de mois, NVIDIA lançait Maxwell sur deux cartes situées dans le milieu de sa gamme. Les puces mobiles de NVIDIA connaissent le même sort : sur la nouvelle gamme des GeForce 800M, seules les GeForce GTX 850M et 860M, ainsi que les GeForce 830M et 840M bénéficient de la dernière architecture graphique du caméléon et encore attention car la GeForce GTX 860M existe en deux versions sous le même nom avec architecture Kepler ou Maxwell.

L'année dernière, NVIDIA avait lancé sa série 700M dans un premier temps (le premier avril), avant d'annoncer les GTX 700M, fin mai. Cette fois, le constructeur a choisi de présenter toute sa gamme en même temps, mais la GTX 880M que nous testons aujourd'hui se base donc sur Kepler.

Est-ce à dire que le caméléon a procédé à un simple renommage de son GeForce GTX 780M ? Pas forcément. D'une part parce que le constructeur revendique une hausse des fréquences, tant au niveau de la mémoire embarquée qu'à celui des cœurs CUDA. D'autre part, parce que les GeForce GTX 800M inaugurent un certain nombre de fonctionnalités articulées autour du GeForce Experience.

Quelles sont ces fonctionnalités, et quelles sont les performances de la GTX 880M ? C'est l'objet de ce dossier.

Carte graphique : découvrez des offres à bas prix sur notre comparateur de prix !

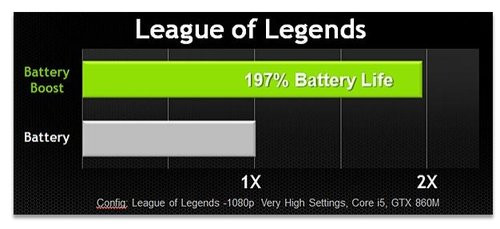

La principale innovation, réservée aux puces mobiles, se nomme Battery Boost. Résumons l'idée : la technologie de NVIDIA est censée augmenter l'autonomie en jeu en ajustant les fréquences de la mémoire et des cœurs CUDA du GPU, ainsi que celles du processeur. Vous choisissez un framerate cible constant (30 fps par exemple), et l'algorithme concocté par NVIDIA ajuste ces paramètres automatiquement.

En visant au plus juste, le caméléon a ainsi pour objectif de réduire la consommation du GPU et du CPU, augmentant de fait l'autonomie des ordinateurs portables équipés d'une GeForce GTX 800M. D'après ses dires, leur durée de vie pourrait être doublée.

Battery Boost requiert le logiciel GeForce Experience. C'est en effet dans cette interface que vous trouverez le fameux réglage du framerate qui devrait vous permettre de gagner de précieuses minutes. Vous choisissez un nombre de fps cible, puis vous lancez votre jeu. Pour le moment, ce paramètre est appliqué à l'ensemble de vos jeux, mais NVIDIA proposera rapidement des profils spécifiques.

Notez enfin que cette technologie est compatible avec les GPU Boost 2.0 et Optimus de NVIDIA. Voilà les informations fournies par le constructeur concernant son Battery Boost, puisque ce dernier préfère ne pas entrer dans le détail.

Nous avons évidemment posé quelques questions supplémentaires à NVIDIA, auxquelles le caméléon n'a pas souhaité répondre. Il nous est ainsi impossible de dire si Battery Boost est une solution uniquement logicielle ou si elle comporte une partie hardware. Et le fait que cette technologie ne soit disponible que sur les GTX 800M ne constitue pas franchement un indice.

NVIDIA ne précise pas non plus comment sa technologie agit sur le processeur, ni avec quels processeurs (Intel ? AMD ?) elle est compatible. Concernant la puce graphique, sur laquelle le caméléon a probablement plus de latitude, impossible de savoir non plus s'il est prévu une fréquence maximale pour les cœurs CUDA ou la mémoire.

Enfin, et même si NVIDIA ne l'évoque pas, on peut aussi se demander si le constructeur n'est pas en mesure de couper certains SMX pour diminuer la consommation.

Battery Boost en pratique

Une fonction automatique dont NVIDIA ne souhaite pas livrer les détails : voilà de quoi attiser notre curiosité. Pour tenter d'en savoir plus sur cette technologie, nous avons effectué quelques tests. Afin, d'une part, de comprendre, du moins en partie, son fonctionnement, mais également d'en mesurer l'apport.Nous avons donc utilisé un utilitaire (HWInfo) capable d'enregistrer, notamment, les fréquences de la mémoire et des cœurs d'exécution de la puce graphique, ainsi que celles des cœurs du processeur.

Ces tests ont été réalisés avec et sans Battery Boost, sur deux jeux : Dirt Showdown et Bioshock Infinite, deux titres qui ont l'avantage de disposer d'un outil de mesure intégré capable de fournir des scènes reproductibles.

Faites chauffer le CPU !

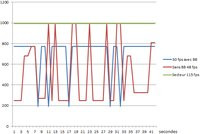

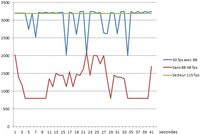

Nous vous faisons grâce de l'analyse des 28 fichiers qui nous ont permis de tirer nos conclusions et préférons ce petit résumé en 3 graphiques qui représentent, de gauche à droite, la fréquence des cœurs CUDA, celle de la mémoire qui leur est associée et enfin celle du processeur Intel. Ces graphiques correspondent à nos tests sous Dirt : Showdown, en 1080p et avec un niveau de détails intermédiaire. Sachez que nous avons également utilisé un niveau de détails très bas, et refait ces deux tests en 1366x768. La même procédure a été suivie sous Bioshock Infinite. Voici nos trois conditions de test :- avec le portable branché au secteur ;

- sur batterie, sans Battery Boost ;

- sur batterie toujours, mais en activant la nouvelle technologie NVIDIA avec une valeur cible à 30 fps.

Lorsqu'on regarde les valeurs prises par la fréquence des cœurs CUDA, on remarque que si la valeur de 954 MHz est effectivement atteinte de façon constante en charge, ce n'est que plus rarement le cas lorsque le ROG 750 est sur batterie. Et lorsque Battery Boost est activé, la fréquence plafonne à 770 MHz, alors qu'elle est également capable de descendre plus bas dans les tours.

Ces nivellements sont encore plus visibles sur la fréquence de la mémoire du GPU : sur ce test, elle est stabilisée à 400 MHz lorsque Battery Boost est actif, alors qu'elle évolue entre 200 et 1 000 MHz sans la fonction de NVIDIA et reste fixée à 1 250 MHz lorsque le portable est sous tension.

Sur le graphique représentant la fréquence du processeur Intel enfin, on observe une nouvelle fois une valeur fixe (à 3,2 GHz) lorsque le ROG 750 est en charge. En revanche, les observations s'inversent par rapport aux deux autres graphiques : ici, lorsque Battery Boost est activé, les fréquences prennent les valeurs plus élevées que lorsque la technologie de NVIDIA ne fonctionne pas.

D'après cette étude, il semblerait donc que l'algorithme concocté par NVIDIA impose un seuil aux fréquences de son GPU (cœurs CUDA et mémoire) et utilise de façon plus intensive le processeur. Le caméléon compterait-il sur le bon rapport performances / watts des processeurs de génération Haswell pour réduire la consommation en jeu ?

Un algorithme parfois inadapté

Ces indicateurs de performances que sont les fréquences de fonctionnement se reflètent naturellement dans le nombre d'images par seconde. Voici quelques-unes des mesures que vous avons prises sur nos deux titres :| 1080p, détails sur moyen | Dirt : Showdown | Bioshock Infinite |

| Sur secteur | 115 fps | 127 fps |

| Sur batterie, sans Battery Boost | 48 fps | 40 fps |

| Sur batterie, Battery Boost à 30 fps | 37 fps | 30 fps |

| Sur batterie, Battery Boost à 45 fps | 55 fps | 40 fps |

Ces quelques valeurs sont riches d'enseignements :

- on remarque tout d'abord, comme nous l'avions évoqué plus haut, que l'on perd une bonne part des performances de la machine lorsqu'on la déconnecte du secteur ;

- on apprend également que Battery Boost ne vise pas forcément juste à chaque fois : pour 30 et 45 fps demandés, on obtient 37 et 55 images par seconde sous Dirt : Showdown ;

- toujours sur ce titre, notez à ce propos que le résultat avec la cible 45 fps est supérieur à celui obtenu sans la technologie de NVIDIA (48 contre 55 fps) ;

- c'est loin d'être le cas sous Bioshock Infinite, pour lequel la cible à 45 fps ne donne que 40 fps réels.

La différence de résultats entre nos deux titres, ensuite, trouve son explication dans le fonctionnement de leurs moteurs graphiques respectifs. En effet, Dirt : Showdown est particulièrement sensible aux fréquences du CPU. Lorsque Battery Boost pousse les fréquences de ce dernier, le nombre de fps s'en ressent fortement. Tant et si bien que même en sous-cadençant la puce graphique, on obtient un nombre de fps supérieur à celui demandé, et même supérieur à celui observé sans la technologie NVIDIA.

Bioshock utilise davantage le GPU que Dirt Showdown et ne souffre pas de cette anomalie. Battery Boost est donc plus adapté aux moteurs qui ne sont pas limités par le CPU, comme Bioshock Infinite.

Notez par ailleurs que le fait d'activer la technologie NVIDIA n'affecte en aucun cas la qualité de l'image, comme le montrent ces captures d'écrans.

Captures d'écrans sans Battery Boost, avec une cible à 45 fps et une cible à 25 fps

Quelle efficacité en termes d'autonomie ?

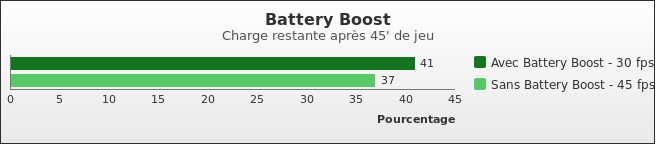

Si cette étude est riche en enseignements, elle n'apporte pas la réponse à la problématique posée par NVIDIA : son Battery Boost augmente-t-il l'autonomie de notre portable gamer ? Pour le savoir, nous avons chargé notre ROG 750 à 100%, ce dernier étant en mode avion, avec une luminosité moyenne. Nous avons alors joué à Battlefield 4 en 1080p, avec un niveau de détails faible, durant 45 minutes et avons relevé la charge de la batterie.

Résultat : Battery Boost permet bien de gagner quelques pourcents, mais la différence reste faible (10% de gain). Ceci étant, ce résultat vaut pour ce jeu, dans cette définition et ce niveau de détails, et sur ce portable. Rien ne dit qu'il en soit de même dans d'autres conditions.

Notre test le plus récent concernant les GPU mobiles est, rappelez-vous, celui qui évoquait les portables ultrafins pour joueurs, avec le test des Razer Blade 14 et de l'Aorus X7. Dans ce dossier, nous avons mesuré les performances des GTX 765M, en solo (sur le Blade) ou en SLI (sur le X7). L'Aorus X7 est équipé d'un Core i7-4700HQ, tout comme l'est l'Asus ROG G750 qui nous a servi durant nos tests. Le Blade embarque quant à lui un Core i7-4702HQ dont les fréquences sont moindres par rapport au Core i7-4700HQ, de seulement 200 MHz.

Il nous a donc semblé pertinent de comparer les résultats de la GTX 880M à ceux de ces deux portables testés récemment.

Asus ROG 750, notre machine de test

C'est donc le tout récent portable gamer d'Asus qui nous a servi pour ce dossier. Cette machine est l'une des premières à embarquer la GeForce GTX 880M de NVIDIA, avec le dernier Blade de Razer.Disposant d'un écran Full HD de 17,3 pouces, ce ROG 750 pèse la bagatelle de 4,5 kg et mesure tout de même 5 cm d'épaisseur. En plus du Core i7-4700HQ d'Intel, on trouve dans cette machine de 8, 16 voire 32 Go de mémoire vive DDR3. Quant au support de stockage, il se compose d'un ou deux disques durs de 750 Go ou de 1 To (à 7 200 RPM), unités qui peuvent être accompagnées d'un SSD de 256 Go.

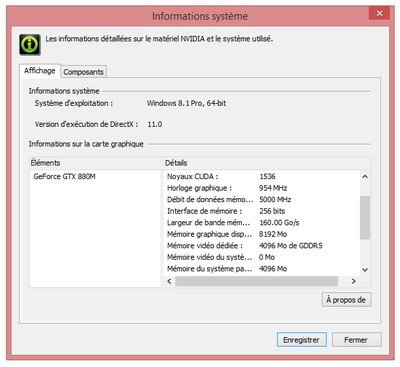

Dans ce portable, on trouve donc la GTX 880M de NVIDIA. Ce GPU dispose, comme l'indique le constructeur, de 1 536 unités de calcul fonctionnant à 954 MHz (contre 823 MHz pour la GTX 780M), hors Boost. Il embarque 4 Go de mémoire GDDR5 cadencé à une fréquence maximale de 2 500 MHz (contre 2 000 MHz pour le précédent haut de gamme), le tout sur un bus 256 bits, tout comme la GTX 780M.

GeForce GTX 880M : les performances

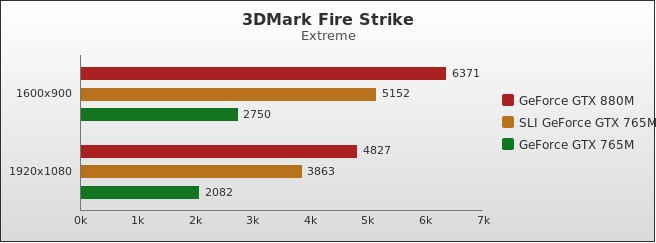

On commence, comme d'habitude, notre série de tests par l'inusable 3DMark, qui nous apprend que la GTX 880M de NVIDIA surpasse le SLI de GTX 765M d'environ 25%, quelle que soit la définition (HD+ et Full HD) utilisée. Par rapport à la seule GTX 765M du Blade, l'écart est naturellement plus important : 131% !

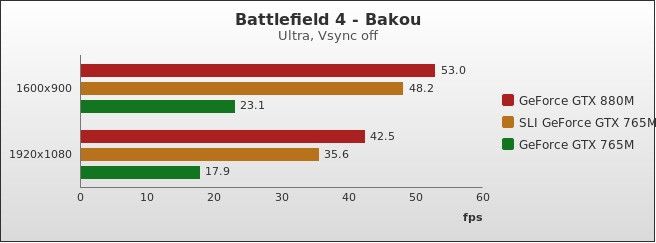

Le test synthétique est une chose, les jeux en sont une autre ! Battlefield 4, testé sous Fraps, livre un verdict assez différent, même si le classement précédent demeure identique. Car si la GTX 880M reste en tête, l'écart se réduit à 10% par rapport au SLI de GTX 765M en HD+, et 20% en Full HD. Par rapport au GTX 765M, la différence reste élevée et similaire à ce que nous avons observé sous 3DMark, c'est à dire supérieur à 130%.

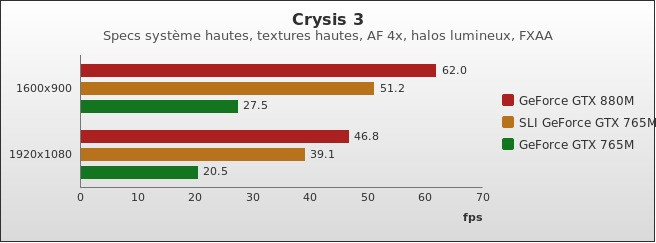

Que nous apprennent Crysis 3 et Fraps ? Que l'écart qui sépare notre SLI de GTX 765M et la GTX 880M s'élève à 20%, en HD+ comme en Full HD. Par rapport au GTX 765M, on reste entre 120 et 130%, quelle que soit la définition choisie.

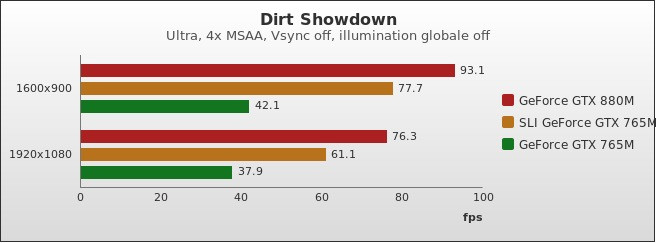

Dirt : Showdown et son utilitaire de mesure donnent des résultats similaires à ceux que nous avons observés plus haut : le GTX 880M surpasse le SLI de GTX 765M de 20 à 25% (en Full HD et en HD+, respectivement), et double les performances du GTX 765M, à minima.

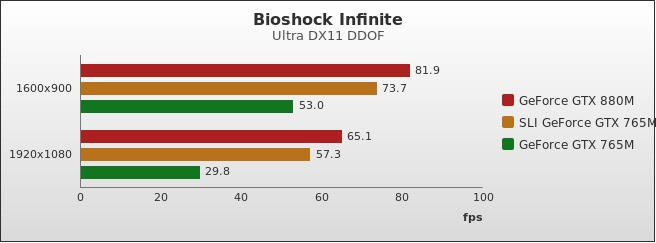

Bioshock Infinite, enfin, que nous testons via son outil de benchmark intégré, est moins généreux avec le GTX 880M, du moins en HD+, puisque l'écart avec le SLI de GTX 765M dépasse à peine les 10% et plafonne à 55% par rapport au GTX 765M seul. En Full HD en revanche, on repasse à 25% et 120%, respectivement.

NVIDIA a en effet simplement relevé les fréquences de sa précédente GTX 780M. C'est peu, mais ça permet à la GTX 880M d'être redoutable en termes de performances, puisqu'elle surpasse aisément un SLI de GTX 765M sur tous nos tests. Mais on n'en attendait pas moins de la part du caméléon.

Là où nous attendions un peu plus de la part du constructeur, c'est au niveau de sa toute nouvelle fonctionnalité, Battery Boost. Si l'idée est séduisante sur le papier, elle souffre d'une application pour l'instant globale sur l'ensemble des titres, alors qu'elle nécessiterait l'utilisation de profils, d'autant qu'elle fonctionne à partir du GeForce Experience.

Le comportement de Battery Boost, qui reste une réelle innovation, est pour le moment parfois inadapté et ses bénéfices sont trop dépendant des moteurs graphiques. NVIDIA se veut toutefois rassurant et affirme qu'une nouvelle version de GeForce Experience arrivera courant avril et permettra de pallier ce manque, puisque les titres compatibles avec le logiciel du caméléon bénéficieront d'un profil à la fois en charge et sur batterie. Nous ne demandons qu'à voir, sachant qu'à notre sens, le travail à réaliser pour proposer des réglages pertinents nous semble particulièrement important.